Come Identificare l'Intento di Ricerca per l'Ottimizzazione AI

Scopri come identificare e ottimizzare per l'intento di ricerca nei motori di ricerca AI. Scopri i metodi per classificare le query degli utenti, analizzare le ...

Scopri come i grandi modelli linguistici interpretano l’intento dell’utente oltre le parole chiave. Esplora espansione delle query, comprensione semantica e come i sistemi AI decidono quali contenuti citare nelle risposte.

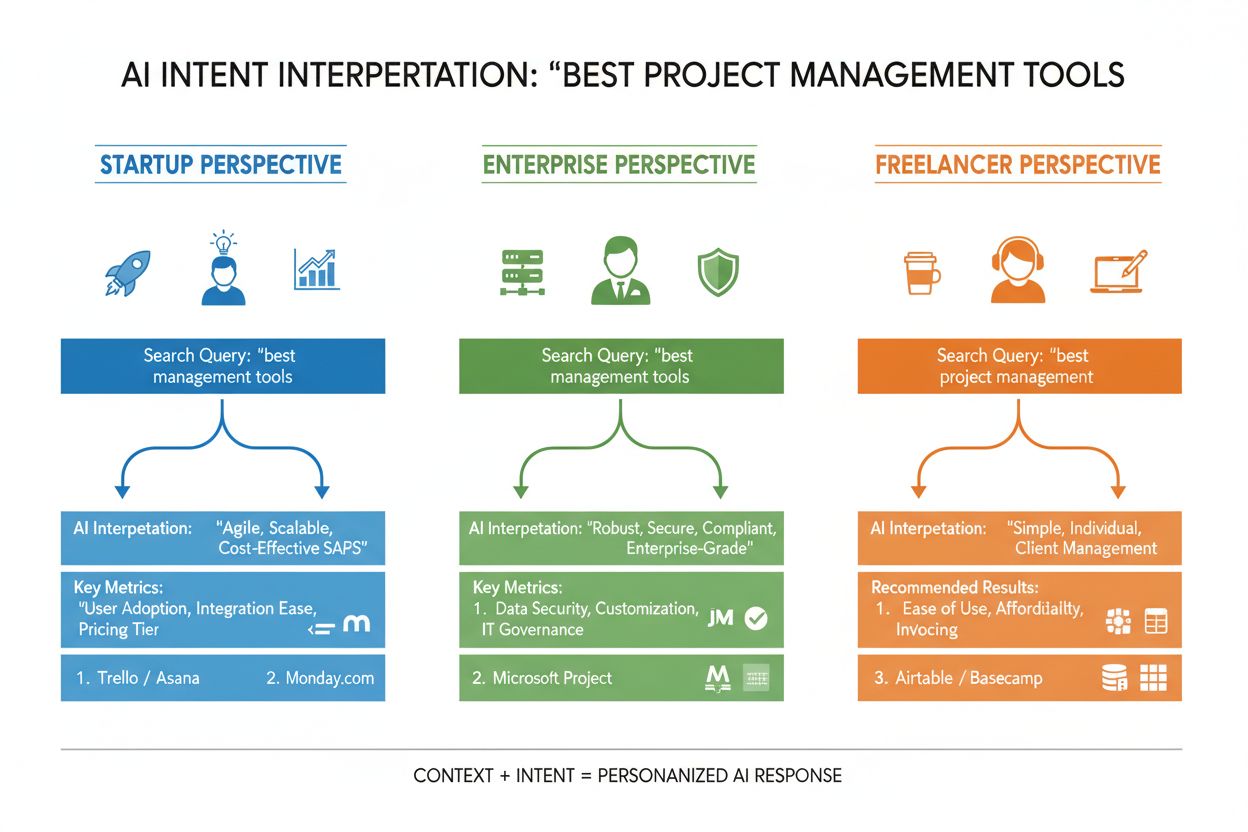

L’intento dell’utente nella ricerca AI si riferisce all’obiettivo o scopo sottostante di una query, non solo alle parole chiave digitate. Quando cerchi “migliori strumenti di project management”, potresti voler un confronto rapido, informazioni sui prezzi o capacità di integrazione—e i grandi modelli linguistici (LLM) come ChatGPT, Perplexity e Gemini di Google lavorano per capire quale di questi obiettivi stai effettivamente perseguendo. A differenza dei motori di ricerca tradizionali che associano parole chiave alle pagine, gli LLM interpretano il significato semantico della tua query analizzando contesto, formulazione e segnali correlati per prevedere ciò che vuoi davvero ottenere. Questo passaggio dal matching delle parole chiave alla comprensione dell’intento è fondamentale nel funzionamento dei moderni sistemi di ricerca AI e determina direttamente quali fonti vengono citate nelle risposte generate dall’AI. Comprendere l’intento dell’utente è diventato critico per i brand che cercano visibilità nei risultati di ricerca AI, poiché strumenti come AmICited ora monitorano come i sistemi AI fanno riferimento ai tuoi contenuti in base all’allineamento dell’intento.

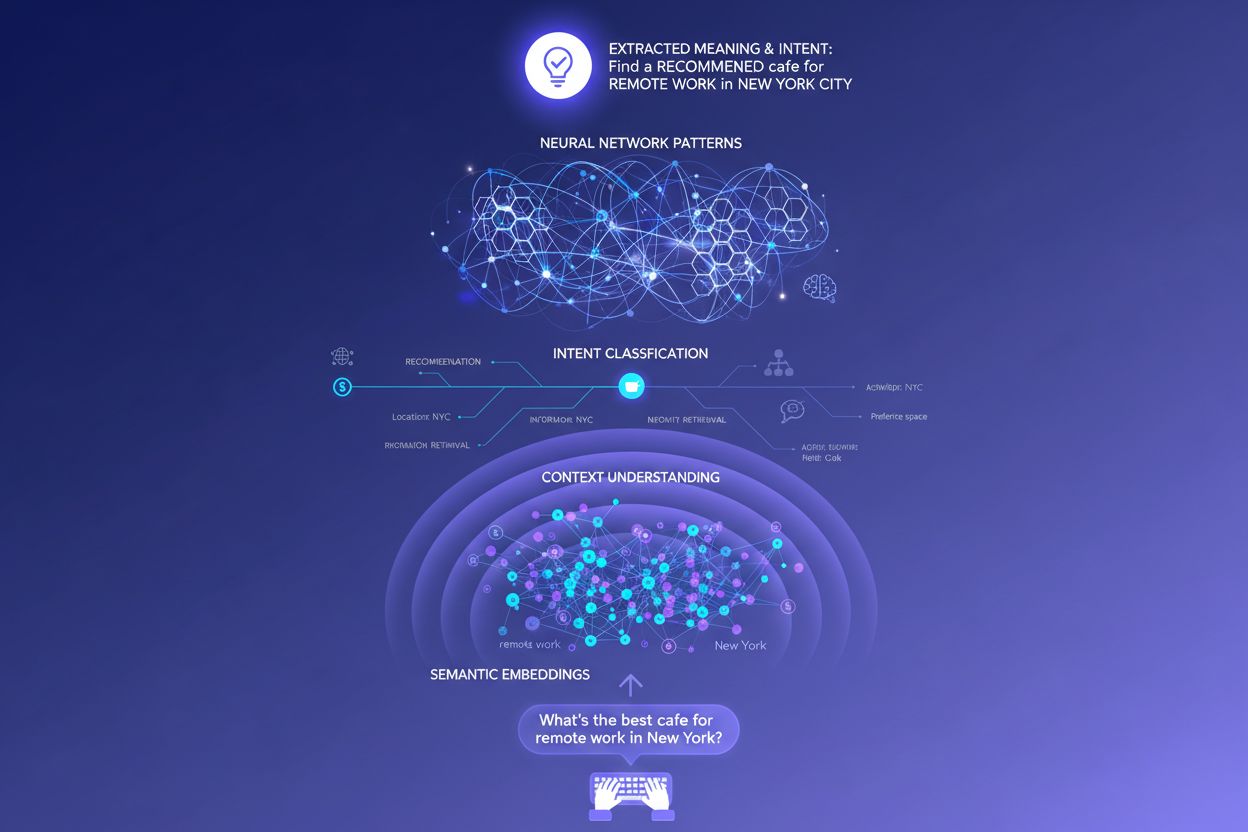

Quando inserisci una singola query in un sistema di ricerca AI, dietro le quinte accade qualcosa di notevole: il modello non risponde semplicemente alla tua domanda in modo diretto. Invece, espande la tua query in dozzine di micro-domande correlate, un processo che i ricercatori chiamano “query fan-out”. Ad esempio, una semplice ricerca come “Notion vs Trello” può generare sotto-query come “Qual è migliore per la collaborazione di squadra?”, “Quali sono le differenze di prezzo?”, “Quale si integra meglio con Slack?” e “Qual è più facile per i principianti?” Questa espansione consente agli LLM di esplorare diversi aspetti del tuo intento e raccogliere informazioni più complete prima di generare una risposta. Il sistema poi valuta passaggi da diverse fonti a livello granulare, invece di classificare intere pagine, il che significa che un singolo paragrafo dei tuoi contenuti potrebbe essere selezionato mentre il resto della pagina viene ignorato. Questa analisi a livello di passaggio spiega perché chiarezza e specificità in ogni sezione contano più che mai—una risposta ben strutturata a un sotto-intento specifico potrebbe essere il motivo per cui i tuoi contenuti vengono inseriti in una risposta AI generata.

| Query Originale | Sotto-Intento 1 | Sotto-Intento 2 | Sotto-Intento 3 | Sotto-Intento 4 |

|---|---|---|---|---|

| “Migliori strumenti di project management” | “Qual è il migliore per team remoti?” | “Qual è il prezzo?” | “Quale si integra con Slack?” | “Qual è il più semplice per i principianti?” |

| “Come migliorare la produttività” | “Quali strumenti aiutano nella gestione del tempo?” | “Quali sono i metodi di produttività comprovati?” | “Come ridurre le distrazioni?” | “Quali abitudini aumentano la concentrazione?” |

| “Motori di ricerca AI spiegati” | “In cosa differiscono da Google?” | “Quale ricerca AI è più accurata?” | “Come gestiscono la privacy?” | “Qual è il futuro della ricerca AI?” |

Gli LLM non valutano la tua query isolatamente—costruiscono quello che i ricercatori chiamano un “embedding utente”, un profilo vettoriale che cattura il tuo intento in evoluzione in base alla cronologia di ricerca, posizione, tipo di dispositivo, ora del giorno e persino conversazioni precedenti. Questa comprensione contestuale consente al sistema di personalizzare radicalmente i risultati: due utenti che cercano “migliori strumenti CRM” potrebbero ricevere raccomandazioni completamente diverse se uno è un fondatore di startup e l’altro un manager aziendale. La ri-classificazione in tempo reale perfeziona ulteriormente i risultati in base a come interagisci con essi—se clicchi su certi risultati, passi tempo a leggere sezioni specifiche o fai domande di approfondimento, il sistema adatta la sua comprensione dell’intento e aggiorna di conseguenza le raccomandazioni future. Questo ciclo di feedback comportamentale significa che i sistemi AI imparano costantemente cosa vogliono realmente gli utenti, non solo ciò che digitano inizialmente. Per i creatori di contenuti e i marketer, questo sottolinea l’importanza di creare contenuti che soddisfino l’intento su più contesti utente e fasi decisionali.

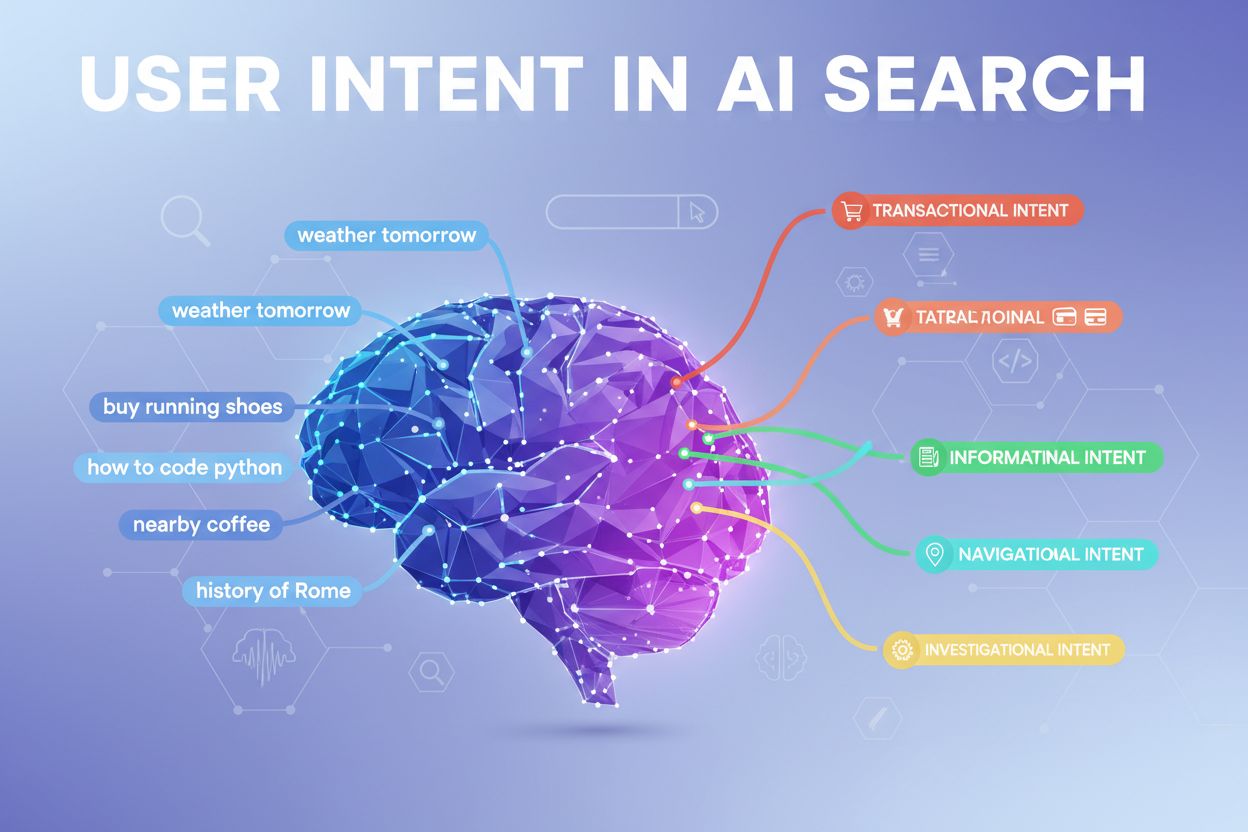

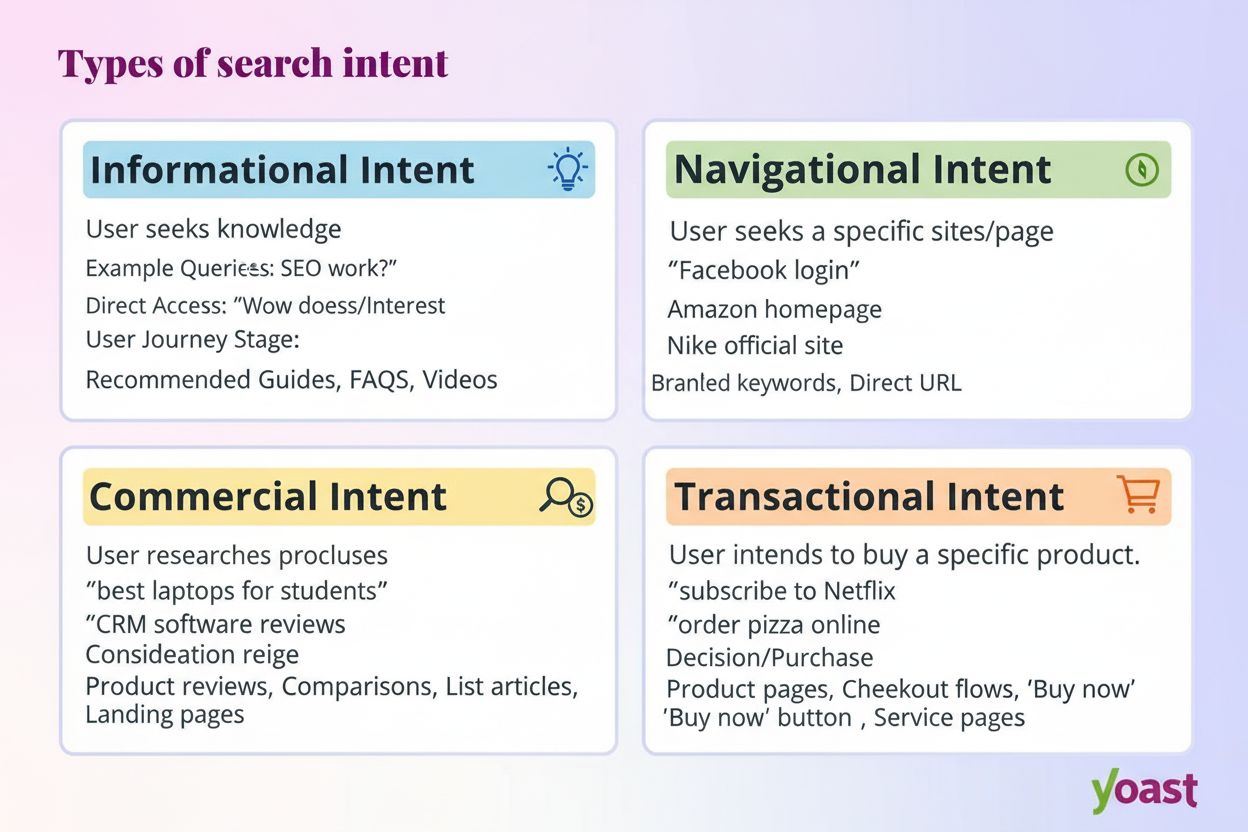

I moderni sistemi AI classificano l’intento dell’utente in diverse categorie distinte, ciascuna delle quali richiede tipi diversi di contenuti e risposte:

Gli LLM classificano automaticamente questi intenti analizzando la struttura della query, le parole chiave e segnali contestuali, selezionando poi i contenuti che meglio rispondono al tipo di intento rilevato. Comprendere queste categorie aiuta i creatori di contenuti a strutturare le loro pagine per soddisfare l’intento specifico con cui gli utenti effettuano le ricerche.

I motori di ricerca tradizionali basati su parole chiave operano tramite una semplice corrispondenza di stringhe—se la tua pagina contiene esattamente le parole cercate da qualcuno, potrebbe essere posizionata. Questo approccio fallisce clamorosamente con sinonimi, parafrasi e contesto. Se qualcuno cerca “software di project management economico” e la tua pagina usa la frase “piattaforma di coordinamento attività a basso costo”, la ricerca tradizionale potrebbe non fare alcun collegamento. Gli embeddings semantici risolvono questo problema trasformando parole e frasi in vettori matematici che catturano il significato e non solo il testo superficiale. Questi vettori esistono in uno spazio ad alta dimensionalità dove concetti semanticamente simili si raggruppano insieme, permettendo agli LLM di riconoscere che “economico”, “a basso costo”, “conveniente” e “low-cost” esprimono tutti lo stesso intento. Questo approccio semantico gestisce anche query lunghe e conversazionali molto meglio del matching delle parole chiave—una query come “Sono un freelance e mi serve qualcosa di semplice ma potente” può essere abbinata a contenuti rilevanti anche senza parole chiave tradizionali. Il risultato pratico è che i sistemi AI possono proporre risposte pertinenti a query vaghe, complesse o non convenzionali, rendendoli molto più utili rispetto ai predecessori basati su parole chiave.

Al cuore tecnico dell’interpretazione dell’intento si trova l’architettura transformer, un design di rete neurale che elabora il linguaggio analizzando le relazioni tra parole tramite un meccanismo chiamato “attenzione”. Invece di leggere il testo in modo sequenziale come un umano, i transformer valutano come ogni parola si relaziona a tutte le altre in una query, permettendo di catturare significato e contesto in modo sfumato. Gli embeddings semantici sono le rappresentazioni numeriche che emergono da questo processo—ogni parola, frase o concetto viene trasformato in un vettore di numeri che ne codifica il significato. Modelli come BERT (Bidirectional Encoder Representations from Transformers) e RankBrain usano questi embeddings per capire che “miglior CRM per startup” e “piattaforma di customer relationship management per nuove aziende” esprimono un intento simile, anche se usano parole completamente diverse. Il meccanismo di attenzione è particolarmente potente perché permette al modello di concentrarsi sulle parti più rilevanti di una query—in “migliori strumenti di project management per team remoti con budget limitato”, il sistema impara a pesare “team remoti” e “budget limitato” come segnali di intento critici. Questa sofisticazione tecnica spiega perché la ricerca AI moderna sembra molto più intelligente rispetto ai sistemi tradizionali basati su parole chiave.

Capire come gli LLM interpretano l’intento cambia radicalmente la strategia di contenuto. Invece di scrivere una guida completa che cerca di posizionarsi per una singola parola chiave, i contenuti di successo ora rispondono a più sotto-intenti in sezioni modulari che possono stare in piedi da sole. Se scrivi sui tool di project management, invece di un unico enorme confronto, crea sezioni distinte che rispondano a “Qual è il migliore per team remoti?”, “Qual è l’opzione più economica?” e “Quale si integra con Slack?"—ogni sezione diventa una potenziale scheda di risposta che gli LLM possono estrarre e citare. Una formattazione pronta per la citazione è fondamentale: usa fatti invece di affermazioni vaghe, includi numeri e date specifiche, e struttura le informazioni in modo che sia facile per i sistemi AI quotare o riassumere. Elenchi puntati, titoli chiari e paragrafi brevi aiutano gli LLM a interpretare meglio i tuoi contenuti rispetto a testi densi. Strumenti come AmICited permettono oggi ai marketer di monitorare come i sistemi AI fanno riferimento ai loro contenuti su ChatGPT, Perplexity e Google AI, rivelando quali allineamenti di intento funzionano e dove ci sono lacune nei contenuti. Questo approccio data-driven alla strategia di contenuto—ottimizzare per come i sistemi AI effettivamente interpretano e citano il tuo lavoro—rappresenta un cambiamento fondamentale rispetto alla SEO tradizionale.

Considera un esempio e-commerce: quando qualcuno cerca “giacca impermeabile sotto i 200 euro”, sta esprimendo più intenti contemporaneamente—vuole informazioni sulla durabilità, conferma del prezzo e raccomandazioni di prodotto. Un sistema AI può espandere questa query in sotto-domande su tecnologia di impermeabilizzazione, confronti di prezzo, recensioni di marca e informazioni sulla garanzia. Un brand che affronta tutti questi aspetti in contenuti modulari e ben strutturati ha molte più probabilità di essere citato nella risposta AI generata rispetto a un concorrente con una pagina prodotto generica. Nel settore SaaS, la stessa query “Come invito il mio team in questo workspace?” può comparire centinaia di volte nei log di supporto, segnalando una lacuna critica nei contenuti. Un assistente AI addestrato sulla tua documentazione può avere difficoltà a rispondere chiaramente a questa domanda, portando a una scarsa esperienza utente e minore visibilità nelle risposte AI di supporto. In contesti di news e informazione, una query come “Cosa sta succedendo con la regolamentazione AI?” viene interpretata diversamente a seconda del contesto utente—un policy maker potrebbe avere bisogno di dettagli legislativi, un business leader di implicazioni competitive, un tecnico di informazioni sugli standard. I contenuti di successo affrontano esplicitamente questi diversi contesti di intento.

Nonostante la loro sofisticazione, gli LLM affrontano vere sfide nell’interpretazione dell’intento. Query ambigue come “Java” possono riferirsi al linguaggio di programmazione, all’isola o al caffè—anche con il contesto, il sistema può classificare male l’intento. Intenti misti o stratificati complicano ulteriormente: “Questo CRM è meglio di Salesforce e dove posso provarlo gratis?” combina confronto, valutazione e intento transazionale in una sola query. Limitazioni della finestra di contesto significano che gli LLM possono considerare solo una quantità finita di cronologia della conversazione, quindi in conversazioni lunghe su più turni, segnali di intento precedenti possono essere dimenticati. Allucinazioni ed errori fattuali restano una preoccupazione, soprattutto nei settori che richiedono alta accuratezza come sanità, finanza o consulenza legale. Considerazioni sulla privacy sono anch’esse rilevanti—man mano che i sistemi raccolgono più dati comportamentali per migliorare la personalizzazione, devono bilanciare l’accuratezza dell’intento con le preoccupazioni sulla privacy degli utenti. Comprendere questi limiti aiuta creatori di contenuti e marketer a fissare aspettative realistiche sulla visibilità nella ricerca AI e a riconoscere che non tutte le query saranno interpretate perfettamente.

La ricerca basata sull’intento sta evolvendo rapidamente verso una comprensione e un’interazione sempre più sofisticate. L’AI conversazionale diventerà sempre più naturale, con sistemi che mantengono il contesto su dialoghi multi-turno più lunghi e complessi, dove l’intento può cambiare ed evolversi. La comprensione multimodale dell’intento combinerà testo, immagini, voce e persino video per interpretare gli obiettivi utente in modo più olistico—immagina di chiedere a un assistente AI “trovami qualcosa come questo” mostrando una foto. La ricerca senza query rappresenta una frontiera emergente in cui i sistemi AI anticipano i bisogni dell’utente prima che vengano esplicitamente dichiarati, utilizzando segnali comportamentali e contesto per proporre proattivamente informazioni rilevanti. Personalizzazione migliorata renderà i risultati sempre più su misura per i profili utente individuali, le fasi decisionali e le situazioni contestuali. L’integrazione con i sistemi di raccomandazione sfumerà il confine tra ricerca e scoperta, con sistemi AI che suggeriscono contenuti rilevanti che l’utente non sapeva nemmeno di cercare. Man mano che queste capacità maturano, il vantaggio competitivo sarà sempre più nelle mani di brand e creatori che comprendono a fondo l’intento e strutturano i loro contenuti per soddisfarlo in modo completo su più contesti e tipi di utenti.

L'intento dell'utente si riferisce all'obiettivo o scopo sottostante dietro una query, non solo alle parole chiave digitate. Gli LLM interpretano il significato semantico analizzando il contesto, la formulazione e segnali correlati per prevedere ciò che gli utenti vogliono realmente ottenere. Per questo la stessa query può produrre risultati diversi in base al contesto dell'utente e alla fase decisionale.

Gli LLM utilizzano un processo chiamato 'espansione della query' per suddividere una singola richiesta in dozzine di micro-domande correlate. Ad esempio, 'Notion vs Trello' può espandersi in sotto-query su collaborazione di squadra, prezzi, integrazioni e facilità d'uso. Questo consente ai sistemi AI di esplorare diverse sfaccettature dell'intento e raccogliere informazioni complete.

Comprendere l'intento aiuta i creatori di contenuti a ottimizzare il modo in cui i sistemi AI interpretano e citano il loro lavoro. I contenuti che affrontano più sotto-intenti in sezioni modulari hanno maggiori probabilità di essere selezionati dagli LLM. Questo impatta direttamente la visibilità nelle risposte AI generate su ChatGPT, Perplexity e Google AI.

Gli embeddings semantici trasformano parole e frasi in vettori matematici che catturano il significato e non solo il testo superficiale. Questo permette agli LLM di riconoscere che 'economico', 'a basso costo' e 'conveniente' esprimono lo stesso intento, anche se usano parole diverse. Questo approccio semantico gestisce sinonimi, parafrasi e contesto molto meglio rispetto al tradizionale matching di parole chiave.

Sì, gli LLM incontrano difficoltà con query ambigue, intenti misti e limiti di contesto. Query come 'Java' possono riferirsi al linguaggio di programmazione, alla geografia o al caffè. Le conversazioni lunghe possono superare le finestre di contesto, facendo dimenticare segnali di intento precedenti. Capire questi limiti aiuta ad avere aspettative realistiche sulla visibilità nella ricerca AI.

I brand dovrebbero creare contenuti modulari che rispondano a più sotto-intenti in sezioni distinte. Utilizza una formattazione pronta per la citazione con fatti, numeri specifici e struttura chiara. Monitora come i sistemi AI fanno riferimento ai tuoi contenuti con strumenti come AmICited per identificare lacune nell'allineamento dell'intento e ottimizzare di conseguenza.

L'intento è orientato al compito—cosa gli utenti vogliono ottenere ora. L'interesse è una curiosità generale più ampia. I sistemi AI danno priorità all'intento perché determina direttamente quali contenuti vengono selezionati per le risposte. Un utente può essere interessato agli strumenti di produttività in generale, ma il suo intento può essere trovare qualcosa per la collaborazione di un team remoto.

I sistemi AI citano le fonti che meglio corrispondono all'intento rilevato. Se il tuo contenuto affronta chiaramente un sotto-intento specifico con informazioni ben strutturate e fattuali, è più probabile che venga selezionato. Strumenti come AmICited tracciano questi pattern di citazione, mostrando quali allineamenti di intento guidano la visibilità nelle risposte AI generate.

Comprendi come gli LLM fanno riferimento ai tuoi contenuti su ChatGPT, Perplexity e Google AI. Tieni traccia dell'allineamento dell'intento e ottimizza la visibilità AI con AmICited.

Scopri come identificare e ottimizzare per l'intento di ricerca nei motori di ricerca AI. Scopri i metodi per classificare le query degli utenti, analizzare le ...

L’intento di ricerca è lo scopo dietro la query di un utente. Scopri le quattro tipologie, come identificarle e ottimizzare i contenuti per un migliore posizion...

Scopri come allineare i tuoi contenuti con l’intento delle query AI per aumentare le citazioni su ChatGPT, Perplexity e Google AI. Padroneggia le strategie di a...