Ricerca Visiva AI

Scopri cos'è la ricerca visiva AI, come funziona e le sue applicazioni nell'e-commerce e nel retail. Scopri le tecnologie dietro la ricerca basata su immagini e...

Scopri come la ricerca visiva e l’IA stanno trasformando la scoperta delle immagini. Ottimizza le tue immagini per Google Lens, AI Overviews e LLM multimodali per aumentare la visibilità nei risultati di ricerca potenziati dall’IA.

La ricerca visiva rappresenta un cambiamento fondamentale nel modo in cui gli utenti scoprono prodotti, informazioni e contenuti online. Invece di digitare parole chiave in una barra di ricerca, ora gli utenti possono puntare la fotocamera su un oggetto, caricare una foto o fare uno screenshot per trovare ciò che cercano. Questo passaggio dalla ricerca testuale a quella visiva sta rimodellando il modo in cui i sistemi IA interpretano e mostrano i contenuti. Con strumenti come Google Lens che elaborano oltre 20 miliardi di query di ricerca mensili, la ricerca visiva è passata da tecnologia emergente a canale di scoperta mainstream che influenza direttamente come i brand appaiono nei risultati guidati dall’IA e nei motori di risposta.

Le moderne IA non “vedono” le immagini come fanno gli esseri umani. I modelli di visione artificiale trasformano i pixel in vettori ad alta dimensionalità chiamati embedding, che catturano schemi di forme, colori e texture. I sistemi IA multimodali apprendono poi uno spazio condiviso in cui embedding visivi e testuali possono essere confrontati, permettendo di abbinare l’immagine di una “scarpa da corsa blu” a una didascalia che usa parole completamente diverse ma descrive lo stesso concetto. Questo processo avviene tramite API di visione e modelli multimodali che i principali provider mettono a disposizione per sistemi di ricerca e raccomandazione.

| Provider | Output Tipici | Insight SEO-Rilevanti |

|---|---|---|

| Google Vision / Gemini | Etichette, oggetti, testo (OCR), categorie safe-search | Quanto bene i visual si allineano ai temi della query e se sono sicuri da mostrare |

| OpenAI Vision Models | Descrizioni in linguaggio naturale, testo rilevato, suggerimenti di layout | Didascalie e riassunti che l’IA può riutilizzare in overviews o chat |

| AWS Rekognition | Scene, oggetti, volti, emozioni, testo | Se le immagini rappresentano chiaramente persone, interfacce o ambienti rilevanti all’intento |

| Altri LLM Multimodali | Embedding congiunti immagine-testo, punteggi sicurezza | Utilità complessiva e rischio nell’includere un visual in output IA |

Questi modelli non si interessano della palette del tuo brand o dello stile fotografico in senso umano. Danno priorità a quanto chiaramente un’immagine rappresenta concetti scopribili come “tabella prezzi”, “dashboard SaaS” o “confronto prima/dopo”, e se tali concetti sono coerenti con il testo e le query circostanti.

L’ottimizzazione classica delle immagini si concentrava sul ranking nei risultati immagini, sulla compressione per la velocità e sull’aggiunta di alt text descrittivo per l’accessibilità. Questi fondamentali contano ancora, ma la posta in gioco è più alta ora che i motori di risposta IA riutilizzano gli stessi segnali per decidere quali siti meritino un posizionamento di rilievo nelle risposte sintetizzate. Invece di ottimizzare solo per una casella di ricerca, ora si ottimizza per la “ricerca ovunque”: web, social e assistenti IA che estraggono, riassumono e riformulano le tue pagine. Un approccio Generative Engine SEO tratta ogni immagine come un asset di dati strutturati, i cui metadati, contesto e performance alimentano decisioni di visibilità su questi canali.

Non tutti i campi contribuiscono allo stesso modo alla comprensione IA. Concentrarsi sugli elementi più influenti permette di ottenere risultati senza sovraccaricare il team:

Pensa a ogni blocco immagine quasi come a un mini brief di contenuto. La stessa disciplina usata nei contenuti SEO (target, intento, entità, struttura) si applica direttamente nel definire il ruolo visivo e i relativi metadati.

Quando gli overviews IA o assistenti come Copilot assemblano una risposta, spesso lavorano da HTML in cache, dati strutturati e embedding precomputati invece che caricare ogni immagine in tempo reale. Questo rende i metadati di qualità e lo schema i principali leve a tua disposizione. Il manuale Microsoft Ads per l’inclusione nelle risposte Copilot raccomanda ai publisher di associare alt text ben scritti, schema ImageObject e didascalie concise a ogni visual, così che il sistema possa estrarre e classificare correttamente le informazioni sulle immagini. I primi adottanti hanno visto i loro contenuti apparire nei pannelli risposta in poche settimane, con un aumento del 13% nel click-through da queste posizioni.

Implementa il markup schema.org adeguato al tipo di pagina: Product (nome, brand, identificatori, immagine, prezzo, disponibilità, recensioni), Recipe (immagine, ingredienti, tempo di cottura, resa, immagini dei passaggi), Article/BlogPosting (headline, immagine, dataPubblicazione, autore), LocalBusiness/Organization (logo, immagini, link sameAs, informazioni NAP), e HowTo (passaggi chiari con immagini opzionali). Includi proprietà image e thumbnailUrl dove supportato, e assicurati che gli URL siano accessibili e indicizzabili. Mantieni coerenza tra dati strutturati e contenuto visibile in pagina, e valida regolarmente il markup man mano che i template evolvono.

Per operazionalizzare l’ottimizzazione immagini su larga scala, costruisci un workflow ripetibile che tratti la parte visual come un processo SEO strutturato:

Qui l’automazione IA e la SEO si incontrano con grande forza. Tecniche simili a quelle dell’AI-powered SEO per clustering keyword o linking interno possono essere riutilizzate per etichettare immagini, proporre didascalie migliori e segnalare visual non coerenti con il topic della pagina.

La ricerca visiva sta già trasformando il modo in cui grandi retailer e brand si collegano ai clienti. Google Lens è diventato uno degli strumenti più potenti per la scoperta di prodotti, con 1 ricerca visiva su 4 a scopo commerciale. Home Depot ha integrato funzionalità di ricerca visiva nella sua app mobile per aiutare i clienti a identificare viti, bulloni, utensili e raccordi con una semplice foto, eliminando la necessità di cercare con nomi vaghi o codici prodotto. ASOS integra la ricerca visiva nella sua app mobile per facilitare la scoperta di prodotti simili, mentre IKEA usa la tecnologia per aiutare gli utenti a trovare mobili e accessori che si abbinano all’arredo già posseduto. Zara ha implementato funzionalità che permettono agli utenti di fotografare outfit di street style e trovare articoli simili nel suo catalogo, collegando direttamente l’ispirazione fashion all’offerta commerciale.

Il tradizionale customer journey (scoperta, valutazione, acquisto) ora ha un nuovo potente punto d’ingresso. Un utente può scoprire il tuo brand senza averlo mai sentito nominare, semplicemente vedendo un tuo prodotto per strada e usando Google Lens. Ogni prodotto fisico diventa un potenziale annuncio ambulante e un gateway verso il tuo shop online. Per i retailer con negozi fisici, la ricerca visiva è uno strumento eccezionale per creare un’esperienza omnicanale. Un cliente può essere in negozio, scansionare un prodotto per vedere se ci sono altri colori online, leggere recensioni o guardare video tutorial. Questo arricchisce l’esperienza in-store e connette senza soluzione di continuità l’inventario fisico al catalogo digitale.

Le integrazioni con piattaforme consolidate moltiplicano l’impatto. Google Shopping integra i risultati Lens direttamente nel percorso di acquisto. Pinterest Lens offre funzionalità simili, e Amazon ha sviluppato StyleSnap, la sua versione di ricerca visiva per la moda. Questa concorrenza accelera l’innovazione e migliora le capacità disponibili a consumatori e retailer. Anche le piccole imprese ne beneficiano: Google My Business permette alle attività locali di apparire nei risultati di ricerca visiva quando gli utenti fotografano prodotti nei negozi.

La misurazione della ricerca visiva sta migliorando, ma resta limitata nell’attribuzione diretta. Monitora i risultati di ricerca con il tipo “Immagine” in Google Search Console laddove rilevante, tracciando impression, click e posizioni per query e risultati ricchi di immagini. Controlla i report Copertura per problemi di indicizzazione immagini. Nella piattaforma analytics, annota quando implementi ottimizzazioni su immagini e schema, poi traccia l’engagement su gallerie e conversioni chiave su pagine ricche di visual. Per le attività locali, consulta le visualizzazioni foto e le azioni utente dopo interazioni con le immagini in Google Business Profile Insights.

La realtà è che oggi i referral da Lens non sono separati nella maggior parte degli analytics. Usa metriche direzionali e test controllati: migliora immagini prodotto e schema specifici, poi confronta la performance con gruppi di controllo. Le aziende che sfruttano l’IA per il targeting ottengono in media il 40% di conversioni in più e un aumento del 35% nel valore medio ordine, a testimonianza del potenziale quando l’ottimizzazione guidata dalle macchine allinea contenuto e intento con precisione.

La ricerca visiva continua a evolvere a ritmi vertiginosi. Multisearch permette di combinare un’immagine con testo per ricerche ultra-specifiche—per esempio, fotografare una camicia e aggiungere “cravatta” per farsi mostrare da Google le cravatte abbinate. Integrazione con la Realtà Aumentata è il passo logico successivo, fondendo la ricerca visiva con l’AR così da proiettare, tramite la fotocamera, il modello 3D di un divano nel proprio salotto per vedere come starebbe. Espansione al video è un altro trend importante: Google già consente ricerche tramite brevi clip video, utilissime per prodotti in movimento o che richiedono una dimostrazione. Traduzione visiva automatica viene integrata nella ricerca: Lens può leggere testo dalle immagini, tradurlo e cercare prodotti nella lingua locale, abbattendo barriere geografiche nella scoperta. Ricerca sempre più contestuale e personalizzata proseguirà, poiché l’IA apprenderà gusti e ambiente, offrendo raccomandazioni proattive su misura rispetto a ciò che vede intorno a te. Nei prossimi anni queste capacità si espanderanno enormemente, con la ricerca visiva destinata a diventare il metodo predominante per scoprire prodotti e informazioni.

La ricerca visiva consente agli utenti di cercare utilizzando immagini invece che testo, puntando una fotocamera, caricando una foto o usando uno screenshot. A differenza della ricerca immagini tradizionale, dove si digitano parole chiave, la ricerca visiva elimina la barriera linguistica e permette la scoperta senza digitazione. Strumenti come Google Lens elaborano oltre 20 miliardi di query visive mensili, rendendola un canale di scoperta mainstream che influenza direttamente la visibilità dei brand nei risultati potenziati dall'IA.

I sistemi IA trasformano i pixel in vettori ad alta dimensionalità chiamati embedding che catturano schemi di forme, colori e texture. I modelli multimodali apprendono uno spazio condiviso in cui embedding visivi e testuali possono essere confrontati, permettendo di associare immagini a concetti. Invece di giudicare l'estetica, l'IA dà priorità a quanto chiaramente un'immagine rappresenta concetti scopribili come 'tabella prezzi' o 'dashboard SaaS' e se questi sono coerenti con il testo e le query circostanti.

Gli elementi di metadati più influenti sono: nomi file leggibili dall'umano (es. 'crm-dashboard-reporting-view.png'), alt text concisi che descrivono soggetto e contesto, didascalie che chiariscono la rilevanza dell'immagine, titoli e testi vicini che rafforzano entità e intenti, dati strutturati (schema ImageObject) e sitemap delle immagini. Questi elementi aiutano i sistemi IA a comprendere cosa rappresentano le immagini e come si collegano al contenuto della pagina.

Inizia con immagini originali di alta qualità che rappresentano chiaramente il soggetto. Usa nomi file descrittivi e scrivi alt text concisi. Implementa dati strutturati (schema Product, Article, HowTo, LocalBusiness) con proprietà immagini. Assicurati che le immagini si carichino rapidamente e siano responsive su mobile. Aggiungi didascalie che chiariscono la rilevanza dell'immagine. Mantieni coerenza tra testo in pagina e ciò che mostrano le immagini. Per l'e-commerce, fornisci più angolazioni e varianti. Valida regolarmente il markup e monitora Search Console per problemi di indicizzazione immagini.

Il riconoscimento immagini identifica oggetti all'interno delle immagini, mentre la ricerca visiva va oltre, stratificando metadati, machine learning e database di prodotti per offrire risultati altamente pertinenti e azionabili. La ricerca visiva comprende contesto, gerarchie di parti e intento utente: non si tratta solo di identificare oggetti, ma di collegarli a informazioni, prodotti e servizi scopribili. Questo rende la ricerca visiva più utile per il commercio e la scoperta rispetto al semplice riconoscimento immagini.

La ricerca visiva amplia tempi e modalità della scoperta, creando nuovi punti d'ingresso affinché gli utenti trovino i tuoi contenuti. Immagini di alta qualità e descrittive diventano asset di ranking. I motori di risposta IA usano gli stessi segnali (qualità immagine, metadati, dati strutturati, contesto circostante) per decidere quali pagine meritano una posizione di rilievo nelle risposte sintetizzate. Considerare le immagini come asset di dati strutturati, i cui metadati e contesto alimentano le decisioni di visibilità su tutti i canali di ricerca, è ora una competenza SEO essenziale.

Utilizza Google Search Console per monitorare prestazioni e indicizzazione delle immagini. Impiega strumenti di validazione dati strutturati per assicurare la correttezza dello schema. Sfrutta strumenti IA per generare alt text e didascalie su larga scala. Usa tool di ottimizzazione immagini per compressione e conversione formato (WebP, AVIF). Le piattaforme di analytics aiutano a tracciare l'engagement su pagine ricche di immagini. Per grandi librerie, usa sistemi DAM (Digital Asset Management) con integrazioni API per automatizzare aggiornamenti e governance dei metadati.

I principali trend emergenti includono Multisearch (combinazione di immagini e testo per query ultra-specifiche), integrazione di Realtà Aumentata (proiezione di prodotti nello spazio reale), espansione nella ricerca video, traduzione visiva automatica (abbattendo barriere geografiche) e maggiore personalizzazione contestuale. L'IA imparerà sempre più dalle preferenze e dall'ambiente dell'utente per offrire raccomandazioni proattive. La ricerca visiva è destinata a diventare il metodo predominante per la scoperta di prodotti e informazioni nei prossimi anni.

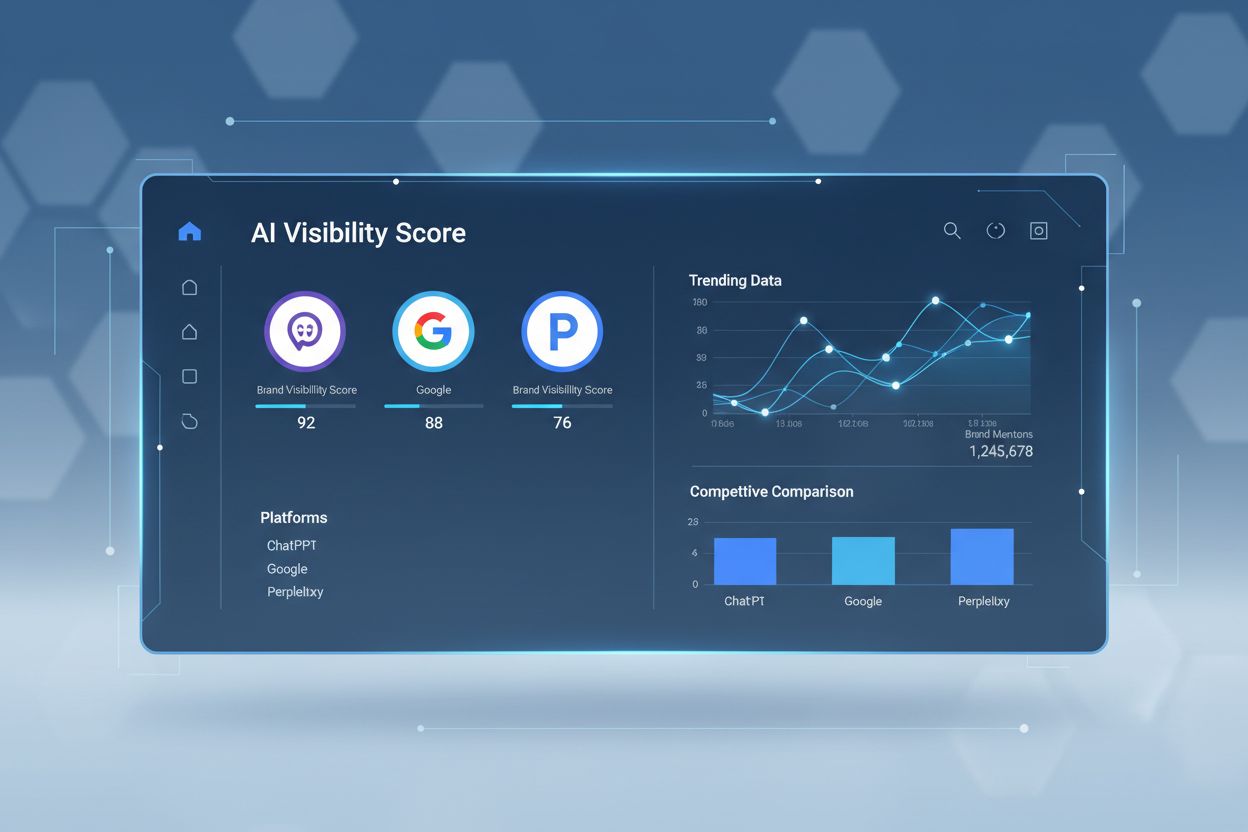

La ricerca visiva sta trasformando il modo in cui l'IA scopre e mostra i tuoi contenuti. AmICited ti aiuta a tracciare come le tue immagini e il tuo marchio appaiono negli AI Overviews, Google Lens e altre esperienze di ricerca IA.

Scopri cos'è la ricerca visiva AI, come funziona e le sue applicazioni nell'e-commerce e nel retail. Scopri le tecnologie dietro la ricerca basata su immagini e...

Guida di riferimento rapido al monitoraggio della visibilità AI. Tieni traccia di menzioni, citazioni e presenza del brand su ChatGPT, Google AI Overviews, Perp...

Diventa esperto del Semrush AI Visibility Toolkit con la nostra guida completa. Scopri come monitorare la visibilità del brand nella ricerca AI, analizzare i co...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.