Accesso Differenziale dei Crawler

Scopri come permettere o bloccare selettivamente i crawler AI in base agli obiettivi aziendali. Implementa l’accesso differenziale dei crawler per proteggere i ...

Scopri come i Web Application Firewall offrono un controllo avanzato sui crawler AI oltre robots.txt. Implementa regole WAF per proteggere i tuoi contenuti dallo scraping AI non autorizzato e monitora le citazioni AI con AmICited.

L’inadeguatezza di robots.txt come unico meccanismo di difesa è sempre più evidente nell’era del consumo di contenuti guidato dall’AI. Mentre i motori di ricerca tradizionali generalmente rispettano le direttive di robots.txt, i moderni crawler AI operano con incentivi e meccanismi di enforcement fondamentali diversi, rendendo le semplici policy testuali insufficienti per proteggere i contenuti. Secondo l’analisi di Cloudflare, i crawler AI ora rappresentano quasi l’80% di tutto il traffico bot verso i siti web, con i crawler di training che consumano enormi quantità di contenuti restituendo pochissimo traffico di riferimento: i crawler di OpenAI mantengono un rapporto crawl-to-referral di 400:1, mentre quello di Anthropic arriva fino a 38.000:1. Per editori e proprietari di contenuti, questa relazione asimmetrica costituisce una minaccia critica al business, poiché i modelli AI addestrati sui loro contenuti possono ridurre direttamente il traffico organico e diminuire il valore della proprietà intellettuale.

Un Web Application Firewall (WAF) funziona come reverse proxy posizionato tra utenti e web server, ispezionando ogni richiesta HTTP in tempo reale per filtrare il traffico indesiderato sulla base di regole configurabili. Diversamente da robots.txt, che si affida alla conformità volontaria dei crawler, i WAF applicano la protezione a livello di infrastruttura, risultando molto più efficaci nel controllo dell’accesso dei crawler AI. Il seguente confronto illustra come i WAF si differenziano dagli approcci di sicurezza tradizionali:

| Funzionalità | Robots.txt | Firewall tradizionale | WAF moderno |

|---|---|---|---|

| Livello di enforcement | Consulenza/Volontario | Blocco basato su IP | Ispezione a livello applicativo |

| Rilevamento crawler AI | Solo user-agent matching | Riconoscimento bot limitato | Analisi comportamentale + fingerprinting |

| Adattamento in tempo reale | File statico | Aggiornamenti manuali richiesti | Threat intelligence continua |

| Controllo granulare | Solo a livello di percorso | Ampie range di IP | Policy a livello di richiesta |

| Machine learning | Nessuno | Nessuno | Classificazione avanzata dei bot |

I WAF offrono classificazione granulare dei bot usando device fingerprinting, analisi comportamentale e machine learning per profilare i bot in base a intento e sofisticazione, consentendo un controllo molto più sfumato rispetto alle semplici regole allow/deny.

I crawler AI si suddividono in tre categorie distinte, ciascuna con minacce diverse e strategie di mitigazione differenti. I crawler di training come GPTBot, ClaudeBot e Google-Extended raccolgono sistematicamente contenuti web per creare dataset per lo sviluppo di modelli linguistici di grandi dimensioni, rappresentando circa l’80% di tutto il traffico dei crawler AI e non restituendo alcun valore di referral agli editori. I crawler di ricerca e citazione come OAI-SearchBot e PerplexityBot indicizzano i contenuti per esperienze di ricerca AI e possono fornire qualche traffico di referral tramite citazioni, sebbene a volumi molto inferiori rispetto ai motori di ricerca tradizionali. Gli user-triggered fetchers si attivano solo quando gli utenti richiedono specificamente contenuti tramite assistenti AI, operando a volumi minimi con richieste una tantum anziché pattern di crawling sistematici. Il panorama delle minacce include:

I WAF moderni utilizzano metodi tecnici sofisticati che vanno ben oltre il semplice matching della stringa user-agent per identificare e classificare i crawler AI con elevata accuratezza. Questi sistemi usano analisi comportamentale per esaminare pattern di richiesta, inclusi velocità di crawl, sequenze di richieste e modalità di gestione delle risposte che distinguono i bot dagli utenti umani. Le tecniche di device fingerprinting analizzano header HTTP, firme TLS e caratteristiche del browser per individuare user agent spoofati che tentano di bypassare le difese tradizionali. I modelli di machine learning addestrati su milioni di richieste possono rilevare firme emergenti di crawler e nuove tattiche bot in tempo reale, adattandosi alle minacce senza bisogno di aggiornamenti manuali delle regole. Inoltre, i WAF possono verificare la legittimità dei crawler incrociando gli indirizzi IP delle richieste con range IP pubblicati dalle principali aziende AI—OpenAI pubblica IP verificati su https://openai.com/gptbot.json, mentre Amazon li fornisce su https://developer.amazon.com/amazonbot/ip-addresses/—garantendo che solo i crawler autenticati da fonti legittime siano autorizzati.

Implementare efficaci regole WAF per crawler AI richiede un approccio multilivello che combini blocco user-agent, verifica IP e policy comportamentali. Il seguente esempio di codice mostra una configurazione base di regole WAF che blocca i crawler di training noti consentendo invece la ricerca legittima:

# WAF Rule: Block AI Training Crawlers

Rule Name: Block-AI-Training-Crawlers

Condition 1: HTTP User-Agent matches (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Action: Block (return 403 Forbidden)

# WAF Rule: Allow Verified Search Crawlers

Rule Name: Allow-Verified-Search-Crawlers

Condition 1: HTTP User-Agent matches (OAI-SearchBot|PerplexityBot)

Condition 2: Source IP in verified IP range

Action: Allow

# WAF Rule: Rate Limit Suspicious Bot Traffic

Rule Name: Rate-Limit-Suspicious-Bots

Condition 1: Request rate exceeds 100 requests/minute

Condition 2: User-Agent contains bot indicators

Condition 3: No verified IP match

Action: Challenge (CAPTCHA) or Block

Le organizzazioni dovrebbero impostare la precedenza delle regole con attenzione, assicurando che regole più specifiche (come la verifica IP per crawler legittimi) vengano eseguite prima delle regole di blocco generali. È essenziale testare e monitorare regolarmente l’efficacia delle regole, poiché le stringhe user-agent e i range IP dei crawler evolvono frequentemente. Molti provider WAF offrono set di regole predefiniti progettati specificamente per la gestione dei crawler AI, riducendo la complessità di implementazione e mantenendo una protezione completa.

La verifica IP e allowlisting rappresenta il metodo più affidabile per distinguere i crawler AI legittimi dalle richieste spoofate, poiché le stringhe user-agent possono essere facilmente falsificate mentre gli indirizzi IP sono molto più difficili da falsificare su larga scala. Le principali aziende AI pubblicano range IP ufficiali in formato JSON, consentendo la verifica automatica senza manutenzione manuale—OpenAI fornisce elenchi IP separati per GPTBot, OAI-SearchBot e ChatGPT-User, mentre Amazon mantiene una lista completa per Amazonbot. Le regole WAF possono essere configurate per consentire solo le richieste provenienti da questi range IP verificati, impedendo efficacemente che i malintenzionati bypassino le restrizioni cambiando semplicemente lo user-agent. Per chi utilizza blocco a livello server via .htaccess o regole firewall, combinare verifica IP e matching user-agent offre una protezione defense-in-depth che opera indipendentemente dalla configurazione WAF. Inoltre, alcuni crawler rispettano meta tag HTML come <meta name="robots" content="noarchive">, che segnala ai crawler conformi che i contenuti non devono essere utilizzati per il training dei modelli, offrendo un meccanismo di controllo supplementare per chi desidera una protezione granulare a livello di pagina.

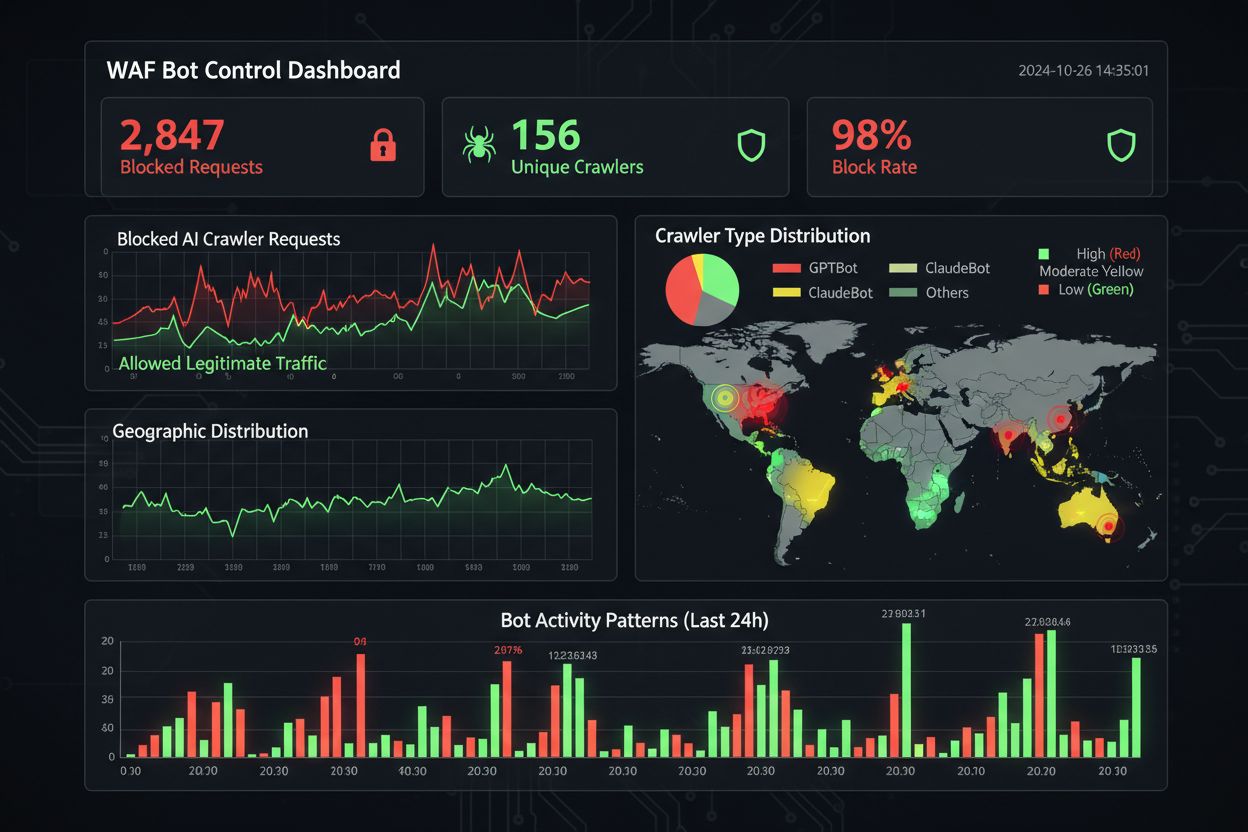

Un efficace monitoraggio e compliance richiede visibilità continua sull’attività dei crawler e verifica che le regole di blocco funzionino come previsto. Le organizzazioni dovrebbero analizzare regolarmente i log di accesso del server per identificare quali crawler stanno accedendo ai siti e se quelli bloccati continuano a fare richieste—i log Apache si trovano tipicamente in /var/log/apache2/access.log mentre quelli Nginx in /var/log/nginx/access.log, e filtrare con grep consente di identificare rapidamente pattern sospetti. Le piattaforme di analytics distinguono sempre più il traffico bot da quello umano, permettendo di misurare l’impatto del blocco dei crawler su metriche legittime come bounce rate, conversioni e performance SEO. Strumenti come Cloudflare Radar offrono visibilità globale sui pattern di traffico bot AI e possono individuare crawler emergenti non ancora nella blocklist. Dal punto di vista della compliance, i log WAF generano audit trail che dimostrano che le organizzazioni hanno implementato misure di sicurezza ragionevoli per proteggere dati dei clienti e proprietà intellettuale, sempre più importante per GDPR, CCPA e altri regolamenti sulla protezione dei dati. Revisioni trimestrali della blocklist crawler sono essenziali, poiché nuovi crawler AI emergono regolarmente e quelli esistenti aggiornano le stringhe user-agent—il progetto community ai.robots.txt su GitHub

è una risorsa preziosa per tracciare le minacce emergenti.

Bilanciare protezione dei contenuti e obiettivi di business richiede un’analisi attenta di quali crawler bloccare e quali consentire, poiché un blocco troppo aggressivo può ridurre la visibilità nei nuovi canali di discovery guidati dall’AI. Bloccare i crawler di training come GPTBot e ClaudeBot protegge la proprietà intellettuale ma non ha impatto diretto sul traffico, poiché questi crawler non inviano mai referral. Tuttavia, bloccare i crawler di ricerca come OAI-SearchBot e PerplexityBot può ridurre la visibilità nei risultati di ricerca AI dove gli utenti cercano attivamente citazioni e fonti—un compromesso che dipende dalla strategia di contenuto e dal pubblico. Alcuni editori stanno esplorando approcci alternativi, come consentire i crawler di ricerca e bloccare quelli di training, o implementare modelli pay-per-crawl in cui le aziende AI compensano gli editori per l’accesso ai contenuti. Strumenti come AmICited.com aiutano gli editori a tracciare se i loro contenuti vengono citati nelle risposte AI, fornendo dati per guidare le decisioni di blocco. La configurazione WAF ottimale dipende dal modello di business: gli editori di notizie possono dare priorità al blocco dei crawler di training per proteggere i contenuti, consentendo invece i crawler di ricerca per la visibilità, mentre le SaaS company potrebbero bloccare tutti i crawler AI per evitare che i concorrenti analizzino prezzi e funzionalità. Monitorare regolarmente pattern di traffico e metriche di ricavo dopo aver implementato le regole WAF assicura che la strategia di protezione sia allineata ai reali risultati di business.

Nel confrontare soluzioni WAF per la gestione dei crawler AI, le organizzazioni dovrebbero valutare alcune capacità chiave che distinguono le piattaforme enterprise da quelle di base. Cloudflare AI Crawl Control si integra con il suo WAF per offrire regole predefinite per i crawler AI noti, con la possibilità di bloccare, consentire o implementare la monetizzazione pay-per-crawl per specifici crawler—l’ordine di precedenza della piattaforma garantisce che le regole WAF vengano eseguite prima degli altri layer di sicurezza. AWS WAF Bot Control offre livelli di protezione base e mirata, con quest’ultima che utilizza interrogazione browser, fingerprinting e euristiche comportamentali per rilevare bot sofisticati che non si autoidentificano, oltre a un’analisi opzionale tramite machine learning delle statistiche di traffico. Azure WAF propone funzionalità simili con set di regole gestite, sebbene meno specializzate sull’AI rispetto a Cloudflare o AWS. Oltre alle grandi piattaforme, soluzioni specializzate di bot management come DataDome offrono modelli di machine learning avanzati addestrati specificamente sul comportamento dei crawler AI, seppur a costi maggiori. La scelta tra le soluzioni dipende dall’infrastruttura esistente, dal budget e dal livello di sofisticazione richiesto—chi già usa Cloudflare beneficia dell’integrazione nativa, mentre i clienti AWS possono sfruttare Bot Control all’interno dell’infrastruttura WAF esistente.

Le best practice per la gestione dei crawler AI enfatizzano un approccio defense-in-depth che combini diversi meccanismi di controllo invece di affidarsi a una sola soluzione. Le organizzazioni dovrebbero effettuare revisioni trimestrali delle blocklist per rilevare nuovi crawler e stringhe user-agent aggiornate, mantenere analisi dei log server per verificare che i crawler bloccati non stiano bypassando le regole, e testare regolarmente le configurazioni WAF per assicurarsi che le regole vengano eseguite nell’ordine corretto. Il futuro della tecnologia WAF vedrà sempre più l’integrazione di rilevamento delle minacce basato su AI che si adatta in tempo reale alle nuove tattiche dei crawler, con l’integrazione in ecosistemi di sicurezza più ampi per una protezione contestuale. Con l’inasprimento delle normative su scraping dati e sourcing dei dati AI, i WAF diventeranno strumenti essenziali di compliance più che semplici feature di sicurezza opzionali. È importante iniziare ora a implementare regole WAF complete per i crawler AI, prima che minacce emergenti come agenti AI browser-based e crawler headless diventino diffusi—il costo dell’inazione, misurato in traffico perso, analytics compromessi e potenziale esposizione legale, supera di gran lunga l’investimento richiesto per un’infrastruttura di protezione robusta.

Robots.txt è un file consultivo che si basa sul rispetto volontario delle direttive da parte dei crawler, mentre le regole WAF sono applicate a livello di infrastruttura e si applicano a tutte le richieste indipendentemente dalla conformità del crawler. I WAF offrono rilevamento e blocco in tempo reale, mentre robots.txt è statico e facilmente aggirabile dai crawler non conformi.

Sì, molti crawler AI ignorano le direttive di robots.txt perché sono progettati per massimizzare la raccolta di dati per l'addestramento. Mentre i crawler ben comportati delle grandi aziende generalmente rispettano robots.txt, i malintenzionati e alcuni nuovi crawler non lo fanno. Ecco perché le regole WAF offrono una protezione più affidabile.

Controlla i log di accesso del server (di solito in /var/log/apache2/access.log o /var/log/nginx/access.log) per le stringhe user-agent contenenti identificatori di bot. Strumenti come Cloudflare Radar offrono visibilità globale sui pattern di traffico dei crawler AI e le piattaforme di analisi distinguono sempre più il traffico bot da quello umano.

Bloccare i crawler di training come GPTBot non ha impatto diretto sulla SEO poiché non inviano traffico di riferimento. Tuttavia, bloccare crawler di ricerca come OAI-SearchBot può ridurre la visibilità nei risultati di ricerca AI. Google AI Overviews segue le regole standard di Googlebot, quindi bloccare Google-Extended non influisce sull'indicizzazione di ricerca regolare.

Cloudflare AI Crawl Control, AWS WAF Bot Control e Azure WAF offrono tutte soluzioni efficaci. Cloudflare offre le funzionalità più specifiche per l'AI con regole predefinite e opzioni pay-per-crawl. AWS offre rilevamento avanzato tramite machine learning, mentre Azure propone una solida serie di regole gestite. Scegli in base all'infrastruttura esistente e al budget.

Rivedi e aggiorna le regole WAF almeno trimestralmente, poiché nuovi crawler AI emergono regolarmente e quelli esistenti aggiornano le stringhe user-agent. Monitora il progetto ai.robots.txt su GitHub per le minacce emergenti e controlla mensilmente i log del server per individuare nuovi crawler che accedono al sito.

Sì, è una strategia comune. Puoi configurare le regole WAF per bloccare i crawler di training come GPTBot e ClaudeBot, consentendo invece quelli di ricerca come OAI-SearchBot e PerplexityBot. Così proteggi i tuoi contenuti dall'essere usati per l'addestramento dei modelli mantenendo la visibilità nei risultati di ricerca AI.

Il prezzo dei WAF varia a seconda del provider. Cloudflare offre WAF a partire da 20$/mese con funzionalità AI Crawl Control. AWS WAF applica tariffe per ogni web ACL e regola, tipicamente 5-10$/mese per la protezione di base. Azure WAF è incluso con Application Gateway. I costi di implementazione sono minimi rispetto al valore di protezione dei tuoi contenuti e al mantenimento di analytics affidabili.

AmICited traccia l'attività dei crawler AI e monitora come i tuoi contenuti vengono citati su ChatGPT, Perplexity, Google AI Overviews e altre piattaforme AI. Ottieni visibilità sulla tua presenza AI e comprendi quali crawler accedono ai tuoi contenuti.

Scopri come permettere o bloccare selettivamente i crawler AI in base agli obiettivi aziendali. Implementa l’accesso differenziale dei crawler per proteggere i ...

Scopri come il controllo dei crawler AI di Cloudflare, basato sull’edge, ti aiuta a monitorare, controllare e monetizzare l’accesso dei crawler AI ai tuoi conte...

Scopri come utilizzare robots.txt per controllare quali bot IA accedono ai tuoi contenuti. Guida completa al blocco di GPTBot, ClaudeBot e altri crawler IA con ...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.