Comprendere i Fattori della Velocità di Indicizzazione AI

La velocità di indicizzazione AI determina quanto rapidamente i tuoi contenuti diventano individuabili nei motori di ricerca alimentati da intelligenza artificiale come ChatGPT, Perplexity e le AI Overviews di Google. A differenza dei motori di ricerca tradizionali che si limitano ad abbinare le parole chiave alle pagine, i sistemi AI devono eseguire il crawling, comprendere e sintetizzare i tuoi contenuti per generare risposte accurate. La velocità con cui ciò accade dipende da numerosi fattori interconnessi che influenzano direttamente la tua visibilità nelle risposte generate dall’AI e la capacità di catturare traffico dalle piattaforme di ricerca AI.

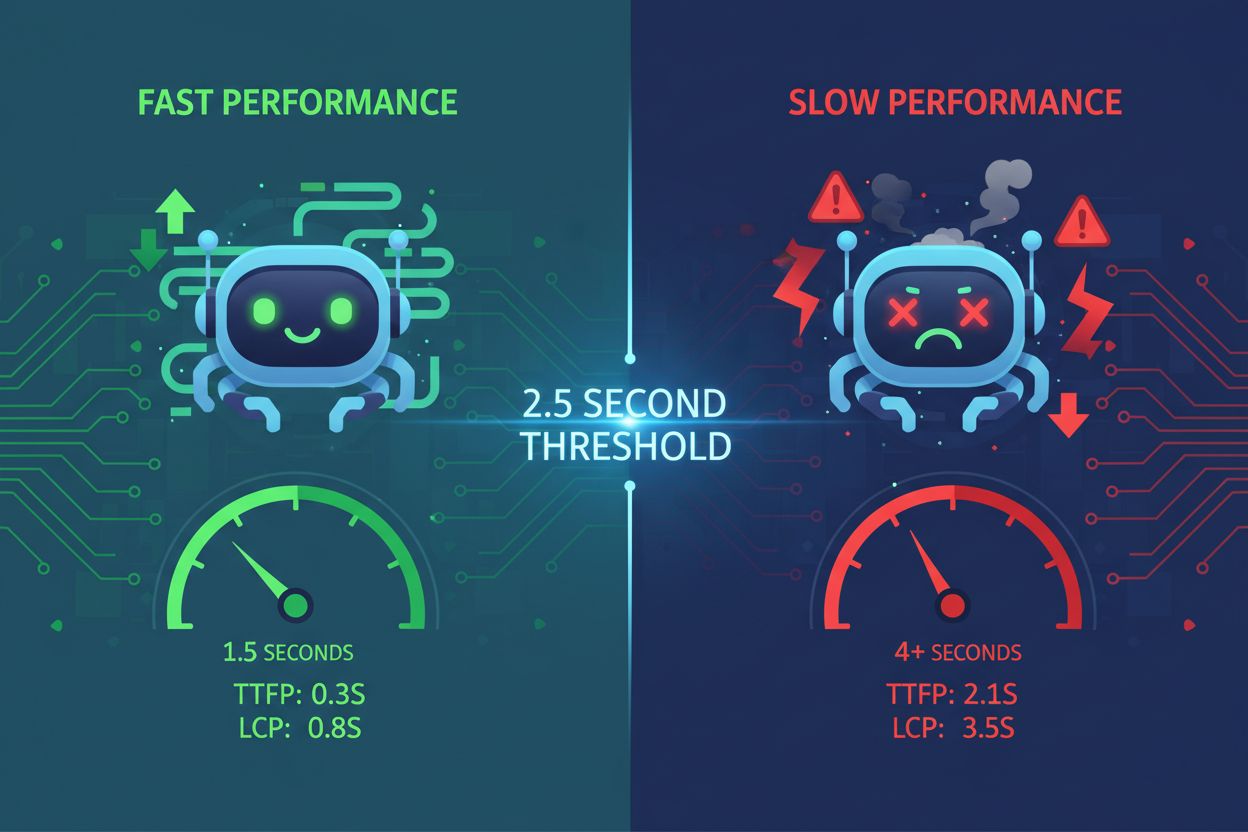

La velocità di caricamento della pagina è uno dei fattori più critici che influenzano la velocità di indicizzazione AI. I crawler AI operano con vincoli di risorse e limiti di tempo stringenti—tipicamente tra 1-5 secondi per richiesta pagina. Quando il tuo sito web è lento, i crawler impiegano più tempo a recuperare i contenuti, il che significa che meno pagine vengono indicizzate nell’arco della finestra di crawling assegnata. Questo crea un effetto a catena in cui le scarse performance riducono direttamente il numero di pagine che i sistemi AI possono processare e indicizzare.

I siti lenti segnalano una scarsa manutenzione ai sistemi AI. Quando le pagine impiegano troppo tempo a caricarsi, i crawler AI possono andare in timeout prima di accedere ai contenuti effettivi, lasciando indicizzato solo lo scheletro HTML. Questo è particolarmente problematico per i siti ricchi di JavaScript dove i contenuti sono caricati in modo dinamico lato client. Il processo di rendering in due fasi richiesto dal JavaScript aggiunge una latenza significativa, rendendo più difficile per i sistemi AI estrarre informazioni utili. Comprimere le immagini, minimizzare il codice, implementare il lazy loading e usare Content Delivery Network (CDN) può migliorare drasticamente i tempi di caricamento e permettere ai crawler AI di processare più pagine in modo efficiente.

| Metrica di Performance | Obiettivo | Impatto sull’Indicizzazione AI |

|---|

| Tempo di caricamento pagina | Meno di 3 secondi | Permette di eseguire il crawling di più pagine per sessione |

| Largest Contentful Paint (LCP) | Meno di 2,5 secondi | Garantisce che l’AI veda rapidamente contenuti significativi |

| First Input Delay (FID) | Sotto i 100ms | Migliora la reattività del crawler |

| Cumulative Layout Shift (CLS) | Vicino a zero | Previene errori nell’estrazione dei contenuti |

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Vincoli del Crawl Budget

Il crawl budget si riferisce al numero limitato di pagine che i sistemi AI possono visitare in un determinato periodo di tempo. Ogni sito riceve una quota finita di crawl dai motori di ricerca AI, in modo simile a quanto fa Google con il suo crawl budget. Quando il tuo crawl budget si esaurisce, i sistemi AI smettono di indicizzare nuovi contenuti, indipendentemente dalla qualità. Questa limitazione diventa particolarmente problematica per i siti di grandi dimensioni con centinaia o migliaia di pagine in competizione per risorse di indicizzazione limitate.

Ottimizzare l’allocazione del crawl budget è essenziale per una indicizzazione AI più veloce. Dovresti dare priorità alle pagine di maggior valore—quelle che generano ricavi, attraggono traffico o contengono informazioni critiche—a scapito di pagine a basso valore come filtri di categoria duplicati o pagine tag ridondanti. Utilizzando in modo strategico i file robots.txt, puoi bloccare i crawler AI dall’accesso a pagine che non necessitano di indicizzazione, preservando il crawl budget per i contenuti che contano. Inoltre, mantenere una sitemap XML aggiornata e utilizzare una struttura di linking interno appropriata aiuta i sistemi AI a scoprire più rapidamente le tue pagine importanti, garantendo che vengano indicizzate prima che il crawl budget si esaurisca.

Qualità e Originalità dei Contenuti

I sistemi AI penalizzano fortemente contenuti duplicati e poco approfonditi, rallentando di molto l’indicizzazione. Quando i crawler AI incontrano contenuti privi di originalità o sostanza, danno minor priorità al crawling di pagine simili sul tuo sito. Questo perché i sistemi AI valutano la qualità dei contenuti utilizzando i segnali E-E-A-T (Esperienza, Competenza, Autorevolezza e Affidabilità). I contenuti che appaiono come poco curati, generati dall’AI senza revisione umana o copiati da altre fonti ricevono priorità più bassa nella coda di indicizzazione.

Contenuti di alta qualità e completi vengono indicizzati più velocemente dai sistemi AI. Contenuti che superano le 3.000 parole e rispondono in modo esaustivo alle domande degli utenti da più prospettive ricevono priorità nell’indicizzazione. I sistemi AI favoriscono i contenuti che includono dati di supporto, statistiche, esempi reali e case study perché questi elementi dimostrano competenza e affidabilità. Quando crei contenuti originali e ben documentati che offrono reale valore, i crawler AI allocano più risorse per indicizzare le tue pagine, portando a una scoperta e inclusione più rapida nelle risposte AI.

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Configurazione Tecnica SEO

Una configurazione errata del robots.txt può bloccare accidentalmente i crawler AI dall’indicizzare i tuoi contenuti. Molti siti impediscono involontariamente ai bot dei motori di ricerca AI di accedere alle pagine a causa di una cattiva configurazione dei file robots.txt. Diversi sistemi AI utilizzano identificativi di crawler differenti—ChatGPT usa OAI-SearchBot, Perplexity utilizza PerplexityBot, altri usano AndiBot o ExaBot. Se il tuo robots.txt non consente esplicitamente questi crawler, non potranno indicizzare i tuoi contenuti, a prescindere dalla qualità o pertinenza.

Una struttura HTML pulita e un markup semantico accelerano l’indicizzazione AI. I crawler AI hanno difficoltà con implementazioni pesanti in JavaScript e strutture annidate complesse. Usare tag semantici HTML5 (article, section, nav), una gerarchia di heading corretta (H1-H6), link descrittivi e alt text per le immagini rende i tuoi contenuti immediatamente accessibili ai sistemi AI. Framework di server-side rendering (SSR) come Next.js o Gatsby pre-renderizzano i contenuti sul server, assicurando che i crawler AI ricevano pagine già complete senza bisogno di eseguire JavaScript, accelerando notevolmente l’indicizzazione.

Indicizzazione del Database e Infrastruttura

Un database sovra-indicizzato crea latenza che rallenta la velocità di indicizzazione AI. Quando i database hanno indici eccessivi, ridondanti o sovrapposti, ogni operazione di inserimento, aggiornamento e cancellazione deve aggiornare più indici, creando colli di bottiglia nelle performance di scrittura. Questo overhead impatta direttamente la velocità con cui il tuo CMS può servire le pagine ai crawler AI. Indici ridondanti occupano spazio, introducono latenza e costringono i query planner a decisioni subottimali, tutto ciò rallenta la consegna dei contenuti ai sistemi AI.

Ottimizzare gli indici del database migliora la velocità di consegna dei contenuti ai crawler AI. Esegui regolarmente audit del database per individuare indici inutilizzati o ridondanti usando strumenti come pg_stat_user_indexes (PostgreSQL) o sys.schema_unused_indexes (MySQL). Rimuovi gli indici non utilizzati da settimane o mesi, consolida quelli sovrapposti e assicurati che il tuo schema sia coerente con i pattern di query attuali. Un database ben ottimizzato serve i contenuti più velocemente ai crawler AI, abilitando un’indicizzazione più rapida e una maggiore inclusione nelle risposte generate dall’AI.

Implementazione del Markup Schema

Un markup schema assente o incompleto ritarda la comprensione e l’indicizzazione AI dei contenuti. Il markup schema fornisce dati strutturati che aiutano i sistemi AI a comprendere rapidamente il contesto, il significato e le relazioni dei tuoi contenuti. Senza una implementazione corretta dello schema, i crawler AI devono dedicare tempo aggiuntivo per inferire la struttura dei contenuti ed estrarre le informazioni chiave. Questo tempo di elaborazione extra riduce la velocità di indicizzazione perché i crawler allocano più risorse per ogni pagina.

Implementare un markup schema completo accelera l’indicizzazione AI. Schema FAQ, How-To, Article e Prodotto forniscono ai sistemi AI informazioni pre-strutturate che possono essere immediatamente comprese e indicizzate. Quando includi informazioni sull’autore, date di pubblicazione, valutazioni e altri dati strutturati, i sistemi AI possono categorizzare e indicizzare i tuoi contenuti rapidamente senza ulteriore elaborazione. Le ricerche dimostrano che il 36,6% delle parole chiave di ricerca attiva featured snippet derivati dal markup schema, mostrando come i dati strutturati incidano direttamente sulla visibilità AI e sulla velocità di indicizzazione.

Struttura dei Link Interni

Una scarsa struttura di linking interno impedisce ai crawler AI di scoprire i tuoi contenuti in modo efficiente. I link interni agiscono come una mappa che guida i crawler AI attraverso l’architettura del tuo sito. Senza una strategia di linking interno, i sistemi AI possono avere difficoltà a scoprire pagine importanti, soprattutto contenuti nuovi sepolti in profondità nella struttura del sito. Questo ritardo nella scoperta si traduce direttamente in una indicizzazione più lenta perché i crawler devono impiegare più tempo per trovare le pagine da indicizzare.

Un linking interno strategico accelera la scoperta e l’indicizzazione AI dei contenuti. Collegare nuovi contenuti da pagine esistenti rilevanti aiuta i crawler AI a trovarli e indicizzarli più rapidamente. Utilizzare anchor text descrittivi che indicano chiaramente il contenuto della pagina collegata aiuta i sistemi AI a comprendere le relazioni e il contesto dei contenuti. Una struttura di linking interno corretta garantisce che le pagine di maggior valore ricevano più attenzione dal crawling, portando a una indicizzazione più veloce e a una priorità più alta nelle risposte AI.

Esperienza Utente e Accessibilità dei Contenuti

Una scarsa esperienza utente segnala ai sistemi AI che i tuoi contenuti potrebbero non essere di valore. Alti tassi di rimbalzo, brevi sessioni e metriche di coinvolgimento basse indicano ai crawler AI che i tuoi contenuti non soddisfano le esigenze degli utenti. I sistemi AI utilizzano sempre più segnali comportamentali per valutare la qualità dei contenuti, e le pagine con una cattiva UX ricevono una priorità di indicizzazione più bassa. Quando gli utenti abbandonano rapidamente le tue pagine, i sistemi AI interpretano ciò come un segnale di scarsa qualità, rallentando l’inclusione nelle risposte AI.

Una struttura dei contenuti user-friendly migliora la velocità di indicizzazione AI. Contenuti formattati con paragrafi brevi (2-3 frasi), sottotitoli descrittivi, elenchi puntati, liste numerate e tabelle sono più facili da processare sia per gli utenti che per i sistemi AI. Questa miglior scansibilità permette ai crawler AI di estrarre rapidamente le informazioni chiave e comprendere la struttura dei contenuti senza elaborazioni intensive. Quando i tuoi contenuti sono ben organizzati e accessibili, i sistemi AI possono indicizzarli più velocemente e con maggiore fiducia nella qualità e rilevanza.

Infrastruttura Hosting e Tempo di Risposta del Server

Un’infrastruttura di hosting lenta crea colli di bottiglia che ritardano l’indicizzazione AI. Gli ambienti di hosting condiviso spesso hanno risorse limitate e tempi di risposta più lenti, il che significa che i crawler AI devono aspettare più tempo per ogni pagina da caricare. Questo tempo di attesa riduce il numero di pagine che possono essere indicizzate nella finestra temporale assegnata al crawler. Il tempo di risposta del server impatta direttamente l’efficienza del crawling—ogni millisecondo di ritardo riduce il totale di pagine indicizzate per sessione.

Passare a un hosting veloce e scalabile accelera l’indicizzazione AI. Hosting WordPress gestiti, soluzioni VPS e piattaforme cloud come Google Cloud o AWS offrono tempi di risposta del server più rapidi e una migliore allocazione delle risorse. CDN come Cloudflare memorizzano i contenuti in cache a livello globale e servono le pagine più velocemente ai crawler indipendentemente dalla loro posizione geografica. Quando la tua infrastruttura di hosting consegna rapidamente le pagine, i crawler AI possono processare più contenuti per sessione, portando a una indicizzazione globale più veloce e a una maggiore visibilità nelle risposte AI.

Monitoraggio e Ottimizzazione

Il monitoraggio continuo delle performance di indicizzazione AI consente una ottimizzazione proattiva. Strumenti come Google Search Console, AI Results Tracker di SE Ranking e Peec.ai ti aiutano a tracciare quanto velocemente i tuoi contenuti appaiono nei risultati di ricerca AI e a identificare le pagine non ancora indicizzate. Monitorando queste metriche, puoi individuare colli di bottiglia e implementare miglioramenti mirati che influiscono direttamente sulla velocità di indicizzazione.

Audit e aggiornamenti regolari mantengono ottimale la velocità di indicizzazione AI. Effettua periodicamente audit delle performance utilizzando strumenti come Google PageSpeed Insights, GTmetrix e WebPageTest per identificare i colli di bottiglia. Aggiorna regolarmente la tua sitemap XML, aggiorna i contenuti per mantenere segnali di freschezza e ottimizza costantemente database e infrastruttura. Un’ottimizzazione costante garantisce che la velocità di indicizzazione AI rimanga competitiva e che i tuoi contenuti continuino ad apparire rapidamente nelle risposte generate dall’AI.