Punteggio di Perplessità

Il Punteggio di Perplessità misura la prevedibilità del testo nei modelli linguistici. Scopri come questa metrica chiave dell'NLP quantifica l'incertezza del mo...

Scopri cosa significa il punteggio di perplessità nei contenuti e nei modelli linguistici. Comprendi come misura l’incertezza del modello, la precisione predittiva e la valutazione della qualità del testo.

Il punteggio di perplessità è una metrica che misura quanto bene un modello linguistico prevede la parola successiva in una sequenza. Quantifica l’incertezza del modello nelle predizioni, con punteggi più bassi che indicano maggiore sicurezza e migliori prestazioni predittive.

Il punteggio di perplessità è una metrica fondamentale utilizzata nell’elaborazione del linguaggio naturale e nel machine learning per valutare quanto bene un modello linguistico si comporta nella previsione del testo. In sostanza, misura il grado di incertezza che un modello ha nell’assegnare probabilità alle parole in una sequenza. La metrica è particolarmente importante per comprendere le prestazioni del modello in attività come la generazione di testo, la traduzione automatica e l’IA conversazionale. Quando un modello linguistico elabora un testo, assegna valori di probabilità alle possibili parole successive in base al contesto fornito dalle parole precedenti. La perplessità cattura quanto il modello sia sicuro in queste previsioni, rendendola uno strumento di valutazione essenziale per sviluppatori e ricercatori che lavorano con grandi modelli linguistici.

Il concetto di perplessità deriva dalla teoria dell’informazione, dove rappresenta una misura di incertezza nelle distribuzioni di probabilità. Nel contesto dei modelli linguistici, punteggi di perplessità più bassi indicano che il modello è più sicuro delle sue predizioni e quindi produce testo più coerente e fluido. Al contrario, punteggi di perplessità più alti suggeriscono che il modello è incerto su quale parola dovrebbe seguire, portando potenzialmente a risultati meno coerenti o meno pertinenti. Comprendere questa metrica è cruciale per chiunque lavori con la generazione di contenuti tramite IA, poiché influisce direttamente sulla qualità e l’affidabilità del testo generato.

Il calcolo del punteggio di perplessità coinvolge diversi passaggi matematici che trasformano le previsioni di probabilità grezze in una metrica unica e interpretabile. La formula fondamentale si basa sull’entropia delle predizioni del modello, che misura il livello di incertezza nell’output. La rappresentazione matematica è: Perplessità = 2^H(p), dove H(p) rappresenta l’entropia delle predizioni del modello. Questa formula mostra che la perplessità deriva direttamente dall’entropia, con valori di entropia più bassi che producono punteggi di perplessità inferiori.

Il processo pratico di calcolo segue un approccio strutturato che coinvolge diversi passaggi. Innanzitutto, il modello linguistico prevede la probabilità del token successivo in base al testo di input e al contesto fornito. In secondo luogo, si applica la trasformazione logaritmica a queste probabilità, aiutando a convertirle in una misura più utile per l’analisi. In terzo luogo, si calcola la media della log-verosimiglianza di tutte le parole previste nel set di test su tutta la sequenza. Infine, si esegue l’esponenziazione della media della log-verosimiglianza per ottenere il punteggio finale di perplessità. La formula completa per calcolare la perplessità per una sequenza di parole è: Perplessità = exp(-1/N × Σ log p(w_i | w_{i-1}, w_{i-2}, …, w_1)), dove p(w_i | w_{i-1}, …, w_1) è la probabilità prevista della i-esima parola date tutte le parole precedenti, e N è il numero totale di parole nella sequenza.

| Fase di calcolo | Descrizione | Scopo |

|---|---|---|

| Predizione del token | Il modello prevede la probabilità della parola successiva | Stabilire le previsioni di base |

| Trasformazione logaritmica | Applicare il logaritmo alle probabilità | Convertire in misura utile |

| Calcolo della media | Calcolare la media della log-verosimiglianza sulla sequenza | Normalizzare sulla lunghezza del testo |

| Esponenziazione | Elevare e alla potenza della media negativa | Ottenere il punteggio finale di perplessità |

Il punteggio di perplessità funge da metrica di valutazione fondamentale per analizzare le prestazioni di un modello linguistico su più dimensioni. La metrica è importante perché offre una valutazione diretta dell’accuratezza predittiva, aiutando gli sviluppatori a capire quanto bene un modello può prevedere le parole e generare testo coerente. Un punteggio di perplessità basso indica che il modello fa previsioni sicure e probabilmente genera contenuti fluenti e contestualmente appropriati. Questo è particolarmente prezioso per applicazioni come chatbot, assistenti virtuali e sistemi di generazione di contenuti in cui la qualità del testo incide direttamente sull’esperienza utente. Inoltre, la perplessità aiuta a valutare il livello di fiducia del modello nelle sue previsioni: se la perplessità è alta, il modello è incerto sulla parola successiva, il che potrebbe portare a generazione di testo incoerente o non pertinente.

La metrica è anche essenziale per il confronto e la selezione dei modelli. Quando si valutano diversi modelli linguistici o si confrontano versioni dello stesso modello durante il fine-tuning, la perplessità fornisce una misura quantitativa di miglioramento o peggioramento. Gli sviluppatori possono usare i punteggi di perplessità per determinare se un modello è adatto a compiti specifici come generazione di testo, traduzione automatica, sintesi o risposta a domande. Inoltre, la perplessità consente una valutazione in tempo reale durante l’addestramento del modello, permettendo agli sviluppatori di valutare istantaneamente le prestazioni e apportare eventuali aggiustamenti. Questa capacità è particolarmente preziosa durante il fine-tuning, dove monitorare la perplessità aiuta a garantire che il modello migliori nella sicurezza delle previsioni invece che adattarsi eccessivamente ai dati di addestramento.

Comprendere come interpretare i punteggi di perplessità è essenziale per prendere decisioni informate sulle prestazioni del modello e sull’idoneità per applicazioni specifiche. Un punteggio di perplessità più basso indica che il modello è più sicuro nelle sue previsioni e generalmente genera testo di qualità superiore e più coerente. Ad esempio, un punteggio di perplessità di 15 suggerisce che il modello sta scegliendo tra circa 15 possibili parole ad ogni passaggio predittivo, indicando una fiducia relativamente alta. Al contrario, un punteggio di perplessità più alto di 50 o superiore suggerisce che il modello è incerto e considera molte più possibilità, il che spesso si traduce in output meno coerenti o meno pertinenti. L’interpretazione di ciò che costituisce un “buon” punteggio di perplessità dipende dal compito specifico, dal dataset e dall’architettura del modello valutato.

Tipi diversi di contenuto e modelli mostrano diverse gamme di perplessità di base. Ad esempio, i modelli addestrati su testo ben strutturato e formale come gli articoli di Wikipedia raggiungono tipicamente punteggi di perplessità più bassi rispetto a quelli addestrati su contenuti conversazionali o creativi. Quando si confrontano i punteggi di perplessità tra modelli diversi, è fondamentale assicurarsi che siano valutati sullo stesso dataset e usando lo stesso metodo di tokenizzazione, poiché questi fattori influenzano notevolmente i risultati. Un modello con un punteggio di perplessità di 20 su un dataset potrebbe non essere direttamente confrontabile con un altro modello con punteggio 25 su un dataset diverso. Inoltre, la lunghezza della sequenza influisce sui calcoli di perplessità: sequenze più lunghe tendono a produrre punteggi più stabili, mentre sequenze più corte possono mostrare maggiore varianza e produrre valori anomali che alterano i risultati.

Anche se il punteggio di perplessità è una metrica preziosa, presenta importanti limitazioni da comprendere quando si valutano i modelli linguistici. Una delle principali limitazioni è che la perplessità non misura la comprensione: un modello con perplessità bassa può comunque produrre testo incoerente, non pertinente o fattualmente errato. La metrica misura solo la capacità del modello di prevedere la parola successiva in base a schemi statistici nei dati di addestramento, non se il modello comprenda davvero il significato o il contesto del contenuto. Ciò significa che un modello potrebbe ottenere ottimi punteggi di perplessità pur generando testo grammaticalmente corretto ma semanticamente privo di senso o errato dal punto di vista dei fatti.

Un’altra considerazione importante è che la perplessità non cattura efficacemente le dipendenze a lungo termine. La metrica si basa sulle previsioni immediate delle parole e potrebbe non riflettere quanto bene un modello mantenga coerenza e consistenza su sequenze di testo più lunghe. Inoltre, la sensibilità alla tokenizzazione è un fattore critico: diversi metodi di tokenizzazione possono influenzare significativamente i punteggi di perplessità, rendendo problematici i confronti diretti tra modelli che utilizzano tokenizzatori diversi. Ad esempio, i modelli a livello di carattere potrebbero ottenere perplessità più basse rispetto a quelli a livello di parola, ma ciò non significa necessariamente che generino testo di qualità superiore. Infine, la perplessità è pensata principalmente per modelli linguistici autoregressivi o causali e non è ben definita per modelli mascherati come BERT, che utilizzano meccanismi di previsione differenti.

Per ottenere una valutazione completa delle prestazioni di un modello linguistico, la perplessità dovrebbe essere utilizzata insieme ad altre metriche di valutazione e non come misura unica. BLEU, ROUGE e METEOR sono metriche ampiamente utilizzate che confrontano il testo generato con testi di riferimento e sono particolarmente utili per compiti come traduzione automatica e sintesi. La valutazione umana da parte di giudici qualificati offre approfondimenti su aspetti che le metriche automatiche non possono cogliere, inclusi fluidità, pertinenza, coerenza e qualità complessiva. La valutazione dell’accuratezza fattuale tramite sistemi di QA basati su conoscenza o framework di fact-checking assicura che il contenuto generato sia non solo fluente ma anche corretto. Metriche di diversità e creatività come tasso di ripetizione, punteggio di novità ed entropia misurano quanto il testo generato sia vario e originale, aspetto importante per applicazioni creative.

Inoltre, valutare i modelli per bias e imparzialità garantisce la loro sicurezza in applicazioni reali dove bias dannosi potrebbero causare problemi significativi. Combinando la perplessità con queste metriche aggiuntive, gli sviluppatori possono valutare meglio la precisione predittiva, la fluidità e la usabilità reale di un modello. Questo approccio completo permette di identificare modelli che non solo prevedono correttamente, ma lo fanno anche con sicurezza, coerenza e affidabilità. La combinazione delle metriche offre un quadro più completo delle prestazioni del modello e aiuta a garantire che i modelli selezionati soddisfino i requisiti specifici delle applicazioni previste.

Il punteggio di perplessità è ampiamente utilizzato in numerose applicazioni reali in cui le prestazioni del modello linguistico incidono direttamente sull’esperienza utente e sulla qualità dei contenuti. Nelle applicazioni di generazione di testo, la perplessità aiuta a garantire che il contenuto generato sia coerente e fluido, confermando che le previsioni del modello siano sicure e contestualmente appropriate. Nei sistemi di traduzione automatica, la perplessità valuta quanto il modello di traduzione preveda bene la parola successiva nella lingua di destinazione, aspetto fondamentale per produrre traduzioni di qualità che mantengano significato e sfumature dalla lingua di origine. Nei chatbot e assistenti virtuali, una perplessità bassa assicura che le risposte siano fluide e contestuali, migliorando direttamente la soddisfazione e il coinvolgimento dell’utente.

I modelli di sintesi traggono beneficio dalla valutazione della perplessità perché garantisce che i riassunti generati siano leggibili e coerenti, mantenendo le informazioni essenziali del testo di origine. I creatori di contenuti e le piattaforme IA usano la perplessità per valutare la qualità dei contenuti generati dall’IA prima di pubblicarli o presentarli agli utenti. Con la crescente diffusione della generazione di contenuti tramite IA su motori di ricerca e piattaforme di risposta, comprendere e monitorare i punteggi di perplessità aiuta a garantire che i contenuti generati rispettino gli standard qualitativi. Le organizzazioni che lavorano con sistemi IA possono usare le metriche di perplessità per identificare quando i modelli necessitano di riaddestramento, fine-tuning o sostituzione, al fine di mantenere una qualità costante dei contenuti e la fiducia degli utenti nelle risposte generate dall’IA.

Tieni traccia di come i tuoi contenuti appaiono nelle risposte AI su ChatGPT, Perplexity e altri motori di ricerca AI. Assicurati che il tuo marchio riceva la giusta attribuzione nelle risposte generate dall'IA.

Il Punteggio di Perplessità misura la prevedibilità del testo nei modelli linguistici. Scopri come questa metrica chiave dell'NLP quantifica l'incertezza del mo...

Discussione della community sul punteggio di perplexity nei contenuti e nei modelli linguistici. Scrittori ed esperti di AI discutono se sia rilevante per la cr...

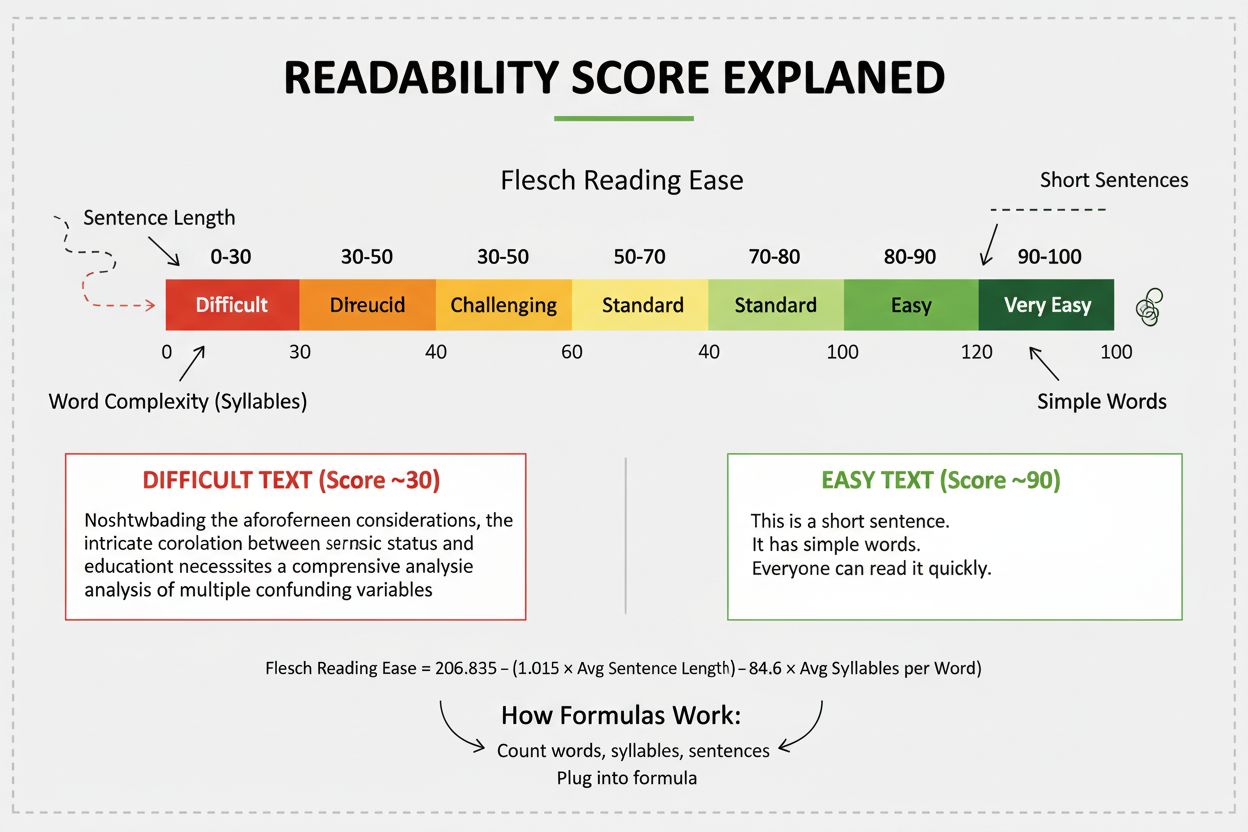

Il punteggio di leggibilità misura la difficoltà di comprensione dei contenuti attraverso l'analisi linguistica. Scopri come le formule di Flesch, Gunning Fog e...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.