Selezione delle Fonti AI

Scopri come i sistemi AI selezionano e classificano le fonti per le citazioni. Esplora gli algoritmi, i segnali e i fattori che determinano quali siti web piatt...

Scopri cos’è il bias di selezione delle fonti nell’IA, come influenza i modelli di machine learning, esempi reali e strategie per rilevare e mitigare questa fondamentale questione di equità.

Il bias di selezione delle fonti si verifica quando i dati di addestramento non sono rappresentativi dell'intera popolazione o della distribuzione reale, causando ai modelli di IA di fare previsioni inaccurate per gruppi o scenari sottorappresentati.

Il bias di selezione delle fonti è un problema fondamentale nell’intelligenza artificiale che si verifica quando i dati utilizzati per addestrare i modelli di machine learning non rappresentano accuratamente la popolazione reale o la distribuzione a cui sono destinati. Questo tipo di bias emerge quando i set di dati vengono scelti in modo da escludere o sottorappresentare sistematicamente determinati gruppi, scenari o caratteristiche. Di conseguenza, i modelli di IA apprendono schemi da dati incompleti o distorti, producendo previsioni che risultano inaccurate, ingiuste o discriminatorie verso le popolazioni sottorappresentate. Comprendere questo bias è fondamentale per chiunque sviluppi, implementi o si affidi a sistemi di IA, poiché influisce direttamente sull’equità, l’accuratezza e l’affidabilità delle decisioni automatizzate in tutti i settori.

Il bias di selezione delle fonti si distingue da altre forme di bias perché origina già nella fase di raccolta dei dati. Invece di emergere da scelte algoritmiche o ipotesi umane durante lo sviluppo del modello, il bias di selezione delle fonti è radicato nelle fondamenta del dataset di addestramento. Questo lo rende particolarmente insidioso, perché i modelli addestrati su dati di origine distorti perpetueranno e amplificheranno tali bias nelle loro previsioni, indipendentemente dalla sofisticatezza dell’algoritmo. Il problema diventa ancora più critico quando i sistemi di IA vengono impiegati in ambiti sensibili come sanità, finanza, giustizia penale e selezione del personale, dove previsioni distorte possono avere gravi conseguenze per individui e comunità.

Il bias di selezione delle fonti si sviluppa tramite diversi meccanismi distinti durante il processo di raccolta e cura dei dati. Il percorso più comune è attraverso il bias di copertura, dove certe popolazioni o scenari vengono sistematicamente esclusi dal dataset di addestramento. Ad esempio, se un sistema di riconoscimento facciale viene addestrato principalmente su immagini di persone con pelle chiara, avrà una copertura insufficiente dei volti con pelle più scura, portando a tassi d’errore più alti per queste popolazioni. Questo accade perché chi raccoglie i dati può avere un accesso limitato a popolazioni diverse, oppure può inconsciamente dare priorità ad alcuni gruppi nella raccolta dei dati.

Un altro meccanismo critico è il bias di non risposta, chiamato anche bias di partecipazione, che si verifica quando certi gruppi sono meno propensi a partecipare ai processi di raccolta dati. Considera un dataset basato su sondaggi per prevedere le preferenze dei consumatori: se alcuni gruppi demografici sono significativamente meno inclini a rispondere ai sondaggi, le loro preferenze saranno sottorappresentate nell’addestramento. Questo crea un dataset che sembra bilanciato ma riflette in realtà i pattern di partecipazione, non le vere caratteristiche della popolazione. In ambito sanitario, ad esempio, se i dati delle sperimentazioni cliniche provengono prevalentemente da popolazioni urbane con accesso a strutture sanitarie avanzate, i modelli di IA risultanti potrebbero non generalizzare bene a comunità rurali o svantaggiate.

Il bias di campionamento rappresenta un terzo meccanismo, dove manca una corretta randomizzazione nella raccolta dei dati. Invece di selezionare casualmente i dati, chi raccoglie può scegliere i primi campioni disponibili o utilizzare metodi di campionamento di convenienza. Questo introduce errori sistematici perché i campioni scelti non rappresentano la popolazione generale. Ad esempio, se un modello di IA per prevedere i default sui prestiti viene addestrato su dati raccolti da una specifica regione geografica o periodo, potrebbe non prevedere accuratamente i default in altre regioni o in condizioni economiche diverse.

| Tipo di bias | Meccanismo | Esempio reale |

|---|---|---|

| Bias di copertura | Esclusione sistematica di popolazioni | Riconoscimento facciale addestrato solo su volti chiari |

| Bias di non risposta | Gap di partecipazione nella raccolta dati | Modelli sanitari addestrati solo su popolazioni urbane |

| Bias di campionamento | Randomizzazione impropria nella selezione | Modelli di previsione prestiti addestrati in una sola regione geografica |

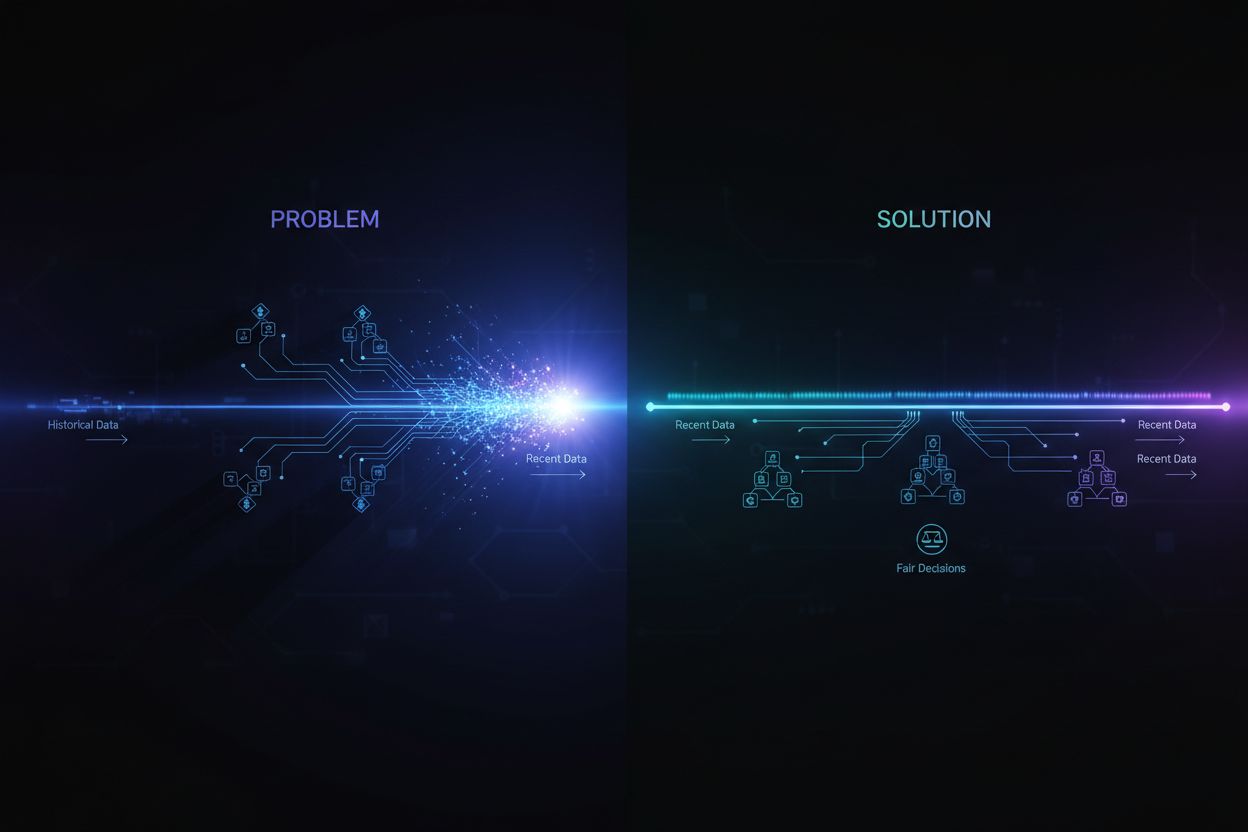

| Bias temporale | Dati di periodi temporali specifici | Modelli addestrati su dati pre-pandemia e applicati post-pandemia |

| Bias di diversità delle fonti | Fonti di dati limitate | Dataset di immagini mediche provenienti da un unico sistema ospedaliero |

Le conseguenze del bias di selezione delle fonti nei sistemi di IA sono profonde e di ampia portata, con impatti su individui e organizzazioni. In sanità, il bias di selezione delle fonti ha portato a sistemi diagnostici che funzionano significativamente peggio per alcune popolazioni di pazienti. Studi hanno documentato che algoritmi di IA per la diagnosi del cancro della pelle sono molto meno accurati per pazienti con tonalità di pelle più scure, con alcuni studi che riportano solo circa la metà dell’accuratezza diagnostica rispetto ai pazienti con pelle chiara. Questa disparità si traduce direttamente in diagnosi ritardate, raccomandazioni di trattamento inappropriate e peggiori risultati di salute per le popolazioni sottorappresentate. Quando i dati di addestramento provengono prevalentemente da pazienti di un solo gruppo demografico, i modelli risultanti apprendono schemi specifici di quel gruppo e non riescono a generalizzare agli altri.

Nei servizi finanziari, il bias di selezione delle fonti negli algoritmi di valutazione del credito e concessione dei prestiti ha perpetuato discriminazioni storiche. Modelli addestrati su dati storici di approvazione dei prestiti che riflettono pratiche di prestito discriminatorie riprodurranno gli stessi bias nelle nuove decisioni. Se certi gruppi sono stati storicamente esclusi dal credito a causa di discriminazioni sistemiche, e questi dati storici vengono usati per addestrare i modelli di IA, i modelli impareranno a negare il credito a gruppi simili in futuro. Questo crea un circolo vizioso dove le iniquità storiche vengono incorporate nelle decisioni algoritmiche, incidendo sull’accesso al capitale e alle opportunità economiche.

Selezione e reclutamento rappresentano un altro ambito critico dove il bias di selezione delle fonti causa notevoli danni. Strumenti di IA utilizzati per lo screening dei curriculum hanno dimostrato bias basati su razza e genere percepiti, con studi che mostrano come nomi associati a persone bianche venissero favoriti nell’85% dei casi in alcuni sistemi. Quando i dati di addestramento provengono da storici delle assunzioni che riflettono discriminazioni passate o pattern omogenei, i modelli di IA risultanti imparano a replicare tali pattern. Questo significa che il bias di selezione delle fonti nei dati di assunzione perpetua la discriminazione nei luoghi di lavoro, limitando le opportunità per i gruppi sottorappresentati e riducendo la diversità nella forza lavoro.

Nella giustizia penale, il bias di selezione delle fonti nei sistemi di polizia predittiva ha portato a una sorveglianza sproporzionata di alcune comunità. Quando i dati di addestramento provengono da registri di arresti storici già distorti contro gruppi marginalizzati, i modelli amplificano questi bias prevedendo tassi di criminalità più alti in quelle comunità. Si crea così un circolo vizioso dove previsioni distorte portano a maggiore sorveglianza in certe aree, generando più dati di arresto da quelle stesse zone e rafforzando ulteriormente il bias nel modello.

Rilevare il bias di selezione delle fonti richiede un approccio sistematico che combini analisi quantitative, valutazioni qualitative e monitoraggio continuo lungo tutto il ciclo di vita del modello. Il primo passo consiste in un audit completo dei dati che esamina le fonti, i metodi di raccolta e la rappresentatività dei dati di addestramento. Questo implica documentare da dove provengono i dati, come sono stati raccolti e se il processo di raccolta possa aver escluso sistematicamente certe popolazioni o scenari. Poni domande critiche: tutti i gruppi demografici rilevanti sono stati rappresentati nella raccolta? Ci sono state barriere di partecipazione che potrebbero aver scoraggiato certi gruppi? Il periodo o l’area geografica di raccolta ha limitato la rappresentazione?

L’analisi della parità demografica offre un approccio quantitativo per rilevare il bias di selezione delle fonti. Consiste nel confrontare la distribuzione delle caratteristiche chiave nei dati di addestramento rispetto alla distribuzione nella popolazione reale che il modello servirà. Se i tuoi dati sottorappresentano significativamente certi gruppi demografici, fasce d’età, regioni geografiche o altre caratteristiche, hai evidenza di bias di selezione delle fonti. Ad esempio, se il tuo dataset include solo il 5% di donne ma la popolazione target è composta per il 50% da donne, questo indica un grave bias di copertura che probabilmente porterà a scarse prestazioni del modello per le donne.

L’analisi delle prestazioni per segmento è un’altra tecnica fondamentale, dove si valuta la performance del modello separatamente per diversi gruppi demografici e sottopopolazioni. Anche se l’accuratezza complessiva appare accettabile, le prestazioni possono variare drasticamente tra i gruppi. Se il modello raggiunge il 95% di accuratezza complessiva ma solo il 70% per un gruppo specifico, questo suggerisce che il bias di selezione delle fonti nei dati di addestramento ha portato il modello ad apprendere pattern specifici del gruppo maggioritario, trascurando le esigenze del gruppo minoritario. Questa analisi dovrebbe essere effettuata non solo sull’accuratezza totale, ma anche su metriche di equità come le odds equalizzate e l’impatto disparato.

I test avversariali consistono nel creare deliberatamente casi di test per evidenziare potenziali bias. Questo può includere il test del modello su dati di popolazioni sottorappresentate, casi limite o scenari poco presenti nei dati di addestramento. Sottoponendo il modello a input diversificati è possibile identificare i punti ciechi creati dal bias di selezione delle fonti. Ad esempio, se il modello è stato addestrato principalmente su dati urbani, testalo a fondo su dati rurali per vedere se le prestazioni calano. Se i dati di addestramento provengono da uno specifico periodo, testa il modello su dati di periodi differenti per rilevare eventuali bias temporali.

Mitigare il bias di selezione delle fonti richiede interventi in più fasi del ciclo di sviluppo dell’IA, a partire dalla raccolta dati fino alla valutazione e implementazione del modello. L’approccio più efficace è la mitigazione data-centrica, che affronta il bias alla radice migliorando la qualità e rappresentatività dei dati di addestramento. Questo inizia con una raccolta dati diversificata, lavorando attivamente per includere popolazioni e scenari sottorappresentati nel dataset. Piuttosto che affidarsi a campionamenti di convenienza o dataset esistenti, le organizzazioni dovrebbero condurre raccolte dati mirate per garantire un’adeguata rappresentazione di tutti i gruppi demografici rilevanti e dei casi d’uso.

Le tecniche di ricampionamento e ripesatura offrono soluzioni pratiche per affrontare squilibri nei dataset esistenti. L’oversampling casuale duplica esempi dei gruppi sottorappresentati, mentre l’undersampling casuale riduce quelli dei gruppi sovrarappresentati. Approcci più sofisticati come il campionamento stratificato assicurano una rappresentanza proporzionale su più dimensioni contemporaneamente. La ripesatura assegna maggiore importanza ai campioni sottorappresentati durante l’addestramento, indicando all’algoritmo di prestare maggiore attenzione ai pattern dei gruppi minoritari. Queste tecniche funzionano meglio se combinate a raccolte dati più diversificate, piuttosto che affidarsi solo al ricampionamento di dati limitati.

La generazione di dati sintetici rappresenta un’altra via per affrontare il bias di selezione delle fonti, soprattutto quando la raccolta di dati reali da popolazioni sottorappresentate è difficile o costosa. Tecniche come le Generative Adversarial Networks (GANs) e le Variational Autoencoders (VAEs) possono creare esempi sintetici realistici per i gruppi minoritari. Approcci più mirati come SMOTE (Synthetic Minority Over-sampling Technique) creano dati sintetici interpolando tra istanze esistenti della minoranza. Tuttavia, i dati sintetici devono essere usati con cautela e validati accuratamente, poiché possono introdurre nuovi bias se non generati correttamente.

Gli algoritmi attenti all’equità rappresentano un’altra strategia di mitigazione che agisce nella fase di addestramento del modello. Questi algoritmi incorporano esplicitamente vincoli di equità nel processo di apprendimento, assicurando che il modello raggiunga prestazioni accettabili su tutti i gruppi demografici, non solo sul gruppo maggioritario. L’adversarial debiasing, ad esempio, utilizza una rete avversaria per fare in modo che le previsioni del modello non possano essere utilizzate per inferire caratteristiche protette come razza o genere. La regularizzazione fairness-aware aggiunge termini di penalità alla funzione di perdita per scoraggiare comportamenti discriminatori. Questi approcci consentono di bilanciare esplicitamente accuratezza complessiva ed equità, scegliendo l’equilibrio che meglio rispecchia le proprie priorità etiche.

Il monitoraggio e riaddestramento continui garantiscono che il bias di selezione delle fonti non emerga o peggiori nel tempo. Anche se i dati di addestramento iniziali sono rappresentativi, la distribuzione reale della popolazione servita dal modello può cambiare a causa di mutamenti demografici, cambiamenti economici o altri fattori. Implementare sistemi di monitoraggio delle prestazioni che tracciano l’accuratezza del modello separatamente per diversi gruppi demografici permette di rilevare quando emerge un bias. Quando si rileva una degradazione delle prestazioni, il riaddestramento con dati aggiornati e rappresentativi può ripristinare l’equità. Questo processo continuo riconosce che la mitigazione dei bias non è uno sforzo una tantum, ma una responsabilità continua.

Comprendere il bias di selezione delle fonti diventa sempre più importante nel contesto del monitoraggio delle risposte dell’IA e del tracking della presenza del brand. Poiché sistemi di IA come ChatGPT, Perplexity e altri generatori di risposte stanno diventando fonti primarie di informazione per gli utenti, le fonti che questi sistemi citano e le informazioni che forniscono sono plasmate dai dati di addestramento. Se i dati utilizzati per costruire questi sistemi di IA presentano bias di selezione delle fonti, anche le risposte generate rifletteranno tale bias. Ad esempio, se i dati di addestramento di un sistema IA sovrarappresentano certi siti web, pubblicazioni o prospettive, mentre ne sottorappresentano altri, il sistema IA sarà più propenso a citare e amplificare le informazioni delle fonti sovrarappresentate.

Questo ha implicazioni dirette per il monitoraggio del brand e la visibilità dei contenuti. Se il tuo brand, dominio o URL sono sottorappresentati nei dati di addestramento dei principali sistemi di IA, i tuoi contenuti potrebbero essere sistematicamente esclusi o sottorappresentati nelle risposte generate dall’IA. Al contrario, se brand concorrenti o fonti di disinformazione sono sovrarappresentati, otterranno una visibilità sproporzionata nelle risposte delle IA. Monitorare come il tuo brand appare nelle risposte generate dall’IA sulle diverse piattaforme ti aiuta a capire se il bias di selezione delle fonti di questi sistemi sta influenzando la tua visibilità e reputazione. Tracciando quali fonti vengono citate, con che frequenza compaiono i tuoi contenuti e se le informazioni presentate sono accurate, puoi identificare potenziali bias su come i sistemi di IA rappresentano il tuo brand e il tuo settore.

Il bias di selezione delle fonti nell’IA è una questione di equità critica che nasce nella fase di raccolta dati e si propaga in tutte le applicazioni downstream dei modelli di machine learning. Si verifica quando i dati di addestramento escludono o sottorappresentano sistematicamente certe popolazioni, scenari o caratteristiche, portando a modelli che producono previsioni inaccurate o ingiuste per i gruppi sottorappresentati. Le conseguenze sono gravi e diffuse, influenzando esiti sanitari, accesso finanziario, opportunità di lavoro e decisioni di giustizia penale. Rilevare il bias di selezione delle fonti richiede audit completi dei dati, analisi della parità demografica, analisi delle prestazioni per segmento e test avversariali. Mitigare tale bias richiede un approccio multifattoriale, inclusa raccolta dati diversificata, ricampionamento e ripesatura, generazione di dati sintetici, algoritmi attenti all’equità e monitoraggio continuo. Le organizzazioni devono riconoscere che affrontare il bias di selezione delle fonti non è opzionale, ma essenziale per costruire sistemi di IA equi, accurati e affidabili per tutte le popolazioni e casi d’uso.

Assicurati che il tuo brand compaia correttamente nelle risposte generate dall'IA su ChatGPT, Perplexity e altre piattaforme IA. Traccia come i sistemi di IA citano i tuoi contenuti e identifica potenziali bias nelle risposte dell'IA.

Scopri come i sistemi AI selezionano e classificano le fonti per le citazioni. Esplora gli algoritmi, i segnali e i fattori che determinano quali siti web piatt...

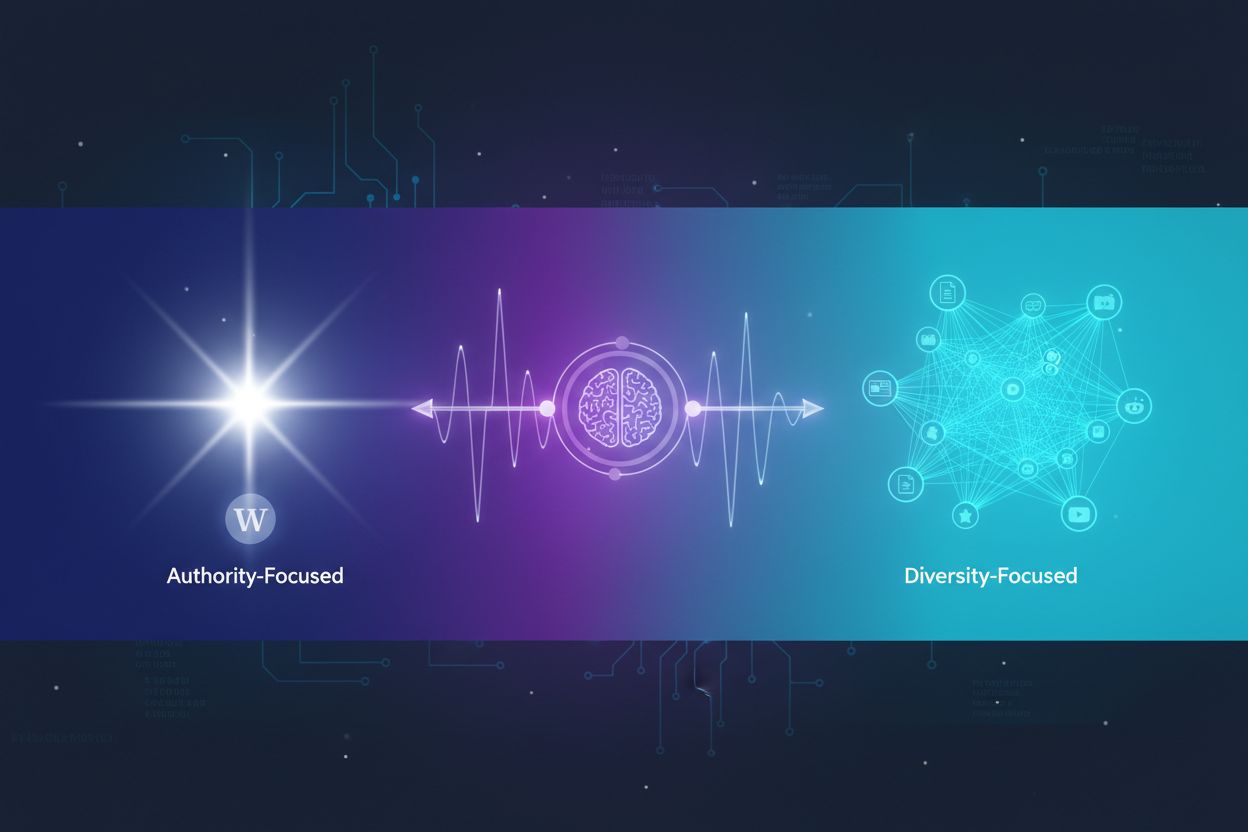

Scopri come i sistemi AI decidono tra citare più fonti o concentrarsi su quelle autorevoli. Comprendi i modelli di citazione su ChatGPT, Google AI Overviews, Pe...

Scopri il bias di recenticità nei sistemi di IA, come influenza la visibilità dei contenuti, gli algoritmi di raccomandazione e le decisioni aziendali. Approfon...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.