Come Contestare e Correggere Informazioni Inaccurate nelle Risposte AI

Scopri come contestare informazioni AI inaccurate, segnalare errori a ChatGPT e Perplexity e implementare strategie per garantire che il tuo brand sia rappresen...

La Correzione della Disinformazione AI si riferisce a strategie e strumenti per identificare e affrontare informazioni errate sul brand che compaiono nelle risposte generate da sistemi AI come ChatGPT, Gemini e Perplexity. Comprende il monitoraggio di come i sistemi AI rappresentano i brand e l’implementazione di correzioni a livello di fonte per garantire che informazioni accurate siano distribuite su piattaforme affidabili. A differenza del fact-checking tradizionale, si concentra sulla correzione delle fonti di cui si fidano i sistemi AI piuttosto che degli output AI stessi. Questo è essenziale per mantenere la reputazione e l’accuratezza del brand in un ambiente di ricerca guidato dall’AI.

La Correzione della Disinformazione AI si riferisce a strategie e strumenti per identificare e affrontare informazioni errate sul brand che compaiono nelle risposte generate da sistemi AI come ChatGPT, Gemini e Perplexity. Comprende il monitoraggio di come i sistemi AI rappresentano i brand e l'implementazione di correzioni a livello di fonte per garantire che informazioni accurate siano distribuite su piattaforme affidabili. A differenza del fact-checking tradizionale, si concentra sulla correzione delle fonti di cui si fidano i sistemi AI piuttosto che degli output AI stessi. Questo è essenziale per mantenere la reputazione e l'accuratezza del brand in un ambiente di ricerca guidato dall'AI.

Correzione della Disinformazione AI si riferisce alle strategie, ai processi e agli strumenti utilizzati per identificare e affrontare informazioni errate, obsolete o fuorvianti sui brand che compaiono nelle risposte generate da sistemi AI come ChatGPT, Gemini e Perplexity. Ricerche recenti dimostrano che circa il 45% delle query AI produce risposte errate, rendendo la precisione del brand nei sistemi AI una preoccupazione cruciale per le aziende. A differenza dei risultati di ricerca tradizionali, dove i brand possono controllare le proprie schede, i sistemi AI sintetizzano informazioni da più fonti sul web, creando un contesto complesso in cui la disinformazione può persistere in modo silenzioso. La sfida non è solo correggere le singole risposte AI, ma capire perché i sistemi AI sbagliano le informazioni sui brand e implementare correzioni sistematiche a livello di fonte.

I sistemi AI non inventano le informazioni sui brand dal nulla; le assemblano da ciò che già esiste online. Tuttavia, questo processo genera diversi punti di fallimento prevedibili che portano a una rappresentazione errata del brand:

| Causa Principale | Come Avviene | Impatto sul Business |

|---|---|---|

| Incoerenza delle Fonti | Il brand è descritto in modo diverso su siti, directory e articoli | L’AI deduce un consenso errato da informazioni in conflitto |

| Fonti Autorevoli Obsolete | Vecchie voci Wikipedia, elenchi di directory o pagine di confronto contengono dati errati | Le correzioni più recenti vengono ignorate perché le fonti più vecchie hanno segnali di autorità più forti |

| Confusione tra Entità | Nomi di brand simili o categorie sovrapposte confondono i sistemi AI | I concorrenti ottengono credito per le tue capacità o il brand viene omesso del tutto |

| Mancanza di Segnali Primari | Mancanza di dati strutturati, pagine About chiare o terminologia coerente | L’AI è costretta a dedurre informazioni, portando a descrizioni vaghe o errate |

Quando un brand viene descritto in modo diverso sulle varie piattaforme, i sistemi AI faticano a determinare quale versione sia autorevole. Invece di chiedere chiarimenti, deducono un consenso basato su frequenza e autorità percepita, anche quando il consenso è errato. Piccole differenze nei nomi, descrizioni o posizionamenti del brand vengono spesso duplicate tra le piattaforme e, una volta ripetute, queste informazioni diventano segnali che i modelli AI considerano affidabili. Il problema si aggrava quando pagine obsolete ma autorevoli contengono dati errati: i sistemi AI spesso danno priorità a queste fonti più vecchie rispetto alle correzioni recenti, soprattutto se queste ultime non si sono diffuse ampiamente su piattaforme affidabili.

Correggere informazioni errate sul brand nei sistemi AI richiede un approccio fondamentalmente diverso rispetto al classico intervento SEO. Nella SEO tradizionale, i brand aggiornano le proprie schede, correggono i dati NAP (Nome, Indirizzo, Telefono) e ottimizzano i contenuti on-page. La correzione AI del brand si concentra su ciò che le fonti affidabili dicono sul tuo brand, non sul controllo diretto della visibilità. Non correggi direttamente l’AI: correggi ciò di cui l’AI si fida. Cercare di “correggere” le risposte AI ripetendo affermazioni errate (anche per smentirle) può avere l’effetto opposto, rafforzando proprio l’associazione che vuoi eliminare. I sistemi AI riconoscono i pattern, non l’intento. Questo significa che ogni correzione deve partire a livello di fonte, risalendo a dove i sistemi AI realmente apprendono le informazioni.

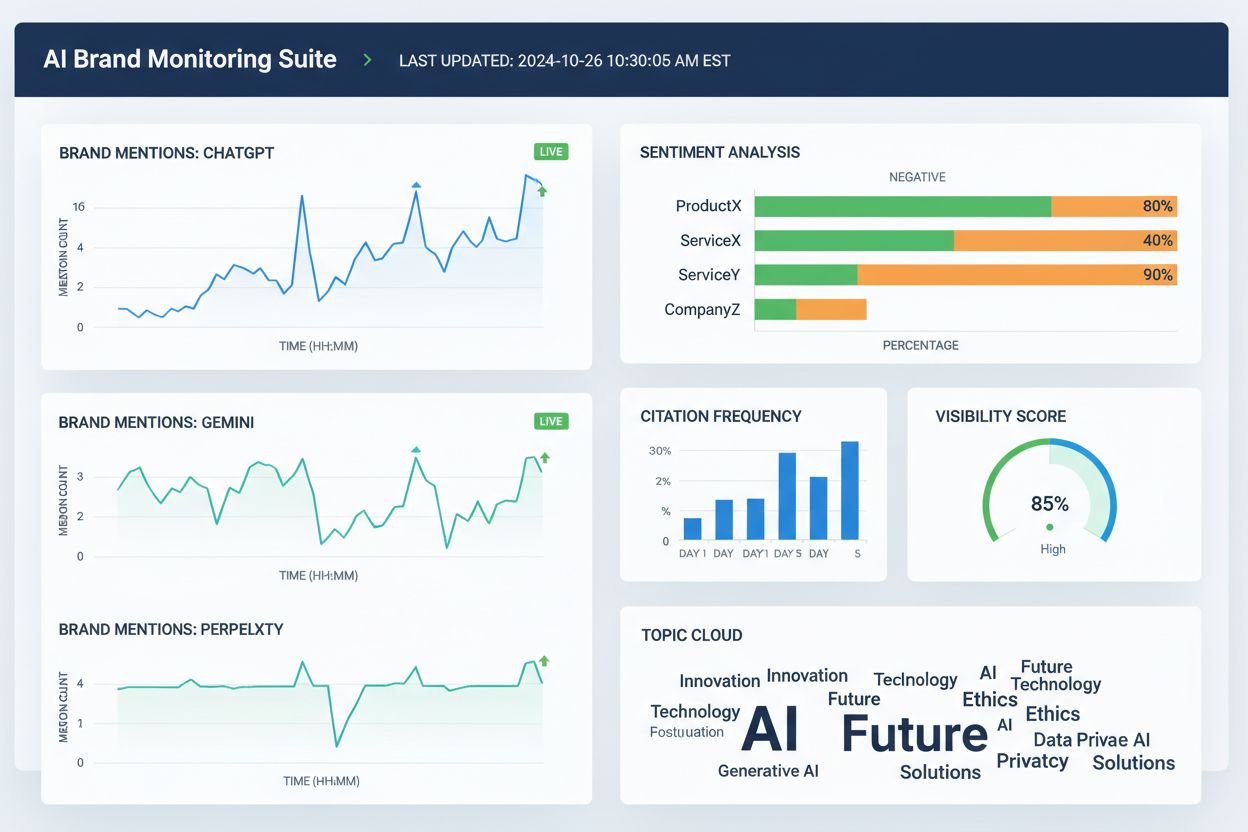

Prima di poter correggere informazioni errate sul brand, serve visibilità su come i sistemi AI descrivono attualmente il tuo brand. Un monitoraggio efficace si focalizza su:

Verifiche manuali non sono sufficientemente affidabili perché le risposte AI variano in base a prompt, contesto e ciclo di aggiornamento. Strumenti di monitoraggio strutturati offrono visibilità per rilevare tempestivamente errori prima che si radichino nei sistemi AI. Molti brand non si accorgono di essere rappresentati in modo errato nell’AI finché non lo segnala un cliente o non scoppia una crisi. Un monitoraggio proattivo previene questo scenario intercettando le incoerenze prima che si diffondano.

Una volta identificate le informazioni errate sul brand, la correzione deve avvenire nei punti da cui i sistemi AI realmente apprendono, non dove l’errore semplicemente appare. Correzioni efficaci a livello di fonte includono:

Il principio chiave è: le correzioni funzionano solo se applicate a livello di fonte. Cambiare ciò che appare negli output AI senza correggere le fonti sottostanti è, nel migliore dei casi, temporaneo. I sistemi AI rivalutano costantemente i segnali man mano che compaiono nuovi contenuti e riemergono vecchie pagine. Una correzione che non interviene sulla fonte originaria verrà presto sovrascritta dalla disinformazione di partenza.

Per correggere informazioni errate sul brand su directory, marketplace o piattaforme alimentate dall’AI, la maggior parte dei sistemi richiede una verifica che colleghi il brand alla titolarità e all’uso legittimo. La documentazione richiesta più comune include:

L’obiettivo non è la quantità, ma la coerenza. Le piattaforme valutano se documenti, schede e dati pubblici sul brand sono allineati. Avere questi materiali organizzati in anticipo riduce i cicli di rifiuto e accelera l’approvazione quando si correggono informazioni errate su scala. Coerenza tra le fonti segnala ai sistemi AI che le informazioni sul brand sono affidabili e autorevoli.

Sono disponibili diversi strumenti che aiutano i team a tracciare la rappresentazione del brand nelle piattaforme AI e sul web più ampio. Pur con funzionalità sovrapposte, si concentrano su visibilità, attribuzione e coerenza:

Questi strumenti non correggono direttamente le informazioni errate. Aiutano invece i team a rilevare tempestivamente gli errori, individuare discrepanze nei dati sul brand prima che si diffondano, verificare se i fix a livello di fonte migliorano l’accuratezza AI e monitorare trend di attribuzione e visibilità nel lungo periodo. Insieme alle correzioni sulle fonti e alla documentazione, gli strumenti di monitoraggio forniscono il feedback necessario per correggere in modo sostenibile le informazioni sbagliate.

La precisione delle ricerche AI migliora quando i brand sono entità ben definite e non partecipanti vaghi di una categoria. Per ridurre la rappresentazione errata del brand nei sistemi AI, concentrati su:

L’obiettivo non è dire di più, ma dire la stessa cosa ovunque. Quando i sistemi AI trovano definizioni coerenti del brand su fonti autorevoli, smettono di indovinare e iniziano a ripetere le informazioni corrette. Questo passo è particolarmente importante per i brand che subiscono menzioni errate, attribuzioni ai concorrenti o omissioni dalle risposte AI rilevanti. Anche dopo aver corretto le informazioni, l’accuratezza non è permanente: i sistemi AI rivalutano costantemente i segnali, rendendo la chiarezza continua essenziale.

Non esistono tempistiche fisse per correggere la rappresentazione errata di un brand nei sistemi AI. I modelli AI si aggiornano in base alla forza del segnale e al consenso, non alla data di invio. I pattern tipici sono:

I primi progressi raramente si manifestano come una risposta “corretta” improvvisa. Cerca invece segnali indiretti: minore variabilità nelle risposte AI, meno descrizioni in conflitto, citazioni più coerenti tra le fonti e inclusione graduale del brand dove prima era assente. La stagnazione si presenta diversamente: se la stessa frase errata persiste nonostante molte correzioni, di solito significa che la fonte originaria non è stata aggiornata o che serve un rafforzamento maggiore altrove.

Il modo più affidabile per correggere informazioni errate è ridurre le condizioni che ne permettono l’emergere. Una prevenzione efficace include:

I brand che trattano la visibilità AI come un sistema vivo, e non come un progetto di pulizia una tantum, si riprendono più rapidamente dagli errori e subiscono meno episodi di rappresentazione errata ricorrente. La prevenzione non consiste nel controllare gli output AI, ma nel mantenere input puliti e coerenti che i sistemi AI possano ripetere con fiducia. Con l’evoluzione della ricerca AI, i brand di successo saranno quelli che riconoscono la correzione della disinformazione come un processo continuo che richiede monitoraggio costante, gestione delle fonti e rafforzamento strategico delle informazioni accurate su piattaforme affidabili.

La Correzione della Disinformazione AI è il processo di identificazione e correzione di informazioni errate, obsolete o fuorvianti sui brand che compaiono nelle risposte generate dall'AI. A differenza del fact-checking tradizionale, si concentra sulla correzione delle fonti di cui si fidano i sistemi AI (elenchi, articoli, directory) invece di modificare direttamente gli output AI. L'obiettivo è garantire che quando gli utenti chiedono informazioni sul tuo brand ai sistemi AI, ricevano dati accurati.

Sistemi AI come ChatGPT, Gemini e Perplexity influenzano ora il modo in cui milioni di persone apprendono informazioni sui brand. Ricerche mostrano che il 45% delle query AI produce errori e informazioni errate possono danneggiare la reputazione, confondere i clienti e far perdere opportunità di business. A differenza della ricerca tradizionale, dove i brand controllano le proprie schede, i sistemi AI sintetizzano informazioni da molteplici fonti, rendendo il controllo dell'accuratezza più difficile ma ancora più cruciale.

No, la correzione diretta non funziona in modo efficace. I sistemi AI non memorizzano i dati sui brand in posizioni modificabili: sintetizzano risposte da fonti esterne. Chiedere ripetutamente all'AI di 'correggere' le informazioni può rafforzare le allucinazioni consolidando l'associazione che vuoi eliminare. Le correzioni devono invece essere applicate a livello di fonte: aggiornando directory, correggendo elenchi obsoleti e pubblicando informazioni accurate su piattaforme affidabili.

Non esiste una tempistica fissa perché i sistemi AI si aggiornano in base alla forza del segnale e al consenso, non alle date di invio. Le correzioni fattuali minori appaiono in genere entro 2-4 settimane, le chiarificazioni a livello di entità richiedono 1-3 mesi e il recupero di attribuzione competitiva può richiedere 3-6 mesi o più. I progressi raramente si manifestano come una risposta 'corretta' improvvisa: valuta invece la riduzione delle variazioni nelle risposte e citazioni più coerenti tra le fonti.

Sono disponibili diversi strumenti che tracciano la rappresentazione del brand sulle piattaforme AI: Wellows monitora menzioni e sentiment su ChatGPT, Gemini e Perplexity; Profound confronta la visibilità tra i LLM; Otterly.ai analizza il sentiment del brand nelle risposte AI; BrandBeacon fornisce analytics sul posizionamento; Ahrefs Brand Radar monitora le menzioni online; e AmICited.com è specializzato nel monitoraggio di come i brand vengono citati e rappresentati nei sistemi AI. Questi strumenti aiutano a rilevare errori precocemente e a verificare l'efficacia delle correzioni.

Le allucinazioni AI si verificano quando i sistemi AI generano informazioni non basate sui dati di addestramento o decodificate in modo errato. La disinformazione AI è informazione falsa o fuorviante che appare negli output AI, e può derivare sia da allucinazioni che da fonti obsolete, confusione tra entità o dati incoerenti tra piattaforme. La correzione della disinformazione affronta sia le allucinazioni che le inesattezze a livello di fonte che portano a una rappresentazione errata del brand.

Monitora come i sistemi AI descrivono il tuo brand ponendo domande sulla tua azienda, prodotti e posizionamento. Cerca informazioni obsolete, descrizioni errate, dettagli mancanti o attribuzioni ai concorrenti. Utilizza strumenti di monitoraggio per tracciare le menzioni su ChatGPT, Gemini e Perplexity. Verifica se il brand è assente dalle risposte AI rilevanti. Confronta le descrizioni AI con le informazioni ufficiali del tuo brand per individuare discrepanze.

È un processo continuo. I sistemi AI rivalutano costantemente i segnali man mano che compaiono nuovi contenuti e riemergono pagine vecchie. Una correzione una tantum senza monitoraggio sarà presto sovrascritta dalla disinformazione originale. I brand di successo trattano la visibilità AI come un sistema vivo, mantenendo definizioni coerenti su tutte le fonti, revisionando regolarmente le directory e monitorando costantemente le menzioni AI per intercettare nuovi errori prima che si diffondano.

Tieni traccia di come i sistemi AI come ChatGPT, Gemini e Perplexity rappresentano il tuo brand. Ottieni approfondimenti in tempo reale su menzioni, citazioni e visibilità del brand sulle piattaforme AI con AmICited.com.

Scopri come contestare informazioni AI inaccurate, segnalare errori a ChatGPT e Perplexity e implementare strategie per garantire che il tuo brand sia rappresen...

Scopri come identificare, prevenire e correggere la disinformazione dell'AI sul tuo brand. Scopri 7 strategie e strumenti comprovati per proteggere la tua reput...

Scopri strategie efficaci per identificare, monitorare e correggere informazioni inesatte sul tuo brand nelle risposte generate da ChatGPT, Perplexity e altri m...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.