Benchmarking Competitivo dell'AI

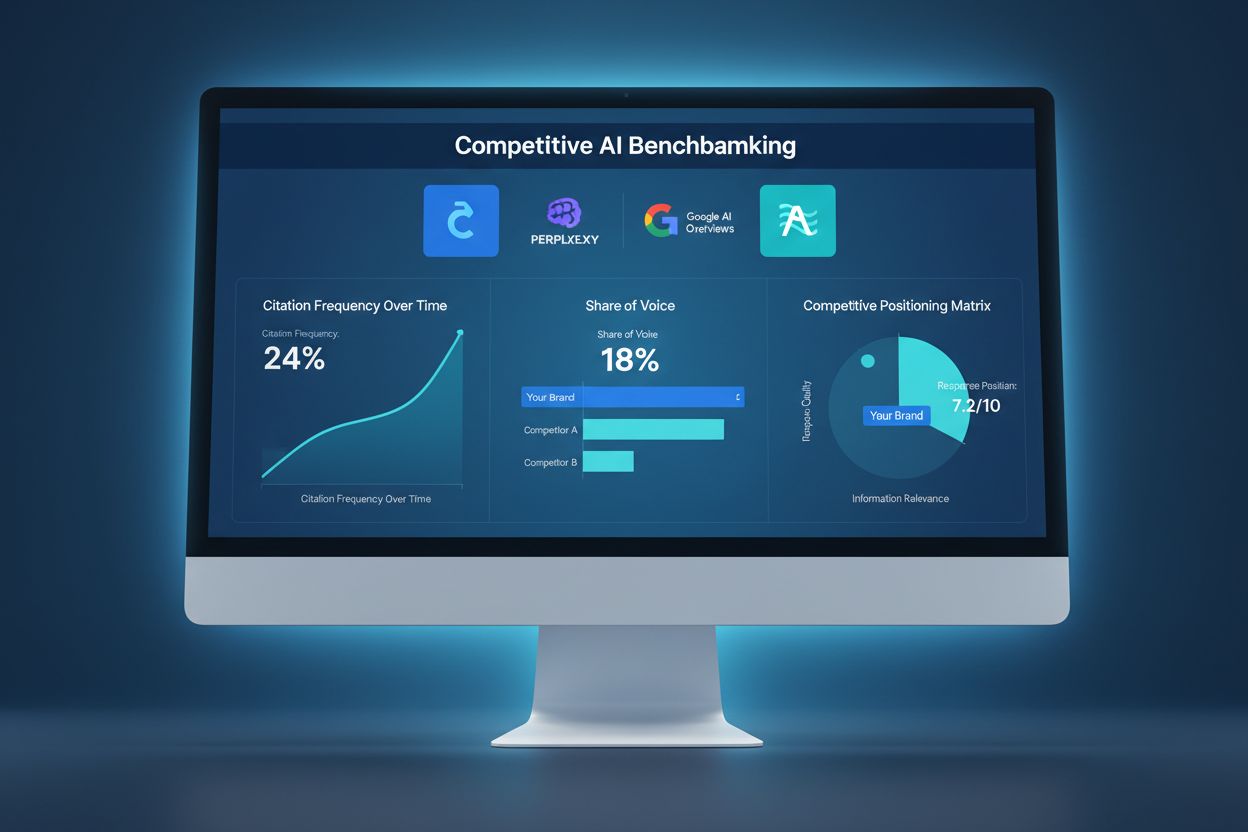

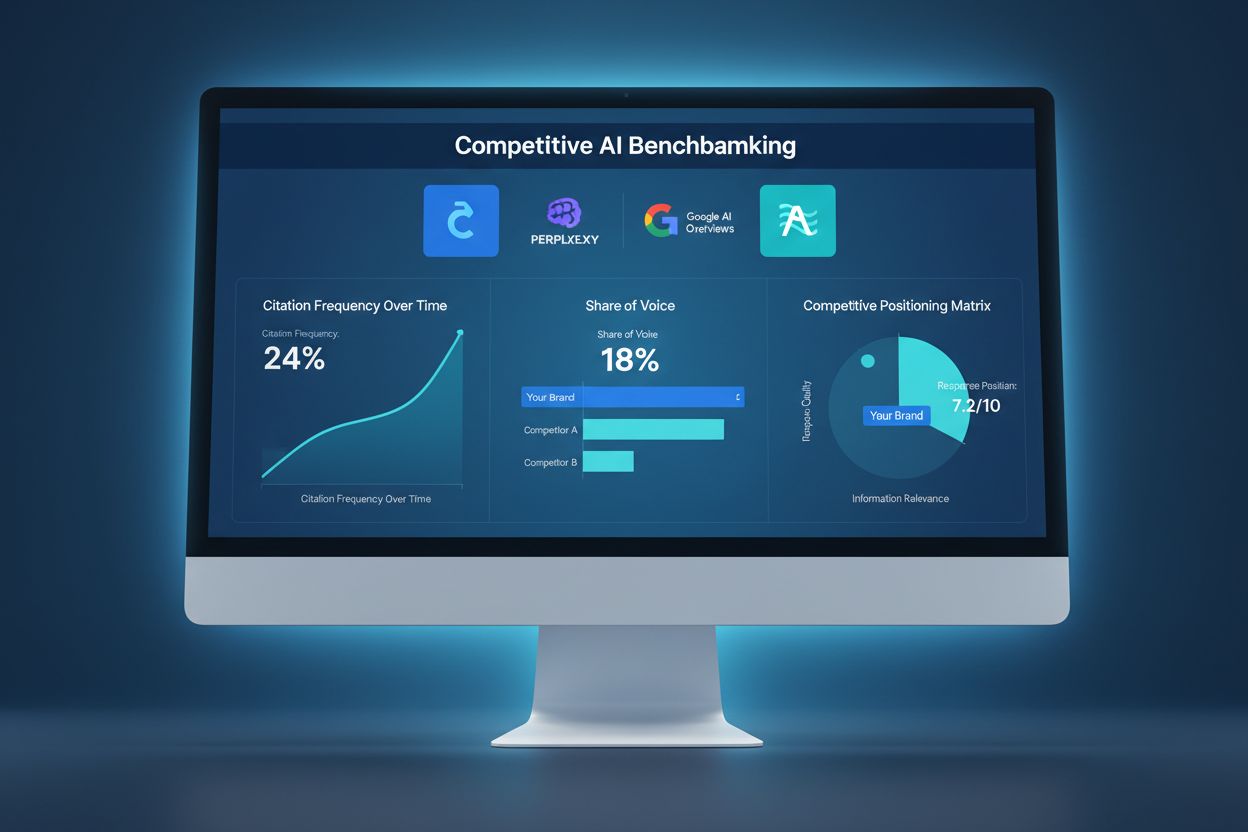

Scopri come confrontare la tua visibilità AI rispetto ai concorrenti. Monitora citazioni, quota di voce e posizionamento competitivo su ChatGPT, Perplexity e Go...

Il sabotaggio competitivo dell’IA si riferisce a tentativi deliberati da parte dei concorrenti di influenzare negativamente la visibilità, la percezione o le prestazioni di un marchio nei risultati di ricerca e nelle risposte dei chatbot alimentati dall’IA. Questo include avvelenamento dei dati, false recensioni, campagne di disinformazione e manipolazione dei dati di addestramento dell’IA per danneggiare la reputazione del marchio e ridurre le citazioni dell’IA.

Il sabotaggio competitivo dell'IA si riferisce a tentativi deliberati da parte dei concorrenti di influenzare negativamente la visibilità, la percezione o le prestazioni di un marchio nei risultati di ricerca e nelle risposte dei chatbot alimentati dall'IA. Questo include avvelenamento dei dati, false recensioni, campagne di disinformazione e manipolazione dei dati di addestramento dell'IA per danneggiare la reputazione del marchio e ridurre le citazioni dell'IA.

Il sabotaggio competitivo dell’IA si riferisce a tentativi deliberati di manipolare, avvelenare o corrompere i dati che i motori di ricerca basati su IA e i modelli linguistici utilizzano per generare risultati e citazioni. A differenza del tradizionale negative SEO, che si concentra sul danneggiare il posizionamento del sito web di un concorrente tramite schemi di link o exploit tecnici, il sabotaggio dell’IA prende di mira i dati di addestramento e le fonti su cui i sistemi IA fanno affidamento per fornire risposte. Questa distinzione è fondamentale perché sistemi come Google AI Overviews, Perplexity e GPT citano direttamente le fonti dai dati di addestramento, rendendoli vulnerabili a campagne di disinformazione coordinate. L’impatto reale è sostanziale: con il 60% delle ricerche che termina senza cliccare sui siti web, i concorrenti possono ora avvelenare i risultati IA per reindirizzare il traffico, danneggiare la reputazione di un marchio o promuovere informazioni false senza mai toccare il posizionamento tradizionale.

Il sabotaggio competitivo dell’IA opera attraverso diversi vettori di attacco interconnessi che sfruttano il modo in cui i sistemi IA acquisiscono ed elaborano le informazioni. L’avvelenamento dei dati è la tecnica principale e consiste nell’iniettare informazioni false, fuorvianti o dannose nelle fonti che i sistemi IA utilizzano per l’addestramento—come database pubblici, forum, siti di recensioni e aggregatori di notizie. Gli aggressori utilizzano il label flipping (modifica dei metadati per classificare erroneamente i contenuti), l’iniezione di dati (aggiunta di voci false ai dataset) e gli attacchi backdoor (inserimento di trigger nascosti nei dati di addestramento). I concorrenti lanciano anche campagne coordinate di false recensioni per inondare le piattaforme di testimonianze inventate, mentre diffondono disinformazione e deepfake tramite social media, blog e contenuti indicizzati dall’IA. La vulnerabilità principale risiede nel fatto che spesso i sistemi IA si fidano del volume e della coerenza delle informazioni piuttosto che verificarne l’autenticità. Ecco come si confrontano i diversi metodi di sabotaggio:

| Metodo | Come Funziona | Impatto sull’IA | Difficoltà di Rilevamento |

|---|---|---|---|

| Avvelenamento dei Dati | Iniezione di informazioni false nei dataset di addestramento | L’IA cita direttamente le fonti avvelenate nei risultati | Alta - richiede analisi dei dati |

| False Recensioni | Bombardamento coordinato di recensioni su piattaforme | Falsifica l’analisi del sentiment e le raccomandazioni IA | Media - l’analisi dei pattern può aiutare |

| Campagne di Disinformazione | Diffusione di affermazioni false su siti indicizzati | L’IA amplifica le false narrazioni nei risultati di ricerca | Alta - richiede fact-checking |

| Deepfake | Creazione di media sintetici di dirigenti o prodotti | Danneggia la credibilità del marchio se citato dall’IA | Molto alta - richiede verifica |

| Hijacking delle Directory | Rivendicazione delle schede aziendali dei concorrenti | L’IA raccoglie informazioni false da directory hijackate | Media - le verifiche aiutano |

| Articoli Fake News | Pubblicazione di storie false su siti simili a testate | L’IA li considera fonti autorevoli | Alta - serve verifica delle fonti |

I sistemi IA sono fondamentalmente più vulnerabili al sabotaggio rispetto ai motori di ricerca tradizionali perché si fidano dei dati di addestramento in modo più implicito rispetto agli esseri umani. Mentre l’algoritmo di Google valuta l’autorità dei link e la reputazione del dominio, i modelli IA apprendono semplicemente dai pattern dei dati con cui vengono addestrati—rendendoli suscettibili ad attacchi coordinati. Le ricerche dimostrano che bastano appena 250 documenti dannosi per avvelenare un modello IA, una soglia di ingresso molto più bassa rispetto agli attacchi SEO tradizionali. Il problema è aggravato dal fatto che i sistemi IA citano direttamente le fonti, quindi i dati avvelenati non influenzano solo i risultati, ma diventano la risposta autorevole che gli utenti vedono. Rilevare dati avvelenati è molto più difficile che identificare un backlink di bassa qualità perché la manipolazione avviene a livello di addestramento, spesso invisibile alle verifiche esterne. Con il traffico di ricerca IA aumentato del 527% in soli cinque mesi (gennaio-maggio 2025) e il 79% degli americani che si fida dei motori di ricerca IA, l’incentivo per i concorrenti a sabotare è più alto che mai, mentre l’infrastruttura di sicurezza per prevenirlo resta poco sviluppata.

L’esempio più noto di sabotaggio IA si è verificato quando Target è stata vittima di una campagna coordinata di disinformazione che affermava falsamente che il rivenditore vendesse abbigliamento per bambini “a tema satanico”. I sistemi IA, addestrati su questa narrazione inventata, hanno iniziato a mostrare queste affermazioni false nei risultati di ricerca e nelle panoramiche IA, causando danni significativi alla reputazione prima che l’azienda potesse reagire. Sistemi di posta elettronica hanno subito attacchi simili tramite avvelenamento dei filtri antispam, dove i concorrenti iniettano pattern dannosi nei dati di addestramento per far sì che email legittime vengano contrassegnate come spam. Il bombardamento di recensioni negative dei concorrenti è diventato sempre più comune, con aziende che inondano di false recensioni negative le schede dei rivali, che i sistemi IA poi aggregano nei punteggi di sentiment. L’hijacking delle schede directory rappresenta un altro vettore, dove gli aggressori rivendicano i profili aziendali dei concorrenti su piattaforme come Google My Business o directory di settore, fornendo così informazioni false che i sistemi IA indicizzano e citano. Questi casi dimostrano che il sabotaggio IA non è teorico—sta già danneggiando le aziende oggi, con danni amplificati perché i risultati IA appaiono autorevoli e spesso sono la prima informazione che gli utenti incontrano.

Rilevare il sabotaggio competitivo dell’IA richiede un approccio di monitoraggio multilivello che segua come il tuo marchio appare nei risultati di ricerca IA e nelle fonti di citazione. Il primo passo è il monitoraggio continuo dei risultati di ricerca IA per il tuo marchio, prodotti e dirigenti chiave su piattaforme come Google AI Overviews, Perplexity, ChatGPT e Claude. Il tracciamento del sentiment sulle fonti indicizzate aiuta a identificare improvvisi cambiamenti nel modo in cui si parla del tuo marchio—un campanello d’allarme per campagne di disinformazione coordinate. L’identificazione di false recensioni prevede l’analisi dei pattern delle recensioni alla ricerca di anomalie statistiche, come improvvisi picchi di valutazioni a una stella o recensioni con linguaggio identico. Il rilevamento precoce è fondamentale; le ricerche dimostrano che le prime 48 ore dall’inizio di un attacco sono cruciali per il contenimento e la risposta. Il monitoraggio dovrebbe anche tracciare quali fonti i sistemi IA citano riguardo al tuo marchio, così da identificare fonti avvelenate prima che causino danni diffusi. Ecco i metodi essenziali di rilevamento:

Costruire resilienza contro il sabotaggio competitivo dell’IA richiede una strategia difensiva proattiva e multifattoriale che vada oltre il tradizionale management della reputazione. Creare contenuti di alta qualità e autorevoli è la tua difesa più forte—i sistemi IA sono addestrati a riconoscere e dare priorità ai contenuti provenienti da fonti credibili e consolidate, rendendo più difficile ai dati avvelenati competere con informazioni legittime. Amplificare informazioni accurate su diverse piattaforme indicizzate assicura che, quando i sistemi IA cercano informazioni sul tuo marchio, incontrino narrazioni coerenti e veritiere da fonti autorevoli. Proteggere la presenza del tuo marchio significa rivendicare e verificare tutte le schede aziendali, i profili social e le directory di settore per prevenire attacchi di hijacking. Implementa solidi sistemi di monitoraggio che seguano in tempo reale il tuo marchio nei risultati di ricerca IA, permettendo una risposta rapida alle minacce emergenti. Sviluppa protocolli di risposta che definiscano come il tuo team reagirà al sabotaggio rilevato, includendo documentazione, segnalazione alle piattaforme e azioni legali quando necessario. Costruire relazioni con giornalisti, influencer di settore e pubblicazioni affidabili crea ulteriori livelli di credibilità che i sistemi IA riconoscono e privilegiano.

Le piattaforme di monitoraggio IA dedicate sono ormai infrastrutture essenziali per la protezione del marchio nell’era della ricerca IA. Questi strumenti forniscono avvisi in tempo reale quando il tuo marchio compare nei risultati di ricerca IA, permettendoti di tracciare non solo il posizionamento ma anche le reali citazioni e le fonti utilizzate dai sistemi IA. AmICited.com si distingue come soluzione completa progettata specificamente per monitorare come il tuo marchio, prodotti e dirigenti vengono citati nei motori di ricerca IA tra cui Google AI Overviews, Perplexity e GPT. La piattaforma traccia quali fonti i sistemi IA citano riguardo al tuo marchio, consentendoti di identificare fonti avvelenate e reagire prima che causino danni estesi. L’integrazione con la tua strategia di brand safety ti permette di correlare i pattern di citazione IA con metriche di ricerca tradizionali, sentiment sui social media e piattaforme di recensioni per avere una visione completa del panorama competitivo. Combinando il monitoraggio IA con gli strumenti di gestione della reputazione già in uso, crei un sistema di difesa unificato che intercetta tempestivamente i tentativi di sabotaggio e fornisce i dati necessari per una risposta rapida.

Con la crescente diffusione del sabotaggio competitivo dell’IA, i quadri normativi si stanno evolvendo per affrontare queste nuove minacce. Gli avvisi di rimozione DMCA possono essere utilizzati per eliminare contenuti avvelenati dalle fonti indicizzate, anche se il processo è spesso lento e richiede prove chiare di violazione del copyright o di impersonificazione. Il diritto alla diffamazione offre tutela quando il sabotaggio comporta affermazioni false che danneggiano la reputazione, anche se dimostrare i danni nell’ambito IA resta complesso. La maggior parte delle piattaforme principali ora ha meccanismi di segnalazione specifici per abusi legati all’IA, inclusi avvelenamento dei dati, false recensioni e campagne di disinformazione, anche se l’applicazione varia molto. Regolamenti emergenti come l’EU AI Act e proposte legislative negli USA iniziano a stabilire quadri di responsabilità per i sistemi IA che amplificano informazioni false, creando potenzialmente nuove strade per azioni legali. Le aziende dovrebbero documentare accuratamente tutti i tentativi di sabotaggio, poiché questa evidenza è cruciale sia per i procedimenti legali che per i ricorsi alle piattaforme. Consultare un legale esperto in IA e reputazione digitale è sempre più importante per sviluppare strategie di risposta conformi alle normative in evoluzione.

Il panorama del sabotaggio competitivo dell’IA continuerà ad evolversi man mano che sia aggressori che difensori svilupperanno tecniche sempre più sofisticate. False recensioni generate dall’IA tramite grandi modelli linguistici saranno sempre più difficili da distinguere dai veri feedback degli utenti, richiedendo sistemi di rilevamento più avanzati. La verifica tramite blockchain e sistemi decentralizzati di credibilità stanno emergendo come possibili soluzioni per garantire l’autenticità delle fonti prima che i dati vengano incorporati nei set di addestramento IA. I fornitori di piattaforma stanno investendo molto in difese migliori, inclusa la validazione dei dati, la verifica delle fonti e algoritmi per il rilevamento di avvelenamenti, anche se queste misure saranno sempre indietro rispetto ai nuovi vettori di attacco. Sistemi di verifica basati sulla comunità, in cui utenti ed esperti segnalano contenuti sospetti, potrebbero diventare la prassi, creando una difesa crowdsourced contro il sabotaggio. Il vantaggio competitivo apparterrà sempre più alle aziende che anticipano le minacce emergenti attraverso monitoraggio continuo, protocolli di risposta rapida e investimenti nella cultura IA dei propri team. Le organizzazioni che trattano il monitoraggio IA come parte fondamentale della strategia di protezione del marchio oggi saranno le più pronte a difendersi dagli attacchi più sofisticati di domani.

Il negative SEO tradizionale prende di mira il posizionamento nei motori di ricerca attraverso la manipolazione dei link e il scraping dei contenuti. Il sabotaggio competitivo dell'IA prende di mira i dati di addestramento dell'IA e il comportamento del modello, avvelenando le fonti che i sistemi IA citano nelle risposte. I sistemi IA sono più vulnerabili perché citano direttamente le fonti e si fidano dei dati di addestramento più degli algoritmi di ricerca tradizionali.

Monitora settimanalmente come le piattaforme IA descrivono il tuo marchio utilizzando strumenti come AmICited.com. Controlla improvvisi cambiamenti di sentiment, affermazioni false che compaiono nelle risposte IA, recensioni negative coordinate o la diffusione di disinformazione sulle piattaforme. Il rilevamento precoce entro le prime 48 ore è fondamentale per il contenimento.

Documenta tutto immediatamente con screenshot e marcature temporali. Segnala alle piattaforme coinvolte (OpenAI, Google, Anthropic). Diffondi informazioni corrette attraverso i tuoi canali. Contatta un legale se si sono verificati diffamazione o danni economici. Implementa sistemi di monitoraggio per individuare tempestivamente futuri attacchi.

Le ricerche dimostrano che agli aggressori bastano solo 250 documenti dannosi o il 7-8% di un dataset per avvelenare in modo significativo i modelli IA. Questa soglia bassa rende i sistemi IA particolarmente vulnerabili rispetto ai motori di ricerca tradizionali, che hanno meccanismi di rilevamento dello spam più sofisticati.

Le attuali piattaforme IA hanno capacità di rilevamento limitate e si affidano principalmente alle segnalazioni degli utenti e a periodici riaddestramenti con dati puliti. Tuttavia, le piattaforme stanno implementando sistemi di verifica migliori, rilevamento di anomalie e controlli di accesso. La responsabilità del rilevamento precoce ricade spesso sulle aziende stesse.

Costruisci una reputazione autentica con contenuti di alta qualità, monitora regolarmente i risultati di ricerca IA, proteggi la presenza del tuo marchio su directory, implementa sistemi di monitoraggio in tempo reale e rispondi rapidamente agli attacchi. La prevenzione tramite la costruzione della reputazione è più efficace della risoluzione dopo il sabotaggio.

AmICited.com monitora come le piattaforme IA (ChatGPT, Perplexity, Google AI Overviews) fanno riferimento al tuo marchio, tracciando cambiamenti di sentiment e modelli di citazione. Avvisi in tempo reale ti notificano improvvisi cambiamenti nel modo in cui l'IA descrive il tuo marchio, permettendo una risposta rapida ai tentativi di sabotaggio.

Puoi intentare azioni per diffamazione, presentare richieste DMCA per la rimozione di contenuti falsi, segnalare alle piattaforme per violazioni dei termini di servizio e potenzialmente richiedere risarcimenti per danni finanziari. La documentazione del sabotaggio è fondamentale. Consulta un avvocato specializzato in diritti digitali e proprietà intellettuale.

Proteggi il tuo marchio dal sabotaggio competitivo dell'IA con il monitoraggio in tempo reale su ChatGPT, Perplexity e Google AI Overviews. Rileva le minacce prima che danneggino la tua reputazione.

Scopri come confrontare la tua visibilità AI rispetto ai concorrenti. Monitora citazioni, quota di voce e posizionamento competitivo su ChatGPT, Perplexity e Go...

Discussione della community sulle tattiche black hat che danneggiano la visibilità AI. Approfondimenti reali su avvelenamento AI, manipolazione dei contenuti e ...

Scopri cosa significa la cannibalizzazione dei contenuti nella ricerca AI, come influisce sulla visibilità del tuo brand nelle risposte AI e perché è importante...