Analisi AI Crawl

Scopri cos’è l’analisi AI crawl e come l’analisi dei log del server monitora il comportamento dei crawler AI, i modelli di accesso ai contenuti e la visibilità ...

L’analisi dei file di log è il processo di esaminare i log di accesso del server per comprendere come i crawler dei motori di ricerca e i bot AI interagiscono con un sito web, rivelando pattern di scansione, problemi tecnici e opportunità di ottimizzazione per le prestazioni SEO.

L'analisi dei file di log è il processo di esaminare i log di accesso del server per comprendere come i crawler dei motori di ricerca e i bot AI interagiscono con un sito web, rivelando pattern di scansione, problemi tecnici e opportunità di ottimizzazione per le prestazioni SEO.

L’analisi dei file di log è l’esame sistematico dei log di accesso al server per comprendere come crawler dei motori di ricerca, bot AI e utenti interagiscono con un sito web. Questi log vengono generati automaticamente dai web server e contengono registrazioni dettagliate di ogni richiesta HTTP effettuata al tuo sito, inclusi indirizzo IP del richiedente, timestamp, URL richiesto, codice di stato HTTP e stringa user-agent. Per i professionisti SEO, l’analisi dei file di log rappresenta la fonte definitiva di verità sul comportamento dei crawler, rivelando pattern che strumenti superficiali come Google Search Console o crawler tradizionali non possono catturare. A differenza delle simulazioni di crawl o dei dati analitici aggregati, i log del server forniscono prove non filtrate e di prima parte di ciò che motori di ricerca e sistemi AI stanno effettivamente facendo sul tuo sito in tempo reale.

L’importanza dell’analisi dei file di log è cresciuta esponenzialmente con l’evoluzione del panorama digitale. Con oltre il 51% del traffico internet globale ora generato da bot (ACS, 2025), e crawler AI come GPTBot, ClaudeBot e PerplexityBot che diventano visitatori regolari dei siti web, comprendere il comportamento dei crawler non è più opzionale—è essenziale per mantenere la visibilità sia nella ricerca tradizionale che nelle piattaforme emergenti di ricerca AI. L’analisi dei file di log colma il divario tra ciò che pensi stia accadendo sul tuo sito e ciò che realmente accade, permettendo decisioni data-driven che impattano direttamente ranking, velocità di indicizzazione e performance organica complessiva.

L’analisi dei file di log è da decenni una pietra miliare della SEO tecnica, ma la sua rilevanza è cresciuta drammaticamente negli ultimi anni. Storicamente, i professionisti SEO si affidavano principalmente a Google Search Console e a crawler di terze parti per comprendere il comportamento dei motori di ricerca. Tuttavia, questi strumenti hanno limiti significativi: Google Search Console fornisce solo dati aggregati e campionati dai crawler di Google; i crawler di terze parti simulano il comportamento dei crawler invece di catturare le interazioni reali; e nessuno dei due traccia efficacemente motori di ricerca non-Google o bot AI.

L’emergere di piattaforme di ricerca alimentate dall’AI ha cambiato radicalmente il panorama. Secondo una ricerca di Cloudflare del 2024, Googlebot rappresenta il 39% di tutto il traffico dei crawler AI e di ricerca, mentre i crawler specifici per l’AI sono ora il segmento a più rapida crescita. I bot AI di Meta da soli generano il 52% del traffico dei crawler AI, più del doppio di Google (23%) o OpenAI (20%). Questo cambiamento significa che i siti web ricevono ora visite da dozzine di diversi tipi di bot, molti dei quali non seguono i protocolli SEO tradizionali o rispettano le regole standard del robots.txt. L’analisi dei file di log è l’unico metodo che cattura questo quadro completo, rendendola indispensabile per le strategie SEO moderne.

Il mercato globale della gestione dei log è destinato a crescere dai 3.228,5 milioni di dollari nel 2025 a valutazioni significativamente superiori entro il 2029, con un tasso di crescita annuale composto (CAGR) del 14,6%. Questa crescita riflette una crescente consapevolezza aziendale che l’analisi dei log è cruciale per la sicurezza, il monitoraggio delle prestazioni e l’ottimizzazione SEO. Le organizzazioni stanno investendo molto in strumenti automatizzati di analisi dei log e piattaforme AI in grado di processare milioni di voci di log in tempo reale, trasformando dati grezzi in insight azionabili che guidano i risultati di business.

Quando un utente o un bot richiede una pagina del tuo sito, il web server elabora la richiesta e registra informazioni dettagliate sull’interazione. Questo processo avviene automaticamente e in modo continuo, creando una traccia di audit completa di tutta l’attività del server. Comprendere come funziona è essenziale per interpretare correttamente i dati dei file di log.

Il flusso tipico inizia quando un crawler (che sia Googlebot, un bot AI o il browser di un utente) invia una richiesta HTTP GET al tuo server, includendo una stringa user-agent che lo identifica. Il server riceve la richiesta, la elabora e restituisce un codice di stato HTTP (200 per successo, 404 per non trovato, 301 per redirect permanente, ecc.) insieme al contenuto richiesto. Ognuna di queste interazioni viene registrata nel file di log di accesso del server, creando una voce con timestamp che cattura indirizzo IP, URL richiesto, metodo HTTP, codice di stato, dimensione della risposta, referrer e stringa user-agent.

I codici di stato HTTP sono particolarmente importanti per l’analisi SEO. Un codice 200 indica la consegna corretta della pagina; i codici 3xx indicano redirect; i 4xx errori lato client (come 404 Not Found); e i 5xx errori lato server. Analizzando la distribuzione di questi codici nei log, puoi individuare problemi tecnici che impediscono ai crawler di accedere ai tuoi contenuti. Ad esempio, se un crawler riceve più risposte 404 tentando di accedere a pagine importanti, segnala un link rotto o un contenuto mancante che richiede attenzione immediata.

Le stringhe user-agent sono altrettanto cruciali per identificare quali bot visitano il tuo sito. Ogni crawler ha una stringa user-agent unica che lo identifica. Quella di Googlebot include “Googlebot/2.1”, quella di GPTBot “GPTBot/1.0” e quella di ClaudeBot “ClaudeBot”. Analizzando queste stringhe, puoi segmentare i dati di log per analizzare il comportamento di specifici tipi di crawler, rivelando quali bot danno priorità a quali contenuti e come differiscono i loro pattern di scansione. Questa analisi granulare permette strategie di ottimizzazione mirate per diverse piattaforme di ricerca e sistemi AI.

| Aspetto | Analisi File di Log | Google Search Console | Crawler di Terze Parti | Strumenti di Analytics |

|---|---|---|---|---|

| Fonte Dati | Log server (prima parte) | Dati di crawl Google | Crawl simulati | Monitoraggio comportamento utenti |

| Completezza | 100% di tutte le richieste | Dati aggregati, campionati | Solo simulazioni | Solo traffico umano |

| Copertura Bot | Tutti i crawler (Google, Bing, bot AI) | Solo Google | Crawler simulati | Nessun dato bot |

| Dati Storici | Cronologia completa (variabile) | Periodo limitato | Snapshot singolo | Storico disponibile |

| Insight in Tempo Reale | Sì (con automazione) | Reporting ritardato | No | Reporting ritardato |

| Visibilità Crawl Budget | Pattern esatti di crawl | Riepilogo generico | Stime | Non applicabile |

| Problemi Tecnici | Dettagliati (codici stato, tempi risposta) | Visibilità limitata | Problemi simulati | Non applicabile |

| Tracciamento Bot AI | Sì (GPTBot, ClaudeBot, ecc.) | No | No | No |

| Costo | Gratuito (log server) | Gratuito | Strumenti a pagamento | Gratis/A pagamento |

| Complessità Configurazione | Da media ad alta | Semplice | Semplice | Semplice |

L’analisi dei file di log è diventata indispensabile per comprendere come motori di ricerca e sistemi AI interagiscono con il tuo sito. A differenza di Google Search Console, che offre solo la prospettiva di Google e dati aggregati, i file di log catturano il quadro completo di tutta l’attività dei crawler. Questa visione completa è essenziale per identificare sprechi di crawl budget, cioè quando i motori di ricerca spendono risorse su pagine a basso valore invece che su contenuti importanti. Le ricerche mostrano che i grandi siti spesso sprecano il 30-50% del crawl budget su URL non essenziali come archivi paginati, navigazione a filtri o contenuti obsoleti.

L’ascesa della ricerca alimentata dall’AI rende l’analisi dei file di log ancora più cruciale. Con bot AI come GPTBot, ClaudeBot e PerplexityBot che visitano regolarmente i siti, comprenderne il comportamento è fondamentale per ottimizzare la visibilità nelle risposte AI. Questi bot spesso si comportano diversamente dai crawler tradizionali—possono ignorare le regole robots.txt, scansionare più aggressivamente o concentrarsi su tipi specifici di contenuti. Solo l’analisi dei file di log rivela questi pattern, permettendoti di ottimizzare il sito per la scoperta AI e gestire l’accesso dei bot tramite regole mirate.

I problemi tecnici SEO che altrimenti passerebbero inosservati possono essere individuati tramite l’analisi dei log. Catene di redirect, errori server 5xx, tempi di caricamento lenti e problemi di rendering JavaScript lasciano tutti tracce nei log del server. Analizzando questi pattern, puoi dare priorità alle correzioni che incidono direttamente su accessibilità e velocità di indicizzazione. Ad esempio, se i log mostrano che Googlebot riceve costantemente errori 503 Service Unavailable su una sezione del sito, sai esattamente dove concentrare gli sforzi tecnici.

Ottenere i log del server è il primo passo nell’analisi dei file di log, ma il processo varia a seconda dell’ambiente di hosting. Per server self-hosted con Apache o NGINX, i log sono generalmente archiviati in /var/log/apache2/access.log o /var/log/nginx/access.log. Puoi accedere a questi file direttamente via SSH o tramite il file manager del server. Per hosting WordPress gestito come WP Engine o Kinsta, i log possono essere disponibili tramite la dashboard di hosting o via SFTP, anche se alcuni provider limitano l’accesso per proteggere le prestazioni del server.

Le Content Delivery Network (CDN) come Cloudflare, AWS CloudFront e Akamai richiedono una configurazione speciale per accedere ai log. Cloudflare offre Logpush, che invia i log delle richieste HTTP verso bucket di storage designati (AWS S3, Google Cloud Storage, Azure Blob Storage) per il recupero e l’analisi. AWS CloudFront fornisce logging standard configurabile per archiviare i log nei bucket S3. Questi log CDN sono essenziali per capire come i bot interagiscono con il tuo sito quando i contenuti sono serviti tramite CDN, poiché catturano le richieste all’edge invece che al server originario.

Gli ambienti di hosting condiviso spesso offrono accesso limitato ai log. Provider come Bluehost e GoDaddy possono offrire log parziali tramite cPanel, ma questi log ruotano frequentemente e possono escludere campi critici. Se sei su hosting condiviso e hai bisogno di analisi esaustiva dei log, valuta l’upgrade a un VPS o a un hosting gestito che garantisca pieno accesso ai log.

Una volta ottenuti i log, la preparazione dei dati è essenziale. I file di log grezzi contengono richieste da tutte le fonti—utenti, bot, scraper e attori malevoli. Per l’analisi SEO, dovrai filtrare il traffico non rilevante e concentrarti sull’attività dei motori di ricerca e dei bot AI. Questo generalmente prevede:

L’analisi dei file di log svela insight invisibili ad altri strumenti SEO, fornendo la base per decisioni strategiche di ottimizzazione. Uno dei più preziosi è l’analisi dei pattern di scansione, che mostra esattamente quali pagine i motori di ricerca visitano e con quale frequenza. Tracciando la frequenza di scansione nel tempo, puoi identificare se Google aumenta o riduce l’attenzione su specifiche sezioni del sito. Calo improvviso della frequenza può indicare problemi tecnici o cambi di importanza percepita, mentre gli aumenti suggeriscono una risposta positiva alle ottimizzazioni.

L’efficienza del crawl budget è un altro insight cruciale. Analizzando il rapporto tra risposte di successo (2xx) e risposte di errore (4xx, 5xx), puoi individuare sezioni del sito dove i crawler incontrano problemi. Se una directory restituisce costantemente errori 404, si spreca crawl budget su link rotti. Allo stesso modo, se i crawler dedicano troppo tempo a URL paginati o a navigazioni a filtri, il budget viene sprecato su contenuti di basso valore. L’analisi dei log quantifica questo spreco, permettendoti di calcolare l’impatto potenziale degli interventi di ottimizzazione.

La scoperta delle pagine orfane è un vantaggio unico dell’analisi dei log. Le pagine orfane sono URL senza link interni, quindi fuori dalla struttura del sito. I crawler tradizionali spesso non le trovano tramite la navigazione interna, ma i log rivelano che i motori di ricerca le scansionano ancora—spesso perché sono collegate dall’esterno o presenti in vecchie sitemap. Identificando queste pagine orfane, puoi decidere se reintegrarle nella struttura, reindirizzarle o eliminarle.

L’analisi del comportamento dei bot AI assume un’importanza crescente. Segmentando i dati di log per user-agent di bot AI, puoi vedere quali contenuti questi bot privilegiano, con quale frequenza visitano il sito e se incontrano barriere tecniche. Ad esempio, se GPTBot scansiona frequentemente le FAQ ma raramente il blog, significa che i sistemi AI ritengono il contenuto in stile FAQ più utile per i dati di addestramento. Questo insight può guidare la content strategy e ottimizzare la visibilità AI.

Un’analisi efficace dei file di log richiede sia gli strumenti giusti sia un approccio strategico. Log File Analyzer di Screaming Frog è tra gli strumenti dedicati più popolari, offrendo interfacce user-friendly per processare grandi file di log, identificare pattern di bot e visualizzare i dati di scansione. Botify offre analisi log di livello enterprise integrate con metriche SEO, permettendo di correlare l’attività dei bot con ranking e traffico. Bot Clarity di seoClarity integra l’analisi dei log direttamente nella piattaforma SEO, facilitando il collegamento tra dati di crawl e altre metriche SEO.

Per organizzazioni con grandi volumi di traffico o infrastrutture complesse, piattaforme di analisi dei log AI-powered come Splunk, Sumo Logic ed Elastic Stack offrono capacità avanzate tra cui riconoscimento automatico dei pattern, rilevamento anomalie e analytics predittivi. Queste piattaforme processano milioni di voci di log in tempo reale, identificando automaticamente nuovi tipi di bot e segnalando attività insolite che possono indicare minacce di sicurezza o problemi tecnici.

Le best practice per l’analisi dei file di log includono:

Con la crescente importanza della ricerca AI, il monitoraggio dei bot AI tramite l’analisi dei file di log è diventato una funzione SEO critica. Tracciando quali bot AI visitano il sito, quali contenuti accedono e con quale frequenza scansionano, puoi capire come i tuoi contenuti alimentano strumenti di ricerca AI e modelli generativi. Questi dati permettono di decidere consapevolmente se consentire, bloccare o limitare specifici bot AI tramite regole robots.txt o header HTTP.

L’ottimizzazione del crawl budget è forse l’applicazione più impattante dell’analisi dei file di log. Per grandi siti con migliaia o milioni di pagine, il crawl budget è una risorsa limitata. Analizzando i log, puoi identificare pagine scansionate troppo spesso rispetto alla loro importanza e pagine che dovrebbero essere scansionate più frequentemente ma non lo sono. Gli scenari comuni di spreco di crawl budget includono:

Affrontando questi problemi—tramite regole robots.txt, canonical, tag noindex o correzioni tecniche—puoi reindirizzare il crawl budget verso contenuti di valore, migliorando velocità di indicizzazione e visibilità delle pagine più importanti per il tuo business.

Il futuro dell’analisi dei file di log è plasmato dalla rapida evoluzione della ricerca alimentata dall’AI. Con sempre più bot AI nell’ecosistema e comportamenti sempre più sofisticati, l’analisi dei file di log sarà ancora più cruciale per capire come i tuoi contenuti vengono scoperti, acceduti e utilizzati dai sistemi AI. I trend emergenti includono:

L’analisi in tempo reale dei log alimentata dal machine learning permetterà ai SEO di rilevare e rispondere a problemi di scansione in pochi minuti anziché giorni. Sistemi automatici identificheranno nuovi tipi di bot, segnaleranno pattern insoliti e suggeriranno azioni di ottimizzazione senza intervento manuale. Questo passaggio da analisi reattiva a proattiva permetterà di mantenere costantemente ottimale la scansabilità e l’indicizzazione.

L’integrazione con il monitoraggio della visibilità AI collegherà i dati dei file di log con metriche di performance nella ricerca AI. Invece di analizzare i log in isolamento, i SEO potranno correlare il comportamento dei crawler con la visibilità effettiva nelle risposte AI, comprendendo esattamente come i pattern di scansione impattano il ranking nelle ricerche AI. Questa integrazione offrirà insight senza precedenti su come il contenuto passa dal crawl ai dati di training AI alle risposte AI rivolte agli utenti.

La gestione etica dei bot diventerà sempre più importante man mano che le organizzazioni dovranno decidere quali bot AI possono accedere ai propri contenuti. L’analisi dei file di log permetterà un controllo granulare sull’accesso dei bot, consentendo ai publisher di permettere crawler AI utili e bloccare quelli che non forniscono valore o attribuzione. Standard come il nascente protocollo LLMs.txt offriranno modi strutturati per comunicare le policy di accesso ai bot, e l’analisi dei log verificherà la conformità.

L’analisi privacy-preserving si evolverà per bilanciare il bisogno di insight dettagliati sui crawl con regole sulla privacy come il GDPR. Tecniche avanzate di anonimizzazione e strumenti di analisi focalizzati sulla privacy permetteranno alle organizzazioni di estrarre insight preziosi dai log senza conservare o esporre dati personali. Questo sarà particolarmente importante con la diffusione dell’analisi dei log e il rafforzamento delle norme sulla protezione dei dati.

La convergenza tra SEO tradizionale e ottimizzazione per la ricerca AI significa che l’analisi dei file di log rimarrà una pietra miliare della strategia SEO tecnica per molti anni. Le organizzazioni che padroneggeranno oggi l’analisi dei file di log saranno pronte a mantenere visibilità e performance man mano che la ricerca continuerà a evolvere.

L'analisi dei file di log fornisce dati completi e non campionati dal tuo server che catturano ogni richiesta di tutti i crawler, mentre le statistiche di scansione di Google Search Console mostrano solo dati aggregati e campionati dei crawler di Google. I file di log offrono dati storici granulari e insight sul comportamento di bot non-Google, inclusi bot AI come GPTBot e ClaudeBot, rendendoli più completi per comprendere il vero comportamento dei crawler e identificare problemi tecnici che la GSC può non rilevare.

Per siti ad alto traffico, è consigliata un'analisi settimanale dei file di log per individuare tempestivamente problemi e monitorare i cambiamenti nei pattern di scansione. I siti più piccoli traggono beneficio da revisioni mensili per individuare trend e nuove attività di bot. Indipendentemente dalla dimensione del sito, l’implementazione di un monitoraggio continuo tramite strumenti automatizzati aiuta a rilevare anomalie in tempo reale, assicurando risposte rapide a sprechi di crawl budget o problemi tecnici che influenzano la visibilità sui motori di ricerca.

Sì, l'analisi dei file di log è uno dei modi più efficaci per tracciare il traffico dei bot AI. Esaminando le stringhe user-agent e gli indirizzi IP nei log del server, puoi identificare quali bot AI visitano il tuo sito, quali contenuti accedono e con quale frequenza effettuano la scansione. Questi dati sono fondamentali per capire come i tuoi contenuti alimentano strumenti di ricerca AI e modelli generativi, permettendoti di ottimizzare la visibilità AI e gestire l’accesso dei bot tramite regole robots.txt.

L'analisi dei file di log rivela numerosi problemi tecnici SEO tra cui errori di scansione (codici di stato 4xx e 5xx), catene di redirect, tempi di caricamento lenti delle pagine, pagine orfane non collegate internamente, spreco di crawl budget su URL di basso valore, problemi di rendering JavaScript e contenuti duplicati. Identifica anche attività di bot falsificati e aiuta a rilevare quando i crawler legittimi incontrano barriere di accessibilità, permettendoti di dare priorità alle correzioni che incidono direttamente sulla visibilità e indicizzazione nei motori di ricerca.

L'analisi dei file di log mostra esattamente quali pagine i motori di ricerca scansionano e con quale frequenza, rivelando dove il crawl budget viene sprecato su contenuti di scarso valore come archivi paginati, navigazioni a filtri o URL obsoleti. Identificando queste inefficienze, puoi aggiornare il file robots.txt, migliorare la struttura dei link interni verso le pagine prioritarie e implementare canonical per indirizzare l’attenzione dei crawler sui contenuti di maggior valore, assicurando che i motori di ricerca si concentrino sulle pagine più importanti per il tuo business.

I file di log del server tipicamente registrano indirizzi IP (che identificano la fonte della richiesta), timestamp (quando si sono verificate le richieste), metodi HTTP (solitamente GET o POST), URL richiesti (le pagine esatte visitate), codici di stato HTTP (200, 404, 301, ecc.), dimensione della risposta in byte, informazioni sul referrer e stringhe user-agent (che identificano il crawler o il browser). Questi dati completi permettono ai SEO di ricostruire esattamente cosa è successo durante ogni interazione con il server e identificare pattern che influenzano la scansibilità e l’indicizzazione.

I bot falsificati si spacciano per crawler legittimi dei motori di ricerca ma hanno indirizzi IP che non corrispondono agli intervalli IP ufficiali pubblicati dal motore di ricerca. Per identificarli, confronta le stringhe user-agent (come 'Googlebot') con gli intervalli IP ufficiali pubblicati da Google, Bing e altri motori. Strumenti come il Log File Analyzer di Screaming Frog validano automaticamente l’autenticità dei bot. I bot falsificati sprecano crawl budget e possono mettere sotto stress il server, quindi è raccomandato bloccarli tramite robots.txt o regole firewall.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Scopri cos’è l’analisi AI crawl e come l’analisi dei log del server monitora il comportamento dei crawler AI, i modelli di accesso ai contenuti e la visibilità ...

Discussione della community sulla frequenza e il comportamento dei crawler AI. Dati reali da webmaster che tracciano GPTBot, PerplexityBot e altri bot AI nei lo...

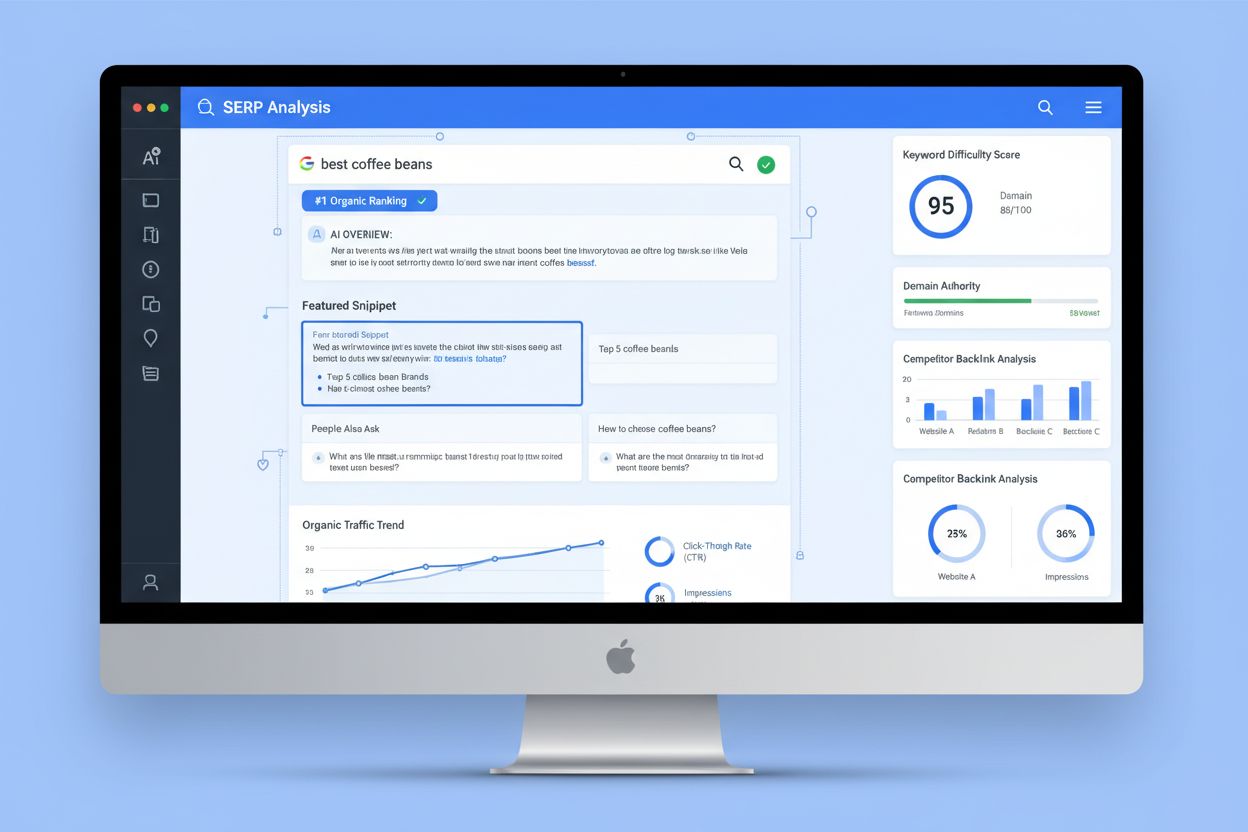

L'Analisi SERP è il processo di esame delle pagine dei risultati dei motori di ricerca per comprendere la difficoltà di posizionamento, l'intento di ricerca e l...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.