Dati di addestramento

I dati di addestramento sono il dataset utilizzato per insegnare ai modelli ML schemi e relazioni. Scopri come la qualità dei dati di addestramento influisce su...

I parametri del modello sono variabili apprendibili all’interno dei modelli di intelligenza artificiale, come pesi e bias, che vengono automaticamente regolati durante l’addestramento per ottimizzare la capacità del modello di effettuare previsioni accurate e definiscono come il modello elabora i dati di input per generare output.

I parametri del modello sono variabili apprendibili all'interno dei modelli di intelligenza artificiale, come pesi e bias, che vengono automaticamente regolati durante l'addestramento per ottimizzare la capacità del modello di effettuare previsioni accurate e definiscono come il modello elabora i dati di input per generare output.

I parametri del modello sono variabili apprendibili all’interno dei modelli di intelligenza artificiale che vengono automaticamente regolate durante il processo di addestramento per ottimizzare la capacità del modello di effettuare previsioni accurate e definire come il modello elabora i dati di input per generare output. Questi parametri fungono da veri e propri “manopole di controllo” dei sistemi di apprendimento automatico, determinando il comportamento preciso e i pattern decisionali dei modelli di IA. Nel contesto del deep learning e delle reti neurali, i parametri sono principalmente costituiti da pesi e bias — valori numerici che controllano come l’informazione fluisce nella rete e quanto fortemente le diverse caratteristiche influenzano le previsioni. Lo scopo dell’addestramento è quello di trovare i valori ottimali per questi parametri che minimizzino gli errori di previsione e consentano al modello di generalizzare bene su nuovi dati mai visti prima. Comprendere i parametri del modello è essenziale per capire come funzionano i moderni sistemi di IA come ChatGPT, Claude, Perplexity e Google AI Overviews e perché producono output diversi per lo stesso input.

Il concetto di parametri apprendibili nell’apprendimento automatico risale ai primi giorni delle reti neurali artificiali negli anni ‘50 e ‘60, quando i ricercatori compresero per la prima volta che le reti potevano regolare valori interni per apprendere dai dati. Tuttavia, l’applicazione pratica dei parametri rimase limitata fino all’avvento della retropropagazione negli anni ‘80, che fornì un algoritmo efficiente per calcolare come regolare i parametri per ridurre gli errori. L’esplosione nella quantità di parametri è accelerata notevolmente con l’ascesa del deep learning negli anni 2010. Le prime reti neurali convoluzionali per il riconoscimento delle immagini contenevano milioni di parametri, mentre i moderni grandi modelli linguistici (LLM) ne contengono centinaia di miliardi o addirittura trilioni. Secondo ricerche di Our World in Data ed Epoch AI, il numero di parametri nei principali sistemi di IA è cresciuto esponenzialmente, con GPT-3 che contiene 175 miliardi di parametri, GPT-4o circa 200 miliardi e alcune stime suggeriscono che GPT-4 possa arrivare fino a 1,8 trilioni di parametri considerando architetture mixture-of-experts. Questa scala drammatica ha trasformato radicalmente ciò che i sistemi di IA possono realizzare, permettendo loro di catturare pattern sempre più complessi in compiti di linguaggio, visione e ragionamento.

I parametri del modello operano tramite un quadro matematico in cui ciascun parametro rappresenta un valore numerico che influenza come il modello trasforma gli input in output. In un semplice modello di regressione lineare, i parametri sono la pendenza (m) e l’intercetta (b) nell’equazione y = mx + b, dove questi due valori determinano la retta che meglio si adatta ai dati. Nelle reti neurali, la situazione diventa esponenzialmente più complessa. Ogni neurone in uno strato riceve input dallo strato precedente, moltiplica ciascun input per un corrispondente parametro di peso, somma questi input ponderati, aggiunge un parametro di bias e passa il risultato attraverso una funzione di attivazione per produrre un output. Questo output diventa quindi input per i neuroni nello strato successivo, creando una catena a cascata di trasformazioni guidate dai parametri. Durante l’addestramento, il modello utilizza la discesa del gradiente e algoritmi di ottimizzazione simili per calcolare come ciascun parametro debba essere regolato per ridurre la funzione di perdita — una misura matematica dell’errore di previsione. Il gradiente della perdita rispetto a ciascun parametro indica la direzione e la grandezza della regolazione necessaria. Attraverso la retropropagazione, questi gradienti scorrono all’indietro nella rete, permettendo all’ottimizzatore di aggiornare tutti i parametri simultaneamente in modo coordinato. Questo processo iterativo continua per molte epoche di addestramento fino a quando i parametri convergono su valori che minimizzano la perdita sui dati di addestramento mantenendo una buona generalizzazione su nuovi dati.

| Aspetto | Parametri del Modello | Iperparametri | Caratteristiche (Features) |

|---|---|---|---|

| Definizione | Variabili apprendibili regolate durante l’addestramento | Impostazioni di configurazione definite prima dell’addestramento | Caratteristiche dei dati di input utilizzate dal modello |

| Quando vengono impostati | Appresi automaticamente tramite ottimizzazione | Configurati manualmente dai professionisti | Estratti o ingegnerizzati dai dati grezzi |

| Esempi | Pesi, bias nelle reti neurali | Tasso di apprendimento, batch size, numero di strati | Valori dei pixel nelle immagini, embedding di parole nei testi |

| Impatto sul modello | Determinano come il modello mappa input su output | Controllano il processo di addestramento e la struttura del modello | Forniscono le informazioni grezze da cui il modello apprende |

| Metodo di ottimizzazione | Discesa del gradiente, Adam, AdaGrad | Grid search, random search, ottimizzazione bayesiana | Feature engineering, selezione delle caratteristiche |

| Numero nei grandi modelli | Da miliardi a trilioni (es. 200B in GPT-4o) | Tipicamente 5-20 iperparametri chiave | Da migliaia a milioni a seconda dei dati |

| Costo computazionale | Alto durante l’addestramento; impatta la velocità di inferenza | Costo computazionale minimo per impostarli | Determinato dalla raccolta e pre-elaborazione dei dati |

| Trasferibilità | Possono essere trasferiti tramite fine-tuning e transfer learning | Devono essere riadattati per nuovi compiti | Possono richiedere re-ingegnerizzazione per nuovi domini |

I parametri del modello assumono forme diverse a seconda dell’architettura e del tipo di modello di apprendimento automatico utilizzato. Nelle reti neurali convoluzionali (CNN) impiegate per il riconoscimento delle immagini, i parametri includono i pesi nei filtri convoluzionali (detti anche kernel) che rilevano pattern spaziali come bordi, texture e forme a diverse scale. Le reti neurali ricorrenti (RNN) e le reti LSTM contengono parametri che controllano il flusso di informazioni nel tempo, inclusi parametri di gating che determinano quali informazioni ricordare o dimenticare. I modelli transformer, che alimentano i moderni grandi modelli linguistici, contengono parametri in molteplici componenti: pesi di attenzione che decidono su quali parti dell’input focalizzarsi, pesi delle reti feed-forward e parametri di normalizzazione degli strati. Nei modelli probabilistici come Naive Bayes, i parametri definiscono distribuzioni di probabilità condizionata. Le macchine a vettori di supporto (SVM) usano parametri che posizionano e orientano i confini decisionali nello spazio delle caratteristiche. I modelli Mixture of Experts (MoE), utilizzati in alcune versioni di GPT-4, contengono parametri per molteplici sub-reti specializzate più parametri di routing che determinano quali esperti processano ciascun input. Questa diversità architetturale significa che la natura e il numero di parametri varia notevolmente tra i diversi tipi di modelli, ma il principio fondamentale rimane costante: i parametri sono i valori appresi che consentono al modello di svolgere il proprio compito.

Pesi e bias rappresentano i due tipi fondamentali di parametri nelle reti neurali e costituiscono la base di come questi modelli apprendono. I pesi sono valori numerici assegnati alle connessioni tra neuroni, determinando la forza e la direzione dell’influenza che l’output di un neurone ha sull’input del successivo. In uno strato completamente connesso con 1.000 neuroni di input e 500 di output, ci sarebbero 500.000 parametri di peso — uno per ogni connessione. Durante l’addestramento, i pesi vengono regolati per aumentare o diminuire l’influenza di specifiche caratteristiche sulle previsioni. Un peso positivo elevato significa che quella caratteristica attiva fortemente il neurone successivo, mentre un peso negativo lo inibisce. I bias sono parametri aggiuntivi, uno per ogni neurone in uno strato, che forniscono uno scostamento costante alla somma degli input del neurone prima dell’applicazione della funzione di attivazione. Matematicamente, se un neurone riceve input ponderati che sommano a zero, il bias permette comunque al neurone di produrre un output diverso da zero, fornendo flessibilità cruciale. Questa flessibilità consente alle reti neurali di apprendere confini decisionali complessi e catturare pattern che non sarebbero possibili con i soli pesi. In un modello con 200 miliardi di parametri come GPT-4o, la maggior parte sono pesi nei meccanismi di attenzione e nelle reti feed-forward, con i bias che rappresentano una porzione minore ma comunque significativa. Insieme, pesi e bias permettono al modello di apprendere gli intricati schemi di linguaggio, visione o altri domini che rendono così potenti i sistemi di IA moderni.

Il numero di parametri in un modello ha un impatto profondo sulla sua capacità di apprendere pattern complessi e sulle sue prestazioni complessive. La ricerca mostra costantemente che esistono leggi di scaling che governano la relazione tra il numero di parametri, la dimensione dei dati di addestramento e le prestazioni del modello. I modelli con più parametri possono rappresentare funzioni più complesse e catturare pattern più sfumati nei dati, portando generalmente a prestazioni migliori su compiti impegnativi. GPT-3 con 175 miliardi di parametri ha dimostrato notevoli capacità di few-shot learning che i modelli più piccoli non potevano eguagliare. GPT-4o con 200 miliardi di parametri mostra ulteriori miglioramenti nel ragionamento, nella generazione di codice e nella comprensione multimodale. Tuttavia, la relazione tra parametri e prestazioni non è lineare e dipende in modo critico dalla quantità e qualità dei dati di addestramento. Un modello con troppi parametri rispetto ai dati rischia l’overfitting, memorizzando esempi specifici invece di apprendere pattern generalizzabili, con conseguente scarsa performance su nuovi dati. Al contrario, un modello con troppo pochi parametri potrebbe sottostimare, fallendo nel catturare pattern importanti e raggiungendo performance subottimali anche sui dati di addestramento. Il numero ottimale di parametri per un determinato compito dipende da fattori come la complessità del task, la dimensione e la diversità del dataset di addestramento e i vincoli computazionali. La ricerca di Epoch AI mostra che i sistemi di IA moderni hanno raggiunto prestazioni notevoli attraverso uno scaling massiccio, con alcuni modelli contenenti trilioni di parametri considerando architetture mixture-of-experts dove non tutti i parametri sono attivi per ogni input.

Sebbene i modelli di grandi dimensioni con miliardi di parametri raggiungano prestazioni impressionanti, il costo computazionale per addestrare e distribuire tali modelli è notevole. Questo ha stimolato la ricerca su metodi di fine-tuning efficienti sui parametri, che consentono di adattare modelli pre-addestrati a nuovi compiti senza aggiornare tutti i parametri. LoRA (Low-Rank Adaptation) è una tecnica di rilievo che congela la maggior parte dei parametri pre-addestrati e addestra solo un piccolo insieme di matrici aggiuntive a bassa dimensionalità, riducendo il numero di parametri addestrabili di ordini di grandezza mantenendo le prestazioni. Ad esempio, il fine-tuning di un modello da 7 miliardi di parametri con LoRA può coinvolgere solo 1-2 milioni di parametri aggiuntivi invece di tutti e 7 i miliardi. I moduli adapter inseriscono piccole reti addestrabili tra gli strati di un modello pre-addestrato congelato, aggiungendo solo una piccola percentuale di parametri ma consentendo un adattamento specifico al task. Il prompt engineering e l’in-context learning rappresentano approcci alternativi che non modificano affatto i parametri, ma sfruttano quelli esistenti del modello tramite input attentamente progettati. Questi approcci efficienti hanno democratizzato l’accesso ai grandi modelli linguistici, permettendo anche a organizzazioni con risorse limitate di personalizzare modelli all’avanguardia per le proprie esigenze. Il compromesso tra efficienza dei parametri e performance rimane un tema di ricerca attivo, con i professionisti che bilanciano l’efficienza computazionale con la necessità di accuratezza specifica per il task.

Comprendere i parametri del modello è fondamentale per piattaforme come AmICited che monitorano come brand e domini appaiono nelle risposte generate dall’IA su sistemi come ChatGPT, Perplexity, Claude e Google AI Overviews. Diversi modelli di IA con configurazioni di parametri differenti producono output diversi per la stessa richiesta, influenzando dove e come i brand vengono menzionati. I 200 miliardi di parametri di GPT-4o sono configurati in modo diverso rispetto ai parametri di Claude 3.5 Sonnet o dei modelli di Perplexity, portando a variazioni nella generazione delle risposte. I parametri appresi durante l’addestramento su dataset diversi e con obiettivi di training differenti fanno sì che i modelli abbiano conoscenze, pattern di ragionamento e comportamenti di citazione distinti. Quando si monitora la presenza di un brand nelle risposte dell’IA, capire che queste differenze derivano dalle variazioni nei parametri aiuta a spiegare perché un brand può essere molto citato in un sistema di IA e appena menzionato in un altro. I parametri che controllano i meccanismi di attenzione determinano quali parti dei dati di training sono più rilevanti per una query, influenzando i pattern di citazione. I parametri negli strati di generazione dell’output determinano come il modello struttura e presenta le informazioni. Tracciando come diversi sistemi di IA con differenti configurazioni di parametri menzionano i brand, AmICited fornisce insight su come il comportamento dei modelli, guidato dai parametri, influisca sulla visibilità del brand nel panorama della ricerca alimentata dall’IA.

Il futuro dei parametri del modello è guidato da diverse tendenze convergenti che cambieranno radicalmente il modo in cui i sistemi di IA vengono progettati e distribuiti. Le architetture Mixture of Experts (MoE) rappresentano un’evoluzione significativa, in cui i modelli contengono molteplici sub-reti specializzate (esperti) con parametri separati, e un meccanismo di routing determina quali esperti processano ciascun input. Questo approccio permette ai modelli di scalare fino a trilioni di parametri mantenendo l’efficienza computazionale in fase di inferenza, poiché non tutti i parametri sono attivi per ogni input. GPT-4 utilizza presumibilmente un’architettura MoE con 16 esperti, ciascuno con 110 miliardi di parametri, per un totale di 1,8 trilioni di parametri ma usando solo una frazione di essi durante l’inferenza. Parametri sparsi e tecniche di pruning vengono sviluppate per identificare e rimuovere i parametri meno importanti, riducendo la dimensione del modello senza sacrificare le prestazioni. Gli approcci di apprendimento continuo puntano a aggiornare i parametri in modo efficiente man mano che nuovi dati diventano disponibili, consentendo ai modelli di adattarsi senza un riaddestramento completo. Il federated learning distribuisce l’addestramento dei parametri su più dispositivi preservando la privacy, permettendo alle organizzazioni di beneficiare dell’addestramento su larga scala senza centralizzare dati sensibili. L’emergere di small language models (SLM) con miliardi e non centinaia di miliardi di parametri suggerisce un futuro in cui l’efficienza parametrica sarà importante quanto il mero conteggio dei parametri. Man mano che i sistemi di IA saranno sempre più integrati in applicazioni critiche, comprendere e controllare i parametri del modello diventerà essenziale per garantire sicurezza, equità e allineamento con i valori umani. La relazione tra numero di parametri e comportamento del modello continuerà a essere un tema centrale della ricerca sull’IA, con implicazioni che vanno dalla sostenibilità computazionale all’interpretabilità e affidabilità dei sistemi di intelligenza artificiale.

I parametri del modello sono variabili interne apprese durante l'addestramento tramite algoritmi di ottimizzazione come la discesa del gradiente, mentre gli iperparametri sono impostazioni esterne configurate prima dell'inizio dell'addestramento. I parametri determinano come il modello mappa gli input sugli output, mentre gli iperparametri controllano il processo di addestramento stesso, come il tasso di apprendimento e il numero di epoche. Ad esempio, pesi e bias nelle reti neurali sono parametri, mentre il tasso di apprendimento è un iperparametro.

I moderni grandi modelli linguistici contengono miliardi o trilioni di parametri. GPT-4o contiene circa 200 miliardi di parametri, mentre GPT-4o-mini ne ha circa 8 miliardi. Anche Claude 3.5 Sonnet opera con centinaia di miliardi di parametri. Questi enormi numeri di parametri consentono a tali modelli di catturare schemi complessi nel linguaggio e generare risposte sofisticate e pertinenti al contesto su una vasta gamma di argomenti.

Un numero maggiore di parametri aumenta la capacità di un modello di apprendere schemi e relazioni complesse nei dati. Con più parametri, i modelli possono rappresentare caratteristiche e interazioni più sfumate, portando a una maggiore accuratezza sui dati di addestramento. Tuttavia, esiste un equilibrio critico: troppi parametri rispetto ai dati di addestramento possono causare overfitting, in cui il modello memorizza il rumore invece di apprendere schemi generalizzabili, con conseguente scarsa performance su nuovi dati non visti.

I parametri del modello vengono aggiornati tramite retropropagazione e algoritmi di ottimizzazione come la discesa del gradiente. Durante l'addestramento, il modello effettua previsioni, calcola la perdita (errore) tra le previsioni e i valori reali, quindi calcola i gradienti che mostrano come ogni parametro ha contribuito a quell'errore. L'ottimizzatore regola quindi i parametri nella direzione che riduce la perdita, ripetendo questo processo su più iterazioni di addestramento fino a quando il modello converge su valori ottimali.

I pesi determinano la forza delle connessioni tra i neuroni nelle reti neurali, controllando quanto fortemente le caratteristiche di input influenzano gli output. I bias agiscono come regolatori di soglia, consentendo ai neuroni di attivarsi anche quando gli input ponderati sono zero, fornendo flessibilità e permettendo al modello di apprendere schemi di base. Insieme, pesi e bias costituiscono i parametri apprendibili fondamentali che permettono alle reti neurali di approssimare funzioni complesse e fare previsioni accurate.

I parametri del modello influenzano direttamente il modo in cui sistemi di IA come ChatGPT, Perplexity e Claude elaborano e rispondono alle domande. Comprendere il numero e la configurazione dei parametri aiuta a spiegare perché diversi modelli di IA producono output differenti per lo stesso prompt. Per piattaforme di monitoraggio dei brand come AmICited, tracciare come i parametri influenzano il comportamento del modello è cruciale per prevedere dove i brand appaiono nelle risposte dell'IA e comprendere la coerenza tra diversi sistemi di IA.

Sì, tramite il transfer learning, i parametri di un modello pre-addestrato possono essere adattati per nuovi compiti. Questo approccio, chiamato fine-tuning, consiste nel prendere un modello con parametri appresi e regolarli su nuovi dati per applicazioni specifiche. Metodi di fine-tuning efficienti come LoRA (Low-Rank Adaptation) consentono aggiornamenti selettivi dei parametri, riducendo i costi computazionali mantenendo le prestazioni. Questa tecnica è ampiamente utilizzata per personalizzare grandi modelli linguistici per domini specializzati.

I parametri del modello incidono direttamente sui requisiti computazionali sia durante l'addestramento che in fase di inferenza. Più parametri richiedono più memoria, potenza di calcolo e tempo per essere addestrati e distribuiti. Un modello con 175 miliardi di parametri (come GPT-3) richiede risorse computazionali significativamente superiori rispetto a un modello da 7 miliardi di parametri. Questa relazione è fondamentale per le organizzazioni che implementano sistemi di IA, poiché il numero di parametri influisce sui costi infrastrutturali, sulla latenza e sul consumo energetico negli ambienti produttivi.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

I dati di addestramento sono il dataset utilizzato per insegnare ai modelli ML schemi e relazioni. Scopri come la qualità dei dati di addestramento influisce su...

Scopri come le specifiche dei prodotti migliorano i sistemi di raccomandazione dell'IA fornendo dati strutturati, aumentando la precisione e consentendo una mig...

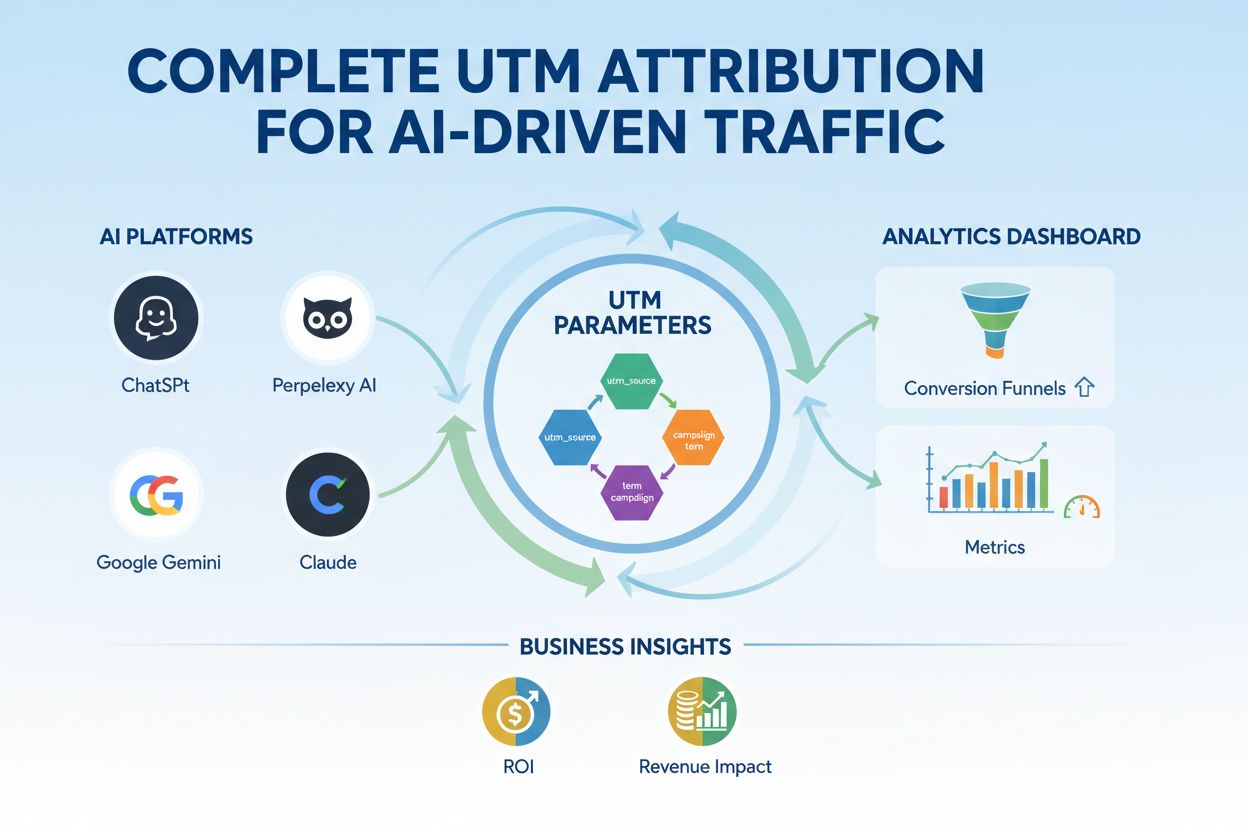

Padroneggia il tracciamento UTM per piattaforme AI come ChatGPT, Perplexity e Google Gemini. Scopri l'impostazione, le best practice e come attribuire accuratam...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.