Definizione di Elaborazione del Linguaggio Naturale (NLP)

Elaborazione del Linguaggio Naturale (NLP) è un sottoinsieme dell’intelligenza artificiale e dell’informatica che consente ai computer di comprendere, interpretare, manipolare e generare il linguaggio umano in modo significativo. La NLP combina linguistica computazionale (modellazione basata su regole del linguaggio umano), algoritmi di machine learning e reti neurali di deep learning per elaborare sia dati testuali che vocali. Questa tecnologia permette alle macchine di comprendere il significato semantico del linguaggio, riconoscere schemi nella comunicazione umana e generare risposte coerenti che imitano la comprensione linguistica umana. La NLP è fondamentale per le applicazioni di IA moderne, alimentando tutto, dai motori di ricerca e chatbot agli assistenti vocali e ai sistemi di monitoraggio dell’IA che tracciano le menzioni di brand su piattaforme come ChatGPT, Perplexity e Google AI Overviews.

Contesto Storico ed Evoluzione della NLP

Il campo dell’Elaborazione del Linguaggio Naturale nasce negli anni ’50 quando i ricercatori tentarono per la prima volta la traduzione automatica, con il celebre esperimento Georgetown-IBM del 1954 che tradusse con successo 60 frasi dal russo all’inglese. Tuttavia, i primi sistemi NLP erano gravemente limitati, basati su approcci rigidi e basati su regole che potevano rispondere solo a richieste pre-programmate specifiche. Negli anni ’90 e nei primi anni 2000 si sono registrati grandi progressi con lo sviluppo di metodi NLP statistici, che introdussero il machine learning nell’elaborazione linguistica, consentendo applicazioni come il filtro antispam, la classificazione di documenti e i primi chatbot. La vera rivoluzione è arrivata negli anni 2010 con la diffusione di modelli di deep learning e reti neurali, capaci di analizzare ampi blocchi di testo e scoprire schemi complessi nei dati linguistici. Oggi, il mercato della NLP sta vivendo una crescita esplosiva, con previsioni che stimano l’espansione globale da 59,70 miliardi di dollari nel 2024 a 439,85 miliardi entro il 2030, con un tasso di crescita annuale composto (CAGR) del 38,7%. Questa crescita riflette l’importanza crescente della NLP nelle soluzioni enterprise, nell’automazione potenziata dall’IA e nelle applicazioni di monitoraggio dei brand.

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Tecniche e Metodi Fondamentali della NLP

L’Elaborazione del Linguaggio Naturale impiega diverse tecniche fondamentali per scomporre e analizzare il linguaggio umano. La tokenizzazione è il processo di suddivisione del testo in unità più piccole come parole, frasi o periodi, rendendo il testo complesso gestibile per i modelli di machine learning. Stemming e lemmatizzazione riducono le parole alle loro forme radice (ad esempio, “correre”, “corre” e “corse” diventano tutte “correre”), permettendo ai sistemi di riconoscere le diverse forme della stessa parola. Il riconoscimento di entità nominate (NER) identifica ed estrae entità specifiche dal testo come nomi di persone, luoghi, organizzazioni, date e valori monetari—una capacità cruciale per i sistemi di monitoraggio dei brand che devono rilevare quando un nome aziendale appare nei contenuti generati dall’IA. L’analisi del sentiment determina il tono emotivo o l’opinione espressa nel testo, classificando i contenuti come positivi, negativi o neutri, essenziale per comprendere come i brand vengono rappresentati nelle risposte dell’IA. Il part-of-speech tagging identifica il ruolo grammaticale di ogni parola in una frase (nome, verbo, aggettivo, ecc.), aiutando i sistemi a comprendere la struttura e il significato delle frasi. La classificazione del testo categorizza documenti o passaggi in categorie predefinite, permettendo di organizzare e filtrare le informazioni. Queste tecniche operano in sinergia all’interno delle pipeline NLP per trasformare testo grezzo e non strutturato in dati strutturati e analizzabili che i sistemi di IA possono processare e da cui possono apprendere.

Confronto tra Approcci e Tecnologie NLP

| Approccio NLP | Descrizione | Casi d’Uso | Vantaggi | Limitazioni |

|---|

| NLP Basata su Regole | Usa alberi decisionali preprogrammati e regole grammaticali | Chatbot semplici, filtri di testo di base | Prevedibile, trasparente, non richiede dati di training | Poco scalabile, non gestisce variazioni linguistiche, flessibilità limitata |

| NLP Statistica | Usa il machine learning per estrarre schemi da dati etichettati | Rilevamento spam, classificazione documenti, POS | Più flessibile delle regole, apprende dai dati | Richiede dati etichettati, fatica con contesto e sfumature |

| NLP Deep Learning | Usa reti neurali e modelli transformer su grandi dataset non strutturati | Chatbot, traduzione automatica, generazione contenuti, monitoraggio brand | Molto accurata, gestisce schemi linguistici complessi, apprende contesto | Richiede molte risorse computazionali, incline a bias nei dati |

| Modelli Transformer (BERT, GPT) | Usa meccanismi di self-attention per processare sequenze intere | Comprensione linguaggio, generazione testo, sentiment, NER | Prestazioni all’avanguardia, training efficiente, comprensione contestuale | Computazionalmente costoso, richiede grandi dataset, problemi di interpretabilità |

| Apprendimento Supervisionato | Addestra su coppie input-output etichettate | Classificazione sentiment, NER, categorizzazione testo | Alta accuratezza su compiti specifici, prestazioni prevedibili | Richiede molti dati etichettati, annotazione lunga |

| Apprendimento Non Supervisionato | Scopre schemi in dati non etichettati | Topic modeling, clustering, rilevamento anomalie | Non richiede etichettatura, individua schemi nascosti | Meno preciso, risultati difficili da interpretare, richiede competenze di dominio |

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Come Funziona l’Elaborazione del Linguaggio Naturale: La Pipeline Completa

L’Elaborazione del Linguaggio Naturale opera attraverso una pipeline sistematica che trasforma il linguaggio umano grezzo in insight leggibili dalla macchina. Il processo inizia con la pre-elaborazione del testo, dove l’input grezzo viene pulito e standardizzato. La tokenizzazione suddivide il testo in parole o frasi, la conversione in minuscolo uniforma tutti i caratteri così che “Apple” e “apple” siano trattati allo stesso modo, e la rimozione delle stop word filtra parole comuni come “il” e “è” che non aggiungono informazione significativa. Stemming e lemmatizzazione riducono le parole alla radice, mentre la pulizia del testo elimina punteggiatura, caratteri speciali ed elementi irrilevanti. Dopo la pre-elaborazione, il sistema esegue la estrazione delle feature, convertendo il testo in rappresentazioni numeriche processabili dai modelli di machine learning. Tecniche come Bag of Words e TF-IDF quantificano l’importanza delle parole, mentre i word embeddings come Word2Vec e GloVe rappresentano le parole come vettori densi in uno spazio continuo, catturando le relazioni semantiche. Gli embedding contestuali più avanzati considerano le parole circostanti per creare rappresentazioni più ricche. La fase successiva prevede l’analisi del testo, dove si applicano tecniche come il riconoscimento di entità nominate per identificare entità specifiche, l’analisi del sentiment per determinare il tono emotivo, il parsing delle dipendenze per comprendere le relazioni grammaticali e il topic modeling per identificare i temi sottostanti. Infine, il training del modello utilizza i dati processati per addestrare modelli di machine learning che apprendono schemi e relazioni, con il modello addestrato poi distribuito per fare previsioni su nuovi dati. Questa pipeline permette a sistemi come AmICited di rilevare e analizzare le menzioni di brand nelle risposte generate dall’IA su piattaforme come ChatGPT, Perplexity e Google AI Overviews.

L’avvento del deep learning ha trasformato radicalmente l’Elaborazione del Linguaggio Naturale, superando i metodi statistici con architetture di reti neurali capaci di apprendere schemi linguistici complessi da enormi dataset. Le Reti Neurali Ricorrenti (RNN) e le Long Short-Term Memory (LSTM) sono stati i primi approcci deep learning in grado di gestire dati sequenziali, ma mostravano limiti nella gestione delle dipendenze a lungo termine. La svolta è arrivata con i modelli transformer, che hanno introdotto il meccanismo di self-attention—un approccio rivoluzionario che permette ai modelli di considerare simultaneamente tutte le parole di una sequenza e determinare quali parti sono più importanti per la comprensione del significato. BERT (Bidirectional Encoder Representations from Transformers), sviluppato da Google, è diventato il fondamento per motori di ricerca e compiti di comprensione linguistica processando il testo in modo bidirezionale e comprendendo il contesto in entrambe le direzioni. I modelli GPT (Generative Pre-trained Transformer), incluso il diffuso GPT-4, utilizzano un’architettura autoregressiva per prevedere la parola successiva in una sequenza, abilitando sofisticate capacità di generazione del testo. Questi modelli transformer possono essere addestrati tramite apprendimento auto-supervisionato su enormi database testuali senza la necessità di annotazione manuale, risultando molto efficienti e scalabili. I foundation models come Granite di IBM sono modelli predefiniti e curati che possono essere rapidamente implementati per vari compiti NLP, inclusa la generazione di contenuti, l’estrazione di insight e il riconoscimento di entità nominate. La forza di questi modelli risiede nella loro capacità di cogliere relazioni semantiche sfumate, comprendere il contesto su lunghi passaggi e generare risposte coerenti e contestualmente appropriate—capacità essenziali per le piattaforme di monitoraggio dell’IA che tracciano le menzioni di brand nei contenuti generati dall’intelligenza artificiale.

Applicazioni della NLP nei Settori e nel Monitoraggio dell’IA

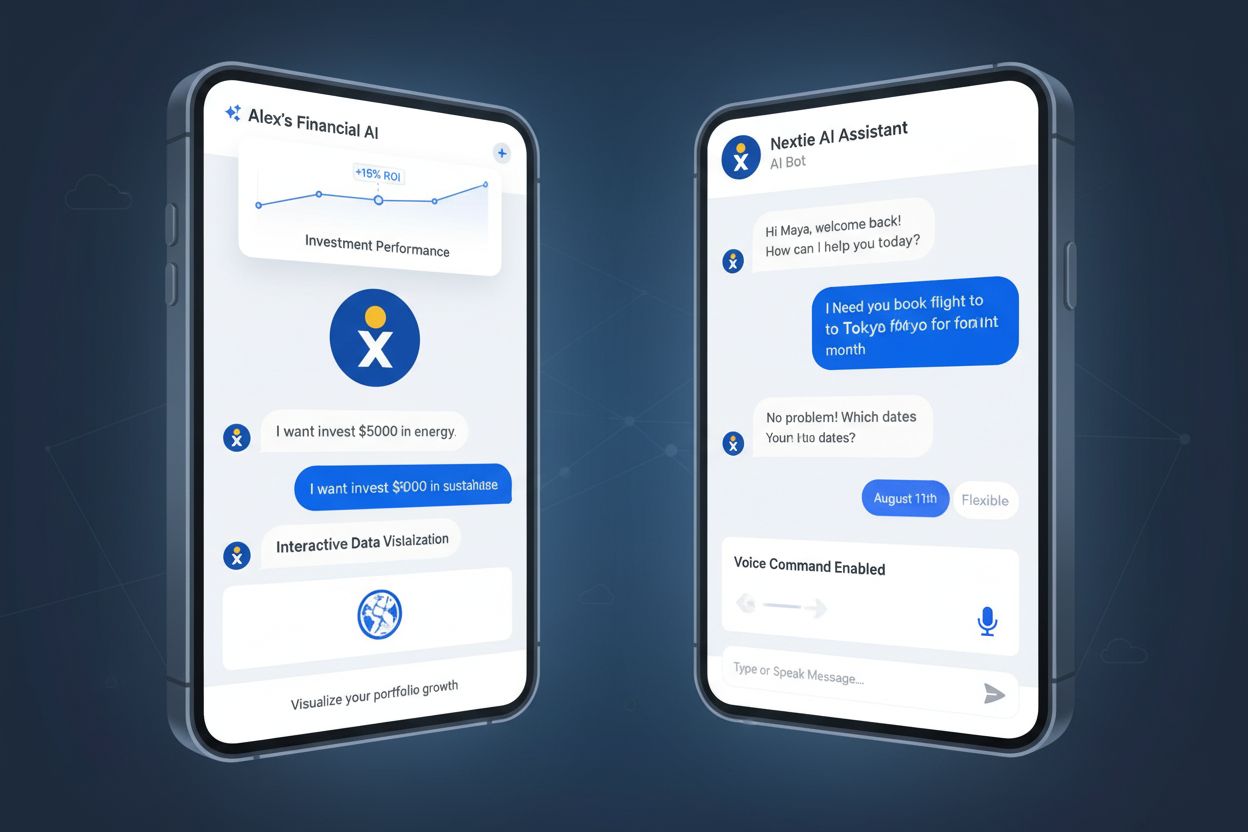

L’Elaborazione del Linguaggio Naturale è diventata indispensabile in quasi tutti i settori, permettendo alle organizzazioni di estrarre insight utili da grandi quantità di dati testuali e vocali non strutturati. In finanza, la NLP accelera l’analisi di bilanci, report normativi e comunicati stampa, aiutando trader e analisti a prendere decisioni più rapide e informate. Le organizzazioni sanitarie utilizzano la NLP per analizzare cartelle cliniche, articoli scientifici e note cliniche, abilitando diagnosi più rapide, pianificazione delle terapie e ricerca medica. Le compagnie di assicurazione implementano la NLP per analizzare richieste di risarcimento, individuare schemi che indicano frodi o inefficienze e ottimizzare i flussi di lavoro. Gli studi legali utilizzano la NLP per la discovery documentale automatizzata, organizzando grandi quantità di atti e precedenti, riducendo notevolmente tempi e costi di revisione. I reparti di customer service sfruttano chatbot basati su NLP per gestire richieste di routine, liberando risorse umane per le problematiche più complesse. I team di marketing e gestione del brand si affidano sempre di più alla NLP per l’analisi del sentiment e il monitoraggio del brand, tracciando come i loro marchi vengono menzionati e percepiti nei canali digitali. In particolare, per la mission di AmICited, la NLP permette alle piattaforme di monitoraggio dell’IA di rilevare e analizzare le menzioni di brand nelle risposte generate da sistemi come ChatGPT, Perplexity, Google AI Overviews e Claude. Queste piattaforme utilizzano il riconoscimento di entità nominate per identificare i nomi dei brand, l’analisi del sentiment per comprendere il contesto e il tono delle menzioni e la classificazione del testo per categorizzare il tipo di menzione. Questa capacità è sempre più critica, poiché le organizzazioni riconoscono che la loro visibilità nei risultati dell’IA influisce direttamente sulla scoperta e sulla reputazione del brand nell’era della generazione automatica.

Compiti e Funzionalità Chiave della NLP

- Riconoscimento di Entità Nominate (NER): Identifica ed estrae entità specifiche come persone, organizzazioni, luoghi, date e prodotti dal testo, fondamentale per il monitoraggio dei brand e l’estrazione di informazioni

- Analisi del Sentiment: Determina il tono emotivo e l’opinione espressa nel testo, classificando i contenuti come positivi, negativi o neutri per comprendere la percezione del brand

- Classificazione del Testo: Categorizza documenti o passaggi in categorie predefinite, consentendo l’organizzazione e il filtraggio automatico di grandi volumi di testo

- Traduzione Automatica: Converte il testo da una lingua all’altra preservandone significato e contesto, grazie a modelli sequence-to-sequence transformer

- Riconoscimento Vocale: Converte il linguaggio parlato in testo, abilitando interfacce vocali e servizi di trascrizione

- Sintesi Automatica del Testo: Genera automaticamente riassunti concisi di documenti più lunghi, risparmiando tempo nell’elaborazione delle informazioni

- Question Answering: Permette ai sistemi di comprendere domande e recuperare o generare risposte accurate da basi di conoscenza

- Risoluzione delle Coreferenze: Identifica quando parole o frasi diverse si riferiscono alla stessa entità, cruciale per comprendere contesto e relazioni

- Part-of-Speech Tagging: Identifica il ruolo grammaticale di ogni parola, aiutando i sistemi a comprendere struttura e significato delle frasi

- Topic Modeling: Scopre temi e argomenti sottostanti all’interno di documenti o raccolte di documenti, utile per l’analisi e l’organizzazione dei contenuti

Sfide e Limitazioni dell’Elaborazione del Linguaggio Naturale

Nonostante i notevoli progressi, l’Elaborazione del Linguaggio Naturale affronta sfide significative che ne limitano l’accuratezza e l’applicabilità. L’ambiguità è forse la sfida più fondamentale: parole e frasi spesso hanno molteplici significati a seconda del contesto e le frasi possono essere interpretate in modi diversi. Ad esempio, “Ho visto l’uomo con il telescopio” può significare sia che chi parla ha usato un telescopio per vedere l’uomo, sia che l’uomo possedeva un telescopio. La comprensione contestuale rimane complessa per i sistemi NLP, soprattutto quando il significato dipende da informazioni molto precedenti nel testo o richiede conoscenze del mondo reale. Sarcasmo, modi di dire e metafore rappresentano sfide particolari perché il loro significato letterale differisce da quello inteso e i sistemi addestrati su linguaggio standard spesso li fraintendono. Tono di voce e sfumature emotive sono difficili da cogliere nel solo testo—le stesse parole possono assumere significati totalmente diversi a seconda di come sono pronunciate, dell’accento o del linguaggio del corpo. Il bias nei dati di addestramento è una preoccupazione rilevante; i modelli NLP addestrati su dati raccolti dal web spesso ereditano pregiudizi sociali, generando output discriminatori o inaccurati. Nuovo vocabolario ed evoluzione linguistica pongono una sfida costante, poiché nuove parole, slang e convenzioni grammaticali emergono più velocemente di quanto i dati di training possano essere aggiornati. Lingue e dialetti rari ricevono meno dati di addestramento, portando a prestazioni molto inferiori per chi parla queste lingue. Errori grammaticali, parlato poco chiaro, rumore di fondo e linguaggio non standard nei dati audio reali creano ulteriori difficoltà per i sistemi di riconoscimento vocale. Queste limitazioni fanno sì che anche i sistemi NLP più avanzati possano fraintendere il significato, specialmente nei casi limite o quando elaborano linguaggi informali, creativi o specifici di una determinata cultura.

Il Futuro della NLP e i Trend Emergenti

Il campo dell’Elaborazione del Linguaggio Naturale si evolve rapidamente, con diversi trend emergenti che ne stanno plasmando la direzione futura. La NLP multimodale, che combina elaborazione di testo, immagini e audio, sta permettendo lo sviluppo di sistemi IA più sofisticati in grado di comprendere e generare contenuti attraverso più modalità contemporaneamente. Il few-shot e zero-shot learning stanno riducendo la necessità di enormi dataset etichettati, consentendo ai modelli NLP di affrontare nuovi compiti con pochi esempi di training. Il Retrieval-Augmented Generation (RAG) sta migliorando accuratezza e affidabilità dei contenuti generati dall’IA collegando i modelli linguistici a fonti di conoscenza esterne, riducendo allucinazioni e migliorando la precisione fattuale. Si stanno sviluppando modelli NLP efficienti per ridurre i requisiti computazionali, rendendo le capacità avanzate accessibili anche a organizzazioni più piccole e dispositivi edge. L’Explainable AI nella NLP sta diventando sempre più importante man mano che le organizzazioni cercano di capire come i modelli prendano decisioni e di garantire la conformità normativa. I modelli NLP specifici di dominio vengono ottimizzati per applicazioni specialistiche in sanità, legale, finanza e altri settori, migliorando l’accuratezza per il linguaggio e la terminologia di settore. L’etica dell’IA e la mitigazione dei bias stanno ricevendo maggiore attenzione, poiché si riconosce l’importanza di sistemi NLP equi e imparziali. Ancora più importante, per il monitoraggio del brand, l’integrazione della NLP con le piattaforme di monitoraggio dell’IA sta diventando essenziale, poiché le organizzazioni riconoscono che la visibilità e la percezione del proprio brand nelle risposte generate dall’IA influiscono direttamente sulla scoperta da parte dei clienti e sul posizionamento competitivo. Poiché sistemi come ChatGPT, Perplexity e Google AI Overviews diventano fonti primarie di informazione per i consumatori, la capacità di monitorare e comprendere come i brand appaiono in questi sistemi—grazie a sofisticate tecniche NLP—diventerà un elemento fondamentale delle strategie moderne di marketing e gestione del brand.

Il Ruolo della NLP nel Monitoraggio dell’IA e nella Visibilità del Brand

L’Elaborazione del Linguaggio Naturale è la base tecnologica che consente a piattaforme come AmICited di tracciare le menzioni di brand nei sistemi di IA. Quando gli utenti pongono domande a ChatGPT, Perplexity, Google AI Overviews o Claude, questi sistemi generano risposte utilizzando large language model alimentati da tecniche NLP avanzate. AmICited utilizza algoritmi NLP per analizzare queste risposte generate dall’IA, rilevando quando i brand vengono menzionati, estraendo il contesto delle menzioni e analizzandone il sentiment. Il riconoscimento di entità nominate identifica i nomi dei brand e le entità correlate, l’analisi del sentiment determina se le menzioni sono positive, negative o neutre e la classificazione del testo categorizza il tipo di menzione (raccomandazione di prodotto, confronto, critica, ecc.). Questa capacità offre alle organizzazioni una visibilità cruciale sulla loro presenza nell’IA—ovvero su come il brand viene scoperto e discusso all’interno di sistemi di IA che sempre più spesso costituiscono la fonte primaria di informazione per i consumatori. Con la crescita esplosiva del mercato NLP, che secondo le proiezioni raggiungerà i 439,85 miliardi di dollari entro il 2030, l’importanza del monitoraggio dei brand potenziato dalla NLP continuerà ad aumentare, rendendo essenziale per le organizzazioni comprendere e sfruttare queste tecnologie per proteggere e valorizzare la reputazione del proprio brand nel futuro guidato dall’intelligenza artificiale.