Riformulazione delle Query

Scopri come la riformulazione delle query aiuta i sistemi AI a interpretare e migliorare le richieste degli utenti per un migliore recupero delle informazioni. ...

Il raffinamento delle query è il processo di miglioramento e ottimizzazione delle query di ricerca tramite aggiustamenti iterativi, chiarimenti ed espansioni per generare risultati più accurati, pertinenti e completi dai motori di ricerca AI e dai sistemi di recupero delle informazioni. Comporta la suddivisione di query complesse degli utenti in sotto-query, l’aggiunta di dettagli contestuali e l’utilizzo di cicli di feedback per migliorare progressivamente le prestazioni della ricerca e la qualità dei risultati.

Il raffinamento delle query è il processo di miglioramento e ottimizzazione delle query di ricerca tramite aggiustamenti iterativi, chiarimenti ed espansioni per generare risultati più accurati, pertinenti e completi dai motori di ricerca AI e dai sistemi di recupero delle informazioni. Comporta la suddivisione di query complesse degli utenti in sotto-query, l'aggiunta di dettagli contestuali e l'utilizzo di cicli di feedback per migliorare progressivamente le prestazioni della ricerca e la qualità dei risultati.

Il raffinamento delle query è il processo iterativo di miglioramento e ottimizzazione delle query di ricerca tramite aggiustamenti sistematici, chiarimenti ed espansioni per generare risultati più accurati, pertinenti e completi dai sistemi di recupero delle informazioni e dai motori di ricerca AI. Invece di trattare la ricerca iniziale dell’utente come definitiva, il raffinamento delle query riconosce che spesso gli utenti devono modificare, espandere o chiarire le proprie richieste per trovare esattamente ciò che cercano. Questo processo comporta l’analisi di come gli utenti modificano le loro ricerche, il suggerimento di formulazioni migliorate e l’utilizzo di cicli di feedback per migliorare progressivamente le prestazioni della ricerca. Nel contesto delle moderne piattaforme di ricerca AI come ChatGPT, Perplexity, Google AI Overviews e Claude, il raffinamento delle query è diventato un meccanismo fondamentale per fornire risposte complete e multi-sorgente che rispondono a domande complesse degli utenti. La tecnica trasforma la ricerca da un’interazione singola e statica a una conversazione dinamica e multistep, in cui ogni raffinamento avvicina l’utente alle informazioni desiderate.

Il raffinamento delle query non è un concetto nuovo nel recupero delle informazioni, ma la sua applicazione si è evoluta notevolmente con l’avvento dell’intelligenza artificiale e dei grandi modelli linguistici. Storicamente, i motori di ricerca si basavano principalmente sul matching delle parole chiave, confrontando direttamente la query dell’utente con i documenti indicizzati. Se cercavi “scarpe da corsa”, il motore restituiva documenti contenenti esattamente quelle parole, indipendentemente dal contesto o dall’intento dell’utente. Questo approccio era rigido e spesso produceva risultati irrilevanti perché ignorava le sfumature del linguaggio umano e la complessità dei bisogni degli utenti.

L’evoluzione verso il raffinamento delle query è iniziata con l’introduzione dei sistemi di suggerimento delle query nei primi anni 2000, quando i motori di ricerca hanno iniziato ad analizzare i comportamenti degli utenti per suggerire query correlate o raffinate. La funzione “Forse cercavi?” di Google e i suggerimenti di completamento automatico sono state le prime implementazioni di questo concetto. Tuttavia, questi sistemi erano relativamente semplici, basati principalmente su log storici delle query e analisi di frequenza. Mancavano della comprensione semantica necessaria per cogliere davvero l’intento dell’utente o le relazioni tra diverse formulazioni di query.

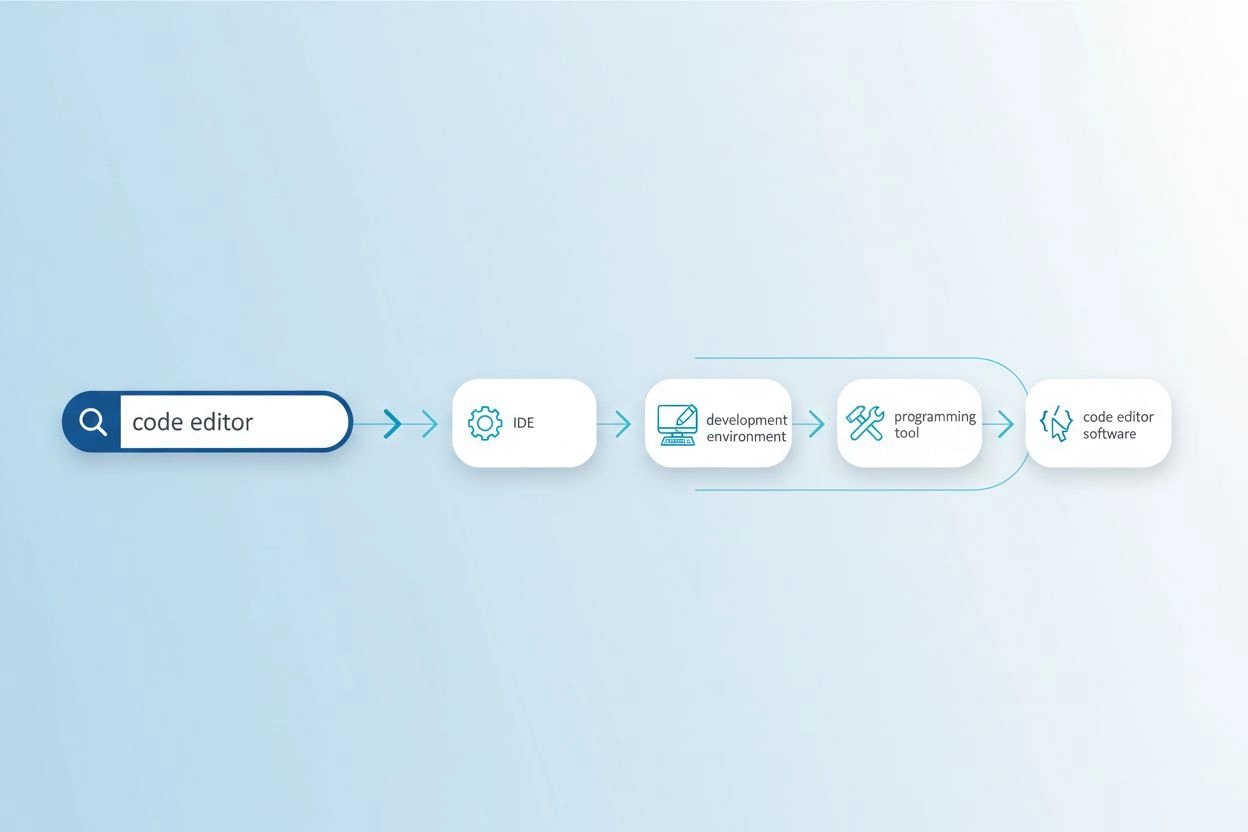

L’introduzione di elaborazione del linguaggio naturale (NLP) e machine learning ha trasformato radicalmente il raffinamento delle query. I sistemi moderni ora possono comprendere che “migliori scarpe da corsa impermeabili” e “scarpe sportive antipioggia più votate” sono essenzialmente la stessa richiesta, pur usando termini diversi. Questa comprensione semantica permette ai sistemi di riconoscere le variazioni delle query, identificare bisogni impliciti e suggerire raffinamenti che migliorano realmente i risultati di ricerca. Secondo una ricerca della Kopp Online Marketing SEO Research Suite, le metodologie di raffinamento delle query sono diventate sempre più sofisticate, con sistemi ora in grado di generare query sintetiche (query create artificialmente che simulano le ricerche reali degli utenti) per potenziare i dati di addestramento e migliorare l’accuratezza del recupero.

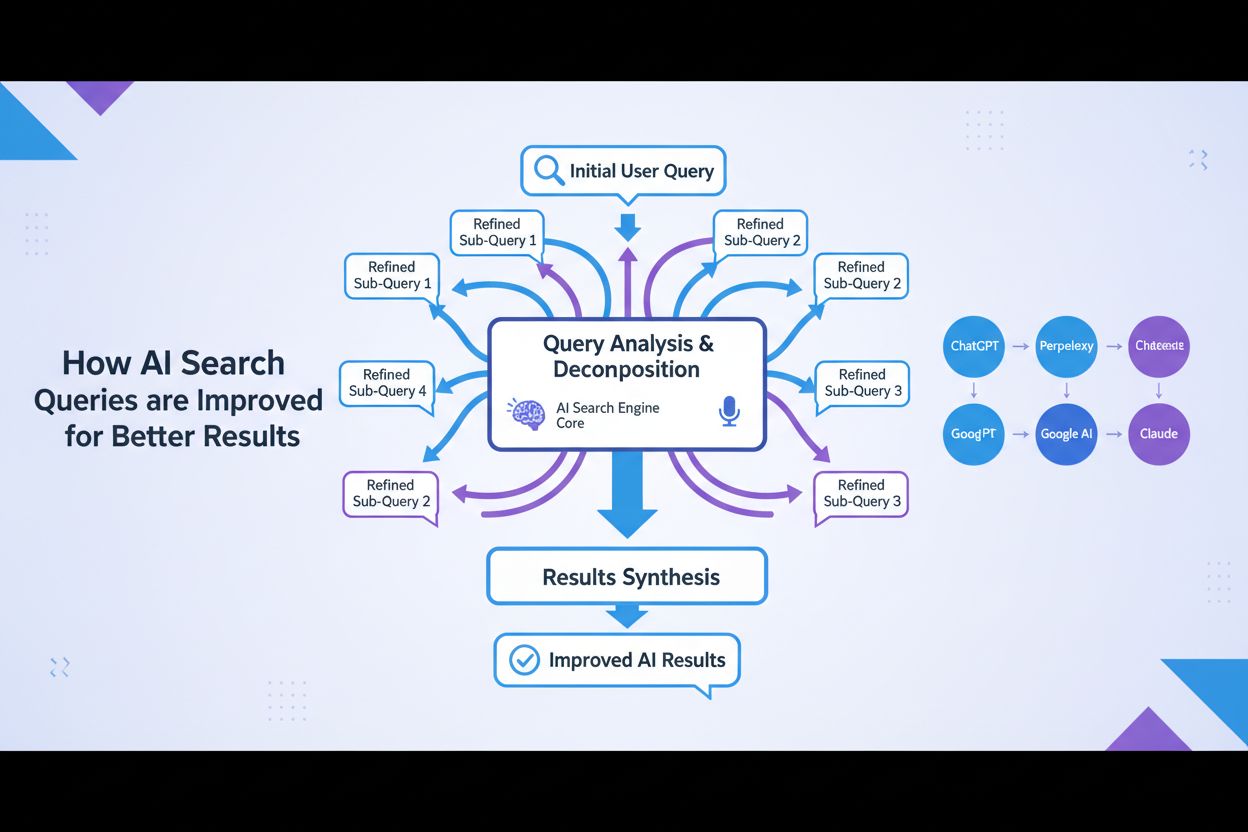

L’emergere dell’AI generativa e dei grandi modelli linguistici ha accelerato ulteriormente questa evoluzione. I moderni motori di ricerca AI non si limitano a raffinare le query: le scompongono in molteplici sotto-query, le eseguono in parallelo su fonti di dati diverse e sintetizzano i risultati in risposte esaustive. Questo rappresenta un cambiamento fondamentale: il raffinamento delle query non è più solo una funzione suggerita all’utente, ma diventa un componente architetturale centrale dei sistemi di ricerca AI.

Il raffinamento delle query opera tramite diversi meccanismi tecnici interconnessi che lavorano insieme per migliorare la qualità della ricerca. Il primo meccanismo è l’analisi della query e il rilevamento dell’intento, in cui il sistema elabora la query iniziale dell’utente per identificare l’intento sottostante, il livello di complessità e il tipo di risposta necessaria. Modelli NLP avanzati analizzano fattori come la lunghezza della query, la specificità della terminologia e i segnali contestuali per determinare se basta un semplice matching di parole chiave o se serve un raffinamento più sofisticato. Ad esempio, una query fattuale come “capitale della Germania” potrebbe non richiedere raffinamenti estesi, mentre una query complessa come “best practice per ottimizzare i contenuti per i motori di ricerca AI” attiverebbe processi di raffinamento completi.

Il secondo meccanismo è la decomposizione delle query e fan-out, una tecnica in cui le query complesse vengono suddivise in più sotto-query costituenti. Questo processo, noto come query fan-out, è particolarmente importante nei sistemi di ricerca AI. Quando un utente chiede “Quali sono le migliori scarpe da corsa impermeabili per chi ha i piedi piatti e corre sui sentieri?”, il sistema la scompone in più sotto-query: una che esplora le offerte di prodotti, un’altra che analizza recensioni di esperti, un’altra ancora che valuta le esperienze degli utenti e una che esamina le specifiche tecniche. Queste sotto-query vengono eseguite simultaneamente su diverse fonti di dati, inclusi web in tempo reale, knowledge graph e database specializzati. Questa esecuzione parallela amplia notevolmente il bacino informativo per la sintesi, permettendo all’AI di fornire risposte più complete e sfaccettate.

Il terzo meccanismo è l’aumento delle query (query augmentation), che implica la generazione di query aggiuntive per migliorare le performance della ricerca. Secondo la Kopp Online Marketing SEO Research Suite, l’aumento delle query utilizza diversi metodi: analisi dei dati storici (esame delle precedenti raffinazioni nelle cronologie utente), sostituzione n-gram (modifica delle query sostituendo sequenze contigue di termini), associazione di entità (identificazione di entità dai risultati di ricerca e combinazione con i termini originali) e identificazione di query sorelle (ricerca di query correlate che condividono un’origine comune). Queste tecniche garantiscono che il sistema esplori molteplici angolazioni e prospettive sul bisogno informativo dell’utente.

Il quarto meccanismo è costituito da cicli di feedback e miglioramento continuo, in cui le interazioni degli utenti con i risultati di ricerca informano il processo di raffinamento. Quando gli utenti cliccano su determinati risultati, trascorrono tempo su alcune pagine o riformulano le proprie query, questi dati ritornano al sistema per migliorare i raffinamenti futuri. Si possono applicare tecniche di reinforcement learning per ottimizzare i modelli generativi, migliorando nel tempo la qualità delle varianti di query sulla base delle risposte soddisfacenti. Si crea così un ciclo virtuoso in cui ogni interazione rende il sistema più intelligente ed efficace nel raffinare le query.

| Aspetto | Google AI Overviews | ChatGPT | Perplexity | Claude |

|---|---|---|---|---|

| Metodo primario di raffinamento | Query fan-out con ricerca tematica | Raffinamento conversazionale multi-turno | Suggerimenti di query interattivi con follow-up | Chiarimento contestuale tramite dialogo |

| Generazione di sotto-query | Decomposizione automatica basata sull’intento | Guidata dall’utente tramite conversazione | Suggerimenti visualizzati come pillole | Implicita tramite comprensione del contesto |

| Fonti di dati | Web live, knowledge graph, shopping graph | Dati di addestramento + ricerca web (con plugin) | Ricerca web in tempo reale su fonti multiple | Dati di addestramento con capacità di ricerca web |

| Meccanismo di citazione | Attribuzione diretta delle fonti nell’overview | Riferimenti con link nelle risposte | Schede fonte con attribuzione dettagliata | Citazioni in linea con link alle fonti |

| Controllo dell’utente | Limitato (raffinamento guidato dal sistema) | Elevato (utente dirige la conversazione) | Medio (raffinamenti suggeriti + input personalizzato) | Elevato (utente può richiedere raffinamenti specifici) |

| Visibilità del raffinamento | Implicita (l’utente vede la risposta sintetizzata) | Esplicita (l’utente vede la cronologia della conversazione) | Esplicita (suggerimenti di raffinamento visibili) | Implicita (raffinamento tramite dialogo) |

| Velocità del raffinamento | Immediata (elaborazione parallela) | Sequenziale (turno per turno) | Immediata (ricerca in tempo reale) | Sequenziale (basata su conversazione) |

| Livello di personalizzazione | Alto (in base a cronologia e posizione) | Medio (in base al contesto della conversazione) | Medio (in base ai dati di sessione) | Medio (in base al contesto della conversazione) |

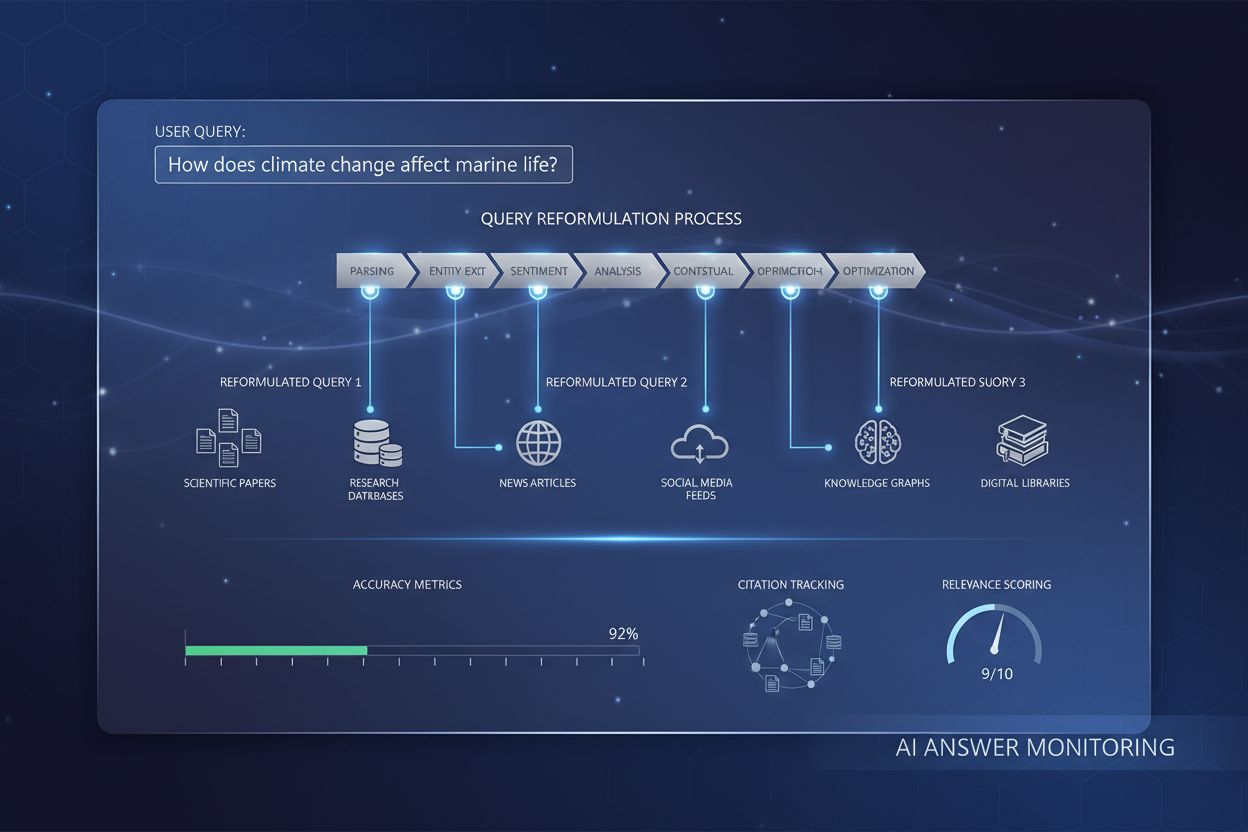

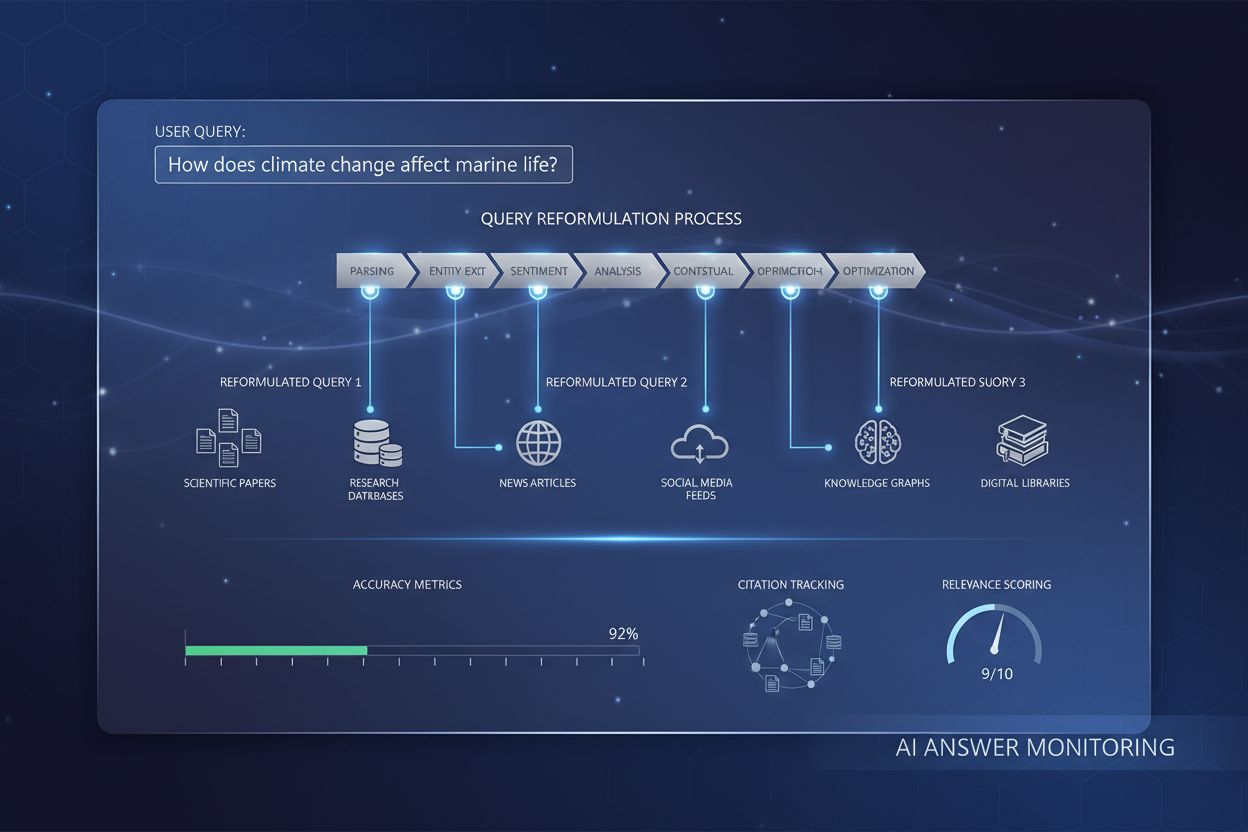

Il processo di raffinamento delle query nei motori di ricerca AI contemporanei segue un flusso di lavoro sofisticato e multi-stadio che si distingue nettamente dalla ricerca tradizionale. Quando un utente invia una query a un sistema come Google AI Mode o ChatGPT, il sistema non cerca subito i risultati. Prima analizza la query utilizzando avanzati algoritmi NLP per capire cosa sta davvero chiedendo l’utente. Questa analisi considera fattori come la cronologia delle ricerche dell’utente, la posizione, il tipo di dispositivo e la complessità stessa della query. Il sistema determina se la query è semplice (richiede solo matching di parole chiave) o complessa (richiede decomposizione e sintesi multi-sorgente).

Per le query complesse, il sistema attiva il processo di query fan-out. Questo comporta la suddivisione della query originale in più sotto-query correlate che esplorano diversi aspetti del bisogno informativo dell’utente. Ad esempio, se un utente chiede “Come devo ottimizzare il mio sito web per i motori di ricerca AI?”, il sistema potrebbe generare sotto-query come: “Quali sono i principali fattori di ranking per i motori di ricerca AI?”, “Come valutano i sistemi AI la qualità dei contenuti?”, “Cos’è l’E-E-A-T e perché è importante per l’AI?”, “Come strutturare i contenuti per essere citati dall’AI?” e “Quali sono le best practice per formattare i contenuti ai fini AI?”. Ognuna di queste sotto-query viene eseguita in parallelo su fonti diverse, recuperando informazioni eterogenee che rispondono ai vari aspetti della domanda originale.

Il sistema valuta quindi le informazioni recuperate utilizzando segnali di qualità come l’autorevolezza del dominio, la freschezza dei contenuti, la pertinenza tematica e i pattern di citazione. Le informazioni da più fonti vengono combinate e sintetizzate in una risposta coerente e completa che risponde direttamente alla query iniziale. Durante tutto il processo, il sistema identifica le fonti più autorevoli e pertinenti, che vengono poi presentate come citazioni o riferimenti nella risposta finale. Ecco perché comprendere il raffinamento delle query è cruciale per gli utenti di AmICited: le fonti che compaiono nelle risposte AI sono determinate in gran parte da quanto bene si allineano alle sotto-query raffinate generate dal sistema AI.

Il rapporto tra raffinamento delle query e visibilità nella ricerca nelle AI Overviews è diretto e misurabile. Le ricerche dimostrano che oltre l’88% delle ricerche che attivano le AI Overviews ha intento informativo, cioè gli utenti vogliono imparare qualcosa e non semplicemente acquistare o navigare verso un sito specifico. Proprio queste query informative sono le più soggette a raffinamenti estesi, poiché spesso richiedono la sintesi di informazioni da fonti diverse per fornire una risposta completa. Quando i tuoi contenuti si allineano alle sotto-query raffinate generate da un sistema AI, il tuo sito ha una probabilità molto più alta di essere citato come fonte.

I dati sono eloquenti: essere presenti come fonte nelle AI Overviews aumenta il tasso di clic dallo 0,6% all’1,08%, quasi raddoppiando il traffico rispetto alla sola presenza nei risultati tradizionali sotto l’overview. Questo rende la comprensione del raffinamento delle query essenziale per la strategia SEO moderna. Anziché ottimizzare per una sola parola chiave, i content creator devono pensare a come i loro contenuti rispondano alle varie query raffinate che un sistema AI potrebbe generare. Ad esempio, se scrivi su “moda sostenibile”, devi anticipare che un sistema AI potrebbe raffinare la richiesta in sotto-query su “impatto ambientale del fast fashion”, “pratiche di produzione etica”, “materiali sostenibili”, “certificazioni fair trade” e “marchi sostenibili ed economici”. I tuoi contenuti dovrebbero affrontare in modo esaustivo queste sfaccettature per massimizzare le possibilità di citazione.

Inoltre, le ricerche indicano che circa il 70% degli utenti legge solo il primo terzo delle AI Overviews, quindi essere citati all’inizio della risposta è molto più prezioso che comparire più tardi. Questo suggerisce che i creatori dovrebbero strutturare i propri contenuti mettendo in evidenza le risposte più importanti e riassuntive all’inizio, in modo chiaro e facilmente citabile. L’obiettivo è diventare la fonte che il sistema AI “deve” citare per fornire una risposta credibile e completa alle query raffinate che genera.

Un efficace raffinamento delle query richiede la comprensione e l’applicazione di alcune tecniche chiave. La prima tecnica è l’aggiunta di dettagli contestuali, in cui utenti o sistemi aggiungono contesto specifico per rendere la query più precisa. Invece di cercare “scarpe da corsa”, una query raffinata può essere “migliori scarpe da corsa impermeabili per donne con arco plantare alto sotto i 150 euro”. Questo contesto aiuta i sistemi AI a capire i vincoli e le preferenze che contano per l’utente, permettendo un recupero più mirato delle informazioni. Per i content creator, ciò significa anticipare questi raffinamenti contestuali e creare contenuti che rispondano a casi d’uso, demografie e vincoli specifici.

La seconda tecnica è la specificazione dei vincoli, in cui gli utenti definiscono limiti o restrizioni per la loro ricerca. Questi possono includere fasce di prezzo, località geografiche, periodi temporali o standard qualitativi. I sistemi AI riconoscono questi vincoli e affinano la ricerca di conseguenza. Ad esempio, una query su “miglior software di project management per team remoti con meno di 50 dipendenti” include più vincoli che dovrebbero guidare la creazione dei contenuti. I tuoi contenuti dovrebbero affrontare esplicitamente questi scenari di vincolo per aumentare le possibilità di essere citati.

La terza tecnica è il follow-up delle domande, in cui gli utenti pongono domande chiarificatrici per affinare la propria comprensione. Nei sistemi AI conversazionali come ChatGPT, gli utenti possono chiedere “Puoi spiegarlo più semplicemente?” o “Come si applica alle piccole imprese?”. Queste domande di follow-up attivano il raffinamento, con il sistema che adatta l’approccio secondo il feedback dell’utente. Per questo la profondità conversazionale e la capacità di affrontare più sfaccettature di un argomento sono sempre più importanti per la visibilità dei contenuti.

La quarta tecnica è la decomposizione delle query, in cui domande complesse vengono suddivise in domande componenti più semplici. Questo è particolarmente importante per i sistemi AI, che utilizzano questa tecnica per garantire una copertura esaustiva di un argomento. Se un utente chiede “Quali sono le best practice per ottimizzare siti e-commerce per i motori di ricerca AI?”, un sistema AI può scomporre la domanda in: “Cosa sono i motori di ricerca AI?”, “Come valutano i sistemi AI i contenuti e-commerce?”, “Quali ottimizzazioni tecniche contano?”, “Come strutturare le descrizioni prodotto?” e “Che ruolo ha il contenuto generato dagli utenti?”. I contenuti che affrontano esaustivamente queste domande componenti avranno più probabilità di essere citati su molteplici query raffinate.

Il Generative Engine Optimization (GEO), noto anche come Large Language Model Optimization (LLMO), riguarda fondamentalmente la comprensione e l’ottimizzazione dei processi di raffinamento delle query. La SEO tradizionale si concentrava sul posizionamento per parole chiave specifiche; la GEO si focalizza sul diventare una fonte citata nelle query raffinate generate dai sistemi AI. Questo rappresenta una svolta nel modo in cui i content creator devono affrontare l’ottimizzazione per la ricerca.

Nel contesto GEO, il raffinamento delle query non è qualcosa che accade semplicemente ai tuoi contenuti, ma qualcosa che devi anticipare e per cui prepararti. Quando crei contenuti, dovresti pensare a tutti i modi in cui un sistema AI potrebbe raffinare o scomporre il tuo argomento in sotto-query. Ad esempio, se scrivi su “moda sostenibile”, dovresti sviluppare contenuti che affrontano: l’impatto ambientale della moda convenzionale, i materiali sostenibili e le loro proprietà, le pratiche etiche e le condizioni di lavoro, le certificazioni e gli standard, le considerazioni sui costi, i marchi consigliati e come passare alla moda sostenibile. Coprendo in modo esaustivo queste sfaccettature raffinate, aumenti la probabilità di essere citato in molteplici risposte AI.

Le ricerche di Elementor’s 2026 AI SEO Statistics mostrano che il traffico di ricerca AI è aumentato del 527% anno su anno, con alcuni siti che ora segnalano oltre l’1% delle sessioni totali provenienti da piattaforme come ChatGPT, Perplexity e Copilot. Questa crescita esplosiva sottolinea l’importanza di comprendere il raffinamento delle query. Il traffico dalle piattaforme AI è anche significativamente più prezioso: i visitatori da referral AI valgono 4,4 volte di più rispetto al traffico organico tradizionale, con bounce rate inferiori del 27% e sessioni più lunghe del 38% per i siti retail. Questo significa che ottimizzare per il raffinamento delle query non è solo una questione di visibilità, ma anche di attrarre traffico di alta qualità pronto a convertire.

Il futuro del raffinamento delle query si sta muovendo verso sistemi sempre più sofisticati, personalizzati e autonomi. La generazione di query sintetiche sta diventando più avanzata, con sistemi AI in grado di generare query diversificate e contestualmente appropriate che simulano i modelli di ricerca reali degli utenti. Queste query sintetiche sono fondamentali per addestrare i sistemi AI a gestire query nuove o molto rare sfruttando pattern acquisiti e informazioni contestuali. Con l’aumentare delle capacità dell’AI, verranno generate sotto-query sempre più sfumate e specifiche, costringendo i content creator a pensare ancora più in profondità alle diverse angolazioni dei propri argomenti.

Un’altra tendenza emergente è il raffinamento stateful delle query, dove i sistemi AI mantengono il contesto attraverso più turni di conversazione, consentendo raffinamenti più sofisticati basati sull’evoluzione dei bisogni e delle preferenze dell’utente. Invece di trattare ogni query come indipendente, questi sistemi capiscono come le query siano collegate alle interazioni precedenti, permettendo raffinamenti più personalizzati e contestuali. Questo impatta anche la strategia dei contenuti: i tuoi contenuti dovrebbero essere strutturati per supportare conversazioni multi-turno in cui l’utente affina progressivamente la propria comprensione.

L’integrazione del reinforcement learning nei sistemi di raffinamento è anch’essa significativa. Questi sistemi possono apprendere dal feedback degli utenti per migliorare costantemente la qualità dei raffinamenti nel tempo. Se gli utenti cliccano regolarmente su certe fonti o trascorrono più tempo su determinate pagine, il sistema impara a dare priorità a quelle fonti nei raffinamenti futuri. Questo crea un vantaggio competitivo per chi fornisce costantemente informazioni di alta qualità e autorevoli, diventando la fonte di riferimento che i sistemi AI imparano a citare.

Inoltre, la crescita degli agent AI e dei sistemi di ricerca autonomi suggerisce che il raffinamento delle query diventerà ancora più sofisticato. Invece di raffinare manualmente le query, gli agent AI genereranno ed eseguiranno automaticamente query raffinate per conto degli utenti, esplorando in modo esaustivo lo spazio informativo per rispondere a domande complesse. Questo significa che i content creator devono assicurarsi che i propri contenuti siano scopribili non solo dagli utenti umani, ma anche dagli agent AI che esplorano e raffinano sistematicamente le query nel web.

Anche il panorama competitivo è in evoluzione. Più piattaforme implementano capacità di raffinamento, più la possibilità di apparire nelle query raffinate diventa un fattore distintivo. Gli utenti AmICited che comprendono e monitorano la propria presenza nelle query raffinate sulle diverse piattaforme AI avranno un vantaggio significativo su chi si concentra solo sui ranking tradizionali. Il futuro appartiene a chi riconosce il raffinamento delle query come elemento fondamentale della visibilità nella ricerca e ottimizza di conseguenza.

Il raffinamento delle query si concentra sul miglioramento della pertinenza e dell'accuratezza dei risultati di ricerca tramite l'aggiustamento o il suggerimento delle query in base al contesto dell'utente e ai dati storici, con l'obiettivo di fornire informazioni più precise. L'espansione delle query, invece, implica la generazione di query aggiuntive per migliorare le prestazioni del motore di ricerca affrontando problemi come query iniziali formulate male o risultati irrilevanti. Mentre il raffinamento migliora una query esistente, l'espansione crea più query correlate per ampliare l'ambito della ricerca. Entrambe le tecniche lavorano insieme nei moderni sistemi di ricerca AI per migliorare la qualità del recupero delle informazioni.

I motori di ricerca AI utilizzano il raffinamento delle query tramite un processo chiamato query fan-out, in cui una singola query utente viene scomposta in più sotto-query che vengono eseguite simultaneamente su varie fonti di dati. Ad esempio, una domanda complessa come 'le migliori scarpe da corsa impermeabili per piedi piatti' può essere suddivisa in sotto-query che esplorano le offerte di prodotti, le recensioni di esperti, le esperienze degli utenti e le specifiche tecniche. Questo recupero parallelo di informazioni da fonti diverse espande notevolmente il pool di informazioni disponibili per la sintesi della risposta, permettendo all'AI di fornire risposte più complete e accurate.

L'elaborazione del linguaggio naturale è fondamentale per il raffinamento delle query perché consente ai sistemi AI di interpretare il significato oltre il semplice abbinamento di parole chiave. L'NLP utilizza schemi e relazioni contestuali tra le parole per decifrare il modo in cui parlano gli esseri umani, rendendo le ricerche più intuitive e accurate. Ad esempio, l'NLP permette a un sistema di capire che 'bar aperti' significa locali attualmente in attività e situati nelle vicinanze, non solo documenti che contengono esattamente quelle parole. Questa comprensione contestuale è ciò che consente ai moderni sistemi AI di affinare le query in modo intelligente e fornire risultati che corrispondono all'intento dell'utente piuttosto che a semplici corrispondenze letterali di parole chiave.

Il raffinamento delle query migliora la visibilità nella ricerca nelle AI Overviews aiutando i creatori di contenuti a capire come gli utenti modificano le loro ricerche per trovare risultati migliori. Targetizzando sia le query iniziali che quelle raffinate con contenuti completi che anticipano le esigenze degli utenti e le domande successive, i siti web possono aumentare le possibilità di essere citati come fonti. Le ricerche dimostrano che essere presenti come fonte in una AI Overview aumenta il tasso di clic dallo 0,6% all'1,08%, rendendo la comprensione del raffinamento delle query essenziale per la moderna strategia SEO e la visibilità delle citazioni AI.

Le query sintetiche sono query generate artificialmente dai grandi modelli linguistici che simulano le ricerche degli utenti reali. Sono fondamentali per il raffinamento delle query perché ampliano i dati di addestramento etichettati, migliorano il recall e consentono al recupero generativo di operare su grandi insiemi di dati colmando le lacune informative. Le query sintetiche vengono generate tramite l'analisi di dati strutturati, titoli di documenti e testi di ancoraggio, e utilizzando insiemi di regole strutturate. Aiutano i sistemi AI a comprendere e raffinare le query fornendo esempi diversificati di come gli utenti potrebbero formulare bisogni informativi simili, migliorando così la capacità del sistema di affinare ed espandere efficacemente le query degli utenti.

Le aziende possono ottimizzare il raffinamento delle query analizzando i dati di Google Search Console per identificare parole chiave correlate e variazioni di query che gli utenti cercano in sequenza. Dovrebbero creare contenuti completi che rispondano sia alle query iniziali generiche che alle variazioni raffinate e specifiche. Utilizzando strumenti come seoClarity o piattaforme simili, le aziende possono estrarre dati di raffinamento delle query e suggerimenti automatici per trovare variazioni rilevanti per la ricerca delle parole chiave. Inoltre, monitorare il posizionamento in base al raffinamento delle query e tracciare le prestazioni delle diverse pagine faccettate aiuta a guidare le decisioni sulla strategia dei contenuti e sull'implementazione tecnica.

Il raffinamento delle query è strettamente collegato all'intento dell'utente perché rivela come i bisogni informativi degli utenti evolvono durante il loro percorso di ricerca. Analizzando i modelli di raffinamento delle query, le aziende possono capire cosa cercano realmente gli utenti in ogni fase del loro processo decisionale. Ad esempio, un utente può iniziare con un intento generico ('scarpe da corsa') e affinare progressivamente verso un intento più specifico ('migliori scarpe da corsa impermeabili per piedi piatti'). Comprendere questi schemi di raffinamento permette ai creatori di contenuti di sviluppare contenuti mirati per ogni fase del percorso utente, migliorando sia la visibilità nella ricerca che i tassi di conversione.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Scopri come la riformulazione delle query aiuta i sistemi AI a interpretare e migliorare le richieste degli utenti per un migliore recupero delle informazioni. ...

Scopri come l’ottimizzazione dell’espansione delle query migliora i risultati di ricerca IA colmando i divari di vocabolario. Approfondisci tecniche, sfide e l’...

Scopri come l'Anticipazione della Query aiuta i tuoi contenuti a catturare conversazioni AI estese affrontando le domande successive. Scopri strategie per ident...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.