Limiti dei Token e Ottimizzazione dei Contenuti: Considerazioni Tecniche

Scopri come i limiti dei token influenzano le prestazioni dell'IA e apprendi strategie pratiche per l'ottimizzazione dei contenuti, tra cui RAG, chunking e tecn...

Un token è l’unità base di testo elaborata dai modelli linguistici, che rappresenta parole, sottoparole, caratteri o segni di punteggiatura convertiti in identificatori numerici. I token costituiscono la base su cui sistemi di IA come ChatGPT, Claude e Perplexity comprendono e generano testo, con ciascun token a cui è assegnato un valore intero unico all’interno del vocabolario del modello.

Un token è l'unità base di testo elaborata dai modelli linguistici, che rappresenta parole, sottoparole, caratteri o segni di punteggiatura convertiti in identificatori numerici. I token costituiscono la base su cui sistemi di IA come ChatGPT, Claude e Perplexity comprendono e generano testo, con ciascun token a cui è assegnato un valore intero unico all'interno del vocabolario del modello.

Un token è l’unità fondamentale di testo che i modelli linguistici elaborano e comprendono. I token rappresentano parole, sottoparole, sequenze di caratteri o segni di punteggiatura, a ciascuno dei quali viene assegnato un identificatore numerico unico all’interno del vocabolario del modello. Anziché elaborare direttamente il testo grezzo, i sistemi di IA come ChatGPT, Claude, Perplexity e Google AI Overviews convertono tutto il testo in input in sequenze di token—traducendo di fatto il linguaggio umano in un formato numerico che le reti neurali possono calcolare. Questo processo di tokenizzazione è il primo passo fondamentale che permette ai modelli linguistici di analizzare le relazioni semantiche, generare risposte coerenti e mantenere efficienza computazionale. Comprendere i token è essenziale per chiunque lavori con i sistemi di IA, poiché il conteggio dei token influenza direttamente i costi API, la qualità delle risposte e la capacità del modello di mantenere il contesto nelle conversazioni.

La tokenizzazione è il processo sistematico di suddivisione del testo grezzo in token discreti che un modello linguistico può elaborare. Quando inserisci un testo in un sistema di IA, il tokenizzatore analizza prima il testo e lo suddivide in unità gestibili. Ad esempio, la frase “I heard a dog bark loudly” potrebbe essere tokenizzata in token individuali: I, heard, a, dog, bark, loudly. Ogni token riceve poi un identificatore numerico unico—magari I diventa l’ID token 1, heard diventa 2, a diventa 3 e così via. Questa rappresentazione numerica permette alla rete neurale di eseguire operazioni matematiche sui token, calcolando relazioni e pattern che consentono al modello di comprendere il significato e generare risposte appropriate.

Il modo specifico in cui il testo viene tokenizzato dipende dall’algoritmo di tokenizzazione adottato da ciascun modello. Modelli linguistici diversi utilizzano tokenizzatori diversi, motivo per cui lo stesso testo può produrre conteggi di token differenti tra le piattaforme. Il vocabolario del tokenizzatore—l’insieme completo di token unici che riconosce—generalmente va da decine di migliaia a centinaia di migliaia di token. Quando il tokenizzatore incontra testo mai visto prima o parole fuori dal suo vocabolario, applica strategie specifiche per gestire questi casi, suddividendole in sottoparole più piccole o rappresentandole come combinazioni di token noti. Questa flessibilità è cruciale per gestire lingue diverse, gergo tecnico, refusi e combinazioni di parole nuove che compaiono nei testi reali.

I diversi approcci di tokenizzazione offrono vantaggi e compromessi distinti. Comprendere questi metodi è essenziale per capire come le varie piattaforme IA elaborano le informazioni in modo differente:

| Metodo di Tokenizzazione | Come Funziona | Vantaggi | Svantaggi | Utilizzato Da |

|---|---|---|---|---|

| Word-Level | Suddivide il testo in parole complete in base a spazi e punteggiatura | Semplice da capire; preserva il significato completo della parola; sequenze di token più brevi | Vocabolario molto grande; non gestisce parole sconosciute o rare (OOV); poco flessibile con refusi | Sistemi NLP tradizionali |

| Character-Level | Considera ogni singolo carattere come un token, inclusi gli spazi | Gestisce qualsiasi testo; nessun problema OOV; controllo molto dettagliato | Sequenze di token molto lunghe; richiede più calcolo; bassa densità semantica per token | Alcuni modelli specializzati; modelli in lingua cinese |

| Subword-Level (BPE) | Unisce iterativamente coppie frequenti di caratteri/sottoparole in token più grandi | Bilancia dimensione del vocabolario e copertura; gestisce bene parole rare; riduce errori OOV | Implementazione più complessa; può dividere unità di significato; richiede addestramento | Modelli GPT, ChatGPT, Claude |

| WordPiece | Parte dai caratteri e unisce progressivamente combinazioni frequenti | Ottimo per gestire parole sconosciute; vocabolario efficiente; buona preservazione semantica | Richiede pre-addestramento; più intensivo computazionalmente | BERT, modelli Google |

| SentencePiece | Metodo indipendente dalla lingua che tratta il testo come byte grezzi | Ottimo per modelli multilingue; gestisce qualsiasi carattere Unicode; nessuna pre-elaborazione necessaria | Meno intuitivo; richiede strumenti specializzati | Modelli multilingue, T5 |

Una volta che il testo è stato convertito in token, i modelli linguistici elaborano queste sequenze numeriche attraverso diversi strati di reti neurali. Ogni token viene rappresentato come un vettore multidimensionale chiamato embedding, che cattura il significato semantico e le relazioni contestuali. Durante la fase di addestramento, il modello impara a riconoscere i pattern in cui i token compaiono insieme, comprendendo che certi token co-occorrono frequentemente o appaiono in contesti simili. Ad esempio, i token di “king” e “queen” sviluppano embedding simili perché condividono proprietà semantiche, mentre “king” e “paper” avranno embedding più distanti a causa dei loro diversi significati e usi.

Il meccanismo di attenzione del modello è cruciale in questo processo. L’attenzione permette al modello di pesare l’importanza dei diversi token tra loro durante la generazione di una risposta. Quando elabora la frase “The bank executive sat by the river bank,” il meccanismo di attenzione aiuta il modello a capire che il primo “bank” si riferisce a un istituto finanziario mentre il secondo “bank” indica una riva del fiume, in base a token contestuali come “executive” e “river.” Questa comprensione contestuale emerge dalle relazioni apprese tra gli embedding dei token, consentendo una comprensione linguistica sofisticata che va ben oltre la semplice corrispondenza di parole.

Durante l’inferenza (quando il modello genera risposte), predice il token successivo in una sequenza in base a tutti i token precedenti. Il modello calcola punteggi di probabilità per ogni token nel suo vocabolario, quindi seleziona il token successivo più probabile. Questo processo si ripete iterativamente—il nuovo token generato viene aggiunto alla sequenza e il modello usa questo contesto ampliato per predire il token seguente. Questa generazione token per token continua fino a quando il modello predice un token speciale di “fine sequenza” o raggiunge il limite massimo di token. Ecco perché è fondamentale comprendere i limiti dei token: se il prompt e la risposta desiderata superano insieme la finestra di contesto del modello, il modello non può generare una risposta completa.

Ogni modello linguistico ha una finestra di contesto—un numero massimo di token che può elaborare contemporaneamente. Questo limite combina sia i token di input (il tuo prompt) che quelli di output (la risposta del modello). Ad esempio, GPT-3.5-Turbo ha una finestra di contesto di 4.096 token, mentre GPT-4 offre finestre da 8.000 a 128.000 token a seconda della versione. I modelli Claude 3 supportano finestre di contesto fino a 200.000 token, permettendo l’analisi di interi libri o documenti estesi. Comprendere la finestra di contesto del tuo modello è essenziale per pianificare i prompt e gestire efficacemente il budget di token.

Gli strumenti di conteggio dei token sono essenziali per ottimizzare l’uso dell’IA. OpenAI mette a disposizione la libreria tiktoken, un tokenizzatore open-source che permette agli sviluppatori di contare i token prima di effettuare chiamate API. Questo previene costi imprevisti e consente una precisa ottimizzazione dei prompt. Ad esempio, se usi GPT-4 con una finestra di contesto di 8.000 token e il tuo prompt ne utilizza 2.000, hai 6.000 token disponibili per la risposta del modello. Conoscere questo vincolo ti aiuta a scrivere prompt che rientrano nello spazio token disponibile pur richiedendo risposte esaustive. Modelli diversi utilizzano tokenizzatori diversi—Claude usa un proprio sistema di tokenizzazione, Perplexity implementa il suo metodo e Google AI Overviews ne usa un altro. Questa variazione significa che lo stesso testo produce conteggi di token diversi tra le piattaforme, rendendo essenziale il conteggio specifico per piattaforma per stime precise di costo e prestazioni.

I token sono diventati l’unità fondamentale di valore economico nell’industria dell’IA. La maggior parte dei fornitori di servizi IA addebita sulla base del consumo di token, con tariffe separate per token di input e di output. La struttura dei prezzi di OpenAI esemplifica questo modello: nel 2024, GPT-4 addebita circa $0,03 per 1.000 token di input e $0,06 per 1.000 token di output, il che significa che i token di output costano circa il doppio rispetto a quelli di input. Questa struttura riflette la realtà computazionale che generare nuovi token richiede più potenza di calcolo rispetto all’elaborazione di token di input esistenti. Anche la tariffazione di Claude segue uno schema simile, mentre Perplexity e altre piattaforme adottano i propri modelli di prezzo basati sui token.

Comprendere l’economia dei token è fondamentale per gestire i costi dell’IA su larga scala. Un singolo prompt prolisso può consumare 500 token, mentre un prompt conciso e ben strutturato raggiunge lo stesso obiettivo con solo 200 token. Su migliaia di chiamate API, questa differenza di efficienza si traduce in un notevole risparmio. Le ricerche indicano che le aziende che usano strumenti di monitoraggio dei contenuti basati su IA possono ridurre il consumo di token del 20-40% grazie all’ottimizzazione dei prompt e strategie intelligenti di caching. Inoltre, molte piattaforme implementano limiti di velocità misurati in token al minuto (TPM), limitando quanti token un utente può elaborare in un intervallo di tempo specifico. Questi limiti prevengono abusi e garantiscono una distribuzione equa delle risorse tra gli utenti. Per le organizzazioni che monitorano la presenza del proprio brand nelle risposte IA tramite piattaforme come AmICited, comprendere i pattern di consumo dei token rivela non solo implicazioni di costo ma anche la profondità e l’ampiezza dell’interazione dell’IA con i propri contenuti.

Per le piattaforme dedicate al monitoraggio della presenza di brand e domini nelle risposte IA, i token rappresentano una metrica cruciale per misurare coinvolgimento e influenza. Quando AmICited traccia come compare il tuo brand su ChatGPT, Claude, Perplexity e Google AI Overviews, il conteggio dei token rivela le risorse computazionali che questi sistemi dedicano ai tuoi contenuti. Una citazione che consuma 50 token indica un coinvolgimento più sostanziale rispetto a una breve menzione che ne consuma solo 5. Analizzando i pattern di token tra diverse piattaforme IA, le organizzazioni possono capire quali sistemi IA danno priorità ai loro contenuti, quanto approfonditamente i diversi modelli trattano il brand e se i loro contenuti ricevono un’analisi approfondita o superficiale.

Il tracciamento dei token permette anche un’analisi sofisticata della qualità e rilevanza delle risposte IA. Quando un sistema IA genera una risposta lunga e dettagliata sul tuo brand utilizzando centinaia di token, indica alta fiducia e conoscenza approfondita. Al contrario, risposte brevi che usano pochi token possono suggerire informazioni limitate o ranking di rilevanza più bassi. Questa distinzione è fondamentale per la gestione del brand nell’era dell’IA. Le organizzazioni possono usare il monitoraggio a livello di token per identificare quali aspetti del brand ricevono maggiore attenzione dall’IA, quali piattaforme danno priorità ai loro contenuti e come la visibilità si confronta con quella dei competitor. Inoltre, i pattern di consumo dei token possono rivelare trend emergenti—se l’uso di token per il tuo brand aumenta improvvisamente su più piattaforme IA, potrebbe indicare una rilevanza crescente o una recente copertura mediatica che viene incorporata nei dati di addestramento dell’IA.

Il panorama della tokenizzazione continua a evolversi man mano che i modelli linguistici diventano più sofisticati e capaci. I primi modelli linguistici utilizzavano una tokenizzazione a livello di parola relativamente semplice, ma i sistemi moderni adottano metodi avanzati di tokenizzazione a livello di sottoparola che bilanciano efficienza e preservazione semantica. Il Byte-Pair Encoding (BPE), introdotto da OpenAI e ora standard di settore, rappresenta un significativo passo avanti rispetto agli approcci precedenti. Tuttavia, ricerche emergenti suggeriscono che potrebbero nascere metodi di tokenizzazione ancora più efficienti man mano che i modelli si espandono per gestire contesti più lunghi e dati più diversificati.

Il futuro della tokenizzazione va oltre il testo. I modelli multimodali come GPT-4 Vision e Claude 3 tokenizzano immagini, audio e video oltre al testo, creando rappresentazioni di token unificate tra le diverse modalità. Questa espansione significa che un singolo prompt può contenere token di testo, token di immagini e token audio, tutti elaborati dalla stessa architettura di rete neurale. Con la maturazione di questi sistemi multimodali, comprendere il consumo di token tra diversi tipi di dati diventa sempre più importante. Inoltre, l’emergere di modelli di ragionamento che generano “thinking tokens” intermedi invisibili agli utenti rappresenta un’ulteriore evoluzione. Questi modelli consumano molti più token durante l’inferenza—a volte 100 volte oltre i modelli tradizionali—per produrre ragionamenti e risoluzioni di problemi di qualità superiore. Questo sviluppo suggerisce che l’industria dell’IA potrebbe spostarsi verso una misurazione del valore non solo sui token di output, ma sui token computazionali totali consumati, inclusi i processi di ragionamento nascosti.

La standardizzazione del conteggio dei token tra le piattaforme resta una sfida aperta. Sebbene la libreria tiktoken di OpenAI sia ormai molto diffusa, le diverse piattaforme mantengono tokenizzatori proprietari che producono risultati variabili. Questa frammentazione crea complessità per le organizzazioni che monitorano la propria presenza su più sistemi IA. In futuro potrebbero emergere standard di settore per i token, analogamente a come gli standard di codifica dei caratteri (UTF-8) hanno unificato la rappresentazione del testo nei sistemi. Tale standardizzazione semplificherebbe la previsione dei costi, permetterebbe un confronto equo tra servizi di IA e faciliterebbe un monitoraggio più efficace della presenza del brand nell’ecosistema dell’IA. Per piattaforme come AmICited dedicate al tracciamento della presenza del brand nelle risposte IA, metriche token standardizzate consentirebbero una misurazione più precisa di come i diversi sistemi IA interagiscono con i contenuti e allocano risorse computazionali.

In media, un token rappresenta circa 4 caratteri o circa tre quarti di una parola in un testo inglese. Tuttavia, questo varia notevolmente in base al metodo di tokenizzazione utilizzato. Parole brevi come "the" o "a" generalmente consumano un token, mentre parole più lunghe o complesse possono richiedere due o più token. Ad esempio, la parola "darkness" potrebbe essere suddivisa in "dark" e "ness" come due token separati.

I modelli linguistici sono reti neurali che elaborano dati numerici, non testo. I token convertono il testo in rappresentazioni numeriche (embedding) che le reti neurali possono comprendere ed elaborare in modo efficiente. Questo passaggio di tokenizzazione è essenziale perché standardizza l'input, riduce la complessità computazionale e consente al modello di apprendere le relazioni semantiche tra diverse parti di testo tramite operazioni matematiche sui vettori dei token.

I token di input sono quelli che derivano dal tuo prompt o dalla domanda inviata al modello di IA, mentre i token di output sono quelli che il modello genera nella sua risposta. La maggior parte dei servizi di IA applica tariffe diverse per i token di input e di output, con i token di output che di solito costano di più perché generare nuovo contenuto richiede più risorse computazionali rispetto all'elaborazione di testo esistente. L'utilizzo totale dei token è la somma di input e output token.

Il numero di token determina direttamente i costi delle API per i modelli linguistici. Servizi come OpenAI, Claude e altri addebitano per token, con tariffe che variano a seconda del modello e del tipo di token. Un prompt più lungo con più token costa di più da elaborare, e generare risposte più lunghe consuma più token di output. Capire l'efficienza dei token aiuta a ottimizzare i costi—prompt concisi che trasmettono le informazioni necessarie minimizzano il consumo di token mantenendo la qualità della risposta.

Una finestra di contesto è il numero massimo di token che un modello linguistico può elaborare contemporaneamente, combinando sia i token di input che di output. Ad esempio, GPT-4 ha una finestra di contesto da 8.000 a 128.000 token a seconda della versione. Questo limite determina quanta parte del testo il modello può "vedere" e ricordare durante la generazione delle risposte. Finestre di contesto più ampie permettono di processare documenti più lunghi, ma richiedono anche maggiori risorse computazionali.

I tre metodi principali di tokenizzazione sono: livello parola (suddivide il testo in parole intere), livello carattere (ogni carattere è un token) e tokenizzazione a livello di sottoparola come il Byte-Pair Encoding (BPE) usato dai modelli GPT. La tokenizzazione a livello di sottoparola è la più comune nei moderni LLM perché bilancia la dimensione del vocabolario, gestisce efficacemente le parole rare e riduce gli errori OOV mantenendo il significato semantico.

Per piattaforme come AmICited che monitorano le risposte IA su ChatGPT, Perplexity, Claude e Google AI Overviews, il tracking dei token è fondamentale per capire quanta parte dei tuoi contenuti di brand o URL viene elaborata e citata dai sistemi di IA. I conteggi dei token rivelano la profondità dell'interazione dell'IA con i tuoi contenuti—un utilizzo maggiore di token indica citazioni o riferimenti più sostanziali, aiutandoti a misurare la visibilità e l'influenza del tuo brand nelle risposte generate dall'IA.

Sì, assolutamente. Modelli linguistici diversi utilizzano diversi tokenizzatori e vocabolari, quindi lo stesso testo produrrà conteggi di token diversi. Ad esempio, la parola "antidisestablishmentarianism" produce 5 token in GPT-3 ma 6 token in GPT-4 a causa dei diversi algoritmi di tokenizzazione. Ecco perché è importante usare conteggiatori di token specifici del modello quando si stimano i costi o si pianificano prompt per particolari sistemi di IA.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Scopri come i limiti dei token influenzano le prestazioni dell'IA e apprendi strategie pratiche per l'ottimizzazione dei contenuti, tra cui RAG, chunking e tecn...

Scopri come i modelli di intelligenza artificiale elaborano il testo tramite tokenizzazione, embedding, blocchi transformer e reti neurali. Comprendi l'intera p...

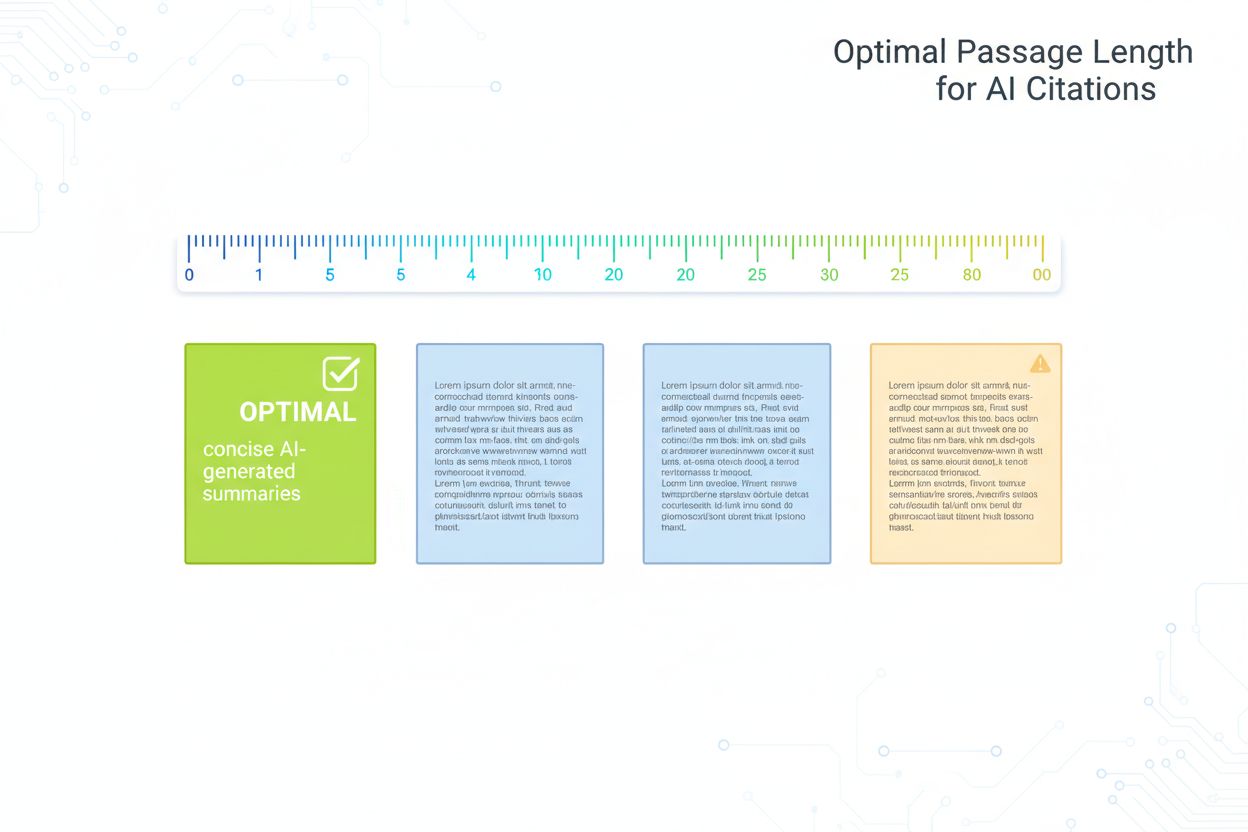

Guida basata sulla ricerca per la lunghezza ottimale dei passaggi per le citazioni AI. Scopri perché 75-150 parole è l'ideale, come i token influenzano il recup...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.