AI可視性プレイブック:チームリファレンスマテリアルの作成

ChatGPT、Perplexity、Google AI Overviewsなどのプラットフォームで、戦略・ガバナンス・AI引用追跡についてチームの足並みを揃えるAI可視性プレイブックの構築方法を学びましょう。...

AI可視性とは、自身のコンテンツエコシステム内でAIシステムがどのように動作しているかを包括的に観察・追跡・把握する能力を指します。コンテンツガバナンスにおいて、可視性は組織がAI生成・AI処理コンテンツに関する管理・法令遵守・リスク低減を可能にする基盤となります。AIシステムの明確な可視性がなければ、組織はバイアスの検知や法規制の遵守、新たな脅威への対応ができず、まさに手探りで運営することになります。可視性重視のガバナンスは、事後的な危機管理を積極的なリスク予防へと変革し、チームがコンテンツ品質・信頼性・組織価値との整合性について根拠ある判断を下せるようにします。

多くの組織は、AI導入速度とそれを効果的に管理する能力との間に重大なガバナンスギャップを抱えています。調査によると、63%の組織が正式なAIガバナンスプログラムを持っていません。これにより法令違反、風評被害、運用上の失敗などに脆弱となっています。AIシステムが高度化し事業中枢に統合されるほど、このギャップは広がり、専用のフレームワークやツールなくして可視性の確保は困難です。このギャップは単なる規制違反にとどまらず、可視性のない組織はコンテンツ品質の維持、有害出力の検知、ステークホルダーへの説明責任にも苦しむことになります。このギャップを埋めるには、AIシステムの挙動やコンテンツ成果をリアルタイムで把握できる可視性メカニズムへの意図的な投資が必要です。

| 項目 | 事後的ガバナンス | 事前的ガバナンス |

|---|---|---|

| 発見 | 公開後に問題を特定 | 継続的監視で早期検知 |

| 対応 | 危機管理と被害抑制 | 予防措置とリスク低減 |

| コンプライアンス | 監査後の是正と罰則 | 継続的な遵守確認 |

| リスク | 未知の脅威への高い曝露 | 計画的なリスク特定と管理 |

効果的なAIコンテンツガバナンスポリシーは、組織全体の意思決定と運用実践を導く6つの基本原則に基づいています。これらの原則は、イノベーションと責任のバランスを保つ一貫性あるフレームワークを形成し、AIシステムが組織の目標に寄与しつつステークホルダーを守ることを保証します。原則をポリシーに組み込むことで、AIシステムのあるべき行動やチームの管理方法の明確な期待値を設定できます。原則同士は相乗効果を持ち、透明性は説明責任を、人的監督は公正性を、プライバシー保護は信頼を生みます。これらを一貫して運用する組織は、法令遵守やステークホルダー信頼、長期的な持続可能性で他社をリードしています。

AIガバナンスの規制環境は急速に進化しており、複数のフレームワークがAIシステム導入組織に義務的要件を課すようになっています。EU AI法は最も包括的な規制アプローチであり、AIシステムをリスクレベルで分類し、コンテンツモデレーションや生成など高リスク用途に厳格な要件を課しています。NIST AIリスク管理フレームワークは、組織がAIリスクを特定・測定・管理できるよう柔軟かつ非規定的なガイダンスを提供します。ISO 42001はAIマネジメントシステムの国際標準を定めており、組織全体でガバナンスを実施するための体系的手法を示します。さらに、米国の大統領令や、州レベルの新興規制が複雑な要件のパッチワークを形成しています。これらのフレームワークはいずれも、透明性・説明責任・人的監督・継続的監視を共通テーマとし、可視性が規制遵守のカギとなっています。

強固なポリシーフレームワーク構築には、自組織のAIシステム・コンテンツフロー・リスク暴露状況の体系的な評価が不可欠です。まず、全てのコンテンツ生成・処理・配信を担うAIシステムについて、その目的・データ入力・ステークホルダーへの影響を網羅したAIインベントリを作成します。続いて、リスクに基づいて異なる監督レベルを割り振るガバナンスティアを設定します。例えば、コンテンツモデレーションなど高リスクシステムには厳格な監視を、低リスク用途には簡便なガバナンスを適用します。各システムの運用方法、許容される成果、問題発生時の対応を明確に記した明確なポリシーを策定します。さらに、ポリシー遵守の責任者やエスカレーション手順を定めた説明責任構造を構築し、測定メカニズムを導入してポリシー遵守状況を追跡、継続的改善につなげます。

AI可視性を実現するには、システムの挙動やコンテンツ成果をリアルタイムで把握するための専用ツールや評価メカニズムの導入が必要です。監視ダッシュボードは、AIシステムやコンテンツプラットフォーム、コンプライアンスシステムのデータを統合し、迅速な問題検知を可能にします。監査証跡は、AIの意思決定、コンテンツ修正、ガバナンス対応の詳細記録を残し、説明責任や規制調査に活用されます。アセスメントフレームワークは、AIシステムをガバナンス原則に照らして体系的に評価し、問題が深刻化する前にギャップや改善点を特定します。自動検出システムは、問題のあるコンテンツやバイアス出力、ポリシー違反を自動で検知し、手動レビューの負担を減らしつつ一貫性を高めます。これらの包括的な可視性ツールに投資することで、組織は規制遵守・ステークホルダー信頼・運用効率で優位性を獲得できます。

継続的監視は、ガバナンスを定期的なコンプライアンス作業から、リアルタイムで問題を検知・対応する運用上の習慣へと転換します。各AIシステムごとに最も重要な指標(正確性、バイアス指標、コンテンツ品質スコア、ポリシー違反頻度など)を定義する監視プロトコルを策定します。指標が許容範囲を逸脱した際に関係チームへ通知する自動アラートシステムを実装し、迅速な調査と対応を可能にします。監視データがシステム改善へと還元されるフィードバックループを構築し、実際のパフォーマンスに基づきAIモデルやガバナンスプロセスを洗練します。さらに、定期的なコンプライアンスレビューを実施し、監視体制そのものの有効性や新たなリスク・規制変更への対応としてポリシーの更新が必要かを評価します。継続的監視を運用に組み込んだ組織は、問題解決の迅速化、コンプライアンスコストの低減、ステークホルダーの信頼強化を実現しています。

効果的なAIコンテンツガバナンスには、各組織機能が専門知識と視点を持ち寄り、協調して取り組むことが不可欠です。法務・コンプライアンス部門は、ポリシーが規制要件に沿っているかを保証し、対外的な規制当局との関係を担います。技術部門は、監視システムや監査証跡の実装、ガバナンス制約下でのAIパフォーマンス最適化を担当します。コンテンツ・編集部門は、ガバナンスポリシーを現場で適用し、日常的なコンテンツ品質や適切性の判断を行います。リスク・倫理部門は、新たな脅威や潜在的な害を評価し、ポリシー調整を提案します。経営層は、リソースの提供や組織の優先順位設定、ガバナンスへのコミットメントを方針や発信で示します。これらの機能が共通ガバナンス目標で連携する組織は、部門ごとにサイロ化した組織よりも優れた成果を達成しています。

AIコンテンツガバナンスとは、AIが生成・処理するコンテンツが信頼でき、法令遵守し、組織の価値観に沿ったものとなるようにするためのポリシー、プロセス、管理体制のことです。コンテンツの作成や検証から、監視、インシデント対応まで幅広く含まれます。

可視性があることで、組織はAIシステムがどこでどのように動作し、どんなリスクが生じているかを把握できます。可視性がなければ、ガバナンスは事後対応的で非効率となります。可視性はガバナンスを危機管理から積極的なリスク予防へと変える力があります。

主なフレームワークとして、EU AI法(リスクベースの法的区分)、NIST AIリスク管理フレームワーク(柔軟なガイダンス)、ISO 42001(国際標準)、さらに大統領令や各州の規制があります。いずれも透明性、説明責任、人による監督を重視しています。

NIST AI RMF や ISO 42001 など認知された基準に沿った体系的な評価フレームワークを使いましょう。既存コントロールを基準要件と照合し、ギャップを特定し、目標成熟度を設定します。定期的な評価により、システム上の弱点や改善機会が明らかになります。

効果的なポリシーには、許容される利用ケース、データ調達ルール、文書化要件、人による監督手順、監視メカニズム、エスカレーション手順などを含めます。実際に現場で使われるツールやワークフローに組み込むことが重要です。

ガバナンスは継続的に監視し、最低でも四半期ごとに正式な見直しを行うべきです。リアルタイム監視で即時の問題検知、定期レビューでフレームワークの有効性やポリシーの見直しが必要かを判断します。

効果的なツールには、リアルタイム指標を示す監視ダッシュボード、説明責任のための監査証跡、コントロール評価のためのアセスメントフレームワーク、ポリシー違反を検知する自動検出システム、リスク定量化プラットフォームなどがあります。これらは技術スタック全体で統合されるべきです。

AmICitedは、GPTs、Perplexity、Google AI OverviewsにおけるAIシステムやLLMがあなたのブランドをどのように参照しているかを監視します。これによりAI上でのプレゼンスを把握し、AIシステムによるコンテンツの利用状況を理解し、AI主導のコンテンツエコシステム内でブランドの評判を守ることができます。

AmICitedは、GPTs、Perplexity、Google AI Overviews でAIシステムやLLMがあなたのコンテンツをどのように引用しているかを追跡します。AIでの存在感を可視化し、ブランドの評判を守りましょう。

ChatGPT、Perplexity、Google AI Overviewsなどのプラットフォームで、戦略・ガバナンス・AI引用追跡についてチームの足並みを揃えるAI可視性プレイブックの構築方法を学びましょう。...

プロアクティブな監視、早期警告システム、戦略的な対応プロトコルでAI可視性危機を防ぐ方法をご紹介。AI時代のブランドを守りましょう。...

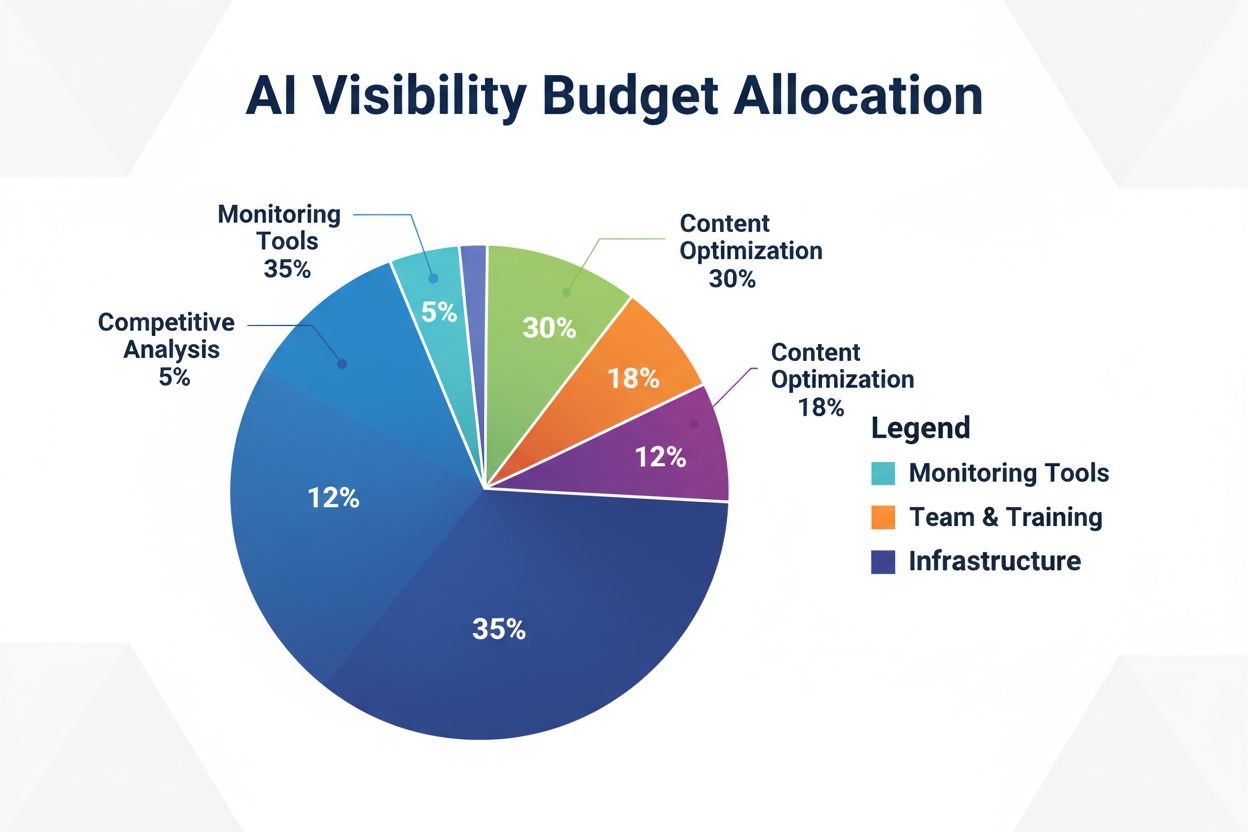

AI生成回答でのROIとブランド認知を最大化するために、モニタリングツール、コンテンツ最適化、チームリソース、競合分析など、AI可視性予算を戦略的に配分する方法を学びましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.