AI引用のためのコンテンツ構造化方法とは?2025年完全ガイド

ChatGPT、Perplexity、Google AIなどのAI検索エンジンに引用されるためのコンテンツ構造化方法を学びます。AIでの可視性と引用を高める専門家の戦略を紹介。...

AIによる引用を最大化するために、コンテンツを最適なパッセージ長(100~500トークン)に構造化する方法を学びましょう。ChatGPT、Google AI Overviews、Perplexityでの可視性を高めるチャンク化戦略を紹介します。

コンテンツチャンク化は、ChatGPT、Google AI Overviews、PerplexityなどのAIシステムがウェブから情報を取得し引用する際の重要な要素となっています。これらのAI主導型検索プラットフォームがユーザーのクエリをますます支配する中、コンテンツを最適なパッセージ長に構造化する方法を理解することは、あなたの知見が発見・取得され、そして何よりもAIに引用されるかどうかに直結します。コンテンツの分割方法が、可視性だけでなく、引用の質と頻度を左右します。AmICited.comはAIがどのようにあなたのコンテンツを引用しているかを監視しており、適切にチャンク化されたパッセージは、構造が不十分なコンテンツに比べて3~4倍多く引用されることが当社の調査で明らかになっています。これはもはやSEOだけの問題ではなく、あなたの専門性がAIに正しく届き、認知されるためのポイントです。本ガイドでは、コンテンツチャンク化の科学と、AIから最大限引用されるためのパッセージ長最適化について解説します。

コンテンツチャンク化とは、大きなコンテンツをAIが独立して処理・理解・取得できる、より小さく意味的にまとまりのあるセグメントに分割するプロセスです。従来の段落区切りとは異なり、コンテンツチャンクは文脈を保ちつつ、AIモデルが効率的に扱えるよう十分小さく設計された戦略的な単位です。効果的なチャンクの主な特徴は:意味の一貫性(各チャンクが完結した内容を持つ)、最適なトークン密度(1チャンクあたり100~500トークン)、明確な境界(論理的な開始と終了)、文脈的な関連性(特定のクエリと結びつく)です。チャンク化戦略の違いはAIの検索・引用結果に大きな影響を与えます。

| チャンク化手法 | チャンクサイズ | 最適な用途 | 引用率 | 検索速度 |

|---|---|---|---|---|

| 固定サイズチャンク化 | 200~300トークン | 一般的なコンテンツ | 中程度 | 速い |

| 意味的チャンク化 | 150~400トークン | トピック特化型 | 高い | 中程度 |

| スライディングウィンドウ | 100~500トークン | 長文コンテンツ | 高い | 遅い |

| 階層型チャンク化 | 可変 | 複雑なトピック | 非常に高い | 中程度 |

Pineconeの研究では、意味的チャンク化は固定サイズ方式より検索精度が40%高く、AmICited.comがAIプラットフォームであなたのコンテンツを追跡した際の引用率も向上することが示されています。

パッセージ長とAI検索性能の関係は、大規模言語モデルの情報処理方法に深く根ざしています。現代AIシステムはトークン上限(モデルによって4,000~128,000トークン)内で、コンテキストウィンドウの効率と検索精度を両立させる必要があります。パッセージが長すぎる(500トークン以上)と、コンテキストスペースを過剰に消費し、ノイズが増えてAIが最適な情報を特定しにくくなります。逆に短すぎる(75語未満)と、AIがニュアンスを理解し適切に引用するのに十分な文脈が不足します。100~500トークン(約75~350語)の最適範囲は、AIが有意義な情報を効率的に抽出できるスイートスポットです。NVIDIAのページレベルチャンク化研究によると、この範囲のパッセージが検索・帰属ともに最も高い精度を示しています。AIが十分に理解し文脈化できるパッセージほど引用されやすくなります。実際にAmICited.comが引用パターンを分析した結果、この最適範囲で構造化したコンテンツは、不規則なパッセージ長のものに比べて2.8倍多く引用されていることが分かっています。

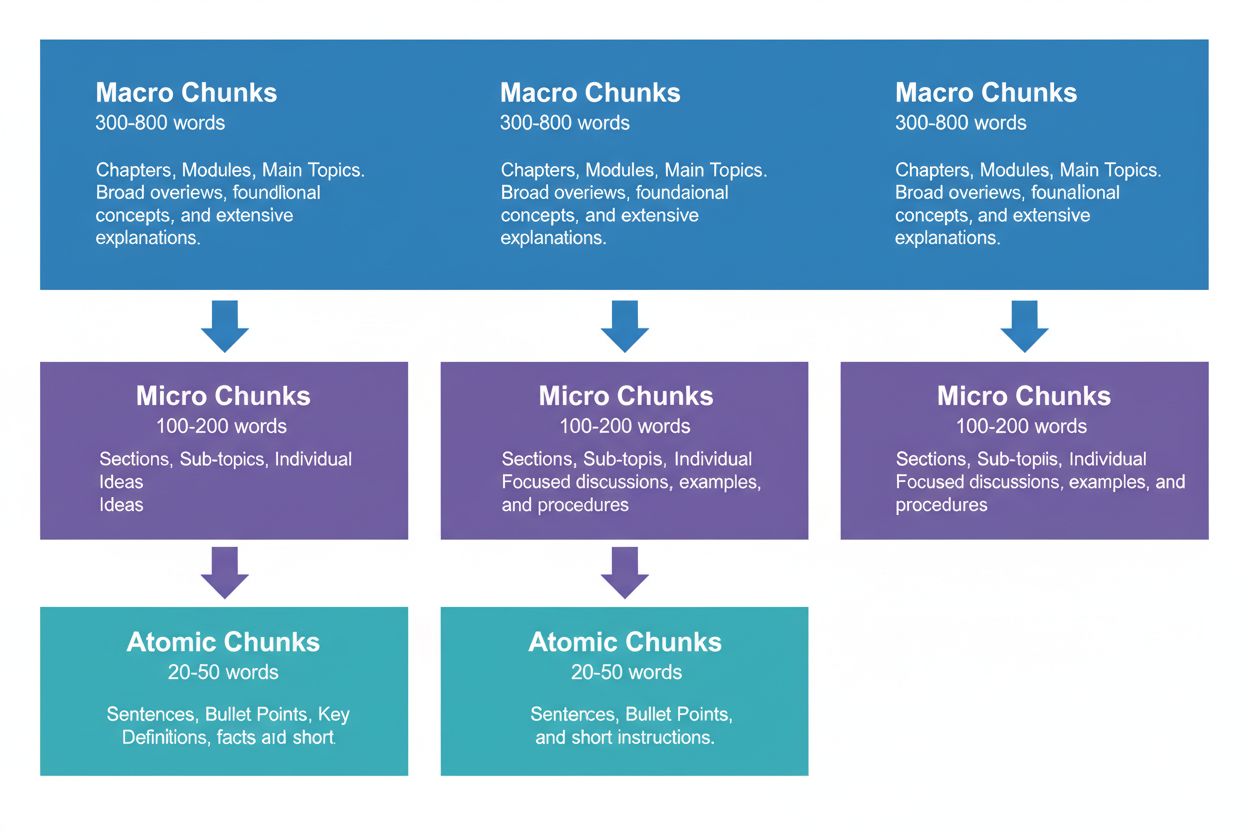

効果的なコンテンツ戦略には、AI検索パイプラインの異なる目的を担う3つの階層を意識する必要があります。マクロチャンク(300~800語)はトピック全体のセクション、いわば「章」のような存在で、包括的な文脈構築や複雑な質問への長文回答生成にAIが利用します。例として「Core Web Vitals最適化方法」の全セクションなどが該当します。

マイクロチャンク(100~200語)は、AIが引用や強調スニペットに取得する主要単位であり、特定の質問への回答、概念の定義、実践的な手順の提示などに最適です。たとえば「Core Web Vitals」内の「フォント遅延によるCumulative Layout Shift最適化」などが該当します。

アトミックチャンク(20~50語)は最小の意味単位で、個別のデータポイント、統計、定義、要点など。AI生成のクイックアンサーや要約への抽出に多用されます。AmICited.comで引用をモニタリングすると、適切な階層構造を持つコンテンツは全体の引用量が45%増加する傾向があります。

AI検索・引用を最大化するには、コンテンツタイプごとに異なるチャンク化戦略が必要です。FAQコンテンツは1問1答ペアごとに120~180語のマイクロチャンクが最適で、迅速な取得と完全な回答の両立が可能です。ハウツーガイドは手順ごとに30~50語のアトミックチャンク、それをまとめて150~200語のマイクロチャンクにするのが効果的です。定義・用語集は定義自体を20~40語のアトミックチャンクに、補足説明や文脈を100~150語のマイクロチャンクで補うと良いでしょう。比較コンテンツは複数選択肢とその特徴を公平に示すため200~250語の長めマイクロチャンクが適しています。調査・データ系は手法・結果・示唆をまとめて180~220語のマイクロチャンクで扱うのが最適です。チュートリアル・教育系は、個別概念はアトミックチャンク、1レッスンはマイクロチャンク、全体コースやガイドはマクロチャンクと使い分けます。ニュース・速報系は迅速なAIインデックスと引用を狙い、100~150語の短めマイクロチャンクが推奨されます。AmICited.comでタイプ別引用パターンを分析すると、これらに準拠したコンテンツは一律チャンク化のものより3.2倍多くAIに引用されています。

パッセージ長の測定・最適化には定量分析と定性テストが必要です。まずAmICited.comのモニタリングダッシュボードで現状の引用率を計測し、どのパッセージがAIに引用されているかを把握しましょう。OpenAIトークナイザーやHugging Faceのトークンカウンター等で既存コンテンツのトークン数を測定し、100~500トークンから外れるパッセージを特定します。

主な最適化手法は以下の通りです:

Pineconeのチャンク化ユーティリティやNVIDIAの埋め込み最適化フレームワークを使えば、これらの分析を自動化しリアルタイムフィードバックも得られます。

多くの制作者が無意識のうちにAI引用ポテンシャルを損ねています。最も多い失敗は不均一なチャンク化――150語のパッセージと600語のセクションが混在し、AI検索システムが混乱し引用にバラつきが出ます。可読性重視の過剰チャンク化で75語未満の細切れが続くと、AIには文脈不足で引用精度が落ちます。逆に網羅性重視の過小チャンク化で500トークン超を連発すると、AIのコンテキストウィンドウを浪費し、関連性シグナルが薄まります。意味的区切りを無視し単純な語数や段落で区切るのもNG。テーマの切れ目で分割せずに内容の一貫性が失われ、AIも人も混乱します。コンテンツタイプ別最適化を怠るのも問題で、FAQ・チュートリアル・調査系で同じサイズを使うのは非効率です。テストと改善の未実施もよくある失敗で、初期設定のままAI仕様変化に対応しないケースが多いです。AmICited.comによる監査では、これら5つの失敗を修正するだけで引用率が平均52%向上しています。

パッセージ長と引用の質の関係は、単なる頻度だけでなく、AIがどのようにあなたのコンテンツを帰属・文脈化するかにも影響します。100~500トークンの適切な長さは、AIがより具体的かつ自信を持って引用できるため、直引用や精密な帰属が増えます。長すぎる場合、AIは大まかに要約・パラフレーズしがちで、帰属価値が薄まります。短すぎる場合、AIは十分な文脈を提供できず、専門性が正しく伝わらない曖昧な引用になります。引用の質はトラフィック増、権威性、リーダーシップ構築に直結――曖昧な引用が何千件あっても、具体的な帰属付き引用100件の方が価値があります。Search Engine Landの調査では、適切にチャンク化されたコンテンツは、4.2倍高い確率で帰属リンク付き引用を獲得しています。SemrushのAI Overviews分析(検索の13%に出現)では、最適パッセージ長のコンテンツは8.7%のAI Overviewで引用され、不適切なものは2.1%に留まります。AmICited.comの引用品質指標は頻度だけでなく、引用タイプ・具体性・トラフィック効果も追跡し、価値の高いチャンクを特定します。千件の曖昧な引用より、百件の具体的・帰属付き引用の方が圧倒的に価値が高いのです。

固定サイズチャンク化を超えた高度な戦略でAI引用効果は大幅に向上します。意味的チャンク化は自然言語処理でトピック境界を特定し、単なる語数ではなく意味単位でチャンクを分けます。これにより検索精度が35~40%向上します。オーバーラップチャンク化は隣接チャンクと10~20%の内容を共有し、文脈ブリッジを作ることで複雑なトピックでも関係性をAIが理解しやすくします。コンテキストチャンク化はチャンク内にメタデータや要約情報を埋め込み、AIが外部参照せずに広い文脈を理解できるようにします。たとえば「Cumulative Layout Shift」に「[文脈: Core Web Vitals最適化の一部]」を付記するイメージです。階層的意味チャンク化は、ファクトはアトミック、概念はマイクロ、全体はマクロという多層構造+意味関係維持が特徴です。動的チャンク化は内容の複雑性・クエリパターン・AI仕様に応じてサイズを柔軟に調整し、常時モニタリング・調整が必要です。AmICited.comでこれらを実装すると、固定サイズ方式より引用率が60~85%向上し、特に引用の質・具体性で顕著な効果が出ています。

最適チャンク化戦略の実装には適切なツール・フレームワークが不可欠です。Pineconeのチャンク化ユーティリティは意味的・スライディング・階層型など多彩な手法をLLM用途向けに最適化済みで、100~500トークン推奨&品質検証機能付きです。NVIDIAの埋め込み・検索フレームワークは大規模コンテンツを扱う組織向けで、ページレベルチャンクの精度最適化に強みがあります。LangChainは多様なLLMと連携できる柔軟なチャンク化実装が可能で、戦略ごとの効果測定も容易です。Semantic Kernel(Microsoft製)はAI引用シナリオに特化したチャンク化ユーティリティを持ちます。Yoastの可読性分析ツールは、人間読者向けの分かりやすさ確保とAI最適化の両立を支援します。Semrushのコンテンツインテリジェンスプラットフォームは、AI Overviews等での引用状況を分析し、どのチャンクが引用を生んでいるかを可視化します。AmICited.comのネイティブチャンク分析ツールはCMSと連携し、パッセージ長の自動分析・最適化提案・各AIプラットフォームでの引用パフォーマンス追跡を自動化します。これらツールは、無料のオープンソースから高機能なエンタープライズまで幅広い選択肢があります。

最適なパッセージ長導入には、技術的最適化とコンテンツ品質の両立が必要です。以下のロードマップでAI引用効果を最大化しましょう:

この体系的アプローチで、60~90日以内に引用率の定量的改善が見込め、AI再インデックス進行に伴い更なる効果が期待できます。

パッセージレベル最適化の未来は、進化するAI能力と洗練された引用メカニズムによって形作られます。今後の主なトレンドとして:AIはページ単位からパッセージ単位での帰属へと進化し、精密なチャンク化の重要性が増します。文脈ウィンドウは拡大傾向(128,000トークン超モデルも登場)、最適チャンクサイズがやや大きくなる可能性もありますが、意味的境界の維持は引き続き重要です。マルチモーダルチャンク化も進行中で、画像・動画・テキスト混在コンテンツの新しい分割戦略が求められます。機械学習によるリアルタイムチャンク最適化も標準化し、クエリや検索実績に応じてサイズが自動調整されるでしょう。引用の透明性も競争優位性となり、AmICited.comのようなプラットフォームが、どのようにどこで引用されたかを可視化する流れを牽引しています。AIが進化するほど、パッセージ単位の引用最適化はコンテンツ制作者・発信者・知識組織のコア競争力となります。今チャンク化戦略を確立した組織こそ、AI主導の情報発見時代で引用価値を最大化できます。より良いチャンク化、モニタリングの高度化、AIシステムの進化――この三位一体の進展で、パッセージ最適化は単なる技術論を超え、コンテンツ戦略の本質的要件となるでしょう。

最適な範囲は100~500トークンで、通常は複雑さによって75~350語となります。小さめのチャンク(100~200トークン)は特定の質問に高精度で対応し、大きめのチャンク(300~500トークン)はより多くの文脈を保持します。最適な長さはコンテンツの種類やターゲットとなる埋め込みモデルによって異なります。

適切なサイズのパッセージは、AIシステムが完全な回答として抽出・提示しやすいため、引用される可能性が高くなります。長すぎるチャンクは切り捨てられたり一部だけ引用されたりし、短すぎるチャンクは正確な表現に必要な文脈が不足することがあります。

いいえ。一貫性も大切ですが、意味的な区切りの方が均一な長さより重要です。定義なら50語で十分な場合もありますが、手順の説明には250語必要なこともあります。各チャンクが独立して1つの質問に答えていることが重要です。

トークン数は埋め込みモデルやトークナイザーによって異なります。一般的に1トークン≒0.75単語ですが、これは変動します。正確なカウントには各埋め込みモデルのトークナイザーを使用しましょう。PineconeやLangChainのようなツールにはトークンカウント機能があります。

強調スニペットは通常40~60語の抜粋を抽出するため、アトミックチャンクと相性が良いです。構造化され焦点の定まったパッセージを作成することで、強調スニペットやAI生成の回答に選ばれる可能性が高まります。

主要なAIシステム(ChatGPT、Google AI Overviews、Perplexity)は類似したパッセージベースの検索メカニズムを採用しているため、100~500トークンの範囲が広く使えます。ただし、最適化にはターゲットAIで実際にテストすることをお勧めします。

はい、推奨されます。隣接するチャンク間に10~15%の重複を持たせることで、セクション境界付近の情報も取得しやすくなり、重要な文脈の損失を防げます。

AmICited.comはChatGPT、Google AI Overviews、Perplexityでブランドがどのように参照されているかを監視します。どのパッセージが引用され、どのように提示されているかを追跡することで、あなたのコンテンツや業界に最適なパッセージ長・構造を特定できます。

ChatGPT、Google AI Overviews、PerplexityでAIがあなたのコンテンツをどのように引用しているかを追跡できます。実際の引用データに基づいてパッセージ長を最適化しましょう。

ChatGPT、Perplexity、Google AIなどのAI検索エンジンに引用されるためのコンテンツ構造化方法を学びます。AIでの可視性と引用を高める専門家の戦略を紹介。...

ChatGPT、Perplexity、ClaudeなどのAIプラットフォーム向けにコンテンツをリパーパス・最適化する方法を学びましょう。AIへの可視性、コンテンツ構成、AI生成回答での引用獲得の戦略を紹介します。...

ChatGPT、Perplexity、Google AIによって引用されるための最適なコンテンツの深さ、構成、詳細要件を学びましょう。AI検索エンジンが引用に値するコンテンツに求める要素を発見できます。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.