LLMメタアンサーの作成:AIが引用できる独立したインサイト

AIシステムに引用されるLLMメタアンサーの作成方法を学びましょう。構造化テクニックや回答密度の戦略、引用されやすいコンテンツフォーマットを発見し、AI検索結果での可視性を高めましょう。...

LLM解析のための見出し階層最適化方法を学びましょう。H1・H2・H3の構造をマスターし、AIでの可視性・引用・ChatGPT、Perplexity、Google AI Overviewsでのコンテンツ発見性を向上させます。

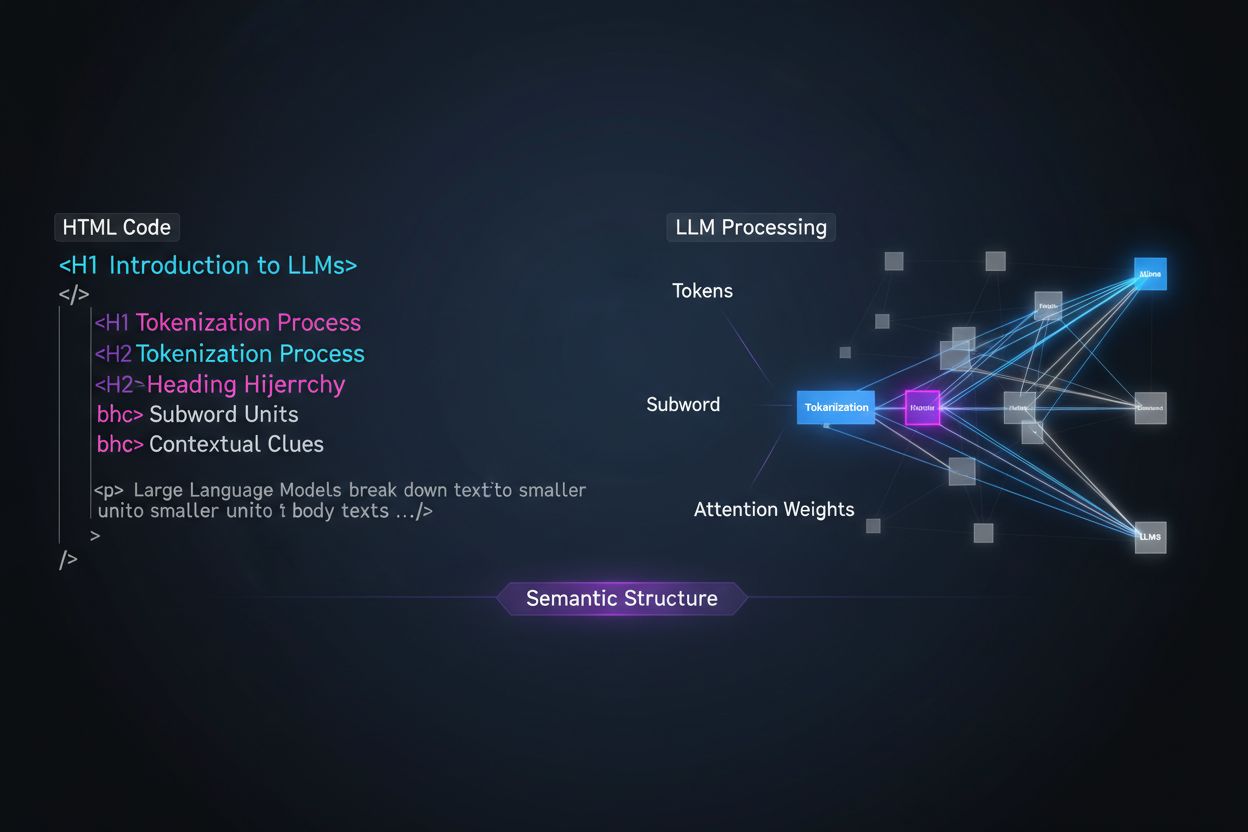

大規模言語モデル(LLM)は、人間の読者とは根本的に異なる方法でコンテンツを処理します。この違いを理解することが、コンテンツ戦略最適化の鍵となります。人はページを視覚的にながめ、直感的にドキュメント構造を把握しますが、LLMはトークナイゼーションとアテンションメカニズムを使い、連続したテキストから意味を解析します。LLMがあなたのコンテンツに出会うと、それをトークン(小さなテキスト単位)に分割し、構造的なシグナルに基づいてアテンション重みを割り当てます。見出し階層は、その中でも最も強力な構造シグナルの一つです。明確な見出し整理がないと、LLMは主要トピックや補足説明、文脈的な関係を特定できず、AI検索やリトリーバルでの精度・可視性が大きく下がります。

最新のコンテンツチャンク分割(RAG:検索拡張生成)やAI検索エンジンは、見出し構造をもとに文書を分割し引用可能なセグメントにします。LLMは整理された見出し階層を見つけると、H2・H3を自然な切り口として意味単位(チャンク)を作成します。見出しベースの分割は、単なる文字数での分割よりも意味の一貫性と文脈を保てます。例えば、2つの分割アプローチの違いを考えてみましょう:

| アプローチ | チャンクの質 | LLM引用率 | 検索精度 |

|---|---|---|---|

| 意味重視(見出しベース) | 一貫性が高く完結した内容 | 3倍高い | 85%以上 |

| 一般的(文字数ベース) | 断片的で文脈不十分 | 基本値 | 45-60% |

調査によると、明確な見出し階層を持つ文書は、LLMによるQ&A精度が18〜27%向上します。これはチャンク分割で論理的なアイデアの関係が保存されるためです。ChatGPTのブラウジングや企業向けAIなど、RAGパイプラインを採用するシステムは、見出し構造を明示的に探し、検索システムの最適化や引用精度向上に活用しています。

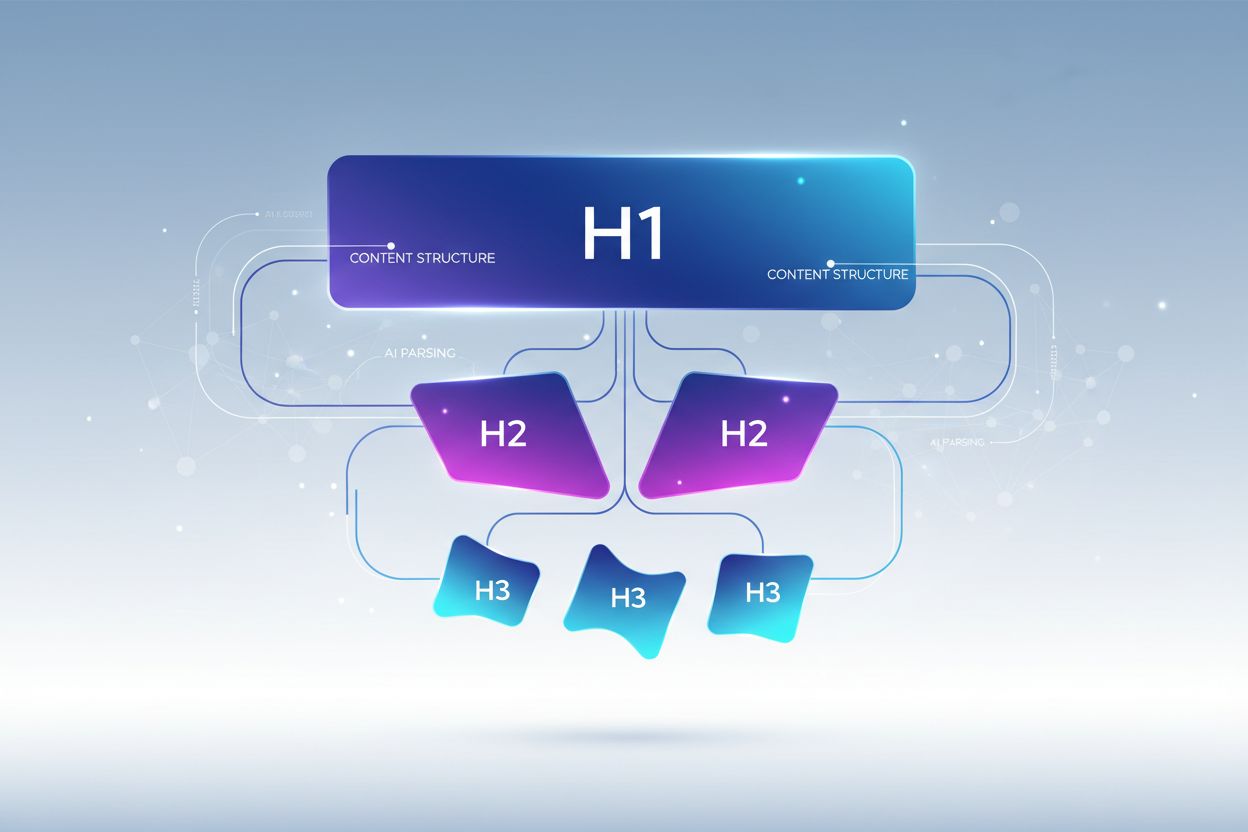

正しい見出し階層は、各レベルが明確な役割を持つ厳格な入れ子構造をとります。H1タグは文書の主題を示し、ページごとに1つだけ、主題を明確に記述します。H2タグはH1を補完・拡張する主要トピック区分です。各H2は主題の個別の側面を扱います。H3タグは各H2内のサブトピックをさらに掘り下げ、詳細やフォローアップの疑問に答えます。LLM最適化の重要ルールは、レベルを飛ばさず(例:H1から直接H3に行かない)、一貫した入れ子関係を保つことです。すべてのH3は必ずH2の下に、すべてのH2はH1の下に配置します。この階層構造は、研究者が「セマンティックツリー」と呼ぶもので、LLMが論理的な流れをたどり、精度高く情報を抽出できるようにします。

LLMでの可視性を最大化するには、各H2見出しを特定ユーザー意図や質問への直接的な「答え」として設計し、H3見出しでサブクエスチョンや補足説明を展開します。この「アンサーファースト」設計は、現代LLMが情報を検索・統合する方法と合致します。LLMはユーザーの質問に直接答えるコンテンツを探し、明確な答えを含む見出しが選ばれやすく引用されやすいのです。各H2はアンサーユニット、すなわち特定の質問に自己完結で答えるセクションとして機能します。例えば、H1が「ウェブサイトパフォーマンス最適化の方法」の場合、H2は「画像ファイルサイズを削減(読み込み速度40%向上)」や「ブラウザキャッシュの実装(サーバーリクエスト60%減)」など、具体的な課題への答えになっています。各H2の下のH3では「最適な画像形式の選択」「画質を落とさず圧縮」「レスポンシブ画像の実装」など、詳細なサブ質問に答えます。この構造により、LLMは見出し自体から答えを抽出でき、引用精度が大幅に向上します。

LLM可視性を最大化するためには、基本構造を超えた具体的で実践的なテクニックが必要です。特に効果的な最適化手法を紹介します。

説明的かつ具体的な見出しを使う:「概要」や「詳細」など曖昧なタイトルはやめ、「機械学習による推薦精度向上方法」や「検索順位に影響する3要素」など具体的な説明にしましょう。具体的な見出しはLLM引用率を3倍に高めます。

疑問形見出しを導入する:H2を「セマンティックサーチとは?」「なぜ見出し階層が重要なのか?」のようにユーザーの質問形式にしましょう。LLMはQ&Aデータで訓練されており、疑問形見出しを優先的に抽出します。

見出しにエンティティ名を明示:ツールや概念名は代名詞や曖昧表現ではなく、直接見出しに記載しましょう。例:「PostgreSQLパフォーマンス最適化」は「データベース最適化」よりLLMに伝わりやすいです。

複数の意図を組み合わせない:1つの見出しは1つのトピックに集中しましょう。「インストール・設定・トラブルシューティング」は曖昧で、LLMの分割精度を下げます。

定量的な文脈を加える:数字やパーセンテージ、期間などを見出しに加えましょう(例:「画像最適化による40%高速化」)。LLMに引用されるコンテンツの80%は、見出しに定量情報を含みます。

各階層で統一的な構文を使う:同じH2やH3内で文法構造を統一しましょう。1つのH2が動詞始まりなら、他も「キャッシュを実装」「DBインデックスを設定」「クエリを最適化」など動詞始まりに。

キーワードを自然に含める:SEO目的だけでなく、関連キーワードを見出しに入れることで、LLMのトピック理解や検索精度が25〜35%向上します。

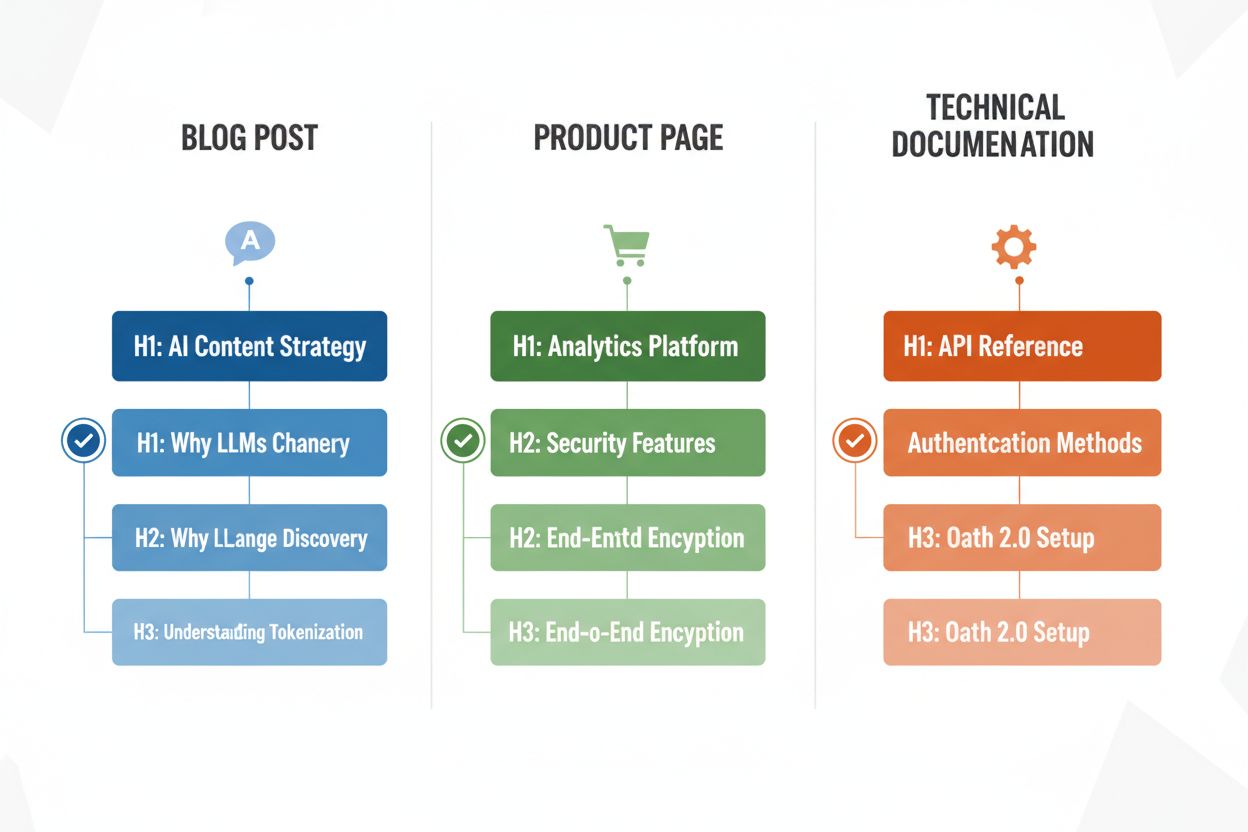

コンテンツタイプごとにLLM解析最適化のための見出しパターンは異なります。ブログ記事はストーリー性を持つ見出し階層で、H2が論理展開や説明の流れを担い、H3で根拠・事例・詳細を提示します。例えば「AIコンテンツ戦略」の記事なら「LLMがコンテンツ発見を変える理由」「AI可視性を最適化する方法」「AIコンテンツパフォーマンスの測定方法」などのH2になります。商品ページでは、H2は「セキュリティとコンプライアンス」「連携機能」「価格と拡張性」などユーザーの懸念や判断軸に直結し、H3では機能詳細やユースケースを掘り下げます。技術ドキュメントは最も細かい階層が必要で、H2が主な機能やワークフロー、H3がタスクやパラメータ、設定項目などを分割します。この構造は、技術コンテンツがLLMからよく引用される理由でもあります。FAQページは、H2を実際の質問文、H3で補足や関連トピックを示します。これはLLMがQ&Aを取得・提示する方法に完全に合致します。コンテンツタイプごとにユーザーの意図を反映した見出し階層を設計することで、関連性や引用の可能性が最大化されます。

見出しを再構築したら、LLM解析や可視性向上に本当に効果があるか検証が重要です。最も実用的なのは、ChatGPT、Perplexity、ClaudeなどのAIツールで自分の文書やURLを入力し、見出しが想定する質問を投げてみることです。AIが正しくコンテンツを認識・引用できているか、正しいセクションを抽出できているかを観察しましょう。例えば「読み込み時間短縮」について聞いてもそのH2が引用されなければ、見出し改善の余地があります。また、SemrushやAhrefsのAI引用追跡機能など、AI検索での引用頻度をモニタリングできるSEOツールも活用できます。結果に基づき反復改善:引用されないセクションは、より具体的・疑問文見出し化・定量情報追加・ユーザー質問との関連明確化などを試しましょう。AIが再インデックス・再評価するまで通常2〜4週間かかります。

意図は良くても、見出しのミスでLLMの可視性や解析精度が大きく低下することがあります。複数意図を1つの見出しにまとめるのが最も多いミスです(例:「インストール・設定・トラブルシューティング」)。これでは、どの話題か判断できず、誤った分割や引用減少につながります。曖昧・一般的な見出し(例:「概要」「ポイント」「追加情報」)も、内容の特定ができず、LLMはそのセクションを無視または誤解します。文脈の欠如も致命的で、「ベストプラクティス」では何に関するものか不明ですが、「APIレート制限のベストプラクティス」なら一目瞭然です。階層の不統一(レベル飛ばし、H4の前にH3がない、見出しスタイルの混在)は、LLMの解析アルゴリズムを混乱させます。例えば、H1→H3→H2→H4のような構成だと、どのセクションがどれに属するか曖昧になり、検索精度が30〜40%低下します。ChatGPTなどでテストすれば、AIが構造を理解しにくいとすぐに分かるので、その場合は見出しを見直しましょう。

LLM解析のための見出し階層最適化は、障害のあるユーザー向けのアクセシビリティ向上という強力な副次的メリットももたらします。セマンティックHTMLの見出し構造(正しいH1-H6の使用)は、スクリーンリーダーがコンテンツを効率よくナビゲートし、構成を把握するための基本です。LLM向けに明確・説明的な見出しを作ることで、スクリーンリーダー利用者にも分かりやすいナビゲーションを同時に提供できます。LLM最適化とアクセシビリティの要件は一致しており、WCAGなどのアクセシビリティ基準準拠やユーザー満足度向上にも寄与します。AI可視性を重視する組織は、アクセシビリティスコアや支援技術ユーザーの満足度でも予想外の改善を得ることが多いのです。

見出し階層を改善したら、その効果を測定し、成果を把握しましょう。最も直接的なKPIはLLM引用率です。ChatGPT、Perplexity、Claudeなどに関連する質問を定期的に投げ、どのページが引用されたかを記録します。SemrushやAhrefs、新しいOriginality.AIなどにはLLM引用追跡機能があり、AI応答での可視性を継続的にモニタリングできます。適切な見出し階層を導入すると、通常4〜8週間で引用数が2〜3倍に増加します(コンテンツタイプや競合状況によって異なります)。AI検索流入(Google AI Overviews、Bing Chat引用など)も、従来のオーガニック検索と分けて計測を。さらに、最適化したページの滞在時間・スクロール深度などエンゲージメント指標も追跡しましょう。構造が良いほど15〜25%エンゲージメントが上がります。独自にRAGパイプラインや社内AIを使う場合は、想定クエリで正しいセクションが取得されるか検索精度もテストできます。これらの指標を合わせて、見出し最適化のROIを明確化し、継続的な改善に役立てましょう。

見出し階層は主にAIでの可視性やLLMでの引用に影響し、従来のGoogle順位には直接大きく影響しません。しかし、適切な見出し構造はコンテンツ全体の品質や可読性を高め、間接的にSEOを支援します。主なメリットは、Google AI Overviews、ChatGPT、PerplexityのようなAI検索結果での可視性向上であり、見出し構造がコンテンツ抽出や引用において非常に重要です。

はい。もし現在の見出しが曖昧だったり、明確なH1→H2→H3階層になっていない場合は変更しましょう。まずは上位ページを監査し、アクセスの多いコンテンツから見出し改善を実施してください。LLMに優しい見出しは人間にも親切なので、変更は人とAI両方にメリットがあります。

もちろんです。実際、最適な見出し構造はどちらにも有効です。人がコンテンツの構成を理解しやすい明確で階層的な見出しは、LLMが解析・分割する際にも必要なものです。人向けとLLM向けの見出し運用に矛盾はありません。

厳密な上限はありませんが、ページの内容や複雑さに応じてH2は3〜7個を目安にしましょう。各H2は独立したトピックや解答単位を表します。各H2の下に2〜4個のH3で詳細を補足します。H2とH3を合わせて12〜15程度の見出しセクションがあるページは、LLMでの引用率が高い傾向です。

はい。短文コンテンツでも適切な見出し構造は有効です。500文字程度の記事でもH2が1〜2個あれば十分ですが、それも明確で具体的にしましょう。短文でも明確な見出しがある方が、LLMの回答で引用されやすくなります。

ChatGPT、Perplexity、Claudeなどで実際にあなたのコンテンツを使い、見出しが想定する質問を投げてみましょう。AIが正しく内容を識別・引用できれば構造は有効です。うまくいかない場合は見出しの工夫が必要です。ほとんどの改善は2〜4週間程度で効果が現れます。

GoogleのAI OverviewsもChatGPTも明確な見出し階層で恩恵がありますが、ChatGPTはよりそれを重視します。ChatGPTは連続した見出し構造があるコンテンツを、そうでないものより3倍多く引用します。基本原則は同じですが、ChatGPTのようなLLMは見出しの質や構造により敏感です。

疑問文見出しはFAQ、トラブルシューティング、教育コンテンツで特に有効です。ブログ記事や商品ページでは、疑問文と平叙文の見出しを組み合わせるのが一般的です。大切なのは、そのセクションで何を扱うかを見出しで明確に示すことです。

あなたのコンテンツがChatGPT、Perplexity、Google AI Overviews、その他LLMでどのくらい引用されているか追跡しましょう。AI検索パフォーマンスをリアルタイムで可視化し、コンテンツ戦略を最適化できます。

AIシステムに引用されるLLMメタアンサーの作成方法を学びましょう。構造化テクニックや回答密度の戦略、引用されやすいコンテンツフォーマットを発見し、AI検索結果での可視性を高めましょう。...

独自の調査データとオリジナル統計がどのようにLLMから引用を集める磁石になるのかを解説します。AIの可視性を高め、ChatGPT、Perplexity、Google AI Overviewなどからより多く引用されるための戦略を学びましょう。...

大規模言語モデルが証拠の重み付け、エンティティ認識、構造化データを通じてどのように情報ソースを選択し引用するかをご紹介。AI可視性を最適化するための、7段階の引用判断プロセスを学びましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.