ファインチューニング

ファインチューニングの定義:事前学習済みAIモデルを、ドメイン固有の学習を通じて特定タスク向けに適応させる手法。ファインチューニングがモデル性能を向上させ、エンタープライズ用途のAIカスタマイズを可能にする方法を解説します。...

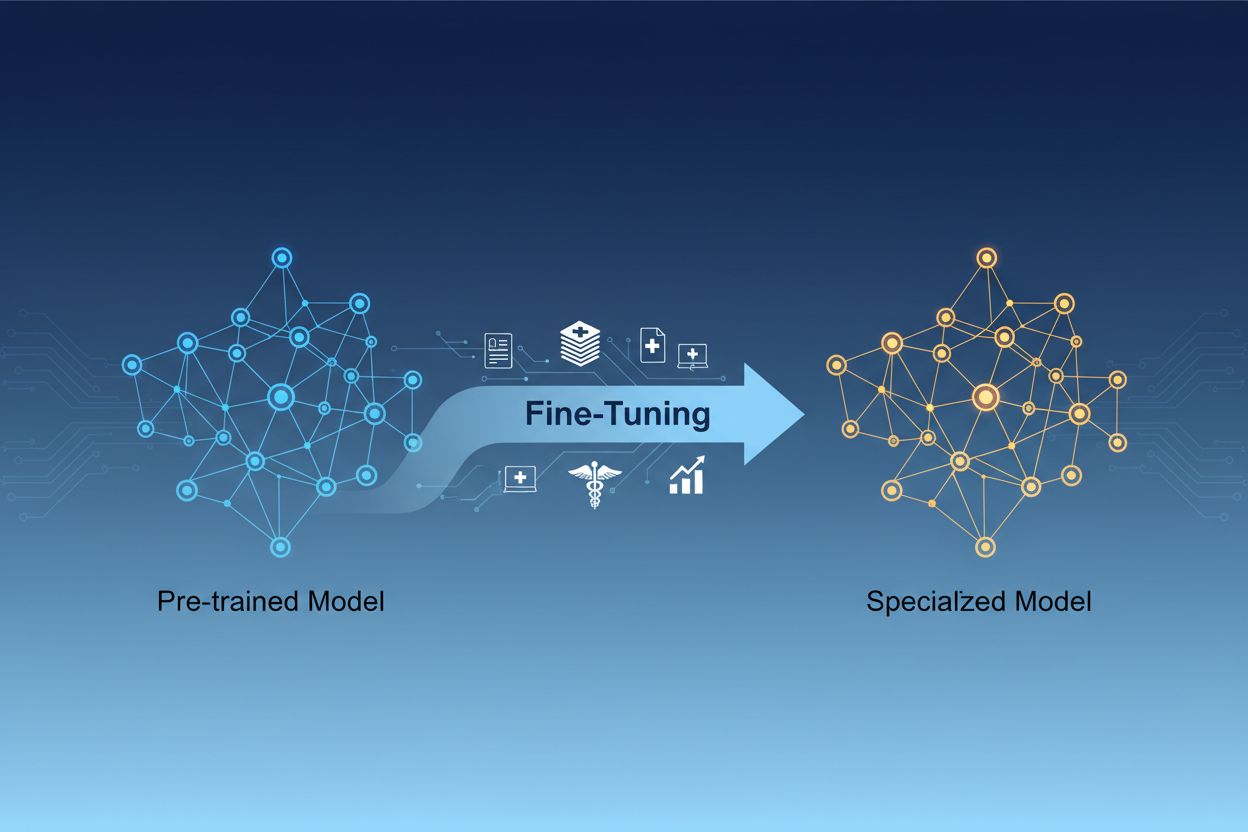

AIモデルのファインチューニングとは、事前学習済みの人工知能モデルを、特定のタスクや専門的なデータに適応させるために、パラメータを追加学習で調整するプロセスです。この手法は、既存の基礎的な知識を活用しつつ、ビジネス固有の用途に合わせてモデルをカスタマイズできるため、ゼロからモデルを学習させる際の膨大な計算コストをかけずに、高度に専門化されたAIシステムを構築できます。

AIモデルのファインチューニングとは、事前学習済みの人工知能モデルを、特定のタスクや専門的なデータに適応させるために、パラメータを追加学習で調整するプロセスです。この手法は、既存の基礎的な知識を活用しつつ、ビジネス固有の用途に合わせてモデルをカスタマイズできるため、ゼロからモデルを学習させる際の膨大な計算コストをかけずに、高度に専門化されたAIシステムを構築できます。

AIモデルのファインチューニングとは、事前学習済みの人工知能モデルを特定のタスクや専門的なデータでさらに調整し、適応させるプロセスです。モデルをゼロから学習させるのではなく、既に基礎的な知識を持つ事前学習済みモデルを活用し、業界やタスク固有のデータセットで追加学習することでパラメータを調整します。この手法は、転移学習の効率性とビジネス用途に必要なカスタマイズ性を両立します。ファインチューニングを使えば、膨大な計算コストや時間をかけずに、高度に専門化されたAIモデルを構築できるため、現代の機械学習開発に不可欠な技術となっています。

ファインチューニングとゼロからの学習の違いは、機械学習開発における最も重要な意思決定の一つです。ゼロから学習する場合、モデルの重みはランダムに初期化され、言語パターンや画像特徴、専門知識など全てを膨大なデータセットと大規模な計算リソースによって一から学習する必要があります。この方法には数週間から数か月の学習期間や、GPUやTPUなどの専用ハードウェアが必要となる場合があります。一方、ファインチューニングは、基本的なパターンや概念を既に理解したモデルを活用し、少量のデータと比較的少ない計算資源で自分の用途に適応させられます。事前学習済みモデルは初期学習段階で一般的な特徴を獲得しているため、ファインチューニングではそれらを自分のユースケースに合わせて微調整します。この効率性により、ファインチューニングは多くの組織で採用され、タイムトゥマーケット短縮やインフラコスト削減を実現しつつ、ゼロからの小型モデル学習より高い性能が得られる場合もあります。

| 項目 | ファインチューニング | ゼロからの学習 |

|---|---|---|

| 学習時間 | 数日~数週間 | 数週間~数か月 |

| データ要件 | 数千~数百万例 | 数百万~数十億例 |

| 計算コスト | 中程度(GPU 1枚で十分なことも) | 非常に高い(複数GPU/TPU必須) |

| 初期知識 | 事前学習済み重みを活用 | ランダム初期化から開始 |

| 性能 | 少量データでも高性能 | 大規模データセットで優位 |

| 必要知識レベル | 中級者向け | 上級者向け |

| カスタマイズ度 | タスク特化で高い | 最大限の柔軟性 |

| インフラ要件 | 標準クラウド資源 | 専用ハードウェアが必要 |

ファインチューニングは、競争優位性のあるAIソリューションを導入したい組織にとって不可欠な能力となっています。事前学習済みモデルを自社の事業環境に合わせて調整することで、業界用語や顧客の好み、運用要件を高精度で理解するAIシステムを構築できます。これは、汎用モデルでは実現できない精度や業務適合性を可能にし、特に医療・法務・技術サポートなどの専門分野でその効果を発揮します。ファインチューニングはコスト効率が高く、今や中小企業でも大規模インフラなしにエンタープライズ級AIを活用できるようになりました。さらに、ファインチューニング済みモデルは迅速に展開可能で、市場機会や競争圧力への素早い対応を実現します。新規データによる継続的なファインチューニングで、AIシステムの有効性と適合性を維持できるのも大きな利点です。

ビジネスにおける主なメリット:

ファインチューニング分野では用途に応じて様々な手法が確立されています。フルファインチューニングは全パラメータを更新するため柔軟性と性能に優れますが、過学習防止には大規模データと計算資源が必要です。パラメータ効率型ファインチューニング(例:LoRAやQLoRA)はごく一部のパラメータのみを学習してモデルを効果的に適応させ、メモリ消費と学習時間を劇的に削減します。この手法は重み行列に低ランク行列を追加してタスク固有の適応を実現し、元の重みは変更しません。アダプターモジュールは事前学習済みモデルの各層間に小型ネットワークを挿入し、パラメータ追加を最小限に抑えて効率的なチューニングを可能にします。プロンプトベースのファインチューニングはモデルの重みではなく入力プロンプトを最適化するもので、パラメータアクセスが制限された場合に有効です。インストラクションファインチューニングは、特定の指示やコマンドに従わせる訓練で、大規模言語モデルを多様なリクエストに適切に対応させたい場合に重要です。どの手法を選ぶかは、計算リソース・データ量・性能要件・モデル構造などに応じて決定されます。

大規模言語モデル(LLM)のファインチューニングは、小規模モデルや他のニューラルネットワークのファインチューニングとは異なる機会と課題があります。GPT系など現代のLLMは数十億のパラメータを持つため、フルファインチューニングは多くの組織にとって現実的ではありません。このため、少量のパラメータだけを更新する効率的な手法が主流となっています。インストラクションファインチューニングはLLMで特に重要で、指示と高品質な応答のペアを学習させることで指示追従性を高めます。**RLHF(人間フィードバックによる強化学習)**は、人間の好みや評価に基づいてモデルをさらに微調整し、人間的な価値観や期待に沿った応答を実現する高度な手法です。LLMのファインチューニングは、数百~数千例のタスク固有データで十分な場合が多く、大規模なラベル付きデータがなくても適用可能です。ただし、ハイパーパラメータの選定・学習率スケジューリング・「破滅的忘却」(新タスク適応時に既習能力を失う現象)防止など、細心の注意が必要です。

多くの業界で、ファインチューニングしたAIモデルが大きなビジネス価値を生み出しています。カスタマーサービス自動化は代表的な用途で、サポートチケットや製品情報、コミュニケーションスタイルなど自社固有データで学習したチャットボットは、専門性とブランド一貫性を持つ対応が可能です。医療・法務文書解析では、一般的な言語モデルを専門用語や規制要件、業界フォーマットに適応させ、正確な情報抽出・分類を実現します。感情分析やコンテンツモデレーションも、業界やコミュニティ特有のデータでファインチューニングすることで、ニュアンスや文脈をより正確に把握できます。コード生成・開発支援は、自社のコードベースやプログラミング規約、アーキテクチャパターンで学習したAIが標準に即したコードを生成しやすくなります。レコメンデーションシステムは、ユーザー行動データや商品カタログでファインチューニングすることで、個別化された提案を実現し、エンゲージメントや収益向上に貢献します。固有表現抽出・情報抽出も、財務報告や学術論文、技術仕様書など専門ドキュメントで学習することで大幅な精度向上が期待できます。このように、ファインチューニングは特定業界や用途に限定されず、ほぼすべてのビジネス領域で競争優位となるAIシステム構築の基盤技術です。

ファインチューニングは、準備から運用・監視まで一連の流れで進めます。データ準備が最重要工程であり、タスクに合致した高品質なドメインデータを収集・整形し、モデルが期待する入力・出力フォーマットに合わせる必要があります。データは本番運用時のタスクを代表する内容であるべきで、量より質が重要です。学習・検証・テスト分割は、モデル性能を適切に評価するため、一般的に学習70~80%、検証10~15%、テスト10~15%で行います。ハイパーパラメータ選定では、学習率やバッチサイズ、エポック数などが学習効率と最終性能に大きく影響します。モデル初期化は事前学習済み重みを使い、基礎知識を維持しつつタスクに応じて調整します。学習実行は、トレーニングデータでパラメータを反復更新しながら、検証性能を監視して過学習を防ぎます。評価と反復はテストセットで最終性能を測定し、必要に応じてハイパーパラメータ変更や追加学習データで再ファインチューニングします。運用準備では推論速度やリソース効率化のための量子化・蒸留なども検討します。最後に、運用監視・保守でデータ分布変化による性能劣化を検知し、新データで定期的に再学習して精度を維持します。

ファインチューニングはゼロからの学習より効率的ですが、独自の課題にも注意が必要です。過学習は、小規模データで学習時にモデルがパターンを一般化せず暗記してしまう現象であり、早期終了や正則化、データ拡張で対策します。破滅的忘却は、ファインチューニングで既存の能力が失われる問題で、学習率調整や知識蒸留により基礎知識を維持できます。データ品質・ラベリングも実務上の大きな課題で、ターゲットドメインに即した高品質なラベル付き例が求められます。計算リソース管理は、性能向上と学習コストのバランスが重要で、大規模モデルほど慎重な設計が必要です。ハイパーパラメータ感度にも注意し、学習率やバッチサイズなどの設定で結果が大きく変わるため、系統的な検証が不可欠です。

成功するファインチューニングのためのベストプラクティス:

組織がAIモデルをタスク適応させる際、ファインチューニング・RAG(検索拡張生成)・プロンプトエンジニアリングという3つのアプローチから選択・組み合わせることが一般的です。プロンプトエンジニアリングは、モデル自体を変更せず指示や例を工夫して振る舞いを誘導する方法で、素早い検証が可能ですが、複雑なタスクや新知識習得には限界があります。RAGは、外部の文書やデータを検索してから回答を生成させるため、モデルをアップデートせずに最新・専門知識を活用でき、ナレッジ集約型タスクに有効ですが推論時の遅延や複雑さが増します。ファインチューニングはパラメータ自体を更新し、タスク固有の知識やパターンを深く埋め込むため、十分なデータとリソースがある場合に最高の性能を発揮しますが、他の手法より学習コストがかかります。最適なソリューションは、プロンプトエンジニアリングで迅速に試作し、RAGで知識依存アプリケーションを構築し、パフォーマンス最重視のシステムにはファインチューニングを適用するなど、これらを組み合わせることです。ファインチューニングは、特定タスクにおいて一貫した高性能が求められ、十分な学習データと投資価値がある場合に最適です。RAGは最新または頻繁に変わる情報が必要な用途に最適となります。プロンプトエンジニアリングは、リソースをかけずに探索・試作したい初期段階に最適です。各アプローチの強みと弱みを理解することで、用途ごとに最適な手法選択が可能になります。

転移学習は、あるタスクで得られた知識を別のタスクの性能向上に活用するという広義の概念であり、ファインチューニングは転移学習の具体的な手法の一つです。ファインチューニングは、事前学習済みモデルのパラメータを新しいデータで調整しますが、転移学習には事前学習済みの重みを固定し新しい層だけ学習する特徴抽出も含まれます。すべてのファインチューニングは転移学習ですが、すべての転移学習がファインチューニングを必要とするわけではありません。

ファインチューニングにかかる時間は、モデルの規模、データセットの大きさ、利用可能なハードウェアによって大きく異なります。LoRAのようなパラメータ効率の高い手法を使えば、130億パラメータのモデルでもA100 GPU 1枚で約5時間でファインチューニングが可能です。小規模モデルや効率的な手法なら数時間で済みますが、大規模モデルのフルファインチューニングでは数日から数週間かかる場合もあります。最大の利点は、ファインチューニングはゼロからの学習よりも圧倒的に速く、ゼロからの学習は数か月かかることもある点です。

はい、ファインチューニングは特に限られたデータ量でも効果的に機能するよう設計されています。事前学習済みモデルはすでに一般的なパターンを学習済みなので、ゼロから学習する場合に必要な何百万件ものデータではなく、通常は数百~数千件の例で十分です。ただし、データの質は量よりも重要です。不均一またはノイズの多いラベルが含まれる大規模データセットよりも、高品質で代表的な小規模データセットの方が良好な結果をもたらします。

LoRA(Low-Rank Adaptation)は、モデルの重み行列にトレーニング可能な低ランク行列を追加し、すべてのパラメータを更新する代わりにごく一部のみを調整する、パラメータ効率の高いファインチューニング手法です。このアプローチにより、学習すべきパラメータが数千分の一に減少し、フルファインチューニングと同等の性能を維持できます。LoRAは、標準的なハードウェアでもファインチューニングを可能にし、メモリ要件を大幅に削減し、高価なインフラなしで大規模モデルの調整を実現できるため、非常に重要です。

過学習は、トレーニング損失が減少しているのに検証損失が増加し始めることで起こり、これはモデルがトレーニングデータを暗記し一般化できていないことを示します。トレーニング中は両方の指標を監視しましょう。もし検証性能が頭打ちまたは悪化しているのにトレーニング性能だけが向上し続けている場合、過学習の可能性が高いです。検証性能が向上しなくなったら早期終了を実施し、正則化やデータ拡張などの手法で過学習を防止しましょう。

ファインチューニングのコストには、計算リソース(GPU/TPU時間)、データ準備やラベリング、モデルの保存・運用インフラ、継続的な監視・保守が含まれます。ただし、これらのコストはゼロからの学習と比べて10~100分の1程度です。LoRAのような効率的な手法を使うことで、フルファインチューニングと比べて計算コストを80~90%削減できるため、多くの組織にとって経済的なアプローチとなります。

はい、ファインチューニングにより特定タスクでのモデル精度が大幅に向上するのが一般的です。業界固有のデータで学習することで、汎用モデルでは見落とされがちなパターンや専門用語をモデルが習得できます。研究によると、ファインチューニングで10~30%以上精度が向上する例もあり、特にファインチューニングするタスクが事前学習タスクと異なる場合はその効果が顕著です。

ファインチューニングによって、機密データを自社インフラ内にとどめ、サードパーティAPIに送信せずに済むようになります。事前学習済みモデルを、自社や規制データ上でローカルにファインチューニングできるため、GDPRやHIPAAなどのデータ保護規則や業界規制にも対応可能です。この方法により、プリトレインドモデルのパフォーマンスを維持しながら、セキュリティとコンプライアンスの両方のメリットが得られます。

GPTs、Perplexity、Google AI OverviewsなどのAIシステムが、あなたのブランドをどのように引用・参照しているかをAmICitedのAIモニタリングプラットフォームで追跡しましょう。

ファインチューニングの定義:事前学習済みAIモデルを、ドメイン固有の学習を通じて特定タスク向けに適応させる手法。ファインチューニングがモデル性能を向上させ、エンタープライズ用途のAIカスタマイズを可能にする方法を解説します。...

AIフィーチャードスニペットとAI生成回答のためにコンテンツを最適化する方法を学びましょう。ChatGPT、Perplexity、Google AI Overviews、その他のAI検索エンジンで可視性を高める戦略を紹介します。...

AIモデルがトークン化、埋め込み、トランスフォーマーブロック、ニューラルネットワークを通じてテキストをどのように処理するかを学びます。入力から出力までの完全なパイプラインを理解しましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.