AI検索テックスタックを構築するために必要なコンポーネントは何ですか?

現代のAI検索テックスタックを構築するために必要な主要コンポーネント、フレームワーク、ツールについて学びましょう。検索システム、ベクトルデータベース、埋め込みモデル、デプロイ戦略を紹介します。...

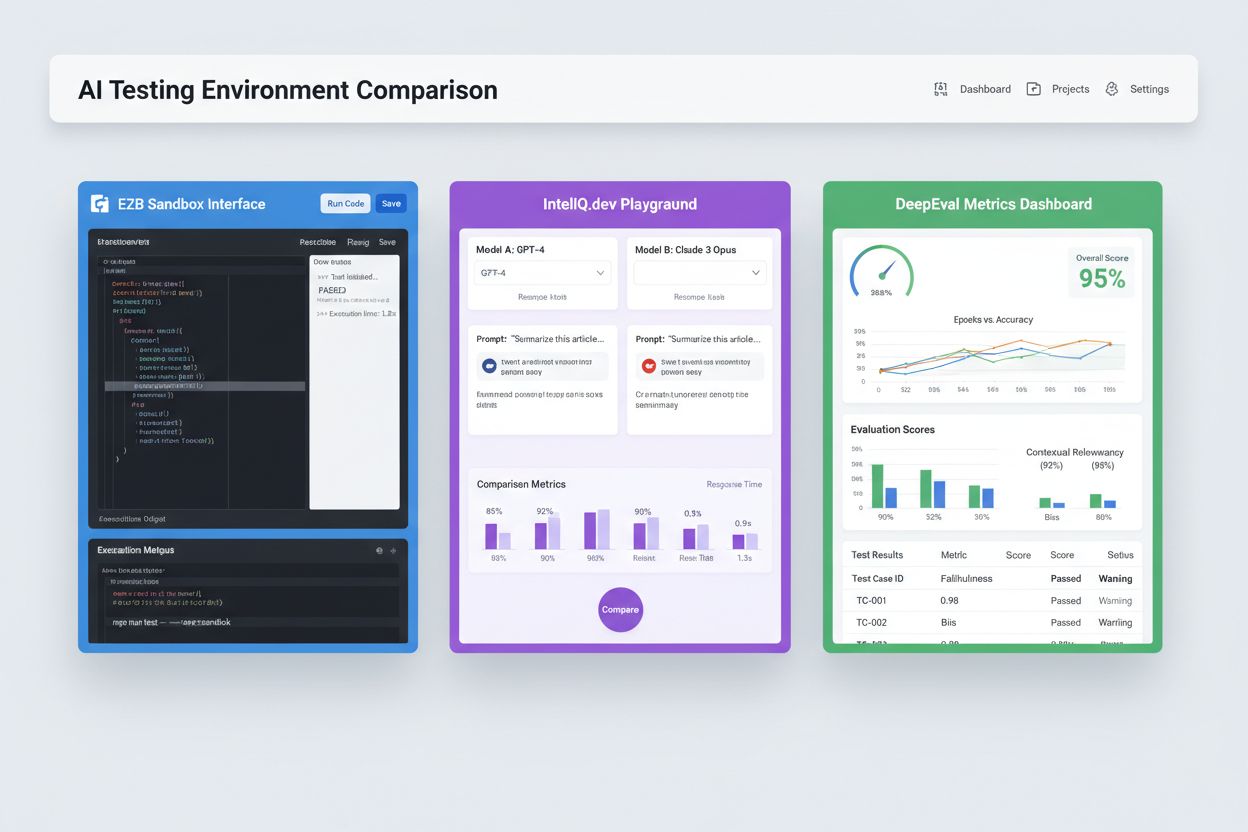

本番展開前に人工知能モデルやアプリケーションを検証、評価、デバッグするために設計された隔離型サンドボックス環境。これらの制御された空間により、AIコンテンツのパフォーマンスをさまざまなプラットフォームでテストし、指標を測定し、ライブシステムや機密データを損なうことなく信頼性を確保できます。

本番展開前に人工知能モデルやアプリケーションを検証、評価、デバッグするために設計された隔離型サンドボックス環境。これらの制御された空間により、AIコンテンツのパフォーマンスをさまざまなプラットフォームでテストし、指標を測定し、ライブシステムや機密データを損なうことなく信頼性を確保できます。

AIテスト環境とは、本番システムへの展開前に人工知能モデルやアプリケーションを検証・評価・デバッグするために設計された、制御された隔離型の計算空間です。開発者、データサイエンティスト、QAチームが安全にAIモデルを実行し、様々な設定のテストや、事前に定義された指標によるパフォーマンス測定をライブシステムや機密データに影響を与えることなく行えます。これらの環境は本番環境を再現しつつ完全隔離を維持し、問題の特定、モデル挙動の最適化、さまざまなシナリオでの信頼性確保を可能にします。テスト環境はAI開発ライフサイクルにおける重要な品質ゲートとして、試作段階とエンタープライズ展開の橋渡しをします。

総合的なAIテスト環境は、完全なテスト機能を提供するために連携する複数の技術レイヤーから成り立ちます。モデル実行レイヤーは実際の推論や計算を担い、PyTorch、TensorFlow、ONNXなど複数フレームワークや(LLM、画像認識、時系列など)多様なモデルタイプをサポートします。データ管理レイヤーはテストデータセット、フィクスチャ、合成データ生成を管理し、データ隔離やコンプライアンスも維持します。評価フレームワークには、モデル出力を期待結果と照合するメトリクスエンジン、アサーションライブラリ、スコアリングシステムが含まれます。モニタリング&ロギングレイヤーは、実行トレースやパフォーマンス指標、レイテンシデータ、エラーログを収集し、テスト後分析を支援します。オーケストレーションレイヤーは、テストワークフロー、並列実行、リソース割り当て、環境プロビジョニングを管理します。下記は、テスト環境タイプ別の主要アーキテクチャ要素の比較表です。

| コンポーネント | LLMテスト | 画像認識 | 時系列 | マルチモーダル |

|---|---|---|---|---|

| モデル実行 | トランスフォーマ推論 | GPU加速推論 | 時系列処理 | ハイブリッド実行 |

| データ形式 | テキスト/トークン | 画像/テンソル | 数値系列 | 複合メディア |

| 評価指標 | 意味的類似度、幻覚検出 | 精度、IoU、F1スコア | RMSE、MAE、MAPE | クロスモーダル整合 |

| レイテンシ要件 | 100-500ms程度 | 50-200ms程度 | <100ms程度 | 200-1000ms程度 |

| 隔離方式 | コンテナ/VM | コンテナ/VM | コンテナ/VM | FirecrackerマイクロVM |

現代のAIテスト環境は、異種のモデルエコシステムに対応し、異なるLLMプロバイダー、フレームワーク、デプロイ先をまたいだアプリケーション評価を可能にしなければなりません。マルチプラットフォームテストにより、OpenAIのGPT-4、AnthropicのClaude、Mistral、LlamaなどOSS代替を同一テストハーネス内で比較でき、モデル選定の意思決定を支援します。E2Bのようなプラットフォームは、各種LLMが生成したコードをPython、JavaScript、Ruby、C++で実行できる隔離サンドボックスを提供し、ファイルシステムやターミナル、パッケージインストールもサポートします。IntelIQ.devは、複数AIモデルの並列比較と統一インターフェイスで、ガードレール付きプロンプトやポリシー対応テンプレートの異なるプロバイダー間テストを実現します。テスト環境は以下を扱う必要があります:

AIテスト環境は、開発・品質保証・コンプライアンスなど多様な組織ニーズに応えます。開発チームは、反復開発中のモデル挙動検証、プロンプト変更やパラメータ調整、統合前のバグ修正に活用します。データサイエンスチームは、ホールドアウトデータセットでのモデル性能評価、アーキテクチャ比較、精度・適合率・再現率・F1スコアなどの計測に利用します。本番モニタリングでは、展開済みモデルをベースライン指標と継続的に比較し、品質低下や再学習パイプラインのトリガーを検知します。コンプライアンス・セキュリティチームは、モデルが規制要件を満たしているか、不適切な出力を出さないか、機密データを正しく扱うかの検証に活用します。エンタープライズ用途例:

AIテスト分野には、用途や組織規模ごとに特化したプラットフォームが存在します。DeepEvalはオープンソースのLLM評価フレームワークで、回答正確性・意味的類似度・幻覚検出・毒性スコアなど50以上の研究指標を提供し、CI/CD向けPytest統合も特長です。LangSmith(LangChain提供)は、LLMアプリのトレーシング、プロンプトバージョン管理、データセット管理を備えた観測・評価・デプロイメント基盤です。E2BはFirecrackerマイクロVMによるセキュアな隔離サンドボックスを提供し、200ms未満の起動速度、最大24時間セッション、主要LLM各社との連携を実現します。IntelIQ.devはエンドツーエンド暗号化、ロールベースアクセス制御、GPT-4やClaude、OSSモデル対応などプライバシー重視のテストを特色とします。主な機能比較表:

| ツール | 主な用途 | 指標 | CI/CD連携 | マルチモデル対応 | 料金体系 |

|---|---|---|---|---|---|

| DeepEval | LLM評価 | 50以上の指標 | Pytestネイティブ | 限定的 | OSS+クラウド |

| LangSmith | 観測・評価 | カスタム指標 | APIベース | LangChainエコシステム | フリーミアム+企業向け |

| E2B | コード実行 | パフォーマンス指標 | GitHub Actions | すべてのLLM | 従量課金+企業向け |

| IntelIQ.dev | プライバシー重視テスト | カスタム指標 | ワークフロー構築 | GPT-4、Claude、Mistral | サブスクリプション制 |

エンタープライズAIテスト環境では、機密データ保護、規制対応、権限外利用防止のため厳格なセキュリティ対策が必須です。データ隔離では、テストデータを外部APIや第三者サービスに漏洩させないことが求められ、E2BのようなプラットフォームはFirecrackerマイクロVMでカーネル非共有の完全なプロセス隔離を実現します。暗号化標準は保存・転送両方でのエンドツーエンド暗号化、およびHIPAA、SOC 2 Type 2、GDPR準拠サポートが必要です。アクセス制御はロールベース権限・監査ログ・承認ワークフローなどを強制します。ベストプラクティスとして、本番データを含まない専用テストデータセット維持、個人情報(PII)のデータマスキング、現実的かつ安全な合成データ生成、テストインフラの定期的なセキュリティ監査、全テスト結果の記録・文書化が推奨されます。また、バイアス検出による差別的挙動の特定、SHAPやLIMEなど解釈性ツールの活用、判断ログでモデル出力根拠の追跡を行い、規制対応の責任所在を明確にする必要があります。

AIテスト環境は、既存の継続的インテグレーション(CI)や継続的デプロイメント(CD)パイプラインとシームレスに統合され、自動品質ゲートや迅速な反復開発を実現する必要があります。ネイティブCI/CD連携により、コードコミット・プルリクエスト・スケジュール実行時にGitHub Actions、GitLab CI、Jenkins等で自動テストが走ります。DeepEvalのPytest統合で、開発者は標準Pythonテストとしてテストケースを記述でき、結果は従来のユニットテスト同様にレポートされます。自動評価で、モデルパフォーマンス指標の測定やベースライン比較、品質基準未達時のデプロイブロックが可能です。アーティファクト管理では、テストデータセットやモデルチェックポイント、評価結果をバージョン管理や成果物リポジトリに保存し、再現性や監査証跡を確保します。主な統合パターン:

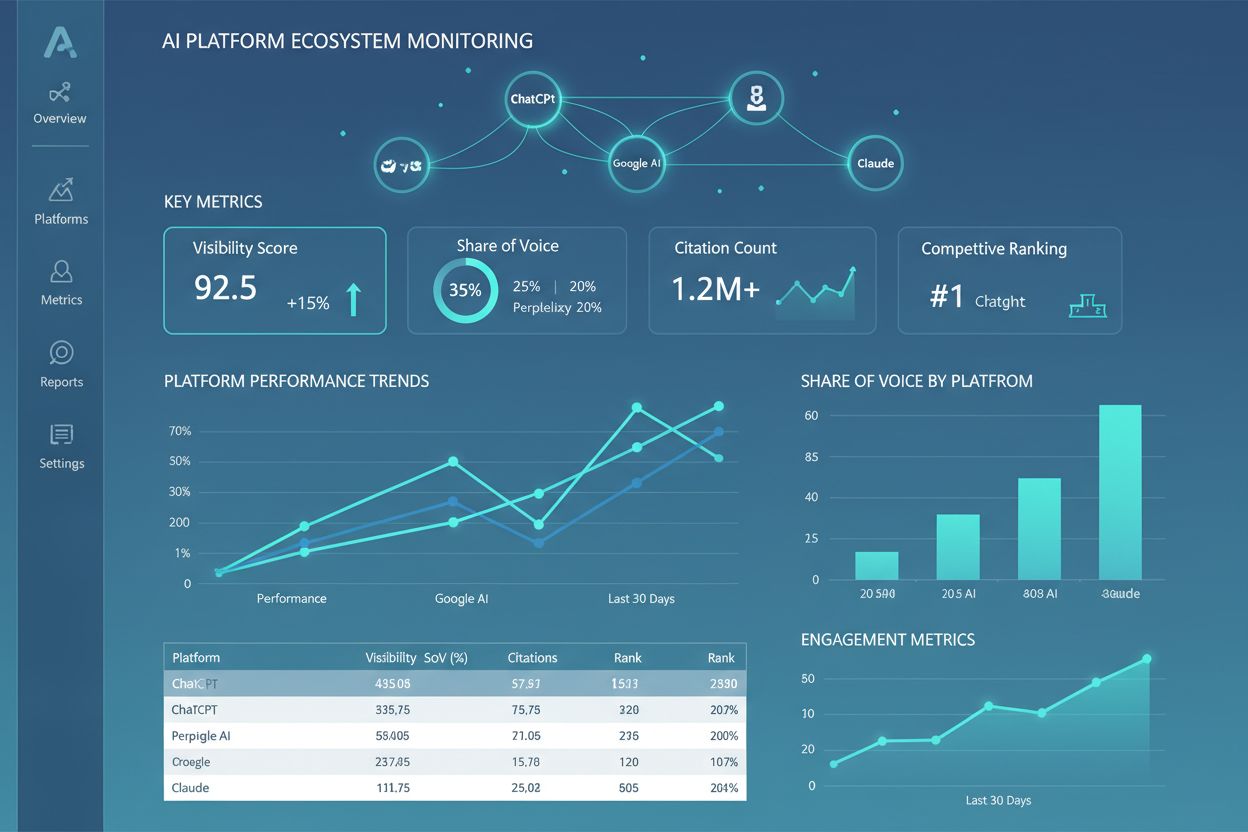

AIテスト環境分野は、モデルの複雑化・大規模化・多様化に対応すべく急速に進化しています。エージェント的テストは、AIが単一モデル推論を超えてツール利用や意思決定、外部システム連携を伴う多段階ワークフローを担う時代に重要性を増し、タスク完了・安全性・信頼性を測る新しい評価基盤が求められます。分散評価は、クラウドインフラ上で数千の同時テスト実行を可能にし、強化学習や大規模モデル学習で重要となります。リアルタイムモニタリングは、従来のバッチ評価から本番級の継続的テストへと変化し、パフォーマンス低下・データドリフト・新たなバイアスのライブ検知を実現します。AmICitedのようなオブザーバビリティプラットフォームは、AI全体のパフォーマンス・利用傾向・品質指標を横断的に可視化する中核ツールとして台頭しています。今後のテスト環境は、自動リメディエーション(問題検知→自動再学習やモデル更新)、クロスモーダル評価(テキスト・画像・音声・動画モデルの統合テスト)も標準化されていくでしょう。

AIテスト環境は、モデルやプロンプト、設定をライブシステムやユーザーに影響を与えることなく安全にテストできる隔離サンドボックスです。本番展開は、実際にユーザーにサービスを提供するライブ環境です。テスト環境では、問題の発見、パフォーマンスの最適化、変更の検証が本番に到達する前に可能となり、リスクを減らし品質を確保します。

はい、最新のAIテスト環境はマルチモデルテストに対応しています。E2B、IntelIQ.dev、DeepEvalのようなプラットフォームでは、同じプロンプトや入力をOpenAI、Anthropic、Mistralなど異なるLLMプロバイダーで同時にテストでき、出力やパフォーマンス指標を直接比較できます。

エンタープライズ向けAIテスト環境では、データ隔離(コンテナ化やマイクロVM)、エンドツーエンド暗号化、ロールベースアクセス制御、監査ログ、各種コンプライアンス認証(SOC 2、GDPR、HIPAA)など複数のセキュリティレイヤーを実装しています。データは明示的にエクスポートしない限り隔離環境から外部に出ることはなく、機密情報を保護します。

テスト環境は、すべてのモデル評価の監査証跡を提供し、データマスキングや合成データ生成をサポートし、アクセス制御を強制し、テストデータを本番システムから完全に隔離することでコンプライアンスを実現します。この記録と制御によって、GDPRやHIPAA、SOC 2といった規制要件への対応を支援します。

重要な指標は用途によって異なります。LLMなら精度、意味的類似度、幻覚率、レイテンシを追跡し、RAGシステムではコンテキスト適合率や忠実性、分類モデルでは適合率・再現率・F1スコアを監視します。すべてのモデルで時間経過によるパフォーマンス劣化やバイアス指標も追跡しましょう。

コストはプラットフォームにより異なります。DeepEvalはオープンソースで無料、LangSmithは無料枠があり有料プランは月額39ドルから、E2Bはサンドボックス稼働時間による従量課金、IntelIQ.devはサブスクリプション制です。大規模展開向けのエンタープライズ価格も用意されていることが多いです。

はい、ほとんどの最新テスト環境はCI/CD統合に対応しています。DeepEvalはPytestとのネイティブ統合、E2BはGitHub ActionsやGitLab CIとの連携、LangSmithはAPIベース統合を提供しています。これにより、コードコミットやデプロイごとに自動テストやゲート制御が可能です。

エンドツーエンドテストはAIアプリ全体をブラックボックスとして扱い、最終出力を期待結果と比較します。コンポーネントレベルテストは(LLM呼び出し、リトリーバ、ツール利用など)個々の要素をトレースやインストゥルメンテーションで個別に評価します。コンポーネントテストは問題箇所の深い洞察、エンドツーエンドテストは全体挙動の検証が可能です。

AmICitedは、ChatGPT、Claude、Perplexity、Google AIであなたのブランドやコンテンツがAIシステムでどのように参照されているかを追跡します。包括的なモニタリングと分析で、AIの可視性をリアルタイムで把握しましょう。

現代のAI検索テックスタックを構築するために必要な主要コンポーネント、フレームワーク、ツールについて学びましょう。検索システム、ベクトルデータベース、埋め込みモデル、デプロイ戦略を紹介します。...

アンビエントAIアシスタントとは何か、スマートホームでどのように機能するのか、購買決定への影響、そしてインテリジェントな生活環境の未来について解説。積極的なAIシステムの包括的ガイド。...

AIプラットフォームエコシステムとは何か、相互接続されたAIシステムがどのように連携するのか、そしてなぜ複数のAIプラットフォームでブランドの存在感を管理することが可視性や顧客発見のために重要なのかをご紹介します。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.