コンテキストウィンドウ

コンテキストウィンドウを解説:LLMが一度に処理できる最大トークン数。ChatGPT、Claude、Perplexity、Google AIにおけるコンテキストウィンドウがAIの正確性、幻覚、ブランド監視にどう影響するか学びましょう。...

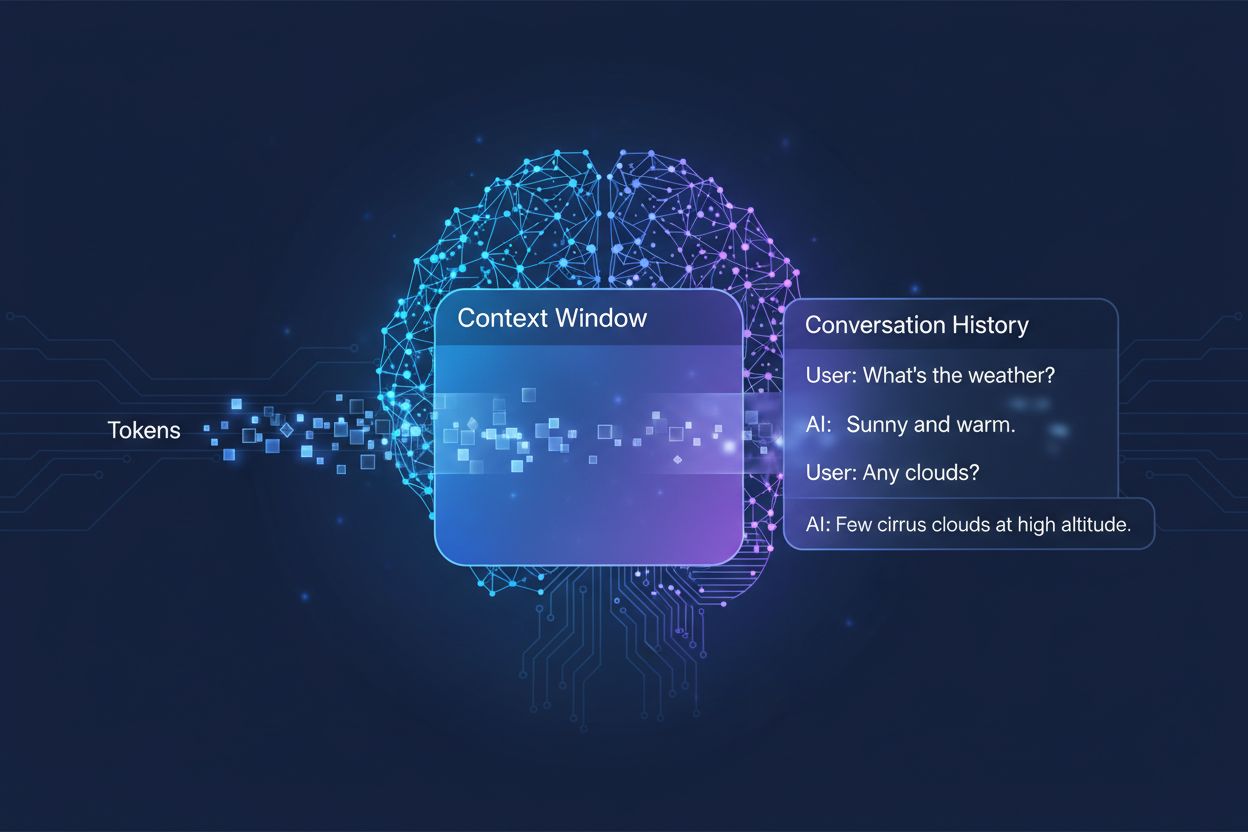

AIシステムが応答を生成する際に考慮する過去の会話量をトークンで測定したもの。AIが同時に処理できるテキスト量を決定し、マルチターンの会話における出力の品質と一貫性に直接影響します。

AIシステムが応答を生成する際に考慮する過去の会話量をトークンで測定したもの。AIが同時に処理できるテキスト量を決定し、マルチターンの会話における出力の品質と一貫性に直接影響します。

コンテキストウィンドウとは、AI言語モデルが会話やタスク中に一度に処理・参照できるテキスト量の上限です。これはモデルの作業用メモリのようなもので、人間が即座に意識できる情報量に限界があるように、AIモデルも現在位置の前後で「見える」テキスト量に限りがあります。この容量はトークンという単位で測定され、トークンは通常、単語や単語の断片を表します(英単語1語は平均で約1.5トークンに相当)。モデルのコンテキストウィンドウを理解することは、AIが応答を生成する際にどれだけの情報を考慮できるかを直接決定するため、複雑なマルチターン会話や長文ドキュメントの処理力において極めて重要な制約となります。

現代の言語モデル、特にトランスフォーマーベースのアーキテクチャは、テキストをトークンに変換し、コンテキストウィンドウ内のすべてのトークン間の関係を同時に分析します。2017年の画期的な論文「Attention is All You Need」で導入されたトランスフォーマーアーキテクチャは、**自己注意(self-attention)**という仕組みを用いて、入力内のどの部分が互いに最も関連性が高いかを判断します。このアテンションメカニズムにより、モデルは全ウィンドウにわたる文脈や意味を理解できるようになります。しかし、コンテキストウィンドウが大きくなるほど、この処理は計算量的に高価になります。なぜなら、アテンションメカニズムはすべてのトークン同士の関係を計算しなければならず、計算量が二乗に増加するためです。以下の表は、主要なAIモデルのコンテキストウィンドウ能力の比較です。

| モデル | コンテキストウィンドウ(トークン) | リリース日 |

|---|---|---|

| GPT-4 | 128,000 | 2023年3月 |

| Claude 3 Opus | 200,000 | 2024年3月 |

| Gemini 1.5 Pro | 1,000,000 | 2024年5月 |

| GPT-4 Turbo | 128,000 | 2023年11月 |

| Llama 2 | 4,096 | 2023年7月 |

これらの異なる容量は、各組織が選択した設計方針や計算資源のトレードオフを反映しており、ウィンドウが大きいほど高度な応用が可能ですが、その分処理能力も多く必要になります。

より大きなコンテキストウィンドウの実現は、過去10年間におけるAI能力の最も大きな進歩の一つです。初期のリカレントニューラルネットワーク(RNN)や長短期記憶(LSTM)モデルは、テキストを逐次的に処理し、入力の遠い部分の情報を保持するのが苦手でした。2017年、トランスフォーマーアーキテクチャの登場により、全シーケンスの並列処理が可能となり、長文にわたる文脈保持能力が劇的に向上しました。これを基礎として、2019年のGPT-2(1,024トークン)、2020年のGPT-3(2,048トークン)、そして2023年のGPT-4(128,000トークン)へと発展してきました。それぞれの進化は、モデルがより長いドキュメントの処理や、マルチターン会話の一貫性保持、テキスト内の遠く離れた概念間の関係理解など、できることの幅を飛躍的に拡大させました。コンテキストウィンドウの指数関数的な拡大は、アーキテクチャの革新と計算資源の向上の両方によるものです。

大きなコンテキストウィンドウは、AIモデルの可能性を根本的に広げ、以前は不可能または制限されていた応用を可能にします。主な利点は次のとおりです:

会話の連続性向上:モデルが会話履歴全体を把握できるため、再度説明する手間が減り、分断感のない自然なマルチターンダイアログを実現します。

大規模なドキュメント処理:ウィンドウが大きければ、AIは論文やコードベース全体を一度に分析でき、前半の情報を失うことなく内容全体のパターンや関係性を把握できます。

高度な推論・分析:より多くの文脈を踏まえて、複数の概念間の関係理解が必要な高度な推論タスクを実現し、リサーチや複雑な問題解決能力が向上します。

文脈切り替えの手間削減:ユーザーがいちいち要約や情報の再導入をする必要がなくなり、AIが全履歴を参照できるため、コラボレーション作業の効率が上がります。

複雑なタスクへの対応向上:法務文書レビューや医療記録分析、コード監査など、包括的な文脈把握が求められる用途で、より正確で抜けのない結果を出せます。

複数文書の横断的作業:関連する複数の文書をまたいで作業できるため、AIが情報をクロスリファレンスし、小さなウィンドウでは不可能だった関連性を発見できます。

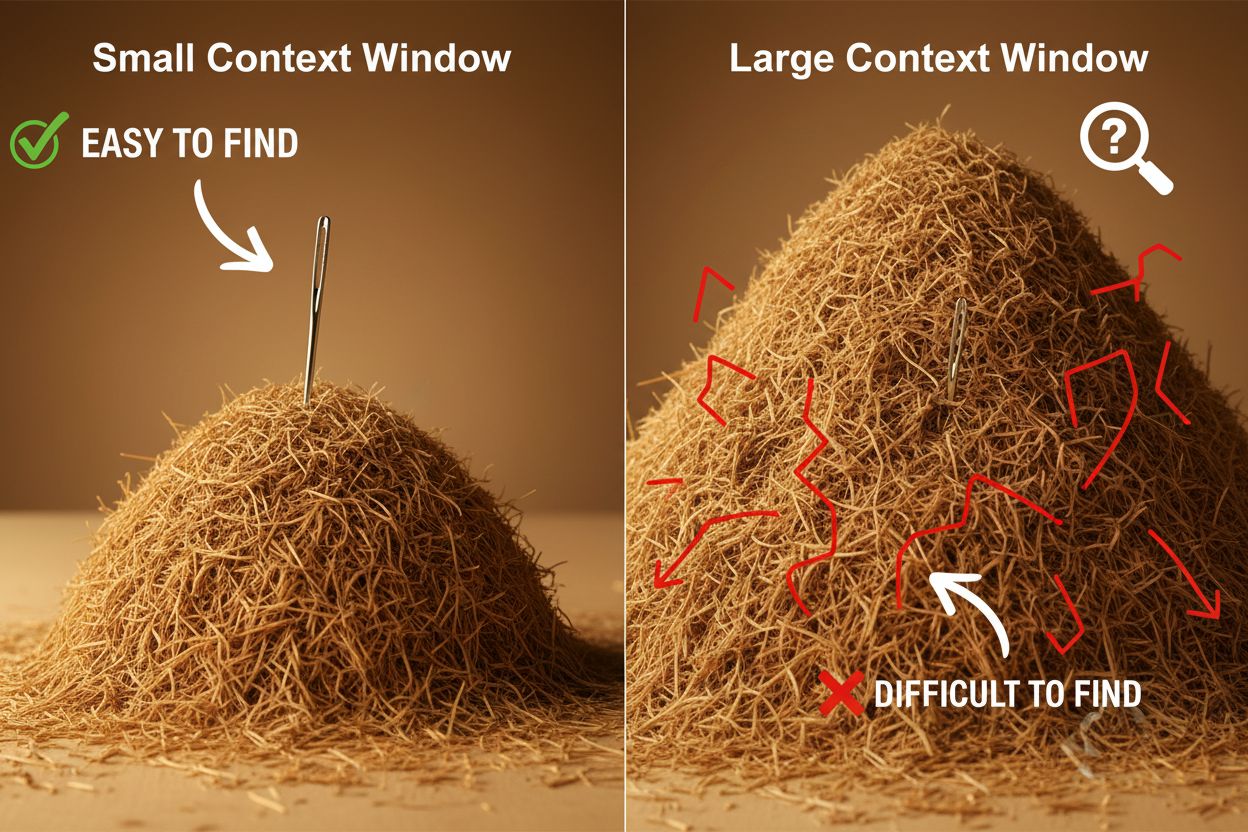

利点が多い一方で、大きなコンテキストウィンドウには開発者やユーザーが注意すべき技術的・実務的な課題もあります。最も明白なのは計算コストで、長いシーケンス処理にはアテンション機構の二次的スケーリングにより膨大なメモリと計算力が必要になり、運用コストが大幅に上昇します。応答の遅延も深刻で、ウィンドウが長いほどレスポンスが遅くなり、リアルタイム用途では致命的です。さらに重要なのが**「干し草の山の中の針」現象で、ウィンドウが大きくなりすぎると、関連情報が埋もれてしまい、逆に小さなウィンドウより性能が低下することもあります。またコンテキスト腐敗**も問題で、ウィンドウ冒頭の情報が出力に与える影響が弱まり、モデルが重要な情報を「忘れてしまう」ことがあります。これらの課題から、単純にウィンドウを最大化することが常に最適とは限りません。

コンテキスト腐敗を理解することは、大きなコンテキストウィンドウを効果的に活用するために不可欠です。シーケンスが長くなると冒頭のトークンの影響力が薄れ、重要な情報が「理論上はウィンドウ内にあっても」事実上忘れられてしまうことがあります。これはアテンションバジェット(モデルが全トークンに有意義に注意を向ける能力)がテキスト全体に分散し、1つ1つへの注意が薄まるためです。こうした制約に対し、**RAG(Retrieval-Augmented Generation)**は、外部データベースから関連情報のみを動的に取得することで、巨大なウィンドウを必要とせずに実質的な知識ベースを拡張します。コンテキスト圧縮技術は、重要度の低い情報を要約・圧縮し、主要な内容を残しつつトークン消費を抑えます。構造化ノート術はユーザーに情報を階層的に整理することを促し、モデルが重要な概念を優先して認識しやすくします。これらは単に容量を増やすのではなく、何をどのようにウィンドウに入れるかを戦略的に管理することで、限界を克服します。

拡大したコンテキストウィンドウにより、従来は困難だった多くの実用的応用が実現しました。カスタマーサポートシステムでは、チケットの全履歴や関連ドキュメントを1回のリクエストで確認でき、顧客が状況を繰り返し説明する必要がなく、より的確な応答が可能です。ドキュメント分析やリサーチでは、研究論文や契約書、技術仕様書全体を読み込んで要点抽出や詳細な質問応答ができ、人間なら何時間もかかる作業を効率化します。コードレビューやソフトウェア開発では、ファイル全体や複数の関連ファイルをウィンドウ内に保持でき、アーキテクチャ全体を理解した上でより知的な提案が可能になります。長文コンテンツ制作や反復的な執筆作業も、モデルが文書全体のトーンや構成・ストーリーを一貫して把握できるため、効率的に進められます。ミーティング議事録分析やリサーチ統合も、大きなウィンドウにより何時間もの会話や多数の資料から洞察を抽出し、人間では気づきにくいテーマや関連性を発見できます。これらの応用は、コンテキストウィンドウの大きさが専門職の現場で直接的な価値を生み出していることを示しています。

コンテキストウィンドウ開発の流れを見ると、近い将来さらに劇的な拡大が予想されます。すでにGemini 1.5 Proは1,000,000トークンのコンテキストウィンドウを実現し、研究機関ではさらに大きな容量への挑戦が続いています。今後は単なるサイズ拡大を超え、タスクごとにウィンドウサイズを動的に調整し、必要な時にだけ容量を増やして効率やコストを最適化する「ダイナミックコンテキストウィンドウ」の普及も見込まれます。さらに、ウィンドウ拡大の計算コスト(二次的スケーリング)を打破する、より効率的なアテンション機構の研究も進んでいます。こうした技術が成熟すれば、コンテキストウィンドウはもはや制約ではなく「解決済みの問題」となり、開発者はAIの他の能力や信頼性向上に注力できるようになるでしょう。ウィンドウの大型化、効率化、スマートな文脈管理の融合が次世代AIアプリの基盤となり、今は想像もつかない新たなユースケースを生み出すと考えられます。

コンテキストウィンドウは、AIモデルが一度に処理できるテキスト(トークンで測定)の総量を指し、トークン制限はモデルが扱えるトークンの最大数を指します。これらの用語はしばしば同じ意味で使われますが、コンテキストウィンドウは単一の推論時に利用できる作業メモリを特に指し、トークン制限は出力制約やAPIの使用制限を指す場合もあります。

大きなコンテキストウィンドウは、モデルがより多くの関連情報を考慮でき、会話の連続性をより良く維持できるため、一般的に応答品質が向上します。しかし、極端に大きなウィンドウでは、重要な情報の優先順位付けが難しくなり「コンテキスト腐敗」が発生しやすくなるため、かえって品質を損なうこともあります。最適なコンテキストウィンドウのサイズは、タスクの内容や情報の整理具合によって異なります。

大きなコンテキストウィンドウは、トランスフォーマーモデルのアテンション機構が二次的にスケーリングするため、より多くの計算能力を必要とします。アテンション機構はすべてのトークン間の関係を計算するため、コンテキストウィンドウを2倍にすると計算量は約4倍になります。そのため、大きなコンテキストウィンドウは運用コストが高く、応答速度も遅くなります。

「干し草の山の中の針」問題とは、AIモデルが非常に大きなコンテキストウィンドウ内に埋もれた関連情報(“針”)を特定して活用するのが難しくなる現象です。アテンション機構が大量の情報に分散されてしまい、本当に重要なものを見分けにくくなるため、極端に大きなコンテキストウィンドウでは、かえって性能が低下することもあります。

コンテキストウィンドウを最大限に活用するには、情報を明確かつ階層的に整理し、重要な情報をコンテキストの先頭や末尾に配置し、JSONやMarkdownのような構造化フォーマットを活用し、必要な場合はRAG(Retrieval-Augmented Generation)のような手法で最も関連性の高い情報だけを動的に読み込むことが有効です。トークンを消費する不要な詳細でモデルを圧倒しないようにしましょう。

コンテキストウィンドウはモデルが一度に処理できるテキストの技術的な限界を指し、会話履歴は実際の会話内の過去メッセージの記録です。会話履歴はコンテキストウィンドウ内に収める必要がありますが、コンテキストウィンドウにはシステムプロンプトや指示、他のメタデータも含まれる場合があります。会話履歴がウィンドウより長い場合は要約や切り捨てが必要です。

現在、すべてのAIモデルはアーキテクチャや計算資源の制約があるため、本当に無制限のコンテキストウィンドウを持つモデルは存在しません。ただしGemini 1.5 Proのように非常に大きなウィンドウ(1,000,000トークン)を持つモデルもあり、RAG(Retrieval-Augmented Generation)のような技術を使えば、必要に応じて動的に情報を取得し実質的に知識ベースを拡張することもできます。

コンテキストウィンドウの大きさはAPIコストに直接影響します。なぜなら大きなウィンドウはより多くの計算資源を必要とし、多くのAI APIプロバイダーはトークン使用量に基づいて課金しているからです。ウィンドウが大きいほど処理トークンも増えコストも高くなります。また、大きなウィンドウを持つモデルにはプレミアム料金が設定されていることもあるため、目的に合ったモデルサイズの選定が重要です。

コンテキストウィンドウを解説:LLMが一度に処理できる最大トークン数。ChatGPT、Claude、Perplexity、Google AIにおけるコンテキストウィンドウがAIの正確性、幻覚、ブランド監視にどう影響するか学びましょう。...

AI言語モデルにおけるコンテキストウィンドウとは何か、その仕組みやモデル性能への影響、AIを活用したアプリケーションや監視においてなぜ重要なのかを学びましょう。...

AIのコンテキストウィンドウと、そのコンテンツマーケティングへの影響についてのコミュニティディスカッション。コンテキスト制限がAIによるコンテンツ処理にどう影響するかを理解しましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.