AI-crawlers uitgelegd: GPTBot, ClaudeBot en meer

Begrijp hoe AI-crawlers zoals GPTBot en ClaudeBot werken, hun verschillen met traditionele zoekmachine-crawlers en hoe je je site optimaliseert voor AI-zoekzich...

Ontdek hoe je strategische beslissingen neemt over het blokkeren van AI-crawlers. Evalueer inhoudstype, verkeersbronnen, verdienmodellen en concurrentiepositie met ons uitgebreide besliskader.

AI-crawlers zijn een belangrijke kracht geworden in het digitale ecosysteem en veranderen fundamenteel hoe content wordt ontdekt, geïndexeerd en gebruikt op het internet. Deze geautomatiseerde systemen zijn ontworpen om systematisch websites te doorzoeken, data te extraheren en deze te voeden aan machine learning-modellen die alles aandrijven van zoekmachines tot generatieve AI-toepassingen. Het landschap omvat drie verschillende typen crawlers: datascrapers die specifieke informatie extraheren voor commerciële doeleinden, zoekmachine-crawlers zoals Googlebot die content indexeren voor zoekresultaten, en AI-assistent-crawlers die trainingsdata verzamelen voor grote taalmodellen. Voorbeelden zijn OpenAI’s GPTBot, Anthropic’s Claude-Web en Google’s AI Overviews-crawler, elk met verschillende doelen en impactprofielen. Volgens recente analyses heeft ongeveer 21% van de top 1.000 websites al een vorm van AI-crawlerblokkering geïmplementeerd, wat wijst op een groeiend bewustzijn van de noodzaak om deze geautomatiseerde bezoekers te beheren. Weten welke crawlers je site bezoeken en waarom ze dat doen is de eerste belangrijke stap om een weloverwogen beslissing te nemen over blokkeren of toestaan. De inzet is hoog, want deze beslissing beïnvloedt direct de zichtbaarheid van je content, je verkeerspatronen en uiteindelijk je verdienmodel.

In plaats van een algemene keuze te maken om alle AI-crawlers te blokkeren of toe te staan, is een meer geavanceerde aanpak het evalueren van je specifieke situatie via het BEDC-kader, wat staat voor Business Model, Exposure Risk, Dependency on Organic Search en Competitive Position. Elk van deze vier factoren weegt anders afhankelijk van de kenmerken van je website en samen vormen ze een uitgebreid beslismatrix die rekening houdt met de complexiteit van moderne digitale publicatie. Dit kader erkent dat er geen universele oplossing is—wat werkt voor een nieuwsorganisatie kan totaal verkeerd uitpakken voor een SaaS-bedrijf en wat een gevestigd merk helpt, kan een opkomende concurrent juist schaden. Door elke factor systematisch te evalueren, ga je verder dan een emotionele reactie op AI en neem je in plaats daarvan datagedreven beslissingen die aansluiten bij je bedrijfsdoelstellingen.

| Factor | Aanbeveling | Belangrijkste Overweging |

|---|---|---|

| Business Model | Sites gebaseerd op advertenties moeten voorzichtiger zijn; abonnementsmodellen kunnen soepeler zijn | Inkomsten afhankelijkheid van direct gebruikerscontact vs. licenties |

| Exposure Risk | Origineel onderzoek en eigen content blokkeren; standaardcontent kan opener zijn | Concurrentievoordeel gekoppeld aan unieke inzichten of data |

| Afhankelijkheid van organisch zoekverkeer | Hoge afhankelijkheid (>40% verkeer) suggereert Google-crawlers toestaan en AI-assistenten blokkeren | Balans tussen zoekzichtbaarheid en bescherming van AI-trainingsdata |

| Concurrentiepositie | Marktleiders kunnen zich blokkeren veroorloven; nieuwkomers profiteren mogelijk van AI-zichtbaarheid | First-mover voordeel bij AI-partnerschappen vs. contentbescherming |

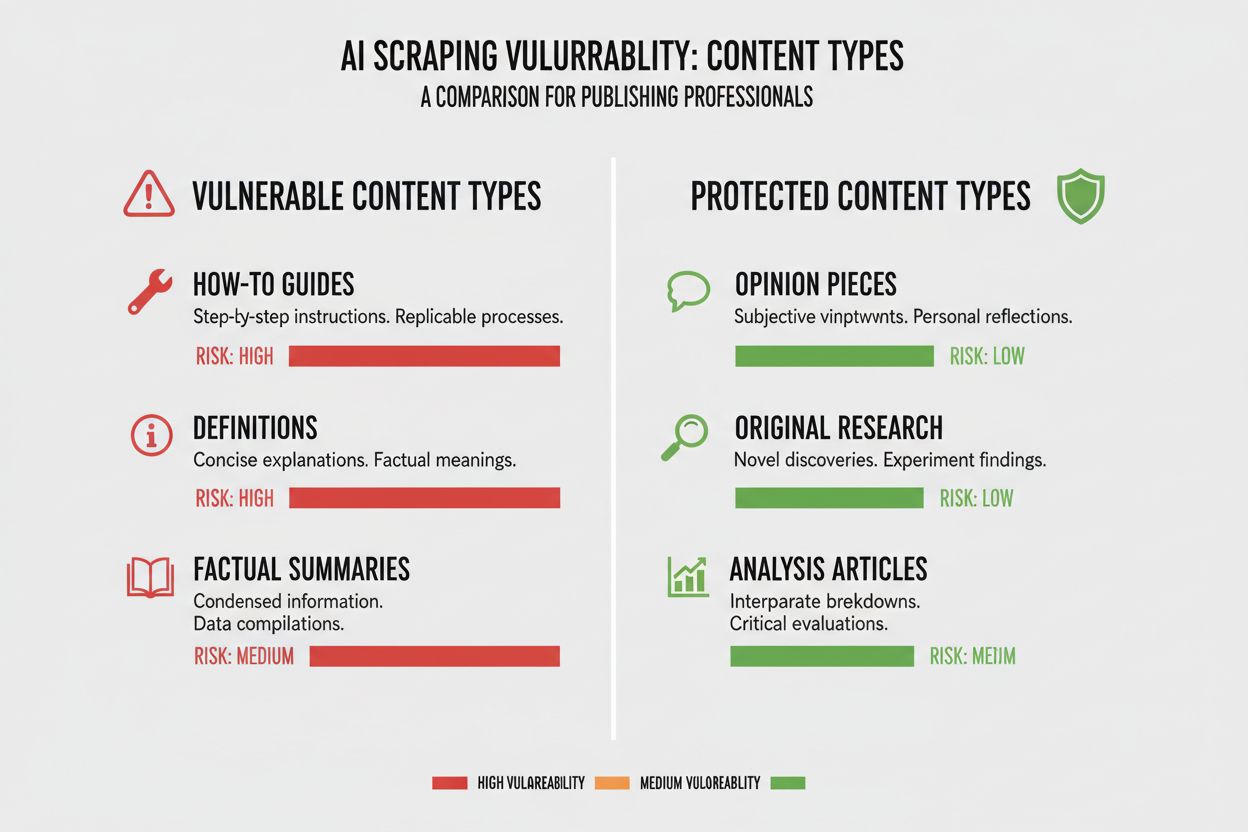

Verschillende soorten content hebben een heel andere kwetsbaarheid voor AI-crawlers, en weten waar jouw content zich op dit spectrum bevindt is essentieel voor de juiste beslissing. Origineel onderzoek en eigen data zijn je meest waardevolle bezit en verdienen de sterkste bescherming, omdat AI-modellen getraind op deze content direct kunnen concurreren met je verdienmodel. Nieuws en actuele informatie zit in het midden—de tijdsgevoelige waarde neemt snel af, maar vindbaar blijven in zoekmachines is kritisch voor verkeer, wat een spanningsveld creëert tussen zichtbaarheid in zoekresultaten en bescherming van AI-trainingsdata. Standaardcontent zoals how-to’s, handleidingen en algemene naslag is veel minder kwetsbaar omdat het overal te vinden is en waarschijnlijk niet je primaire inkomstenbron is. Stemgestuurde en multimediale content heeft een natuurlijke bescherming, omdat huidige AI-crawlers moeite hebben om waardevolle informatie uit audio en video te halen, waardoor deze formaten van nature veiliger zijn voor extractie van AI-trainingsdata. Tijdloze educatieve content en opinieartikelen vallen ergens in het midden; ze zijn waardevol voor zoekverkeer maar minder direct bedreigd door AI-concurrentie. De kern is dat je blokkeringsstrategie proportioneel moet zijn aan het concurrentievoordeel dat je content biedt—bescherm je kroonjuwelen, maar blijf open voor crawlers bij content die baat heeft bij brede verspreiding.

Je afhankelijkheid van organisch zoekverkeer is misschien wel de meest concrete factor bij de AI-crawlerbeslissing, omdat het direct de afweging tussen zichtbaarheid en contentbescherming kwantificeert. Websites die meer dan 40% van hun verkeer uit organisch zoeken halen, lopen een groot risico: het blokkeren van AI-crawlers betekent vaak ook het blokkeren of beperken van Google’s crawlers, wat hun zichtbaarheid en verkeer ernstig schaadt. Het onderscheid tussen Google-Extended (voor AI-training) en Googlebot (voor zoekindexering) is hier cruciaal, want je kunt in theorie de ene toestaan en de andere blokkeren, hoewel dit technisch complex is. Een opvallende casestudy van The New York Times laat de inzet zien: de krant ontving ongeveer 240.600 bezoeken van AI-crawlers in een bepaalde periode, wat het schaalniveau van AI-verkeer voor grote uitgevers toont. Toch blijkt uit Akamai-data dat het blokkeren van crawlers zorgt voor 96% minder doorverwezen verkeer uit die bronnen, wat suggereert dat het aandeel van AI-crawlers klein is vergeleken met traditioneel zoekverkeer. De crawl-to-referral ratio voor de meeste AI-crawlers is extreem laag—vaak genereert minder dan 0,15% van gecrawlde content een terugkerend bezoek—waardoor blokkeren van deze crawlers nauwelijks invloed heeft op je daadwerkelijke gebruikersverkeer. Voor websites met grote afhankelijkheid van organisch zoeken moet de beslissing om AI-crawlers te blokkeren worden afgewogen tegen het risico om per ongeluk zoekmachine-crawlers te blokkeren, wat veel schadelijker zou zijn voor je bedrijf.

Je verdienmodel vormt de basis voor je benadering van AI-crawlers, omdat verschillende inkomstenstrategieën andere prikkels geven voor contentdistributie en -bescherming. Advertentiegedreven websites ervaren de grootste spanning met AI-crawlers, omdat hun inkomsten afhangen van bezoekers die advertenties zien, en AI-modellen die hun content samenvatten verminderen de drang om door te klikken. Abonnementsmodellen kunnen soepeler zijn met AI-crawlers, omdat hun inkomsten uit directe gebruikersabonnementen komen in plaats van advertentie-impressies, en AI-zichtbaarheid zelfs abonnees kan opleveren. Hybride modellen met advertenties, abonnementen en affiliate-inkomsten vragen om een genuanceerdere aanpak, omdat blokkeren van crawlers advertentie-inkomsten kan beschermen, maar affiliate-kansen of abonneegroei kan schaden. Een opkomende kans is het AI-verwijzingsmodel, waarbij websites inkomsten kunnen verdienen door AI-crawlers toegang te geven in ruil voor vermelding en verkeersverwijzingen—een model in ontwikkeling dat de economie van contentdistributie kan veranderen. Voor uitgevers die de impact van AI-crawlers willen begrijpen, bieden tools zoals AmICited.com essentiële monitoring om te zien waar je content wordt geciteerd en gebruikt door AI-systemen, en inzicht in de werkelijke waarde-uitwisseling van je content. Het is essentieel om je verdienmodel zo goed te begrijpen dat je kunt voorspellen hoe AI-crawlers elk inkomstenkanaal beïnvloeden, in plaats van een principiële alles-of-nietsbeslissing te nemen.

Zodra je hebt besloten bepaalde AI-crawlers te blokkeren, vraagt de technische uitvoering om inzicht in de mogelijkheden en beperkingen van je tools. De meest gebruikte methode is robots.txt, een eenvoudig tekstbestand in de root van je website dat crawlers instrueert welke delen ze wel of niet mogen bezoeken. Robots.txt heeft echter een belangrijke beperking: het is een vrijwillige standaard waarop crawlers niet verplicht zijn te reageren, en kwaadwillende of agressieve crawlers kunnen het negeren. Zo blokkeer je specifieke AI-crawlers in je robots.txt:

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

Overweeg naast robots.txt ook het blokkeren van deze grote AI-crawlers:

Voor sterkere bescherming implementeren veel organisaties blokkeren op CDN-niveau via diensten als Cloudflare, waardoor verkeer aan de rand wordt geblokkeerd voordat het je servers bereikt en je betere prestaties en veiligheid krijgt. Een dubbele laag van robots.txt en CDN-blokkering biedt de sterkste bescherming, omdat het zowel respectvolle als agressieve crawlers afvangt. Houd er rekening mee dat blokkeren op CDN-niveau meer technische kennis vereist en onbedoelde gevolgen kan hebben als het niet goed geconfigureerd is—deze aanpak is dus het meest geschikt voor organisaties met technische capaciteit.

De ongemakkelijke waarheid over het blokkeren van AI-crawlers is dat de werkelijke impact op verkeer vaak veel kleiner is dan de emotionele reactie op AI-scraping doet vermoeden, en de data laat een genuanceerder beeld zien dan veel uitgevers verwachten. Volgens recente analyses zijn AI-crawlers doorgaans goed voor slechts 0,15% van het totale websiteverkeer bij de meeste uitgevers, een verrassend klein aandeel gezien de aandacht voor dit onderwerp. Toch groeit het verkeer van AI-crawlers snel, met rapporten die 7x groei per jaar laten zien in AI-crawlerverzoeken—de huidige impact is klein, maar de trend steil. ChatGPT is goed voor circa 78% van al het AI-crawlerverkeer, waarmee OpenAI de dominante speler is, gevolgd door kleinere bijdragen van andere AI-bedrijven. De crawl-to-referral-ratio is veelzeggend: AI-crawlers kunnen miljoenen pagina’s opvragen, maar zorgen voor daadwerkelijke terugkerende bezoeken van vaak minder dan 0,15%, waardoor blokkeren nauwelijks je gebruikersverkeer beïnvloedt. Het blokkeren van AI-crawlers vermindert doorverwezen verkeer met 96%, maar omdat dat verkeer al minimaal was (vaak minder dan 0,15% van het totaal), is het netto-effect op je bedrijf vaak verwaarloosbaar. Dit creëert een paradox: AI-crawlers blokkeren voelt als een principieel standpunt tegen contentdiefstal, maar de feitelijke zakelijke impact is vaak zo klein dat het nauwelijks zichtbaar is in je statistieken. De echte vraag is niet of blokkeren je verkeer schaadt—meestal niet—maar of toelaten strategische kansen of risico’s oplevert die opwegen tegen de minimale bijdrage aan verkeer.

Je concurrentiepositie bepaalt fundamenteel je aanpak van AI-crawlers, want de optimale strategie voor een marktleider verschilt sterk van die voor een opkomende concurrent. Dominante spelers zoals The New York Times, Wall Street Journal en grote nieuwsorganisaties kunnen zich veroorloven om AI-crawlers te blokkeren, omdat hun merkbekendheid en directe relatie met het publiek betekent dat ze niet afhankelijk zijn van AI-ontdekking voor verkeer. Nieuwkomers en nichesites hebben een andere afweging: geïndexeerd worden door AI-systemen en verschijnen in AI-gegenereerde samenvattingen kan een van hun weinige manieren zijn om zichtbaar te worden naast gevestigde concurrenten. Het first-mover voordeel bij AI-partnerschappen kan aanzienlijk zijn—uitgevers die vroeg gunstige deals sluiten met AI-bedrijven kunnen betere vermelding, verwijzingsverkeer of licenties krijgen dan laatkomers. Er is ook sprake van een subsidie-effect: als dominante uitgevers AI-crawlers blokkeren, dwingt dat AI-bedrijven om meer te leunen op content van uitgevers die wel toestaan, wat die uitgevers relatief veel zichtbaarheid in AI-systemen kan geven. Dit creëert een concurrentiedynamiek waarin blokkeren je positie zelfs kan schaden als je concurrenten crawlers toestaan en zo AI-zichtbaarheid winnen. Begrijpen waar je staat in je markt is essentieel om te voorspellen hoe je blokkeringsbeslissing je positie ten opzichte van concurrenten beïnvloedt.

De keuze om AI-crawlers te blokkeren of toe te staan vraagt om een systematische beoordeling van je situatie aan de hand van concrete criteria. Gebruik deze checklist voor je besluitvorming:

Beoordeling van Contentblootstelling

Analyse van Verkeerssamenstelling

Evaluatie van Marktpositie

Inkomstrisico-inschatting

Voer naast deze eerste beoordeling kwartaalreviews uit van je AI-crawlerstrategie, want het landschap verandert snel en je optimale keuze nu kan over enkele maanden anders zijn. Gebruik tools zoals AmICited.com om te volgen waar je content wordt geciteerd en gebruikt door AI-systemen, zodat je concrete data krijgt over de waarde-uitwisseling van je content. Het belangrijkste inzicht is dat deze beslissing niet eenmalig genomen en vergeten mag worden—het vraagt voortdurende evaluatie en aanpassing naarmate het AI-landschap en je bedrijfsomstandigheden veranderen.

Een belangrijke opkomende kans die het hele AI-crawlerlandschap kan veranderen, is Cloudflare’s pay-per-crawl functie, die een toestemmingsgedreven internetmodel introduceert waarbij website-eigenaren AI-crawlertoegang kunnen gelde maken in plaats van alleen blokkeren of toestaan. Deze aanpak erkent dat AI-bedrijven waarde halen uit het crawlen van jouw content, en in plaats van een vijandige blokkadestrijd kun je compensatie onderhandelen voor die toegang. Het model gebruikt cryptografische verificatie om te zorgen dat alleen geautoriseerde crawlers toegang krijgen tot je content, waardoor ongeautoriseerde scraping wordt voorkomen en legitieme AI-bedrijven kunnen betalen voor toegang. Dit biedt gedetailleerde controle over welke crawlers toegang krijgen tot welke content, zodat je waardevolle content kunt gelde maken en toch openblijft voor zoekmachines en andere nuttige crawlers. Het pay-per-crawl-model maakt ook AI-auditmogelijkheden mogelijk, zodat je exact kunt zien welke content is gecrawld, wanneer en door wie, wat transparantie biedt die onmogelijk is met traditionele blokkade. Voor uitgevers die deze strategie toepassen, worden de monitoringmogelijkheden van AmICited.com nog waardevoller, omdat je niet alleen kunt volgen waar je content verschijnt in AI-systemen, maar ook kunt verifiëren dat je passende compensatie ontvangt voor dat gebruik. Hoewel dit model nog in opkomst is en de adoptie beperkt, biedt het een potentieel geavanceerdere aanpak dan de binaire keuze tussen blokkeren en toestaan—een aanpak die de wederzijdse waarde in de relatie tussen uitgevers en AI-bedrijven erkent, terwijl je belangen worden beschermd via contractuele en technische mechanismen.

Het blokkeren van AI-crawlers voorkomt dat ze toegang krijgen tot je content via robots.txt of blokkering op CDN-niveau, waardoor je content wordt beschermd tegen gebruik voor AI-training. Toestaan betekent dat je content kan worden geïndexeerd door AI-systemen en mogelijk verschijnt in AI-gegenereerde samenvattingen en antwoorden. De keuze hangt af van je inhoudstype, verdienmodel en concurrentiepositie.

Het blokkeren van AI-crawlers schaadt je SEO niet direct als je alleen AI-specifieke crawlers zoals GPTBot blokkeert en Googlebot toestaat. Als je echter per ongeluk Googlebot blokkeert, zullen je zoekresultaten aanzienlijk dalen. Belangrijk is om gedetailleerde controle te gebruiken om alleen AI-trainingscrawlers te blokkeren en de toegang van zoekmachines te behouden.

Ja, je kunt robots.txt gebruiken om specifieke crawlers te blokkeren op basis van hun user-agent, terwijl je anderen toestaat. Zo kun je bijvoorbeeld GPTBot blokkeren en Google-Extended toestaan, of andersom. Met deze gedetailleerde aanpak kun je je content beschermen tegen bepaalde AI-bedrijven en toch zichtbaar blijven voor anderen.

robots.txt is een vrijwillige standaard waarbij crawlers je instructies alleen opvolgen als ze dat willen—sommige AI-bedrijven negeren dit. Blokkeren op CDN-niveau (zoals bij Cloudflare) blokkeert verkeer aan de rand van het netwerk voordat het je servers bereikt en biedt sterkere handhaving. Een dubbele laag met beide methoden biedt de beste bescherming.

Je kunt je serverlogs controleren op user-agents van bekende AI-crawlers zoals GPTBot, CCBot en Claude-Web. Tools zoals AmICited.com bieden monitoringfuncties om te volgen waar je content verschijnt in AI-systemen en hoe vaak deze wordt bezocht door AI-crawlers.

Pay-per-crawl is een opkomend model waarbij AI-bedrijven betalen voor toegang tot je content. Hoewel het nog in bèta is en beperkt wordt gebruikt, biedt het mogelijk een nieuwe inkomstenbron. De levensvatbaarheid hangt af van het AI-crawlerverkeer en de tarieven die AI-bedrijven bereid zijn te betalen.

Als een AI-crawler je robots.txt negeert, kun je blokkeren op CDN-niveau toepassen via diensten als Cloudflare. Je kunt ook je server configureren om 403-fouten te retourneren aan bekende AI-crawlers. Bij aanhoudende schendingen kun je juridische stappen overwegen of direct contact opnemen met het AI-bedrijf.

Herzie je AI-crawlerstrategie elk kwartaal, omdat het landschap snel verandert. Monitor veranderingen in AI-crawlerverkeer, nieuwe crawlers op de markt en verschuivingen in je concurrentiepositie. Gebruik tools zoals AmICited.com om te volgen hoe je content wordt gebruikt door AI-systemen en pas je strategie daarop aan.

Volg waar jouw content verschijnt in AI-gegenereerde antwoorden en begrijp de impact van AI-crawlers op je bedrijf met het uitgebreide monitoringsplatform van AmICited.com.

Begrijp hoe AI-crawlers zoals GPTBot en ClaudeBot werken, hun verschillen met traditionele zoekmachine-crawlers en hoe je je site optimaliseert voor AI-zoekzich...

Leer hoe AI-crawlers invloed hebben op serverresources, bandbreedte en prestaties. Ontdek echte statistieken, strategieën voor mitigatie en infrastructuuroploss...

Leer hoe je AI-crawlers zoals GPTBot, PerplexityBot en ClaudeBot kunt identificeren en monitoren in je serverlogs. Ontdek user-agent strings, IP-verificatiemeth...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.