Wat AI beschouwt als hoogwaardige content: verder dan traditionele maatstaven

Ontdek hoe AI-systemen contentkwaliteit beoordelen buiten traditionele SEO-maatstaven. Leer over semantisch begrip, feitelijke juistheid en kwaliteitssignalen d...

Leer hoe je topische autoriteit opbouwt voor LLM’s met semantische diepgang, entiteitoptimalisatie en contentclusters. Beheers de strategieën waardoor AI-systemen jouw merk citeren.

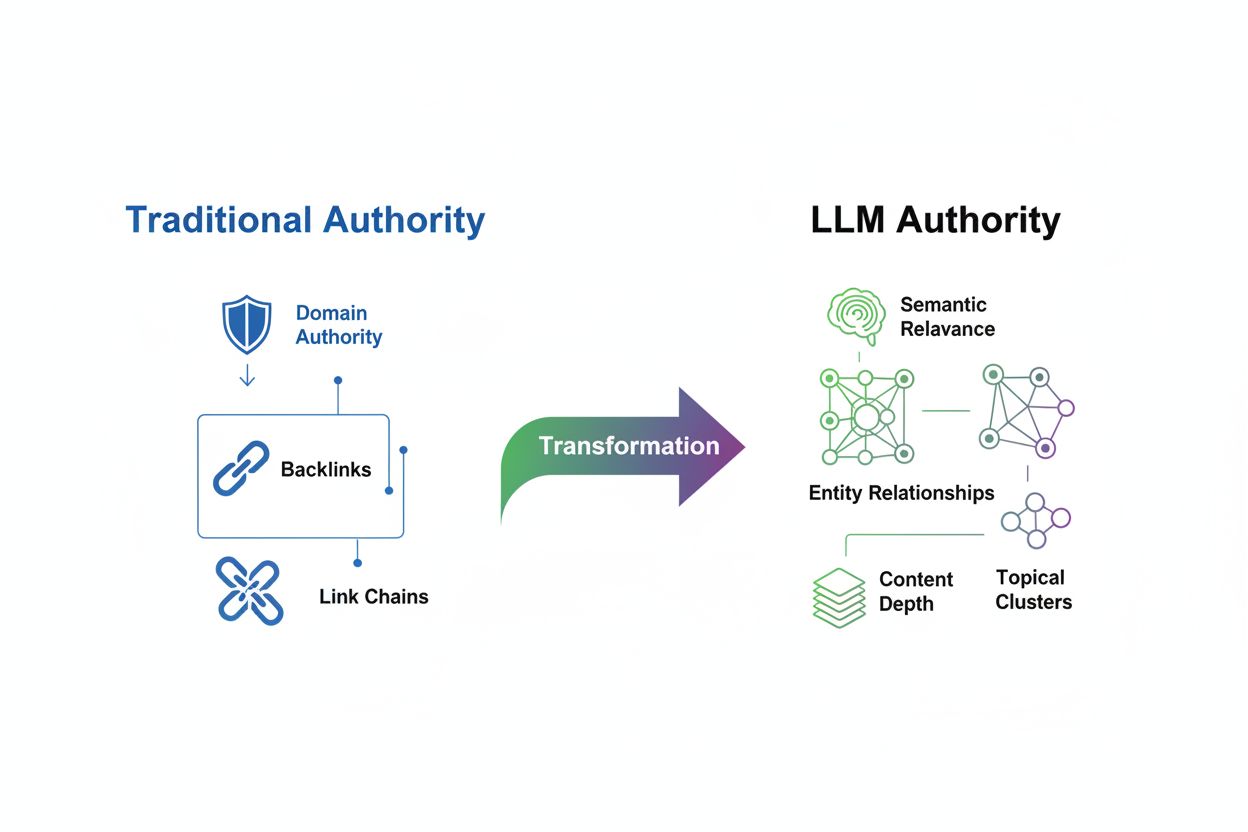

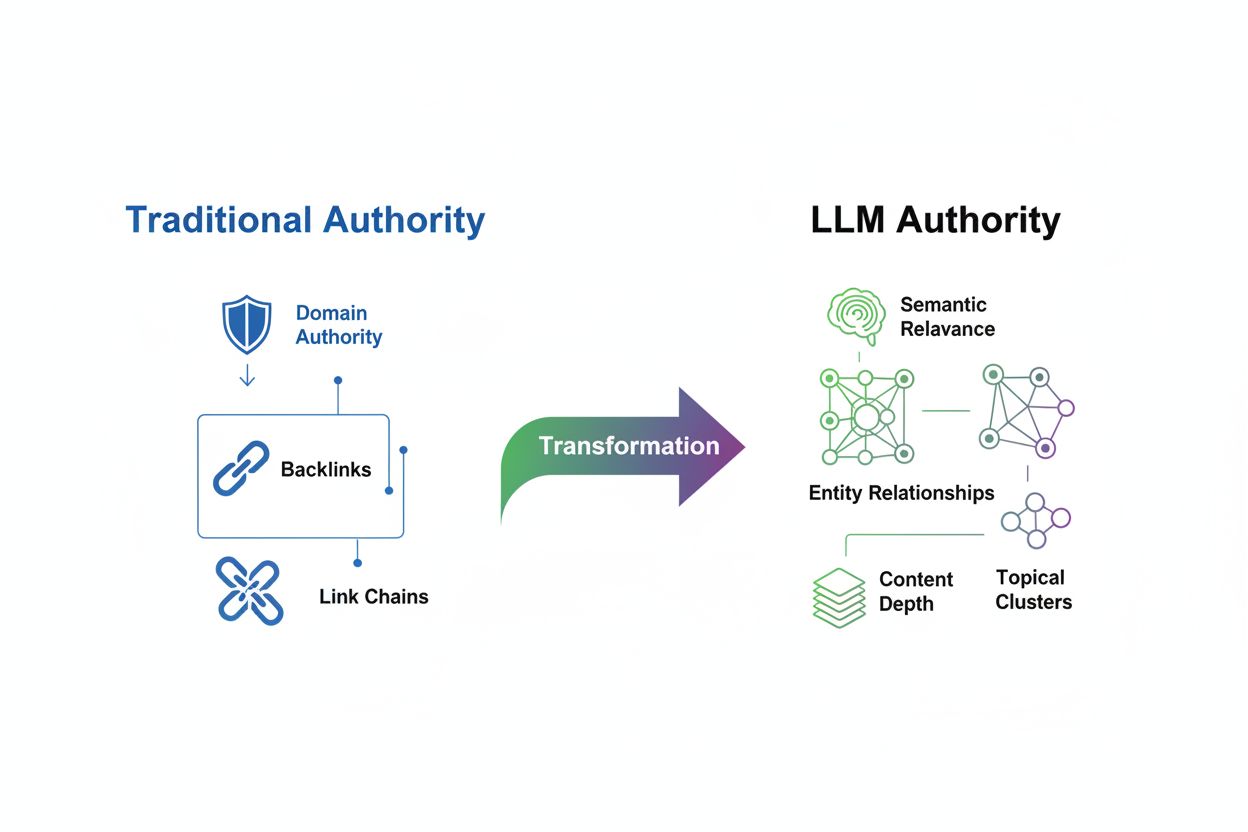

De beoordeling van topische autoriteit heeft een fundamentele transformatie ondergaan in het tijdperk van Large Language Models. Waar traditionele SEO ooit backlinks en zoekwoorddichtheid als primaire autoriteitssignalen vooropstelde, beoordelen moderne LLM’s content vanuit een totaal ander perspectief gericht op semantische relevantie, contextuele diepgang en entiteitsrelaties. Deze verschuiving is meer dan een kleine algoritme-update—het is een volledige herziening van hoe zoekmachines en AI-systemen bepalen welke bronnen zichtbaarheid en vertrouwen verdienen. Het oude model beloonde volume en het aantal links; het nieuwe paradigma beloont semantische rijkdom en volledige dekking van een onderwerp. Dit inzicht is cruciaal, omdat merken die blijven optimaliseren voor verouderde autoriteitssignalen zichzelf steeds onzichtbaarder zullen maken in AI-gegenereerde antwoorden, zelfs als ze sterke traditionele SEO-statistieken behouden. De toekomst van zichtbaarheid behoort toe aan degenen die beseffen dat LLM’s autoriteit herkennen door diepgang, consistentie en semantische helderheid in plaats van het verzamelen van externe links.

Topische autoriteit wordt gedefinieerd als het niveau van expertise, diepgang en consistentie dat een website aantoont binnen een specifiek onderwerp, zoals erkend door zowel zoekmachines als kunstmatige intelligentiesystemen. In tegenstelling tot traditionele autoriteitsmetingen, die sterk leunen op externe validatie via backlinks, focust LLM-gebaseerde autoriteitsevaluatie op hoe volledig en samenhangend een domein zijn gekozen onderwerp behandelt. Semantische relevantie is de hoeksteen geworden van deze nieuwe beoordelingsmethode—LLM’s beoordelen of content volledig aansluit bij de gebruikersintentie, verschillende invalshoeken van een onderwerp behandelt en logische verbanden tussen gerelateerde concepten bewaart. Het verschil is groot: een website met 50 oppervlakkige, op zoekwoorden gerichte artikelen kan sterke traditionele autoriteitssignalen hebben maar zwakke topische autoriteit in de LLM-context, terwijl een concurrent met 10 diepgaand onderzochte, onderling verbonden artikelen kan domineren in AI-gegenereerde antwoorden.

| Autoriteitssignaal | Traditionele SEO | LLM Evaluatie |

|---|---|---|

| Primaire Maatstaf | Aantal backlinks en domeinautoriteit | Semantische diepgang en onderwerpdekking |

| Contentaanpak | Zoekwoordoptimalisatie en volume | Uitgebreide, onderling verbonden contentclusters |

| Entiteitsherkenning | Weinig nadruk | Cruciaal voor begrip van verbanden |

| Interne Linkbuilding | Secundaire overweging | Essentieel om expertise te tonen |

| Meetfocus | Domeinniveau-metrics (DA, DR, DP) | Topicniveau-zichtbaarheid en citatiefrequentie |

Large Language Models beoordelen autoriteit via geavanceerde mechanismen die fundamenteel verschillen van traditionele zoekalgoritmes. Wanneer een LLM content tegenkomt, telt het niet simpelweg backlinks of zoekt naar zoekwoordfrequentie; in plaats daarvan gebruikt het patroonherkenning over miljarden documenten om te begrijpen hoe concepten zich tot elkaar verhouden. Het model analyseert entiteitsrelaties—de verbindingen tussen mensen, organisaties, producten en concepten—om te bepalen of een bron het onderwerp echt begrijpt of slechts oppervlakkig benoemt. Semantische rijkdom speelt een cruciale rol, want LLM’s beoordelen de diepte van uitleg, de variatie aan perspectieven en de logische samenhang tussen ideeën. Daarnaast wijst consistentie over meerdere contentstukken op echte expertise; als een domein herhaaldelijk kennis toont over onderling verbonden subonderwerpen, herkent de LLM dit als gezaghebbend.

Belangrijke mechanismen die LLM’s gebruiken om autoriteit te herkennen:

In het LLM-tijdperk is contentdiepte exponentieel waardevoller dan contentvolume. Eén uitgebreide, diepgaande gids van 5.000 woorden die een onderwerp vanuit meerdere invalshoeken, met praktijkvoorbeelden en toepasbare inzichten behandelt, zal het beter doen dan tien artikelen van 500 woorden die het onderwerp slechts oppervlakkig aanraken. Dit principe daagt het traditionele contentmarketinghandboek uit dat kwantiteit beloonde. LLM’s geven de voorkeur aan semantische dekking—de mate waarin content alle relevante dimensies van een onderwerp behandelt—boven zoekwoordherhaling. Door content te maken die een onderwerp vanuit verschillende perspectieven belicht, gerelateerde vragen beantwoordt en verbindingen legt met bredere concepten, bouw je wat onderzoekers topische clusters noemen: netwerken van onderling verbonden content die samen expertise aantonen. Bijvoorbeeld, een financiële dienstverlener die autoriteit wil opbouwen rond “pensioenplanning”, moet content maken over beleggingsstrategieën, belastingimplicaties, zorgkosten, optimalisatie van de sociale zekerheid en estate planning—niet slechts 20 variaties van “hoe plan ik mijn pensioen”. De diepgangsaanpak signaleert aan LLM’s dat je organisatie het onderwerp-ecosysteem echt begrijpt, waardoor je content veel sneller wordt geciteerd in AI-antwoorden.

Effectieve topicclusters creëren vereist een strategische, hiërarchische aanpak van contentorganisatie die expertise signaleert aan zowel gebruikers als LLM’s. De basis van deze strategie is de pillar page—een uitgebreide, gezaghebbende bron die het hoofdonderwerp breed behandelt en dient als hub voor alle gerelateerde content. Hieromheen staan clusterpagina’s, die dieper ingaan op specifieke subonderwerpen en met strategische interne links duidelijk terugverwijzen naar de hoofd-pillar.

Volg deze stappen voor een effectieve topiccluster en interne linkstrategie:

Identificeer je kernpillaronderwerp: Kies een breed onderwerp waar je organisatie echt expertise in heeft en waarvoor marktbehoefte bestaat. Dit moet specifiek genoeg zijn om autoriteit te tonen, maar breed genoeg voor meerdere ondersteunende artikelen. Voorbeeld: “Enterprise Resource Planning (ERP) Implementatie” in plaats van alleen “ERP”.

Kaart gerelateerde subonderwerpen en vragen uit: Gebruik tools als SEMrush, AnswerThePublic en Google’s “Mensen vragen ook” om alle vragen, zorgen en subonderwerpen van je doelgroep te identificeren. Maak een visuele map die toont hoe deze subonderwerpen zich tot de hoofd-pillar en tot elkaar verhouden.

Maak je pillar page: Ontwikkel een uitgebreide gids (3.000-5.000+ woorden) die het hoofdonderwerp holistisch behandelt. Neem een overzicht op van alle subonderwerpen, belangrijke definities en links naar je clustercontent. Gebruik duidelijke koppen en logische structuur zodat zowel gebruikers als LLM’s de inhoud kunnen begrijpen.

Ontwikkel clustercontent: Schrijf 8-15 ondersteunende artikelen die specifieke subonderwerpen diepgaand behandelen. Elk clusterartikel moet 1.500-2.500 woorden zijn en zich richten op één aspect van je pillar. Zorg dat elk artikel teruglinkt naar de pillar met contextuele ankertekst.

Implementeer strategische interne linking: Verbind clusterartikelen onderling waar relevant en creëer zo een netwerk van gerelateerde content. Gebruik beschrijvende ankerteksten met relevante zoekwoorden en entiteitsnamen. Voeg secties “gerelateerde artikelen” en navigatiewidgets toe om verkenning van je contentnetwerk te stimuleren.

Blijf consistent en update regelmatig: Bekijk periodiek je cluster op hiaten, verouderde informatie en nieuwe subonderwerpen. Voeg nieuwe clusterartikelen toe als je onderwerp zich ontwikkelt en werk bestaande content bij voor relevantie en nauwkeurigheid.

Entiteitoptimalisatie betekent een paradigmaverschuiving in hoe we contentstructuur en SEO benaderen. In plaats van optimaliseren voor zoekwoorden, optimaliseren we nu voor entiteiten—de specifieke mensen, organisaties, producten, locaties en concepten waarmee LLM’s contentbetekenis begrijpen. Door entiteiten duidelijk te definiëren en consistent te benoemen in je content, leer je feitelijk het kennisnetwerk van de LLM hoe jouw content zich tot het bredere informatie-ecosysteem verhoudt. Schema markup van Schema.org vormt de technische basis voor entiteitoptimalisatie, waarmee je zoekmachines en LLM’s expliciet vertelt welke entiteiten je content bespreekt en hoe ze zich tot elkaar verhouden.

Praktische tips voor entiteitoptimalisatie:

Definieer kernentiteiten duidelijk: Identificeer de primaire entiteiten in je content (bijv. “Google Analytics”, “conversie-optimalisatie”, “A/B-testen”) en benoem deze expliciet in koppen, subkoppen en de tekst. Vermijd vage termen; wees specifiek over de producten, personen of concepten die je bespreekt.

Gebruik gestructureerde datamarkup: Implementeer Schema.org-markup om entiteiten en hun relaties te definiëren. Gebruik Article schema voor blogposts, Organization schema voor je bedrijf, Product schema voor aanbiedingen en Person schema voor auteursinformatie. Deze gestructureerde data helpt LLM’s de belangrijkste informatie te extraheren en te begrijpen.

Verbind entiteiten aan gezaghebbende bronnen: Link je entiteiten aan gezaghebbende externe referenties zoals Wikipedia, DBpedia en Google Knowledge Graph. Deze externe validatie versterkt de geloofwaardigheid van je entiteitsvermeldingen en helpt LLM’s de context te begrijpen.

Houd entiteitsvermeldingen consistent: Gebruik dezelfde terminologie, spelling en naamgevingsconventies voor entiteiten over al je content, website, social media en brancheplatforms. Consistentie signaleert aan LLM’s dat je over dezelfde entiteit spreekt en bouwt een samenhangende kennisbasis op.

Google’s E-E-A-T-framework—Experience, Expertise, Authoritativeness en Trust—heeft een nieuwe betekenis gekregen nu LLM’s centraal staan in zoekopdrachten. Hoewel deze signalen belangrijk blijven voor traditionele rangschikkingen, is de interpretatie ervan veranderd in AI-gedreven contexten. LLM’s beoordelen deze signalen niet meer alleen via backlinks maar via contentanalyse, auteurscredentials en consistentiepatronen.

Experience toont aan dat je organisatie of auteur directe, praktische ervaring heeft met het onderwerp. LLM’s herkennen ervaring via case studies, klantresultaten, persoonlijke anekdotes van gekwalificeerde auteurs en gedetailleerde procesbeschrijvingen. Claim expertise niet alleen, maar toon het aan met gedocumenteerde voorbeelden van het oplossen van echte problemen. Voeg auteursbio’s toe met relevante achtergrond en gebruik testimonials of resultaten van daadwerkelijke klanten of gebruikers.

Expertise blijkt uit uitgebreide, genuanceerde content die diepgaande vakkennis aantoont. LLM’s beoordelen expertise door te kijken of je content randgevallen behandelt, complexiteit erkent, relevant onderzoek citeert en inzichten biedt die verder gaan dan oppervlakkige informatie. Publiceer content over geavanceerde onderwerpen, verken tegenintuïtieve bevindingen en toon kennis van branchedebatten en veranderende best practices.

Authoritativeness in het LLM-tijdperk komt voort uit erkenning als toonaangevende bron in je veld. Dit bouw je op door consistente publicatie van hoogwaardige content, citaties van andere autoriteiten, sprekersrollen, gepubliceerde onderzoeken en branche-erkenning. LLM’s volgen welke bronnen vaak samen worden geciteerd en welke bronnen verschijnen bij antwoorden op gezaghebbende zoekopdrachten.

Trust wordt opgebouwd door transparantie, nauwkeurigheid en verantwoordelijkheid. Zet publicatiedata en update-tijdstempels op al je content, citeer je bronnen duidelijk, vermeld mogelijke belangenconflicten en corrigeer fouten snel. Gebruik auteursreferenties, professionele certificeringen en lidmaatschappen om legitimiteit te tonen. LLM’s worden steeds beter in het detecteren van misleidende claims en belonen bronnen die nauwkeurigheid boven sensatie stellen.

Het volgen van topische autoriteitsmetrics vereist een verschuiving van traditionele SEO-metingen naar nieuwe indicatoren die weerspiegelen hoe LLM’s jouw expertise waarnemen. Terwijl Domein Autoriteit en Domein Rating relevant blijven voor traditionele zoekopdrachten, tonen ze een zwakke correlatie met LLM-zichtbaarheid—onderzoek van Search Atlas onder 21.767 domeinen vond correlaties tussen autoriteitsmetrics en LLM-zichtbaarheid van -0,08 tot -0,21, wat aangeeft dat traditionele signalen weinig invloed hebben op AI-resultaten.

Belangrijke metrics en tools voor het monitoren van topische autoriteit zijn:

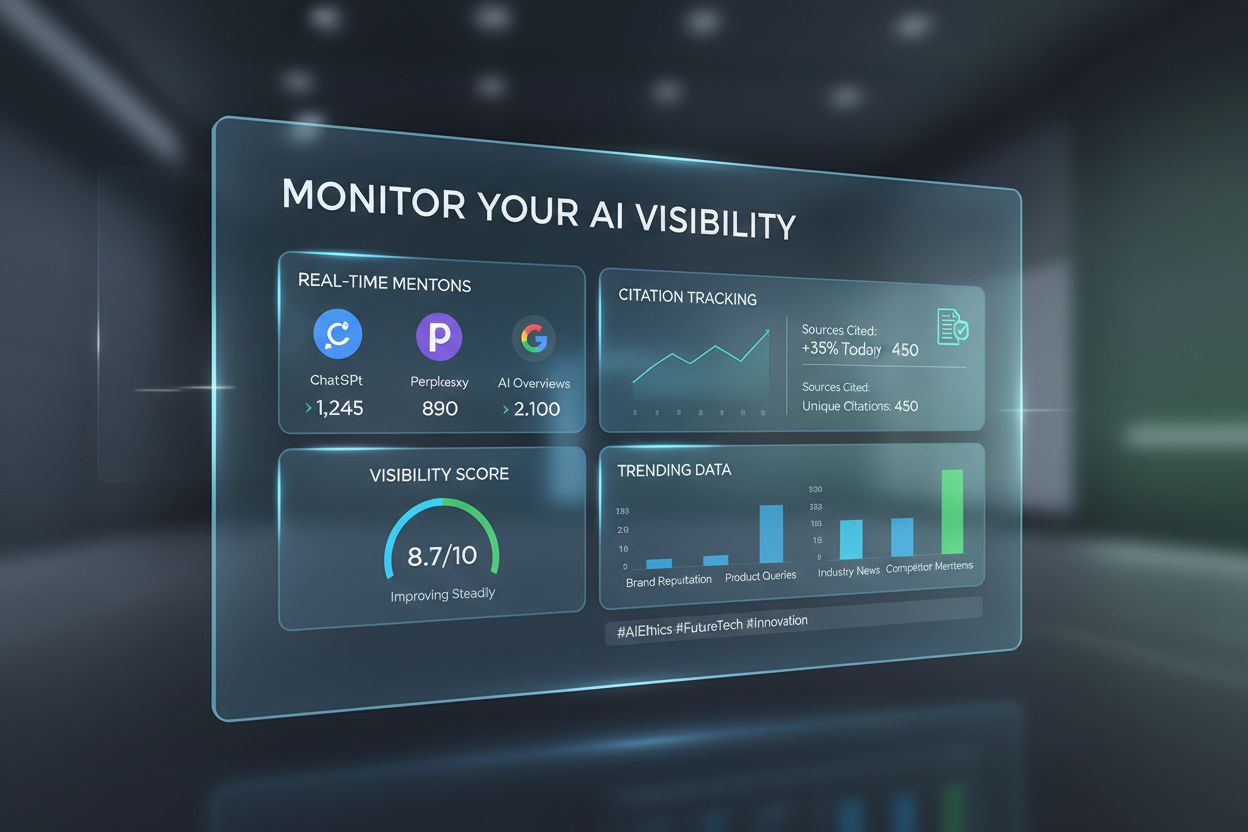

LLM Zichtbaarheidsscore: Volg hoe vaak en prominent je content verschijnt in antwoorden van ChatGPT, Gemini en Perplexity. Tools zoals de LLM Visibility-feature van Search Atlas meten citatiefrequentie en zichtbaarheid over meerdere modellen.

Topicniveau-verkeer: Monitor organisch verkeer niet alleen op zoekwoordniveau, maar voor hele topicclusters. Gebruik Google Analytics om verkeer per onderwerp te segmenteren en te volgen of je zichtbaarheid krijgt voor meerdere gerelateerde vragen.

Contentvolledigheidsmetrics: Beoordeel of je content alle belangrijke subonderwerpen en vragen rondom je hoofdonderwerp behandelt. Tools als Clearscope en MarketMuse meten topicdekking en signaleren contenthiaten.

Sterkte Interne Linkstructuur: Analyseer je interne linkstructuur om te zorgen dat clusterpagina’s logisch verbonden zijn met pilaren en met elkaar. Tools als Screaming Frog visualiseren en optimaliseren je interne linking.

Tracking van Entiteitconsistentie: Monitor of je sleutelentiteiten consequent benoemt en definieert in je content. Tools als Google Search Console tonen met welke entiteiten je content wordt geassocieerd in zoekresultaten.

Veel organisaties die topische autoriteit nastreven, ondermijnen hun inspanningen onbedoeld door vermijdbare fouten. Inzicht in deze valkuilen voorkomt dat je middelen verspilt aan ineffectieve strategieën.

Veelgemaakte fouten zijn onder andere:

Dunne content publiceren: Tientallen korte artikelen (300-500 woorden) maken die een onderwerp slechts oppervlakkig aanraken. LLM’s herkennen dit als onvoldoende dekking en verkiezen minder maar meer uitgebreide bronnen.

Slechte interne linkstructuur: Gerelateerde content niet verbinden of generieke ankertekst zoals “klik hier” gebruiken in plaats van beschrijvende, entiteitsrijke ankertekst. Hierdoor begrijpen LLM’s niet hoe je content samenhangt.

Inconsistente entiteitsvermeldingen: Verschillende termen gebruiken voor hetzelfde concept in verschillende artikelen (bijv. “conversie-optimalisatie” in het ene artikel, “CRO” in een ander, “conversies verbeteren” in een derde). Dit voorkomt dat LLM’s je expertise als consistent herkennen.

Contenthiaten negeren: Over sommige aspecten van een onderwerp publiceren en belangrijke subonderwerpen onbesproken laten. LLM’s zien onvolledige dekking en kunnen concurrenten met meer uitgebreide bronnen verkiezen.

Contentupdates verwaarlozen: Oude content laten verouderen terwijl nieuwe artikelen over hetzelfde onderwerp verschijnen. Dit veroorzaakt redundantie en verwarring over welke bron je actuele expertise vertegenwoordigt.

Topische autoriteit opbouwen is een gestructureerd proces dat planning, uitvoering en voortdurende optimalisatie vereist. Dit stappenplan biedt een heldere route.

Volg deze roadmap voor LLM-herkende topische autoriteit:

Voer een topische autoriteitsaudit uit: Analyseer je bestaande content om je sterkste onderwerpen en hiaten te identificeren. Kaart uit welke onderwerpen je nu behandelt, welke subonderwerpen ontbreken en waar je content dun of verouderd is. Gebruik tools als SEMrush Topic Research en Ahrefs om te zien wat concurrenten behandelen.

Definieer je kern-topische pilaren: Kies 3-5 hoofdonderwerpen waar je organisatie echt expertise in heeft en waarvoor marktvraag bestaat. Deze moeten specifiek genoeg zijn om autoriteit te tonen, maar breed genoeg voor meerdere ondersteunende artikelen. Leg vast waarom jouw organisatie uniek gekwalificeerd is om hierover te spreken.

Maak een uitgebreide contentmap: Ontwikkel een visuele weergave van je pillarpagina’s en clustercontent. Geef aan hoe subonderwerpen zich tot de hoofdonderwerpen en tot elkaar verhouden. Identificeer welke content al bestaat, welke nog gemaakt moet worden en welke geconsolideerd of verwijderd moet worden.

Ontwikkel of vernieuw pillarpagina’s: Maak uitgebreide pillarpagina’s (3.000-5.000+ woorden) voor elk hoofdonderwerp. Zorg dat elke pillar het onderwerp breed behandelt, kernentiteiten duidelijk definieert en naar alle ondersteunende clustercontent linkt. Optimaliseer pilaren met schema markup zodat LLM’s de structuur begrijpen.

Bouw clustercontent en interne linking: Creëer 8-15 ondersteunende artikelen per pillar, die elk een specifiek subonderwerp diepgaand behandelen. Implementeer strategische interne linking met beschrijvende ankertekst. Zorg dat clusterartikelen teruglinken naar de pillar en naar relevante andere clusters.

Implementeer entiteitoptimalisatie en schema markup: Voeg Schema.org-markup toe in je content om entiteiten en hun relaties expliciet te definiëren. Zorg voor consistente entiteitsvermeldingen over alle content. Link entiteiten aan gezaghebbende externe bronnen voor meer geloofwaardigheid.

Naarmate je topische autoriteit groeit, wordt het essentieel om te volgen hoe dit zich vertaalt naar zichtbaarheid in AI-systemen. AmICited is een gespecialiseerd platform om de aanwezigheid en citaties van je merk over Large Language Models te monitoren, en biedt inzicht in hoe AI-systemen jouw content herkennen en benoemen. In tegenstelling tot traditionele SEO-tools die zich richten op Google-rangschikkingen, volgt AmICited specifiek de LLM-zichtbaarheid—hoe vaak en hoe prominent je merk verschijnt in antwoorden van ChatGPT, Gemini, Perplexity en andere generatieve AI-platforms.

Het platform biedt meerdere voordelen bij het monitoren van je autoriteit in AI:

Cross-platform citatie-tracking: Volg je merkvermeldingen en citaties over meerdere LLM’s tegelijk, zodat je ziet welke platforms jouw autoriteit het sterkst erkennen en waar nog zichtbaarheidshiaten zijn.

Concurrentiebenchmarking: Vergelijk je LLM-zichtbaarheid met concurrenten in je branche. Zie welke concurrenten vaker worden geciteerd en analyseer hun contentstrategie voor kansen.

Analyse van citatiecontext: Zie niet alleen dát je geciteerd wordt, maar ook hóe. Begrijp welke onderwerpen je citaties triggeren, in welke context LLM’s je merk noemen en of citaties positief en accuraat zijn.

Monitoring van zichtbaarheidstrends: Volg hoe je LLM-zichtbaarheid verandert in de tijd naarmate je je topische autoriteit verbetert. Meet de impact van nieuwe content, updates en structurele veranderingen op je AI-zichtbaarheid.

Inzichten in autoriteitssignalen: Ontvang aanbevelingen over welke contenthiaten je moet vullen, welke onderwerpen je kunt uitbreiden en welke entiteiten je moet optimaliseren op basis van LLM-citatiepatronen en concurrentieanalyse.

Door AmICited naast traditionele SEO-tools te gebruiken, krijg je een volledig beeld van je autoriteit in zowel klassieke zoekopdrachten als AI-gestuurde vindbaarheid. Dit dubbele perspectief is essentieel in 2025 en daarna, nu LLM-gedreven zoekopdrachten centraal staan in hoe gebruikers informatie ontdekken. Merken die zowel traditionele als AI-zichtbaarheid monitoren en optimaliseren, behouden hun concurrentievoordeel nu zoeken steeds meer richting conversatie en AI-antwoorden verschuift.

Topische autoriteit meet hoe uitgebreid en consistent je een onderwerp behandelt, terwijl zoekwoordrangschikking zich richt op individuele zoektermen. LLM's beoordelen topische autoriteit door semantische diepgang, entiteitsrelaties en onderlinge contentverbondenheid te analyseren. Een site kan scoren op specifieke zoekwoorden zonder echt topische autoriteit te hebben, maar topische autoriteit leidt doorgaans tot zichtbaarheid bij meerdere gerelateerde zoekopdrachten en AI-gegenereerde antwoorden.

Topische autoriteit opbouwen is een langetermijnstrategie die doorgaans 3-6 maanden vereist voor de eerste resultaten en 6-12 maanden voor sterke erkenning. De tijdlijn hangt af van je uitgangspunt, contentkwaliteit, concurrentieniveau en hoe consequent je de strategie uitvoert. LLM's herkennen autoriteit aan patronen over tijd, dus consistentie en diepgang zijn belangrijker dan snelheid.

Ja, absoluut. In tegenstelling tot traditionele autoriteitsmetingen die gevestigde domeinen met veel backlinks bevoordelen, beoordelen LLM's topische autoriteit op basis van semantische diepgang en contentkwaliteit. Een klein merk met 10 uitgebreide, onderling verbonden artikelen over een specifiek onderwerp kan een grote uitgever met 100 oppervlakkige artikelen overtreffen. Focus op diepgang, consistentie en entiteitoptimalisatie in plaats van proberen het volume te evenaren.

Backlinks blijven relevant voor traditionele Google-rangschikkingen, maar laten een zwakke correlatie zien met LLM-zichtbaarheid. Onderzoek toont correlaties tussen traditionele autoriteitsmetingen en LLM-zichtbaarheid van -0,08 tot -0,21. Terwijl backlinks nog steeds tellen voor SEO, geven LLM's prioriteit aan semantische relevantie, contentdiepgang en entiteitsrelaties. Focus op het creëren van uitzonderlijke content die vanzelf citaties aantrekt in plaats van links na te jagen omwille van de links zelf.

Signalen van topische autoriteit zijn: verschijnen in AI-gegenereerde antwoorden voor meerdere gerelateerde vragen, consistente citaties over verschillende LLM's, scoren op topicclusters in plaats van losse zoekwoorden, hoge betrokkenheidsstatistieken op pijler- en clustercontent, en erkenning als toonaangevende bron in je branche. Gebruik tools zoals AmICited om LLM-citaties te volgen en Search Atlas om zichtbaarheid op onderwerp te monitoren.

Je moet op beide focussen, maar met verschillende prioriteiten. Topische autoriteit wordt steeds belangrijker voor AI-gestuurde vindbaarheid en langdurige zichtbaarheid, terwijl traditionele SEO essentieel blijft voor Google-rangschikkingen. Het goede nieuws is dat strategieën voor topische autoriteit (semantische diepgang, entiteitoptimalisatie, contentclusters) ook traditionele SEO verbeteren. Begin met topische autoriteit als basis, dan volgen de SEO-voordelen vanzelf.

Gebruikersbetrokkenheidssignalen zoals leestijd, scrolldiepte en terugkerende bezoeken tonen LLM's dat je content echte waarde biedt. Wanneer gebruikers tijd besteden aan je content en gerelateerde artikelen binnen je cluster verkennen, geeft dat aan dat je content uitgebreid en gezaghebbend is. LLM's interpreteren deze betrokkenheidspatronen als indicatoren van contentkwaliteit en relevantie, waardoor optimalisatie van gebruikerservaring essentieel is voor topische autoriteit.

LLM's analyseren hoe je verschillende entiteiten (personen, organisaties, producten, concepten) benoemt en met elkaar verbindt in je content. Wanneer je consequent gerelateerde entiteiten noemt en hun verbanden uitlegt, zien LLM's dit als bewijs van diepgaand begrip. Schema markup helpt door entiteitsrelaties expliciet te definiëren. Bijvoorbeeld, 'pensioenplanning' verbinden met 'Sociale Zekerheid', 'beleggingsstrategieën' en 'belastingoptimalisatie' toont aan dat je het onderwerp-ecosysteem begrijpt.

Volg hoe LLM's jouw content citeren en meet je topische autoriteit over ChatGPT, Gemini en Perplexity met AmICited's AI-monitoringplatform.

Ontdek hoe AI-systemen contentkwaliteit beoordelen buiten traditionele SEO-maatstaven. Leer over semantisch begrip, feitelijke juistheid en kwaliteitssignalen d...

Leer hoe je autoriteit opbouwt voor AI-zichtbaarheid. Ontdek E-E-A-T strategieën, topische autoriteit en hoe je genoemd wordt in AI Overviews en LLM-antwoorden....

Leer bewezen strategieën voor bronvermelding om je content LLM-betrouwbaar te maken. Ontdek hoe je AI-vermeldingen verdient van ChatGPT, Perplexity en Google AI...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.