Hoe Casestudy's Presteren in AI-zoekresultaten

Ontdek hoe casestudy's scoren in AI-zoekmachines zoals ChatGPT, Perplexity en Google AI Overviews. Leer waarom AI-systemen casestudy's als gezaghebbende bronnen...

Leer hoe je case studies formatteert voor AI-bronvermeldingen. Ontdek het stappenplan voor het structureren van succesverhalen die LLMs citeren in AI Overviews, ChatGPT en Perplexity.

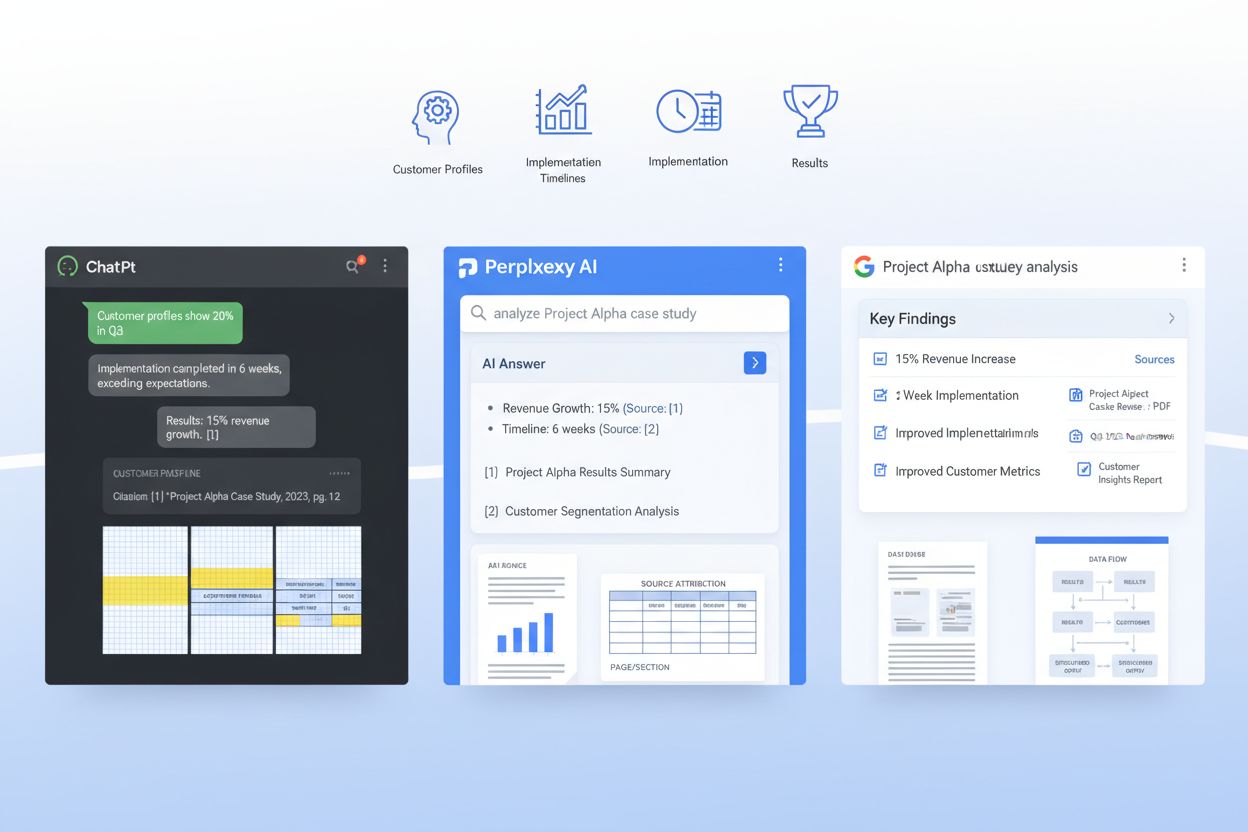

AI-systemen zoals ChatGPT, Perplexity en Google’s AI Overviews veranderen fundamenteel hoe B2B-kopers case studies ontdekken en valideren—maar de meeste bedrijven publiceren ze nog steeds in formats die LLMs nauwelijks kunnen ontleden. Wanneer een zakelijke koper aan een AI-systeem vraagt: “Welke SaaS-platforms werken het best voor ons gebruik?”, doorzoekt het systeem miljoenen documenten op zoek naar relevante bewijzen, maar slecht geformatteerde case studies blijven onzichtbaar voor deze retrievalsystemen. Dit creëert een cruciale kloof: terwijl traditionele case studies een basis-winstpercentage van 21% opleveren in late-stage deals, kunnen AI-geoptimaliseerde case studies de kans op bronvermelding met 28-40% verhogen wanneer ze correct gestructureerd zijn voor machine learning modellen. De bedrijven die in dit nieuwe landschap winnen, begrijpen dat voorsprong met eigen data voortkomt uit vindbaar zijn voor AI-systemen, niet alleen voor menselijke lezers. Zonder bewuste optimalisatie voor LLM-retrieval zijn je meest overtuigende klantverhalen in feite opgesloten voor de AI-systemen die nu meer dan 60% van de zakelijke aankoopbeslissingen beïnvloeden.

Een AI-klaar case study is niet alleen een goed geschreven verhaal—het is een strategisch gestructureerd document dat zowel menselijke lezers als machine learning modellen tegelijk bedient. De meest effectieve case studies volgen een consistente opbouw die LLMs in staat stelt belangrijke informatie te extraheren, context te begrijpen en je bedrijf met vertrouwen te citeren. Hieronder vind je het essentiële stappenplan dat AI-vindbare case studies onderscheidt van verhalen die verloren gaan in retrievalsystemen:

| Sectie | Doel | AI-optimalisatie |

|---|---|---|

| TL;DR Samenvatting | Directe context voor drukke lezers | Bovenaan geplaatst voor vroege tokenconsumptie; 50-75 woorden |

| Klantsnapshot | Snelle identificatie van bedrijfsprofiel | Gestructureerd als: Industrie / Bedrijfsgrootte / Locatie / Rol |

| Zakelijke Context | Probleemstelling en marktsituatie | Gebruik consistente terminologie; vermijd jargonvariaties |

| Doelstellingen | Specifieke, meetbare doelen van de klant | Formatteer als genummerde lijst; met gekwantificeerde targets |

| Oplossing | Hoe jouw product/dienst de behoefte invulde | Leg feature-to-benefit mapping expliciet uit |

| Implementatie | Tijdlijn, proces en adoptiedetails | Opsplitsen in fases; incl. duur en mijlpalen |

| Resultaten | Gekwantificeerde uitkomsten en impactmetrics | Presenteer als: Metric / Basislijn / Eindresultaat / Verbetering % |

| Bewijs | Data, screenshots, of derde partij validatie | Voeg tabellen toe voor metrics; citeer bronnen duidelijk |

| Klantcitaten | Authentieke stem en emotionele bevestiging | Toeschrijven met naam, titel, bedrijf; 1-2 zinnen elk |

| Hergebruik-signalen | Interne links en cross-promotie hooks | Stel gerelateerde case studies, webinars of resources voor |

Deze structuur zorgt ervoor dat elke sectie een dubbele functie heeft: het leest natuurlijk voor mensen en biedt semantische helderheid voor RAG-systemen (Retrieval-Augmented Generation) waarop moderne LLMs draaien. De consistentie van dit format in je case study-bibliotheek maakt het exponentieel makkelijker voor AI-systemen om vergelijkbare datapunten te extraheren en je bedrijf met vertrouwen te citeren.

Naast structuur hebben de specifieke formattingkeuzes die je maakt grote impact op of AI-systemen je case studies daadwerkelijk kunnen vinden en citeren. LLMs verwerken documenten anders dan mensen—ze scannen niet of gebruiken visuele hiërarchie zoals lezers, maar zijn zeer gevoelig voor semantische markeringen en consistente formatpatronen. Dit zijn de formattingelementen die AI-retrieval het meest versterken:

Deze formattingkeuzes zijn niet esthetisch bedoeld—ze zijn gericht op machineleesbaarheid, zodat wanneer een LLM zoekt naar relevante bewijzen, jouw bedrijfsverhaal het verhaal is dat geciteerd wordt.

De meest geavanceerde aanpak voor AI-klare case studies is het direct inbedden van een JSON-schema in je case study-document of metadata-laag, waarmee je een dubbele laag creëert waarbij mensen het verhaal lezen en machines de gestructureerde data verwerken. JSON-schema’s bieden LLMs ondubbelzinnige, machineleesbare representaties van de belangrijkste informatie van je case study, wat de nauwkeurigheid en relevantie van bronvermeldingen aanzienlijk verbetert. Zo structureer je dit:

{

"@context": "https://schema.org",

"@type": "CaseStudy",

"name": "Enterprise SaaS Platform verkort onboardingtijd met 60%",

"customer": {

"name": "TechCorp Industries",

"industry": "Financiële Dienstverlening",

"companySize": "500-1000 medewerkers",

"location": "San Francisco, CA"

},

"solution": {

"productName": "Jouw Productnaam",

"category": "Workflow Automatisering",

"implementationDuration": "8 weken"

},

"results": {

"metrics": [

{"name": "Verkorting Onboardingtijd", "baseline": "120 dagen", "final": "48 dagen", "improvement": "60%"},

{"name": "Gebruikersadoptiegraad", "baseline": "45%", "final": "89%", "improvement": "97%"},

{"name": "Reductie Supporttickets", "baseline": "450/maand", "final": "120/maand", "improvement": "73%"}

]

},

"datePublished": "2024-01-15",

"author": {"@type": "Organization", "name": "Jouw Bedrijf"}

}

Door schema.org-conforme JSON-structuren te implementeren, geef je LLMs in feite een gestandaardiseerde manier om je case study te begrijpen en te citeren. Deze aanpak integreert naadloos met RAG-systemen, waardoor AI-modellen exacte metrics kunnen extraheren, klantcontext begrijpen en bronvermeldingen met vertrouwen aan jouw bedrijf kunnen toeschrijven. Bedrijven die JSON-gestructureerde case studies gebruiken zien 3-4x hogere citatienauwkeurigheid in AI-gegenereerde antwoorden dan alleen narratieve formats.

RAG-systemen verwerken je hele case study niet als één monolithisch blok—ze delen het op in semantische chunks die in het contextvenster van een LLM passen, en hoe je document gestructureerd is, bepaalt direct of die chunks bruikbaar of gefragmenteerd zijn. Effectief chunking betekent dat je je case study zo organiseert dat natuurlijke semantische grenzen overeenkomen met hoe RAG-systemen de content opdelen. Dit vereist bewuste paragraafgrootte: elke paragraaf focust op één idee of datapunt, typisch 100-150 woorden, zodat een RAG-systeem bij het extraheren van een chunk altijd complete, samenhangende informatie krijgt in plaats van verdwaalde zinnen. Narratieve scheiding is cruciaal—gebruik duidelijke sectieonderbrekingen tussen probleemstelling, oplossingsbeschrijving en resultaten zodat een LLM “de resultatensectie” als een samenhangende eenheid kan extraheren zonder deze per ongeluk te vermengen met implementatiedetails. Bovendien is tokenefficiëntie belangrijk: door metrics als tabellen te presenteren in plaats van proza, verlaag je het aantal tokens dat nodig is om dezelfde informatie over te brengen, waardoor LLMs meer van je case study in hun antwoord kunnen opnemen zonder contextlimieten te overschrijden. Het doel is je case study “RAG-vriendelijk” te maken, zodat elke chunk die een AI-systeem eruit haalt, zelfstandig waardevol is en goed in context staat.

Case studies publiceren voor AI-systemen vereist de balans tussen de specificiteit die ze geloofwaardig maakt en de vertrouwelijkheidsverplichtingen tegenover je klanten. Veel bedrijven aarzelen om gedetailleerde case studies te publiceren uit angst om gevoelige bedrijfsinformatie prijs te geven, maar strategische redactie en anonimisering stellen je in staat zowel transparantie als vertrouwen te behouden. De meest effectieve aanpak is het maken van meerdere versies van elke case study: een volledig gedetailleerde interne versie met klantnamen, exacte metrics en propriëtaire implementatiedetails, en een publieke AI-geoptimaliseerde versie waarin de klant geanonimiseerd is, maar de gekwantificeerde impact en strategische inzichten behouden blijven. In plaats van “TechCorp Industries bespaarde $2,3 miljoen per jaar” publiceer je bijvoorbeeld “Middenmarkt financiële dienstverlener verlaagde operationele kosten met 34%"—de metric is nog steeds specifiek genoeg om door LLMs te worden geciteerd, maar de identiteit van de klant blijft beschermd. Versiebeheer en compliance tracking zijn essentieel: houd bij welke informatie is geredigeerd, waarom en wanneer, zodat je case study-bibliotheek altijd auditklaar blijft. Deze governance-aanpak versterkt je AI-citatie strategie juist, omdat je vaker en sneller case studies kunt publiceren zonder juridische obstakels, waardoor LLMs meer bewijspunten vinden en citeren.

Voordat je een case study publiceert, valideer of hij daadwerkelijk goed presteert wanneer hij door LLMs en RAG-systemen wordt verwerkt—ga er niet vanuit dat goede formatting automatisch tot goede AI-prestaties leidt. Door je case studies te testen op echte AI-systemen ontdek je of je structuur, metadata en content daadwerkelijk correcte bronvermelding en retrieval mogelijk maken. Vijf essentiële testmethoden:

Voer deze tests elk kwartaal uit naarmate LLM-gedrag evolueert en gebruik de resultaten om je case study-formatting en structuur te verbeteren.

Het meten van het effect van AI-geoptimaliseerde case studies vereist het bijhouden van zowel AI-zijde metrics (hoe vaak je case studies door LLMs geciteerd worden) als menselijke metrics (hoe die citaties daadwerkelijk deals beïnvloeden). Aan de AI-zijde gebruik je AmICited.com om citatiefrequentie te monitoren in ChatGPT, Perplexity en Google AI Overviews—bekijk hoe vaak je bedrijf verschijnt in AI-gegenereerde antwoorden voor relevante zoekopdrachten, en of de frequentie stijgt nadat je nieuwe AI-klare case studies publiceert. Meet je huidige citatiegraad, stel dan als doel om binnen zes maanden na AI-ready formatting het aantal citaties met 40-60% te verhogen. Aan de menselijke kant koppel je het toenemen van AI-citaties aan vervolgmetrics: houd bij hoeveel deals vermelden “ik vond jullie via een AI-zoekopdracht” of “een AI raadde jullie case study aan”, meet de verbetering van het winstpercentage in deals waarbij je case study door een AI genoemd werd (streef: 28-40% verbetering t.o.v. de 21% baseline), en volg de verkorting van de salescyclus bij accounts die je case study via AI ontdekten. Monitor daarnaast SEO-metrics—AI-geoptimaliseerde case studies met correcte schema-markup scoren vaak beter in traditionele zoekresultaten, wat een dubbel voordeel oplevert. Kwalitatieve feedback van je salesteam is even belangrijk: vraag of prospects met meer productkennis binnenkomen en of case study-citaties de tijd voor bezwaren verminderen. De ultieme KPI is omzet: houd de extra ARR bij die toe te schrijven is aan deals beïnvloed door AI-geciteerde case studies, en je hebt een duidelijke ROI-onderbouwing voor blijvende investering in dit format.

Case studies optimaliseren voor AI-citaties levert alleen rendement op als het proces geoperationaliseerd en herhaalbaar wordt, niet slechts een eenmalig project. Begin met het vastleggen van je AI-klare case study-template in een gestandaardiseerd format dat je marketing- en salesteams voor elk nieuw klantverhaal gebruiken—zo waarborg je consistentie in je bibliotheek en bespaar je tijd bij het publiceren van nieuwe case studies. Integreer deze template in je CMS of content management systeem zodat het publiceren van een nieuwe case study automatisch het JSON-schema, de metadata headers en de formattingelementen genereert zonder handmatig werk. Maak van case study-creatie een kwartaal- of maandelijkse routine, geen jaarlijks evenement, want LLMs citeren bedrijven met diepere, recentere case study-bibliotheken vaker. Positioneer case studies als kernonderdeel van je bredere omzetstrategie: laat ze doorwerken in salesmateriaal, productmarketing, demand generation-campagnes en customer success-playbooks. Zet tenslotte een continu verbeterproces op, waarbij je monitort welke case studies de meeste AI-citaties genereren, welke metrics het beste resoneren met LLMs en welke klantsegmenten het vaakst geciteerd worden—gebruik deze inzichten voor de volgende generatie case studies. De bedrijven die winnen in het AI-tijdperk schrijven niet alleen betere case studies; ze behandelen case studies als strategische omzetassets die voortdurende optimalisatie, meting en verfijning vereisen.

Begin met het extraheren van tekst uit je PDF's en het koppelen van bestaande content aan een standaard schema met velden zoals klantprofiel, uitdaging, oplossing en resultaten. Maak vervolgens van elk verhaal een lichte HTML- of CMS-versie met duidelijke koppen en metadata, waarbij je het originele PDF-bestand aanbiedt als downloadbare asset in plaats van als primaire bron voor AI-opvraging.

Marketing of productmarketing beheert doorgaans het verhaal, maar sales, solutions engineering en customer success moeten ruwe data, implementatiedetails en validatie aanleveren. Juridische zaken, privacy en RevOps helpen bij governance, correcte anonimisering en afstemming op bestaande systemen zoals je CRM en sales enablement-platforms.

Een headless CMS of gestructureerd contentplatform is ideaal voor het opslaan van schema's en metadata, terwijl een CRM of sales enablement-tool de juiste verhalen in de workflow kan aanbieden. Voor AI-opvraging combineer je meestal een vectordatabank met een LLM-orkestratielaag zoals LangChain of LlamaIndex.

Transcribeer videogetuigenissen en webinars en voorzie de transcripties vervolgens van dezelfde velden en secties als je geschreven case studies, zodat AI ze kan citeren. Voeg bij grafieken en diagrammen korte alt-teksten of bijschriften toe die het belangrijkste inzicht beschrijven, zodat retrievalmodellen visuele assets aan specifieke vragen kunnen koppelen.

Houd je kernschema en ID's wereldwijd consistent en maak vervolgens vertaalde varianten die taal, valuta en regelgeving lokaal maken, terwijl je canonieke metrics behoudt. Sla versies per land of regio op als afzonderlijke maar gekoppelde objecten, zodat AI-systemen antwoorden in de taal van de gebruiker kunnen prioriteren zonder je datamodel te fragmenteren.

Evalueer impactvolle case studies minimaal jaarlijks, of sneller bij grote productwijzigingen, nieuwe metrics of gewijzigde klantcontext. Gebruik een eenvoudige versiebeheerworkflow met laatst-beoordeelde data en statusvlaggen om aan zowel AI-systemen als mensen te signaleren welke verhalen het meest actueel zijn.

Integreer het ophalen van case studies rechtstreeks in de tools die vertegenwoordigers al gebruiken en maak concrete playbooks die laten zien hoe je de assistent om relevante bewijzen vraagt. Stimuleer adoptie door succesverhalen te delen waarin op maat gemaakte, door AI gevonden case studies hielpen om sneller deals te sluiten of nieuwe stakeholders te overtuigen.

Traditionele case studies zijn geschreven voor menselijke lezers met een verhalende opbouw en visueel ontwerp. AI-geoptimaliseerde case studies behouden dat verhaal, maar voegen gestructureerde metadata, consistente opmaak, JSON-schema's en semantische duidelijkheid toe, zodat LLMs specifieke informatie kunnen extraheren, begrijpen en met meer dan 96% nauwkeurigheid kunnen citeren.

Volg hoe AI-systemen uw merk citeren in ChatGPT, Perplexity en Google AI Overviews. Krijg inzicht in uw AI-zichtbaarheid en optimaliseer uw contentstrategie.

Ontdek hoe casestudy's scoren in AI-zoekmachines zoals ChatGPT, Perplexity en Google AI Overviews. Leer waarom AI-systemen casestudy's als gezaghebbende bronnen...

Ontdek hoe Smart Rent 345% meer leads genereerde via AI-citaties. Echte case study met B2B leadgeneratie strategie, resultaten en implementatietactieken voor AI...

Discussie binnen de community over hoe case studies presteren in AI-zoekresultaten. Echte ervaringen van marketeers die het citeren van hun case studies in Chat...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.