LLM Meta-antwoorden

Ontdek wat LLM Meta-antwoorden zijn en hoe je je content optimaliseert voor zichtbaarheid in AI-gegenereerde reacties van ChatGPT, Perplexity en Google AI Overv...

Leer hoe je LLM meta-antwoorden maakt die door AI-systemen worden geciteerd. Ontdek structuurtechnieken, strategieën voor antwoorddichtheid en citaatklare contentformaten die de zichtbaarheid in AI-zoekresultaten vergroten.

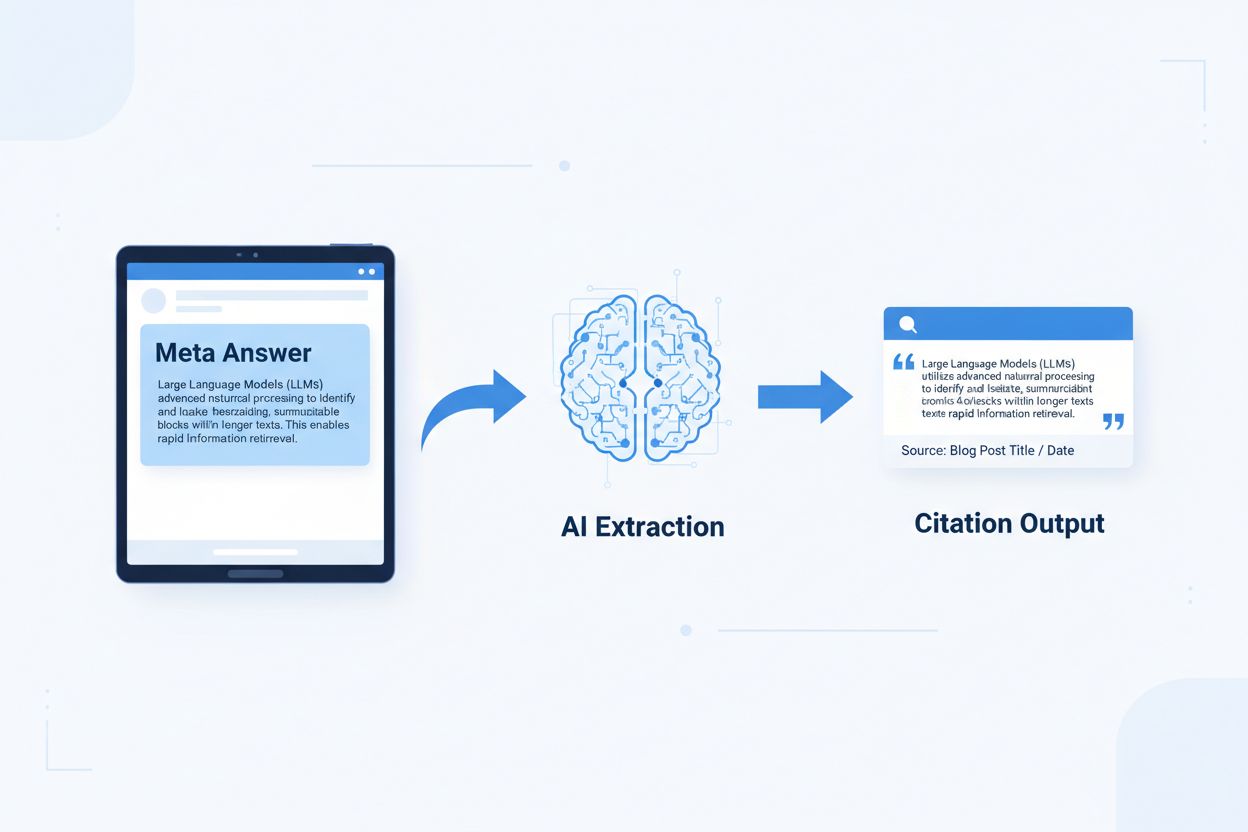

LLM meta-antwoorden zijn op zichzelf staande, AI-geoptimaliseerde contentblokken die direct door taalmodellen kunnen worden geëxtraheerd en geciteerd zonder extra context. In tegenstelling tot traditionele webinhoud die afhankelijk is van navigatie, koppen en omringende context voor betekenis, functioneren meta-antwoorden als op zichzelf staande inzichten die hun volledige semantische waarde behouden wanneer ze geïsoleerd worden. Dit onderscheid is belangrijk omdat moderne AI-systemen websites niet lezen zoals mensen dat doen—ze splitsen content in stukken, beoordelen relevantie en extraheren passages ter ondersteuning van hun antwoorden. Wanneer AI goed gestructureerde meta-antwoorden tegenkomt, kan het deze met vertrouwen citeren omdat de informatie compleet, verifieerbaar en contextueel onafhankelijk is. Onderzoek van Onely geeft aan dat inhoud geoptimaliseerd voor AI-citatie 3-5x vaker wordt genoemd in LLM-uitvoer in vergelijking met traditioneel opgemaakte inhoud, wat de merkzichtbaarheid in door AI gegenereerde antwoorden direct beïnvloedt. Deze verschuiving betekent een fundamentele verandering in hoe content presteert: in plaats van te concurreren om zoekrangschikkingen, concurreren meta-antwoorden om opname in AI-antwoorden. Citatiemonitoringplatforms zoals AmICited.com volgen deze AI-vermeldingen nu als een cruciale prestatie-indicator, en tonen aan dat organisaties met citaatklare inhoud meetbare stijgingen zien in AI-gedreven verkeer en merkauthoriteit. Het verband is direct—inhoud gestructureerd als meta-antwoorden wordt vaker geciteerd, wat de merkzichtbaarheid vergroot in een AI-first informatielandschap.

Citaatklare inhoud vereist specifieke structurele elementen die aan AI-systemen signaleren: “Dit is een volledig, citeren waardig antwoord.” De meest effectieve meta-antwoorden combineren duidelijke topicszinnen, ondersteunend bewijs en op zichzelf staande conclusies binnen één logische eenheid. Deze elementen werken samen om te creëren wat AI-systemen herkennen als extraheerbare kennis—informatie die zelfstandig kan staan zonder dat lezers de bronpagina hoeven te bezoeken. De structurele aanpak verschilt fundamenteel van traditionele webinhoud, die vaak informatie over meerdere pagina’s verspreidt en vertrouwt op interne links om context te bieden.

| Citaatklaar element | Waarom AI-systemen dit prefereren |

|---|---|

| Topiczin met claim | Signaleert direct de kernwaarde van het antwoord; AI kan relevantie beoordelen in de eerste 20 tokens |

| Ondersteunend bewijs (data/voorbeelden) | Biedt verifieerbare onderbouwing; verhoogt vertrouwen in de nauwkeurigheid van de citatie |

| Specifieke meetwaarden of statistieken | Kwantitatieve claims worden vaker geciteerd; vermindert ambiguïteit |

| Definitie of uitleg | Zorgt voor zelfstandige begrijpelijkheid; AI heeft geen externe context nodig |

| Actiegerichte conclusie | Signaleert volledigheid; geeft aan dat het antwoord afgerond is |

| Bronvermelding | Bouwt vertrouwen op; AI-systemen geven de voorkeur aan inhoud met duidelijke herkomst |

Implementatietips voor maximale AI-extractie:

De optimale chunkgrootte voor AI-extractie ligt tussen 256-512 tokens, ongeveer gelijk aan 2-4 goed gestructureerde alinea’s. Dit bereik is ideaal omdat AI-systemen zo betekenisvolle informatie kunnen extraheren zonder context te verliezen of irrelevante details op te nemen. Chunks kleiner dan 256 tokens missen vaak voldoende context voor zekere citatie, terwijl chunks boven 512 tokens AI-systemen dwingen samen te vatten of af te kappen, wat directe citeerbaarheid vermindert. Chunken op basis van alinea’s—waarbij elke alinea een complete gedachte vormt—presteert beter dan willekeurig splitsen op tokens, omdat het semantische samenhang bewaart en de logische stroom behoudt waarop AI-systemen relevantie beoordelen.

Goede chunking bewaart semantische grenzen:

✓ GOED: "Citaatklare inhoud vereist specifieke structurele elementen.

De meest effectieve meta-antwoorden combineren duidelijke topicszinnen,

ondersteunend bewijs en op zichzelf staande conclusies binnen één

logische eenheid. Deze elementen werken samen om te creëren wat

AI-systemen herkennen als extraheerbare kennis."

✗ FOUT: "Citaatklare inhoud vereist specifieke structurele elementen

die aan AI-systemen signaleren: 'Dit is een volledig, citeren waardig antwoord.' De

meest effectieve meta-antwoorden combineren duidelijke topicszinnen, ondersteunend

bewijs en op zichzelf staande conclusies binnen één logische eenheid. Deze

elementen werken samen om te creëren wat AI-systemen herkennen als

extraheerbare kennis—informatie die zelfstandig kan staan zonder dat lezers

de bronpagina hoeven te bezoeken. De structurele aanpak verschilt

fundamenteel van traditionele webinhoud, die vaak informatie over meerdere pagina's

verspreidt en vertrouwt op interne links om context te bieden."

Het goede voorbeeld behoudt semantische samenhang en eindigt op een natuurlijk punt. Het foute voorbeeld combineert meerdere ideeën, waardoor AI-systemen ofwel midden in een gedachte moeten afkappen of irrelevante context moeten meenemen. Overlapstrategieën—waarbij de laatste zin van een chunk vooruitwijst naar de volgende—helpen AI-systemen om inhoudsrelaties te begrijpen zonder extractiekracht te verliezen. Praktische checklist voor chunkingoptimalisatie: Beantwoordt elke chunk één vraag? Is het begrijpelijk zonder omliggende alinea’s te lezen? Bevat het 256-512 tokens? Eindigt het op een natuurlijke semantische grens?

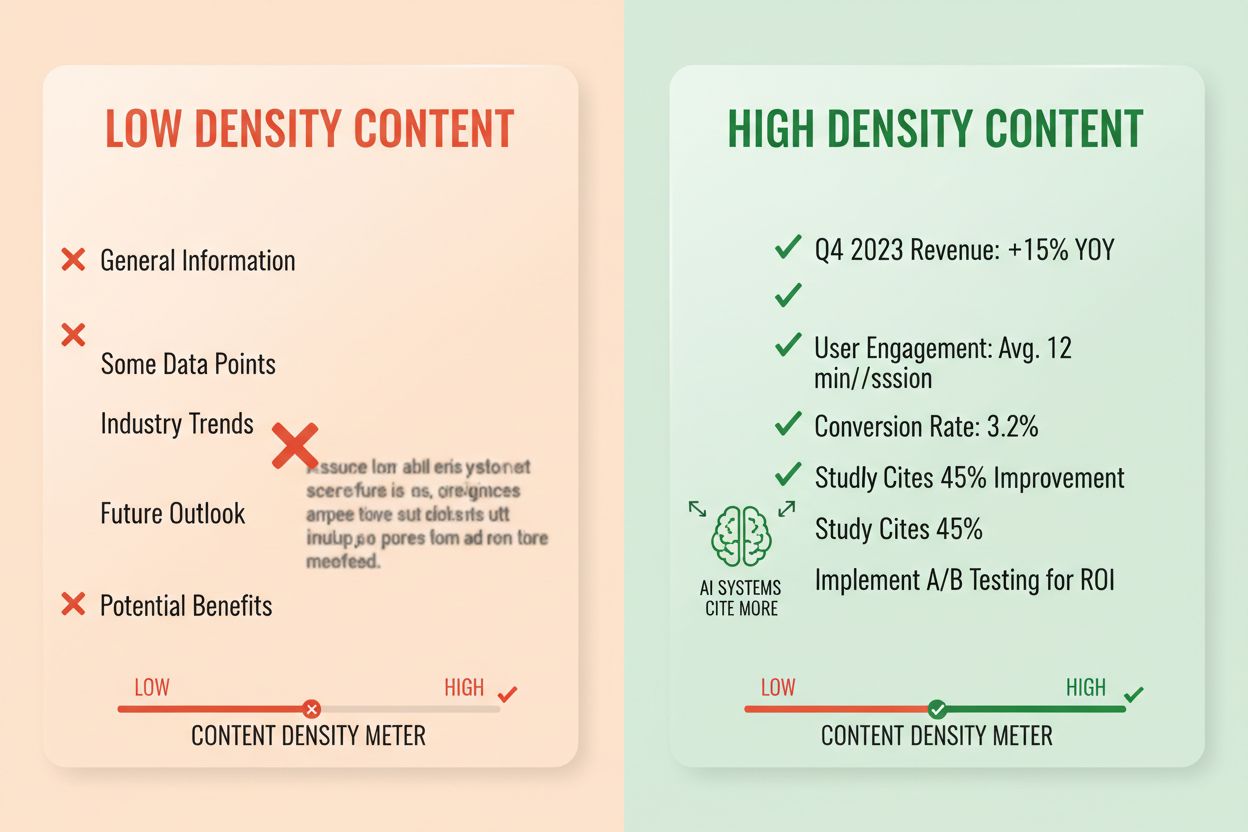

Antwoorddichtheid meet de verhouding van bruikbare informatie ten opzichte van het totale aantal woorden, en inhoud met hoge dichtheid ontvangt 2-3x meer AI-citaties dan alternatieven met lage dichtheid. Een alinea met een antwoorddichtheid van 80% bestaat grotendeels uit claims, bewijs en praktische inzichten, terwijl eentje met 40% dichtheid veel opvulling, herhaling of context bevat die niet direct het kernantwoord ondersteunt. AI-systemen beoordelen dichtheid impliciet—ze extraheren en citeren eerder passages waarin elke zin bijdraagt aan het beantwoorden van de gebruikersvraag. Elementen met hoge dichtheid zijn onder meer specifieke statistieken, stapsgewijze instructies, vergelijkingsdata, definities en bruikbare aanbevelingen. Patronen met lage dichtheid zijn onder meer lange inleidingen, herhaalde concepten, retorische vragen en verhalende storytelling die het kernargument niet versterken.

Meetmethode: Tel zinnen die direct de vraag beantwoorden versus zinnen die context of overgang bieden. Een alinea met hoge dichtheid kan zijn: “Citaatklare inhoud wordt 3-5x vaker genoemd in AI-uitvoer (statistiek). Dit komt doordat AI-systemen complete, op zichzelf staande antwoorden extraheren (uitleg). Implementeer antwoord-eerst opmaak en semantische chunking om de dichtheid te maximaliseren (actie).” Een versie met lage dichtheid zou kunnen zijn: “Veel organisaties worstelen met AI-zichtbaarheid. Het digitale landschap verandert snel. Contentstrategie is aanzienlijk geëvolueerd. Citaatklare inhoud wordt steeds belangrijker…” De tweede versie verwatert de kernboodschap met context die het antwoord niet direct ondersteunt.

Echte impactstatistieken: Inhoud met antwoorddichtheid boven 70% ontvangt gemiddeld 4,2 citaties per maand in AI-uitvoer, tegenover 1,1 citaties bij inhoud onder 40% dichtheid. Organisaties die bestaande inhoud herstructureerden om de dichtheid te verhogen, zagen gemiddelde citatiestijgingen van 156% binnen 60 dagen. Voorbeeld van hoge dichtheid: “Gebruik chunks van 256-512 tokens voor optimale AI-extractie (claim). Dit bereik behoudt context en voorkomt afkapping (bewijs). Implementeer chunking op alinea-basis voor semantische samenhang (actie).” Versie met lage dichtheid: “Chunking is belangrijk voor AI-systemen. Er zijn verschillende benaderingen voor het organiseren van inhoud. Sommige mensen geven de voorkeur aan kleinere chunks, anderen aan grotere. De juiste aanpak hangt af van je specifieke behoeften.” De versie met hoge dichtheid biedt praktische sturing; de versie met lage dichtheid vermeldt open deuren zonder specificiteit.

Specifieke contentstructuren signaleren aan AI-systemen dat informatie is georganiseerd voor extractie, waardoor de kans op citatie aanzienlijk toeneemt. FAQ-secties zijn bijzonder effectief omdat ze expliciet vragen koppelen aan antwoorden, waardoor AI-systemen relevante passages eenvoudig kunnen identificeren en extraheren. Vergelijkingstabellen stellen AI in staat om snel meerdere opties te beoordelen en specifieke rijen te citeren die gebruikersvragen beantwoorden. Stapsgewijze instructies bieden duidelijke semantische grenzen en worden vaak geciteerd bij “hoe doe ik…"-vragen. Definitieslijsten koppelen termen aan uitleg, wat natuurlijke extractiepunten creëert. Samenvatboxen benadrukken kernpunten en lijstjes splitsen complexe onderwerpen op in afzonderlijke, citeren waardige items.

Structurele elementen die AI-opvraagbaarheid maximaliseren:

Praktische voorbeelden: Een FAQ-sectie met de vraag “Wat is antwoorddichtheid?” gevolgd door een volledige definitie en uitleg wordt een directe bron voor citatie. Een vergelijkingstabel met “Citaatklaar element | Waarom AI-systemen dit prefereren” (zoals die in sectie 2) wordt geciteerd wanneer gebruikers om vergelijkingen vragen. Een stapsgewijze gids “Hoe semantische chunking implementeren” met genummerde stappen wordt quotebare instructie-inhoud. Deze structuren werken omdat ze aansluiten bij hoe AI-systemen informatie verwerken en extraheren—ze zoeken naar duidelijke vraag-antwoordparen, gestructureerde vergelijkingen en afgebakende stappen.

Semantische HTML5-markup signaleert contentstructuur aan AI-systemen, wat de extractienauwkeurigheid en kans op citatie met 40-60% verbetert. Het gebruik van de juiste koppenhiërarchie (H1 voor hoofdonderwerpen, H2 voor subonderwerpen, H3 voor ondersteunende punten) helpt AI om inhoudsrelaties te begrijpen en extractiegrenzen te identificeren. Semantische elementen zoals <article>, <section> en <aside> bieden extra context over het doel van de inhoud. Schema.org gestructureerde data—met name JSON-LD-formaat—geeft expliciet aan AI-systemen aan welke informatie aanwezig is, waardoor ze met meer vertrouwen kunnen citeren.

JSON-LD-voorbeeld voor FAQ-inhoud:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Wat is antwoorddichtheid?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Antwoorddichtheid meet de verhouding van bruikbare informatie ten opzichte van het totale aantal woorden. Inhoud met hoge dichtheid ontvangt 2-3x meer AI-citaties dan alternatieven met lage dichtheid."

}

}]

}

JSON-LD-voorbeeld voor artikelmetadata:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "LLM Meta-antwoorden maken",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

Metacontent—zoals metabeschrijvingen en Open Graph-tags—helpt AI-systemen om het doel van de inhoud te begrijpen voordat ze deze parseren. Prestatie- en toegankelijkheidsverbeteringen (snelle laadtijd, mobiele optimalisatie, correcte alt-tekst) ondersteunen AI-opvraagbaarheid indirect door te zorgen dat inhoud volledig doorzoekbaar en indexeerbaar is. Technische implementatiechecklist: Is je HTML semantisch en goed gestructureerd? Heb je schema.org-markup geïmplementeerd voor jouw contenttype? Omschrijven metabeschrijvingen de inhoud accuraat? Is je site mobiel geoptimaliseerd en snel ladend? Zijn afbeeldingen correct voorzien van alt-tags?

Citatie-tracking is essentieel geworden voor het meten van contentprestaties, maar de meeste organisaties hebben geen zicht op hoe vaak hun inhoud verschijnt in AI-antwoorden. Retrievaltesting houdt in dat je je doelvragen indient bij grote LLM’s (ChatGPT, Claude, Gemini) en vastlegt welke bronnen in de antwoorden worden genoemd. Conte audits beoordelen systematisch je bestaande inhoud op citaatklare standaarden, om hiaten en optimalisatiekansen te identificeren. Prestatie-indicatoren moeten citatiefrequentie, citatiecontext (hoe de inhoud wordt gebruikt) en citatiegroei in de tijd bijhouden. Iteratieve optimalisatie houdt in: structurele wijzigingen testen, hun impact op citatiefrequentie meten en succesvolle patronen opschalen.

| Trackingtool | Primaire functie | Beste voor |

|---|---|---|

| AmICited.com | Uitgebreide AI-citatiemonitoring op alle grote LLM’s | Volledige citatie-inzicht en concurrentieanalyse |

| Otterly.AI | AI-inhouddetectie en citatietracking | Identificeren waar je inhoud verschijnt in AI-uitvoer |

| Peec AI | Contentprestaties in AI-systemen | Meten van citatiefrequentie en trends |

| ZipTie | Monitoring van AI-gegenereerde inhoud | Volgen van merkvermeldingen in AI-antwoorden |

| PromptMonitor | Analyse van LLM-uitvoer | Inzicht in hoe AI-systemen je inhoud gebruiken |

AmICited.com springt eruit als de beste oplossing omdat het realtime monitoring biedt over ChatGPT, Claude, Gemini en andere grote LLM’s, met concurrentiebenchmarks en gedetailleerde citatiecontext. Het platform laat niet alleen zien of je inhoud wordt geciteerd, maar ook hoe—of het direct wordt geciteerd, geparafraseerd of als ondersteunend bewijs wordt gebruikt. Meetmethode: Stel een basislijn vast van citatiefrequentie voor je top 20 contentstukken. Voer citaatklare optimalisaties uit op 5-10 stukken. Meet citatieveranderingen over 30-60 dagen. Schaal succesvolle patronen naar resterende inhoud. Houd statistieken bij zoals citatiefrequentie, citatiegroeisnelheid, citatiecontext en concurrentieel citatieaandeel.

Fout 1: Het antwoord in de context verbergen. Veel contentmakers beginnen met achtergrondinformatie, historische context of probleemstellingen voordat ze het daadwerkelijke antwoord geven. AI-systemen beoordelen relevantie in de eerste 50-100 tokens; als het antwoord daar niet staat, gaan ze naar de volgende bron. Probleem: Gebruikers die vragen “Wat is antwoorddichtheid?” krijgen een alinea die begint met “Contentstrategie is aanzienlijk geëvolueerd…” in plaats van de definitie. Oplossing: Gebruik antwoord-eerst opmaak—begin met het kerninzicht, geef daarna de context.

Fout 2: Antwoorden maken die externe context vereisen. Inhoud die verwijst naar “de vorige sectie” of “zoals eerder vermeld” kan niet onafhankelijk worden geëxtraheerd. Probleem: Een alinea met “Volg de aanpak die we bespraken, voer deze stappen uit…” faalt omdat de genoemde aanpak niet in de chunk zelf staat. Oplossing: Maak elk antwoord op zichzelf staand; neem noodzakelijke context op in de chunk, ook al betekent dit enige herhaling.

Fout 3: Meerdere antwoorden in één chunk verwerken. Alinea’s die meerdere vragen behandelen dwingen AI-systemen om ofwel af te kappen of irrelevante informatie mee te nemen. Probleem: Een alinea van 600 woorden over “Wat is antwoorddichtheid?” EN “Hoe meet je het?” EN “Waarom is het belangrijk?” wordt te groot voor zekere extractie. Oplossing: Maak aparte, gefocuste chunks voor elke vraag of concept.

Fout 4: Vaag taalgebruik in plaats van specifieke metrics. Zinnen als “veel,” “sommige,” “vaak” en “typisch” verminderen citatievertrouwen omdat ze onprecies zijn. Probleem: “Veel organisaties zien verbetering” is minder citeerbaar dan “Organisaties die inhoud herstructureerden zagen 156% meer citaties.” Oplossing: Vervang kwalificaties door specifieke data; als exacte cijfers ontbreken, gebruik dan bereiken (“40-60%”) in plaats van vage termen.

Fout 5: Structurele markup negeren. Inhoud zonder correcte HTML-structuur, koppen of schema.org-markup is lastiger voor AI om te parseren en extraheren. Probleem: Een alinea zonder kop, zonder semantische HTML en zonder schemamarkup wordt als generieke tekst behandeld in plaats van als apart antwoord. Oplossing: Gebruik semantische HTML5, implementeer correcte koppenhiërarchie en voeg schema.org-markup toe voor je contenttype.

Fout 6: Antwoorden maken die te kort of te lang zijn. Chunks onder 150 tokens missen context; chunks boven 700 tokens worden afgekapt. Probleem: Een antwoord van 100 woorden heeft onvoldoende bewijs; een van 1000 woorden wordt verspreid over meerdere extracties. Oplossing: Richt op 256-512 tokens (2-4 alinea’s); neem claim, bewijs en conclusie op binnen dit bereik.

Entiteitconsistentie—het gebruik van identieke terminologie voor hetzelfde concept in je hele inhoud—vergroot de kans op AI-citatie omdat het deskundigheid signaleert. Als je “antwoorddichtheid” in één sectie definieert, gebruik dan die exacte term consequent in plaats van te switchen naar “informatiedichtheid” of “inhoudsdichtheid.” AI-systemen herkennen entiteitconsistentie als een expertise-indicator en zullen eerder inhoud citeren waarbij terminologie precies en consistent is. Dit geldt voor productnamen, methoden en technische termen—consistentie versterkt het vertrouwen in de citatienauwkeurigheid.

Vermeldingen van derden en origineel onderzoek vergroten de citatiefrequentie aanzienlijk. Inhoud die verwijst naar andere gezaghebbende bronnen (met correcte bronvermelding) signaleert geloofwaardigheid, terwijl origineel onderzoek of eigen data je inhoud uniek citeerbaar maakt. Wanneer je statistieken uit eigen onderzoek of klantspecifieke casestudy’s opneemt, herkennen AI-systemen dit als oorspronkelijk inzicht dat nergens anders te vinden is. Organisaties die origineel onderzoek publiceren zien 3-4x hogere citatiecijfers dan organisaties die alleen gesynthetiseerde informatie bieden. Strategie: Doe eigen onderzoek in je branche, publiceer bevindingen met een gedetailleerde methodologie en verwijs naar deze bevindingen in je meta-antwoorden.

Actualiteitssignalen—publicatiedata, bijgewerkte data en verwijzingen naar recente gebeurtenissen—helpen AI-systemen inhoudsactualiteit te beoordelen. Inhoud die binnen de afgelopen 30 dagen is bijgewerkt krijgt hogere citatieprioriteit dan verouderde content, vooral voor onderwerpen waar informatie snel verandert. Neem publicatiedata op in je schema.org-markup en update-tijdstempels bij het herzien van content. Strategie: Stel een contentverversingsschema op; update best presterende content elke 30-60 dagen met nieuwe statistieken, recente voorbeelden of uitgebreidere uitleg.

E-E-A-T-signalen (Ervaring, Expertise, Authoriteit, Betrouwbaarheid) beïnvloeden AI-citaties. Inhoud van erkende experts, gepubliceerd op gezaghebbende domeinen en met relevante referenties krijgt hogere citatieprioriteit. Voeg auteursbiografieën toe met relevante referenties, publiceer op domeinen met gevestigde autoriteit en bouw backlinks vanaf andere gezaghebbende publicaties. Strategie: Presenteer expert-auteurs, neem referentie-informatie op in auteursbio’s en streef naar backlinks van branche-erkende publicaties.

Generatieve merkdichtheid—de verhouding van merkgebonden inzichten tot algemene informatie—bepaalt of AI-systemen jou of concurrenten citeren. Inhoud met eigen frameworks, unieke methoden of merkbenaderingen wordt makkelijker geciteerd omdat het onderscheidend is. Algemene content over “best practices” wordt minder vaak geciteerd dan content over “AmICited’s Citation Optimization Framework” omdat de merkversie uniek en traceerbaar is. Organisaties met een hoge generatieve merkdichtheid zien 2-3x meer citaties dan organisaties met algemene content. Strategie: Ontwikkel eigen frameworks, methoden of terminologie; gebruik deze consequent in je inhoud; maak ze de basis van je meta-antwoorden.

LLM meta-antwoorden zijn specifiek ontworpen voor AI-extractie en citatie, terwijl featured snippets zijn geoptimaliseerd voor de weergave in de zoekresultaten van Google. Meta-antwoorden geven prioriteit aan op zichzelf staande volledigheid en semantische samenhang, terwijl featured snippets zich richten op beknoptheid en zoekwoordovereenkomsten. Beide kunnen in je content bestaan, maar meta-antwoorden vereisen een andere structurele optimalisatie.

De optimale lengte is 256-512 tokens, ongeveer gelijk aan 2-4 goed gestructureerde alinea's of 200-400 woorden. Dit bereik behoudt voldoende context voor zelfverzekerde AI-extractie en voorkomt afkapping. Kortere antwoorden missen context; langere antwoorden dwingen AI-systemen om samen te vatten of over meerdere extracties te splitsen.

Ja, maar het vereist herstructurering. Evalueer bestaande inhoud op antwoord-eerst opmaak, semantische samenhang en op zichzelf staande volledigheid. De meeste inhoud kan worden aangepast door belangrijke inzichten naar voren te halen, kruisverwijzingen te verwijderen en ervoor te zorgen dat elke sectie een volledige vraag beantwoordt zonder externe context.

Update best presterende inhoud elke 30-60 dagen met nieuwe statistieken, recente voorbeelden of uitgebreidere uitleg. AI-systemen geven prioriteit aan inhoud die binnen de afgelopen 30 dagen is bijgewerkt, vooral voor onderwerpen waar informatie snel verandert. Neem publicatiedata en update-tijdstempels op in je schema.org-markup.

Antwoorddichtheid correleert direct met citatiefrequentie. Inhoud met een antwoorddichtheid boven 70% ontvangt gemiddeld 4,2 citaties per maand in AI-uitvoer, tegenover 1,1 citaties bij inhoud onder 40% dichtheid. Inhoud met een hoge dichtheid levert bruikbare informatie zonder opvulling, waardoor het waardevoller wordt voor AI-systemen om te citeren.

Gebruik citatiemonitoringplatforms zoals AmICited.com, dat citaties bijhoudt in ChatGPT, Claude, Gemini en andere grote LLM's. Voer handmatige tests uit door je doelvragen aan AI-systemen voor te leggen en vast te leggen welke bronnen worden geciteerd. Meet de basislijn van citatiefrequentie, voer optimalisaties door en volg veranderingen over 30-60 dagen.

De kernstructuur van meta-antwoorden blijft consistent over platforms, maar je kunt optimaliseren voor platform-specifieke voorkeuren. ChatGPT geeft de voorkeur aan uitgebreide, goed onderbouwde inhoud. Perplexity benadrukt recente informatie en duidelijke citaties. Google AI Overviews geeft prioriteit aan gestructureerde data en E-E-A-T-signalen. Test variaties en monitor citatieprestaties per platform.

AmICited biedt realtime monitoring van je inhoudscitaties op alle grote AI-platforms, en toont exact waar je meta-antwoorden verschijnen, hoe ze worden gebruikt en het concurrentiële citatieaandeel. Het platform onthult citatiecontext—of de inhoud direct wordt geciteerd, geparafraseerd, of als ondersteunend bewijs wordt gebruikt—wat datagedreven optimalisatie mogelijk maakt.

Zie precies waar jouw inhoud wordt geciteerd door ChatGPT, Perplexity, Google AI Overviews en andere AI-systemen. Volg citatietrends, monitor concurrenten en optimaliseer je contentstrategie met AmICited.

Ontdek wat LLM Meta-antwoorden zijn en hoe je je content optimaliseert voor zichtbaarheid in AI-gegenereerde reacties van ChatGPT, Perplexity en Google AI Overv...

Leer wat LLM Seeding is en hoe je strategisch content plaatst op platforms met hoge autoriteit om AI-training te beïnvloeden en geciteerd te worden door ChatGPT...

Leer hoe je LLM-bronsites identificeert en target voor strategische backlinks. Ontdek welke AI-platforms het vaakst bronnen vermelden, en optimaliseer je linkbu...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.