Medische E-E-A-T: Vertrouwen opbouwen in Gezondheidscontent voor AI

Leer hoe je betrouwbare gezondheidszorg content bouwt met behulp van E-E-A-T-principes. Ontdek strategieën om medische autoriteit, expertise en vertrouwenssigna...

Ontdek hoe zorgorganisaties medische inhoud kunnen optimaliseren voor LLM-zichtbaarheid, YMYL-vereisten kunnen navigeren en AI-citaties kunnen monitoren met het AI-monitoringplatform van AmICited.com.

Your Money or Your Life (YMYL)-inhoud omvat onderwerpen die direct invloed hebben op het welzijn van gebruikers, zoals gezondheid, financiën, veiligheid en civieke informatie—waarbij de zorg bovenaan staat in Google’s hiërarchie van controle. Na Google’s core update van maart 2024 heeft de zoekgigant de zichtbaarheid van inhoud van lage kwaliteit met 40% verminderd, wat duidt op een ongekend harde aanpak van onbetrouwbare medische informatie. De uitdaging voor zorgorganisaties is echter fundamenteel verschoven: inhoud moet nu niet alleen zichtbaar zijn voor zoekmachines, maar ook voor Grote Taalmodellen (LLM’s) die steeds vaker het startpunt vormen voor mensen die gezondheidsinformatie zoeken. Met 5% van alle Google-zoekopdrachten die gezondheidsgerelateerd zijn en 58% van de patiënten die nu AI-tools gebruiken voor gezondheidsinformatie, staan zorgverleners voor een cruciale zichtbaarheidsgap—hun inhoud kan goed scoren in traditionele zoekresultaten, maar blijft onzichtbaar voor de AI-systemen die patiënten daadwerkelijk raadplegen. Deze dubbele zichtbaarheidseis vormt een geheel nieuw terrein voor de zorginhoudstrategie.

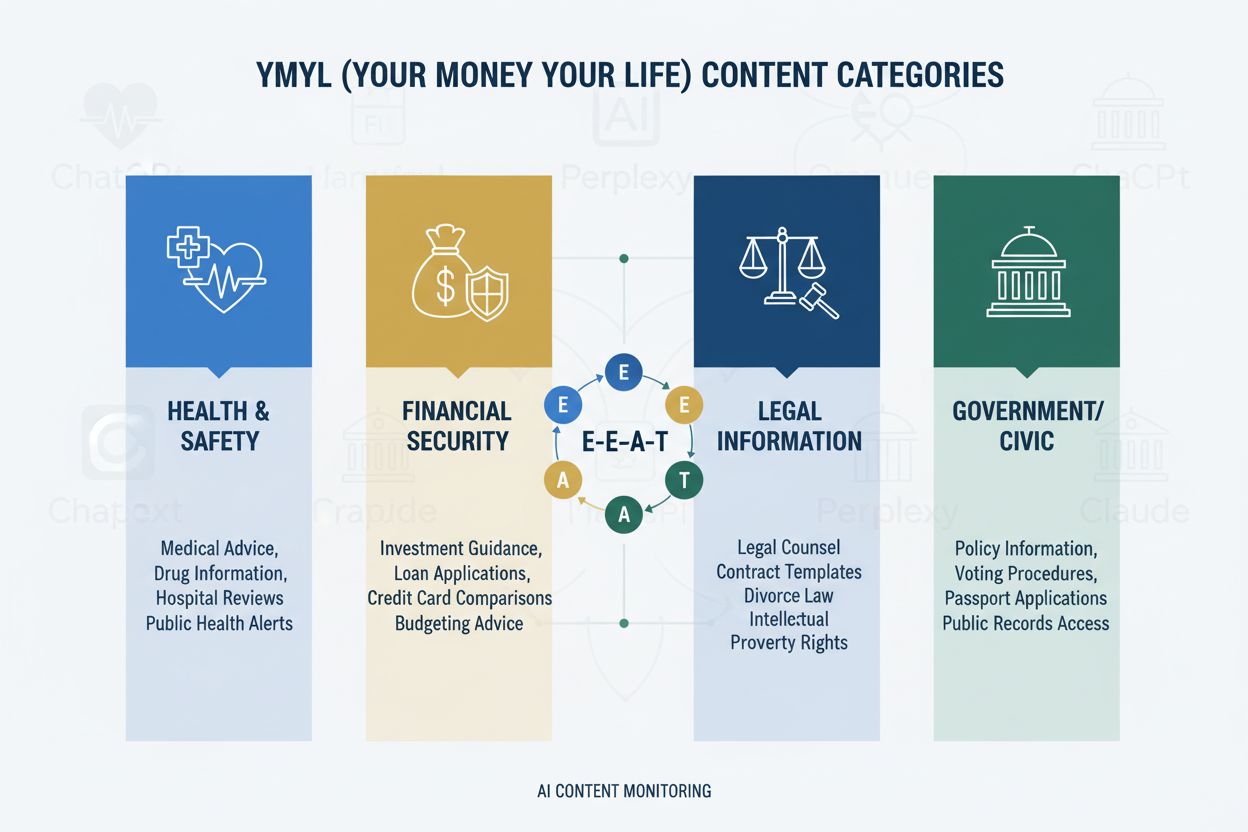

Het YMYL-kader verdeelt inhoud in vier cruciale domeinen: Gezondheid (medische aandoeningen, behandelingen, welzijn), Financiën (beleggingsadvies, financiële planning), Veiligheid (noodprocedures, beveiliging) en Civiek (stemmen, juridische zaken)—waarbij zorg de hoogste controle krijgt vanwege de directe impact op het menselijke welzijn. Google’s E-E-A-T-raamwerk (Experience, Expertise, Authoritativeness, Trustworthiness) dient als evaluatiestandaard en vereist dat zorginhoud echte medische kennis, professionele kwalificaties en verifieerbare nauwkeurigheid aantoont. De Quality Rater Guidelines benadrukken expliciet dat zorginhoud moet zijn gemaakt of gecontroleerd door gekwalificeerde medische professionals, met duidelijke auteurscredentials en institutionele ondersteuning. Zorgorganisaties moeten begrijpen dat E-E-A-T niet optioneel is—het is de basisvereiste voor zowel zichtbaarheid in zoekmachines als opname in LLM’s. Hieronder staat de impacthiërarchie van YMYL-categorieën:

| YMYL-categorie | Impactniveau | Intensiteit van controle | Relevantie voor zorg |

|---|---|---|---|

| Gezondheid | Kritiek | Hoogste | Directe patiëntveiligheid |

| Financiën | Hoog | Hoog | Verzekering, kosten |

| Veiligheid | Hoog | Hoog | Noodprotocollen |

| Civiek | Medium | Medium | Gezondheidsbeleid |

Ondanks hun verfijning tonen LLM’s alarmerende foutpercentages bij het verwerken van medische informatie, waarbij Stanford HAI-onderzoek 30-50% niet-ondersteunde uitspraken in zorgantwoorden documenteert. GPT-4 met Retrieval-Augmented Generation (RAG) levert nog steeds antwoorden op waarvan 50% niet-onderbouwde claims bevat, zelfs wanneer getraind op gezaghebbende bronnen—een fenomeen dat bekend staat als hallucinatie en zich kan uiten in het aanbevelen van niet-bestaande medische apparatuur, het suggereren van onjuiste behandelprotocollen of het verzinnen van medicijninteracties. Een opvallend geval betrof Men’s Journal, dat een door AI gegenereerd artikel publiceerde met 18 specifieke medische fouten, waaronder gevaarlijke behandeladviezen die lezers konden schaden. Het fundamentele probleem is dat AI “ervaring” mist—de directe klinische kennis die expert-artsen onderscheidt van statistische patroonherkenningssystemen. Dit betekent dat zonder goed gestructureerde, gezaghebbende inhoud van geverifieerde medische professionals, LLM’s vol vertrouwen plausibel klinkend maar potentieel gevaarlijk medisch advies zullen genereren.

AI Overviews en vergelijkbare op LLM gebaseerde antwoordsystemen veranderen fundamenteel hoe patiënten gezondheidsinformatie ontdekken door directe antwoorden te geven zonder websitebezoek, waarmee de traditionele doorklik wegvalt die decennialang zorgwebverkeer aandreef. Zichtbaarheid van inhoud hangt nu af van vermelding in AI-antwoorden in plaats van rangschikking, wat betekent dat het artikel van een zorgverlener kan worden verwerkt in een AI-antwoord zonder ooit verkeer of bronvermelding te krijgen. LLM’s synthetiseren informatie uit meerdere bronnen tegelijk en creëren zo een nieuwe informatiearchitectuur waarin individuele websites strijden om opname in door AI gegenereerde samenvattingen in plaats van om topposities in zoekresultaten. Zorgverleners moeten erkennen dat Share of Model (SOM)—het percentage AI-antwoorden dat hun inhoud noemt—is uitgegroeid tot de kritische zichtbaarheidsmaatstaf en de traditionele doorklikratio vervangt. Deze paradigmaverschuiving vereist een fundamentele herziening van de contentstrategie: niet optimaliseren voor klikken, maar voor citatiekwaliteit, nauwkeurigheid en structurele helderheid waardoor hun inhoud de voorkeursbron wordt voor LLM-synthese.

LLM’s verwerken medische inhoud het best wanneer deze is georganiseerd met een duidelijke hiërarchische structuur die klinische besluitvorming weerspiegelt: definitie van de aandoening → symptoompresentatie → diagnostische criteria → behandelingsopties → prognose. Progressive disclosure-architectuur—eerst eenvoudige en dan complexe concepten aanbieden—stelt LLM’s in staat om nauwkeurige mentale modellen op te bouwen in plaats van verwante maar verschillende aandoeningen te vermengen. Vraaggestuurde contentopbouw (eerst “Wat is aandoening X?” beantwoorden vóór “Hoe wordt het behandeld?”) sluit aan bij hoe LLM’s informatie ophalen en synthetiseren uit meerdere documenten. Semantische rijkdom en onderling verbonden concepten—expliciet relateren van aandoeningen, behandelingen en risicofactoren—helpen LLM’s relaties te begrijpen die anders impliciet blijven. Implementatie van Schema.org-medische markup (MedicalCondition, MedicalProcedure, MedicalTreatment) biedt gestructureerde data die LLM’s betrouwbaar kunnen verwerken en citeren. Natuurlijke taal die expertuitleg nabootst—met terminologie die artsen gebruiken maar toch toegankelijk blijft—signaleert authenticiteit aan zowel LLM’s als menselijke lezers. Zorgorganisaties zouden bestaande inhoud moeten beoordelen op deze structurele eisen, want traditioneel SEO-geoptimaliseerde teksten missen vaak de hiërarchische helderheid en semantische rijkdom die LLM’s nodig hebben voor correcte synthese.

Aanwezigheid op meerdere platforms versterkt autoriteitssignalen op manieren die strategieën met slechts één website niet bereiken, omdat LLM’s consistente expertise herkennen die op meerdere gezaghebbende kanalen wordt getoond. Medische Q&A-platforms zoals HealthTap en Figure 1 bieden directe interactie tussen arts en patiënt die door LLM’s als authentieke expertise wordt gezien, met geverifieerde kwalificaties en realtime betrokkenheid. Professionele netwerken zoals Doximity en medische LinkedIn-gemeenschappen vestigen erkenning onder vakgenoten en professionele reputatie die LLM’s zwaar laten meewegen in hun beoordeling van autoriteit. Bijdragen aan medische Wikipedia en vergelijkbare samenwerkingskennisbanken laten zien dat men bijdraagt aan publieke medische kennis zonder commercieel belang, een vertrouwenssignaal dat LLM’s herkennen. Uitgebreide auteurspagina’s met geloofwaardigheid—met diploma’s, publicaties, klinische ervaring en institutionele affiliaties—moeten aanwezig zijn op de hoofdwebsite en consequent gelinkt worden over alle platforms heen. Consistentie over platforms in kwalificaties, specialismen en klinische perspectieven versterkt de authenticiteit; tegenstrijdigheden roepen scepsis op bij LLM’s. Zorgorganisaties moeten een multi-platform autoriteitsstrategie ontwikkelen waarbij elk platform een versterkend signaal is, niet een los kanaal, zodat deskundigheid van artsen zichtbaar en verifieerbaar is in het hele digitale ecosysteem.

Traditionele zorganalyse—zoals organisch verkeer, doorklikratio’s en zoekpositie—mist het verhaal rond AI-zichtbaarheid volledig, waardoor een gevaarlijke blinde vlek ontstaat waarin inhoud volgens oude maatstaven succesvol lijkt, maar onzichtbaar blijft voor LLM’s. Share of Model (SOM) wordt de nieuwe kritische maatstaf, die meet welk percentage van AI-gegenereerde antwoorden over een bepaalde aandoening uw organisatie citeert. Effectieve monitoring vereist systematisch testen op meerdere LLM-platforms (ChatGPT, Claude, Perplexity en nieuwkomers) met consistente vragen over uw specialismen, waarbij citatiefrequentie en positie binnen antwoorden worden vastgelegd. Citatiekwaliteit is net zo belangrijk als frequentie—als primaire bron genoemd worden telt zwaarder dan genoemd worden in een lijst met secundaire bronnen, en LLM’s herkennen wanneer inhoud wordt geciteerd vanwege specifieke expertise versus algemene informatie. Monitoringtools variëren van handmatig testen (vragen stellen en resultaten documenteren) tot automatiseringsplatforms die SOM-veranderingen door de tijd volgen en waarschuwen bij verschuivingen in zichtbaarheid. Indirecte indicatoren zoals branded search volume, patiëntfeedback over AI-aanbevelingen en verwijspatronen vanuit AI-platforms bieden aanvullende data die SOM-trends valideren. Zorgorganisaties moeten direct een SOM-baseline vaststellen, want het concurrentielandschap verandert snel en vroege zichtbaarheid biedt een voorsprong die toeneemt naarmate LLM’s leren betrouwbare bronnen te herkennen.

Zorgorganisaties zouden moeten beginnen met één specialisme in plaats van direct alles te willen veranderen, zodat teams expertise opbouwen en processen kunnen verfijnen voordat ze opschalen. Contentaudits vanuit een LLM-perspectief vragen om beoordeling van bestaande artikelen op hiërarchische helderheid, semantische rijkdom, vraaggestuurde opzet en auteursprestige—waarbij vaak blijkt dat goed scorende inhoud de structuur mist die LLM’s nodig hebben. Zichtbaarheidstests op AI-platforms met vakspecifieke vragen leggen de huidige SOM-baseline vast en tonen welke aandoeningen en behandelingen zichtbaar of juist onzichtbaar zijn. Implementatie van vraaggestuurde opbouw betekent bestaande inhoud herstructureren of nieuwe inhoud creëren die begint met patiëntvragen (“Waarom heb ik dit symptoom?”) vóór de klinische uitleg. Auteursprestigepagina’s moeten voor elke medisch auteur worden aangemaakt, met diploma’s, specialismen, publicaties en klinische ervaring, en consequent gelinkt vanaf alle gepubliceerde inhoud. Contentclustering rond aandoeningen—onderling verbonden artikelen over symptomen, diagnostiek, behandelingen en prognose—helpt LLM’s om volledige aandoeningsinformatie te begrijpen in plaats van losse artikelen. Deze gefaseerde aanpak stelt zorgorganisaties in staat om impact te meten, strategie bij te stellen en intern expertise op te bouwen voordat wordt opgeschaald naar andere specialismen.

HIPAA-naleving blijft essentieel, ook als inhoud zichtbaar wordt voor LLM’s; patiëntprivacy geldt ongeacht of informatie via zoekmachines of AI-systemen wordt benaderd, wat zorgvuldige anonimisering en de-identificatie van casussen vereist. Medische disclaimers en nauwkeurigheidsvereisten moeten expliciet en prominent zijn, met duidelijke vermelding dat AI-samengevatte informatie geen vervanging is voor professioneel medisch advies, en dat individuele situaties kunnen afwijken van algemene informatie. Factchecking en bronvermelding zijn cruciale compliance-elementen, want zorgorganisaties zijn aansprakelijk voor de nauwkeurigheid van gepubliceerde informatie en LLM’s zullen fouten op grote schaal verspreiden. Regelgevende controle op door AI-gegenereerde medische inhoud neemt toe, waarbij FDA en FTC steeds meer onderzoeken hoe AI-systemen medische informatie presenteren; zorgorganisaties moeten ervoor zorgen dat alle inhoud—of deze nu door mensen is geschreven of met AI-hulp—is volgens de regelgeving. Menselijke medische beoordeling door gekwalificeerde artsen moet verplicht blijven voor alle zorginhoud, met gedocumenteerde reviewprocessen die aantonen dat men zich inzet voor nauwkeurigheid en veiligheid. Aansprakelijkheid gaat verder dan traditionele medische aansprakelijkheid en omvat ook mogelijke verantwoordelijkheid voor door LLM’s gesynthetiseerde en aan patiënten gepresenteerde informatie; zorgorganisaties moeten juridisch advies inwinnen over hun verantwoordelijkheid voor het gebruik van hun inhoud in AI-systemen. Naleving en veiligheid mogen niet als bijzaak worden gezien in de race naar AI-zichtbaarheid.

AI zal de zoektocht naar gezondheidsinformatie blijven veranderen in steeds hoger tempo, waarbij LLM’s steeds geavanceerder worden in medisch redeneren en steeds centraler in de manier waarop patiënten aandoeningen onderzoeken. Zorgorganisaties die nu hun contentstrategie aanpassen, positioneren zichzelf als betrouwbare bron in dit nieuwe ecosysteem, terwijl achterblijvers onzichtbaar dreigen te worden voor de AI-systemen die hun patiënten daadwerkelijk gebruiken. Vroege adopters krijgen concurrentievoordeel door gevestigde autoriteitssignalen, hogere Share of Model-scores en patiëntvertrouwen door consistente zichtbaarheid in AI-antwoorden—voordelen die groeien naarmate LLM’s leren betrouwbare bronnen te herkennen en prioriteren. Integratie van traditionele SEO en LLM-optimalisatie is geen of-of-keuze maar een complementaire strategie, nu zoekmachines steeds meer LLM-technologie integreren en patiënten meerdere bronnen blijven gebruiken. Duurzaam succes hangt af van echte deskundigheid in plaats van optimalisatietrucs; zorgorganisaties die investeren in authentieke medische kennis, transparante kwalificaties en accurate informatie zullen floreren, ongeacht hoe het landschap van informatieontdekking zich ontwikkelt. De zorginhoudssector is fundamenteel veranderd en organisaties die deze overgang als kans zien, zullen de toekomst van gezondheidsinformatie voor patiënten bepalen.

YMYL (Your Money Your Life) verwijst naar inhoud die aanzienlijke invloed kan hebben op iemands gezondheid, financiële stabiliteit of veiligheid. De zorg is de categorie met de strengste controle, omdat medische desinformatie ernstige schade of zelfs de dood kan veroorzaken. Google hanteert strengere algoritmische normen voor YMYL-inhoud, en LLM's worden steeds vaker door patiënten gebruikt om gezondheidsinformatie te zoeken, waardoor YMYL-naleving essentieel is voor zichtbaarheid.

LLM's synthetiseren informatie uit meerdere bronnen om directe antwoorden te geven, terwijl zoekmachines individuele pagina's rangschikken. Zorginhoud moet nu zo worden gestructureerd dat AI-systemen het kunnen citeren, niet alleen voor Google-rankings. Dit betekent dat uw inhoud duizenden mensen kan onderwijzen via AI-antwoorden zonder direct websiteverkeer te ontvangen, wat een fundamenteel andere optimalisatie vereist.

E-E-A-T staat voor Experience, Expertise, Authoritativeness en Trustworthiness. Zorginhoud vereist de hoogste E-E-A-T-normen, met nadruk op eerstehands medische ervaring en geverifieerde kwalificaties. Google's Quality Rater Guidelines noemen E-E-A-T 137 keer, wat het cruciale belang ervan voor zichtbaarheid van zorginhoud in zowel zoek- als LLM-systemen weerspiegelt.

Uit onderzoek blijkt dat AI 30-50% van de tijd niet-ondersteunde medische uitspraken doet en medische informatie hallucineert. AI mist echte medische ervaring en kan informatie niet verifiëren aan de hand van actuele medische standaarden. Daarom blijft menselijke medische beoordeling en deskundig auteurschap essentieel—AI moet zorgprofessionals ondersteunen, niet vervangen.

Test uw inhoud in ChatGPT, Claude en Perplexity met veelvoorkomende patiëntvragen binnen uw specialisme. Volg Share of Model (SOM)-statistieken—het percentage AI-antwoorden dat uw inhoud citeert. AmICited.com automatiseert deze monitoring en biedt realtime inzicht in hoe uw zorgmerk verschijnt op meerdere LLM-platforms.

Traditionele SEO richt zich op het rangschikken van individuele pagina's voor zoekwoorden. LLM-optimalisatie legt de nadruk op volledige dekking, semantische rijkdom en gestructureerde inhoud die AI-systemen kunnen begrijpen en citeren. Beide benaderingen zijn complementair—zorgorganisaties hebben geïntegreerde strategieën nodig die optimaliseren voor zowel zoekmachines als LLM's.

AI mag alleen worden gebruikt als hulpmiddel ter ondersteuning van menselijke medische experts, niet ter vervanging ervan. Alle zorginhoud moet worden gecontroleerd en goedgekeurd door gekwalificeerde medische professionals voordat deze wordt gepubliceerd. De risico's zijn te groot om voor zorginhoud te vertrouwen op AI-generatie zonder deskundige beoordeling en verificatie.

AmICited.com monitort hoe zorgmerken en medische inhoud verschijnen in AI-antwoorden op ChatGPT, Perplexity, Google AI Overviews en andere LLM-platforms. Het biedt zichtbaarheidsstatistieken, volgt Share of Model (SOM) en geeft optimalisatie-advies zodat zorgorganisaties hun expertise vindbaar kunnen maken via AI-gestuurd patiëntenonderzoek.

Volg hoe uw medische inhoud verschijnt in ChatGPT, Perplexity, Google AI Overviews en andere LLM-platforms. Krijg realtime inzicht in uw Share of Model (SOM) en optimaliseer voor AI-gestuurde patiëntontdekking.

Leer hoe je betrouwbare gezondheidszorg content bouwt met behulp van E-E-A-T-principes. Ontdek strategieën om medische autoriteit, expertise en vertrouwenssigna...

Communitydiscussie over hoe AI-systemen omgaan met YMYL (Your Money or Your Life) onderwerpen. Echte inzichten over zichtbaarheid van gezondheids-, financiële e...

YMYL-inhoud vereist hoge E-E-A-T-normen. Leer wat kwalificeert als Your Money Your Life-inhoud, waarom het belangrijk is voor SEO en AI-zichtbaarheid, en hoe u ...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.