Multimodale AI-zoekopdracht

Ontdek hoe multimodale AI-zoeksystemen tekst, afbeeldingen, audio en video samen verwerken om nauwkeurigere en contextueel relevantere resultaten te leveren dan...

Ontdek hoe je tekst, afbeeldingen en video optimaliseert voor multimodale AI-systemen. Leer strategieën om AI-verwijzingen en zichtbaarheid te verbeteren in ChatGPT, Gemini en Perplexity.

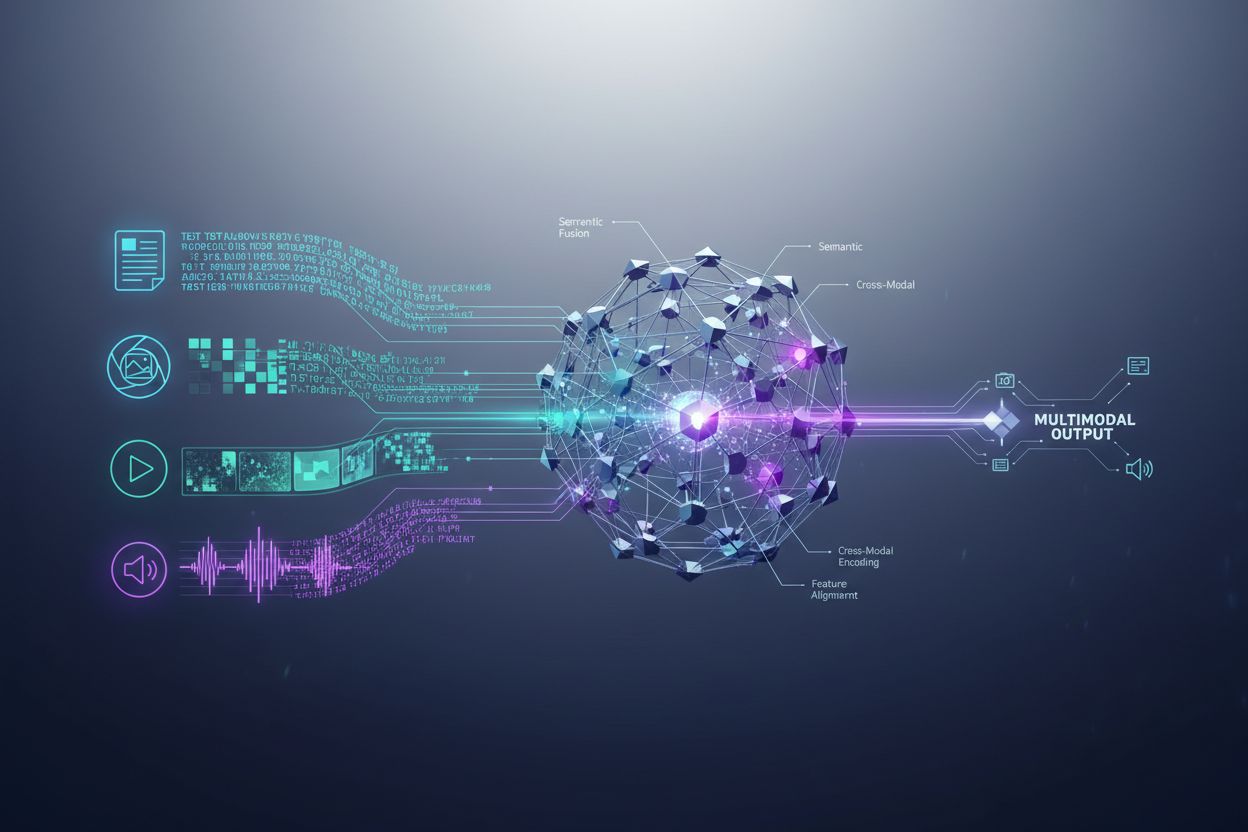

Multimodale AI vertegenwoordigt een fundamentele verschuiving in hoe kunstmatige intelligentiesystemen informatie verwerken en begrijpen. In tegenstelling tot unimodale systemen die alleen tekst, afbeeldingen of video afzonderlijk verwerken, integreert multimodale AI meerdere datatypes gelijktijdig om een meer omvattend begrip van complexe informatie te creëren. Deze aanpak weerspiegelt hoe mensen de wereld natuurlijk verwerken — we scheiden niet wat we zien van wat we horen of lezen, maar we synthetiseren alle input samen. De multimodale AI-markt, gewaardeerd op $1,6 miljard in 2024, groeit explosief met een samengestelde jaarlijkse groei van 32,7% (CAGR), wat het cruciale belang van de technologie voor ondernemings-AI-strategieën onderstreept. Industrieanalisten voorspellen dat 40% van alle generatieve AI-oplossingen in 2027 multimodaal zal zijn, volgens onderzoek van Gartner. Deze overgang is niet slechts incrementeel; het is een paradigmaverschuiving in hoe organisaties AI inzetten voor concurrentievoordeel. De convergentie van tekst-, beeld- en videoprocessing stelt AI-systemen in staat inzichten en mogelijkheden te leveren die voorheen onmogelijk waren met enkelvoudige benaderingen.

Multimodale AI-systemen gebruiken geavanceerde architecturale componenten om diverse datainput naadloos te verwerken. Encoders zijn gespecialiseerde neurale netwerken die elk datatype — tekst, afbeeldingen en video — omzetten in een uniforme numerieke representatie, embeddings genaamd. Deze embeddings vangen de semantische betekenis van elke modaliteit in een gedeelde wiskundige ruimte, waardoor het systeem informatie over verschillende contenttypen kan vergelijken en relateren. Het fusiemechanisme combineert vervolgens deze embeddings, hetzij via concatenatie, optelling, of meer geavanceerde geleerde fusietechnieken die bepalen hoeveel gewicht elke modaliteit aan het uiteindelijke resultaat moet bijdragen. Cross-attentionmechanismen stellen het model in staat dynamisch te focussen op relevante informatie over modaliteiten; bijvoorbeeld, bij het analyseren van een productafbeelding met begeleidende tekst kan het systeem zich richten op specifieke visuele kenmerken die overeenkomen met tekstuele beschrijvingen. Dit meerstapsproces stelt multimodale systemen in staat contextueel begrip te bereiken dat enkelvoudige systemen niet kunnen evenaren. De volgende tabel illustreert de verschillen in mogelijkheden:

| Mogelijkheid | Unimodale AI | Multimodale AI |

|---|---|---|

| Tekstanalyse | Uitstekend | Uitstekend |

| Beeldbegrip | Beperkt/Géén | Uitstekend |

| Videoprocessing | Beperkt/Géén | Uitstekend |

| Cross-modale redenering | Niet mogelijk | Uitstekend |

| Contextintegratie | Eén bron | Meerdere bronnen |

| Nauwkeurigheid in praktijk | 60-75% | 85-95% |

| Verwerkingssnelheid | Snel | Geoptimaliseerd snel |

Het multimodale AI-landschap wordt gedomineerd door krachtige platforms die nieuwe standaarden voor geïntegreerde verwerking hebben gezet. GPT-4o van OpenAI is een toonaangevend multimodaal model dat tekst, afbeeldingen en video naadloos verwerkt met native integratie van alle modaliteiten. Google Gemini biedt multimodale mogelijkheden op ondernemingsniveau, vooral sterk in het begrijpen van complexe visuele documenten en lange videocontent. Claude van Anthropic levert geavanceerde multimodale redenering met nadruk op nauwkeurigheid en genuanceerd begrip over tekst- en beeldinput. Meta’s ImageBind-technologie laat een andere architecturale aanpak zien door een verenigde embeddingruimte te creëren over zes modaliteiten, waaronder tekst, beeld, audio, diepte, thermisch en IMU-data. Deze platforms vertegenwoordigen de voorhoede van multimodale technologie, elk met eigen architecturale innovaties en optimalisatiestrategieën. Organisaties die multimodale platforms kiezen, moeten niet alleen kijken naar de breedte van mogelijkheden, maar ook naar prestatieoptimalisatie, kostenefficiëntie en integratie met bestaande workflows.

Multimodale AI transformeert bedrijfsvoering in vrijwel elke sector en levert meetbare verbeteringen in efficiëntie, nauwkeurigheid en klantbeleving. Organisaties die deze technologieën implementeren rapporteren opmerkelijke resultaten:

Zorg: Radiologen gebruiken multimodale AI om medische beelden te analyseren in combinatie met patiëntendossiers en klinische notities, waardoor de diagnostische nauwkeurigheid toeneemt en analysetijd tot 40% afneemt. AI-systemen kunnen visuele bevindingen koppelen aan tekstuele medische geschiedenis om patronen te ontdekken die mensen mogelijk missen.

Retail: Mode- en e-commercebedrijven gebruiken multimodale AI om klantomschrijvingen te koppelen aan visuele inventaris, waardoor “zoeken op beschrijving”-mogelijkheden ontstaan die conversieratio’s verhogen. Productaanbevelingen worden significant beter wanneer AI zowel visuele voorkeuren als tekstuele feedback begrijpt.

Productie: Kwaliteitscontroleprocessen versnellen enorm met multimodale inspectiesystemen die visuele defectdetectie combineren met sensordata en onderhoudslogs, met 100x snellere catalogisering van productieproblemen ten opzichte van handmatige processen.

Contentcreatie: Mediabedrijven gebruiken multimodale AI om automatisch bijschriften, transcripties en metadata voor videocontent te genereren, waarbij 72% van de media-executives met generatieve AI positieve ROI meldt op hun investeringen.

Klantenservice: Chatbots met multimodale mogelijkheden kunnen klantafbeeldingen van problemen samen met tekstuele beschrijvingen verwerken en zo nauwkeuriger en contextueel support leveren.

Landbouw: Boeren zetten multimodale systemen in die gewasbeelden, weersgegevens en bodemsensoren analyseren om irrigatie, bemesting en plaagbestrijding te optimaliseren.

Robotica: Autonome systemen gebruiken multimodale waarneming om complexe omgevingen te navigeren, waarbij visuele input wordt gecombineerd met audiocues en tactiele feedback voor veiligere, intelligentere werking.

Om de effectiviteit van multimodale AI-systemen te maximaliseren, vereist tekstcontent bewuste optimalisatiestrategieën die de machineleesbaarheid en contextueel begrip versterken. Structured data markup volgens schema.org-standaarden helpt AI-systemen om semantische relaties binnen je content te begrijpen, wat nauwkeurigere cross-modale connecties mogelijk maakt. Het gebruik van conversatietaal in plaats van alleen formeel proza stelt multimodale systemen in staat intentie en context beter te begrijpen, vooral wanneer tekst samen met visuele of video-elementen wordt verwerkt. Beschrijvende koppen en subkoppen dienen een dubbel doel: ze leiden menselijke lezers én geven AI-systemen cruciale structuur om informatie te ordenen en te prioriteren. Relevante zoekwoorden in natuurlijke contexten opnemen — in plaats van geforceerde keyword stuffing — zorgt dat tekstcontent aansluit bij hoe multimodale systemen onderwerpenrelaties over modaliteiten identificeren. Metadata-optimalisatie, waaronder title tags, meta descriptions en gestructureerde data-attributen, geeft expliciete signalen over de betekenis van content die multimodale systemen benutten. Organisaties moeten ook overwegen hoe tekst visuele content aanvult; bijschriften en alt-tekst zijn niet alleen toegankelijkheidsfeatures — het zijn essentiële optimalisatie-elementen waarmee multimodale AI de relatie tussen tekstuele en visuele informatie begrijpt.

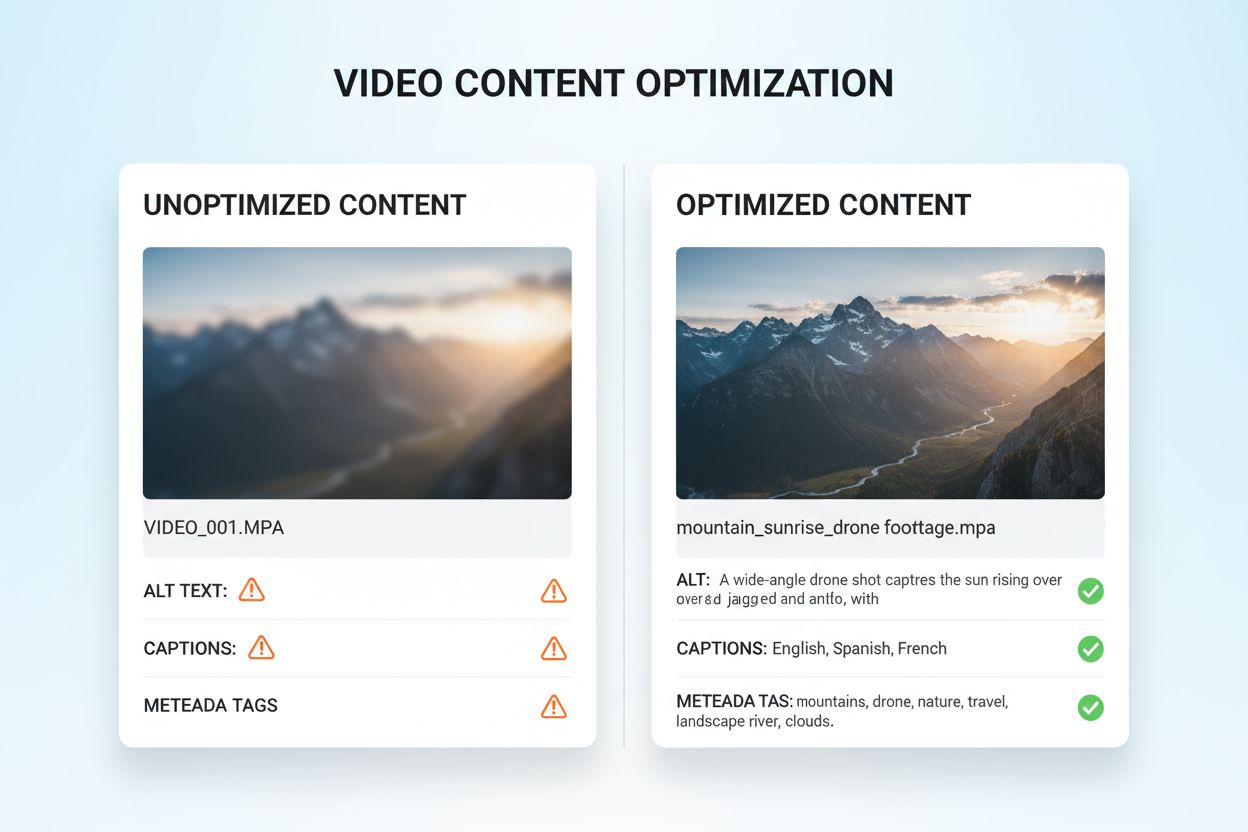

Voor multimodale AI vereist optimalisatie van visuele en video-inhoud een allesomvattende aanpak die veel verder gaat dan traditionele SEO-praktijken. Beschrijvende alt-tekst is fundamenteel; in plaats van generieke beschrijvingen moet alt-tekst de semantische betekenis, context en relevante details bevatten die AI-systemen helpen begrijpen wat de afbeelding overbrengt. Bestandsnaamconventies zijn van groot belang — beschrijvende bestandsnamen zoals “product-vergelijkingsgrafiek-2024.jpg” geven essentiële context die AI-systemen gebruiken om het doel van de content te begrijpen. Videobijschriften en transcripties zijn essentieel; ze stellen multimodale systemen in staat gesproken inhoud te correleren met visuele elementen, wat het begrip van complexe videomateriaal sterk verbetert. Metadata-velden zoals titel, beschrijving en tags moeten specifiek en accuraat ingevuld worden, omdat deze velden direct bepalen hoe AI-systemen visuele content categoriseren en relateren aan andere modaliteiten. Beeldcompressie en technische optimalisatie zorgen ervoor dat de visuele kwaliteit hoog genoeg blijft voor AI-analyse en tegelijkertijd snelle laadtijden behoudt. Gestructureerde data voor visuele content, waaronder markup voor afbeeldingen, video’s en mediagalerijen, geeft expliciete signalen over contentrelaties. Organisaties moeten ook temporele metadata voor videocontent overwegen — het markeren van belangrijke momenten, scènewisselingen en onderwerpsovergangen helpt multimodale systemen om narratieve structuren te begrijpen en relevante segmenten te extraheren.

Multimodale AI-systemen gebruiken twee hoofdarchitecturen, elk met eigen voordelen en afwegingen. Verenigde architecturen verwerken alle modaliteiten via één geïntegreerd neuraal netwerk dat vanaf het begin gezamenlijke representaties leert. Deze aanpak levert doorgaans superieure cross-modale redenering omdat het systeem diepgaand begrijpt hoe modaliteiten zich tot elkaar verhouden, maar vereist meer rekenkracht en langere training. Modulaire architecturen behouden afzonderlijke gespecialiseerde netwerken voor elke modaliteit en combineren hun output via fusiemechanismen. Dit biedt meer flexibiliteit, waardoor organisaties individuele modaliteitsprocessors kunnen vervangen zonder het hele systeem opnieuw te trainen, en vereist doorgaans minder rekenkracht. Mixture of Experts (MoE)-modellen zijn een opkomende hybride aanpak, waarbij verschillende expert-netwerken gespecialiseerd zijn in verschillende modaliteiten of taken, en een selectiemechanisme input naar de juiste experts stuurt. Deze architectuur behaalt efficiëntieverbeteringen van 30-50% ten opzichte van dense verenigde modellen, terwijl de nauwkeurigheid vergelijkbaar blijft. De keuze tussen architecturen hangt af van de use case: verenigde architecturen blinken uit in complexe redeneervraagstukken die diep cross-modale inzichten vereisen, terwijl modulaire benaderingen geschikt zijn voor scenario’s waar flexibiliteit en efficiëntie belangrijk zijn.

Effectieve implementatie van multimodale AI vereist robuuste meetkaders die zowel technische prestaties als zakelijke impact volgen. Belangrijke prestatie-indicatoren (KPI’s) moeten nauwkeurigheidsstatistieken per modaliteit bevatten, kwaliteit van cross-modale redenering, verwerkingssnelheid en kosten per inferentie. Analyseplatforms moeten in kaart brengen hoe multimodale AI downstream-bedrijfsstatistieken beïnvloedt: conversieratio’s in retail, diagnostische nauwkeurigheid in de zorg, productie-efficiëntie in de industrie. Organisaties moeten attributietracking implementeren om te begrijpen welke modaliteit het meest bijdraagt aan specifieke resultaten — dit inzicht stuurt optimalisatie en resource-allocatie. ROI-meting moet rekening houden met zowel directe kostenbesparingen (zoals de 100x snellere catalogisering in de industrie) als indirecte voordelen zoals verbeterde klanttevredenheid of minder fouten. Monitoringtools moeten in de gaten houden of modelprestaties na verloop van tijd achteruitgaan, want real-world datadrift kan de nauwkeurigheid van multimodale systemen verminderen als die niet actief wordt beheerd. Voor organisaties die AI-gegenereerde content en inzichten gebruiken, wordt bronverwijzing en attributietracking steeds belangrijker; tools zoals AmICited.com helpen monitoren hoe AI-systemen bronnen citeren en informatie toeschrijven, wat inzicht geeft in AI-beslissingen en naleving van herkomstvereisten waarborgt. Regelmatige prestatie-audits en optimalisatiecycli zorgen ervoor dat multimodale systemen waarde blijven leveren naarmate bedrijfsbehoeften en datapatronen evolueren.

Het multimodale AI-landschap blijft zich snel ontwikkelen, met diverse baanbrekende trends die bepalen hoe organisaties deze technologie zullen inzetten. Stemintegratie is het volgende grensgebied, doordat systemen audio-input combineren met visuele en tekstuele data en zo een werkelijk volledig begrip van menselijke communicatie en omgevingscontext bereiken. Agentische AI-systemen — AI-agenten die zelfstandig meerstaps taken kunnen plannen en uitvoeren — zullen multimodale perceptie inzetten om complexe reële scenario’s te navigeren, van autonome voertuigen tot robotisering van bedrijfsprocessen. Realtime verwerking ontwikkelt zich snel, waardoor multimodale analyse van live videostreams, audiostromen en sensordata mogelijk wordt, en nieuwe kansen ontstaan voor directe beslissingen in tijdkritische toepassingen. Efficiëntieverbeteringen via technieken als distillatie en kwantisatie maken geavanceerde multimodale mogelijkheden toegankelijk voor organisaties met beperkte rekenkracht en democratiseren zo geavanceerde AI. Gespecialiseerde domeinmodellen verschijnen, waarbij multimodale systemen worden afgestemd op sectoren zoals zorg, juridisch of financiële dienstverlening en zo betere prestaties leveren dan algemene modellen. De convergentie van deze trends suggereert dat multimodale AI zal evolueren van een concurrentievoordeel tot een basisvoorwaarde voor organisaties die relevant willen blijven in een steeds meer AI-gedreven wereld. Organisaties die vandaag hun content en processen optimaliseren voor multimodale AI, zijn het best gepositioneerd om te profiteren van deze nieuwe mogelijkheden in de toekomst.

Multimodale AI verwerkt meerdere datatypes (tekst, afbeeldingen, audio, video) gelijktijdig, terwijl traditionele unimodale AI slechts één type aankan. Dit zorgt voor een rijker contextbegrip en meer nauwkeurige output. Multimodale systemen begrijpen relaties tussen verschillende modaliteiten en leveren inzichten die enkelvoudige systemen niet kunnen evenaren.

Nu multimodale AI de standaard wordt voor generatieve AI-oplossingen (naar verwachting 40% tegen 2027), zorgt optimalisatie van uw content voor betere zichtbaarheid in AI-gegenereerde antwoorden. Organisaties die optimaliseren over tekst, afbeelding en video zien meer AI-verwijzingen, betere zichtbaarheid op platforms zoals ChatGPT en Gemini, en betere algehele contentprestatie.

Volg belangrijke statistieken zoals nauwkeurigheid over modaliteiten, kwaliteit van cross-modale redenering, verwerkingssnelheid en zakelijke impact (conversieratio's, betrokkenheid, enz.). Gebruik tools zoals AmICited.com om te volgen hoe AI-systemen uw content citeren en implementeer analytics om te begrijpen welke modaliteiten het meeste bijdragen aan uw bedrijfsresultaten.

Belangrijke uitdagingen zijn onder andere het waarborgen van consistente metadata over modaliteiten, het behouden van hoge kwaliteit alt-teksten en bijschriften, het afstemmen van tijdsgegevens in video's en het beheren van de benodigde rekenkracht. Organisaties moeten ook plannen voor datavoorbereiding (10-20% van het projectbudget) en verandermanagement wanneer teams zich aanpassen aan nieuwe optimalisatiepraktijken.

Zorg, retail, productie, contentcreatie, klantenservice, landbouw en robotica zien allemaal aanzienlijke voordelen. De zorg gebruikt het voor diagnostische nauwkeurigheid, retail voor productontdekking, productie voor kwaliteitscontrole (100x snellere catalogisering), en mediabedrijven melden 72% ROI op generatieve AI-investeringen.

AmICited.com monitort hoe AI-systemen zoals ChatGPT, Perplexity en Google AI Overviews uw content citeren over verschillende modaliteiten. Het biedt realtime inzicht in uw AI-zoekaanwezigheid, zodat u begrijpt hoe uw tekst-, beeld- en videocontent wordt genoemd in AI-gegenereerde antwoorden.

Verenigde architecturen verwerken alle modaliteiten via één geïntegreerd netwerk, wat superieure cross-modale redenering oplevert maar meer rekenkracht vereist. Modulaire architecturen behouden afzonderlijke netwerken per modaliteit en bieden meer flexibiliteit en efficiëntie. Mixture of Experts (MoE)-modellen bieden een hybride aanpak met 30-50% efficiëntieverbetering.

Optimaliseer tekst met gestructureerde data en conversatietaal, voeg beschrijvende alt-tekst en metadata toe aan afbeeldingen, voeg bijschriften en transcripties toe aan video en gebruik consistente bestandsnamen. Zorg dat alle modaliteiten samenwerken voor volledige context en implementeer schema markup om AI-systemen te helpen semantische relaties te begrijpen.

Volg hoe multimodale AI-systemen uw content citeren in ChatGPT, Perplexity, Google AI Overviews en andere platforms. Krijg realtime inzicht in uw AI-zoekaanwezigheid.

Ontdek hoe multimodale AI-zoeksystemen tekst, afbeeldingen, audio en video samen verwerken om nauwkeurigere en contextueel relevantere resultaten te leveren dan...

Beheers optimalisatie voor multimodale AI-zoekopdrachten. Leer hoe je afbeeldingen en spraakvragen optimaliseert voor door AI aangedreven zoekresultaten, met st...

Ontdek wat multi-modale content voor AI is, hoe het werkt, en waarom het belangrijk is. Bekijk voorbeelden van multi-modale AI-systemen en hun toepassingen in v...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.