Multimodale AI-zoekopdracht

Ontdek hoe multimodale AI-zoeksystemen tekst, afbeeldingen, audio en video samen verwerken om nauwkeurigere en contextueel relevantere resultaten te leveren dan...

Beheers optimalisatie voor multimodale AI-zoekopdrachten. Leer hoe je afbeeldingen en spraakvragen optimaliseert voor door AI aangedreven zoekresultaten, met strategieën voor GPT-4o, Gemini en LLM’s.

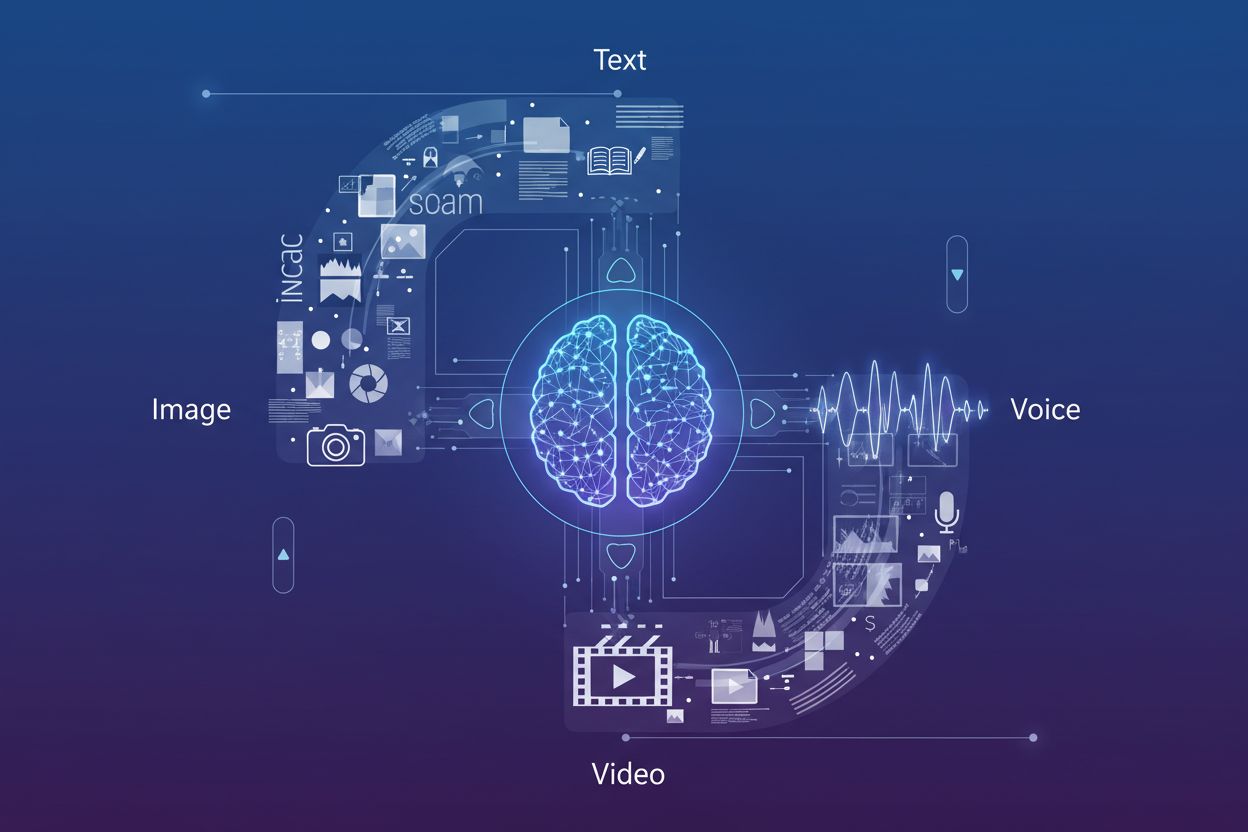

Multimodale AI-zoekopdracht betekent een fundamentele verschuiving in hoe zoekmachines gebruikersvragen verwerken en begrijpen door verschillende gegevenstypen—tekst, afbeeldingen, spraak en video—te integreren in één zoekervaring. In plaats van elke modality als een apart kanaal te behandelen, maken moderne zoeksystemen nu gebruik van multimodale AI-modellen die gelijktijdig informatie uit verschillende formaten kunnen analyseren en met elkaar in verband brengen, wat meer contextuele en nauwkeurige resultaten mogelijk maakt. Deze evolutie van zoekopdrachten met één modality (waarbij tekstvragen tekstresultaten opleverden) naar geïntegreerde multimodale systemen weerspiegelt de realiteit van hoe gebruikers van nature met informatie omgaan—gesproken vragen combineren met visuele referenties, afbeeldingen uploaden voor context en resultaten verwachten die meerdere contenttypen combineren. Het belang van deze verschuiving kan niet worden overschat: het verandert fundamenteel hoe contentmakers hun digitale aanwezigheid moeten optimaliseren en hoe merken hun zichtbaarheid in zoekkanalen moeten monitoren. Inzicht in multimodale zoekoptimalisatie is niet langer optioneel voor bedrijven die hun zichtbaarheid willen behouden in door AI aangedreven zoekomgevingen.

De opkomst van geavanceerde multimodale modellen heeft zoekmogelijkheden getransformeerd, waarbij verschillende toonaangevende platforms nu geavanceerde visie-taalmodellen aanbieden die content over meerdere modaliteiten gelijktijdig kunnen verwerken en begrijpen. Dit is hoe de belangrijkste spelers zich tot elkaar verhouden:

| Modelnaam | Maker | Belangrijkste mogelijkheden | Beste voor |

|---|---|---|---|

| GPT-4o | OpenAI | Real-time beeldanalyse, spraakverwerking, 320ms reactie | Complexe visuele redenering, multimodale gesprekken |

| Gemini | Geïntegreerde zoekopdracht, video-inzicht, cross-modale redenering | Zoekintegratie, uitgebreide contentanalyse | |

| Claude 3.7 | Anthropic | Documentanalyse, beeldinterpretatie, genuanceerd begrip | Technische documentatie, gedetailleerde visuele analyse |

| LLaVA | Open-source community | Lichtgewicht visie-taalverwerking, efficiënte inferentie | Omgevingen met beperkte middelen, edge deployment |

| ImageBind | Meta | Cross-modale embeddings, audio-visueel begrip | Multimediale contentcorrelatie, semantische zoekopdracht |

Deze modellen vertegenwoordigen de voorhoede van AI-zoektechnologie, elk geoptimaliseerd voor verschillende gebruiksscenario’s en implementatiecontexten. Organisaties moeten begrijpen welke modellen hun doelzoekplatforms aandrijven om content effectief te optimaliseren voor vindbaarheid. Door de snelle technologische vooruitgang moeten strategieën voor zoekzichtbaarheid flexibel en aanpasbaar blijven om nieuwe mogelijkheden en rankingfactoren te kunnen benutten.

Beeldzoekoptimalisatie is essentieel geworden nu visuele zoekmogelijkheden enorm zijn uitgebreid—Google Lens registreerde alleen al 10 miljoen bezoeken in mei 2025, wat de explosieve groei van beeldgebaseerde zoekopdrachten aantoont. Om de zichtbaarheid in beeldzoek AI-resultaten te maximaliseren, moeten contentmakers een uitgebreide optimalisatiestrategie hanteren:

Deze veelzijdige aanpak zorgt ervoor dat afbeeldingen niet alleen vindbaar zijn via traditionele beeldzoekopdrachten, maar ook via multimodale AI-systemen die visuele content in samenhang met omliggende tekst en metadata analyseren.

De integratie van Large Language Models in spraakzoekopdrachten heeft fundamenteel veranderd hoe zoekmachines gesproken vragen interpreteren en beantwoorden, en gaat veel verder dan eenvoudige zoekwoordherkenning richting geavanceerd contextueel begrip. Traditionele spraakzoekopdrachten waren afhankelijk van fonetische herkenning en basale natuurlijke taalverwerking, maar moderne LLM-gestuurde spraakzoekopdrachten begrijpen nu intentie, context, nuance en conversatiepatronen met opmerkelijke precisie. Dit betekent dat optimalisatie voor spraakzoekopdrachten niet langer alleen op exacte zoekwoorden kan focussen; in plaats daarvan moet content zo gestructureerd worden dat deze inspeelt op de achterliggende intentie van conversatievragen die gebruikers natuurlijk uitspreken. De implicaties zijn groot: een gebruiker die vraagt “Wat is de beste manier om een lekkende keukenkraan te repareren?” zoekt fundamenteel iets anders dan iemand die “lekkende kraan repareren” typt, en content moet zowel de vraag als de impliciete behoefte aan stapsgewijze instructies adresseren. Featured snippets zijn uitgegroeid tot de primaire bron voor spraakzoekantwoorden, waarbij zoekmachines de voorkeur geven aan beknopte, directe antwoorden bovenaan de zoekresultaten. Inzicht in deze hiërarchie—waarbij spraakzoekantwoorden uit featured snippets worden gehaald—is essentieel voor elke contentstrategie gericht op spraakgestuurde apparaten en assistenten.

Optimaliseren voor conversatievragen vereist een fundamentele herstructurering van hoe content is georganiseerd en gepresenteerd: weg van zoekwoordrijke alinea’s, richting natuurlijke vraag-antwoord-formaten die weerspiegelen hoe mensen daadwerkelijk spreken. Content moet worden opgebouwd rond vraaggerichte koppen die direct veelvoorkomende vragen van gebruikers beantwoorden, gevolgd door korte, gezaghebbende antwoorden die direct waarde bieden zonder dat gebruikers door lange uitleg hoeven te zoeken. Deze aanpak sluit aan bij hoe natuurlijke taalverwerkende systemen antwoorden uit webcontent halen—ze zoeken naar duidelijke vraag-antwoordparen en directe uitspraken die door spraakassistenten kunnen worden voorgelezen. Het implementeren van gestructureerde data markup die expliciet vragen en antwoorden identificeert helpt zoekmachines het conversatiekarakter van uw content te begrijpen en vergroot de kans om geselecteerd te worden voor spraakzoekresultaten. Long-tail, conversatiegerichte zinnen moeten op een natuurlijke manier door de content heen worden verwerkt en niet kunstmatig in zoekwoorden worden gepropt. Het doel is content te creëren die natuurlijk klinkt als deze wordt voorgelezen, en tegelijkertijd geoptimaliseerd is voor AI-systemen die informatie uit uw pagina’s halen. Deze balans tussen menselijke leesbaarheid en machine-interpretatie is de sleutel tot effectieve spraakzoekoptimalisatie.

Het correct implementeren van schema markup is essentieel om aan multimodale AI-systemen duidelijk te maken wat uw content voorstelt en hoe deze geïnterpreteerd moet worden in verschillende zoekcontexten. De meest effectieve gestructureerde data implementaties voor multimodale zoekopdrachten zijn onder andere FAQ-schema (waarmee vraag-antwoordparen expliciet worden gemarkeerd voor spraakzoekopdrachten), HowTo-schema (dat stapsgewijze instructies in machineleesbaar formaat biedt) en Local Business-schema (voor locatiegebaseerde multimodale vragen). Naast deze hoofdtypen zorgen ook Article-schema, Product-schema en Event-schema ervoor dat uw content correct wordt gecategoriseerd en begrepen door AI-systemen die uw pagina’s analyseren. De Rich Results Test van Google moet regelmatig worden gebruikt om te valideren dat uw schema markup correct is geïmplementeerd en wordt herkend door zoeksystemen. De technische SEO-basis—schone HTML-structuur, snelle laadtijden, mobiele responsiviteit en juiste canonicalisatie—wordt nog belangrijker in multimodale zoekomgevingen, waar AI-systemen uw content snel moeten kunnen verwerken in verschillende formaten. Organisaties dienen hun volledige contentbibliotheek te auditen om kansen voor schema-implementatie te identificeren, met prioriteit voor pagina’s met veel verkeer en content die zich leent voor vraag-antwoord- of instructieformaten.

Prestaties in multimodale zoekopdrachten meten vereist een verschuiving naar andere metrics dan traditionele organische traffic, met specifieke focus op featured snippet vertoningen, spraakzoekbetrokkenheid en conversieratio’s uit multimodale bronnen. Google Search Console geeft inzicht in prestaties van featured snippets, toont hoe vaak uw content in positie nul verschijnt en welke zoekopdrachten uw snippets activeren—gegevens die direct samenhangen met zichtbaarheid in spraakzoekopdrachten. Mobiele engagement metrics worden steeds belangrijker omdat spraakzoekopdrachten vooral via mobiele apparaten en smart speakers worden gebruikt, waardoor mobiele conversieratio’s en sessieduur kritieke KPI’s zijn voor spraakgeoptimaliseerde content. Analyticsplatforms moeten zo worden ingesteld dat verkeer uit spraakassistenten en beeldzoekopdrachten apart wordt gevolgd van traditionele organische zoekopdrachten, zodat u begrijpt welke multimodale kanalen het meest waardevolle verkeer genereren. Spraakzoekmetrics moeten niet alleen verkeersvolume omvatten, maar ook conversiekwaliteit, aangezien spraakzoekers vaak andere intenties en gedragspatronen hebben dan tekstzoekers. Monitoren van merkvermeldingen in AI Overviews en andere AI-gegenereerde zoekresultaten geeft inzicht in hoe uw merk wordt weergegeven in deze nieuwe zoekformaten. Regelmatige audits van uw featured snippet prestaties, gecombineerd met analyse van spraakzoekverkeer, bieden een compleet beeld van uw multimodale zoekzichtbaarheid en ROI.

De ontwikkeling van multimodale zoekopdrachten wijst op steeds geavanceerdere AI-zoektrends die de grenzen tussen zoeken, browsen en directe taakafhandeling vervagen, waarbij AI Overviews nu al een stijging van 10%+ in gebruik laten zien naarmate gebruikers AI-gegenereerde samenvattingen omarmen. Opkomende mogelijkheden omvatten agentische AI-systemen die namens gebruikers handelingen kunnen uitvoeren—zoals reserveringen maken, aankopen doen of afspraken plannen—op basis van multimodale vragen die spraak, beeld en contextuele informatie combineren. Personalisatie zal steeds verfijnder worden, waarbij AI-systemen niet alleen begrijpen wat gebruikers vragen maar ook hun voorkeuren, locatie, aankoopgeschiedenis en gedragspatronen om hyperrelevante resultaten te leveren over alle modaliteiten heen. Real-time zoekmogelijkheden breiden uit, zodat gebruikers vragen kunnen stellen over live evenementen, actuele omstandigheden of het laatste nieuws, met de verwachting van directe, nauwkeurige antwoorden die uit meerdere bronnen zijn gesynthetiseerd. Videosearch zal volwassen worden als primaire modality, waarbij AI-systemen niet alleen videometadata maar ook de daadwerkelijke inhoud van video’s begrijpen, waardoor gebruikers kunnen zoeken naar specifieke momenten, concepten of informatie binnen videobibliotheken. Het concurrentielandschap zal steeds meer in het voordeel zijn van merken die over alle modaliteiten geoptimaliseerd zijn, omdat zichtbaarheid in het ene kanaal (featured snippets, beeldzoekopdracht, spraakresultaten) direct invloed heeft op zichtbaarheid in andere via cross-modale rankingsignalen.

Nu multimodale zoekopdrachten de norm worden, is AI-monitoring geëvolueerd van het bijhouden van eenvoudige zoekposities naar uitgebreide merkcitatie-monitoring over beeldzoekopdrachten, spraakresultaten en AI-gegenereerde overzichten. AmICited biedt essentieel inzicht in hoe uw merk verschijnt in AI Overviews, featured snippets en spraakzoekresultaten—en monitort niet alleen of u rankt, maar ook hoe uw merk wordt weergegeven en geciteerd door AI-systemen die informatie uit meerdere bronnen combineren. Het platform volgt beeldcitaten in visuele zoekresultaten, zodat uw visuele content correct wordt toegeschreven en gelinkt naar uw domein, wat zowel uw SEO-autoriteit als merkzichtbaarheid beschermt. Spraakzoekvermeldingen worden gemonitord over smart speakers en spraakassistenten, zodat u ziet hoe uw content wordt voorgelezen en gepresenteerd aan gebruikers in spraakgerichte contexten waar traditionele doorklikmetrics niet gelden. Nu AI-gegenereerde zoekresultaten een aanzienlijk deel van de gebruikersinteracties uitmaken, is inzicht in uw zichtbaarheid in deze nieuwe formaten cruciaal—AmICited biedt de monitoringinfrastructuur die nodig is om uw aanwezigheid over alle multimodale zoekkanalen te volgen, meten en optimaliseren. Voor merken die serieus werk willen maken van concurrerende zichtbaarheid in het door AI gedreven zoeklandschap, is uitgebreide multimodale monitoring via platforms als AmICited niet langer optioneel maar essentieel om uw digitale aanwezigheid te begrijpen en te beschermen.

Multimodale AI-zoekopdracht integreert meerdere gegevenstypen—tekst, afbeeldingen, spraak en video—tot één zoekervaring. Moderne zoeksystemen maken nu gebruik van multimodale AI-modellen die informatie uit verschillende formaten gelijktijdig kunnen analyseren en correleren, wat meer contextuele en nauwkeurige resultaten mogelijk maakt dan zoekopdrachten met slechts één modality.

Optimaliseer afbeeldingen door gebruik te maken van hoogwaardige, originele beelden met beschrijvende bestandsnamen en uitgebreide alt-teksten. Implementeer schema markup, geef contextuele omringende tekst, toon meerdere hoeken van hetzelfde onderwerp en comprimeer bestanden voor snelle laadtijden. Deze praktijken zorgen voor zichtbaarheid in zowel traditionele beeldzoekopdrachten als multimodale AI-systemen.

Featured snippets zijn de primaire bron voor antwoorden bij spraakzoekopdrachten. Spraakassistenten halen beknopte, directe antwoorden uit positie nul-resultaten op de zoekresultatenpagina's. Content optimaliseren om in featured snippets te verschijnen is essentieel voor zichtbaarheid en ranking in spraakzoekopdrachten.

Structureer content met vraaggerichte koppen die direct veelvoorkomende spraakvragen beantwoorden, gevolgd door korte antwoorden. Gebruik natuurlijke, conversatiestijl taal en implementeer gestructureerde data markup (FAQ-schema, HowTo-schema) om AI-systemen te helpen het conversatiekarakter van uw content te begrijpen.

De belangrijkste multimodale modellen zijn GPT-4o (OpenAI), Gemini (Google), Claude 3.7 (Anthropic), LLaVA (open-source) en ImageBind (Meta). Elk heeft verschillende mogelijkheden en toepassingsgebieden. Weten welke modellen uw doelzoekplatforms aandrijven helpt om content effectief te optimaliseren.

Volg featured snippet vertoningen in Google Search Console, monitor mobiele engagement metrics, analyseer spraakzoekverkeer apart van traditionele organische zoekopdrachten en meet conversieratio's uit multimodale bronnen. Monitor merkvermeldingen in AI Overviews en volg hoe uw content verschijnt op verschillende modaliteiten.

AmICited monitort hoe uw merk verschijnt in AI Overviews, featured snippets, beeldzoekresultaten en spraakzoekantwoorden. Nu AI-gegenereerde zoekresultaten dominant worden, is uitgebreide multimodale monitoring essentieel om uw digitale aanwezigheid in alle zoekkanalen te begrijpen en te beschermen.

De toekomst omvat steeds geavanceerdere AI-systemen met agentische capaciteiten die namens gebruikers handelingen kunnen uitvoeren, hyper-gepersonaliseerde resultaten op basis van voorkeuren en gedrag, realtime zoekopdrachten voor live evenementen en volwassen videosearchmogelijkheden. Merken die geoptimaliseerd zijn over alle modaliteiten zullen concurrentievoordelen hebben.

Volg hoe uw merk verschijnt in AI Overviews, beeldzoekresultaten en spraakzoekantwoorden. Krijg realtime inzicht in uw aanwezigheid binnen multimodale zoekopdrachten.

Ontdek hoe multimodale AI-zoeksystemen tekst, afbeeldingen, audio en video samen verwerken om nauwkeurigere en contextueel relevantere resultaten te leveren dan...

Ontdek hoe je tekst, afbeeldingen en video optimaliseert voor multimodale AI-systemen. Leer strategieën om AI-verwijzingen en zichtbaarheid te verbeteren in Cha...

Ontdek wat multi-modale content voor AI is, hoe het werkt, en waarom het belangrijk is. Bekijk voorbeelden van multi-modale AI-systemen en hun toepassingen in v...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.