Beïnvloedt JavaScript AI-Crawling? Impact op Zichtbaarheid in AI-zoekresultaten

Ontdek hoe JavaScript de zichtbaarheid voor AI-crawlers beïnvloedt. Leer waarom AI-bots geen JavaScript kunnen renderen, welke inhoud verborgen blijft en hoe u ...

Ontdek hoe prerendering JavaScript-inhoud zichtbaar maakt voor AI-crawlers zoals ChatGPT, Claude en Perplexity. Leer de beste technische oplossingen voor AI-zoekoptimalisatie en verbeter je zichtbaarheid in AI-gestuurde zoekresultaten.

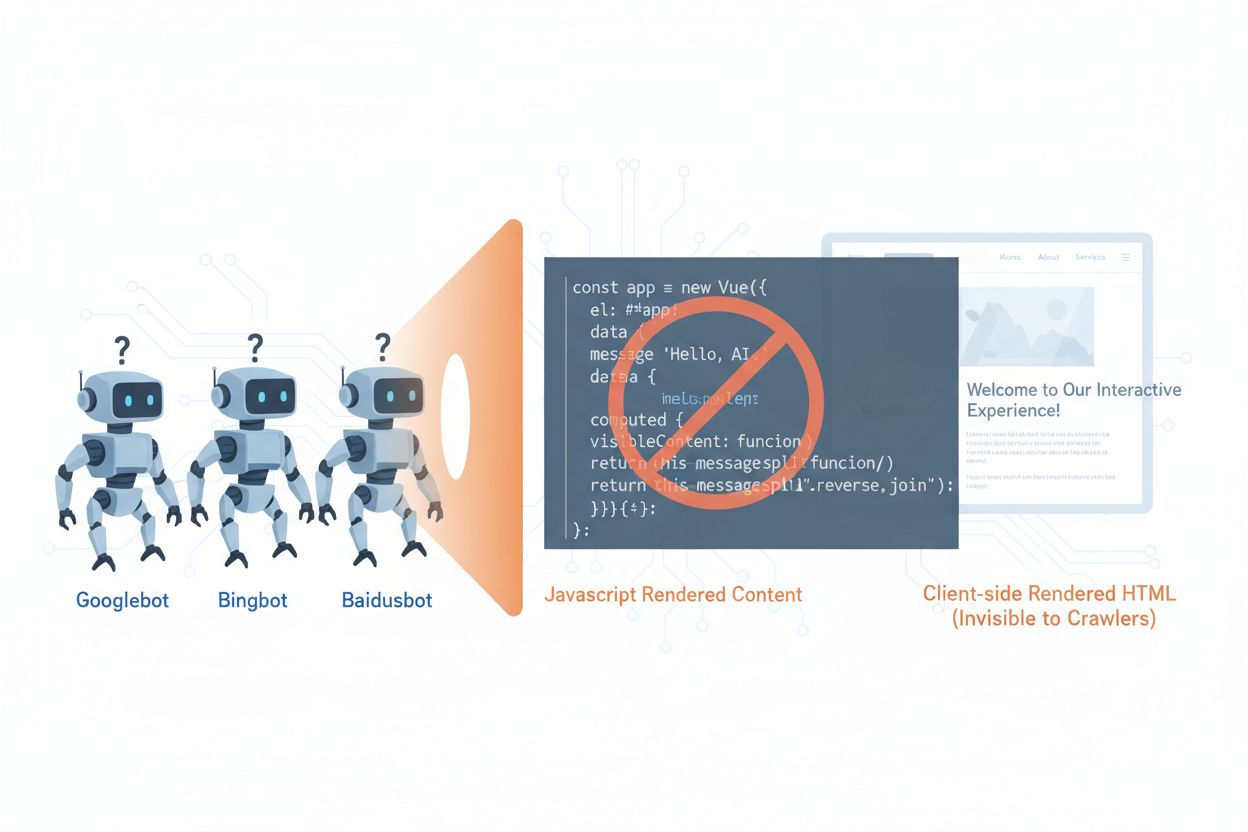

AI-crawlers zoals GPTBot, ClaudeBot en PerplexityBot hebben de manier waarop inhoud wordt ontdekt en geïndexeerd op het web fundamenteel veranderd, maar ze hebben een cruciale beperking: ze kunnen geen JavaScript uitvoeren. Dit betekent dat alle inhoud die dynamisch wordt weergegeven via JavaScript—die moderne single-page applicaties (SPA’s), dynamische productpagina’s en interactieve dashboards aandrijft—volledig onzichtbaar blijft voor deze crawlers. Volgens recente gegevens zijn AI-crawlers nu goed voor ongeveer 28% van het Googlebot-verkeer, wat ze een aanzienlijk deel van het crawlbudget van uw site maakt en een cruciale factor in de toegankelijkheid van inhoud. Wanneer een AI-crawler een pagina opvraagt, ontvangt deze de initiële HTML-shell zonder de gerenderde inhoud, en ziet dus effectief een lege of onvolledige versie van uw site. Dit creëert een paradox: uw inhoud is perfect zichtbaar voor menselijke gebruikers met JavaScript-ingeschakelde browsers, maar onzichtbaar voor de AI-systemen die in toenemende mate invloed hebben op contentontdekking, samenvatting en ranking in AI-gestuurde zoekmachines en applicaties.

De technische redenen achter de JavaScript-beperkingen van AI-crawlers komen voort uit fundamentele architectuurverschillen tussen de manier waarop browsers en crawlers webinhoud verwerken. Browsers beschikken over een volledige JavaScript-engine die code uitvoert, het DOM (Document Object Model) manipuleert en de uiteindelijke visuele output weergeeft, terwijl AI-crawlers doorgaans minimale of geen JavaScript-uitvoermogelijkheden hebben vanwege resourcebeperkingen en beveiligingsoverwegingen. Asynchrone laadtijden—waarbij inhoud van API’s wordt opgehaald na het eerste paginalaadmoment—vormen een extra grote uitdaging, omdat crawlers alleen de initiële HTML ontvangen voordat de inhoud arriveert. Single-page applicaties (SPA’s) verergeren dit probleem doordat ze volledig vertrouwen op client-side routing en rendering, waardoor crawlers alleen een JavaScript-bundel ontvangen. Hier ziet u hoe verschillende renderingsmethodes zich verhouden qua zichtbaarheid voor AI-crawlers:

| Renderingsmethode | Werking | Zichtbaarheid voor AI-crawler | Prestaties | Kosten |

|---|---|---|---|---|

| CSR (Client-Side Rendering) | Browser voert JavaScript uit om inhoud weer te geven | ❌ Slecht | Snel voor gebruikers | Lage infrastructuur |

| SSR (Server-Side Rendering) | Server rendert HTML bij elk verzoek | ✅ Uitstekend | Tragere eerste laadtijd | Hoge infrastructuur |

| SSG (Static Site Generation) | Inhoud vooraf gebouwd tijdens build | ✅ Uitstekend | Snelst | Gemiddeld (buildtijd) |

| Prerendering | Statische HTML on-demand gecachet | ✅ Uitstekend | Snel | Gemiddeld (gebalanceerd) |

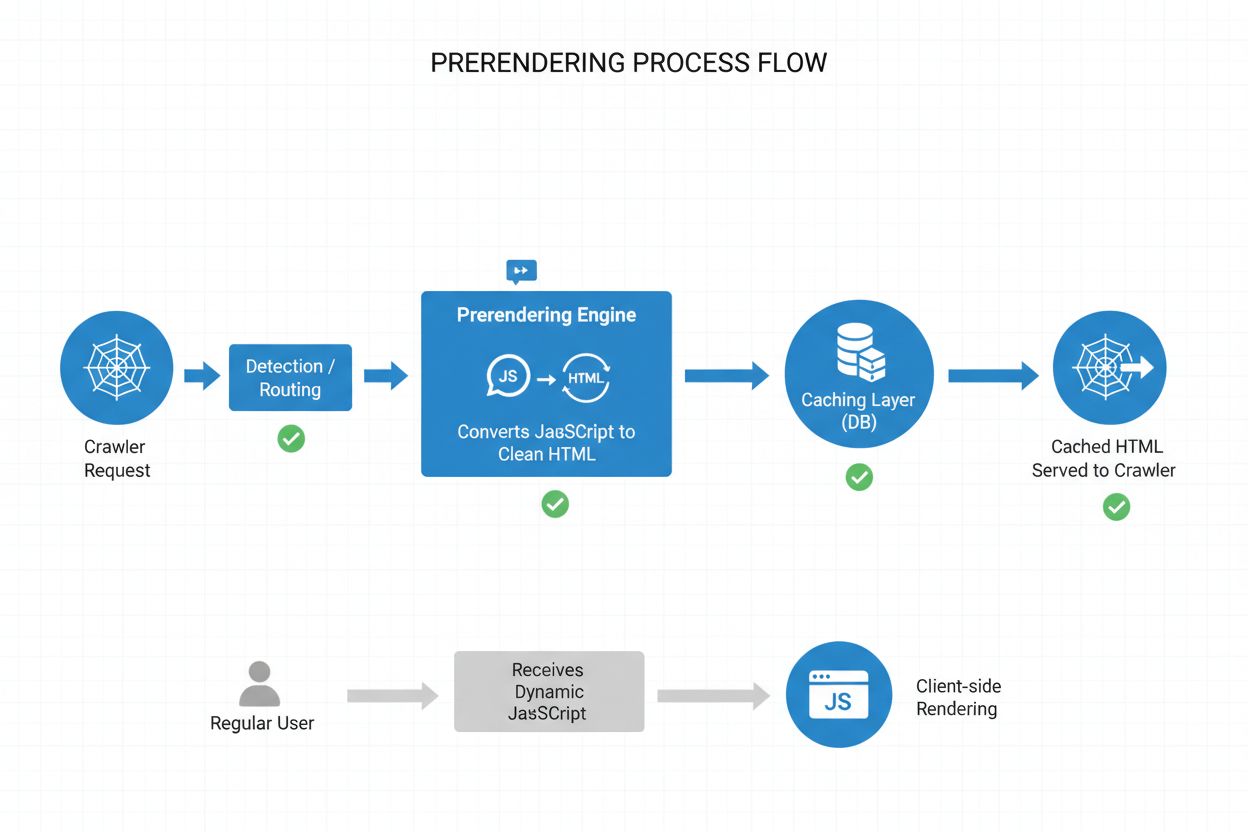

Prerendering biedt een elegante middenweg tussen de intensieve eisen van server-side rendering en de buildtijd-beperkingen van statische sitegeneratie. In plaats van inhoud bij elk verzoek (SSR) of tijdens de build (SSG) te genereren, maakt prerendering statische HTML-snapshots on-demand wanneer een crawler of bot een pagina opvraagt, en slaat die versie in de cache op voor volgende verzoeken. Dit betekent dat AI-crawlers volledig gerenderde, statische HTML ontvangen met alle inhoud die normaal door JavaScript zou worden gegenereerd, terwijl gewone gebruikers de dynamische, interactieve versie van uw site blijven ontvangen zonder enige wijziging in hun ervaring. Prerendering is bijzonder kosteneffectief omdat het alleen pagina’s rendert die daadwerkelijk door crawlers worden opgevraagd, waardoor de overhead van het vooraf renderen van uw hele site of het onderhouden van dure SSR-infrastructuur wordt vermeden. Het onderhoud is minimaal—uw applicatiecode blijft ongewijzigd, en de prerenderinglaag werkt transparant op de achtergrond, waardoor het een ideale oplossing is voor teams die AI-crawler-toegankelijkheid willen zonder ingrijpende architecturale aanpassingen.

Het prerenderingproces werkt via een geavanceerde maar eenvoudige workflow die ervoor zorgt dat AI-crawlers geoptimaliseerde inhoud ontvangen terwijl gebruikers geen verstoring ervaren. Wanneer een verzoek uw server bereikt, wordt eerst de user-agent gedetecteerd om te bepalen of het een AI-crawler (GPTBot, ClaudeBot, PerplexityBot) of een gewone browser betreft. Als een AI-crawler wordt gedetecteerd, wordt het verzoek doorgestuurd naar de prerendering-engine, die een headless browser-instantie lanceert, alle JavaScript uitvoert, wacht op asynchroon geladen inhoud en een compleet statisch HTML-snapshot van de gerenderde pagina genereert. Deze HTML wordt vervolgens gecached (meestal voor 24-48 uur) en direct aan de crawler geserveerd, waardoor uw applicatie geheel wordt omzeild en de serverbelasting afneemt. Gewone browserverzoeken passeren de prerenderinglaag volledig en ontvangen uw dynamische applicatie zoals normaal, zodat gebruikers de volledige interactieve ervaring met realtime updates en dynamische functionaliteit behouden. Het hele proces gebeurt transparant—crawlers zien volledig gerenderde inhoud, gebruikers zien uw applicatie ongewijzigd, en uw infrastructuur blijft efficiënt omdat prerendering alleen wordt geactiveerd voor botverkeer.

Hoewel zowel prerendering als server-side rendering (SSR) het JavaScript-zichtbaarheidsprobleem oplossen, verschillen ze aanzienlijk in implementatie, kosten en schaalbaarheid. SSR rendert inhoud bij elk verzoek, wat betekent dat uw server een JavaScript-runtime moet opstarten, uw volledige applicatiecode uitvoert en bij elk bezoek HTML moet genereren—een proces dat op schaal onbetaalbaar wordt en de Time to First Byte (TTFB) voor alle gebruikers kan verhogen. Prerendering daarentegen cachet gerenderde pagina’s en regenereert deze alleen wanneer de inhoud verandert of de cache verloopt, waardoor de serverbelasting drastisch afneemt en de responstijden voor zowel crawlers als gebruikers verbeteren. SSR is zinvol bij sterk gepersonaliseerde inhoud of vaak veranderende data waarbij elke gebruiker unieke HTML nodig heeft, terwijl prerendering uitblinkt bij relatief statische inhoud of inhoud die zelden verandert—productpagina’s, blogposts, documentatie en marketinginhoud. Veel geavanceerde implementaties gebruiken een hybride aanpak: prerendering voor AI-crawlers en statische inhoud, SSR voor gepersonaliseerde gebruikerservaringen, en client-side rendering voor interactieve functies. Deze gelaagde strategie biedt het beste van alle werelden—uitstekende AI-crawler-toegankelijkheid, snelle prestaties voor gebruikers en redelijke infrastructuurkosten.

Gestructureerde data in JSON-LD-formaat is essentieel om AI-crawlers te helpen de betekenis en context van uw inhoud te begrijpen, maar de meeste implementaties houden geen rekening met de beperkingen van AI-crawlers. Wanneer gestructureerde data via JavaScript aan de pagina wordt toegevoegd—een gangbare praktijk met Google Tag Manager en vergelijkbare tagmanagementsystemen—zien AI-crawlers deze niet, omdat ze het JavaScript dat deze datastructuren creëert niet uitvoeren. Dit betekent dat rich snippets, productinformatie, organisatiedetails en andere semantische markeringen onzichtbaar blijven voor AI-systemen, zelfs als ze perfect zichtbaar zijn voor traditionele zoekmachines die JavaScript inmiddels wel aankunnen. De oplossing is eenvoudig: zorg ervoor dat alle kritieke gestructureerde data aanwezig is in de server-gerenderde HTML, en niet via JavaScript wordt geïnjecteerd. Dit kan betekenen dat u JSON-LD-blokken vanuit uw tagmanager naar het server-side sjabloon van uw applicatie verplaatst, of prerendering gebruikt om via JavaScript geïnjecteerde gestructureerde data vast te leggen en deze als statische HTML aan crawlers te serveren. AI-crawlers vertrouwen sterk op gestructureerde data om feiten, relaties en entiteitsinformatie te extraheren, waardoor server-side implementatie van gestructureerde data essentieel is voor AI-gestuurde zoekmachines en kennisgraaf-integratie.

Het implementeren van prerendering vereist een strategische aanpak die dekking, kosten en onderhoud in balans brengt. Volg deze stappen om te starten:

Identificeer JavaScript-intensieve pagina’s: Voer een audit uit op uw site om pagina’s te vinden waar essentiële inhoud via JavaScript wordt gerenderd—meestal SPA’s, dynamische productpagina’s en interactieve dashboards. Gebruik tools zoals Lighthouse of handmatige inspectie om pagina’s te vinden waar de initiële HTML aanzienlijk verschilt van de gerenderde versie.

Kies een prerenderingservice: Selecteer een prerenderingprovider zoals Prerender.io, die headless browser rendering, caching en crawlerdetectie afhandelt. Evalueer op basis van prijs, cacheduur, API-betrouwbaarheid en ondersteuning voor uw specifieke tech stack.

Configureer user-agentdetectie: Stel uw server of CDN zo in dat AI-crawler user-agents (GPTBot, ClaudeBot, PerplexityBot, Bingbot, Googlebot) worden gedetecteerd en naar de prerenderingservice worden doorgestuurd, terwijl gewone browsers normaal worden doorgelaten.

Test en valideer: Gebruik tools zoals curl met aangepaste user-agents om te controleren of crawlers volledig gerenderde HTML ontvangen. Test met echte AI-crawler user-agents om te verzekeren dat inhoud zichtbaar is en gestructureerde data aanwezig is.

Monitor de resultaten: Stel logging en analytics in om de effectiviteit van prerendering, cache-hitratio’s en eventuele renderingsfouten te volgen. Bewaak het dashboard van uw prerenderingservice voor prestatiecijfers en fouten.

Effectieve monitoring is essentieel om ervoor te zorgen dat uw prerenderingimplementatie correct blijft werken en dat AI-crawlers toegang hebben tot uw inhoud. Loganalyse is uw belangrijkste instrument—analyseer uw serverlogs om verzoeken van AI-crawler user-agents te identificeren, te volgen welke pagina’s ze bezoeken en patronen in crawlgedrag of fouten op te sporen. De meeste prerenderingservices zoals Prerender.io bieden dashboards die cache-hitratio’s, metrics voor succesvolle/onsuccesvolle rendering en prestatiestatistieken tonen, zodat u zicht hebt op hoe effectief uw prerenderde inhoud wordt geserveerd. Belangrijke metrics om te volgen zijn cache-hitratio (percentage verzoeken geserveerd vanuit cache), renderingsuccesratio (percentage pagina’s dat zonder fouten rendert), gemiddelde renderduur en crawlerverkeer-volume. Stel waarschuwingen in voor renderingsfouten of ongebruikelijke crawls die kunnen wijzen op problemen met uw JavaScript of dynamische inhoud. Door prerenderingstatistieken te correleren met uw AI-zoekverkeer en contentzichtbaarheid, kunt u het effect van uw prerenderingimplementatie kwantificeren en optimalisatiekansen identificeren.

Succesvolle prerendering vereist aandacht voor detail en doorlopend onderhoud. Vermijd deze veelvoorkomende valkuilen:

Prerender geen 404-pagina’s: Configureer uw prerenderingservice om pagina’s die een 404-statuscode retourneren over te slaan, want het cachen van foutpagina’s verspilt resources en verwart crawlers over de structuur van uw site.

Zorg voor actuele inhoud: Stel passende cache-vervalperiodes in op basis van hoe vaak uw inhoud verandert. Pagina’s met veel verkeer en frequente updates hebben mogelijk cachevensters van 12-24 uur nodig, terwijl statische inhoud langer mee kan.

Blijf monitoren: Zet prerendering niet op en vergeet het vervolgens. Controleer regelmatig of pagina’s correct renderen, gestructureerde data aanwezig is en crawlers de verwachte inhoud ontvangen.

Vermijd cloaking: Bied nooit andere inhoud aan crawlers dan aan gebruikers—dit is in strijd met zoekmachine-richtlijnen en schaadt het vertrouwen. Prerendering moet crawlers dezelfde inhoud tonen als gebruikers, alleen in statische vorm.

Test met echte crawlers: Gebruik echte AI-crawler user-agents bij uw testen, niet alleen generieke bot-identificaties. Verschillende crawlers kunnen andere renderingvereisten of beperkingen hebben.

Houd inhoud up-to-date: Als uw prerenderde inhoud verouderd raakt, indexeren crawlers achterhaalde informatie. Implementeer cache-invalideringsstrategieën die prerenderde pagina’s verversen wanneer de inhoud verandert.

Het belang van AI-crawleroptimalisatie zal alleen maar toenemen naarmate deze systemen centraler worden in contentontdekking en kennisextractie. Hoewel huidige AI-crawlers beperkte JavaScript-uitvoermogelijkheden hebben, suggereren opkomende technologieën zoals Comet en Atlas browsers dat toekomstige crawlers geavanceerdere renderingmogelijkheden zullen hebben, hoewel prerendering om prestatieredenen en betrouwbaarheid waardevol blijft. Door nu prerendering te implementeren, future-proof je je inhoud tegen veranderende crawler-capaciteiten en zorg je ervoor dat je site toegankelijk blijft ongeacht hoe AI-systemen zich ontwikkelen. De convergentie van traditionele SEO en AI-crawleroptimalisatie betekent dat je vooruit moet denken: optimaliseer voor zowel menselijke gebruikers als AI-systemen, zorg dat je inhoud in meerdere formaten toegankelijk is en behoud flexibiliteit om aan te passen als het landschap verandert. Prerendering is een pragmatische, schaalbare oplossing die de kloof overbrugt tussen moderne JavaScript-intensieve applicaties en de toegankelijkheidseisen van AI-gestuurde zoek- en ontdeksystemen, en is daarmee een essentieel onderdeel van elke vooruitstrevende SEO- en contentstrategie.

Prerendering genereert statische HTML-snapshots op aanvraag en slaat deze in de cache op, terwijl server-side rendering (SSR) de inhoud bij elk verzoek rendert. Prerendering is voor de meeste toepassingen kostenefficiënter en schaalbaarder, terwijl SSR beter geschikt is voor sterk gepersonaliseerde of vaak veranderende inhoud die unieke HTML vereist per gebruiker.

Nee, prerendering heeft alleen invloed op hoe crawlers uw inhoud zien. Gewone gebruikers ontvangen uw dynamische, interactieve JavaScript-applicatie precies zoals voorheen. Prerendering werkt transparant op de achtergrond en heeft geen impact op de functionaliteit of prestaties aan de gebruikerszijde.

Cache-vervalperiodes zijn afhankelijk van hoe vaak uw inhoud verandert. Pagina's met veel verkeer en frequente updates hebben mogelijk cachevensters van 12-24 uur nodig, terwijl statische inhoud langere duur kan gebruiken. De meeste prerendering-services laten toe dat u cachetijden per pagina of sjabloon instelt.

Ja, prerendering werkt goed met dynamische inhoud. U kunt kortere cache-vervaltijden instellen voor pagina's die vaak veranderen, of cache-invalideringsstrategieën implementeren die prerenderde pagina's verversen wanneer de inhoud wordt bijgewerkt. Zo zien crawlers altijd relatief verse inhoud.

De belangrijkste AI-crawlers om voor te optimaliseren zijn GPTBot (ChatGPT), ClaudeBot (Claude) en PerplexityBot (Perplexity). U moet ook blijven optimaliseren voor traditionele crawlers zoals Googlebot en Bingbot. De meeste prerenderingdiensten bieden ondersteuning voor alle grote AI- en zoekcrawlers.

Als u al SSR gebruikt, is de toegankelijkheid voor AI-crawlers goed. Prerendering kan echter alsnog voordelen bieden door de serverbelasting te verminderen, de prestaties te verbeteren en een cachinglaag te bieden die uw infrastructuur efficiënter en schaalbaarder maakt.

Controleer het dashboard van uw prerenderingservice voor cache-hitpercentages, metrics voor renderingsucces en prestatiestatistieken. Bekijk uw serverlogs voor AI-crawlerverzoeken en controleer of ze volledig gerenderde HTML ontvangen. Volg veranderingen in uw AI-zoekzichtbaarheid en contentvermeldingen in de tijd.

De kosten van prerendering variëren per service en gebruiksvolume. De meeste aanbieders hanteren prijsniveaus op basis van het aantal gerenderde pagina's per maand. De kosten zijn doorgaans veel lager dan het onderhouden van server-side rendering-infrastructuur, waardoor prerendering een kosteneffectieve oplossing is voor de meeste websites.

Volg hoe AI-platforms zoals ChatGPT, Claude en Perplexity uw inhoud vermelden met AmICited. Krijg realtime inzichten in uw AI-zoekzichtbaarheid en optimaliseer uw contentstrategie.

Ontdek hoe JavaScript de zichtbaarheid voor AI-crawlers beïnvloedt. Leer waarom AI-bots geen JavaScript kunnen renderen, welke inhoud verborgen blijft en hoe u ...

Ontdek hoe je je content zichtbaar maakt voor AI-crawlers zoals ChatGPT, Perplexity en Google's AI. Leer technische vereisten, best practices en monitoringstrat...

Leer hoe JavaScript-rendering de zichtbaarheid in AI beïnvloedt. Ontdek waarom AI-crawlers geen JavaScript kunnen uitvoeren, welke content verborgen blijft en h...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.