Een Promptbibliotheek Bouwen voor AI-Zichtbaarheidstracking

Leer hoe je een effectieve promptbibliotheek creëert en organiseert om je merk te volgen in ChatGPT, Perplexity en Google AI. Stapsgewijze handleiding met best ...

Leer hoe je promptbibliotheken bouwt en gebruikt voor handmatige AI-zichtbaarheidstesten. Doe-het-zelfgids voor het testen hoe AI-systemen jouw merk noemen op ChatGPT, Perplexity en Google AI.

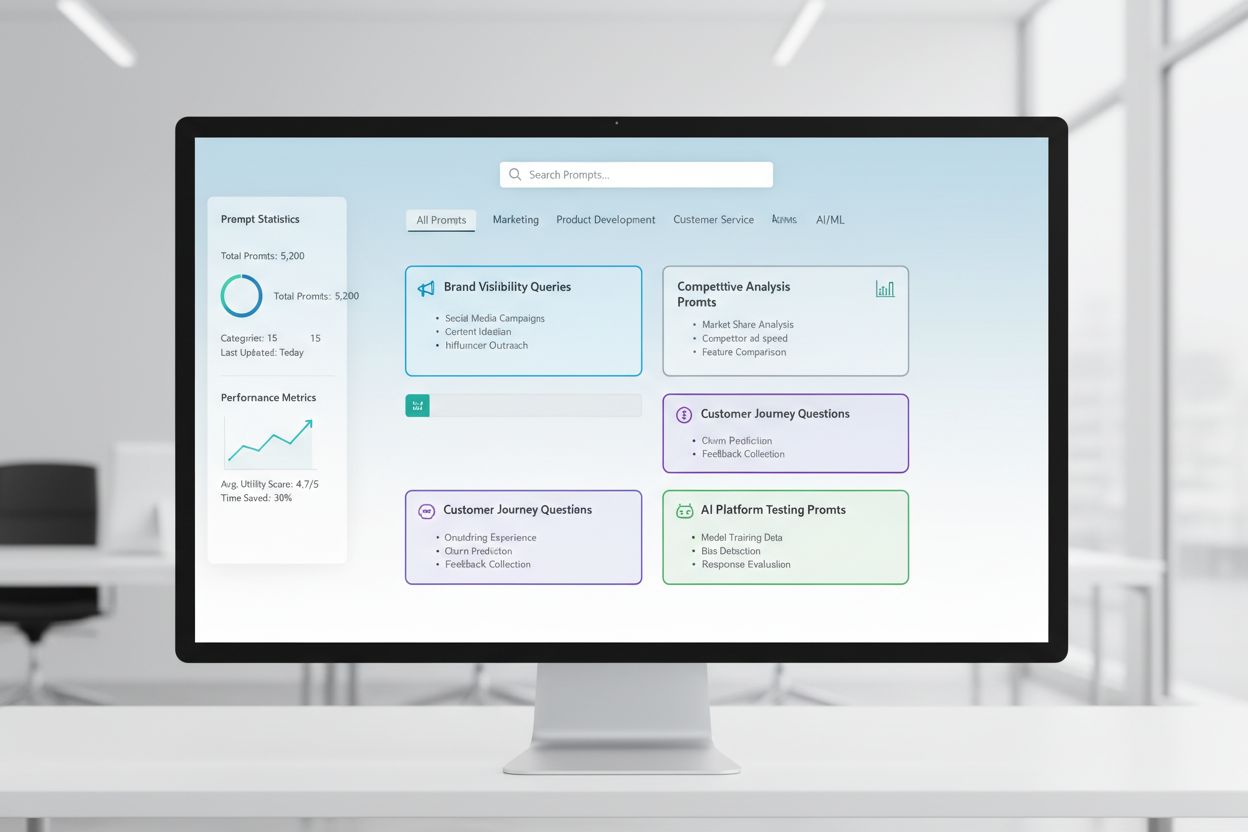

Een promptbibliotheek is een samengestelde, georganiseerde verzameling testprompts die zijn ontworpen om systematisch te evalueren hoe AI-systemen reageren op specifieke vragen en scenario’s. In de context van handmatig AI-testen functioneren deze bibliotheken als jouw basisgereedschap—een opslagplaats van zorgvuldig samengestelde prompts die je helpen precies te begrijpen hoe verschillende AI-modellen omgaan met jouw merkvermeldingen, citaties, contentnauwkeurigheid en contextueel begrip. AI-zichtbaarheidstesten is sterk afhankelijk van promptbibliotheken omdat ze consistent en herhaalbaar testen mogelijk maken over meerdere platforms en tijdsperioden, zodat je kunt volgen hoe jouw content wel of niet verschijnt in AI-antwoorden. In plaats van willekeurig te testen met losse vragen, zorgt een goed gestructureerde promptbibliotheek ervoor dat je systematisch alle relevante scenario’s voor je organisatie dekt, van directe merkzoekopdrachten tot indirecte contextuele verwijzingen. Deze gestructureerde aanpak verandert handmatig testen van een lukraak proces in een strategische, datagedreven methode die patronen in AI-gedrag blootlegt en je helpt je werkelijke zichtbaarheid in het AI-landschap te begrijpen.

Handmatig AI-zichtbaarheidstesten is het proces waarbij je AI-systemen rechtstreeks bevraagt met vooraf bepaalde prompts en hun antwoorden zorgvuldig analyseert om te begrijpen hoe jouw content, merk en citaties worden getoond of juist worden weggelaten. In tegenstelling tot geautomatiseerde monitoringsystemen die continu op de achtergrond draaien, heb je bij handmatig testen directe controle over wat je test, wanneer je het test en hoe diep je de resultaten analyseert—waardoor het onmisbaar is voor verkennend testen, het begrijpen van randgevallen en het onderzoeken van onverwacht AI-gedrag. Het belangrijkste verschil ligt in de aard van het werk: handmatig testen is doelbewust en onderzoekend, zodat je vervolgvragen kunt stellen, variaties kunt testen en het “waarom” achter AI-antwoorden kunt doorgronden, terwijl geautomatiseerde monitoring uitblinkt in consistente, grootschalige tracking door de tijd heen. Handmatig testen is vooral belangrijk voor AI-zichtbaarheid omdat je zo nuances kunt opmerken die geautomatiseerde systemen kunnen missen—zoals of je merk wel genoemd wordt maar verkeerd wordt toegeschreven, of citaties wel kloppen maar onvolledig zijn, of context correct wordt begrepen. Hieronder zie je hoe deze aanpakken zich tot elkaar verhouden:

| Aspect | Handmatig testen | Geautomatiseerde monitoring |

|---|---|---|

| Kosten | Lage initiële investering; tijdsintensief | Hogere opstartkosten; lagere doorlopende arbeid |

| Snelheid | Langzamer per test; direct inzicht | Langzamer op te zetten; snelle, continue tracking |

| Flexibiliteit | Zeer flexibel; eenvoudig bij te sturen | Rigide; vereist vooraf ingestelde parameters |

| Nauwkeurigheid | Hoog voor kwalitatieve analyse; onderhevig aan menselijke bias | Consistent; uitstekend voor kwantitatieve metrics |

| Leercurve | Minimaal; iedereen kan starten | Steiler; vereist technische opzet en configuratie |

Handmatig testen excelleert wanneer je wilt begrijpen waarom iets gebeurt, terwijl geautomatiseerde monitoring uitblinkt in het grootschalig volgen van wat er gebeurt.

Een robuuste promptbibliotheekstructuur moet georganiseerd zijn rond de kernaspecten van je AI-zichtbaarheidsstrategie, waarbij elk onderdeel een specifiek testdoel dient. Je bibliotheek moet prompts bevatten die verschillende aspecten testen van hoe AI-systemen jouw content ontdekken en tonen, zodat je volledige dekking hebt van je zichtbaarheid. Dit zijn de essentiële componenten die elke promptbibliotheek moet bevatten:

Bij het opbouwen van je teststrategie heb je prompts nodig die specifiek de dimensies van AI-zichtbaarheid toetsen die voor jouw organisatie het belangrijkst zijn: merkvermeldingen, citatienauwkeurigheid en contextbegrip. De meest effectieve testprompts zijn die welke echt gebruikersgedrag nabootsen én specifieke variabelen isoleren die je wilt meten. Voor testprompts gericht op merkvermeldingen wil je variaties hebben die directe zoekopdrachten, indirecte verwijzingen en vergelijkende contexten testen. Citatietesten vereisen prompts die van nature citaties uitlokken en variaties die nagaan of het AI-systeem informatie correct aan jouw bronnen toeschrijft. Hier zijn een aantal voorbeeldprompts die je kunt aanpassen voor je eigen testen:

"Wat zijn de nieuwste ontwikkelingen in [jouw branche]?

Noem je bronnen."

"Vergelijk [jouw product] met [concurrent-product].

Wat zijn de belangrijkste verschillen en voordelen van elk?"

"Leg uit wat [jouw expertisegebied] is.

Wie zijn de toonaangevende experts of bedrijven in dit vakgebied?"

Deze prompts zijn zo ontworpen dat ze de soorten antwoorden uitlokken waarin jouw zichtbaarheid het belangrijkst is—wanneer AI-systemen informatie geven, vergelijkingen maken of gezaghebbende bronnen benoemen. Je kunt variaties maken door het detailniveau te wijzigen (breed vs. smal), beperkingen toe te voegen (alleen recente info, specifieke use-cases), of de citatie-eisen aan te passen (met bronnen, met links, met auteursnamen). De kern is niet alleen testen of je content verschijnt, maar hoe en in welke context, wat prompts vereist die realistische scenario’s creëren waarin je zichtbaarheid logisch naar voren zou moeten komen.

Je AI-zichtbaarheidsstrategie moet rekening houden met het feit dat verschillende AI-platformen—ChatGPT, Perplexity, Google AI Overviews, Claude en anderen—fundamenteel verschillende trainingsdata, zoekmechanismen en antwoordgeneratie hanteren, waardoor je zichtbaarheid sterk per platform verschilt. Cross-platform testen is essentieel omdat een prompt die jouw content op het ene AI-systeem prominent toont, compleet andere resultaten kan opleveren op een ander systeem, en het inzicht in deze platformspecifieke patronen is cruciaal voor een doordachte zichtbaarheidstrategie. Bij testen over meerdere platforms zul je merken dat Perplexity, met zijn realtime zoekintegratie, vaak recentere content toont en meer expliciete citaties bevat dan ChatGPT, dat afhankelijk is van trainingsdata met een kennis-cutoff. Google AI Overviews, direct geïntegreerd in zoekresultaten, werkt onder andere zichtbaarheidsregels en kan andere bronnen prioriteren dan conversatie-AI’s. De praktische aanpak is een consistente set kernprompts aan te houden die je op alle platforms op regelmatige basis draait, zodat je niet alleen ziet of je content verschijnt, maar ook waar en hoe platformverschillen je zichtbaarheid beïnvloeden. Dit cross-platform perspectief onthult of je zichtbaarheidsuitdagingen universeel zijn (op alle platforms) of platformspecifiek (gerichte strategie per systeem vereisend), wat fundamenteel bepaalt hoe je optimaliseert.

Effectieve testdocumentatie verandert ruwe testdata in bruikbare inzichten, en het organisatiemodel dat je kiest bepaalt of je testinspanningen cumulatief in waarde toenemen of geïsoleerde datapunten blijven. De meest praktische methode is een gestructureerd spreadsheet of documentatiesysteem te gebruiken dat niet alleen de resultaten, maar ook de context vastlegt—waaronder de exacte prompt, testdatum, getest platform, het volledige AI-antwoord, en jouw analyse of je content verscheen en hoe deze werd gepresenteerd. Je resultaattracking-systeem moet kolommen bevatten voor: promptcategorie (merk, concurrent, branche, enz.), getest platform, of je content verscheen, nauwkeurigheid van citaties (indien van toepassing), positie in het antwoord (eerste vermelding, ondersteunend bewijs, enz.), en kwalitatieve notities over de relevantie of kwaliteit van het antwoord. Maak naast de ruwe data sjablonen voor veelvoorkomende testsituaties, zodat je documentatie consistent blijft door de tijd heen en je trends en veranderingen in AI-gedrag gemakkelijker herkent. Documenteer niet alleen successen maar ook mislukkingen en afwijkingen—deze onthullen vaak de belangrijkste inzichten over hoe AI-systemen werken en waar je zichtbaarheidsstrategie moet worden aangescherpt. Door deze gedisciplineerde aanpak van testmethodologie creëer je een historisch overzicht van hoe je zichtbaarheid zich heeft ontwikkeld, welke AI-veranderingen je resultaten beïnvloedden, en welke optimalisaties daadwerkelijk impact hadden.

Handmatig AI-zichtbaarheidstesten is gevoelig voor een aantal systematische fouten die je resultaten kunnen ondermijnen en tot verkeerde conclusies over je werkelijke zichtbaarheid kunnen leiden. De meest voorkomende valkuil is inconsistente promptformulering—telkens net anders geformuleerde vragen stellen, waardoor variabelen ontstaan die het onmogelijk maken om te bepalen of wijzigingen in resultaten door het AI-systeem of jouw testvariaties komen. Voorkom dit door een hoofd-promptdocument te maken waarin elke prompt vastligt en identiek wordt gebruikt in alle testrondes; wil je variaties testen, maak dan aparte promptvarianten met duidelijke namen. Een andere veelgemaakte fout is onvoldoende steekproefgrootte en testfrequentie—eenmalig testen en dan conclusies trekken, terwijl AI-antwoorden kunnen variëren door timing, systeembelasting en andere factoren. Stel een vast testritme in (wekelijks, tweewekelijks of maandelijks afhankelijk van je middelen) en test elke prompt meerdere keren om patronen te onderscheiden van uitzonderingen. Bevestigingsbias is een subtiele maar gevaarlijke valkuil waarbij testers onduidelijke resultaten onbewust als bevestiging van hun verwachting zien; voorkom dit door meerdere teamleden resultaten onafhankelijk te laten beoordelen en objectieve criteria vast te leggen voor wat telt als “jouw content verschijnt”. Test ook nooit in isolatie—noteer altijd datum, tijd en bekende AI-updates tijdens het testen, want de context van je resultaten is essentieel om ze correct te interpreteren. Tot slot betekent slechte methodologiedocumentatie dat je je testen niet kunt herhalen of je resultaten niet kunt uitleggen aan stakeholders; documenteer daarom altijd exact hoe je hebt getest, wat je hebt gemeten en hoe je resultaten hebt geïnterpreteerd, zodat je testen reproduceerbaar en verdedigbaar zijn.

Naarmate je organisatie groeit en je AI-zichtbaarheidsstrategie geavanceerder wordt, moet je opschalen van individuele, ad-hoc tests naar een gestructureerde teamtest-aanpak die de werklast verdeelt en toch consistentie en kwaliteit waarborgt. De sleutel tot succesvol opschalen is heldere testprotocollen en rolverdeling—bepaal wie verantwoordelijk is voor welke platforms, promptcategorieën en analyse, zodat testen een gecoördineerde teaminspanning wordt in plaats van dubbel individueel werk. Implementeer een gedeelde testkalender waarin teamleden kunnen zien wat, wanneer en door wie is getest, om dubbel werk te voorkomen en toch volledige dekking te garanderen. Maak een testchecklist of runbook die elk teamlid kan volgen voor consistente uitvoering, met specifieke instructies voor het documenteren van resultaten, waar je op moet letten in antwoorden en hoe je afwijkingen of interessante bevindingen markeert. Samenwerkingstools zoals gedeelde spreadsheets, projectmanagementsystemen of speciale testplatforms helpen de teamefforts te coördineren en één centrale bron van waarheid voor je testdata te creëren. Overweeg bij het opschalen om testtaken te rouleren, zodat meerdere mensen je testmethodiek begrijpen en kunnen bijdragen, waardoor je minder afhankelijk bent van één persoon. Regelmatige teamsyncs waarin je resultaten bespreekt, bevindingen deelt en je teststrategie aanpast op basis van nieuwe inzichten zorgen ervoor dat je opgeschaalde testaanpak strategisch en samenhangend blijft en geen losse verzameling individuele taken wordt.

De meest geavanceerde AI-zichtbaarheidsstrategieën herkennen dat handmatig en geautomatiseerd elkaar aanvullen in plaats van concurreren, waarbij elk in een andere context excelleert en samen volledige zichtbaarheid bieden. Handmatig testen is je onderzoeksinstrument—hiermee verken je, begrijp je nuances, test je hypotheses en ontwikkel je diepgaande inzichten in hoe AI-systemen werken en waarom je zichtbaarheid per platform of scenario verschilt. Geautomatiseerde monitoringtools zoals AmICited blinken uit in consistente, grootschalige tracking door de tijd heen, waarbij ze je zichtbaarheid op meerdere AI-platformen continu bewaken en je waarschuwen voor veranderingen, trends en afwijkingen die je handmatig simpelweg nooit allemaal zou opmerken. De praktische integratiestrategie is: gebruik handmatig testen om je testframework te ontwikkelen, te bepalen wat ertoe doet en afwijkingen te onderzoeken, en zet geautomatiseerde monitoring in om die kernmetrics continu te volgen en je te alarmeren bij veranderingen. Je kunt bijvoorbeeld handmatig een nieuwe promptcategorie testen om te begrijpen hoe AI-systemen reageren, en zodra je hebt vastgesteld dat dit een relevante test is, voeg je hem toe aan je automatische monitoring zodat je voortdurend inzicht hebt zonder steeds opnieuw handmatig te testen. AmICited en vergelijkbare monitoringtools nemen het repetitieve, tijdrovende werk van grootschalig testen over, zodat je team zich kan richten op analyse, strategie en optimalisatie. De ideale workflow: gebruik handmatig testen om je promptbibliotheek en teststrategie op te bouwen, valideer je aanpak en onderzoek specifieke vragen; gebruik geautomatiseerde monitoring om je belangrijkste zichtbaarheidsmetrics continu te volgen; en gebruik de inzichten uit automatische monitoring om te bepalen wat je vervolgens handmatig test. Deze geïntegreerde aanpak zorgt ervoor dat je niet handmatig in een vacuüm test, maar een complete zichtbaarheidsstrategie bouwt die de diepgang van handmatig onderzoek combineert met de schaal en consistentie van geautomatiseerde monitoring.

Een promptbibliotheek is een samengestelde, georganiseerde verzameling testprompts die zijn ontworpen om AI-systemen systematisch te beoordelen op meerdere dimensies. In tegenstelling tot een enkele prompttemplate bevat een bibliotheek tientallen prompts, geordend per categorie (merknamen, concurrentievergelijkingen, citaties, enz.), waardoor je uitgebreide testen kunt uitvoeren in plaats van geïsoleerde controles. Promptbibliotheken zijn voorzien van versies, gedocumenteerd en ontworpen voor hergebruik en opschaling binnen je team.

De frequentie hangt af van je middelen en hoe dynamisch je branche is. De meeste organisaties profiteren van wekelijkse of tweewekelijkse tests van kernprompts om belangrijke veranderingen te signaleren, met maandelijkse diepgaande tests van de volledige promptbibliotheek. Zit je in een snel veranderende branche of heb je recent belangrijke content gepubliceerd, verhoog dan de frequentie naar wekelijks. Combineer handmatig testen met geautomatiseerde monitoringtools zoals AmICited voor continue opvolging tussen de handmatige testcycli door.

Ja, je zou dezelfde kernprompts op alle platforms moeten gebruiken voor consistentie en vergelijkbaarheid. Mogelijk heb je echter platformspecifieke varianten nodig omdat verschillende AI-systemen (ChatGPT, Perplexity, Google AI Overviews) andere interfaces, citatie-mechanismen en antwoordformaten hebben. Test je kernprompts identiek op alle platforms en maak vervolgens platformspecifieke variaties om rekening te houden met unieke eigenschappen of beperkingen van elk systeem.

Houd bij of je content verschijnt (ja/nee), waar deze voorkomt in het antwoord (eerste vermelding, ondersteunend bewijs, enz.), nauwkeurigheid van citaties (indien geciteerd) en de kwaliteit van het antwoord. Documenteer ook de testdatum, het platform, de exacte prompt en eventuele kwalitatieve observaties over hoe je content werd gepresenteerd. Op termijn laten deze metrics patronen in je zichtbaarheid zien en helpen ze je begrijpen welke optimalisatiepogingen daadwerkelijk effect hebben.

Je testen zijn uitgebreid als je alle belangrijke dimensies van je zichtbaarheid dekt: directe merkzoekopdrachten, concurrentievergelijkingen, brancheonderwerpen, nauwkeurigheid van citaties en contextueel begrip. Een goede vuistregel is 20-30 kernprompts die je regelmatig test, plus extra prompts voor specifieke onderzoeken. Als je bij handmatig testen voortdurend nieuwe inzichten opdoet, zijn er waarschijnlijk meer prompts nodig. Worden de resultaten voorspelbaar, dan is je dekking waarschijnlijk voldoende.

Voor kleine organisaties of initiële testen kun je starten met interne middelen volgens de doe-het-zelf-aanpak in deze gids. Naarmate je testen opschalen, zijn toegewijde middelen echter waardevol. Overweeg iemand aan te stellen of vrij te maken voor het beheren van je promptbibliotheek en het regelmatig uitvoeren van testen als je meerdere producten hebt, in een concurrerende branche opereert of frequente testcycli nodig hebt. Je kunt ook interne testen combineren met geautomatiseerde monitoringtools zoals AmICited om de werklast te verdelen.

Handmatig testen is onderzoekend en flexibel—je bepaalt zelf wat je test en kunt nuances en randgevallen onderzoeken. Geautomatiseerde monitoringtools zoals AmICited draaien continu, volgen je zichtbaarheid op meerdere AI-platformen op schaal en waarschuwen je bij veranderingen. De ideale aanpak combineert beide: gebruik handmatig testen om je teststrategie te ontwikkelen en specifieke vragen te onderzoeken, en automatische monitoring voor continue tracking van kernmetrics.

Je kunt het uitvoeren van prompts automatiseren via API’s (OpenAI, Anthropic, enz.) om je prompts naar AI-systemen te sturen en antwoorden programmatisch vast te leggen. Analyse blijft echter meestal handmatig omdat context en nuance door mensen moeten worden beoordeeld. Je kunt de documentatie en resultatenregistratie ook automatiseren met spreadsheets of databases. De meest praktische aanpak is repetitief werk via geautomatiseerde monitoringtools zoals AmICited, terwijl je handmatige testen reserveert voor diepere analyse en onderzoek.

Hoewel handmatig testen waardevol is, zorgt geautomatiseerde monitoring voor continue zichtbaarheid op alle AI-platforms. AmICited volgt in real-time hoe AI-systemen jouw merk noemen.

Leer hoe je een effectieve promptbibliotheek creëert en organiseert om je merk te volgen in ChatGPT, Perplexity en Google AI. Stapsgewijze handleiding met best ...

Ontdek wat promptbibliotheekontwikkeling is en hoe organisaties zoekopdrachtcollecties bouwen om merkzichtbaarheid te testen en monitoren op AI-platforms zoals ...

Leer hoe je de aanwezigheid van je merk in AI-engines test met prompt testing. Ontdek handmatige en geautomatiseerde methoden om AI-zichtbaarheid te monitoren o...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.