AI Crawler Referentiekaart: Alle Bots in Één Oogopslag

Compleet naslagwerk over AI crawlers en bots. Identificeer GPTBot, ClaudeBot, Google-Extended en meer dan 20 andere AI-crawlers met user agents, crawl rates en ...

Leer hoe je XML-sitemaps optimaliseert voor AI-crawlers zoals GPTBot en ClaudeBot. Beheers sitemap best practices om je zichtbaarheid in AI-gegenereerde antwoorden en LLM-indexering te verbeteren.

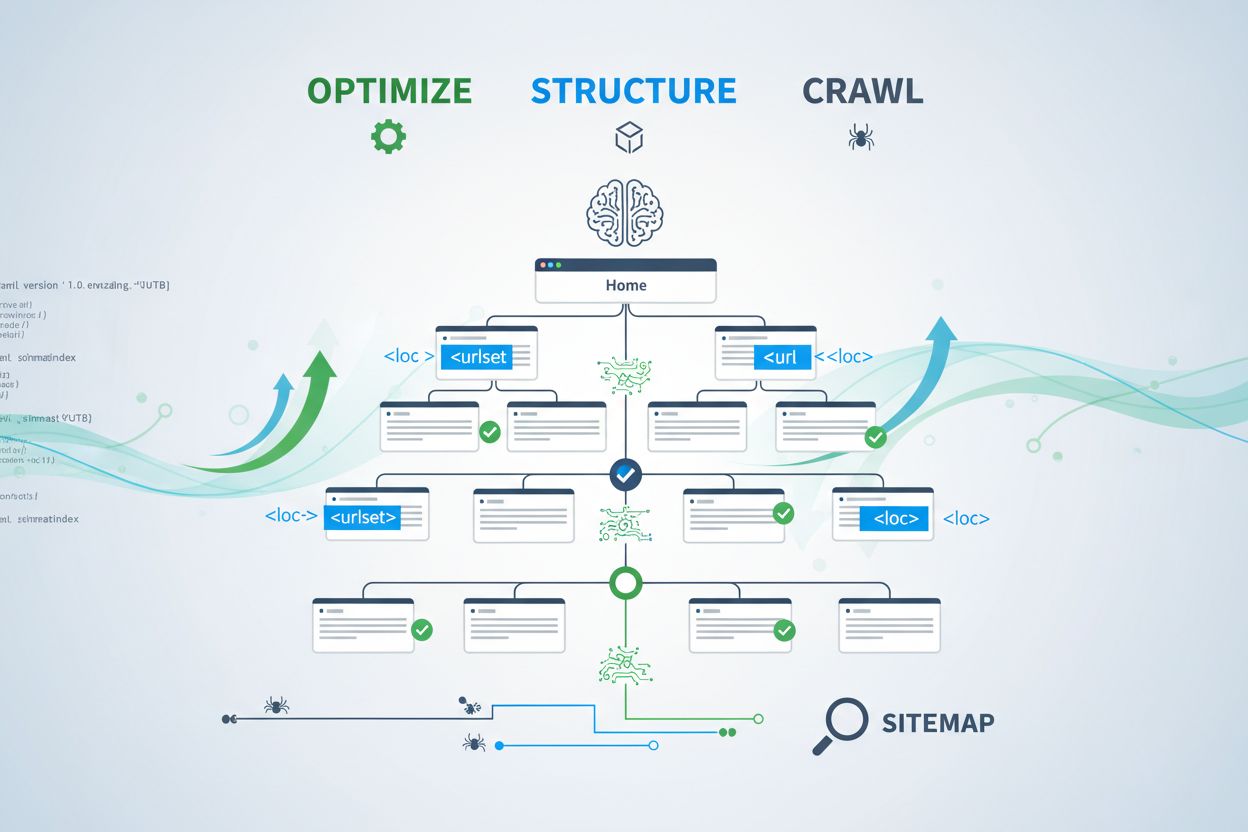

AI-crawlers zoals GPTBot, ClaudeBot en PerplexityBot werken fundamenteel anders dan traditionele zoekmachinebots. Waar Googlebot pagina’s indexeert voor ranking in zoekresultaten, halen AI-crawlers kennis op om grote taalmodellen te trainen en te informeren die conversatiezoekopdrachten en AI-gegenereerde antwoorden aandrijven. Zonder een goed geoptimaliseerde XML-sitemap blijft je content onzichtbaar voor deze cruciale systemen, ongeacht hoe goed geschreven of gezaghebbend die is. Zie je sitemap als een routekaart die AI-systemen precies vertelt waar je meest waardevolle content zich bevindt en hoe het is georganiseerd.

Het onderscheid tussen traditionele zoekcrawlers en AI-crawlers is cruciaal om te begrijpen waarom sitemap-optimalisatie belangrijker is dan ooit. Traditionele zoekmachines zoals Google richten zich op het rangschikken van individuele pagina’s voor specifieke zoekwoorden, terwijl AI-crawlers kennisopname en semantisch begrip prioriteren. Hier is hoe ze verschillen:

| Aspect | Traditionele crawlers (Googlebot) | AI-crawlers (GPTBot, ClaudeBot) |

|---|---|---|

| Primair doel | Pagina’s rangschikken in zoekresultaten | Kennis extraheren voor LLM-training en realtime antwoorden |

| Focus | Metadata, interne links, rankingsignalen | Contentstructuur, semantische betekenis, feiten-dichtheid |

| Crawlprioriteit | Gebaseerd op PageRank en actualiteit | Gebaseerd op autoriteit, thematische relevantie en kenniswaarde |

| Citeringsimpact | Stuurt verkeer via blauwe links | Bepaalt of je content verschijnt in AI-gegenereerde antwoorden |

| JavaScript-afhandeling | Voert uit en rendert JavaScript | Slaat JavaScript vaak over; geeft prioriteit aan server-gerenderde HTML |

Dit fundamentele verschil betekent dat optimaliseren voor alleen traditionele SEO niet langer voldoende is. Je sitemap moet nu een dubbele functie vervullen: traditionele zoekmachines helpen bij het begrijpen van je sitestructuur en tegelijkertijd AI-systemen naar je meest waardevolle kennis-assets leiden.

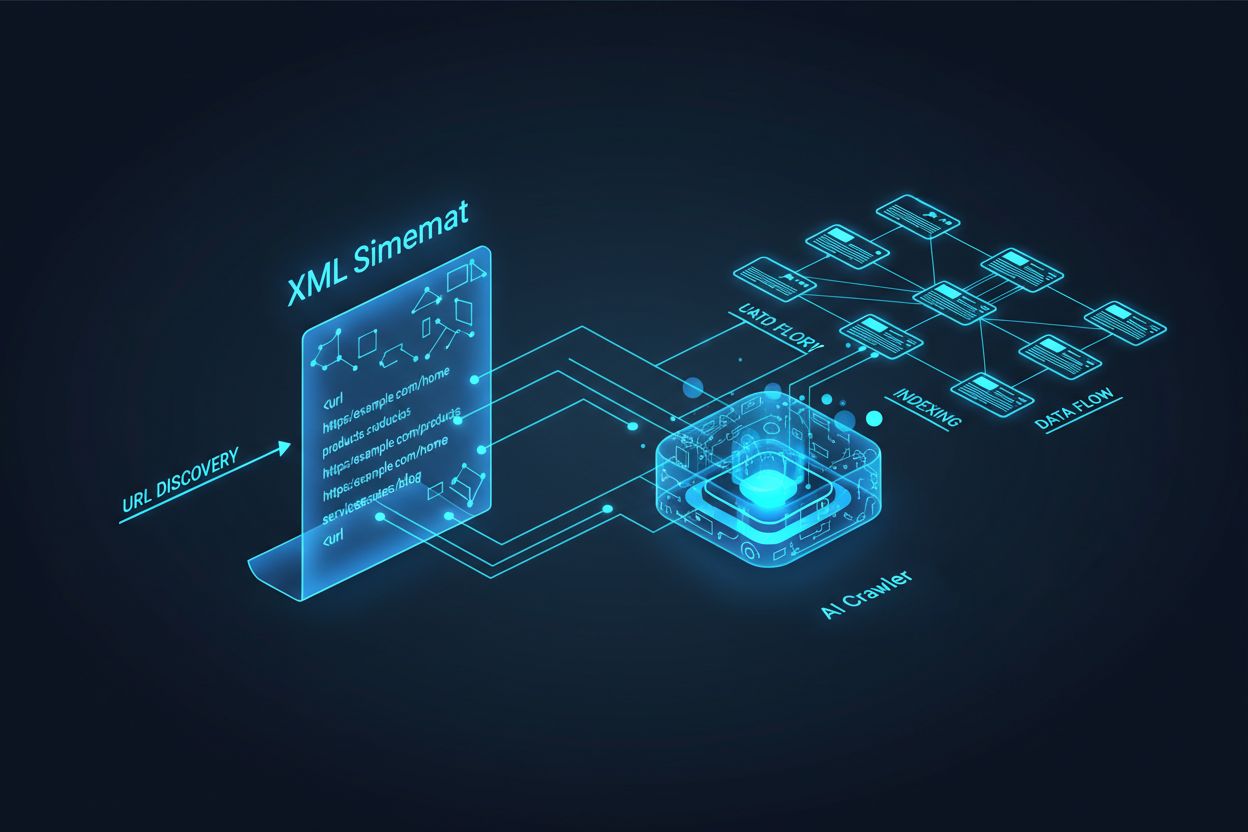

Een XML-sitemap fungeert als het blauwdruk van je website en geeft expliciet aan crawlers aan welke pagina’s er zijn en hoe ze zich verhouden tot je algehele contentstrategie. Voor AI-systemen vervullen sitemaps een nog belangrijkere functie dan voor traditionele zoekopdrachten. AI-crawlers gebruiken sitemaps om de thematische architectuur van je site te begrijpen, belangrijke content te identificeren en te bepalen welke pagina’s diepgaandere analyse verdienen. Wanneer je sitemap volledig en goed georganiseerd is, kunnen AI-systemen efficiënter je content ontdekken en beoordelen voor opname in gegenereerde antwoorden. Omgekeerd creëert een onvolledige of verouderde sitemap blinde vlekken die voorkomen dat AI-systemen je belangrijkste pagina’s ooit tegenkomen. Het effect is direct: pagina’s die niet in je sitemap staan, worden aanzienlijk minder snel door AI-systemen geciteerd, ongeacht hun kwaliteit of relevantie.

Een effectieve sitemap maken voor AI-crawlers vereist meer dan alleen het opsommen van elke URL op je site. Je sitemap moet strategisch worden samengesteld en alleen pagina’s bevatten die echt waarde bieden aan gebruikers en AI-systemen. Hier zijn de essentiële best practices:

Een goed gestructureerde sitemap fungeert als kwaliteitsfilter en laat AI-systemen zien dat je je content zorgvuldig hebt geselecteerd en dat elke opgenomen URL aandacht verdient. Deze strategische aanpak vergroot je kans aanzienlijk om geselecteerd te worden voor citatie in AI-gegenereerde antwoorden.

Actualiteit is een van de sterkste rankingfactoren in AI-zoeksystemen. Wanneer AI-crawlers beoordelen welke bronnen ze in gegenereerde antwoorden moeten citeren, hechten ze zwaar aan contentversheid. De lastmod-tijdstempel in je XML-sitemap is het primaire signaal dat aan AI-systemen aangeeft wanneer je content voor het laatst is bijgewerkt. Verouderde of ontbrekende tijdstempels kunnen zelfs gezaghebbende content laten dalen ten gunste van recentere bronnen. Als je sitemap laat zien dat een pagina al jaren niet is bijgewerkt, kunnen AI-systemen aannemen dat de informatie verouderd is en kiezen ze eerder voor concurrenten. Nauwkeurige lastmod-tijdstempels die werkelijke updates weerspiegelen, geven AI-crawlers aan dat je informatie actueel en betrouwbaar is. Voor tijdgevoelige onderwerpen zoals prijzen, regelgeving of branchetrends is het bijhouden van nauwkeurige tijdstempels extra belangrijk. Geautomatiseerde updates via je CMS zorgen ervoor dat elke wijziging direct zichtbaar is in je sitemap en maximaliseren je zichtbaarheid in AI-gegenereerde antwoorden.

Waar sitemaps crawlers uitnodigen om je content te indexeren, sturen robots.txt-bestanden aan welke delen van je site crawlers toegang hebben. Deze twee bestanden moeten samenwerken om je AI-zichtbaarheid te maximaliseren. Een veelgemaakte fout is het creëren van een uitgebreide sitemap en tegelijkertijd AI-crawlers blokkeren in je robots.txt-bestand, wat een tegenstrijdigheid oplevert die crawlers in verwarring brengt en je zichtbaarheid vermindert. Je robots.txt moet grote AI-crawlers zoals GPTBot, ClaudeBot en PerplexityBot expliciet toegang geven tot je content. Je kunt robots.txt strategisch gebruiken om alleen pagina’s te blokkeren die niet geïndexeerd mogen worden, zoals admin dashboards, loginpagina’s of dubbele contentversies. Het belangrijkste is dat je robots.txt-regels aansluiten op je sitemapstrategie—als een pagina in je sitemap staat, moet deze toegankelijk zijn volgens je robots.txt-regels. Regelmatige audits van beide bestanden helpen misconfiguraties identificeren die je AI-zichtbaarheid ongemerkt kunnen beperken.

De meest effectieve AI-optimalisatiestrategieën behandelen sitemaps en gestructureerde data als complementaire systemen die elkaar versterken. Wanneer je sitemap een pagina als belangrijk markeert en die pagina relevante schemamarkering bevat, geef je consistente signalen aan AI-crawlers over het doel en de waarde van de pagina. Bijvoorbeeld: als je sitemap een how-to-gids prioriteert, moet die pagina HowTo-schema bevatten dat gestructureerde informatie over de stappen biedt. Evenzo moeten productpagina’s in je sitemap Product-schema bevatten met prijs-, beschikbaarheids- en beoordelingsinformatie. Deze afstemming creëert een samenhangend dataprofiel dat AI-systemen eenvoudig kunnen interpreteren en vertrouwen. Wanneer sitemaps en gestructureerde data conflicteren of uiteenlopen, raken AI-crawlers onzeker over het werkelijke doel van de pagina, waardoor de kans op citatie afneemt. Door ervoor te zorgen dat je sitemapstrategie aansluit op je schema-implementatie, creëer je een eenduidig signaal dat je kans om gekozen te worden voor AI-gegenereerde antwoorden drastisch verhoogt.

Verschillende contenttypes vereisen verschillende sitemapstrategieën om maximale AI-zichtbaarheid te bereiken. Blogposts, productpagina’s, dienstbeschrijvingen en FAQ-content hebben allemaal een andere functie en moeten dienovereenkomstig worden geoptimaliseerd:

| Contenttype | Sitemapstrategie | Aanbevolen schemamarkering | Prioriteits-overwegingen |

|---|---|---|---|

| Blogposts & artikelen | Opnemen met nauwkeurige publicatie- en update-data | Article, NewsArticle, BlogPosting | Geef prioriteit aan recente, evergreen content; werk lastmod regelmatig bij |

| Productpagina’s | Opnemen met voorraadupdates; overweeg aparte productsitemap | Product, Offer, AggregateRating | Markeer bestsellers en nieuwe producten; werk prijzen vaak bij |

| Dienstpagina’s | Opnemen met update-data van diensten | Service, LocalBusiness, ProfessionalService | Prioriteer kernservices; werk beschikbaarheid en tarieven bij |

| FAQ-pagina’s | Opnemen met content-update-data | FAQPage, Question, Answer | Geef prioriteit aan uitgebreide FAQ’s; werk antwoorden bij als informatie verandert |

| Video-content | Opnemen in videositemap met thumbnail en duur | VideoObject, Video | Voeg transcripties toe; werk weergaveaantallen en engagement bij |

| Afbeeldingscontent | Opnemen in afbeeldingen-sitemap met bijschriften | ImageObject, Product (voor productafbeeldingen) | Optimaliseer alt-tekst; voeg beschrijvende bijschriften toe |

Deze gedifferentieerde aanpak zorgt ervoor dat elk contenttype de juiste optimalisatie krijgt voor AI-ontdekking. Door je sitemapstrategie af te stemmen op je contentmix, maximaliseer je de kans dat AI-systemen je meest waardevolle assets vinden en citeren.

De llms.txt-standaard, voorgesteld eind 2024, is een experimentele aanpak om AI-systemen te helpen de structuur van een website te begrijpen. In tegenstelling tot XML-sitemaps is llms.txt een op Markdown gebaseerd bestand dat een mens-leesbare inhoudsopgave van je site biedt. Het somt je belangrijkste pagina’s en bronnen op in een formaat dat eenvoudiger te parsen en te begrijpen is voor taalmodellen. Hoewel het concept veelbelovend is, wijst huidig bewijs erop dat llms.txt weinig impact heeft op AI-zichtbaarheid vergeleken met traditionele XML-sitemaps. Grote AI-crawlers zoals GPTBot en ClaudeBot vertrouwen nog steeds voornamelijk op XML-sitemaps voor URL-ontdekking en actualiteitssignalen. Zie llms.txt daarom als een aanvullend hulpmiddel en niet als vervanging van je XML-sitemap. Als je llms.txt toepast, zorg er dan voor dat het je kernstrategie aanvult en focus eerst op het perfectioneren van je XML-sitemap met nauwkeurige tijdstempels en strategische contentselectie.

Zelfs goedbedoelde websites maken vaak kritieke sitemapfouten die ongemerkt hun AI-zichtbaarheid beperken. Het begrijpen en vermijden van deze fouten is essentieel om je aanwezigheid in AI-gegenereerde antwoorden te maximaliseren:

Het aanpakken van deze veelvoorkomende fouten kan je AI-zichtbaarheid direct verbeteren. Begin met het auditen van je huidige sitemap aan de hand van deze checklist en los eventuele problemen op die je vindt.

Het onderhouden van een geoptimaliseerde sitemap vereist voortdurende monitoring en validatie. Verschillende tools kunnen je helpen om je sitemap effectief te houden voor AI-crawlers. Google Search Console biedt ingebouwde sitemapvalidatie en toont hoeveel URL’s Google heeft geïndexeerd uit je sitemap. Screaming Frog SEO Spider stelt je in staat je hele site te crawlen en de resultaten te vergelijken met je sitemap, zodat je ontbrekende of gebroken URL’s kunt opsporen. XML-sitemapvalidators controleren je sitemapsyntax en zorgen dat die voldoet aan het XML-sitemapprotocol. Voor grote organisaties bevatten gespecialiseerde SEO-platformen zoals Semrush en Ahrefs sitemap-analysefuncties waarmee je wijzigingen in de tijd kunt volgen. Regelmatige audits—bij voorkeur maandelijks—helpen je problemen te signaleren voordat ze je AI-zichtbaarheid beïnvloeden. Zet herinneringen in je agenda om je sitemap te controleren wanneer je grote contentwijzigingen doorvoert, nieuwe secties lanceert of je sitestructuur bijwerkt.

Begrijpen hoe AI-crawlers omgaan met je sitemap vereist actieve monitoring en analyse. Je serverlogs bevatten waardevolle data over welke AI-crawlers je site bezoeken, hoe vaak ze crawlen en welke pagina’s ze prioriteren. Door deze logs te analyseren kun je patronen herkennen en je sitemap daarop optimaliseren. Tools zoals AmICited.com helpen je te monitoren hoe vaak je content wordt geciteerd door AI-systemen zoals ChatGPT, Claude, Perplexity en Google’s AI Overviews, waardoor je direct inzicht krijgt in de effectiviteit van je sitemap. Google Analytics kan worden geconfigureerd om verwijzingsverkeer van AI-systemen te volgen, zodat je ziet welke pagina’s de meeste AI-gedreven zichtbaarheid opleveren. Door deze data te koppelen aan je sitemapstructuur kun je vaststellen welke contenttypes en onderwerpen het meest aanslaan bij AI-systemen. Deze datagedreven aanpak stelt je in staat je sitemapstrategie continu te verfijnen, met prioriteit voor content die de meeste AI-verwijzingen en zichtbaarheid oplevert.

Naast basisoptimalisatie kunnen geavanceerde strategieën je AI-zichtbaarheid aanzienlijk vergroten. Het maken van aparte sitemaps voor verschillende contenttypes—zoals aparte blogsitemaps, productsitemaps en videositemaps—maakt type-specifieke optimalisaties mogelijk. Dynamische sitemap-generatie, waarbij je sitemap realtime wordt bijgewerkt zodra content verandert, zorgt ervoor dat AI-crawlers altijd je meest actuele content zien. Voor grote ondernemingssites met duizenden pagina’s helpt het implementeren van sitemap-hiërarchieën en strategische prioriteiten AI-crawlers zich te richten op je meest waardevolle content. Sommige organisaties maken AI-specifieke sitemaps die alleen hun hoogst gezaghebbende, meest citeringswaardige content markeren, als signaal aan AI-systemen welke pagina’s prioriteit verdienen. Door je sitemapstrategie te integreren met je CMS vindt optimalisatie automatisch plaats in plaats van handmatig. Deze geavanceerde benaderingen vereisen meer technische kennis maar kunnen aanzienlijke verbeteringen opleveren in AI-zichtbaarheid voor organisaties met complexe content-ecosystemen.

Het AI-crawlerlandschap ontwikkelt zich razendsnel, met steeds nieuwe crawlers en standaarden zoals llms.txt die aan terrein winnen. Je sitemapstrategie toekomstbestendig maken betekent flexibiliteit inbouwen in je systemen en op de hoogte blijven van ontwikkelingen in de sector. Implementeer systemen voor sitemap-generatie die eenvoudig nieuwe crawlvereisten aankunnen zonder handmatige herconfiguratie. Volg aankondigingen van grote AI-bedrijven over nieuwe crawlers en pas je robots.txt- en sitemapstrategieën daarop aan. Overweeg de langetermijnwaarde van AI-zichtbaarheid versus contentcontrole—waar sommige organisaties AI-crawlers blokkeren, wijst de trend erop dat AI-verwijzingen steeds belangrijker worden voor merkzichtbaarheid. Ontwikkel duidelijke beleidsregels voor hoe je organisatie AI-crawlertoegang en contentgebruik beheert. Door je sitemap als een levend document te behandelen dat meegroeit met het AI-landschap, zorg je ervoor dat je content vindbaar en citeerbaar blijft naarmate zoek- en ontdekkingsmechanismen blijven veranderen.

Je dient je sitemap bij te werken telkens wanneer je nieuwe content publiceert of ingrijpende wijzigingen aanbrengt aan bestaande pagina's. Idealiter implementeer je geautomatiseerde sitemap-generatie zodat updates direct plaatsvinden. Voor sites met frequente contentwijzigingen zijn dagelijkse updates aanbevolen. Voor statische sites volstaat een maandelijkse controle.

De meeste grote AI-crawlers zoals GPTBot en ClaudeBot respecteren robots.txt-richtlijnen, maar niet allemaal doen dat. De beste praktijk is AI-crawlers expliciet toe te staan in je robots.txt-bestand in plaats van te vertrouwen op standaardgedrag. Controleer je serverlogs om te verifiëren dat crawlers zich gedragen zoals verwacht.

XML-sitemaps zijn machine-leesbare bestanden die al je URL’s met metadata zoals lastmod-tijdstempels bevatten. llms.txt is een nieuw, op Markdown gebaseerd standaard dat bedoeld is om AI-systemen een mens-leesbare inhoudsopgave te bieden. XML-sitemaps zijn momenteel belangrijker voor AI-zichtbaarheid, terwijl llms.txt als aanvullend moet worden gezien.

Controleer je serverlogs op user agents zoals 'GPTBot', 'ClaudeBot', 'PerplexityBot' en 'Google-Extended'. Je kunt ook tools zoals AmICited.com gebruiken om te monitoren hoe vaak jouw content wordt geciteerd door AI-systemen, wat succesvolle crawling en indexering aangeeft.

Ja, het aanmaken van aparte sitemaps voor blogs, producten, video's en afbeeldingen stelt je in staat type-specifieke optimalisatiestrategieën toe te passen. Dit helpt AI-crawlers ook om je contentstructuur duidelijker te begrijpen en kan de crawl-efficiëntie voor grote sites verbeteren.

XML-sitemaps mogen niet meer dan 50.000 URL’s per bestand bevatten. Voor grotere sites gebruik je sitemap-indexen om meerdere sitemap-bestanden te organiseren. AI-crawlers kunnen grote sitemaps aan, maar het onderverdelen in logische secties verbetert de crawl-efficiëntie en maakt beheer eenvoudiger.

Lastmod-tijdstempels geven aan AI-crawlers de actualiteit van je content aan. Recente inhoud is een sterke rankingfactor in AI-systemen, dus nauwkeurige tijdstempels helpen je content om te concurreren voor verwijzingen. Gebruik altijd geautomatiseerde systemen om tijdstempels bij te werken alleen wanneer de content daadwerkelijk verandert—zet nooit handmatig valse tijdstempels.

Ja, een slecht onderhouden sitemap kan je AI-zichtbaarheid aanzienlijk schaden. Dode links, verouderde URL’s, onnauwkeurige tijdstempels en onvolledige dekking verkleinen allemaal je kans om door AI-systemen geciteerd te worden. Regelmatige audits en onderhoud zijn essentieel om je AI-zichtbaarheid te beschermen.

Volg hoe vaak jouw content wordt geciteerd door ChatGPT, Claude, Perplexity en Google AI Overviews. Optimaliseer je sitemapstrategie op basis van echte AI-verwijzingsdata.

Compleet naslagwerk over AI crawlers en bots. Identificeer GPTBot, ClaudeBot, Google-Extended en meer dan 20 andere AI-crawlers met user agents, crawl rates en ...

Ontdek welke AI-crawlers je moet toestaan of blokkeren in je robots.txt. Uitgebreide gids over GPTBot, ClaudeBot, PerplexityBot en 25+ AI-crawlers met configura...

Leer hoe je AI-bots zoals GPTBot, PerplexityBot en ClaudeBot toestaat om je site te crawlen. Configureer robots.txt, stel llms.txt in en optimaliseer voor AI-zi...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.