Reviews beheren voor AI-zichtbaarheid: Authenticiteit en Volume

Leer hoe je reviews beheert voor maximale AI-zichtbaarheid. Ontdek het belang van authenticiteit, semantische diversiteit en strategische distributie voor LLM-c...

Ontdek hoe sociaal bewijs AI-aanbevelingen vormgeeft en de zichtbaarheid van een merk beïnvloedt. Leer waarom klantbeoordelingen nu cruciale trainingsdata zijn voor LLM’s en hoe je kunt optimaliseren voor AI-zichtbaarheid.

Decennialang is sociaal bewijs de hoeksteen geweest van het opbouwen van consumentenvertrouwen. Klantbeoordelingen, testimonials en sterrenbeoordelingen beïnvloeden aankoopbeslissingen, vormen merkreputaties en stimuleren conversies in alle sectoren. Het landschap verandert echter ingrijpend. Tegenwoordig beïnvloedt sociaal bewijs niet alleen menselijke kopers—het wordt ook cruciale trainingsdata voor kunstmatige intelligentiesystemen die producten, diensten en content aan miljoenen gebruikers aanbevelen. Nu AI-gedreven tools als ChatGPT, Google AI Overviews en Perplexity de primaire ontdekkanalen voor consumenten worden, is de rol van sociaal bewijs fundamenteel getransformeerd. Dezelfde beoordelingen en ratings die ooit een sceptische koper overtuigden, bepalen nu hoe AI-systemen jouw merk begrijpen, beschrijven en aanbevelen.

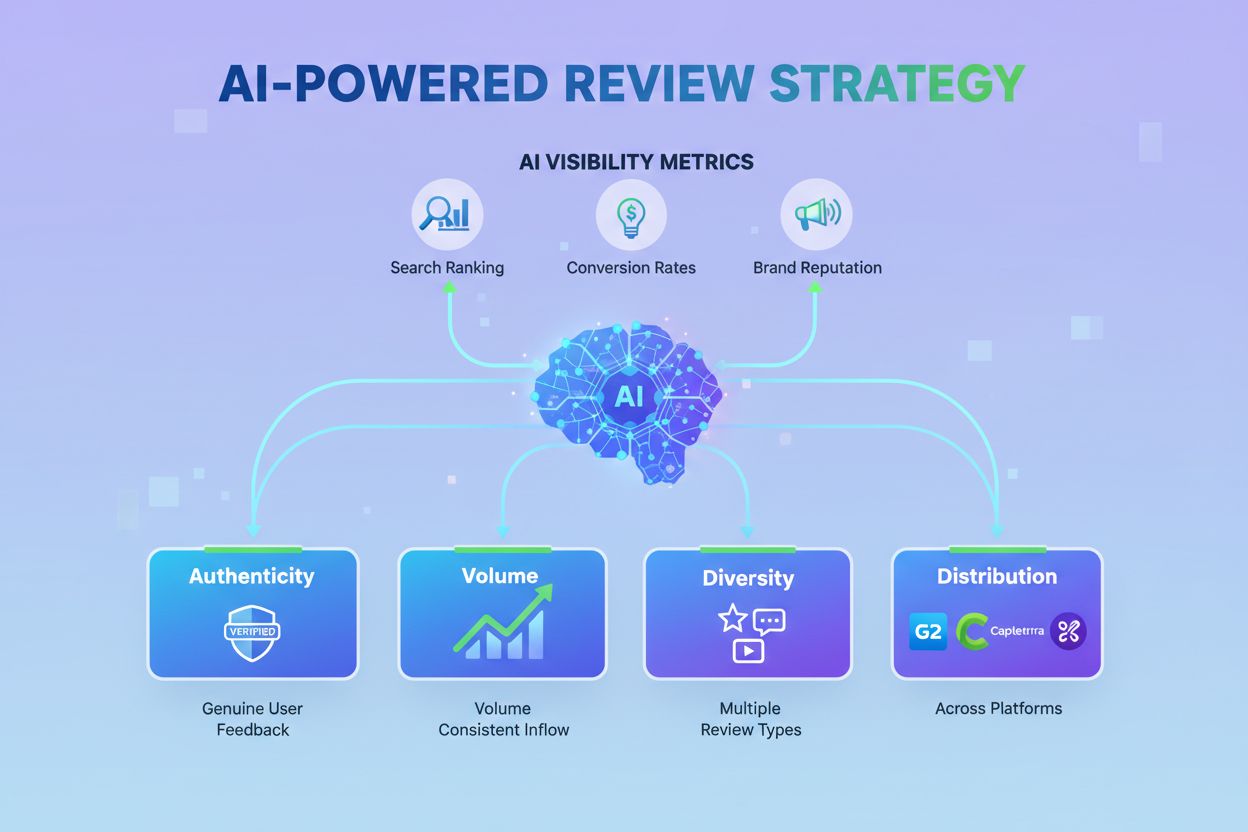

Grote taalmodellen worden getraind op enorme datasets van publiek beschikbare teksten, waarbij klantbeoordelingen een belangrijk onderdeel van die trainingsdata vormen. Wanneer je een beoordeling schrijft, communiceer je niet alleen met andere mensen—je draagt bij aan het corpus dat AI-systemen leert hoe merken te beschrijven en te evalueren. Dit betekent dat de taal die klanten gebruiken in hun beoordelingen direct invloed heeft op hoe AI-modellen in de toekomst over jouw bedrijf praten. Het proces is niet willekeurig; AI-systemen geven prioriteit aan drie kritieke factoren bij het verwerken van beoordelingsdata: actualiteit (recente beoordelingen signaleren voortdurende relevantie), volume (honderden of duizenden beoordelingen creëren sterkere patronen dan een paar), en diversiteit van formulering (gevarieerde taal vergroot de woordenschat van AI voor het beschrijven van jouw merk).

Denk aan het concept “semantisch oppervlak”—oftewel het bereik aan unieke uitdrukkingen en beschrijvingen waar AI uit kan putten. Een beoordeling als “geweldig product” biedt nauwelijks semantisch oppervlak. Maar een gedetailleerde beoordeling zoals “dit hield het perfect vol tijdens een trailrun van 32 kilometer in zware regen; de waterdichtheid overtrof mijn verwachtingen” creëert meerdere aangrijpingspunten voor AI om jouw product in onverwachte zoekcontexten te laten verschijnen. Daarom zijn specifieke, gedetailleerde klantbeschrijvingen in het AI-tijdperk veel belangrijker dan algemene lof ooit was.

| Aspect | Traditioneel sociaal bewijs | Sociaal bewijs in AI-tijdperk |

|---|---|---|

| Primair gebruik | Beïnvloeden van menselijke kopers | AI-modellen trainen |

| Belangrijkste metric | Gemiddelde sterrenwaardering | Actualiteit + Volume + Formuleringsdiversiteit |

| Belang van authenticiteit | Hoog | Kritiek (AI filtert nepreviews) |

| Platformstrategie | Focus op één platform | Verspreiding over meerdere platforms |

| Inhoudswaarde | Algemene lof acceptabel | Specifieke, gedetailleerde taal gewenst |

| Tijdgevoeligheid | Altijd relevant | Zeer tijdgevoelig |

| Impact op AI-zichtbaarheid | Indirect | Direct en meetbaar |

Mensen zijn van nature geneigd om stemmen van gelijken meer te vertrouwen dan beloften van merken. Dit psychologische principe, sociaal bewijs genoemd, is een van de krachtigste hefbomen bij het nemen van beslissingen. Als we zien dat anderen zoals wij iets goedkeuren, zijn we zelf ook sneller geneigd het te vertrouwen. AI-systemen ervaren vertrouwen niet zoals mensen, maar spiegelen dit gedrag door input die betrouwbaarheid en authenticiteit signaleren, zwaarder te laten wegen. Sociaal bewijs activeert meerdere psychologische triggers die AI-systemen hebben leren herkennen en waarderen: transparantie (klanten willen zowel sterke als zwakke punten zien), eerlijkheid (mensen verwachten eerlijke behandeling, geen perfectie), en consensus (de wijsheid van de massa weegt zwaar).

Opvallend genoeg voelt een product met een gemiddeld cijfer van 4,5 sterren vaak betrouwbaarder aan voor zowel mensen als AI-systemen dan een perfecte 5,0-score. Dit komt doordat gemengde beoordelingen—waar sommige klanten bepaalde aspecten prijzen terwijl anderen legitieme nadelen noemen—authenticiteit signaleren. AI-systemen hebben geleerd deze evenwichtige feedback te detecteren en te belonen, en zien het als een sterker vertrouwenssignaal dan kunstmatig perfecte scores. Wanneer je doordacht reageert op negatieve beoordelingen, manage je niet alleen de menselijke perceptie; je creëert een datatrail van verantwoording die AI-systemen herkennen en waarderen. Deze verschuiving betekent dat goed omgaan met kritiek net zo belangrijk is geworden als het genereren van positieve beoordelingen.

De integratie van AI in winkelen en productontdekking versnelt snel. OpenAI’s ChatGPT Merchants-functie laat gebruikers AI direct om productaanbevelingen vragen, terwijl Google’s AI Overviews steeds vaker beoordelingsdata in zoekresultaten opnemen. Ook Perplexity, Claude en andere AI-zoektools volgen deze trend en gebruiken signalen van sociaal bewijs om te bepalen welke producten en diensten worden aanbevolen. Wanneer een AI-systeem een vraag krijgt als “Wat is de beste hardloopschoen onder de €150?”, kijkt het niet alleen naar productspecificaties—het weegt beoordelingsvolume, consistentie van ratings en de thema’s die uit klantfeedback naar voren komen mee.

Deze verschuiving betekent een fundamentele verandering in hoe online zichtbaarheid werkt. De afgelopen twintig jaar richtte SEO zich op optimalisatie voor zoekmachine-algoritmen. Nu ontstaat een nieuwe discipline: reputatie-optimalisatie. In plaats van “Staan we bovenaan in Google?”, moeten bedrijven zich nu afvragen: “Hebben we de reviewgezondheid om door AI aanbevolen te worden?” Een bedrijf met een dunne reviewbasis, inconsistente ratings over platforms of hoofdzakelijk negatieve feedback wordt simpelweg uit AI-aanbevelingssets gefilterd, ongeacht de werkelijke productkwaliteit. De inzet is hoger dan ooit, want AI-aanbevelingen geven vaak één antwoord in plaats van een keuzelijst—als je niet wordt aanbevolen, besta je niet.

Sociaal bewijs creëren dat zowel bij mensen als AI resoneert, vraagt om een strategische, veelzijdige aanpak. De basis is het stimuleren van authentieke beoordelingen op het optimale moment—het zogenaamde “happy moment”, wanneer klanten het meest geneigd zijn om positieve ervaringen te delen. Dit kan direct na een succesvolle aankoop zijn, na uitstekende service, of wanneer een product aan de verwachtingen voldoet. Maak het beoordelingsproces zo frictieloos mogelijk door directe links, QR-codes of éénklik-prompts aan te bieden.

Na het verzamelen verschuift de strategie naar distributie en consistentie. Dit zijn de belangrijkste acties:

De consistentie van je reviewaanwezigheid is belangrijker dan het volume. Een bedrijf dat in één maand honderd beoordelingen verzamelt en daarna zes maanden stil is, komt voor AI-systemen verdacht over. Een gestage, voortdurende stroom positieve beoordelingen signaleert blijvende relevantie en tevredenheid. Daarom is het opbouwen van een duurzaam reviewproces—in je klantbeleving geïntegreerd—waardevoller dan eenmalige campagnes.

Nu beoordelingen steeds belangrijker worden voor AI-systemen, zijn de belangen rond authenticiteit groter dan ooit tevoren. AI-systemen worden steeds beter in het herkennen en filteren van nepreviews, gemanipuleerde ratings en onechte feedback. Een bedrijf dat het systeem probeert te manipuleren, loopt niet alleen reputatieschade op bij menselijke klanten—het riskeert ook een lagere prioriteit of volledige uitsluiting uit AI-aanbevelingssets. Geverifieerde aankopen zijn een cruciaal vertrouwenssignaal en bewijzen dat de reviewer het product daadwerkelijk heeft ervaren. Platformoverstijgende consistentie telt ook; als een bedrijf op het ene platform uitstekende beoordelingen heeft maar elders slecht scoort, markeert AI dit als een mogelijk waarschuwingssignaal.

Derdepartijverificatie-badges en vertrouwenssignalen zijn in het AI-tijdperk belangrijker geworden. Wanneer een beoordeling is gemarkeerd als “geverifieerde aankoop” of afkomstig is van een vertrouwd platform, weegt AI deze zwaarder mee. Governance—beleid dat review-flooding, duplicatie en nepaccounts voorkomt—bouwt lange termijn geloofwaardigheid op. De beoordelingen die het meest tellen voor AI zijn dezelfde die mensen ook vertrouwen: authentiek, divers en natuurlijk gevarieerd qua taal en sentiment. Bedrijven die authenticiteit boven volume stellen, zullen op de lange termijn beter scoren op AI-zichtbaarheid.

Traditionele SEO bood een duidelijke metric: zoekwoordposities. In het AI-tijdperk dient zich een nieuwe vraag aan: Hoe beschrijft AI mijn merk op dit moment? Dit is meetbaar en zou net zo belangrijk moeten worden als elke andere marketingmetric. De methode is eenvoudig: stel een set prompts op en voer deze op regelmatige basis uit bij verschillende LLM’s om in de tijd te volgen hoe AI jouw merk beschrijft.

Voorbeelden van testprompts zijn:

Door deze prompts maandelijks of per kwartaal uit te voeren, creëer je een momentopname van je AI-merknarratief. Na verloop van tijd zie je of verbeteringen in diversiteit, actualiteit en authenticiteit van beoordelingen invloed hebben op de manier waarop AI-systemen jouw bedrijf beschrijven. Tools zoals AmICited.com kunnen helpen monitoren hoe AI-systemen jouw merk noemen op verschillende platforms, zodat je inzicht krijgt in deze nieuwe laag van digitale aanwezigheid. Door deze AI-narratiefanalyse te koppelen aan je reviewdata, wordt het directe verband tussen de kwaliteit van sociaal bewijs en AI-zichtbaarheid zichtbaar.

De impact van sociaal bewijs op AI-aanbevelingen verschilt sterk per sector, maar het onderliggende principe blijft gelijk: reputatie is omzet. Voor e-commerce merken bepalen Amazon-beoordelingen nu al conversies, en naarmate AI meer geïntegreerd raakt in het shoppen, zullen producten met hogere sterrenwaarderingen en meer gedetailleerde feedback de aanbevelingen domineren. Voor SaaS-bedrijven zijn platforms als G2 en Capterra cruciaal geworden; zakelijke kopers vertrouwen steeds vaker op door AI samengestelde samenvattingen van softwarebeoordelingen, net zo veel als op traditionele analistenrapporten.

Lokale dienstverleners—restaurants, tandartsen, sportscholen, loodgieters—staan voor een bijzonder scherpe omslag. Google Maps en Yelp-beoordelingen bepalen direct of AI jou aanbeveelt als “de beste optie in de buurt”. Bureaus zullen klanten moeten helpen hun reviewaanwezigheid over meerdere platforms te beheren, want een gefragmenteerd of inconsistent profiel signaleert zwakte aan AI-systemen. Restaurants in het bijzonder zullen merken dat AI-aanbevelingen op basis van review-signalen een primair ontdek-kanaal worden, waardoor reviewmanagement net zo belangrijk wordt als de voedselkwaliteit zelf.

In al deze sectoren geldt één patroon: bedrijven die reputatiemanagement als groeistrategie zien in plaats van als crisisrespons, zullen floreren. De bedrijven die vandaag investeren in authentieke reviewgeneratie, verspreiding over meerdere platforms en consistente betrokkenheid bij klantfeedback, zijn morgen degenen die door AI worden aanbevolen.

De koers is duidelijk: AI-winkelen wordt mainstream. ChatGPT Merchants, de integratie van AI in Google-zoekopdrachten en de opkomst van gespecialiseerde AI-shopassistenten vormen nog maar het begin. Naarmate deze tools de belangrijkste manier worden waarop consumenten producten ontdekken, zal de doorslaggevende factor niet prijs, features of traditionele marketing zijn—maar vertrouwen, gemeten via sociaal bewijs.

Reputatiemanagement evolueert van een reactieve discipline (reageren op crises) naar een proactieve groeistrategie (vertrouwenssignalen bouwen die AI-systemen herkennen). Nieuwe optimalisatiestrategieën ontstaan rond semantisch oppervlak, reviewtempo en platformoverstijgende consistentie. De convergentie van menselijke vertrouwenspsychologie en machine learning creëert een nieuw concurrerend landschap waarin authenticiteit en transparantie geen luxe meer zijn, maar essentiële bedrijfsinfrastructuur.

De voorlopers—bedrijven die de verschuiving van SEO naar reputatie-optimalisatie herkennen en nu investeren in authentieke sociaal bewijsstrategieën—zullen een aanzienlijk voordeel hebben. Zij zijn beter gepositioneerd voor AI-zichtbaarheid, weerbaarder tegen algoritmewijzigingen en beter afgestemd op hoe consumenten de komende jaren producten zullen ontdekken. Het moment om je sociaal bewijsstrategie voor te bereiden is niet wanneer AI-aanbevelingen dominant zijn geworden; het is nu, zolang je nog tijd hebt om een authentieke, diverse en consistente reviewaanwezigheid over platforms op te bouwen.

LLM's worden getraind op publiekelijk beschikbare tekst, waaronder klantbeoordelingen. Deze beoordelingen helpen AI-systemen te leren hoe merken te beschrijven en te evalueren. De taal, formuleringen en sentimenten in beoordelingen beïnvloeden direct hoe AI-modellen in de toekomst over jouw bedrijf praten, waardoor de kwaliteit van beoordelingen cruciaal is voor AI-zichtbaarheid.

Semantisch oppervlak verwijst naar het bereik van unieke uitdrukkingen en beschrijvingen waaruit AI kan putten bij het beschrijven van jouw merk. Gedetailleerde, specifieke beoordelingen creëren meer taalkundig terrein voor AI om jouw producten in uiteenlopende zoekopdrachten te tonen, terwijl algemene lof weinig semantisch oppervlak biedt.

AI-systemen worden steeds geavanceerder in het detecteren en filteren van nepreviews, gemanipuleerde beoordelingen en onechte feedback. Geverifieerde aankopen, platformoverstijgende consistentie en natuurlijke taalvariatie signaleren authenticiteit aan AI-systemen, die deze signalen zwaarder laten meewegen in hun aanbevelingen.

Stel een reeks testprompts op en voer deze op regelmatige basis uit bij verschillende LLM's. Voorbeelden zijn: 'Wat zeggen klanten over [merk]?' en 'Waarom kiezen mensen voor [merk]?' Door AI-reacties in de tijd te volgen, kun je meten of verbeteringen in beoordelingskwaliteit invloed hebben op AI-zichtbaarheid.

Traditioneel sociaal bewijs richtte zich op het beïnvloeden van menselijke kopers via sterrenbeoordelingen en testimonials. Sociaal bewijs in het AI-tijdperk dient als trainingsdata voor machine learning-modellen, waarbij actualiteit, volume en diversiteit van formulering voorop staan. AI-systemen belonen specifieke, gedetailleerde taal en authentieke, evenwichtige feedback boven algemene lof.

Consistentie is belangrijker dan volume. Zorg voor een gestage, doorlopende stroom van beoordelingen in plaats van piekcampagnes die voor AI-systemen kunstmatig lijken. Regelmatige beoordelingen signaleren blijvende relevantie en klanttevredenheid, wat AI-systemen herkennen als sterkere vertrouwenssignalen.

Niet per se. Gemengde beoordelingen met zowel positieve als negatieve feedback signaleren vaak authenticiteit aan AI-systemen. Een gemiddelde van 4,5 sterren komt vaak betrouwbaarder over dan een perfecte 5,0-score. Wat telt is hoe je op kritiek reageert—doordachte reacties creëren verantwoordingssporen die AI-systemen waarderen.

Verspreiding over meerdere platforms is cruciaal. Google, Trustpilot, Amazon, G2 en branchespecifieke beoordelingssites dragen allemaal bij aan jouw AI-zichtbaarheid. Platformoverstijgende consistentie signaleert authenticiteit aan AI-systemen, terwijl een gefragmenteerd of inconsistent beoordelingsprofiel als verdacht kan worden gemarkeerd.

Volg hoe AI-systemen jouw merk noemen en aanbevelen via ChatGPT, Perplexity, Google AI Overviews en meer met AmICited's AI-citatiemonitoringplatform.

Leer hoe je reviews beheert voor maximale AI-zichtbaarheid. Ontdek het belang van authenticiteit, semantische diversiteit en strategische distributie voor LLM-c...

Ontdek hoe authentieke klantgetuigenissen je AI-zichtbaarheid vergroten binnen Google AI Overviews, ChatGPT en Perplexity. Leer waarom echte klantstemmen belang...

Ontdek hoe Trustpilot's 300+ miljoen reviews AI-aanbevelingen, LLM-training en consumentenvertrouwen beïnvloeden. Leer meer over AI-fraudedetectie, optimalisati...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.