Hoe zorg je dat AI-crawlers al je content zien

Ontdek hoe je je content zichtbaar maakt voor AI-crawlers zoals ChatGPT, Perplexity en Google's AI. Leer technische vereisten, best practices en monitoringstrat...

Ontdek hoe SSR- en CSR-renderingstrategieën de zichtbaarheid voor AI-crawlers, merkvermeldingen in ChatGPT en Perplexity, en je algehele AI-zoekaanwezigheid beïnvloeden.

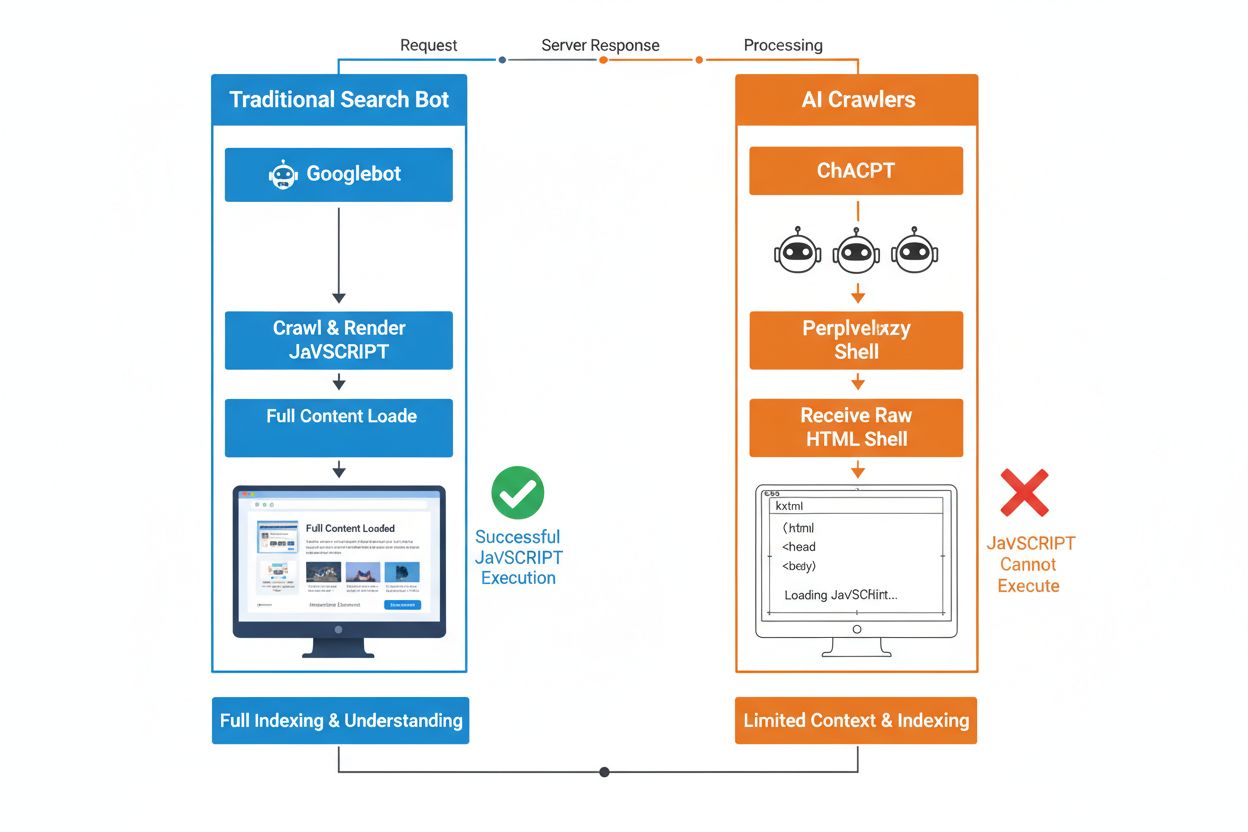

Het fundamentele verschil tussen traditionele zoekbots en AI-crawlers zit in hun benadering van JavaScript-uitvoering. Waar Googlebot en andere traditionele zoekmachines JavaScript kunnen renderen (zij het met resourcebeperkingen), voeren AI-crawlers zoals GPTBot, ChatGPT-User en OAI-SearchBot helemaal geen JavaScript uit—ze zien alleen de ruwe HTML die bij het eerste paginabezoek wordt geleverd. Dit cruciale onderscheid betekent dat als de inhoud van je website afhankelijk is van client-side JavaScript om te renderen, AI-systemen een onvolledige of lege weergave van je pagina’s ontvangen, waarbij productdetails, prijsinformatie, reviews en andere dynamische inhoud die gebruikers in hun browser zien, ontbreken. Dit verschil begrijpen is essentieel omdat AI-gestuurde zoekresultaten snel een primair kanaal worden voor gebruikers die informatie zoeken.

Server-Side Rendering (SSR) verbetert AI-zichtbaarheid fundamenteel door volledig gerenderde HTML direct vanaf de server bij het eerste verzoek te leveren, waardoor AI-crawlers geen JavaScript hoeven uit te voeren. Met SSR is alle kritieke inhoud—koppen, hoofdtekst, productinformatie, metadata en gestructureerde data—aanwezig in de HTML die bots ontvangen, zodat deze direct beschikbaar is voor opname in AI-trainingscorpora en retrieval-indexen. Deze aanpak zorgt voor consistente inhoudslevering voor alle crawlers, snellere indexeersnelheden en volledige metadatasetzichtbaarheid waar AI-systemen op vertrouwen om je inhoud correct te begrijpen en te citeren. De volgende tabel laat zien hoe verschillende renderstrategieën de zichtbaarheid voor AI-crawlers beïnvloeden:

| Rendering Type | Wat AI-crawlers zien | Indexeersnelheid | Inhoudsvolledigheid | Metadata-zichtbaarheid |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | Volledig gerenderde HTML met alle inhoud | Snel (direct) | Compleet | Uitstekend |

| Client-Side Rendering (CSR) | Minimale HTML-shell, mist dynamische inhoud | Traag (indien überhaupt gerenderd) | Onvolledig | Slecht |

| Static Site Generation (SSG) | Vooraf gebouwde, gecachte HTML | Zeer snel | Compleet | Uitstekend |

| Hybride/Incrementieel | Mix van statische en dynamische routes | Gemiddeld tot snel | Goed (indien kritieke pagina’s pre-rendered) | Goed |

Client-Side Rendering (CSR) levert aanzienlijke uitdagingen op voor AI-zichtbaarheid omdat het crawlers dwingt te wachten op JavaScript-uitvoering—iets wat AI-bots simpelweg niet doen vanwege resourcebeperkingen en strakke time-outs. Wanneer een site op basis van CSR laadt, bevat de initiële HTML-respons alleen een minimale shell met laadspinners en placeholder-elementen, terwijl de echte inhoud asynchroon via JavaScript wordt geladen. AI-crawlers hanteren strikte time-outs van 1-5 seconden en voeren geen scripts uit, wat betekent dat ze een lege of vrijwel lege momentopname van de pagina maken die productbeschrijvingen, prijzen, beoordelingen en andere kritieke informatie mist. Dit veroorzaakt een sneeuwbaleffect: onvolledige inhoudsmomentopnamen leiden tot slechte chunking en embedding-kwaliteit, waardoor de kans kleiner wordt dat je pagina’s worden geselecteerd voor opname in AI-gegenereerde antwoorden. Voor e-commerce sites, SaaS-platforms en contentrijke applicaties die op CSR vertrouwen, vertaalt dit zich direct naar verlies van zichtbaarheid in AI Overviews, ChatGPT-antwoorden en Perplexity-resultaten—de kanalen die juist zorgen voor ontdekking in het AI-tijdperk.

De technische reden dat AI-bots geen JavaScript kunnen uitvoeren, komt voort uit fundamentele schaalbaarheids- en resourcebeperkingen in hun architectuur. AI-crawlers geven prioriteit aan snelheid en efficiëntie boven volledigheid, opererend onder strikte time-outs omdat ze miljarden pagina’s moeten verwerken om taalmodellen te trainen en bij te werken. Het uitvoeren van JavaScript vereist het opstarten van headless browsers, toewijzen van geheugen en wachten op asynchrone processen—luxe die niet schaalbaar is bij het crawlen op het volume dat nodig is voor LLM-training. In plaats daarvan richten AI-systemen zich op het extraheren van schone, semantisch gestructureerde HTML die direct beschikbaar is en beschouwen ze statische inhoud als de canonieke versie van je site. Deze ontwerpkeuze weerspiegelt een fundamentele waarheid: AI-systemen zijn geoptimaliseerd voor statische HTML-levering, niet voor het renderen van complexe JavaScript-frameworks zoals React, Vue of Angular.

De impact op AI-gegenereerde antwoorden en merkzichtbaarheid is diepgaand en heeft direct gevolgen voor je bedrijfsresultaten. Wanneer AI-crawlers je inhoud niet kunnen bereiken vanwege JavaScript-rendering, wordt je merk onzichtbaar in AI Overviews, ontbreekt het in vermeldingen en is het afwezig in door LLM aangedreven zoekresultaten—zelfs als je goed scoort in traditionele Google-zoekresultaten. Voor e-commerce betekent dit dat productdetails, prijzen en beschikbaarheidsinformatie nooit AI-systemen bereiken, wat leidt tot onvolledige of onnauwkeurige productaanbevelingen en gemiste verkoopkansen. SaaS-bedrijven verliezen zichtbaarheid voor featurevergelijkingen en prijspagina’s die anders gekwalificeerde leads zouden opleveren via AI-ondersteunde onderzoekstools. Nieuws- en contentwebsites zien hun artikelen uitgesloten worden van AI-samenvattingen, wat leidt tot minder verwijzingsverkeer van platforms als ChatGPT en Perplexity. Het verschil tussen wat mensen zien en wat AI-systemen zien, creëert een tweelaags zichtbaarheidsprobleem: je site lijkt gezond in traditionele SEO-metrics, maar wordt tegelijkertijd onzichtbaar voor het snelst groeiende ontdekkingkanaal.

Pre-rendering en hybride oplossingen bieden praktische manieren om de voordelen van beide renderingbenaderingen te combineren zonder een volledige architecturale revisie. In plaats van te kiezen tussen de interactiviteit van CSR en de crawlbaarheid van SSR, worden tegenwoordig strategische combinaties ingezet voor verschillende doeleinden:

Deze benaderingen stellen je in staat rijke, interactieve gebruikerservaringen te behouden en tegelijkertijd te zorgen dat AI-crawlers volledige, volledig gerenderde HTML ontvangen. Frameworks zoals Next.js, Nuxt en SvelteKit maken hybride rendering toegankelijk zonder uitgebreide maatwerkontwikkeling. De sleutel is om te identificeren welke pagina’s acquisitie, omzet of supportafhandeling stimuleren—deze kritieke pagina’s moeten altijd pre-rendered of server-rendered zijn om AI-zichtbaarheid te garanderen.

Renderingstrategie bepaalt direct hoe AI-systemen je merk refereren en vermelden, waardoor het essentieel is je zichtbaarheid op AI-platforms te monitoren. Tools als AmICited.com volgen hoe AI-systemen je merk vermelden in ChatGPT, Perplexity, Google AI Overviews en andere LLM-platforms, en laten zien of je inhoud deze systemen daadwerkelijk bereikt. Wanneer je site CSR gebruikt zonder pre-rendering, laat AmICited-data vaak een duidelijk verschil zien: je kunt goed scoren in traditionele zoekresultaten, maar geen enkele vermelding krijgen in AI-gegenereerde antwoorden. Deze monitoring onthult de werkelijke kosten van JavaScript-rendering—niet alleen qua crawlefficiëntie, maar ook in gemiste merkzichtbaarheid en citatiekansen. Door SSR of pre-rendering te implementeren en vervolgens de resultaten via AmICited te volgen, kun je het directe effect van renderingbeslissingen op AI-zichtbaarheid kwantificeren, waardoor het eenvoudiger wordt om investeringen in engineering te rechtvaardigen bij belanghebbenden die zich richten op verkeer en conversies.

Het auditen en optimaliseren van je renderingstrategie voor AI-zichtbaarheid vereist een systematische, stapsgewijze aanpak. Begin met het identificeren van pagina’s die het meest waardevol zijn: productpagina’s, prijspagina’s, kern-documentatie en veelbezochte blogposts zijn de prioriteit. Gebruik tools zoals Screaming Frog (in “alleen tekst”-modus) of Chrome DevTools om te vergelijken wat bots zien versus wat gebruikers zien—als kritieke inhoud ontbreekt in de paginabron, is deze afhankelijk van JavaScript en onzichtbaar voor AI-crawlers. Kies vervolgens je renderingstrategie op basis van de vereiste contentversheid: statische pagina’s kunnen SSG gebruiken, vaak bijgewerkte inhoud profiteert van SSR of ISR, en interactieve functies kunnen met JavaScript bovenop server-gerenderde HTML worden toegevoegd. Test vervolgens met echte AI-bots door je pagina’s te sturen naar ChatGPT, Perplexity en Claude om te verifiëren dat ze je inhoud kunnen bereiken. Controleer tenslotte de crawllogs op AI user-agents (GPTBot, ChatGPT-User, OAI-SearchBot) om te bevestigen dat deze bots je pre-rendered of server-rendered pagina’s succesvol crawlen. Deze iteratieve aanpak verandert rendering van een technisch detail in een meetbare zichtbaarheidshefboom.

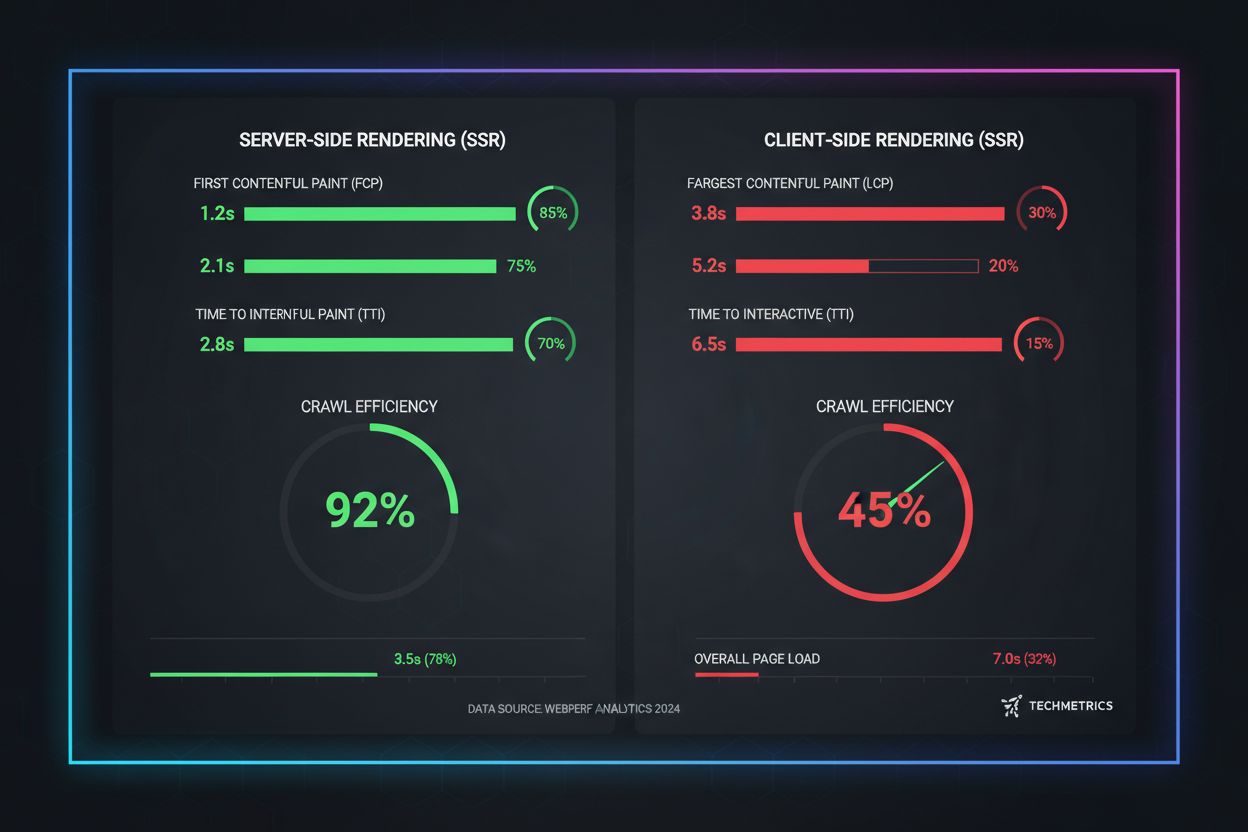

Praktijkmetingen laten het grote verschil tussen renderingbenaderingen zien als het gaat om AI-crawlbaarheid. SSR- en pre-rendered pagina’s behalen First Contentful Paint (FCP) in 0,5-1,5 seconden, terwijl CSR-sites vaak 2-4 seconden of meer nodig hebben voordat JavaScript is gedownload en uitgevoerd. Voor AI-crawlers met 1-5 seconden time-outs betekent dit het verschil tussen volledige zichtbaarheid en totale onzichtbaarheid. Crawlefficiëntie verbetert drastisch met SSR: een pre-rendered e-commerce site kan binnen enkele uren volledig worden gecrawld en geïndexeerd, terwijl een CSR-equivalent weken kan duren omdat crawlers moeite hebben met JavaScript-rendering. Indexeersnelheid is even indrukwekkend—SSR-sites zien nieuwe inhoud binnen 24-48 uur geïndexeerd, terwijl CSR-sites vaak 7-14 dagen vertraging ervaren. Voor tijdgevoelige inhoud zoals nieuwsartikelen, productlanceringen of tijdelijke aanbiedingen vertaalt deze vertraging zich direct in verloren zichtbaarheid tijdens het kritieke moment waarop gebruikers actief zoeken.

De toekomst van SEO is onlosmakelijk verbonden met AI-zoekzichtbaarheid, waardoor renderingstrategie een cruciale langetermijninvestering is in plaats van een technische bijzaak. AI-gestuurde zoekopdrachten groeien exponentieel—13,14% van alle Google-zoekresultaten activeert nu AI Overviews en platforms zoals ChatGPT krijgen meer dan vier miljard bezoeken per maand, met Perplexity en Claude die snel terrein winnen. Naarmate AI-systemen het primaire ontdekkingkanaal worden voor meer gebruikers, bepalen de renderingbeslissingen die je vandaag neemt je zichtbaarheid van morgen. Continue monitoring is essentieel omdat AI-crawlergedrag, time-outdrempels en JavaScript-ondersteuning evolueren naarmate deze systemen volwassen worden. Teams die rendering als een eenmalige migratie beschouwen, merken vaak dat ze binnen enkele maanden weer onzichtbaar zijn na veranderingen in crawlstrategieën van AI-platforms. Maak renderoptimalisatie daarom onderdeel van je kwartaalplanningscyclus, neem AI-zichtbaarheidscontroles op in je regressietesten en gebruik tools als AmICited om te volgen of je merk zichtbaar blijft terwijl het AI-landschap verschuift. De merken die winnen in AI-zoekopdrachten zijn diegenen die renderstrategie zien als een kernconcurrentievoordeel, niet als een technische schuld voor later.

AI-crawlers zoals GPTBot en ChatGPT-User werken onder strikte resourcebeperkingen en korte time-outs (1-5 seconden) omdat ze miljarden pagina's moeten verwerken om taalmodellen te trainen. Het uitvoeren van JavaScript vereist het opstarten van headless browsers en wachten op asynchrone operaties—luxe die niet op schaal werkt voor LLM-training. In plaats daarvan richten AI-systemen zich op het extraheren van schone, statische HTML die direct beschikbaar is.

Server-Side Rendering levert volledig gerenderde HTML bij het eerste verzoek, waardoor alle inhoud direct toegankelijk is voor AI-crawlers zonder JavaScript-uitvoering. Dit zorgt ervoor dat je productdetails, prijzen, beoordelingen en metadata betrouwbaar AI-systemen bereiken, waardoor de kans toeneemt dat je merk wordt vermeld in AI-gegenereerde antwoorden en verschijnt in AI Overviews.

Server-Side Rendering (SSR) rendert pagina's on-demand wanneer een verzoek binnenkomt, terwijl pre-rendering statische HTML-bestanden genereert tijdens de build. Pre-rendering werkt het beste voor inhoud die niet vaak verandert, terwijl SSR beter is voor dynamische inhoud die regelmatig wordt bijgewerkt. Beide benaderingen zorgen ervoor dat AI-crawlers volledige HTML ontvangen zonder JavaScript-uitvoering.

Ja, maar met aanzienlijke beperkingen. Je kunt pre-renderingtools gebruiken om statische HTML-snapshots van je CSR-pagina's te genereren, of hybride rendering implementeren waarbij kritieke pagina's server-gerenderd zijn en minder belangrijke pagina's client-gerenderd blijven. Zonder deze optimalisaties zijn CSR-sites echter grotendeels onzichtbaar voor AI-crawlers.

Gebruik tools zoals Screaming Frog (alleen-tekstmodus), Chrome DevTools of Google Search Console om te vergelijken wat bots zien versus wat gebruikers zien. Als kritieke inhoud ontbreekt in de paginabron, is deze afhankelijk van JavaScript en onzichtbaar voor AI-crawlers. Je kunt ook direct testen met ChatGPT, Perplexity en Claude om te controleren of ze toegang hebben tot je inhoud.

SSR- en pre-rendered pagina's behalen doorgaans First Contentful Paint (FCP) in 0,5-1,5 seconden, terwijl CSR-sites vaak 2-4+ seconden nodig hebben. Omdat AI-crawlers werken met 1-5 seconden time-outs, vertaalt snellere rendering zich direct naar betere AI-crawlbaarheid. Verbeterde Core Web Vitals zijn ook gunstig voor de gebruikerservaring en traditionele SEO-rankings.

AmICited monitort hoe AI-systemen je merk vermelden via ChatGPT, Perplexity en Google AI Overviews. Door je AI-zichtbaarheid te volgen vóór en na de implementatie van SSR of pre-rendering, kun je het directe effect van renderingbeslissingen op merkvermeldingen en AI-zoekaanwezigheid meten.

Dat hangt af van je eisen voor contentverversing en bedrijfsprioriteiten. Statische inhoud profiteert van SSG, vaak bijgewerkte inhoud van SSR, en interactieve functies kunnen met JavaScript bovenop server-gerenderde HTML worden toegevoegd. Begin met het identificeren van waardevolle pagina's (productpagina's, prijzen, documentatie) en geef deze prioriteit voor SSR of pre-rendering.

Monitor hoe ChatGPT, Perplexity en Google AI Overviews je merk vermelden. Begrijp het echte effect van je renderingstrategie op AI-vermeldingen.

Ontdek hoe je je content zichtbaar maakt voor AI-crawlers zoals ChatGPT, Perplexity en Google's AI. Leer technische vereisten, best practices en monitoringstrat...

Compleet naslagwerk over AI crawlers en bots. Identificeer GPTBot, ClaudeBot, Google-Extended en meer dan 20 andere AI-crawlers met user agents, crawl rates en ...

Leer hoe JavaScript-rendering de zichtbaarheid in AI beïnvloedt. Ontdek waarom AI-crawlers geen JavaScript kunnen uitvoeren, welke content verborgen blijft en h...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.