Auteursvermeldingen en AI: Verbetert auteurschap het aantal citaties?

Ontdek hoe auteursvermeldingen AI-citaties beïnvloeden. Leer waarom genoemd auteurschap 1,9x meer citaties ontvangt van ChatGPT en Perplexity, en hoe je bylines...

Ontdek hoe eigen enquêtegegevens en originele statistieken ware citatiemagneten worden voor LLM’s. Ontdek strategieën om AI-zichtbaarheid te vergroten en meer citaties te verdienen van ChatGPT, Perplexity en Google AI Overviews.

Grote taalmodellen verzinnen geen data—ze halen deze uit verifieerbare bronnen. Wanneer jouw team unieke statistieken of originele methodieken publiceert, bezit je tijdelijk die kennis, wat LLM’s een reden geeft om jou te citeren om hun antwoorden te onderbouwen. Dit is de basis van wat IDX de “Authority Flywheel” noemt: een systeem waarin eigen onderzoek jouw krachtigste citatiemagneet wordt.

De werking is eenvoudig: AI-modellen beoordelen bronnen op basis van de mogelijkheid claims via meerdere kanalen te verifiëren. Als je origineel onderzoek publiceert, creëer je een kennisasset die nergens anders op het web bestaat. Deze uniekheid dwingt LLM’s om jouw bron te citeren als ze die data in hun antwoorden willen opnemen. Een campagne voor The Zebra, een verzekeringsplatform, laat dit principe perfect zien—de combinatie van eigen onderzoek met Digital PR leverde meer dan 1.580 hoogwaardige medialinks op en zorgde voor een stijging van 354% in organisch verkeer.

Uit recent onderzoek blijkt dat 48,6% van de SEO-experts Digital PR als de meest effectieve linkbuilding-tactiek voor 2025 identificeert. Maar de echte kracht zit in wat er daarna gebeurt: wanneer jouw eigen data via Digital PR verspreid wordt over uiteenlopende, hoogwaardige domeinen, bevestigt dat je autoriteit binnen meerdere kennisnetwerken tegelijk. Deze validatie via meerdere kanalen is precies waar LLM’s op letten bij de beslissing om jouw merk te citeren.

Het belangrijkste inzicht: eigen data creëert wat onderzoekers “tijdelijk kennisbezit” noemen. In tegenstelling tot generieke content die concurreert met duizenden soortgelijke artikelen, is jouw originele onderzoek de enige bron voor die specifieke data. Dit schaarsteprincipe maakt LLM’s eerder geneigd jou te citeren, omdat dat de enige manier is om die informatie in hun antwoorden op te nemen.

Begrijpen hoe LLM’s daadwerkelijk bronnen ophalen en selecteren, is cruciaal voor meer citaties. Deze systemen werken niet als traditionele zoekmachines. Ze opereren via twee aparte kenniskanalen: parametrisch geheugen (kennis opgeslagen bij training) en opgehaalde kennis (real-time informatie via Retrieval-Augmented Generation, oftewel RAG).

Parametrische kennis omvat alles wat een LLM “weet” uit de pre-training. Deze kennis is statisch en vastgelegd tot aan de trainingscutoff van het model. Ongeveer 60% van de ChatGPT-vragen wordt beantwoord puur vanuit parametrische kennis zonder websearch. Entiteiten die vaak genoemd worden in gezaghebbende bronnen tijdens de training, krijgen sterkere neurale representaties en worden sneller opgeroepen. Wikipedia vormt zo’n 22% van de trainingsdata van grote LLM’s, wat verklaart waarom Wikipedia-citaties vaak voorkomen in AI-antwoorden.

Opgehaalde kennis werkt anders. Wanneer een LLM actuele informatie nodig heeft, gebruikt het RAG-systemen die semantisch zoeken (dichte vectoren) combineren met keyword matching (BM25) via Reciprocal Rank Fusion. Onderzoek laat zien dat hybride retrieval 48% verbetering oplevert ten opzichte van enkele methoden. Hierna worden de resultaten gerangschikt met cross-encoder-modellen voordat de 5-10 beste stukken in de prompt van de LLM als context worden ingevoegd.

| Signaal | Prioriteit Traditionele SEO | Prioriteit LLM-citatie | Waarom Relevant |

|---|---|---|---|

| Domeinautoriteit | Hoog (kernrankingfactor) | Zwak/Neutraal | LLM’s prioriteren contentstructuur boven domeinkracht |

| Backlink-aantal | Hoog (primaire signaal) | Zwak/Neutraal | LLM’s beoordelen bron-credibiliteit anders |

| Contentstructuur | Gemiddeld | Cruciaal | Duidelijke headings en antwoordblokken essentieel voor extractie |

| Eigen Data | Laag | Zeer Hoog | Unieke informatie dwingt tot citatie |

| Merkzoekvolume | Laag | Hoogst (0,334 correlatie) | Geeft echte autoriteit en vraag aan |

| Actualiteit | Gemiddeld | Hoog | LLM’s verkiezen recent bijgewerkte content |

| E-E-A-T-signalen | Gemiddeld | Hoog | Auteursgegevens en transparantie tellen mee |

Het cruciale verschil: LLM’s ranken geen pagina’s—ze halen semantische stukken eruit. Een pagina met matige SEO-metrics maar haarscherpe structuur en eigen data kan beter presteren dan een autoritaire pagina met vage positionering. Deze fundamentele verschuiving betekent dat je citatiestrategie machineleesbaarheid en contenthelderheid boven traditionele linkbuilding moet stellen.

De metrics die tellen voor AI-zichtbaarheid zijn fundamenteel verschoven van traditionele SEO-signalen. Twintig jaar lang bepaalden domeinautoriteit, backlinks en keyword-rankings het succes. In 2025 zijn deze metrics vrijwel irrelevant voor LLM-citaties. In plaats daarvan is er een nieuwe hiërarchie ontstaan gebaseerd op hoe AI-systemen bronnen daadwerkelijk evalueren en selecteren.

Merkzoekvolume is nu de sterkste voorspeller van LLM-citaties, met een correlatiecoëfficiënt van 0,334—aanzienlijk hoger dan welke traditionele SEO-metric dan ook. Logisch ook: als miljoenen mensen op jouw merknaam zoeken, duidt dat op echte autoriteit en vraag. LLM’s herkennen dit signaal en wegen het zwaar bij de keuze om jou te citeren. Ondertussen tonen backlinks een zwakke of neutrale correlatie met AI-citaties, in tegenspraak met decennia aan SEO-wijsheid.

Die verschuiving geldt ook voor contentbeoordeling. Statistieken toevoegen aan je content verhoogt AI-zichtbaarheid met 22%. Citaten toevoegen verhoogt zichtbaarheid met 37%. Origineel onderzoek wordt 3x vaker geciteerd dan generieke content. Dit zijn geen marginale verbeteringen—ze vormen fundamentele veranderingen in hoe LLM’s bronkwaliteit beoordelen.

| Metric | Focus Vroeger (Pre-2024) | Focus Nieuw (2025+) | Impact op LLM-citaties |

|---|---|---|---|

| Kwaliteitsindicator Link | Domeinautoriteit Score (DA/DR) | Topical Relevantie & Redactionele Context | Gronding en brondiversiteit |

| Ankertekststrategie | Exacte Match Keywords | Branded/Entiteit-vermeldingen | Entiteitsherkenning en consistentie |

| Contenttype | Gastblogs (Volume) | Origineel Onderzoek/Datajournalistiek | 3x hogere citatiekans |

| Doelmeting | Rankingpositie Stijging | Citatiepercentage in AI-overzichten | Vertrouwen en autoriteit |

| Outreach-aanpak | Links verwerven | Relaties opbouwen/Waarde leveren | Hogere redactionele kwaliteit |

Deze matrix onthult een belangrijk inzicht: de winnaars in AI-zichtbaarheid zijn niet per se de merken met de meeste backlinks of hoogste domeinautoriteit. Het zijn de merken die origineel onderzoek doen, consistente merksignalen onderhouden en content publiceren die gestructureerd is voor machine-extractie. Het voordeel is verschoven van linkhoeveelheid naar contentkwaliteit en uniekheid.

Eigen enquêtegegevens spelen een unieke rol in een AI-zichtbaarheidsstrategie. In tegenstelling tot generieke branche-rapporten die LLM’s uit meerdere bronnen kunnen halen, kunnen je eigen enquêtegegevens alleen vanaf jouw website geciteerd worden. Dit levert een citatievoordeel op dat concurrenten niet kunnen kopiëren, hoe sterk hun backlinkprofielen ook zijn.

Enquêtegegevens werken omdat ze bieden wat LLM’s “gronding” noemen—verifieerbaar bewijs dat claims onderbouwt. Als je stelt dat “78% van de marketingmanagers AI-zichtbaarheid prioriteert,” kan een LLM jouw enquête als bewijs citeren. Zonder die eigen data zou dezelfde claim speculatief zijn, en zou een LLM deze overslaan of het onderzoek van een concurrent citeren.

De meest effectieve enquêtegegevens beantwoorden specifieke vragen die jouw doelgroep stelt:

De impact is meetbaar. Onderzoek toont aan dat het toevoegen van statistieken de AI-zichtbaarheid met 22% verhoogt, terwijl citaten deze met 37% verhogen. Origineel onderzoek wordt 3x vaker geciteerd dan generieke content. Deze effecten versterken elkaar als je meerdere typen eigen data in één contentasset combineert.

Transparantie is essentieel. LLM’s beoordelen methodologie net zo streng als de bevindingen. Als je methodologie degelijk is, de steekproefomvang voldoende en de bevindingen eerlijk gepresenteerd (inclusief beperkingen), zullen LLM’s je vol vertrouwen citeren. Is de methodologie vaag of lijken bevindingen selectief, dan geven LLM’s de voorkeur aan transparantere concurrenten.

Het publiceren van eigen data is maar de helft van het werk. De andere helft is het structureren van die data zodat LLM’s deze makkelijk kunnen extraheren en citeren. Contentarchitectuur is net zo belangrijk als de data zelf.

Begin met directe antwoorden. LLM’s geven de voorkeur aan content die met het antwoord begint, niet met het verhaal eromheen. In plaats van “We hebben een enquête uitgevoerd naar marketingprioriteiten, en dit vonden we,” schrijf je “78% van de marketingmanagers prioriteert nu AI-zichtbaarheid in hun strategie voor 2025.” Deze directe structuur maakt extractie eenvoudiger en verhoogt de kans op citatie.

De optimale paragraaflengte voor LLM-extractie is 40-60 woorden. Deze lengte stelt LLM’s in staat een volledige gedachte op te halen zonder afbreking. Langere paragrafen worden opgeknipt, waardoor context verloren kan gaan. Korte paragrafen bevatten vaak niet genoeg informatie.

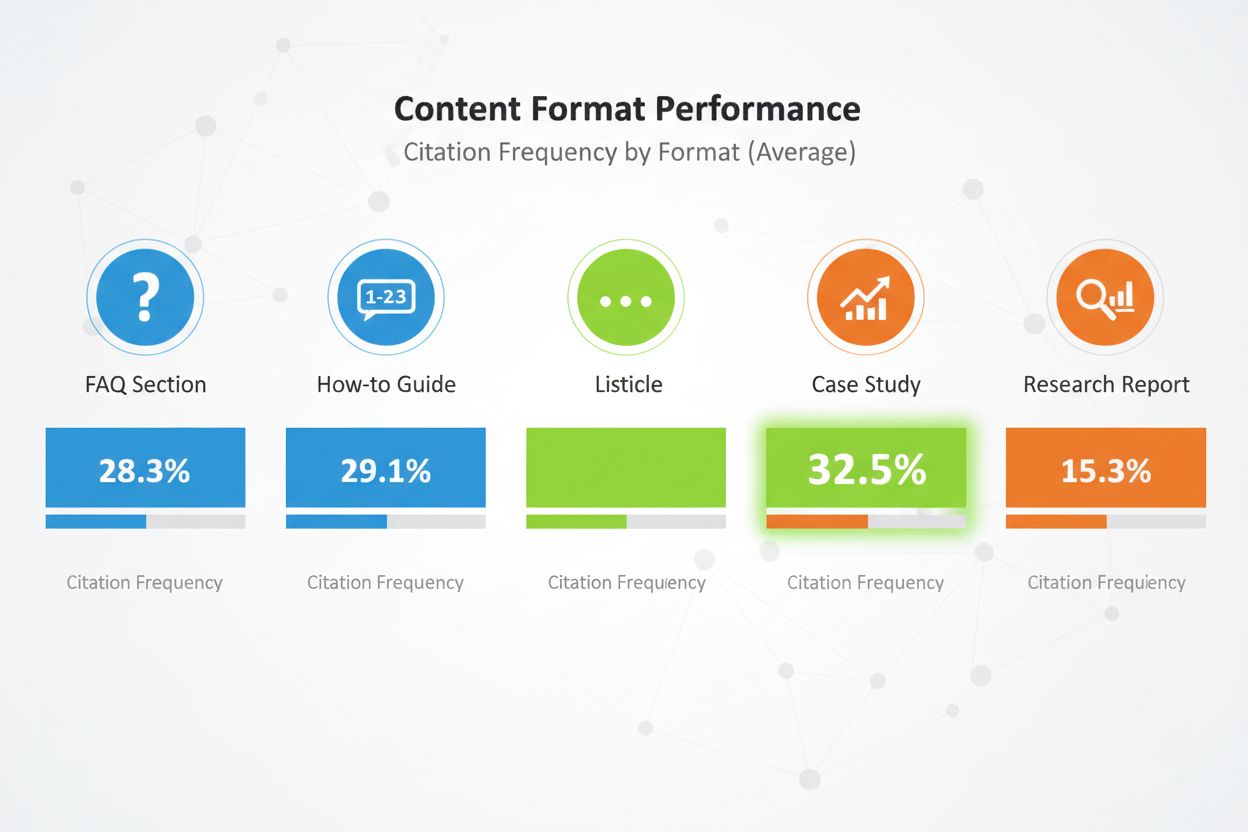

Contentformats zijn van groot belang. Vergelijkende lijstjes ontvangen 32,5% van alle AI-citaties—het hoogste percentage van alle formats. FAQ-secties presteren uitzonderlijk goed omdat ze aansluiten bij hoe gebruikers AI-systemen bevragen. How-to’s, casestudy’s en onderzoeksrapporten doen het ook goed, maar lijstjes scoren structureel het beste.

Structuur je content met een duidelijke heading-hiërarchie. Gebruik H2-koppen die lijken op veelgestelde zoekopdrachten. Gebruik onder elke H2 H3-koppen voor subonderwerpen. Deze hiërarchie helpt LLM’s je contentstructuur te begrijpen en relevante secties te extraheren.

Implementeer E-E-A-T-signalen door heel je content. Voeg auteursbio’s toe met relevante ervaring. Link naar externe validatie van je claims. Wees transparant over de methodologie. Verwijs naar je bronnen. Deze signalen laten LLM’s zien dat je content betrouwbaar en het citeren waard is.

Gebruik semantische HTML overal. Structureer data met echte <table>, <ul> en <ol>-tags in plaats van CSS-gestylede divs. Dit maakt je content makkelijker voor AI om te parsen en samen te vatten. Voeg schema-markup toe (Article, FAQPage, HowTo) om extra context over je contenttype te geven.

Werk je content tenslotte regelmatig bij. LLM’s verkiezen recentere content, zeker voor tijdgevoelige data. Is je enquête uit 2024, update hem dan in 2025. Voeg “Laatst bijgewerkt”-tijden toe om te laten zien dat je actief onderhoudt. Dit signaleert aan LLM’s dat je data actueel en betrouwbaar blijft.

Je eigen data op je website publiceren is noodzakelijk maar onvoldoende. LLM’s ontdekken content via meerdere kanalen, en je distributiestrategie bepaalt op hoeveel van die kanalen je data verschijnt.

Digital PR is het meest effectieve distributiekanaal voor eigen data. Verschijnt je onderzoek in branchemedia, nieuwswebsites en autoritaire blogs, dan ontstaan er meerdere citatiekansen. LLM’s indexeren deze externe vermeldingen en gebruiken deze om je originele bron te valideren. Een merk dat op 4+ platforms verschijnt, wordt 2,8x vaker geciteerd in ChatGPT-antwoorden dan merken met beperkte aanwezigheid.

Effectieve distributiekanalen zijn onder andere:

Iedere distributiekanaal heeft een functie. Persberichten zorgen voor initiële aandacht en media-aandacht. Vakpublicaties bieden geloofwaardigheid en bereiken beslissers. LinkedIn bereikt professionals op schaal. Reddit toont communityvertrouwen. Reviewplatforms bieden gestructureerde data die LLM’s makkelijk kunnen parsen.

Het multipliereffect is aanzienlijk. Verschijnt je eigen data op meerdere gezaghebbende bronnen, dan zien LLM’s consistente signalen over het web. Deze consistentie verhoogt het vertrouwen in je data en maakt citatie waarschijnlijker. Een enkele vermelding op je website kan genegeerd worden. Verschijnt diezelfde data op je website, in een persbericht, op een vakpublicatie én op een reviewplatform, dan valt deze niet te negeren.

Timing is ook belangrijk. Verspreid je eigen data strategisch. Publiceer eerst op je eigen site met een persbericht. Volg met plaatsingen in vakmedia. Versterk daarna via sociale kanalen en community-engagement. Deze gefaseerde aanpak creëert een aanhoudende zichtbaarheidsgolf in plaats van een korte piek.

Eigen data publiceren zonder de impact te meten is als adverteren zonder conversies te tracken. Je hebt inzicht nodig in of je data daadwerkelijk citaties oplevert en je AI-zichtbaarheid verbetert.

Begin met het volgen van citatiefrequentie. Bepaal 20-50 waardevolle koopvragen waarop jouw eigen data antwoord geeft. Onderzoek maandelijks grote AI-platforms (ChatGPT, Perplexity, Claude, Google AI Overviews) met deze vragen. Noteer of je merk verschijnt, op welke positie en of de citatie een link bevat naar je site.

Bereken je citatiefrequentie als percentage: (Prompts waarin je genoemd wordt) / (Totaal aantal prompts) × 100. Streef naar 30%+ citatiefrequentie voor je belangrijkste categorievragen. Topmerken in competitieve categorieën behalen 50%+ citatiefrequentie.

Meet AI Share of Voice (AI SOV) door identieke prompts te draaien en je percentage van alle merkvermeldingen te bepalen. Verschijn je in 3 van de 10 AI-antwoorden terwijl concurrenten elk 2 keer verschijnen, dan is je AI SOV 30%. In competitieve markten streef je naar een AI SOV die 10-20% boven je traditionele marktaandeel ligt.

Monitor sentimentanalyse. Kijk niet alleen of je genoemd wordt, maar ook of AI-systemen je merk positief, neutraal of negatief beschrijven. Gebruik tools zoals Profound AI die hallucinaties detecteren—wanneer AI onjuiste of verouderde informatie over je merk geeft. Streef naar 70%+ positief sentiment op AI-platforms.

Stel een Knowledge-Based Indicator (KBI)-dashboard in dat de volgende zaken bijhoudt:

Update deze metrics maandelijks. Kijk naar trends, niet naar losse meetpunten. Een maand lage citaties kan toeval zijn. Drie maanden dalende citaties duiden op een probleem dat onderzoek en actie vereist.

Handmatig citaties van eigen data bijhouden, is tijdrovend en foutgevoelig. AmICited.com biedt de infrastructuur om jouw AI-zichtbaarheid op schaal te monitoren, speciaal voor merken die eigen data inzetten als citatiestrategie.

Het platform monitort hoe AI-systemen je eigen onderzoek citeren op ChatGPT, Perplexity, Google AI Overviews, Claude, Gemini en opkomende AI-platforms. In plaats van maandelijks handmatig elke platform te bevragen, automatiseert AmICited dit proces, draait continu je doelprompts en volgt citatiepatronen realtime.

Belangrijke functies zijn onder andere:

Het platform integreert met je bestaande analytics-stack en voedt AI-citatiedata in je marketingdashboards naast traditionele SEO-metrics. Dit gecombineerde inzicht laat je de volledige impact van je eigen datastrategie op merkzichtbaarheid en pipeline zien.

Voor merken die serieus werk maken van AI-zichtbaarheid biedt AmICited de meetinfrastructuur die optimalisatie mogelijk maakt. Je kunt niet verbeteren wat je niet meet, en traditionele analysetools zijn nooit ontworpen om LLM-citaties te volgen. AmICited vult dat gat, zodat je het maximale rendement uit je eigen data-investeringen haalt.

Zelfs goedbedoelde eigen datastrategieën falen vaak door te voorkomen fouten. Kennis van deze valkuilen helpt ze te vermijden.

De meest gemaakte fout is data verstoppen achter “Contact Sales”-formulieren. LLM’s kunnen geen afgesloten content bereiken, dus vertrouwen ze op onvolledige of speculatieve informatie uit fora. Zijn je enquêtebevindingen verborgen, dan citeren LLM’s een Reddit-discussie over je product in plaats van je officiële onderzoek. Publiceer belangrijke bevindingen openbaar met transparante methodologie. Je kunt gedetailleerde rapporten afsluiten, zolang samenvattingen en inzichten openbaar blijven.

Inconsistente terminologie over platforms zorgt voor verwarring. Noemt je website je product een “marketing automation platform” en je LinkedIn-profiel het “CRM-software,” dan kunnen LLM’s je bedrijf moeilijk duiden. Gebruik overal consistente categorietaal. Definieer je terminologiemap en pas deze consequent toe op je website, LinkedIn, Crunchbase en andere profielen.

Ontbrekende auteursgegevens ondermijnen vertrouwen. LLM’s beoordelen E-E-A-T-signalen streng. Mist je enquête auteursbio’s met echte ervaring, dan wordt deze minder geciteerd. Voeg uitgebreide auteursbio’s toe met relevante ervaring, certificeringen en eerdere publicaties. Link naar auteursprofielen op LinkedIn en elders.

Verouderde statistieken schaden je geloofwaardigheid. Is je enquête uit 2023 maar citeer je die nog in 2025, dan valt dat op bij LLM’s. Werk je onderzoek regelmatig bij. Voeg “Laatst bijgewerkt”-tijden toe. Doe jaarlijks een nieuwe enquête om actueel te blijven. LLM’s geven de voorkeur aan recente data, zeker bij actuele onderwerpen.

Vage methodologie verkleint de kans op citatie. Als je methodologie niet transparant is, stellen LLM’s je bevindingen ter discussie. Publiceer je methodologie openlijk. Leg steekproefomvang, steekproefmethode, onderzoeksperiode en beperkingen uit. Transparantie wekt vertrouwen.

Keyword stuffing in je eigen datacontent werkt slechter in AI-systemen dan in traditionele zoekmachines. LLM’s detecteren en bestraffen kunstmatige taal. Schrijf natuurlijk. Focus op helderheid en nauwkeurigheid, niet op keyworddichtheid. Eigen data moet lezen als echt onderzoek, niet als marketingtekst.

Dunne content rondom je eigen data wordt actief afgestraft. Met één alinea over je enquêtebevindingen kom je er niet. Schrijf uitgebreide content die gevolgen onderzoekt, context biedt en vervolgvragen beantwoordt. Streef naar 2.000+ woorden substantieve content per grote data-asset.

Praktijkvoorbeelden laten de kracht van eigen data voor AI-zichtbaarheid zien. Deze merken investeerden in origineel onderzoek en zagen meetbare resultaten.

The Zebra’s Digital PR-succes: The Zebra, een verzekeringsvergelijkingsplatform, combineerde eigen onderzoek met Digital PR en genereerde 1.580+ hoogwaardige medialinks en 354% meer organisch verkeer. Door originele onderzoeksdata over verzekeringen te publiceren en via earned media te verspreiden, werd The Zebra dé bron voor verzekeringsdata. LLM’s citeren nu The Zebra’s onderzoek bij vragen over verzekeringstrends en -prijzen.

Tally’s communitystrategie: Tally, een online formulierenbouwer, verbeterde haar AI-zichtbaarheid door actief deel te nemen aan communityfora en de productroadmap te delen. In plaats van alleen onderzoek te publiceren werd Tally een vertrouwde stem in gebruikersgemeenschappen. Deze authentieke betrokkenheid maakte ChatGPT tot een topverwijzer, wat leidde tot een sterke toename in wekelijkse aanmeldingen. Door GPT-4 te voeden met zorgvuldig samengestelde, contextspecifieke bewijzen steeg de feitelijke nauwkeurigheid van 56% naar 89%.

HubSpot’s doorlopend onderzoeksprogramma: HubSpot publiceert regelmatig onderzoeksrapporten over marketingtrends, sales-effectiviteit en klantservicetrends. Deze rapporten zijn dé standaard geworden die LLM’s vaak citeren. HubSpot’s commitment aan doorlopend onderzoek maakt het merk synoniem aan marketingdata en -inzicht. Bij AI-antwoorden over marketingtrends verschijnt HubSpot consequent.

Deze casestudy’s delen gemeenschappelijke kenmerken: origineel onderzoek, transparante methodologie, consistente distributie en doorlopende updates. Geen van deze merken vertrouwt op één onderzoeksproject. Ze bouwen onderzoeksprogramma’s die continu nieuwe data genereren en zo een blijvend citatievoordeel creëren.

De les is duidelijk: eigen data is geen eenmalige tactiek. Het is een strategische investering in het worden van de autoriteit in jouw categorie. Merken die kiezen voor regelmatig onderzoek, transparante methodologie en strategische distributie, verdienen structureel citaties van LLM’s en bouwen blijvende concurrentievoordelen in AI-zichtbaarheid op.

Je hebt geen enorme datasets nodig. Zelfs een gerichte enquête onder 100-500 respondenten kan waardevolle, eigen inzichten bieden die LLM's zullen citeren. Het belangrijkste is dat de data origineel is, de methodologie transparant en de bevindingen bruikbaar. Kwaliteit en uniekheid zijn belangrijker dan kwantiteit.

Klanttevredenheidsonderzoeken, onderzoek naar branchetrends, concurrentieanalyses, studies naar gebruikersgedrag en marktomvangonderzoek presteren allemaal goed. De beste data geven antwoord op specifieke vragen van je doelgroep en bieden inzichten die concurrenten niet hebben.

Realtime platforms zoals Perplexity kunnen nieuwe data binnen enkele weken citeren. ChatGPT en andere modellen met minder frequente updates doen er meestal 2-3 maanden over. Consistente, kwalitatief hoogwaardige eigen data laat doorgaans meetbare citatiestijgingen zien binnen 3-6 maanden.

Nee. LLM's kunnen geen afgesloten content benaderen, dus zullen ze in plaats daarvan vertrouwen op onvolledige of speculatieve informatie uit fora. Publiceer belangrijke bevindingen openbaar met een transparante methodologie. Je kunt gedetailleerde rapporten afschermen, zolang samenvattende data en inzichten openbaar beschikbaar blijven.

Gebruik duidelijke, consistente terminologie op alle platforms. Neem een transparante methodologie op in je onderzoek. Voeg auteursgegevens en certificeringen toe. Link naar externe validatie. Gebruik schema-markup om je data te structureren. Monitor citaties maandelijks en corrigeer snel onjuistheden.

Ja. Origineel onderzoek verdient doorgaans backlinks en media-aandacht, wat de traditionele rankings verbetert. Daarnaast zorgt eigen data voor content die completer en gezaghebbender is, wat helpt bij zowel traditionele SEO als AI-zichtbaarheid.

Eigen data is origineel onderzoek dat je zelf uitvoert. Generieke rapporten zijn breed beschikbaar. LLM's geven de voorkeur aan eigen data omdat het uniek is en alleen vanaf jouw bron geciteerd kan worden. Dit creëert een citatievoordeel dat concurrenten niet makkelijk kunnen repliceren.

Volg citatiefrequentie, AI Share of Voice, merkzoekvolume en verkeer vanuit AI-platforms. Vergelijk deze statistieken vóór en na publicatie van eigen data. Bereken de waarde van AI-verwezen verkeer (doorgaans 4,4x hogere conversieratio dan traditioneel organisch) om het rendement te bepalen.

Monitor hoe AI-systemen jouw eigen data citeren in ChatGPT, Perplexity, Google AI Overviews en meer. Krijg realtime inzichten in je AI-zichtbaarheid en concurrentiepositie.

Ontdek hoe auteursvermeldingen AI-citaties beïnvloeden. Leer waarom genoemd auteurschap 1,9x meer citaties ontvangt van ChatGPT en Perplexity, en hoe je bylines...

Leer hoe je origineel onderzoek en data-gedreven PR-content creëert die actief door AI-systemen wordt geciteerd. Ontdek de 5 eigenschappen van citeerwaardige co...

Ontdek bewezen strategieën om autoriteit op te bouwen en de zichtbaarheid van je merk te vergroten in AI-gegenereerde antwoorden van ChatGPT, Perplexity en ande...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.