AI-Zichtbaarheid van Overheidswebsites: Optimalisatie van de Publieke Sector

Ontdek hoe overheidsinstanties hun digitale aanwezigheid kunnen optimaliseren voor AI-systemen zoals ChatGPT en Perplexity. Leer strategieën voor het verbeteren...

Leer essentiële AI-transparantie en beste praktijken voor openbaarmaking. Ontdek gedrags-, verbale en technische openbaarmakingsmethoden om vertrouwen op te bouwen en te voldoen aan veranderende AI-regelgeving.

AI-transparantie is een kritisch uitgangspunt geworden in een tijdperk waarin kunstmatige intelligentiesystemen alles beïnvloeden van contentcreatie tot wervingsbeslissingen en financiële aanbevelingen. Nu AI-gegenereerde content zich verspreidt over digitale platforms, ervaren organisaties steeds meer druk om te onthullen wanneer en hoe zij deze technologieën inzetten, niet alleen als juridische verplichting, maar als fundamentele voorwaarde om vertrouwen en geloofwaardigheid bij hun publiek te behouden. Vooral voor merken en contentmakers zijn de belangen groot, omdat consumenten steeds vaker willen weten of de informatie die zij ontvangen afkomstig is van menselijke expertise of algoritmische generatie. Zonder transparante openbaarmakingspraktijken riskeren organisaties het vertrouwen dat jarenlang is opgebouwd te ondermijnen, met mogelijke reputatieschade, regelgevende boetes en verlies van publieksvertrouwen tot gevolg. De relatie tussen transparantie en geloofwaardigheid is symbiotisch—organisaties die proactief hun AI-gebruik bekendmaken tonen integriteit en respect voor hun stakeholders, en profileren zich als eerlijke actoren in een steeds meer door AI gedreven wereld.

De opkomst van AI-gegenereerde content heeft een diepgaande vertrouwensparadox gecreëerd: doelgroepen hebben moeite om authentiek, door mensen gemaakt werk te onderscheiden van geavanceerde AI-alternatieven, terwijl transparantie over AI-gebruik per sector sterk verschilt. Deze verwarring ondermijnt het fundamentele contract tussen makers en publiek, waarbij het publiek verwacht te weten wat de ware oorsprong van de aangeboden content is. Wanneer AI-gegenereerde content zonder openbaarmaking wordt gepresenteerd, schendt dit deze impliciete afspraak, wat een “echt versus nep”-dichotomie creëert die verder gaat dan simpele authenticiteitsvragen—het raakt aan kwesties van misleiding, manipulatie en geïnformeerde toestemming. De paradox wordt versterkt doordat sommige AI-content qua kwaliteit en stijl niet meer te onderscheiden is van mensenwerk, waardoor visuele of stilistische aanwijzingen onbetrouwbare indicatoren voor herkomst worden. Transparantie doet ertoe omdat het deze paradox oplost door het publiek de informatie te geven die zij nodig hebben om weloverwogen keuzes te maken over de content die ze consumeren en vertrouwen. Organisaties die duidelijke openbaarmakingspraktijken omarmen, veranderen potentiële scepsis in vertrouwen en tonen aan niets te verbergen te hebben en alles te winnen met eerlijke communicatie.

De regelgeving rond AI-openbaarmaking ontwikkelt zich snel, waarbij meerdere jurisdicties eisen stellen waaraan organisaties zorgvuldig moeten voldoen. De EU AI Act, een van de meest uitgebreide kaders, verplicht dat AI-gegenereerde of sterk AI-bewerkte content zichtbare of in metadata vastgelegde openbaarmaking bevat, met specifieke eisen voor hoog-risico-AI-systemen en transparantieverplichtingen voor ontwikkelaars. In de Verenigde Staten heeft de FTC gewaarschuwd dat het niet bijwerken van gebruikersvoorwaarden en privacybeleid voor AI-gebruik als misleidende praktijk kan worden gezien, terwijl op staatsniveau—vooral de recente Californische AI Frontier Model Law—verhoogde transparantie en rapportageverplichtingen oplegt aan ontwikkelaars van grote AI-systemen. Auteursrechten en intellectueel eigendom voegen een extra laag complexiteit toe, aangezien organisaties moeten aangeven of trainingsdata auteursrechtelijk beschermd materiaal bevatte en hoe AI-systemen zijn getraind. Bovendien gelden GDPR- en CCPA-vereisten ook voor AI-systemen die persoonsgegevens verwerken, waarbij organisaties geautomatiseerde besluitvorming moeten melden en individuen betekenisvolle informatie over AI-verwerking moeten geven. De volgende tabel vat de belangrijkste regelgeving samen in grote jurisdicties:

| Jurisdictie | Regelgeving | Belangrijkste vereisten | Ingangsdatum |

|---|---|---|---|

| Europese Unie | EU AI Act | Openbaarmaking voor hoog-risico-AI; transparantierapporten; metadata-labeling voor AI-content | Gefaseerd (2024-2026) |

| Verenigde Staten (federaal) | FTC-richtlijnen | Privacybeleid bijwerken; AI-gebruik melden; misleiding vermijden | Doorlopend |

| Californië | AI Frontier Model Law | Gestandaardiseerde openbaarmaking; rapportageplicht; veiligheidsmaatregelen | 2025 |

| Europese Unie | GDPR | Geautomatiseerde besluitvorming melden; informatie over AI-verwerking verstrekken | Doorlopend |

| Verenigde Staten (meerdere staten) | CCPA & vergelijkbaar | Gebruik van data in AI-systemen melden; opt-out-mogelijkheden bieden | Verschilt per staat |

| Internationaal | Auteursrechtelijke overwegingen | Trainingsdatabronnen melden; auteursrecht in AI-uitvoer adresseren | In ontwikkeling |

Organisaties die in meerdere rechtsgebieden opereren, dienen openbaarmakingspraktijken te implementeren die voldoen aan de strengste eisen, omdat naleving van één standaard vaak de minimumeisen van andere overstijgt.

Gedragssignalen zijn de subtielste maar krachtige vorm van AI-openbaarmaking: zij werken via presentatie, stijl, stem en creatieve keuzes die het publiek onbewust verwerkt bij het beoordelen van de authenticiteit van content. Deze signalen omvatten kenmerkende patronen in schrijfstijl, consistentie van stem, visuele compositie, kenmerken van avatars of persona’s, en de algehele “fidelity” van de makersrepresentatie—oftewel de mate waarin de content echte menselijke persoonlijkheid en besluitvorming weerspiegelt. Zo vertoont AI-gegenereerde tekst vaak specifieke patronen in zinsopbouw, woordkeuze en logische opbouw die verschillen van mensenwerk, terwijl AI-gegenereerde beelden subtiele inconsistenties kunnen bevatten in belichting, anatomie of achtergrond die door getrainde waarnemers worden opgemerkt. Het concept maker-fidelity staat hierbij centraal: het publiek ontwikkelt verwachtingen over hoe een maker klinkt, eruitziet en zich presenteert, en afwijkingen van dit patroon kunnen AI-gebruik signaleren. Maar alleen vertrouwen op gedragssignalen is riskant omdat AI steeds beter menselijke eigenschappen imiteert, en het publiek niet tot AI-forensisch expert kan worden opgeleid. Daarom dienen gedragssignalen als aanvulling op expliciete openbaarmakingsmethoden, als secundaire transparantielaag die heldere, directe communicatie over AI-gebruik versterkt, niet vervangt.

Verbale openbaarmakingstrategieën zorgen voor expliciete, directe communicatie over AI-gebruik via taalgebaseerde signalen die geen twijfel laten bestaan over de herkomst en betrokkenheid van AI. Deze methoden zijn essentieel omdat ze een duidelijke, gedocumenteerde openbaarmaking opleveren en het publiek ondubbelzinnige informatie geven over AI-gebruik. Organisaties kunnen verbale openbaarmaking op verschillende, elkaar aanvullende manieren toepassen:

De geschiktheid van elke methode hangt af van de context: labels werken goed voor sociale media en visuele content, watermerken voor video en audio, bylines bij journalistieke en creatieve content, openbaarmakingsvelden bij langere content en dankbetuigingen bij complexe projecten. Organisaties dienen methoden te kiezen die passen bij het contenttype en de verwachtingen van het publiek, zodat openbaarmaking niet te missen is, maar ook niet storend werkt.

Technische signalen en metadata zorgen voor machineleesbare, gestandaardiseerde informatie over AI-betrokkenheid, waardoor geautomatiseerde detectie, verificatie en tracking van AI-content binnen digitale ecosystemen mogelijk is. Deze benaderingen maken gebruik van ingebedde data en cryptografische technieken om permanente, fraudebestendige bewijzen te creëren van contentoorsprong en bewerkingsgeschiedenis. De IPTC-standaarden, recent uitgebreid met AI-specifieke metadatavelden, stellen makers in staat gestructureerde informatie over AI-gebruik direct in afbeeldingsbestanden op te nemen, inclusief details over gebruikte AI-systemen, toegepaste bewerkingen en menselijke wijzigingen. C2PA (Coalition for Content Provenance and Authenticity) is een opkomende industriestandaard die cryptografische handtekeningen en content-credentials gebruikt om verifieerbare ketens van herkomst te creëren voor digitale content, zodat het publiek content kan herleiden tot de bron en alle wijzigingen kan zien. Deze technische benaderingen ondervangen een belangrijk probleem van menselijk leesbare openbaarmaking: ze creëren permanente, verifieerbare bewijzen die niet eenvoudig te verwijderen of te wijzigen zijn, en stellen geautomatiseerde systemen in staat AI-content op grote schaal te herkennen en te labelen. Organisaties die technische openbaarmaking implementeren, doen er goed aan C2PA-credentials te gebruiken voor waardevolle content, IPTC-metadata in afbeeldingen en mediabestanden te integreren, en gedetailleerde digitale brontype-documentatie bij te houden die AI-betrokkenheid door de hele contentlevenscyclus volgt. Het voordeel van technische signalen is hun permanentie en verifieerbaarheid; de uitdaging is dat publiek en platforms deze signalen moeten (h)erkennen en respecteren.

Succesvolle AI-openbaarmaking vereist het institutionaliseren van transparantiepraktijken in het hele contentcreatieproces, zodat openbaarmaking van een bijzaak een fundamenteel onderdeel van contentbeheer wordt. Organisaties moeten gestructureerde contentkaders invoeren die AI-betrokkenheid op elk creatiestadium vastleggen—van onderzoek en concept tot redactie en publicatie—zodat openbaarmakingsinformatie soepel door bestaande contentmanagementsystemen stroomt. Automatisering en workflowintegratie zijn daarbij essentieel: contentmanagementsystemen moeten verplichte velden voor AI-openbaarmaking bevatten, automatische prompts die makers verplichten AI-gebruik te documenteren voor publicatie, en goedkeuringsworkflows die openbaarmakingsvolledigheid controleren voor livegang. Zo wordt openbaarmaking een kwaliteitsborgingsvereiste, niet een optionele toevoeging, vergelijkbaar met factchecking, juridische toetsing of merkrichtlijnen. Organisaties moeten ook duidelijke beleidsregels opstellen die bepalen welk AI-gebruik openbaarmaking vereist (bijv. moet AI-ondersteund onderzoek worden gemeld? En AI-geassisteerde redactie?), zodat teams consistent handelen en openbaarmakingsgaten worden voorkomen. Training en documentatie zijn even belangrijk: contentmakers moeten heldere instructies krijgen over hoe zij AI-gebruik op de juiste manier openbaar maken voor verschillende contenttypen en platforms. Door openbaarmaking in contentmodellen en workflows te verankeren, maken organisaties van transparantie een standaardprocedure die zowel het bedrijf als het publiek beschermt.

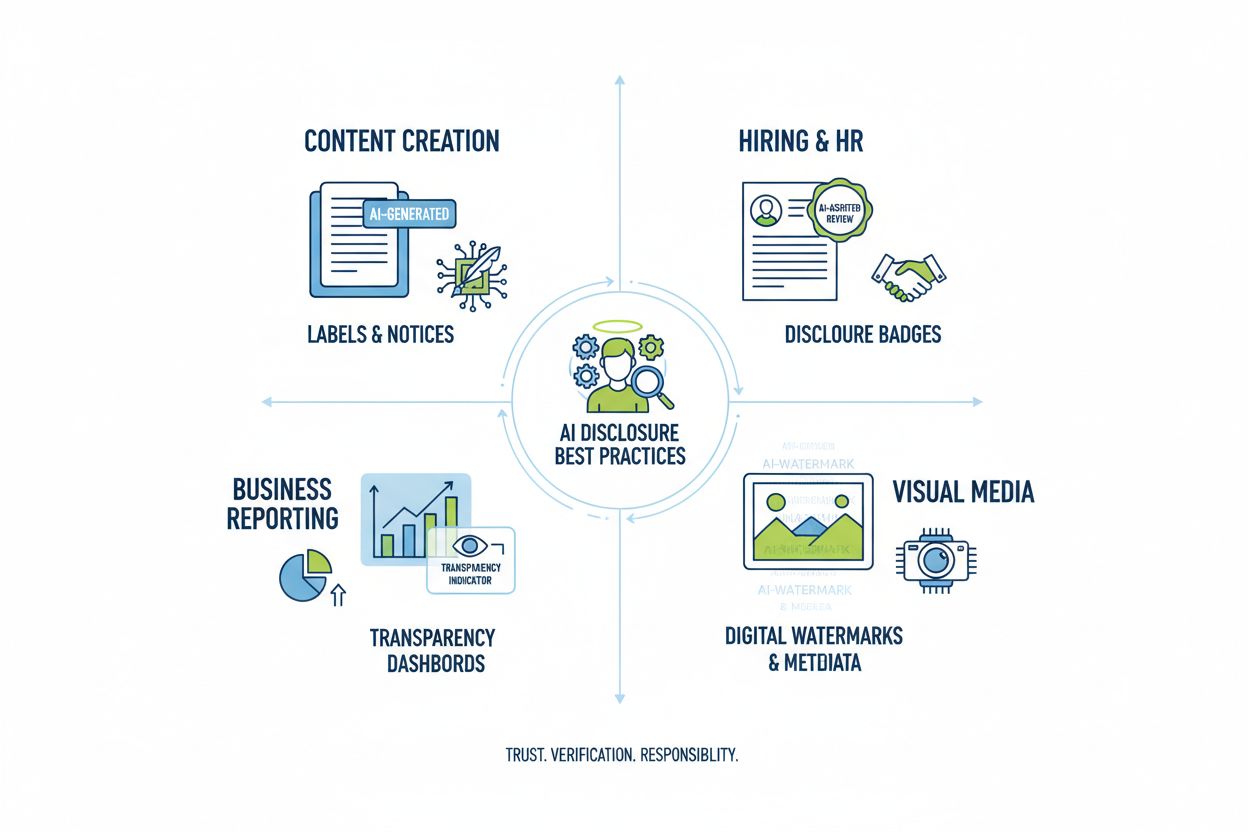

Verschillende AI-toepassingen vragen om aangepaste openbaarmakingsstrategieën die rekening houden met context, publieksverwachtingen en regelgeving. Contentcreatie (artikelen, social media, marketingteksten) moet duidelijke labels of aangepaste bylines bevatten die AI-betrokkenheid aangeven, met aanvullende openbaarmakingsvelden over gebruikte AI-tools en menselijk toezicht; vooral bij nieuws en opinie is dit cruciaal voor vertrouwen. Werving en selectie vereist de meest rigoureuze openbaarmaking, omdat kandidaten recht hebben te weten wanneer AI hun sollicitatie beoordeelt of de eerste selectie doet, met uitleg over hoe AI-besluiten tot stand komen en welke menselijke beoordeling volgt. Rapportages en analyses (financiële rapporten, marktonderzoek, data-analyse) moeten technische openbaarmaking en metadata bevatten over welke analyses AI-ondersteund waren, zeker als AI-systemen patronen of inzichten hebben aangedragen die conclusies beïnvloeden. Visuele content (afbeeldingen, video’s, grafieken) vraagt om zowel zichtbare watermerken als metadata-openbaarmaking, want publiek kan AI-visuals niet betrouwbaar van echte onderscheiden; dit is vooral belangrijk bij nieuwsfotografie, productfoto’s en content waar authenticiteit aankoopbeslissingen of vertrouwen beïnvloedt. Klantcommunicatie (chatbots, geautomatiseerde antwoorden, klantenservice) moet AI-betrokkenheid aan het begin van de interactie duidelijk maken, zodat klanten indien gewenst menselijke hulp kunnen vragen. Organisaties dienen hun AI-gebruik in deze contexten te inventariseren en openbaarmakingspraktijken toe te passen die passen bij de gevoeligheid en impact, met het besef dat transparantie-eisen variëren naargelang AI-besluiten het publiek raken.

De toekomst van AI-openbaarmaking hangt af van branchebrede standaardisatie en de ontwikkeling van interoperabele kaders die consistente, vergelijkbare transparantie mogelijk maken over organisaties en platforms heen. Opkomende standaarden zoals C2PA, IPTC-metadata en het NIST AI Risk Management Framework bieden fundamentele structuren, maar brede adoptie vereist samenwerking tussen technologieplatforms, contentmakers, toezichthouders en brancheorganisaties. De EU AI Act en vergelijkbare regelgeving stimuleren standaardisatie door specifieke openbaarmakingsvormen en -categorieën te eisen, waarmee druk ontstaat voor branchebrede invoering van gedeelde standaarden in plaats van eigenzinnige oplossingen. Initiatieven vanuit de sector zoals de ethische AI-richtlijnen van de PRSA en transparantiekaders illustreren groeiende consensus rond openbaarmakingspraktijken, hoewel vrijwillige toepassing nog inconsistent is. De volgende stap is de overgang van vrijwillige naar verplichte standaardisatie, vergelijkbaar met hoe FDA-voedingslabels voedseltransparantie standaardiseerden. Monitoring- en zichtbaarheidsplatforms—zoals AmICited.com—spelen een steeds grotere rol in dit ecosysteem door te volgen hoe AI merken en content noemt in AI-antwoorden, en organisaties inzicht te geven in hoe hun werk verschijnt in AI-uitvoer en of correcte toeschrijving en openbaarmaking plaatsvinden. Naarmate AI-systemen geavanceerder en alomtegenwoordig worden, wordt de mogelijkheid om AI-openbaarmaking te monitoren, verifiëren en auditen essentieel voor het behouden van vertrouwen in digitale informatiesystemen. Organisaties die nu investeren in robuuste openbaarmakingspraktijken en monitoring, zijn het best gepositioneerd om het veranderende regelgevingslandschap te navigeren en het vertrouwen van het publiek in een AI-gedreven toekomst te waarborgen.

Gedragsmatige openbaarmaking gebruikt presentatiekeuzes (stijl, stem, avatar) om AI-betrokkenheid te signaleren. Verbale openbaarmaking gebruikt expliciete verklaringen, labels en watermerken. Technische openbaarmaking voegt machineleesbare metadata en cryptografische handtekeningen toe. Elke methode bedient verschillende doelgroepen en contexten, en organisaties zouden meerdere methoden samen moeten gebruiken voor volledige transparantie.

Wettelijke vereisten verschillen per jurisdictie. De EU AI Act vereist openbaarmaking voor AI-systemen met hoog risico. De FTC vereist openbaarmaking wanneer AI-gebruik invloed kan hebben op consumentbeslissingen. Staatswetten zoals de California AI Frontier Model Law leggen rapportageverplichtingen op. Auteursrecht vereist openbaarmaking van AI-gegenereerde content. Organisaties dienen juridisch advies in te winnen voor jurisdictie-specifieke vereisten.

AI-gegenereerde afbeeldingen dienen zowel visuele watermerken als metadata-openbaarmaking te bevatten. Visuele watermerken moeten zichtbaar maar niet storend zijn, duidelijk aangeven dat het om AI-generatie gaat. Metadata dient IPTC digitale broninformatie en C2PA-credentials te bevatten waar mogelijk. Onderschriften en openbaarmakingsvelden moeten expliciet vermelden dat beelden AI-gegenereerd zijn, vooral bij nieuws-, product- of promotionele content.

IPTC-standaarden bieden gestructureerde metadata-velden voor het documenteren van AI-gebruik in afbeeldingen en mediabestanden. Ze maken geautomatiseerde detectie en tracking van AI-gegenereerde content over platforms mogelijk. IPTC digitale broncategorieën omvatten 'Trained Algorithmic Media', 'Composite Synthetic' en 'Algorithmic Media'. Deze standaarden zijn belangrijk omdat ze permanente, verifieerbare bewijzen van AI-betrokkenheid creëren die niet gemakkelijk te verwijderen of te wijzigen zijn.

Bedrijven moeten een AI-audit uitvoeren om alle AI-gebruikssituaties te identificeren, openbaarmakingsbeleid implementeren afgestemd op toepasselijke regelgeving, openbaarmaking integreren in contentbeheerprocessen, teams trainen in openbaarmakingsvereisten en naleving regelmatig monitoren. Overleg met juridische experts die bekend zijn met AI-regelgeving in uw jurisdictie is essentieel, omdat vereisten sterk verschillen per regio.

Gevolgen zijn onder meer regelgevende boetes (FTC-boetes, overtredingen van staatswetten), reputatieschade en verlies van publiek vertrouwen, juridische aansprakelijkheid voor auteursrechtinbreuk of misleidende praktijken, en mogelijke rechtszaken van betrokken partijen. Organisaties die AI-gebruik niet openbaar maken riskeren het verlies van geloofwaardigheid die jarenlang is opgebouwd, waardoor proactieve openbaarmaking een strategische investering in langdurig vertrouwen is.

Verschillende belanghebbenden hebben verschillende informatieniveaus nodig. Algemene doelgroepen hebben eenvoudige, duidelijke verklaringen over AI-betrokkenheid nodig. Toezichthouders hebben gedetailleerde technische documentatie en bewijs van naleving nodig. Journalisten en contentmakers hebben specifieke informatie nodig over AI-tools en menselijke controle. Klanten moeten begrijpen hoe AI hun ervaring beïnvloedt. Pas de openbaarmakingsvorm en detailniveau aan op de behoeften en verwachtingen van elke doelgroep.

C2PA (Coalition for Content Provenance and Authenticity) biedt cryptografische credentials voor contentverificatie. IPTC-standaarden maken metadata-integratie in afbeeldingen mogelijk. Contentmanagementsystemen bevatten steeds vaker AI-openbaarmakingsvelden. Monitoringsplatforms zoals AmICited.com volgen AI-vermeldingen en zichtbaarheid. Branchekaders van PRSA, NIST en anderen bieden richtlijnen. De adoptie van deze tools en standaarden versnelt nu de regelgeving strenger wordt.

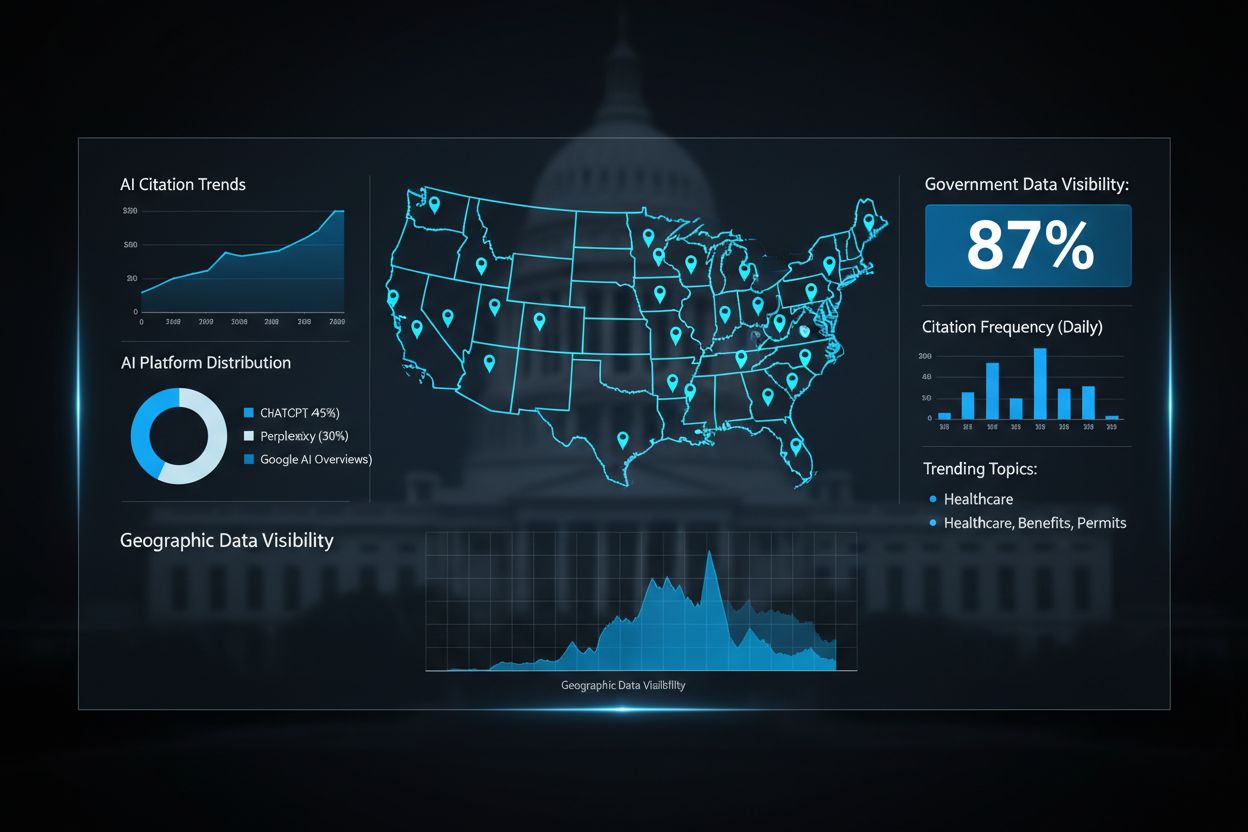

Volg hoe AI-systemen uw merk vermelden binnen GPT's, Perplexity en Google AI Overviews. Zorg dat uw content correcte toeschrijving en zichtbaarheid krijgt in AI-gegenereerde antwoorden.

Ontdek hoe overheidsinstanties hun digitale aanwezigheid kunnen optimaliseren voor AI-systemen zoals ChatGPT en Perplexity. Leer strategieën voor het verbeteren...

Leer hoe je het juiste AI-platform voor zichtbaarheid monitoring voor jouw merk kiest. Vergelijk functies, prijzen en mogelijkheden om je aanwezigheid in ChatGP...

Leer hoe je uitgebreide AI-zichtbaarheidsrapporten bouwt die leidinggevenden begrijpen. Volg merkvermeldingen op ChatGPT, Perplexity en Google AI Overviews met ...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.