Differentiële crawler-toegang

Ontdek hoe je AI-crawlers selectief kunt toestaan of blokkeren op basis van zakelijke doelstellingen. Implementeer differentiële crawler-toegang om content te b...

Ontdek hoe Web Application Firewalls geavanceerde controle bieden over AI-crawlers, verder dan robots.txt. Implementeer WAF-regels om je content te beschermen tegen ongeautoriseerde AI-scraping en monitor AI-verwijzingen met AmICited.

De ontoereikendheid van robots.txt als op zichzelf staand verdedigingsmechanisme is steeds duidelijker geworden in het tijdperk van AI-gedreven contentconsumptie. Terwijl traditionele zoekmachines robots.txt-richtlijnen meestal respecteren, werken moderne AI-crawlers volgens fundamenteel andere prikkels en handhavingsmechanismen, waardoor eenvoudige tekstgebaseerde beleidsregels onvoldoende zijn voor contentbescherming. Volgens analyse van Cloudflare zijn AI-crawlers nu verantwoordelijk voor bijna 80% van al het botverkeer naar websites, waarbij trainingscrawlers enorme hoeveelheden content consumeren maar nauwelijks verwijzingsverkeer terugsturen—de crawlers van OpenAI kennen een crawl-to-referral-verhouding van 400:1, terwijl die van Anthropic zelfs 38.000:1 halen. Voor uitgevers en content-eigenaren vormt deze asymmetrische relatie een kritisch zakelijk risico, omdat AI-modellen die getraind zijn op hun content direct organisch verkeer kunnen verminderen en de waarde van hun intellectueel eigendom aantasten.

Een Web Application Firewall (WAF) fungeert als een reverse proxy tussen gebruikers en webservers, waarbij elke HTTP-aanvraag in realtime wordt geïnspecteerd om ongewenst verkeer te filteren op basis van instelbare regels. In tegenstelling tot robots.txt, dat vertrouwt op vrijwillige naleving door crawlers, wordt bescherming met WAF’s op infrastructuurniveau afgedwongen, waardoor ze aanzienlijk effectiever zijn voor het controleren van AI-crawlertoegang. De volgende vergelijking laat zien hoe WAF’s verschillen van traditionele beveiligingsmethoden:

| Kenmerk | Robots.txt | Traditionele firewall | Moderne WAF |

|---|---|---|---|

| Handhavingsniveau | Adviserend/Vrijwillig | IP-gebaseerde blokkering | Application-aware inspectie |

| AI-crawlerdetectie | Alleen user-agent matching | Beperkte botherkenning | Gedragsanalyse + fingerprinting |

| Realtime aanpassing | Statisch bestand | Handmatige updates vereist | Continue threat intelligence |

| Genuanceerde controle | Alleen op padniveau | Brede IP-reeksen | Beleidsregels op verzoekniveau |

| Machine learning | Geen | Geen | Geavanceerde botclassificatie |

WAF’s bieden gedetailleerde botclassificatie met device fingerprinting, gedragsanalyse en machine learning om bots te profileren naar intentie en verfijning, waardoor veel genuanceerdere controle mogelijk is dan met eenvoudige toestaan/weigeren-regels.

AI-crawlers vallen uiteen in drie categorieën, die elk verschillende bedreigingen vormen en verschillende mitigatiestrategieën vereisen. Trainingscrawlers zoals GPTBot, ClaudeBot en Google-Extended verzamelen systematisch webinhoud voor de ontwikkeling van grote taalmodellen. Zij zijn verantwoordelijk voor circa 80% van al het AI-crawlerverkeer en leveren uitgevers geen enkele verwijzingswaarde op. Zoek- en citatiecrawlers zoals OAI-SearchBot en PerplexityBot indexeren content voor AI-gestuurde zoekervaringen en kunnen enig verwijzingsverkeer leveren via citaties, maar op veel lagere volumes dan traditionele zoekmachines. Gebruikerstriggerde fetchers worden alleen geactiveerd wanneer gebruikers specifiek content opvragen via AI-assistenten; zij werken met een minimaal volume en incidentele verzoeken in plaats van systematische crawlingpatronen. Het dreigingslandschap omvat onder andere:

Moderne WAF’s gebruiken geavanceerde technische detectiemethoden die veel verder gaan dan eenvoudige user-agent string matching om AI-crawlers nauwkeurig te identificeren en te classificeren. Deze systemen maken gebruik van gedragsanalyse om aanvraagpatronen te onderzoeken, waaronder crawl-snelheid, volgorde van aanvragen en kenmerken van responsafhandeling die bots onderscheiden van menselijke gebruikers. Device fingerprinting analyseert HTTP-headers, TLS-handtekeningen en browserkenmerken om gespoofde user-agents te identificeren die traditionele verdedigingsmechanismen proberen te omzeilen. Machine learning-modellen getraind op miljoenen verzoeken detecteren in realtime opkomende crawlersignaturen en nieuwe bot-tactieken, zodat ze zich kunnen aanpassen aan nieuwe dreigingen zonder handmatige regelupdates. Daarnaast kunnen WAF’s de legitimiteit van een crawler verifiëren door aanvraag-IP-adressen te vergelijken met gepubliceerde IP-reeksen van grote AI-bedrijven—OpenAI publiceert geverifieerde IP’s op https://openai.com/gptbot.json, terwijl Amazon deze aanbiedt op https://developer.amazon.com/amazonbot/ip-addresses/—waardoor alleen geauthenticeerde crawlers van legitieme bronnen worden toegelaten.

Het implementeren van effectieve WAF-regels voor AI-crawlers vereist een gelaagde aanpak met user-agent blocking, IP-verificatie en gedragsmatige beleidsregels. Het onderstaande codevoorbeeld toont een basisconfiguratie van WAF-regels die bekende trainingscrawlers blokkeren en legitieme zoekfunctionaliteit toelaten:

# WAF-regel: AI-trainingscrawlers blokkeren

Regelnaam: Block-AI-Training-Crawlers

Voorwaarde 1: HTTP User-Agent komt overeen met (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Actie: Blokkeren (geef 403 Forbidden terug)

# WAF-regel: Geverifieerde zoekcrawlers toestaan

Regelnaam: Allow-Verified-Search-Crawlers

Voorwaarde 1: HTTP User-Agent komt overeen met (OAI-SearchBot|PerplexityBot)

Voorwaarde 2: Bron-IP in geverifieerde IP-reeks

Actie: Toestaan

# WAF-regel: Verkeer van verdachte bots rate-limiten

Regelnaam: Rate-Limit-Suspicious-Bots

Voorwaarde 1: Aanvraagfrequentie overschrijdt 100 verzoeken/minuut

Voorwaarde 2: User-Agent bevat bot-indicatoren

Voorwaarde 3: Geen geverifieerde IP-match

Actie: Challenge (CAPTCHA) of Blokkeren

Organisaties moeten regelvolgorde zorgvuldig implementeren, zodat specifiekere regels (zoals IP-verificatie voor legitieme crawlers) vóór bredere blokkeringsregels worden uitgevoerd. Regelmatig testen en monitoren van de effectiviteit van regels is essentieel, omdat crawler user-agent strings en IP-reeksen vaak veranderen. Veel WAF-providers bieden vooraf ingestelde regelsets die speciaal ontworpen zijn voor het beheer van AI-crawlers, waardoor implementatie eenvoudig blijft en toch brede bescherming wordt geboden.

IP-verificatie en allowlisting zijn de meest betrouwbare methode om legitieme AI-crawlers te onderscheiden van gespoofde verzoeken, omdat user-agent strings eenvoudig te vervalsen zijn, terwijl IP-adressen op schaal veel moeilijker te spoofen zijn. Grote AI-bedrijven publiceren officiële IP-reeksen in JSON-formaat, waardoor geautomatiseerde verificatie mogelijk is zonder handmatig onderhoud—OpenAI biedt aparte IP-lijsten voor GPTBot, OAI-SearchBot en ChatGPT-User, terwijl Amazon een uitgebreide lijst heeft voor Amazonbot. WAF-regels kunnen zo geconfigureerd worden dat alleen verzoeken uit deze geverifieerde IP-reeksen worden toegestaan, zodat kwaadwillenden niet simpelweg door het aanpassen van hun user-agent header beperkingen kunnen omzeilen. Voor organisaties die serverniveau-blokkering gebruiken via .htaccess of firewallregels, biedt het combineren van IP-verificatie met user-agent matching een defense-in-depth bescherming die onafhankelijk werkt van WAF-configuratie. Daarnaast respecteren sommige crawlers HTML-meta-tags zoals <meta name="robots" content="noarchive">, waarmee aan conforme crawlers wordt aangegeven dat content niet voor modeltraining mag worden gebruikt—dit biedt uitgevers een aanvullende, pagina-specifieke controlemogelijkheid.

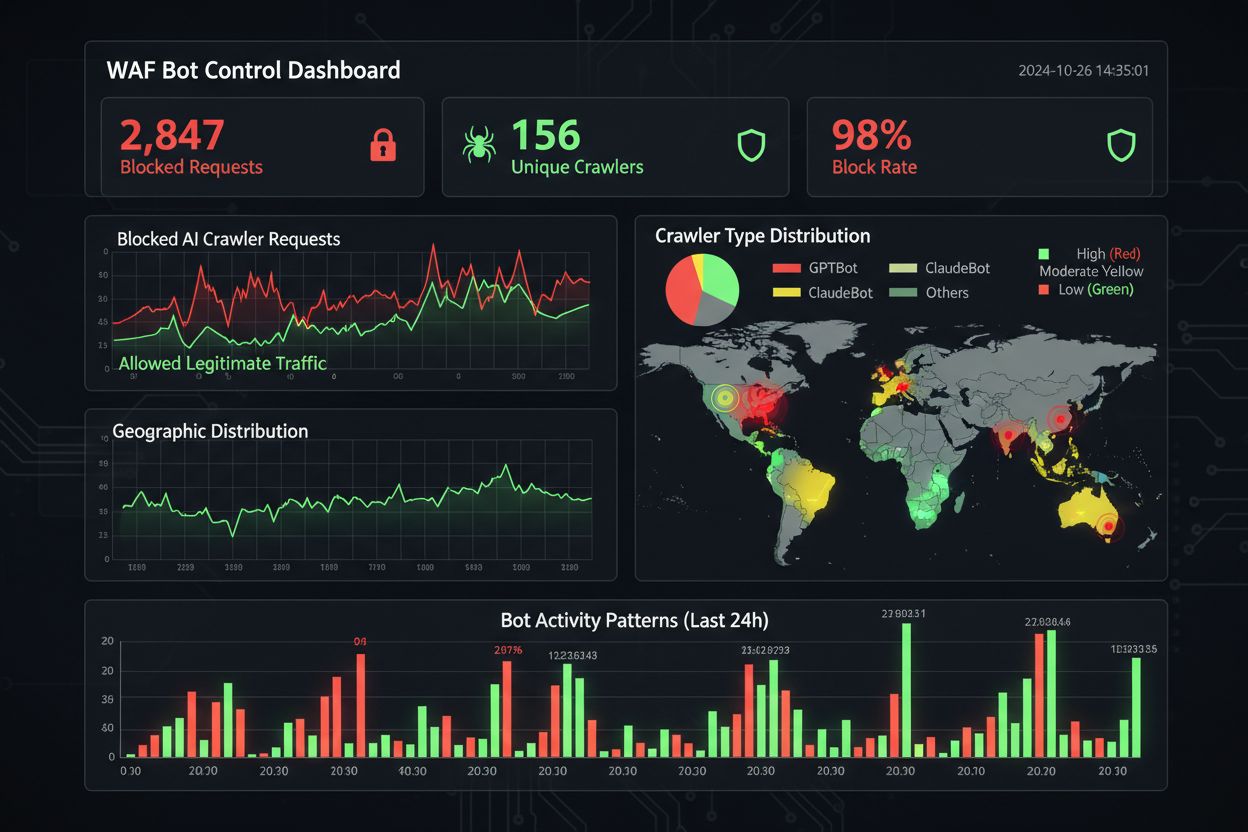

Effectief monitoren en voldoen aan regelgeving vereist continu inzicht in crawleractiviteit en verificatie dat blokkeringsregels naar behoren werken. Organisaties moeten regelmatig servertoegangslogs analyseren om te identificeren welke crawlers hun sites bezoeken en of geblokkeerde crawlers nog steeds verzoeken indienen—Apache-logs staan doorgaans in /var/log/apache2/access.log, Nginx-logs in /var/log/nginx/access.log, en met grep-filtering kun je snel verdachte patronen opsporen. Analysetools maken steeds beter onderscheid tussen botverkeer en menselijke bezoekers, zodat teams het effect van crawlerblokkering op legitieme statistieken zoals bounce rate, conversietracking en SEO kunnen meten. Tools zoals Cloudflare Radar geven wereldwijd inzicht in AI-botverkeer en kunnen nieuwe crawlers identificeren die nog niet op je blokkeerlijst staan. Vanuit compliance-perspectief genereren WAF-logs audittrails die aantonen dat organisaties redelijke beveiligingsmaatregelen nemen om klantdata en intellectueel eigendom te beschermen, wat steeds belangrijker wordt voor GDPR, CCPA en andere privacyregels. Kwartaalreviews van je crawlerblokkeerlijst zijn essentieel, omdat er voortdurend nieuwe AI-crawlers verschijnen en bestaande crawlers hun user-agent strings aanpassen—het community-onderhouden ai.robots.txt-project op GitHub

biedt een waardevolle bron voor het volgen van nieuwe bedreigingen.

Het balanceren van contentbescherming met zakelijke doelstellingen vereist een zorgvuldige analyse van welke crawlers je blokkeert of toestaat, omdat te strenge blokkering de zichtbaarheid in opkomende AI-ontdekkingskanalen kan verminderen. Het blokkeren van trainingscrawlers zoals GPTBot en ClaudeBot beschermt intellectueel eigendom zonder direct effect op verkeer, omdat deze crawlers nooit verwijzingsverkeer sturen. Het blokkeren van zoekcrawlers zoals OAI-SearchBot en PerplexityBot kan echter de zichtbaarheid in AI-gestuurde zoekresultaten verminderen, waar gebruikers actief naar citaties en bronnen zoeken—een afweging die afhankelijk is van je contentstrategie en doelgroep. Sommige uitgevers verkennen alternatieve benaderingen, zoals het toestaan van zoekcrawlers en het blokkeren van trainingscrawlers, of het implementeren van pay-per-crawl-modellen waarbij AI-bedrijven uitgevers compenseren voor contenttoegang. Tools zoals AmICited.com helpen uitgevers te volgen of hun content wordt geciteerd in AI-antwoorden, wat data oplevert ter ondersteuning van blokkeringsbeslissingen. De optimale WAF-configuratie hangt af van je businessmodel: nieuwsuitgevers kunnen prioriteit geven aan het blokkeren van trainingscrawlers om content te beschermen maar zoekcrawlers toestaan voor zichtbaarheid, terwijl SaaS-bedrijven alle AI-crawlers kunnen blokkeren om te voorkomen dat concurrenten prijzen en functies analyseren. Regelmatige monitoring van verkeerspatronen en omzet na het instellen van WAF-regels zorgt ervoor dat je beschermingsstrategie aansluit bij de daadwerkelijke bedrijfsresultaten.

Bij het vergelijken van WAF-oplossingen voor AI-crawlermanagement moeten organisaties letten op enkele belangrijke mogelijkheden die enterprise-platforms onderscheiden van basale opties. Cloudflare’s AI Crawl Control integreert met de WAF en biedt vooraf ingestelde regels voor bekende AI-crawlers, met de mogelijkheid om specifieke crawlers te blokkeren, toe te staan of pay-per-crawl-monetisatie toe te passen—de volgorde van uitvoering zorgt ervoor dat WAF-regels vóór andere beveiligingslagen worden toegepast. AWS WAF Bot Control biedt zowel basis- als gerichte bescherming; het gerichte niveau gebruikt browserinterrogatie, fingerprinting en gedragsheuristieken om geavanceerde bots die zich niet identificeren te detecteren, plus optionele machine learning-analyse van verkeersstatistieken. Azure WAF biedt vergelijkbare functies via beheerde regelsets, maar met minder AI-specifieke specialisatie dan Cloudflare of AWS. Naast deze grote platformen leveren gespecialiseerde botmanagementoplossingen van bijvoorbeeld DataDome geavanceerde machine learning-modellen die specifiek getraind zijn op AI-crawlergedrag, zij het tegen hogere kosten. De keuze tussen oplossingen hangt af van je bestaande infrastructuur, budget en benodigde verfijning—organisaties die al Cloudflare gebruiken profiteren van naadloze integratie, terwijl AWS-klanten Bot Control binnen hun bestaande WAF kunnen inzetten.

Best practices voor AI-crawlermanagement leggen de nadruk op een defense-in-depth-aanpak met meerdere controlemechanismen in plaats van te vertrouwen op één enkele oplossing. Organisaties moeten elk kwartaal blokkeerlijsten herzien om nieuwe crawlers en user-agent strings te detecteren, serverloganalyse onderhouden om te verifiëren dat geblokkeerde crawlers geen regels omzeilen, en WAF-configuraties regelmatig testen om te verzekeren dat regels in de juiste volgorde werken. De toekomst van WAF-technologie zal steeds meer AI-gestuurde dreigingsdetectie bevatten die zich realtime aanpast aan nieuwe crawlertactieken, met integratie in bredere security-ecosystemen voor contextbewuste bescherming. Naarmate regelgeving rondom dataverzameling en AI-trainingsdata strikter wordt, zullen WAF’s essentiële compliance-tools worden in plaats van optionele beveiligingsmaatregelen. Organisaties doen er goed aan nu al uitgebreide WAF-regels voor AI-crawlers te implementeren, voordat nieuwe dreigingen zoals browsergebaseerde AI-agents en headless browser-crawlers gemeengoed worden—de kosten van nietsdoen, gemeten in verloren verkeer, verstoorde analyses en mogelijk juridisch risico, overstijgen ruimschoots de investering in een degelijke beschermingsinfrastructuur.

Robots.txt is een adviserend bestand dat ervan uitgaat dat crawlers vrijwillig je richtlijnen respecteren, terwijl WAF-regels op infrastructuurniveau worden afgedwongen en van toepassing zijn op alle verzoeken, ongeacht of een crawler zich eraan houdt. WAF's bieden realtime detectie en blokkering, terwijl robots.txt statisch is en eenvoudig kan worden omzeild door niet-conforme crawlers.

Ja, veel AI-crawlers negeren robots.txt omdat ze ontworpen zijn om zoveel mogelijk trainingsdata te verzamelen. Terwijl goedgedragende crawlers van grote bedrijven robots.txt doorgaans respecteren, doen kwaadwillenden en sommige nieuwe crawlers dit niet. Daarom bieden WAF-regels betrouwbaardere bescherming.

Controleer je servertoegangslogboeken (meestal in /var/log/apache2/access.log of /var/log/nginx/access.log) op user-agent strings met bot-identificaties. Tools zoals Cloudflare Radar geven wereldwijd inzicht in AI-crawlerverkeer, en analysetools onderscheiden steeds beter botverkeer van menselijke bezoekers.

Het blokkeren van trainingscrawlers zoals GPTBot heeft geen directe SEO-impact, omdat zij geen verwijzingsverkeer sturen. Het blokkeren van zoekcrawlers zoals OAI-SearchBot kan echter de zichtbaarheid in AI-gestuurde zoekresultaten verminderen. Google's AI Overviews volgen de standaard Googlebot-regels, dus het blokkeren van Google-Extended heeft geen invloed op reguliere zoekindexering.

Cloudflare's AI Crawl Control, AWS WAF Bot Control en Azure WAF bieden allemaal effectieve oplossingen. Cloudflare biedt de meeste AI-specifieke functies met vooraf ingestelde regels en pay-per-crawl-opties. AWS biedt geavanceerde machine learning-detectie, terwijl Azure sterke beheerde regelsets levert. Kies op basis van je bestaande infrastructuur en budget.

Beoordeel en werk je WAF-regels minimaal elk kwartaal bij, aangezien er regelmatig nieuwe AI-crawlers verschijnen en bestaande crawlers hun user-agent strings bijwerken. Volg het community-onderhouden ai.robots.txt-project op GitHub voor nieuwe dreigingen en controleer je serverlogs maandelijks om nieuwe crawlers te identificeren.

Ja, dit is een veelgebruikte strategie. Je kunt WAF-regels zo instellen dat trainingscrawlers zoals GPTBot en ClaudeBot worden geblokkeerd, terwijl zoekcrawlers zoals OAI-SearchBot en PerplexityBot worden toegestaan. Zo bescherm je je content tegen gebruik in modeltraining, terwijl je zichtbaar blijft in AI-gestuurde zoekresultaten.

De prijs van een WAF verschilt per provider. Cloudflare biedt WAF vanaf $20/maand met AI Crawl Control-functies. AWS WAF rekent per web ACL en regel, meestal $5-10/maand voor basisbescherming. Azure WAF is inbegrepen bij Application Gateway. De implementatiekosten zijn minimaal vergeleken met de waarde van het beschermen van je content en het behouden van nauwkeurige analyses.

AmICited volgt AI-crawleractiviteit en monitort hoe jouw content geciteerd wordt op ChatGPT, Perplexity, Google AI Overviews en andere AI-platformen. Krijg inzicht in je AI-aanwezigheid en ontdek welke crawlers toegang hebben tot jouw content.

Ontdek hoe je AI-crawlers selectief kunt toestaan of blokkeren op basis van zakelijke doelstellingen. Implementeer differentiële crawler-toegang om content te b...

Leer hoe je robots.txt gebruikt om te bepalen welke AI-bots toegang krijgen tot je content. Complete gids om GPTBot, ClaudeBot en andere AI-crawlers te blokkere...

Compleet naslagwerk over AI crawlers en bots. Identificeer GPTBot, ClaudeBot, Google-Extended en meer dan 20 andere AI-crawlers met user agents, crawl rates en ...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.