Hoe Onderzoek Ik AI-zoekopdrachten?

Leer hoe je AI-zoekopdrachten onderzoekt en monitort via ChatGPT, Perplexity, Claude en Gemini. Ontdek methodes om merkvermeldingen te volgen en te optimalisere...

Ontdek hoe enquêtes de nauwkeurigheid van AI-citaties verbeteren, merkzichtbaarheid in AI-antwoorden monitoren en de contentzichtbaarheid vergroten op ChatGPT, Perplexity en andere AI-platforms.

Enquêtes helpen AI-citaties door gestructureerde, feitelijke gegevens te bieden die AI-systemen eenvoudig kunnen ophalen en citeren. Ze verhogen de contentautoriteit, maken citatiemonitoring mogelijk op AI-platforms en helpen organisaties te begrijpen welke content wordt geciteerd in AI-antwoorden.

Enquêtes zijn krachtige instrumenten voor het verzamelen van gestructureerde gegevens die direct beïnvloeden hoe AI-systemen informatie citeren en verwijzen. Wanneer organisaties enquêtes uitvoeren, verzamelen ze kwantificeerbare, feitelijke informatie die zeer waardevol wordt voor Retrieval-Augmented Generation (RAG)-systemen die gebruikt worden door AI-platforms zoals ChatGPT, Perplexity en Google’s AI Overviews. Deze enquêtes leveren het soort concrete gegevens, statistieken en bewijsmateriaal waar AI-algoritmes prioriteit aan geven bij het selecteren van bronnen om te citeren in hun gegenereerde antwoorden. De gestructureerde aard van enquêtegegevens maakt het voor AI-systemen gemakkelijker om deze te analyseren, begrijpen en opnemen in antwoorden, wat de kans aanzienlijk vergroot dat uw content wordt geciteerd.

De relatie tussen enquêtes en AI-citaties werkt op meerdere niveaus. Ten eerste genereren enquêtes gezaghebbende gegevens die deskundigheid en geloofwaardigheid aantonen—twee cruciale factoren in AI-citatiealgoritmes. Wanneer uw organisatie de resultaten van een enquête publiceert, creëert u in feite een primaire informatiebron die AI-systemen herkennen als waardevol en betrouwbaar. Ten tweede bieden enquêtes specifieke, kwantificeerbare informatie die AI-systemen verkiezen boven vage of conceptuele content. In plaats van algemene beweringen bevatten door enquêtes ondersteunde uitspraken percentages, getallen en concrete bevindingen die AI-modellen vol vertrouwen kunnen citeren zonder risico op onnauwkeurigheid.

AI-citatiealgoritmes beoordelen bronnen op vijf kernaspecten, en enquêtes presteren meestal uitstekend op deze gebieden. Autoriteit is de eerste belangrijke factor—domeinreputatie, backlinkprofiel en aanwezigheid in kennisgrafieken bepalen of AI-systemen uw content vertrouwen. Wanneer u origineel enquêteonderzoek publiceert, profileert u zich als primaire bron, wat uw autoriteitssignalen aanzienlijk versterkt. Onderzoek naar 150.000 AI-citaties toont aan dat gezaghebbende bronnen voorrang krijgen, waarbij gevestigde publicaties ongeveer 35% van de ChatGPT-citaties ontvangen en vergelijkbare percentages op andere platforms.

Actualiteit is de tweede evaluatiedimensie, en enquêtes voldoen hier van nature aan. Content die binnen 48-72 uur is gepubliceerd of bijgewerkt, krijgt een hogere rangschikking in AI-systemen, waarbij de zichtbaarheid merkbaar daalt binnen 2-3 dagen zonder updates. Door regelmatig enquêtes te houden en verse resultaten te publiceren, behoudt u continue actualiteitssignalen die uw content actief in overweging houden voor AI-citaties. Dit creëert een cumulatief voordeel—organisaties die kwartaal- of jaarrapportages publiceren, behouden consistente actualiteit en voorkomen dat content veroudert.

Relevantie is de derde factor, waarop enquêtes uitblinken. Enquêtes behandelen direct specifieke vragen en bieden gerichte antwoorden, waarmee ze sterke semantische overeenstemming met gebruikersvragen creëren. Wanneer een AI-systeem een vraag verwerkt over markttrends, consumentengedrag of industrie-statistieken, biedt enquêtegegevens precies het soort gerichte, relevante informatie dat algoritmes belonen. Feitendichtheid is de vierde dimensie—enquêtes bevatten van nature specifieke gegevens, statistieken, data en concrete voorbeelden die beter presteren dan puur conceptuele content. Een enquête waaruit blijkt dat 73% van de consumenten een bepaalde functie verkiest, weegt in AI-citatiealgoritmes veel zwaarder dan een algemene uitspraak over consumentvoorkeuren.

Enquêtes fungeren als fundamentele geloofwaardigheidsbouwers in het AI-citatie-ecosysteem. Wanneer u origineel onderzoek publiceert, creëert u meerdere manieren voor AI-systemen om uw autoriteit te herkennen en te citeren. Ten eerste krijgen enquêtes de status van primaire bron, wat AI-algoritmen zwaar laten meewegen in hun evaluatiecriteria. In tegenstelling tot secundaire bronnen die andere bronnen aanhalen, hebben primaire onderzoeksgegevens inherente autoriteit omdat ze origineel onderzoek en dataverzameling vertegenwoordigen. Dit voordeel van primaire bron betekent dat uw enquêteresultaten referentiepunten worden die andere organisaties citeren, waardoor uw autoriteit met elke citatie toeneemt.

Ten tweede stellen enquêtes u in staat om topische autoriteit op te bouwen binnen specifieke domeinen. Door meerdere enquêtes uit te voeren over gerelateerde onderwerpen, toont u uitgebreide expertise die AI-systemen herkennen en belonen. Bijvoorbeeld, een organisatie die kwartaalenquêtes uitvoert over AI-adoptie, implementatie-uitdagingen en ROI-statistieken, profileert zich als thought leader op het gebied van AI-toepassingen in het bedrijfsleven. AI-systemen herkennen dit patroon van consistente, gezaghebbende research en geven voorrang aan citaties van dergelijke bronnen bij het beantwoorden van vragen over deze onderwerpen.

Ten derde creëren enquêtes vertrouwensketens via hun citatiepatronen. Wanneer uw enquête gezaghebbende referenties en primaire bronnen citeert, beoordelen AI-systemen of uw beweringen onderbouwd zijn met gegevens. Dit zorgt voor een versterkende cyclus waarbij goed onderzochte enquêtes die betrouwbare bronnen citeren, vertrouwen erven van die geciteerde bronnen. Organisaties die AI-reputatiemanagementstrategieën ontwikkelen, moeten consistente communicatie waarborgen over alle digitale kanalen, en enquêtes bieden het feitelijke fundament dat deze consistentie ondersteunt.

Naast het genereren van citeerbare content fungeren enquêtes als directe monitoringmechanismen om de prestaties van AI-citaties te volgen. Organisaties kunnen enquêtes opzetten die specifiek zijn ontworpen om te meten hoe hun merk verschijnt in AI-antwoorden op verschillende platforms. Deze enquêtes tonen welke content citaties ontvangt, welke onderwerpen de meeste AI-vermeldingen opleveren en hoe verschillende AI-platforms bronnen verschillend prioriteren.

| AI-platform | Citatievoorkeur | Toepassing enquête |

|---|---|---|

| ChatGPT | Encyclopedische, gezaghebbende bronnen | Enquête onder gevestigde merken en Wikipedia-organisaties |

| Google AI Overviews | Diverse bronnen, waaronder blogs en fora | Enquête over contentprestaties op diverse contenttypen |

| Perplexity AI | Branchegerichte reviews en expertpublicaties | Enquête welke vakbladen uw onderzoek citeren |

| Claude | Gedetailleerde, goed onderbouwde content | Enquête naar citatiepatronen in technische en onderzoekscontent |

Enquêtes stellen organisaties in staat kwantitatieve gegevens over citatiepatronen te verzamelen die anders onzichtbaar blijven. Door klanten, branchegenoten en monitoringtools te bevragen, kunnen organisaties vaststellen welke van hun content wordt geciteerd, welke onderwerpen de meeste AI-vermeldingen genereren en welke platforms hun bronnen prioriteren. Deze datagedreven benadering verandert citatiemonitoring van giswerk in strategische intelligentie die contentcreatie en optimalisatie aanstuurt.

Enquêtes creëren die specifiek zijn ontworpen voor AI-citatie vereist inzicht in hoe AI-systemen gestructureerde gegevens verwerken en evalueren. Enquêteontwerp heeft direct invloed op de kans op citatie—enquêtes die zijn gestructureerd als vraag-antwoordparen presteren beter in retrievalalgoritmes dan enquêtes met complexe opmaak of onduidelijke hiërarchie. FAQ-achtige enquêtes en content die natuurlijk taalgebruik nabootsen, krijgen voorrang van AI-systemen omdat ze aansluiten bij hoe gebruikers vragen stellen en hoe AI relevante informatie ophaalt.

Het presentatieformat van enquêteresultaten beïnvloedt de kans op citatie aanzienlijk. Enquêtes met een duidelijke hiërarchische structuur, beschrijvende koppen en logische opbouw scoren hoger in AI-evaluatiealgoritmes. Gestructureerde datamarkup kan de kans op citatie tot 10% verhogen, wat betekent dat enquêtes met correcte schema-markup meetbaar vaker worden geciteerd dan ongestructureerde presentaties. Organisaties moeten FAQ-schema, Artikel-schema met auteurinformatie en Organisatie-schema implementeren om machine-leesbare signalen te creëren die retrievalalgoritmes prioriteren.

Steekproefgrootte en transparantie over methodologie beïnvloeden eveneens AI-citatiebeslissingen. AI-systemen beoordelen of enquêtes ondersteunend bewijs en methodologiedocumentatie bevatten. Enquêtes die duidelijk hun steekproefomvang, methodologie, betrouwbaarheidsintervallen en dataverzamelingsmethoden toelichten, verkrijgen geloofwaardigheid door deze transparantie. Wanneer AI-systemen kunnen controleren dat een enquête volgens rigoureuze onderzoeksmethoden is uitgevoerd, citeren ze deze resultaten met meer vertrouwen. Dit betekent dat het publiceren van een gedetailleerde methodologie naast de enquêteresultaten de kans op citatie vergroot ten opzichte van het publiceren van resultaten zonder methodologische context.

Een van de meest onderbenutte voordelen van enquêtes voor AI-citaties is het behouden van continue actualiteitssignalen. AI-algoritmen hechten veel waarde aan de actualiteit van content, waarbij zichtbaarheid merkbaar daalt binnen 2-3 dagen zonder updates. Organisaties die regelmatig enquêtes uitvoeren—of dat nu per kwartaal, halfjaar of jaarlijks is—behouden voortdurende actualiteitssignalen die contentveroudering voorkomen. Elke nieuwe enquêtepublicatie zet de actualiteitsklok opnieuw, waardoor uw content actief in aanmerking blijft komen voor AI-citaties.

Dit actualiteitsvoordeel wordt sterker na verloop van tijd. Een organisatie die jaarlijks enquêtes publiceert, zorgt voor minimaal één grote contentvernieuwing per jaar, terwijl organisaties met kwartaalenquêtes vier grote vernieuwingen per jaar realiseren. Elke publicatie creëert nieuwe indexeringskansen, nieuwe citatiemogelijkheden en vernieuwde zichtbaarheidssignalen die AI-systemen herkennen en belonen. Het cumulatieve effect is dat organisaties met een consistent publicatieschema voor enquêtes een hoger basis-citatiepercentage behouden dan organisaties die slechts sporadisch enquêtes publiceren.

Organisaties zouden de frequentie van citaties moeten volgen door relevante zoekopdrachten handmatig te testen op ChatGPT, Google AI Overviews, Perplexity en andere platforms. Regelmatige prompttests laten zien welke enquête-inhoud succesvol wordt geciteerd en waar hiaten bestaan in AI-representatie. Door zoekopdrachten met betrekking tot uw enquêteonderwerpen vóór en na publicatie te testen, kunt u de directe impact van enquêtepublicaties op citatiepercentages meten. Deze testmethodiek levert concrete gegevens op over welke enquêtes citaties genereren, welke onderwerpen aanslaan bij AI-systemen en welke platforms uw onderzoek prioriteren.

Aanpassingsvereisten ontstaan doordat AI-citatiealgoritmes continu veranderen met de uitbreiding van trainingsdata en retrievalstrategieën. Contentstrategieën vereisen regelmatige tests en bijsturing op basis van prestaties. Wanneer enquêtecontent geen citaties meer ontvangt ondanks eerder succes, vernieuw deze dan met recente informatie of herstructureer voor betere semantische afstemming. Organisaties zouden kwartaalreviews moeten inplannen waarbij ze citatieprestaties testen, onderpresterende enquêtes identificeren en vernieuwingsstrategieën ontwikkelen die de zichtbaarheid van citaties behouden.

Het concurrentielandschap voor AI-citaties verschilt fundamenteel van traditionele zoekmachineoptimalisatie. Meerdere bronnen kunnen voor één zoekopdracht geciteerd worden, waardoor co-citatiekansen ontstaan in plaats van zero-sum concurrentie. Organisaties profiteren van het creëren van uitgebreide enquêtecontent die bestaande, veel geciteerde bronnen aanvult in plaats van dupliceert. Door hiaten in bestaand enquêteonderzoek te identificeren en originele enquêtes te publiceren die deze hiaten adresseren, positioneren organisaties zich voor citatiekansen zonder direct te concurreren met gevestigde bronnen.

Volg hoe uw merk verschijnt in AI-antwoorden op ChatGPT, Perplexity, Google AI Overviews en andere AI-platforms. Ontvang realtime inzichten in uw citatieprestaties.

Leer hoe je AI-zoekopdrachten onderzoekt en monitort via ChatGPT, Perplexity, Claude en Gemini. Ontdek methodes om merkvermeldingen te volgen en te optimalisere...

Leer hoe je statistieken en data-onderbouwde inzichten gebruikt om de zichtbaarheid van je merk te vergroten in AI-zoekmachines zoals ChatGPT, Perplexity en Goo...

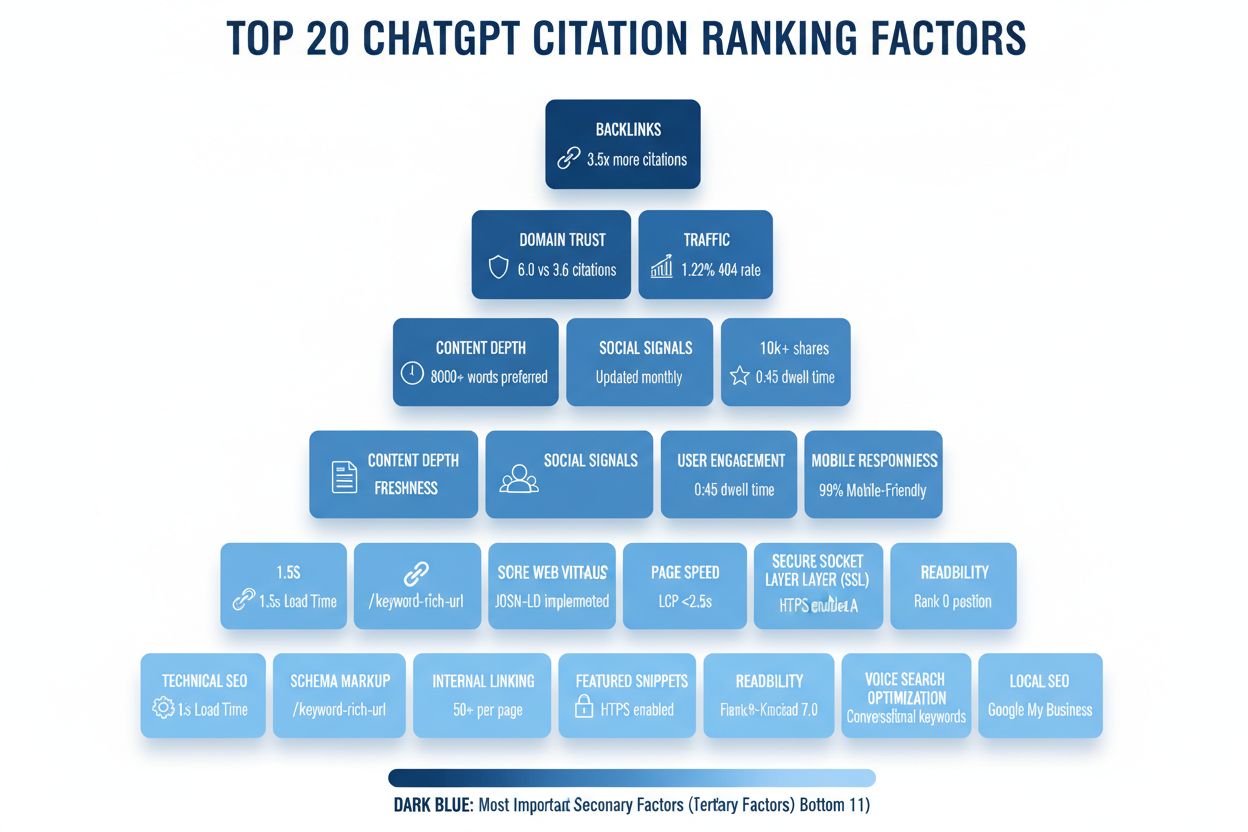

Ontdek de 20 factoren die ChatGPT-citaties beïnvloeden op basis van SE Ranking's analyse van 129.000 domeinen. Leer hoe je optimaliseert voor AI-zichtbaarheid m...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.