Begrijpen welke factoren AI-indexeringssnelheid beïnvloeden

AI-indexeringssnelheid bepaalt hoe snel je content vindbaar wordt in AI-aangedreven zoekmachines zoals ChatGPT, Perplexity en Google’s AI Overviews. In tegenstelling tot traditionele zoekmachines die simpelweg trefwoorden aan pagina’s koppelen, moeten AI-systemen je content crawlen, begrijpen en synthetiseren om nauwkeurige antwoorden te genereren. De snelheid waarmee dit gebeurt, hangt af van tal van onderling verbonden factoren die direct je zichtbaarheid in AI-gegenereerde antwoorden beïnvloeden en je vermogen om verkeer van AI-zoekplatforms te verkrijgen.

Siteprestaties en paginalaadsnelheid

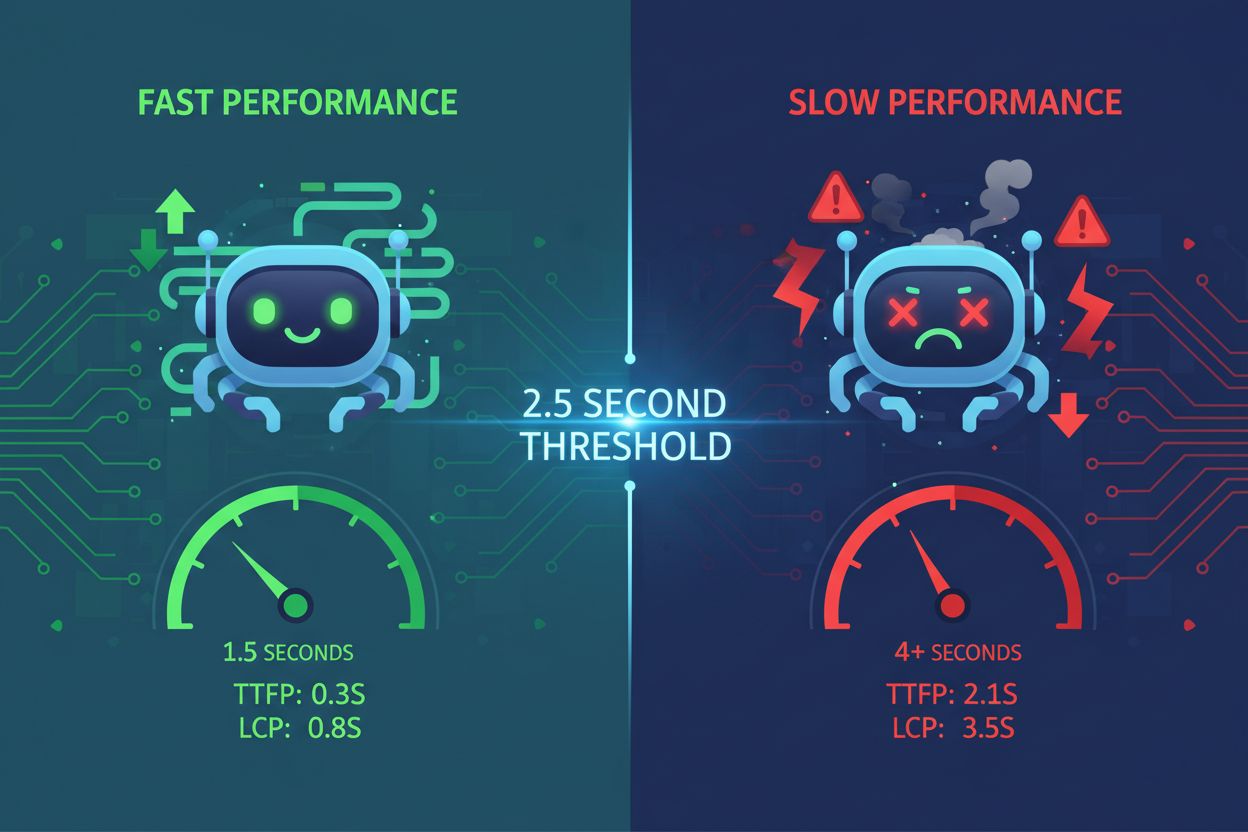

Paginalaadsnelheid is een van de meest kritische factoren die de AI-indexeringssnelheid beïnvloeden. AI-crawlers werken binnen strikte resourcebeperkingen en tijdslimieten—meestal tussen 1-5 seconden per paginaverzoek. Wanneer je website langzaam laadt, besteden crawlers meer tijd aan het ophalen van content, waardoor minder pagina’s worden geïndexeerd binnen hun toegewezen crawlvenster. Dit veroorzaakt een cascade-effect waarbij trage prestaties direct het aantal pagina’s verminderen dat AI-systemen kunnen verwerken en indexeren.

Langzaam ladende sites signaleren slechte onderhoud aan AI-systemen. Wanneer pagina’s te lang nodig hebben om te laden, kunnen AI-crawlers mogelijk een timeout krijgen voordat ze je daadwerkelijke content bereiken, waardoor alleen je HTML-skelet wordt geïndexeerd. Dit is vooral problematisch voor JavaScript-rijke websites waar content dynamisch aan de clientzijde wordt geladen. Het benodigde tweestapsrenderproces voor JavaScript zorgt voor aanzienlijke vertraging, waardoor het voor AI-systemen moeilijker wordt zinvolle informatie te extraheren. Door afbeeldingen te comprimeren, code te minificeren, lazy loading toe te passen en Content Delivery Networks (CDN’s) te gebruiken, kun je laadtijden drastisch verbeteren en AI-crawlers in staat stellen meer pagina’s efficiënt te verwerken.

| Prestatiekenmerk | Doelstelling | Impact op AI-indexering |

|---|

| Paginalaadtijd | Onder 3 seconden | Maakt het mogelijk meer pagina’s per sessie te crawlen |

| Largest Contentful Paint (LCP) | Onder 2,5 seconden | Zorgt dat AI snel betekenisvolle content ziet |

| First Input Delay (FID) | Lager dan 100ms | Verbetert crawler-responsiviteit |

| Cumulative Layout Shift (CLS) | Zo dicht mogelijk bij nul | Voorkomt fouten bij het extraheren van content |

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Beperkingen van het crawlbudget

Crawlbudget verwijst naar het beperkte aantal pagina’s dat AI-systemen binnen een bepaald tijdsbestek kunnen bezoeken. Elke website krijgt een eindige crawltoewijzing van AI-zoekmachines, vergelijkbaar met hoe Google crawlbudget verdeelt. Wanneer je crawlbudget op is, stoppen AI-systemen met het indexeren van nieuwe content, ongeacht de kwaliteit. Deze beperking is vooral problematisch voor grote websites met honderden of duizenden pagina’s die concurreren om beperkte indexeringsresources.

Optimalisatie van crawlbudget is essentieel voor snellere AI-indexering. Je moet prioriteit geven aan waardevolle pagina’s—degene die omzet genereren, verkeer aantrekken of cruciale informatie bevatten—boven minder waardevolle pagina’s, zoals dubbele categorie-filters of overbodige tag-pagina’s. Door robots.txt-bestanden strategisch te gebruiken, kun je AI-crawlers blokkeren voor pagina’s die geen indexering nodig hebben, zodat je crawlbudget behouden blijft voor belangrijke content. Verder helpt het bijhouden van een actuele XML-sitemap en het gebruiken van een correcte interne linkstructuur AI-systemen om je belangrijkste pagina’s sneller te ontdekken, zodat deze worden geïndexeerd voordat je crawlbudget op is.

Contentkwaliteit en originaliteit

AI-systemen straffen dubbele en dunne content zwaar af, wat de indexering aanzienlijk vertraagt. Wanneer AI-crawlers content tegenkomen die originaliteit of diepgang mist, geven ze het crawlen van soortgelijke pagina’s op je site minder prioriteit. Dit komt doordat AI-systemen de contentkwaliteit beoordelen aan de hand van E-E-A-T-signalen (Ervaring, Expertise, Autoriteit en Betrouwbaarheid). Content die lijkt op weinig moeite, AI-gegenereerd zonder menselijke review, of gekopieerd van andere bronnen, krijgt een lagere prioriteit in de indexeringswachtrij.

Hoogwaardige, uitgebreide content wordt sneller door AI-systemen geïndexeerd. Content van meer dan 3.000 woorden die gebruikersvragen vanuit meerdere invalshoeken grondig beantwoordt, krijgt prioriteit bij indexering. AI-systemen geven de voorkeur aan content met ondersteunende data, statistieken, praktijkvoorbeelden en casestudy’s omdat deze elementen expertise en betrouwbaarheid aantonen. Wanneer je originele, goed onderzochte content creëert die echte waarde biedt, kennen AI-crawlers meer resources toe aan het indexeren van je pagina’s, wat leidt tot snellere ontdekking en opname in AI-gegenereerde antwoorden.

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Technische SEO-configuratie

Onjuiste robots.txt-configuratie kan AI-crawlers per ongeluk blokkeren bij het indexeren van je content. Veel websites voorkomen onbedoeld dat AI-zoekbots hun pagina’s bereiken door foutieve robots.txt-bestanden. Verschillende AI-systemen gebruiken verschillende crawler-identificaties—ChatGPT gebruikt OAI-SearchBot, Perplexity gebruikt PerplexityBot, en andere gebruiken AndiBot of ExaBot. Als je robots.txt deze crawlers niet expliciet toestaat, kunnen ze je content niet indexeren, ongeacht de kwaliteit of relevantie.

Schone HTML-structuur en semantische markup versnellen AI-indexering. AI-crawlers hebben moeite met JavaScript-rijke implementaties en complexe geneste structuren. Door semantische HTML5-tags te gebruiken (article, section, nav), correcte heading-hiërarchieën (H1-H6), beschrijvende linktekst en alt-tekst voor afbeeldingen, wordt je content direct toegankelijk voor AI-systemen. Server-side rendering (SSR)-frameworks zoals Next.js of Gatsby prerenderen content op de server, zodat AI-crawlers volledig gevormde pagina’s ontvangen zonder dat JavaScript hoeft te worden uitgevoerd, wat de indexering aanzienlijk versnelt.

Database-indexering en infrastructuur

Overmatig indexeren in je database zorgt voor vertraging die de AI-indexeringssnelheid afremt. Wanneer databases buitensporig veel, overbodige of overlappende indexen bevatten, moet elke insert-, update- en delete-operatie meerdere indexen bijwerken, wat schrijftbottlenecks veroorzaakt. Deze overhead beïnvloedt direct hoe snel je contentmanagementsysteem pagina’s aan AI-crawlers kan serveren. Overbodige indexen nemen opslagruimte in, introduceren vertraging en dwingen queryplanners suboptimale beslissingen te nemen, wat allemaal de contentlevering aan AI-systemen vertraagt.

Het optimaliseren van database-indexen verbetert de snelheid van contentlevering aan AI-crawlers. Controleer je database regelmatig om ongebruikte of overbodige indexen te identificeren met tools zoals pg_stat_user_indexes (PostgreSQL) of sys.schema_unused_indexes (MySQL). Verwijder indexen die weken of maanden niet zijn gebruikt, consolideer overlappende indexen en zorg dat je databaseschema aansluit op de huidige querypatronen. Een goed geoptimaliseerde database serveert content sneller aan AI-crawlers, waardoor snellere indexering en opname in AI-gegenereerde antwoorden mogelijk is.

Implementatie van schema markup

Ontbrekende of onvolledige schema markup vertraagt AI-begrip van content en indexering. Schema markup biedt gestructureerde data die AI-systemen helpt snel de context, betekenis en relaties van je content te begrijpen. Zonder correcte schema-implementatie moeten AI-crawlers extra verwerkingstijd besteden aan het afleiden van de contentstructuur en het extraheren van kerninformatie. Deze extra verwerkingstijd verlaagt de indexeringssnelheid omdat crawlers meer resources per pagina moeten inzetten.

Het implementeren van uitgebreide schema markup versnelt AI-indexering. FAQ-schema, How-To-schema, Artikel-schema en Product-schema bieden AI-systemen vooraf gestructureerde informatie die direct begrepen en geïndexeerd kan worden. Wanneer je auteursinformatie, publicatiedata, beoordelingen en andere gestructureerde data toevoegt, kunnen AI-systemen je content snel categoriseren en indexeren zonder extra verwerking. Uit onderzoek blijkt dat 36,6% van de zoekwoorden featured snippets oproept die afkomstig zijn uit schema markup, wat aantoont dat gestructureerde data direct invloed heeft op AI-zichtbaarheid en indexeringssnelheid.

Interne linkstructuur

Zwakke interne linkstructuur belemmert AI-crawlers bij het efficiënt ontdekken van je content. Interne links fungeren als een routekaart die AI-crawlers door je website-architectuur leidt. Zonder strategische interne links kunnen AI-systemen moeite hebben om belangrijke pagina’s te vinden, zeker nieuwere content die diep in je site-structuur is geplaatst. Deze ontdekkingstijd vertaalt zich direct in tragere indexering omdat crawlers meer tijd moeten besteden aan het zoeken naar pagina’s om te indexeren.

Strategische interne linkstructuur versnelt AI-contentontdekking en indexering. Nieuwe content linken vanaf relevante bestaande pagina’s helpt AI-crawlers deze sneller te vinden en indexeren. Het gebruik van beschrijvende anchorteksten die duidelijk aangeven wat de gelinkte pagina bevat, helpt AI-systemen de relaties en context van content te begrijpen. Een juiste interne linkstructuur zorgt ervoor dat waardevolle pagina’s meer crawl-aandacht krijgen, wat resulteert in snellere indexering en hogere prioriteit in AI-gegenereerde antwoorden.

Gebruikerservaring en contenttoegankelijkheid

Slechte gebruikerservaring geeft aan AI-systemen het signaal dat je content mogelijk niet waardevol is. Hoge bouncepercentages, korte sessieduur en lage engagement-metrics geven AI-crawlers aan dat je content niet aan de gebruikersbehoefte voldoet. AI-systemen maken steeds meer gebruik van gedragssignalen om de kwaliteit van content te beoordelen, en pagina’s met slechte UX krijgen een lagere indexeringsprioriteit. Wanneer gebruikers je pagina’s snel verlaten, interpreteren AI-systemen dit als een signaal dat de content geen waarde biedt, waardoor opname in AI-antwoorden vertraagt.

Lezersvriendelijke contentstructuur verbetert de AI-indexeringssnelheid. Content die is opgemaakt in korte alinea’s (2-3 zinnen), beschrijvende subkoppen, opsommingen, genummerde lijsten en tabellen is gemakkelijker voor zowel gebruikers als AI-systemen om te verwerken. Deze verbeterde scanbaarheid maakt het voor AI-crawlers mogelijk snel kerninformatie te extraheren en de contentstructuur te begrijpen zonder uitgebreide verwerking. Wanneer je content goed georganiseerd en toegankelijk is, kunnen AI-systemen deze sneller en met meer vertrouwen in kwaliteit en relevantie indexeren.

Hostinginfrastructuur en serverresponstijd

Trage hostinginfrastructuur veroorzaakt knelpunten die AI-indexering vertragen. Shared hostingomgevingen hebben vaak beperkte resources en tragere responstijden, waardoor AI-crawlers langer moeten wachten tot een pagina geladen is. Deze wachttijd vermindert het aantal pagina’s dat binnen het toegewezen tijdsvenster van de crawler kan worden geïndexeerd. Serverresponstijd heeft direct invloed op de crawlefficiëntie—elke milliseconde aan vertraging verlaagt het totale aantal pagina’s dat per sessie wordt geïndexeerd.

Upgraden naar snelle, schaalbare hosting versnelt AI-indexering. Managed WordPress-hosts, VPS-oplossingen en cloudplatforms zoals Google Cloud of AWS bieden snellere serverresponstijden en betere resourceallocatie. CDN’s zoals Cloudflare cachen content wereldwijd en leveren pagina’s sneller aan crawlers, ongeacht hun geografische locatie. Wanneer je hostinginfrastructuur pagina’s snel levert, kunnen AI-crawlers meer content per sessie verwerken, wat resulteert in snellere totale indexering en betere zichtbaarheid in AI-gegenereerde antwoorden.

Monitoring en optimalisatie

Continue monitoring van AI-indexeringsprestaties maakt proactieve optimalisatie mogelijk. Tools zoals Google Search Console, SE Ranking’s AI Results Tracker en Peec.ai helpen je te volgen hoe snel je content verschijnt in AI-zoekresultaten en identificeren pagina’s die niet worden geïndexeerd. Door deze metrics te monitoren, kun je knelpunten herkennen en gerichte verbeteringen doorvoeren die direct invloed hebben op de indexeringssnelheid.

Regelmatige audits en updates behouden een optimale AI-indexeringssnelheid. Voer periodieke prestatie-audits uit met tools zoals Google PageSpeed Insights, GTmetrix en WebPageTest om snelheidsknelpunten te identificeren. Werk je XML-sitemap regelmatig bij, vernieuw content om versheidssignalen te behouden en blijf je database en infrastructuur optimaliseren. Consistente optimalisatie zorgt ervoor dat je AI-indexeringssnelheid concurrerend blijft en je content snel blijft verschijnen in AI-gegenereerde antwoorden.