AI-prerendering

Ontdek wat AI-prerendering is en hoe server-side renderingstrategieën je website optimaliseren voor zichtbaarheid bij AI-crawlers. Leer implementatiestrategieën...

Ontdek hoe pre-rendering je website helpt zichtbaar te zijn in AI-zoekresultaten van ChatGPT, Perplexity en Claude. Begrijp de technische implementatie en voordelen voor AI-zichtbaarheid.

Pre-rendering voor AI-zoekopdrachten is het proces waarbij volledig gerenderde HTML-pagina's worden gegenereerd tijdens de buildfase of via gespecialiseerde diensten, waardoor je content direct toegankelijk wordt voor AI-crawlers zoals die van ChatGPT, Perplexity en Claude zonder dat JavaScript hoeft te worden uitgevoerd.

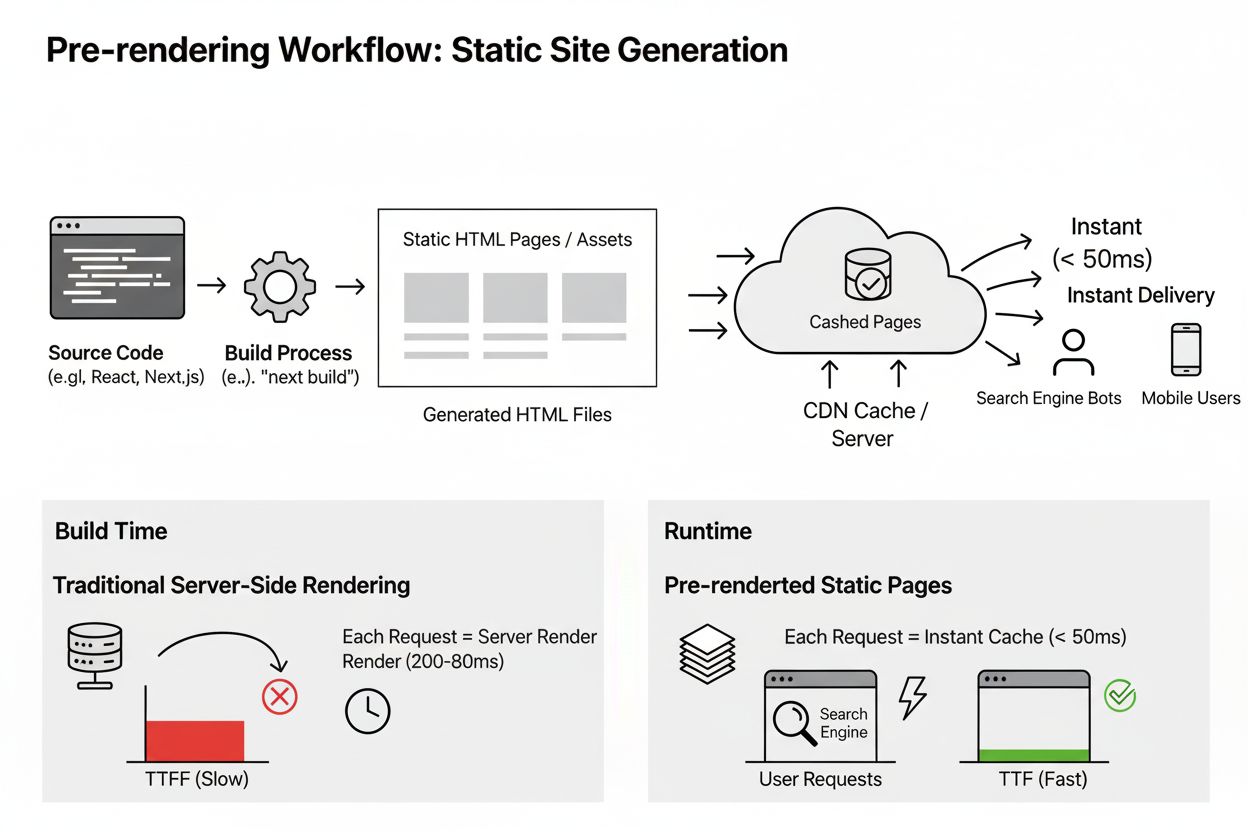

Pre-rendering voor AI-zoekopdrachten is een technische optimalisatiestrategie die volledig gerenderde HTML-pagina’s genereert voordat gebruikers of AI-crawlers deze opvragen. In tegenstelling tot traditionele client-side rendering, waarbij JavaScript wordt uitgevoerd nadat een gebruiker een pagina bezoekt, compileert pre-rendering de inhoud van je website tijdens de buildfase, waardoor statische HTML-bestanden ontstaan die direct toegankelijk zijn voor AI-zoekmachines. Deze aanpak zorgt ervoor dat AI-crawlers van platforms zoals ChatGPT, Perplexity, Claude en Google’s Gemini onmiddellijk toegang hebben tot en je content kunnen lezen zonder te hoeven wachten op de uitvoering van JavaScript. Het fundamentele verschil tussen pre-rendering en andere renderingmethoden zit in de timing: pre-rendering verschuift het rekenwerk van runtime (wanneer gebruikers de site bezoeken) naar buildtime (voor de uitrol), wat resulteert in snellere contentlevering en betere zichtbaarheid op AI-platforms.

AI-crawlers werken fundamenteel anders dan traditionele zoekmachinebots zoals Googlebot. Hoewel Google al jaren JavaScript kan renderen, kunnen de meeste AI-crawlers helemaal geen JavaScript uitvoeren, waardoor ze geen toegang hebben tot content die afhankelijk is van client-side rendering. Onderzoek toont aan dat ongeveer 25% van de AI-crawlers JavaScript kan ophalen, maar het niet kan uitvoeren, wat betekent dat je dynamisch gerenderde content volledig onzichtbaar blijft voor deze systemen. Daarnaast hebben AI-crawlers aanzienlijk kortere time-outvensters—meestal 1-5 seconden—in vergelijking met traditionele zoekbots, en ze wachten niet op trage pagina’s. Dit creëert een cruciaal probleem: als je website afhankelijk is van JavaScript om content weer te geven, kunnen AI-platforms je informatie niet vinden wanneer gebruikers vragen stellen waarop jouw content een antwoord kan bieden. Pre-rendering lost dit op door ervoor te zorgen dat al je belangrijke content beschikbaar is als eenvoudige HTML, waardoor de noodzaak voor JavaScript-uitvoering wordt geëlimineerd en AI-systemen direct toegang krijgen tot je pagina’s.

Pre-rendering werkt via een eenvoudig maar krachtig proces dat de architectuur van je website transformeert. Wanneer je pre-rendering implementeert, genereert je build-systeem tijdens de uitrol volledige HTML-bestanden voor elke pagina van je website, in plaats van deze on-demand te genereren wanneer bezoekers arriveren. Dit betekent dat wanneer een AI-crawler je pagina opvraagt, de server onmiddellijk reageert met volledig gerenderde HTML met alle tekst, koppen, links en gestructureerde data—zonder dat JavaScript hoeft te worden uitgevoerd. Het proces omvat doorgaans drie belangrijke stappen: eerst verwerkt je buildtool (zoals Next.js, Gatsby of Hugo) je broncode en content; ten tweede genereert het statische HTML-bestanden voor elke route of pagina; en ten derde worden deze pre-rendered bestanden gedeployed naar je hostinginfrastructuur. Wanneer een AI-crawler je site bezoekt, ontvangt deze direct de complete, leesklare HTML, waardoor het informatie kan extraheren, je contentstructuur kan begrijpen en mogelijk je website kan citeren in AI-gegenereerde antwoorden. Deze aanpak is bijzonder effectief omdat AI-crawlers 47 keer minder efficiënt zijn dan Googlebot, wat betekent dat ze content zo toegankelijk mogelijk nodig hebben om je pagina’s succesvol te indexeren en te refereren.

Er zijn verschillende benaderingen om pre-rendering voor je website te implementeren, elk met een ander niveau van complexiteit en controle. Static Site Generation (SSG) is de meest eenvoudige methode, waarbij frameworks als Next.js, Gatsby, Hugo en anderen automatisch statische HTML-pagina’s genereren tijdens de buildfase. Deze frameworks regelen het volledige proces automatisch—je hoeft alleen maar te configureren welke pagina’s gepre-renderd moeten worden, en het framework genereert de benodigde HTML-bestanden tijdens de uitrol. Deze methode is ideaal als je een nieuw project start of al een van deze frameworks gebruikt, omdat het minimale extra configuratie vereist en volledige controle biedt over welke pagina’s worden gepre-renderd. Voor websites die al zijn gebouwd met client-side rendering frameworks zoals Create React App, bieden pre-rendering diensten zoals Prerender.io of Netlify Prerendering een alternatieve oplossing. Deze diensten onderscheppen verzoeken van AI-crawlers en serveren hen gepre-renderde versies van je pagina’s, terwijl gewone gebruikers nog steeds de interactieve JavaScript-versie ontvangen. Hoewel deze aanpak meer configuratie vereist en afhankelijk is van externe diensten, kun je hiermee AI-zoekoptimalisatie toevoegen aan bestaande applicaties zonder grote architecturale veranderingen.

| Renderingmethode | Uitvoeringstijdstip | Toegang AI-crawler | Prestaties | Beste voor |

|---|---|---|---|---|

| Client-Side Rendering (CSR) | Runtime (na gebruikersverzoek) | ❌ Beperkt - vereist JavaScript | Tragere initiële laadtijd | Interactieve single-page apps |

| Static Site Generation (SSG) | Buildtime (voor uitrol) | ✅ Volledig - pure HTML | Snelst | Blogs, documentatie, contentwebsites |

| Pre-rendering services | Buildtime via externe dienst | ✅ Volledig - pure HTML | Snel | Bestaande CSR-applicaties |

| Server-Side Rendering (SSR) | Runtime op server | ✅ Volledig - pure HTML | Gemiddeld | Dynamische content met SEO-behoefte |

Een van de meest kritische aspecten van pre-rendering voor AI-zoekopdrachten is ervoor zorgen dat alle belangrijke content leesbaar is zonder JavaScript-uitvoering. Veel moderne websites zijn sterk afhankelijk van JavaScript om content weer te geven, met technieken als lazy loading, dynamische tabbladen, accordeons en andere interactieve elementen die content verbergen achter JavaScript-interacties. AI-crawlers hebben geen toegang tot deze verborgen content omdat ze geen JavaScript uitvoeren. Om te controleren of je content toegankelijk is voor AI-crawlers, kun je browserextensies gebruiken zoals de Rendering Difference Engine, die precies laat zien welke elementen van je pagina onzichtbaar kunnen zijn voor crawlers die geen JavaScript aankunnen. De extensie markeert koppen die achter JavaScript-elementen verborgen zijn, onzichtbare of niet-klikbare links en tekst die JavaScript-rendering vereist om zichtbaar te zijn. Een ander nuttig hulpmiddel is AI Eyes, dat rapporten genereert over hoeveel content verloren gaat als JavaScript is ingeschakeld op je pagina. Door ervoor te zorgen dat alle cruciale informatie—waaronder koppen, productbeschrijvingen, prijzen, contactinformatie en kernboodschappen—beschikbaar is in eenvoudige HTML zonder JavaScript-afhankelijkheden, garandeer je dat AI-crawlers toegang hebben tot en mogelijk je content kunnen citeren in hun antwoorden.

Pre-rendering levert aanzienlijke voordelen op, niet alleen voor AI-zoekzichtbaarheid, maar ook voor je algehele zoekmachineoptimalisatie. Zoekmachines kunnen gepre-renderde pagina’s veel effectiever indexeren omdat ze direct volledige HTML-content ontvangen, zonder JavaScript te hoeven uitvoeren of te wachten op het laden van dynamische content. Dit resulteert in snellere indexering, efficiënter gebruik van het crawlbudget en betere posities in traditionele zoekresultaten. Gepre-renderde websites ervaren doorgaans snellere laadtijden omdat gebruikers volledig gerenderde HTML ontvangen in plaats van een kale HTML-file plus JavaScript die nog moet worden uitgevoerd in de browser. Deze prestatieverbetering heeft direct impact op de gebruikerservaring en zoekresultaten, omdat paginasnelheid een bevestigde rankingfactor is voor zowel Google als andere zoekmachines. Daarnaast elimineert pre-rendering de veelvoorkomende SEO-problemen die gepaard gaan met client-side rendering, zoals slechte meta tag-verwerking, ontbrekende gestructureerde data en onvolledige content-indexering. Door rendering naar buildtime te verschuiven, zorg je ervoor dat elke pagina volledig is geoptimaliseerd voor zoekmachines voordat deze wordt uitgerold, wat resulteert in betere zichtbaarheid op alle zoekplatformen—zowel traditionele zoekmachines als AI-gestuurde zoeksystemen.

Begrijpen hoe verschillende AI-platforms je website benaderen en crawlen is essentieel voor een effectieve pre-renderingstrategie. Verschillende AI-modellen en zelfs verschillende modi van hetzelfde AI-platform kunnen pagina’s op uiteenlopende manieren benaderen. Zo benadert Google’s Gemini App de paginacontent in realtime en kan dit worden gevolgd in serverlogs, terwijl Gemini via de API aangeeft bepaalde pagina’s niet te kunnen bereiken. ChatGPT gaf eerder de voorkeur aan het lezen van Google-zoekfragmenten in plaats van pagina’s direct te benaderen, hoewel dit gedrag mogelijk is veranderd in nieuwere versies. AI-platforms houden geen index bij van bezochte pagina’s of cachen webcontent zoals traditionele zoekmachines doen—ze moeten je pagina elke keer opnieuw bezoeken als ze deze tegenkomen tijdens een externe zoekopdracht om informatie te lezen en te extraheren. Dit betekent dat je pagina’s consequent toegankelijk en leesbaar moeten zijn bij elk bezoek van een AI-crawler. Bovendien benaderen AI-crawlers pagina’s via verschillende mechanismen: sommige gebruiken zoektools die toegang geven tot geïndexeerde content met reeds geparste gestructureerde data, terwijl anderen directe paginatoegangstools gebruiken die mogelijk geen volledige toegang tot JSON-LD gestructureerde data hebben. Om maximale compatibiliteit te waarborgen, moet je ervoor zorgen dat je pagina’s zijn geïndexeerd in Google en Bing, je serverlogs monitoren op directe bezoeken van AI-crawlers, en ervoor zorgen dat alle belangrijke content toegankelijk is zonder JavaScript-afhankelijkheden.

Hoewel de discussie over het effect van gestructureerde data op AI-zoekopdrachten nog gaande is, biedt het implementeren van schema markup naast pre-rendering extra voordelen voor AI-zichtbaarheid. De zichtbaarheid van gestructureerde data verschilt sterk tussen verschillende AI-agenttypen en toegangsmethoden. Wanneer AI-agenten zoektools gebruiken (zoals GPT-5’s web.search of Gemini’s google_search), hebben ze volledige toegang tot je gestructureerde data omdat zoekmachines JSON-LD, microdata en RDFa markup vooraf indexeren, wat rijke, semantisch verbeterde fragmenten met volledige entiteitsinformatie oplevert. Wanneer agenten echter directe paginatoegangstools gebruiken, ontstaat er een cruciale kloof: JSON-LD gestructureerde data wordt grotendeels onzichtbaar en alleen microdata die direct in HTML-attributen is opgenomen, blijft toegankelijk tijdens directe pagina-analyse. Ondanks deze inconsistentie blijft het implementeren van schema markup aanbevolen omdat het een redelijke kans biedt om te helpen, het geen kwaad kan doen en het weinig tijd kost om te implementeren. Je kunt gratis schema generators gebruiken voor veelvoorkomende types zoals Organisatie-schema, Persoon/Auteur-schema, FAQ-schema en Dataset-schema om snel gestructureerde data toe te voegen aan je gepre-renderde pagina’s.

Na het implementeren van pre-rendering is het van cruciaal belang om te monitoren hoe je content verschijnt in AI-zoekresultaten op verschillende platforms. Het volgen van je merk, domein en specifieke URL’s in AI-gegenereerde antwoorden van ChatGPT, Perplexity, Claude en andere AI-zoekmachines helpt je te begrijpen of je pre-rendering-inspanningen effectief zijn. Je dient regelmatig te controleren of je website wordt geciteerd in AI-antwoorden op relevante zoekopdrachten, te verifiëren of de geciteerde informatie accuraat en up-to-date is en kansen te identificeren om je content te verbeteren voor betere AI-zichtbaarheid. Serverlogs bieden waardevolle inzichten in AI-crawleractiviteit—je kunt zien welke pagina’s worden bezocht, hoe vaak crawlers langskomen en of ze je content succesvol ophalen. Door pre-rendering te combineren met actieve monitoring van je AI-zoekaanwezigheid, zorg je ervoor dat je website zichtbaar en relevant blijft naarmate AI-gestuurde zoekopdrachten aan belang blijven winnen.

Volg waar je domein, merk en URL's verschijnen in AI-gegenereerde antwoorden op alle grote AI-platforms. Krijg realtime inzicht in je AI-zichtbaarheid en zorg ervoor dat je content correct wordt geciteerd.

Ontdek wat AI-prerendering is en hoe server-side renderingstrategieën je website optimaliseren voor zichtbaarheid bij AI-crawlers. Leer implementatiestrategieën...

Pre-rendering genereert statische HTML-pagina's tijdens de build-fase voor directe levering en verbeterde SEO. Ontdek hoe deze techniek voordelen biedt voor AI-...

Ontdek hoe JavaScript-rendering de zichtbaarheid van je website beïnvloedt in AI-zoekmachines zoals ChatGPT, Perplexity en Claude. Lees waarom AI-crawlers moeit...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.