AI Bronselectie

Ontdek hoe AI-systemen bronnen selecteren en rangschikken voor citaties. Leer over de algoritmes, signalen en factoren die bepalen welke websites AI-platformen ...

Leer over bronselectiebias in AI, hoe het machine learning-modellen beïnvloedt, praktijkvoorbeelden en strategieën om dit belangrijke eerlijkheidsprobleem te detecteren en te mitigeren.

Bronselectiebias treedt op wanneer trainingsdata niet representatief is voor de volledige populatie of de werkelijke verdeling, waardoor AI-modellen onnauwkeurige voorspellingen doen voor ondervertegenwoordigde groepen of scenario's.

Bronselectiebias is een fundamenteel probleem in kunstmatige intelligentie dat optreedt wanneer de data die wordt gebruikt om machine learning-modellen te trainen niet accuraat de werkelijke populatie of verdeling weerspiegelt waarvoor ze bedoeld zijn. Dit type bias ontstaat wanneer datasets op een manier worden gekozen die systematisch bepaalde groepen, scenario’s of kenmerken uitsluit of ondervertegenwoordigt. Het gevolg is dat AI-modellen patronen leren uit onvolledige of scheve data, wat leidt tot voorspellingen die onnauwkeurig, oneerlijk of discriminerend zijn tegenover ondervertegenwoordigde populaties. Inzicht in deze bias is essentieel voor iedereen die AI-systemen ontwikkelt, inzet of erop vertrouwt, omdat het direct invloed heeft op de eerlijkheid, nauwkeurigheid en betrouwbaarheid van geautomatiseerde besluitvorming in diverse sectoren.

Bronselectiebias verschilt van andere vormen van bias omdat het ontstaat in de fase van dataverzameling zelf. In plaats van voort te komen uit algoritmische keuzes of menselijke aannames tijdens de ontwikkeling van het model, zit bronselectiebias ingebakken in de basis van de trainingsdataset. Dit maakt het bijzonder verraderlijk, omdat modellen die getraind zijn op bevooroordeelde brondata deze biases in hun voorspellingen zullen voortzetten en versterken, ongeacht hoe geavanceerd het algoritme is. Het probleem wordt nog kritieker wanneer AI-systemen worden ingezet in sectoren met grote maatschappelijke impact, zoals de gezondheidszorg, financiën, het strafrecht en werving, waar bevooroordeelde voorspellingen ernstige gevolgen kunnen hebben voor individuen en gemeenschappen.

Bronselectiebias ontstaat via verschillende mechanismen tijdens het verzamelen en samenstellen van data. De meest voorkomende weg is via dekkingsbias, waarbij bepaalde populaties of scenario’s systematisch worden uitgesloten uit de trainingsdataset. Bijvoorbeeld, als een gezichtsherkenningssysteem voornamelijk wordt getraind op afbeeldingen van mensen met een lichte huid, zal het een slechte dekking hebben van gezichten met een donkere huid, wat leidt tot hogere foutpercentages voor die populaties. Dit gebeurt omdat dataverzamelaars mogelijk beperkte toegang hebben tot diverse populaties, of onbewust bepaalde groepen prioriteren bij het verzamelen van data.

Een ander belangrijk mechanisme is non-responsbias, ook wel participatiebias genoemd, die optreedt wanneer bepaalde groepen minder geneigd zijn deel te nemen aan dataverzamelingsprocessen. Denk aan een dataset op basis van enquêtes om consumentvoorkeuren te voorspellen: als bepaalde demografische groepen aanzienlijk minder geneigd zijn om op enquêtes te reageren, zullen hun voorkeuren ondervertegenwoordigd zijn in de trainingsdata. Dit creëert een dataset die gebalanceerd lijkt, maar in werkelijkheid participatiepatronen weerspiegelt in plaats van de ware populatiekenmerken. In de gezondheidszorg bijvoorbeeld, als klinische proefdata voornamelijk afkomstig is van stedelijke populaties met toegang tot geavanceerde medische faciliteiten, zullen de resulterende AI-modellen mogelijk niet goed generaliseren naar landelijke of minder bedeelde gemeenschappen.

Steekproefbias is een derde mechanisme waarbij geen goede randomisatie wordt toegepast tijdens het verzamelen van data. In plaats van willekeurig gegevenspunten te selecteren, kiezen verzamelaars mogelijk de eerste beschikbare voorbeelden of gebruiken ze gemakzuchtige steekproeven. Dit introduceert systematische fouten omdat de gekozen voorbeelden niet representatief zijn voor de bredere populatie. Bijvoorbeeld, als een AI-model voor het voorspellen van wanbetalingen op leningen wordt getraind op data die is verzameld uit een specifieke geografische regio of tijdsperiode, kan het mogelijk niet accuraat voorspellen in andere regio’s of tijdens andere economische omstandigheden.

| Type Bias | Mechanisme | Praktijkvoorbeeld |

|---|---|---|

| Dekkingsbias | Systematische uitsluiting van populaties | Gezichtsherkenning getraind op alleen lichte gezichten |

| Non-responsbias | Participatieverschillen bij dataverzameling | Gezondheidszorgmodellen getraind op alleen stedelijke populaties |

| Steekproefbias | Onjuiste randomisatie bij selectie | Leningvoorspellingsmodellen getraind op één geografische regio |

| Tijdsbias | Data uit specifieke tijdsperiodes | Modellen getraind op pre-pandemische data, toegepast na de pandemie |

| Brondiversiteitsbias | Beperkte databronnen | Medische beeldvormingsdatasets van één ziekenhuis |

De gevolgen van bronselectiebias in AI-systemen zijn diepgaand en verstrekkend, met impact op zowel individuen als organisaties. In de gezondheidszorg heeft bronselectiebias geleid tot diagnostische systemen die aanzienlijk slechter presteren bij bepaalde patiëntpopulaties. Onderzoek heeft aangetoond dat AI-algoritmen voor het diagnosticeren van huidkanker aanzienlijk lagere nauwkeurigheid behalen bij patiënten met een donkere huid, waarbij sommige studies slechts ongeveer de helft van de diagnostische nauwkeurigheid tonen ten opzichte van patiënten met een lichte huid. Dit verschil leidt direct tot vertraagde diagnoses, onjuiste behandeladviezen en slechtere gezondheidsresultaten voor ondervertegenwoordigde populaties. Wanneer trainingsdata voornamelijk afkomstig is van patiënten uit één demografische groep, leren de resulterende modellen patronen die specifiek zijn voor die groep en falen ze te generaliseren naar anderen.

In de financiële dienstverlening heeft bronselectiebias in kredietbeoordelings- en leensystemen historische discriminatie in stand gehouden. Modellen die getraind zijn op historische gegevens van leningen die bestaande discriminerende praktijken weerspiegelen, zullen dezelfde biases herhalen bij nieuwe beslissingen over kredietverlening. Als bepaalde groepen historisch gezien krediet werden geweigerd door systemische discriminatie, en deze historische data wordt gebruikt om AI-modellen te trainen, zullen de modellen leren om vergelijkbare groepen in de toekomst ook krediet te weigeren. Dit creëert een vicieuze cirkel waarbij historische ongelijkheden worden ingebed in algoritmische besluitvorming, met gevolgen voor de toegang tot kapitaal en economische kansen.

Werving en selectie is een ander belangrijk domein waar bronselectiebias aanzienlijke schade veroorzaakt. AI-tools die worden gebruikt bij het screenen van cv’s blijken vooroordelen op basis van waargenomen ras en geslacht te vertonen, waarbij uit onderzoeken blijkt dat namen die geassocieerd worden met witte personen in sommige systemen tot 85% vaker werden gekozen. Wanneer trainingsdata afkomstig is uit historische personeelsbestanden die bestaande discriminatie of homogene aannamepatronen weerspiegelen, leren de resulterende AI-modellen deze patronen te herhalen. Dit betekent dat bronselectiebias in wervingsdata discriminatie op de werkvloer op grote schaal in stand houdt, waardoor kansen voor ondervertegenwoordigde groepen worden beperkt en de diversiteit op de werkvloer afneemt.

In het strafrecht heeft bronselectiebias in voorspellende politiezorgsystemen geleid tot onevenredige aandacht voor bepaalde gemeenschappen. Wanneer trainingsdata afkomstig is uit historische arrestatiegegevens die zelf al bevooroordeeld zijn ten opzichte van gemarginaliseerde groepen, versterken de resulterende modellen deze biases door hogere criminaliteitscijfers te voorspellen in die gemeenschappen. Dit creëert een feedbacklus waarbij bevooroordeelde voorspellingen leiden tot meer politie-inzet in bepaalde gebieden, wat weer leidt tot meer arrestatiegegevens uit die gebieden, waardoor de bias in het model verder wordt versterkt.

Het detecteren van bronselectiebias vereist een systematische aanpak die kwantitatieve analyse, kwalitatieve evaluatie en voortdurende monitoring gedurende de hele levenscyclus van het model combineert. De eerste stap is het uitvoeren van een uitgebreide data-audit waarin de bronnen, verzamelmethoden en representativiteit van uw trainingsdata worden onderzocht. Dit omvat het documenteren van waar de data vandaan kwam, hoe deze werd verzameld en of het verzamelproces mogelijk systematisch bepaalde populaties of scenario’s heeft uitgesloten. Stel kritische vragen: Waren alle relevante demografische groepen vertegenwoordigd in het dataverzamelingsproces? Waren er participatiebarrières die bepaalde groepen konden ontmoedigen om deel te nemen? Heeft de verzamelperiode of de geografische reikwijdte de representatie beperkt?

Demografische pariteitsanalyse biedt een kwantitatieve methode om bronselectiebias op te sporen. Hierbij wordt de verdeling van belangrijke kenmerken in uw trainingsdata vergeleken met de verdeling in de werkelijke populatie die uw model moet bedienen. Als uw trainingsdata bepaalde demografische groepen, leeftijdsklassen, geografische regio’s of andere relevante kenmerken significant ondervertegenwoordigt, is er sprake van bronselectiebias. Bijvoorbeeld, als uw trainingsdata slechts 5% vrouwen bevat, terwijl de doelgroep 50% vrouw is, wijst dit op een ernstige dekkingsbias die waarschijnlijk zal resulteren in slechte modelprestaties voor vrouwen.

Uitgesplitste prestatieanalyse is een andere belangrijke detectietechniek waarbij u de prestaties van uw model afzonderlijk voor verschillende demografische groepen en subpopulaties evalueert. Zelfs als de algemene nauwkeurigheid van het model acceptabel lijkt, kunnen de prestaties sterk variëren tussen groepen. Als uw model bijvoorbeeld 95% nauwkeurigheid behaalt in het algemeen, maar slechts 70% voor een bepaalde demografische groep, duidt dit erop dat bronselectiebias in de trainingsdata ertoe heeft geleid dat het model patronen heeft geleerd die specifiek zijn voor de meerderheidsgroep, terwijl het faalt bij de minderheidsgroep. Deze analyse moet niet alleen worden uitgevoerd op algemene nauwkeurigheid, maar ook op eerlijkheidsstatistieken zoals equalized odds en disparate impact.

Adversariële testing houdt in dat u bewust testgevallen creëert om potentiële biases aan het licht te brengen. Dit kan bijvoorbeeld door uw model te testen op data van ondervertegenwoordigde populaties, randgevallen of scenario’s die slecht vertegenwoordigd zijn in de trainingsdata. Door uw model te ‘stress-testen’ met diverse inputs, kunt u zien waar bronselectiebias blinde vlekken heeft veroorzaakt. Als uw model bijvoorbeeld voornamelijk is getraind op data uit stedelijke gebieden, test het dan uitvoerig op data uit landelijke gebieden om te zien of de prestaties verslechteren. Als uw trainingsdata uit een specifieke tijdsperiode komt, test het model dan op data uit andere periodes om tijdsbias te detecteren.

Het mitigeren van bronselectiebias vereist ingrepen in meerdere fasen van de AI-ontwikkelcyclus, te beginnen bij dataverzameling en doorlopend tot model-evaluatie en -uitrol. De meest effectieve aanpak is data-centrische mitigatie, waarbij bias wordt aangepakt bij de bron door de kwaliteit en representativiteit van trainingsdata te verbeteren. Dit begint met diverse dataverzameling waarbij u actief werkt aan het opnemen van ondervertegenwoordigde populaties en scenario’s in uw trainingsdataset. In plaats van te vertrouwen op gemakzuchtige steekproeven of bestaande datasets, zouden organisaties gerichte inspanningen moeten leveren om voldoende vertegenwoordiging van alle relevante demografische groepen en use cases te waarborgen.

Herschalings- en herwegingsmethoden bieden praktische manieren om onbalans in bestaande datasets aan te pakken. Willekeurig oversamplen dupliceert voorbeelden van ondervertegenwoordigde groepen, terwijl willekeurig undersamplen voorbeelden van oververtegenwoordigde groepen vermindert. Geavanceerdere methoden zoals gestratificeerde steekproeven zorgen voor proportionele vertegenwoordiging over meerdere dimensies tegelijk. Herweging kent een hogere waarde toe aan ondervertegenwoordigde voorbeelden tijdens het trainen van het model, waardoor het algoritme effectief wordt aangemoedigd om beter te letten op patronen in minderheidsgroepen. Deze technieken werken het beste in combinatie met inspanningen om meer diverse data te verzamelen, in plaats van uitsluitend te vertrouwen op herschaling van beperkte data.

Synthetische datageneratie biedt een ander pad om bronselectiebias aan te pakken, vooral als het moeilijk of duur is om echte data te verzamelen van ondervertegenwoordigde populaties. Technieken zoals Generative Adversarial Networks (GANs) en Variational Autoencoders (VAEs) kunnen realistische synthetische voorbeelden creëren voor ondervertegenwoordigde groepen. Meer gerichte methoden zoals SMOTE (Synthetic Minority Over-sampling Technique) maken synthetische voorbeelden door te interpoleren tussen bestaande minderheidsvoorbeelden. Synthetische data moet echter zorgvuldig worden gebruikt en grondig gevalideerd, omdat het zelf ook bias kan introduceren als het niet goed wordt gegenereerd.

Eerlijkheidsbewuste algoritmen vormen een andere mitigatiestrategie die wordt ingezet tijdens het trainen van het model. Deze algoritmen nemen expliciet eerlijkheidsbeperkingen op in het leerproces, zodat het model acceptabele prestaties behaalt voor alle demografische groepen, niet alleen voor de meerderheidsgroep. Adversariële debiasing gebruikt bijvoorbeeld een adversair netwerk om ervoor te zorgen dat de voorspellingen van het model niet kunnen worden gebruikt om beschermde kenmerken zoals ras of geslacht te achterhalen. Eerlijkheidsbewuste regularisatie voegt boetetermen toe aan de verliesfunctie die discriminatoir gedrag ontmoedigen. Deze benaderingen stellen u in staat om expliciet een afweging te maken tussen algehele nauwkeurigheid en eerlijkheid, afhankelijk van uw ethische prioriteiten.

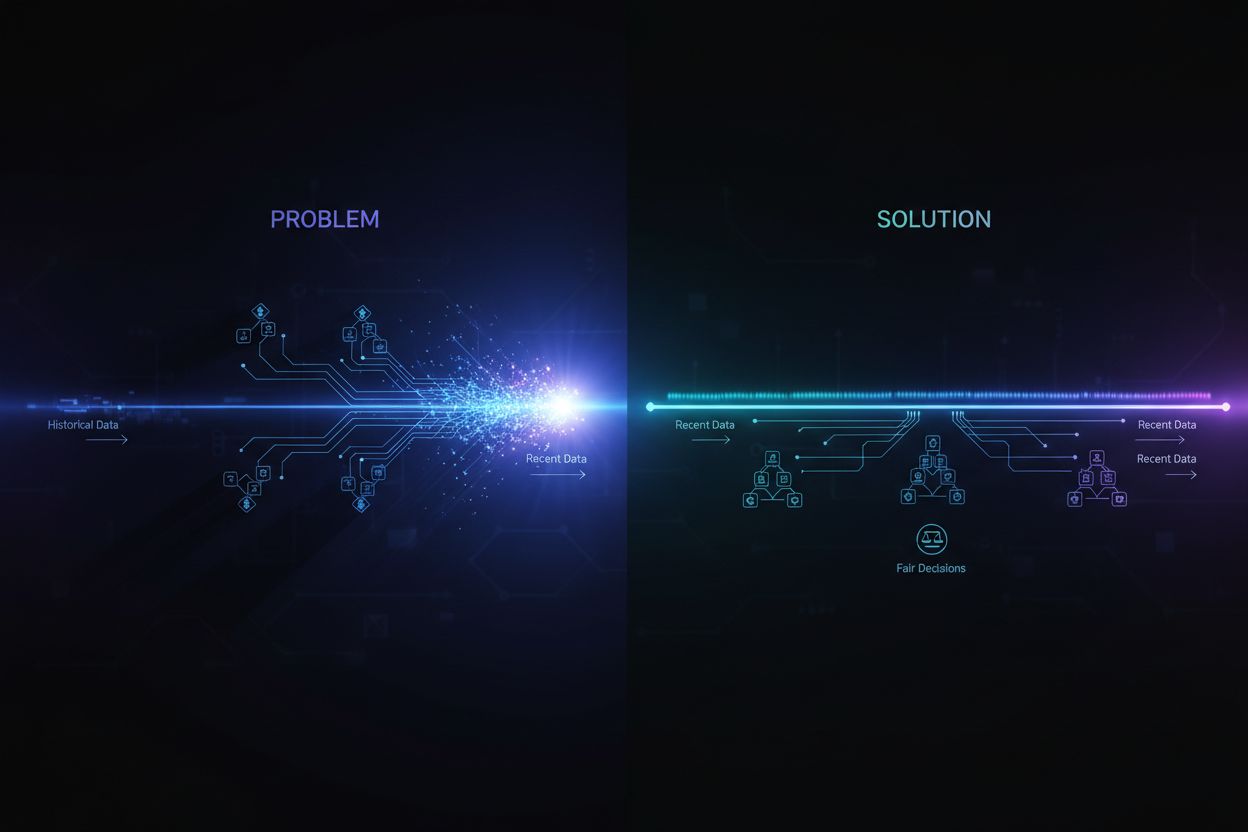

Continue monitoring en hertraining zorgen ervoor dat bronselectiebias niet ontstaat of verergert in de loop van de tijd. Zelfs als uw initiële trainingsdata representatief is, kan de werkelijke verdeling die uw model bedient veranderen door demografische verschuivingen, economische veranderingen of andere factoren. Door prestatiemonitoringsystemen te implementeren die de modelnauwkeurigheid afzonderlijk voor verschillende demografische groepen bijhouden, kunt u zien wanneer bias ontstaat. Wanneer prestatievermindering wordt gedetecteerd, kan hertraining met bijgewerkte data die de huidige populatieverdeling weerspiegelt de eerlijkheid herstellen. Dit voortdurende proces onderstreept dat mitigatie van bias geen eenmalige inspanning is, maar een blijvende verantwoordelijkheid.

Het begrijpen van bronselectiebias wordt steeds belangrijker in de context van AI-antwoordenmonitoring en merkaanwezigheidstracking. Nu AI-systemen zoals ChatGPT, Perplexity en andere AI-antwoordsystemen steeds vaker de primaire informatiebron voor gebruikers vormen, worden de bronnen die deze systemen citeren en de informatie die ze presenteren bepaald door hun trainingsdata. Als de trainingsdata die zijn gebruikt voor deze AI-systemen bronselectiebias bevatten, zullen de antwoorden die ze genereren die bias weerspiegelen. Bijvoorbeeld, als de trainingsdata van een AI-systeem bepaalde websites, publicaties of perspectieven oververtegenwoordigen en andere ondervertegenwoordigen, zal het AI-systeem eerder informatie van de oververtegenwoordigde bronnen citeren en versterken.

Dit heeft directe gevolgen voor merkmonitoring en contentzichtbaarheid. Als uw merk, domein of URL’s ondervertegenwoordigd zijn in de trainingsdata van grote AI-systemen, kan uw content systematisch worden uitgesloten of onderbelicht in AI-gegenereerde antwoorden. Omgekeerd, als concurrerende merken of bronnen van desinformatie oververtegenwoordigd zijn in de trainingsdata, krijgen zij een onevenredige zichtbaarheid in AI-antwoorden. Door te monitoren hoe uw merk verschijnt in AI-gegenereerde antwoorden op verschillende platforms, krijgt u inzicht in de vraag of bronselectiebias in deze systemen uw zichtbaarheid en reputatie beïnvloedt. Door bij te houden welke bronnen worden geciteerd, hoe vaak uw content verschijnt en of de gepresenteerde informatie accuraat is, kunt u potentiële biases identificeren in hoe AI-systemen uw merk en branche weergeven.

Bronselectiebias in AI is een kritiek eerlijkheidsprobleem dat ontstaat in de fase van dataverzameling en doorwerkt in alle volgende toepassingen van machine learning-modellen. Het ontstaat wanneer trainingsdata systematisch bepaalde populaties, scenario’s of kenmerken uitsluit of ondervertegenwoordigt, wat resulteert in modellen die onnauwkeurige of oneerlijke voorspellingen doen voor ondervertegenwoordigde groepen. De gevolgen zijn ernstig en breed, met impact op gezondheidszorgresultaten, toegang tot financiële middelen, werkgelegenheidskansen en beslissingen in het strafrecht. Het detecteren van bronselectiebias vereist uitgebreide data-audits, demografische pariteitsanalyse, uitgesplitste prestatieanalyse en adversariële testing. Het mitigeren van deze bias vergt een veelzijdige aanpak, waaronder diverse dataverzameling, herschaling en herweging, synthetische datageneratie, eerlijkheidsbewuste algoritmen en continue monitoring. Organisaties moeten erkennen dat het aanpakken van bronselectiebias niet optioneel is, maar essentieel voor het bouwen van AI-systemen die eerlijk, accuraat en betrouwbaar zijn voor alle populaties en use cases.

Zorg ervoor dat uw merk accuraat verschijnt in AI-gegenereerde antwoorden op ChatGPT, Perplexity en andere AI-platforms. Volg hoe AI-systemen uw content citeren en identificeer potentiële biases in AI-antwoorden.

Ontdek hoe AI-systemen bronnen selecteren en rangschikken voor citaties. Leer over de algoritmes, signalen en factoren die bepalen welke websites AI-platformen ...

Ontdek hoe AI-systemen beslissen tussen het citeren van meerdere bronnen of het concentreren op gezaghebbende bronnen. Begrijp citeerpatronen bij ChatGPT, Googl...

Lees meer over recency bias in AI-systemen, hoe het de zichtbaarheid van content, aanbevelingsalgoritmen en zakelijke beslissingen beïnvloedt. Ontdek mitigaties...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.