Hoe voer je een AI Zichtbaarheid Audit uit: Complete Methodologie

Leer de complete stapsgewijze methodologie voor het uitvoeren van een AI zichtbaarheid audit. Ontdek hoe je merkvermeldingen, citaties en zichtbaarheid meet ove...

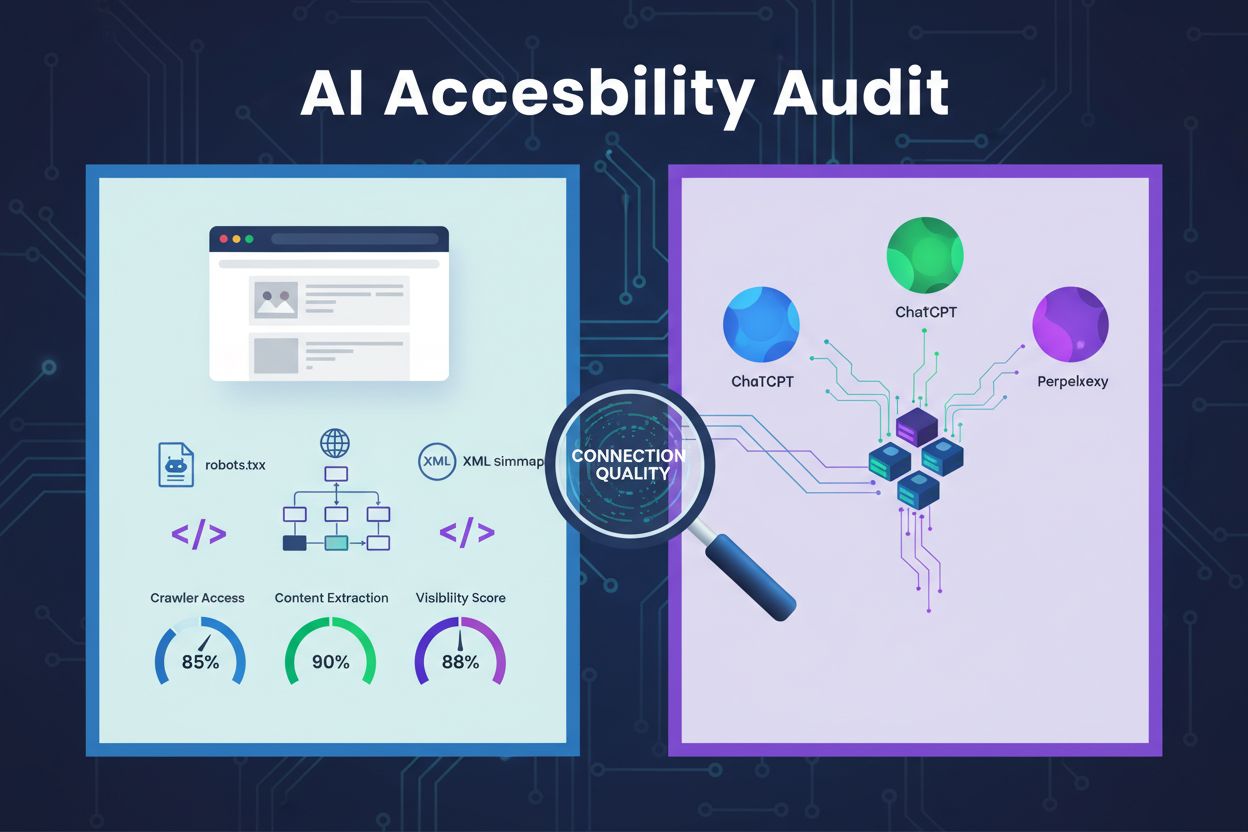

Een technische beoordeling van de websitearchitectuur, configuratie en contentstructuur om te bepalen of AI-crawlers effectief toegang hebben tot, begrip hebben van en content kunnen extraheren. Evalueert robots.txt-configuratie, XML-sitemaps, site-crawbaarheid, JavaScript-rendering en contentextractiemogelijkheid om zichtbaarheid te waarborgen op AI-aangedreven zoekplatforms zoals ChatGPT, Claude en Perplexity.

Een technische beoordeling van de websitearchitectuur, configuratie en contentstructuur om te bepalen of AI-crawlers effectief toegang hebben tot, begrip hebben van en content kunnen extraheren. Evalueert robots.txt-configuratie, XML-sitemaps, site-crawbaarheid, JavaScript-rendering en contentextractiemogelijkheid om zichtbaarheid te waarborgen op AI-aangedreven zoekplatforms zoals ChatGPT, Claude en Perplexity.

Een AI-toegankelijkheidsaudit is een technische beoordeling van de architectuur, configuratie en contentstructuur van je website om te bepalen of AI-crawlers effectief toegang kunnen krijgen tot, begrip hebben van en jouw content kunnen extraheren. In tegenstelling tot traditionele SEO-audits die zich richten op zoekwoordrangschikkingen en backlinks, onderzoeken AI-toegankelijkheidsaudits de technische fundamenten die AI-systemen zoals ChatGPT, Claude en Perplexity in staat stellen om jouw content te ontdekken en te citeren. Deze audit evalueert kritieke componenten zoals robots.txt-configuratie, XML-sitemaps, site-crawbaarheid, JavaScript-rendering en contentextractiemogelijkheid om ervoor te zorgen dat je website volledig zichtbaar is binnen het AI-aangedreven zoekeccosysteem.

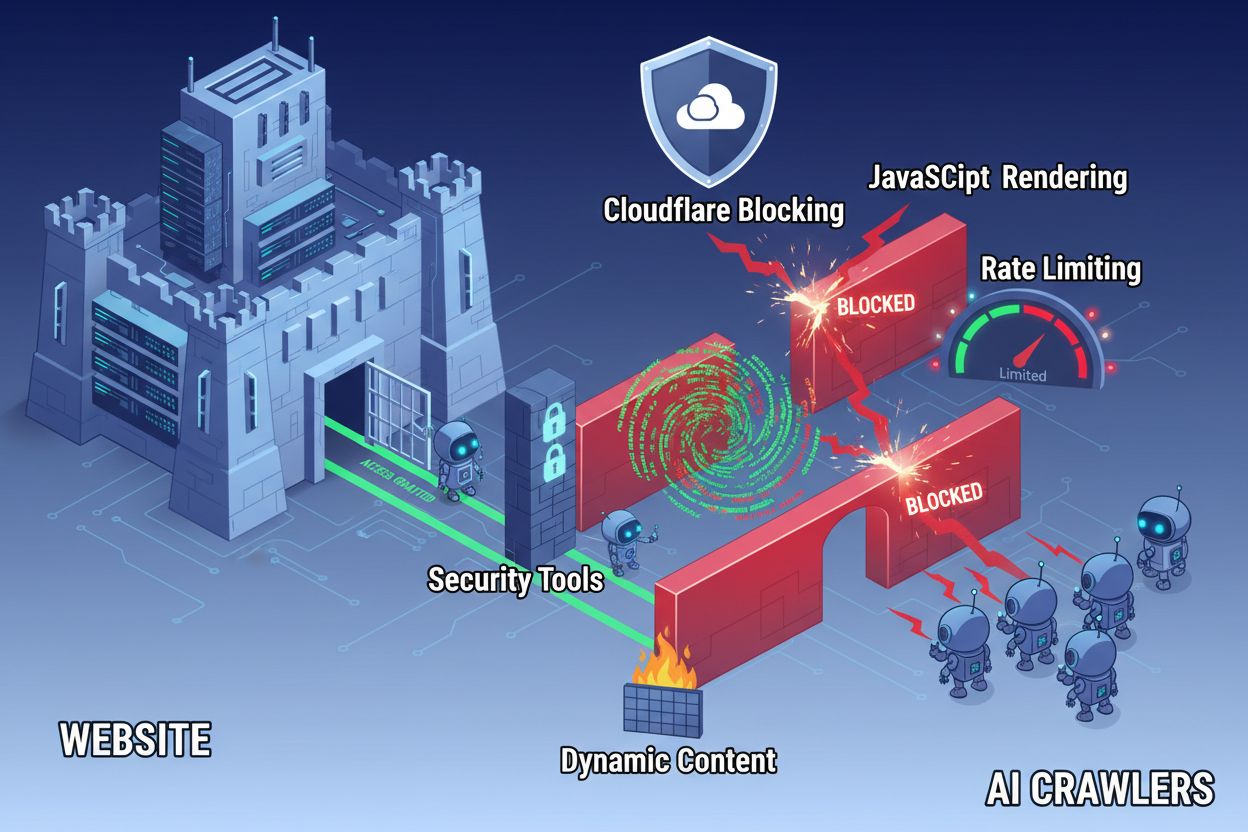

Ondanks de vooruitgang in webtechnologie ondervinden AI-crawlers aanzienlijke barrières bij het benaderen van moderne websites. De belangrijkste uitdaging is dat veel hedendaagse websites sterk leunen op JavaScript-rendering om content dynamisch te tonen, maar de meeste AI-crawlers kunnen geen JavaScript-code uitvoeren. Dit betekent dat ongeveer 60-90% van de moderne website-inhoud onzichtbaar blijft voor AI-systemen, zelfs als het perfect zichtbaar is in de browser voor gebruikers. Daarnaast blokkeren beveiligingstools zoals Cloudflare standaard AI-crawlers en behandelen ze als mogelijke dreigingen in plaats van legitieme indexeerbots. Onderzoek toont aan dat 35% van de bedrijfswebsites AI-crawlers onbedoeld blokkeert, waardoor waardevolle content niet wordt ontdekt en geciteerd door AI-systemen.

Veelvoorkomende barrières die AI-crawlertoegang verhinderen zijn:

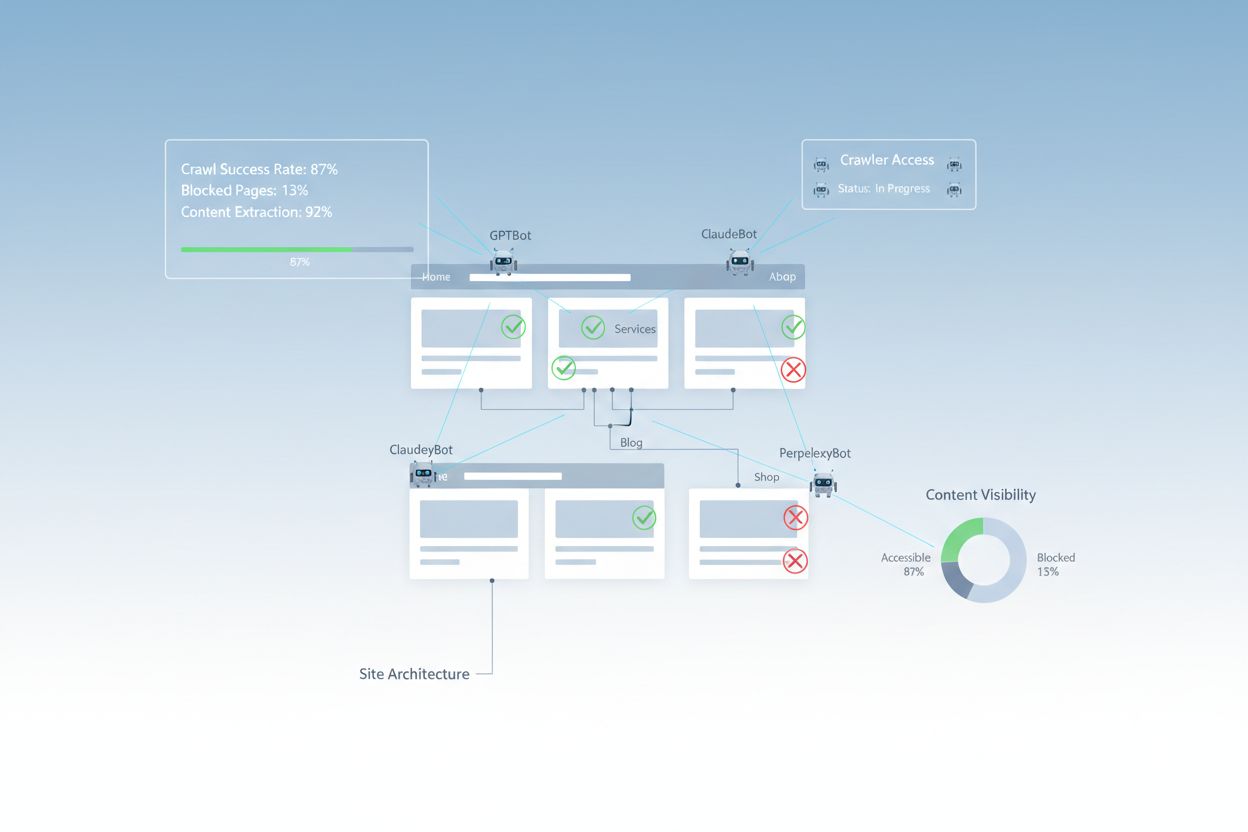

Een volledige AI-toegankelijkheidsaudit onderzoekt meerdere technische en structurele elementen die bepalen hoe AI-systemen met je website interageren. Elk onderdeel speelt een unieke rol bij het zichtbaar maken van je content voor AI-aangedreven zoekplatforms. Het auditproces omvat het testen van de crawbaarheid, het verifiëren van configuratiebestanden, het beoordelen van de contentstructuur en het monitoren van het werkelijke gedrag van crawlers. Door deze componenten systematisch te evalueren, kun je specifieke barrières identificeren en gerichte oplossingen implementeren om je AI-zichtbaarheid te verbeteren.

| Component | Doel | Impact op AI-zichtbaarheid |

|---|---|---|

| Robots.txt-configuratie | Bepaalt welke crawlers toegang hebben tot specifieke sitegedeelten | Kritisch - Verkeerde configuratie blokkeert AI-crawlers volledig |

| XML-sitemaps | Stuurt crawlers naar belangrijke pagina’s en contentstructuur | Hoog - Helpt AI-systemen content te prioriteren en ontdekken |

| Site-crawbaarheid | Zorgt dat pagina’s toegankelijk zijn zonder authenticatie of complexe navigatie | Kritisch - Geblokkeerde pagina’s zijn onzichtbaar voor AI-systemen |

| JavaScript-rendering | Bepaalt of dynamische content zichtbaar is voor crawlers | Kritisch - 60-90% van content kan worden gemist zonder prerendering |

| Contentextractie | Beoordeelt hoe gemakkelijk AI-systemen content kunnen ontleden en begrijpen | Hoog - Slechte structuur verlaagt kans op citeren |

| Beveiligingstoolconfiguratie | Beheert firewall- en beschermingsregels die crawlertoegang beïnvloeden | Kritisch - Te strenge regels blokkeren legitieme AI-bots |

| Schema markup-implementatie | Biedt machineleesbare context over content | Middel - Verbetert AI-begrip en kans op citeren |

| Interne linkstructuur | Legt semantische relaties tussen pagina’s | Middel - Helpt AI onderwerpautoriteit en relevantie begrijpen |

Je robots.txt-bestand is het primaire mechanisme om te bepalen welke crawlers toegang krijgen tot je website. Dit eenvoudige tekstbestand staat in de root van je domein en bevat instructies die crawlers vertellen tot welke gedeelten ze toegang hebben. Voor AI-toegankelijkheid is een juiste robots.txt-configuratie essentieel, omdat verkeerde regels grote AI-crawlers zoals GPTBot (OpenAI), ClaudeBot (Anthropic) en PerplexityBot (Perplexity) volledig kunnen blokkeren. Het is belangrijk deze crawlers expliciet toe te staan en tegelijkertijd de veiligheid te waarborgen door kwaadwillende bots te blokkeren en gevoelige delen te beschermen.

Voorbeeld robots.txt-configuratie voor AI-crawlers:

# Sta alle AI-crawlers toe

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ClaudeBot

User-agent: Claude-Web

User-agent: PerplexityBot

User-agent: Google-Extended

Allow: /

# Blokkeer gevoelige gebieden

Disallow: /admin/

Disallow: /private/

Disallow: /api/

# Sitemaps

Sitemap: https://jouwsite.com/sitemap.xml

Sitemap: https://jouwsite.com/ai-sitemap.xml

Deze configuratie staat grote AI-crawlers expliciet toe toegang te krijgen tot je publieke content, terwijl administratieve en privésecties beschermd blijven. De Sitemap-regels helpen crawlers om snel je belangrijkste pagina’s te vinden.

Een XML-sitemap fungeert als routekaart voor crawlers en somt de URL’s op die je geïndexeerd wilt hebben, met metadata per pagina. Voor AI-systemen zijn sitemaps bijzonder waardevol omdat ze crawlers helpen je site-structuur te begrijpen, belangrijke content te prioriteren en pagina’s te ontdekken die anders gemist worden via standaard crawlen. In tegenstelling tot traditionele zoekmachines die site-structuur uit links kunnen afleiden, profiteren AI-crawlers sterk van expliciete sturing naar de belangrijkste pagina’s. Een goed gestructureerde sitemap met juiste metadata vergroot de kans dat je content wordt ontdekt, begrepen en geciteerd door AI-systemen.

Voorbeeld XML-sitemapstructuur voor AI-optimalisatie:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<!-- Content met hoge prioriteit voor AI-crawlers -->

<url>

<loc>https://jouwsite.com/over</loc>

<lastmod>2025-01-03</lastmod>

<priority>1.0</priority>

</url>

<url>

<loc>https://jouwsite.com/producten</loc>

<lastmod>2025-01-03</lastmod>

<priority>0.9</priority>

</url>

<url>

<loc>https://jouwsite.com/blog/ai-gids</loc>

<lastmod>2025-01-02</lastmod>

<priority>0.8</priority>

</url>

<url>

<loc>https://jouwsite.com/faq</loc>

<lastmod>2025-01-01</lastmod>

<priority>0.7</priority>

</url>

</urlset>

Het priority-attribuut geeft aan welke pagina’s het belangrijkst zijn voor AI-crawlers, terwijl lastmod de actualiteit van de content aanduidt. Dit helpt AI-systemen om crawlresources effectief in te zetten en je contenthiërarchie te begrijpen.

Naast configuratiebestanden zijn er verschillende technische barrières die effectieve toegang van AI-crawlers tot je content belemmeren. JavaScript-rendering blijft de grootste uitdaging, omdat moderne webframeworks zoals React, Vue en Angular content dynamisch in de browser genereren, waardoor AI-crawlers vaak alleen lege HTML zien. Cloudflare en vergelijkbare beveiligingstools blokkeren standaard vaak AI-crawlers, omdat hun hoge volume aan verzoeken als aanval gezien wordt. Rate limiting kan een volledige indexatie verhinderen, terwijl complexe site-architectuur en dynamisch ladende content crawlertoegang verder bemoeilijken. Gelukkig zijn er meerdere oplossingen om deze barrières te overwinnen.

Oplossingen om AI-crawlertoegang te verbeteren:

AI-systemen moeten niet alleen toegang krijgen tot je content—ze moeten deze ook begrijpen. Contentextractie verwijst naar hoe effectief AI-crawlers informatie van je pagina’s kunnen ontleden, begrijpen en extraheren. Dit hangt sterk af van een semantische HTML-structuur, waarbij juiste heading-hiërarchieën, beschrijvende tekst en logische organisatie betekenis overbrengen. Wanneer je content goed is gestructureerd met duidelijke koppen (H1, H2, H3), beschrijvende alinea’s en een logische opbouw, kunnen AI-systemen makkelijker belangrijke informatie en context herkennen. Daarnaast levert schema markup machineleesbare metadata die AI-systemen expliciet vertelt waar je content over gaat, wat het begrip en de kans op citeren aanzienlijk verhoogt.

Een correcte semantische structuur houdt ook in dat je semantische HTML-elementen gebruikt zoals <article>, <section>, <nav> en <aside> in plaats van generieke <div>-tags. Dit helpt AI-systemen het doel en belang van verschillende contentdelen te begrijpen. In combinatie met gestructureerde data zoals FAQ-schema, Product-schema of Organisatie-schema wordt je content aanzienlijk toegankelijker voor AI-systemen, wat de kans vergroot om te worden opgenomen in AI-gegenereerde antwoorden.

Na het doorvoeren van verbeteringen is het belangrijk te verifiëren dat AI-crawlers daadwerkelijk toegang hebben tot je content en de prestaties doorlopend te monitoren. Serverlogs geven direct bewijs van crawleractiviteit en tonen welke bots je site bezochten, welke pagina’s ze bekeken en of er fouten optraden. Google Search Console biedt inzicht in hoe Google’s crawlers je site behandelen, terwijl gespecialiseerde AI-zichtbaarheidstools tonen hoe je content verschijnt op verschillende AI-platforms. AmICited.com monitort specifiek hoe AI-systemen je merk vermelden op ChatGPT, Perplexity en Google AI Overzichten, waardoor je ziet welke pagina’s geciteerd worden en hoe vaak.

Tools en methoden voor monitoring van AI-crawlertoegang:

Het optimaliseren van je website voor AI-crawlertoegang vereist een strategische, doorlopende aanpak. In plaats van AI-toegankelijkheid als eenmalig project te behandelen, implementeren succesvolle organisaties continue monitoring en verbeterprocessen. De meest effectieve strategie combineert correcte technische configuratie met contentoptimalisatie, zodat zowel je infrastructuur als je content AI-ready zijn.

Do’s voor AI-toegankelijkheid:

Don’ts voor AI-toegankelijkheid:

De meest succesvolle AI-toegankelijkheidsstrategie behandelt crawlers als partners in contentdistributie in plaats van als dreigingen die geblokkeerd moeten worden. Door je website technisch solide, correct geconfigureerd en semantisch duidelijk te maken, maximaliseer je de kans dat AI-systemen je content ontdekken, begrijpen en citeren in hun antwoorden aan gebruikers.

AI-toegankelijkheidsaudits richten zich op semantische structuur, machineleesbare content en citeerbaarheid voor AI-systemen, terwijl traditionele SEO-audits de nadruk leggen op zoekwoorden, backlinks en zoekrangschikkingen. AI-audits onderzoeken of crawlers toegang hebben tot en uw content begrijpen, terwijl SEO-audits zich richten op rankingfactoren voor Google's zoekresultaten.

Controleer uw serverlogs op AI-crawler user agents zoals GPTBot, ClaudeBot en PerplexityBot. Gebruik Google Search Console om crawlactiviteit te monitoren, test uw robots.txt-bestand met validatietools en gebruik gespecialiseerde platforms zoals AmICited om bij te houden hoe AI-systemen uw content op verschillende platforms vermelden.

De meest voorkomende barrières zijn JavaScript-renderingbeperkingen (AI-crawlers kunnen geen JavaScript uitvoeren), Cloudflare en beveiligingstoolblokkades (35% van de bedrijfswebsites blokkeert AI-crawlers), rate limiting die uitgebreide indexering voorkomt, complexe site-architectuur en dynamische contentladen. Elke barrière vereist andere oplossingen.

De meeste bedrijven profiteren van het toestaan van AI-crawlers, omdat zij de merkzichtbaarheid vergroten in AI-aangedreven zoekresultaten en conversatie-interfaces. De beslissing hangt echter af van uw contentstrategie, concurrentiepositie en bedrijfsdoelstellingen. U kunt robots.txt gebruiken om bepaalde crawlers selectief toe te staan terwijl u andere blokkeert op basis van uw specifieke behoeften.

Voer elk kwartaal een uitgebreide audit uit of wanneer u belangrijke wijzigingen aanbrengt in uw site-architectuur, contentstrategie of beveiligingsconfiguratie. Monitor crawleractiviteit continu via serverlogs en gespecialiseerde tools. Werk uw robots.txt en sitemaps bij telkens wanneer u nieuwe contentsecties lanceert of URL-structuren wijzigt.

Robots.txt is uw primaire mechanisme om AI-crawlertoegang te controleren. Een juiste configuratie staat grote AI-crawlers (GPTBot, ClaudeBot, PerplexityBot) expliciet toe terwijl gevoelige gebieden beschermd worden. Een verkeerd geconfigureerde robots.txt kan AI-crawlers volledig blokkeren, waardoor uw content onzichtbaar wordt voor AI-systemen, ongeacht de kwaliteit ervan.

Hoewel technische optimalisatie belangrijk is, kunt u ook de AI-zichtbaarheid verbeteren via contentoptimalisatie—gebruik van semantische HTML-structuur, implementatie van schema markup, verbetering van interne links en volledigheid van content. Technische barrières zoals JavaScript-rendering en beveiligingstools vereisen echter meestal technische oplossingen voor volledige AI-toegankelijkheid.

Gebruik serverloganalyse om crawleractiviteit te volgen, Google Search Console voor crawlstatistieken, robots.txt-validators om configuratie te verifiëren, schema markup-validators voor gestructureerde data en gespecialiseerde platforms zoals AmICited om AI-vermeldingen te monitoren. Veel SEO-tools zoals Screaming Frog bieden ook crawlersimulatiemogelijkheden voor het testen van AI-toegankelijkheid.

Volg hoe ChatGPT, Perplexity, Google AI Overzichten en andere AI-systemen uw merk vermelden met AmICited. Krijg realtime inzicht in uw AI-zoekzichtbaarheid en optimaliseer uw contentstrategie.

Leer de complete stapsgewijze methodologie voor het uitvoeren van een AI zichtbaarheid audit. Ontdek hoe je merkvermeldingen, citaties en zichtbaarheid meet ove...

Ontdek wat een AI-contentaudit is, hoe deze verschilt van traditionele contentaudits en waarom het monitoren van de aanwezigheid van jouw merk in AI-zoekmachine...

Ontdek wat AI Concurrentie-audits zijn, waarom ze belangrijk zijn voor concurrentiepositie, en hoe je de zichtbaarheid van concurrenten analyseert op ChatGPT, P...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.