Hoe AI-zoekmachines Werken: Architectuur, Retrieval en Generatie

Ontdek hoe AI-zoekmachines zoals ChatGPT, Perplexity en Google AI Overviews werken. Leer over LLM's, RAG, semantisch zoeken en realtime retrieval-mechanismen.

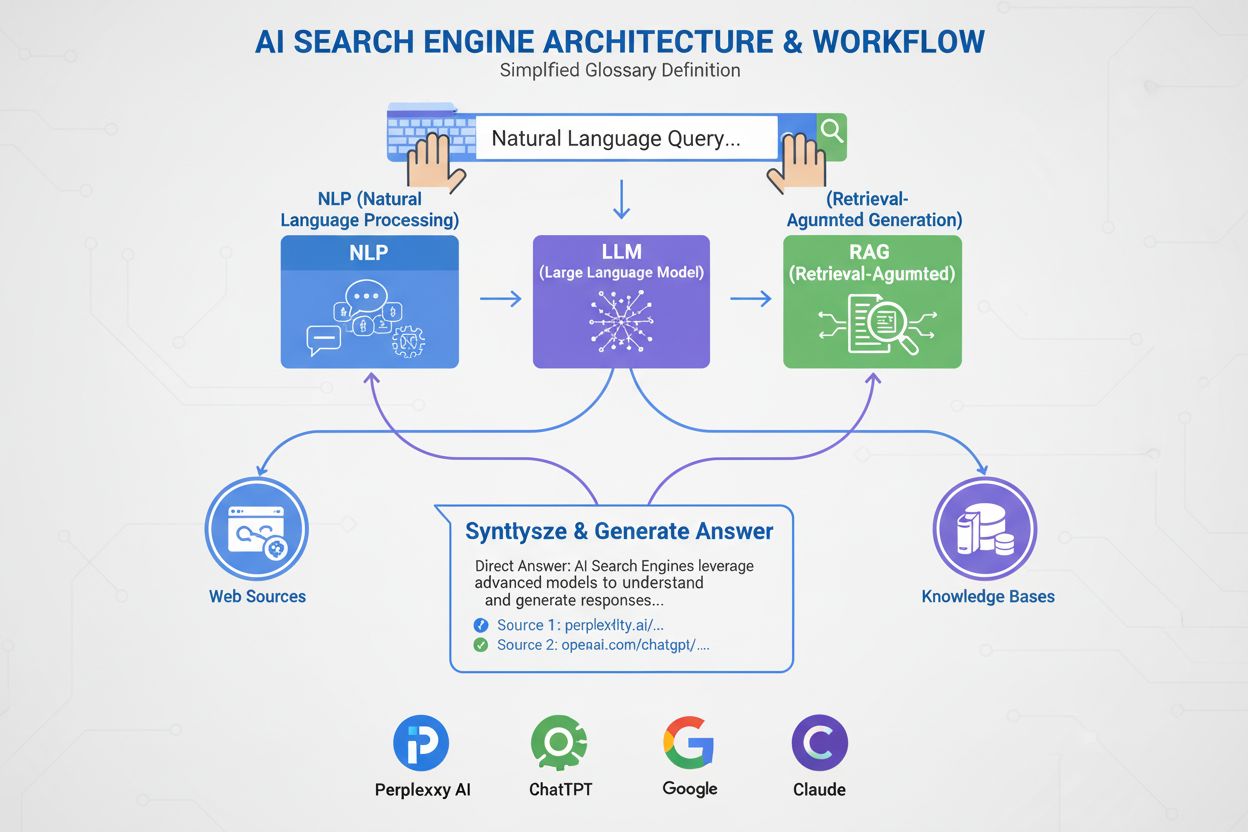

Een AI-zoekmachine is een platform dat gebruikmaakt van kunstmatige intelligentie, natuurlijke taalverwerking en grote taalmodellen om gebruikersvragen te interpreteren en directe, conversatiële antwoorden te genereren die gesynthetiseerd zijn uit webbronnen, in plaats van traditionele lijsten met links weer te geven. Deze platforms maken gebruik van retrieval-augmented generation (RAG) om actuele, geciteerde informatie te bieden met realtime webtoegang.

Een AI-zoekmachine is een platform dat gebruikmaakt van kunstmatige intelligentie, natuurlijke taalverwerking en grote taalmodellen om gebruikersvragen te interpreteren en directe, conversatiële antwoorden te genereren die gesynthetiseerd zijn uit webbronnen, in plaats van traditionele lijsten met links weer te geven. Deze platforms maken gebruik van retrieval-augmented generation (RAG) om actuele, geciteerde informatie te bieden met realtime webtoegang.

Een AI-zoekmachine is een platform dat gebruikmaakt van kunstmatige intelligentie, natuurlijke taalverwerking (NLP) en grote taalmodellen (LLM’s) om gebruikersvragen te interpreteren en directe, conversatiële antwoorden te genereren die gesynthetiseerd zijn uit webbronnen. In tegenstelling tot traditionele zoekmachines die lijsten met links tonen, bieden AI-zoekmachines beknopte, eenvoudige samenvattingen die direct inspelen op de gebruikersintentie. Deze platforms maken gebruik van retrieval-augmented generation (RAG) om realtime webophaling te combineren met generatieve AI-synthese, waardoor ze actuele, geciteerde informatie kunnen leveren. AI-zoekmachines vormen een fundamentele verschuiving in hoe mensen online informatie ontdekken, door de overgang van trefwoordgebaseerde linklijsten naar semantisch begrip en directe antwoorden. De technologie achter deze systemen integreert meerdere AI-disciplines—waaronder semantisch zoeken, entiteit-herkenning en conversatie-AI—om een intuïtievere en efficiëntere zoekervaring te creëren.

De opkomst van AI-zoekmachines markeert een belangrijke evolutie in informatieterugwinningstechnologie. Jarenlang werkten zoekmachines op basis van een trefwoord-matchparadigma, waarbij relevantie werd bepaald door de aanwezigheid en frequentie van zoektermen binnen geïndexeerde documenten. De opkomst van grote taalmodellen en vooruitgang in natuurlijk taalbegrip hebben dit echter fundamenteel veranderd. De wereldwijde markt voor AI-zoekmachines bereikte USD 15,23 miljard in 2024 en zal naar verwachting een samengestelde jaarlijkse groei (CAGR) van 16,8% tot 2032 doormaken, volgens marktonderzoek. Deze explosieve groei weerspiegelt zowel de adoptie door bedrijven als de consumentenbehoefte aan intelligentere, conversatiegerichte zoekervaringen.

Generatieve AI heeft de manier waarop mensen online informatie ontdekken veranderd, en heeft zoeken voorbij de vertrouwde lijst met blauwe links geduwd richting directere, conversatiële antwoorden. Marktleiders zoals Google en Microsoft Bing hebben snel AI geïntegreerd in hun platforms om gelijke tred te houden met opkomende namen zoals Perplexity en You.com. Volgens onderzoek van McKinsey heeft ongeveer 50% van de Google-zoekopdrachten al AI-samenvattingen, en dit percentage zal naar verwachting stijgen tot meer dan 75% in 2028. Deze verschuiving is meer dan een verandering in gebruikersinterface—het herdefinieert contentstrategie en zoekmachineoptimalisatie tot een nieuw tijdperk genaamd “generative engine optimization” (GEO).

De transitie weerspiegelt een bredere organisatie-adoptie van AI-technologieën. 78% van de organisaties meldde AI te gebruiken in 2024, tegenover 55% een jaar eerder, aldus Stanford’s AI Index Report. Voor zoek- en marketingprofessionals betekent dit dat zichtbaarheid nu afhangt van hoe AI-systemen content ontleden, samenvatten en herformuleren tot eenvoudige samenvattingen. De uitdaging is dat AI-gegenereerde antwoorden vaak verkeer helemaal wegtrekken van de oorspronkelijke websites, wat zowel kansen als uitdagingen biedt voor contentmakers en merken die zichtbaarheid zoeken in dit nieuwe landschap.

AI-zoekmachines opereren via een geavanceerde meertraps pipeline die ophalen, rangschikken en syntheseren combineert. Het proces begint met querybegrip, waarbij het systeem de invoer van de gebruiker analyseert met natuurlijke taalverwerking om betekenis, intentie en context te extraheren. In plaats van de vraag als een simpele reeks trefwoorden te behandelen, creëert het systeem meerdere representaties: een lexicale vorm voor exacte matches, een dense embedding voor semantisch zoeken en een entiteitsvorm voor kennisgrafiekmatching.

Zodra de vraag begrepen is, passen de meeste AI-zoekmachines retrieval-augmented generation (RAG) toe, een kernarchitectuur die de fundamentele zwaktes van grote taalmodellen aanpakt. RAG voert een live ophaalstap uit, waarbij webindexen of API’s worden doorzocht om relevante documenten en passages te vinden. Deze kandidaten worden vervolgens gerangschikt met geavanceerdere modellen die gezamenlijk de vraag en kandidaat beoordelen om verfijnde relevantiescores te geven. De hoogst gerangschikte resultaten worden gevoed aan een groot taalmodel als grondcontext, dat een conversatieantwoord synthetiseert en trouw blijft aan de opgehaalde bronnen.

Hybride retrieval-pijplijnen zijn standaard bij toonaangevende platforms. Deze combineren lexicaal zoeken (trefwoordgebaseerd, met algoritmes als BM25) met semantisch zoeken (embedding-gebaseerd, via vectorvergelijking). Lexicaal zoeken blinkt uit in precisie voor exacte matches, zeldzame termen en naam-entiteiten, terwijl semantisch zoeken uitblinkt in recall voor conceptueel gerelateerde content. Door beide benaderingen te combineren en cross-encoder reranking toe te passen, behalen AI-zoekmachines een hogere nauwkeurigheid dan elke methode afzonderlijk. In de laatste synthesefase wordt een groot taalmodel gebruikt om een samenhangend, menselijk antwoord te formuleren dat informatie uit meerdere bronnen integreert, met behoud van nauwkeurigheid en met bronvermeldingen.

| Aspect | Traditionele zoekmachines | AI-zoekmachines |

|---|---|---|

| Resultaatformaat | Lijsten met links en korte fragmenten | Conversatiële samenvattingen met directe antwoorden |

| Queryverwerking | Trefwoordmatching en ranking | Semantisch begrip en intentie-analyse |

| Leermethode | Werkt bij elke zoekopdracht vanaf nul | Leert continu van gebruikersinteracties en feedback |

| Informatieterugwinning | Lexicaal/trefwoordgebaseerd | Hybride (lexicaal + semantisch + entiteit-gebaseerd) |

| Invoerformaten | Alleen tekst | Tekst, afbeeldingen, spraak en video (multimodaal) |

| Realtime updates | Index-gebaseerd, periodiek crawlen | Realtime webtoegang via RAG |

| Bronvermelding | Geen bronvermelding; gebruikers vinden zelf bronnen | Geïntegreerde bronvermelding en naamsvermelding |

| Gebruikersinteractie | Enkele vraag, statisch resultaat | Meerturngesprekken met vervolgvragen |

| Biasafhandeling | Curatoren ordenen informatie | AI-synthese kan ontwikkelaarsbias introduceren |

| Hallucinatierisico | Laag (links zijn feitelijk) | Hoger (LLM’s kunnen onjuiste informatie genereren) |

Verschillende AI-zoekmachines implementeren uiteenlopende architecturen, elk met unieke optimalisatie-implicaties. Google’s AI Overviews en AI Mode gebruiken een query fan-out strategie, waarbij één gebruikersvraag wordt opgesplitst in meerdere subvragen die verschillende intentiedimensies bestrijken. Deze subvragen draaien parallel op diverse databronnen—de webindex, Knowledge Graph, YouTube-transcripten, Google Shopping-feeds en specialistische indexen. Resultaten worden samengevoegd, gededupliceerd en gerangschikt voordat ze tot een overzicht worden gesynthetiseerd. Voor GEO-specialisten betekent dit dat content meerdere facetten van een vraag extracteerbaar moet behandelen om de fan-out te overleven.

Bing Copilot volgt een meer traditionele search-native aanpak, gebruikmakend van Microsofts volwassen Bing-rankinginfrastructuur en daarbovenop GPT-klasse synthese. Het platform gebruikt dual-lane retrieval, waarbij BM25 lexicaal zoeken wordt gecombineerd met dense vector semantisch zoeken. Resultaten gaan door een contextuele cross-encoder reranker die zich richt op relevantie op passageniveau in plaats van hele pagina’s. Deze architectuur betekent dat klassieke SEO-signalen—crawlbaarheid, canonical tags, schone HTML, paginasnelheid—nog steeds van groot belang zijn, omdat ze bepalen welke kandidaten de grondingsset bereiken. Bing Copilot legt ook nadruk op extracteerbaarheid: passages met duidelijke scope, lijsten, tabellen en definitiestijl worden sneller geciteerd.

Perplexity AI werkt met opzettelijke transparantie en toont bronnen prominent vóór het gegenereerde antwoord. Het platform voert realtime zoekopdrachten uit, vaak op zowel Google- als Bing-indexen, en beoordeelt kandidaten op een mix van lexicale en semantische relevantie, thematische autoriteit en antwoord-extracteerbaarheid. Onderzoek naar 59 factoren die Perplexity’s ranking beïnvloeden laat zien dat het platform directe antwoordopmaak prioriteert—pagina’s die de vraag expliciet herhalen in een kop, direct gevolgd door een beknopt, informatief antwoord, worden onevenredig vaak geciteerd. Entiteitsprominentie en linking zijn ook belangrijk; Perplexity geeft de voorkeur aan passages waarin sleutelentiteiten duidelijk bij naam worden genoemd en contextueel gelinkt aan verwante concepten.

ChatGPT Search hanteert een opportunistische benadering, genereert zoekopdrachten dynamisch en gebruikt Bing’s API om specifieke URL’s op te halen. In tegenstelling tot platforms met een persistente index haalt ChatGPT content in realtime op, wat betekent dat opname volledig afhankelijk is van directe vindbaarheid. Als een site geblokkeerd is via robots.txt, traag laadt, verborgen is achter client-side rendering of semantisch ondoorzichtig is, wordt deze niet gebruikt in de synthese. Deze architectuur legt de nadruk op toegankelijkheid en duidelijkheid: pagina’s moeten technisch crawlbaar, lichtgewicht en semantisch transparant zijn zodat on-the-fly ophalen schone, leesbare tekst oplevert.

Natuurlijke taalverwerking (NLP) is de fundering die AI-zoekmachines in staat stelt verder te gaan dan trefwoordmatching. NLP maakt het mogelijk dat systemen de structuur, semantiek en intentie van zoekopdrachten begrijpen, context snappen en synoniemen en verwante concepten herkennen. Wanneer een gebruiker vraagt: “beste plekken om te eten in de buurt met terras,” begrijpt een NLP-gestuurd systeem dat er wordt gezocht naar restaurants met buitenzitplaatsen, ook al worden die woorden niet genoemd. Dit semantische begrip stelt AI-zoekmachines in staat relevante resultaten te leveren, zelfs als de intentie minder duidelijk of conversatieel is geformuleerd.

Grote taalmodellen (LLM’s) drijven de synthese van AI-zoekmachines aan. Ze zijn getraind op enorme hoeveelheden tekstdata en voorspellen het volgende logische woord op basis van context, waardoor ze samenhangende, grammaticaal correcte tekst produceren die sterk lijkt op mensentaal. LLM’s brengen echter ook risico’s met zich mee. Ze kunnen hallucineren—onwaarheden presenteren als feiten—omdat ze tekst genereren vanuit waarschijnlijkheidskennis, niet door live bronnen te citeren. Daarom is retrieval-augmented generation (RAG) cruciaal: door LLM-synthese te gronden in vers opgehaalde, gezaghebbende bronnen, verkleinen AI-zoekmachines het hallucinatierisico en verbeteren ze de feitelijke juistheid. Sommige platforms hebben regeltje-voor-regeltje bronvermelding geïmplementeerd om hallucinatie verder te beperken, hoewel de geciteerde artikelen niet altijd accuraat zijn en soms zelfs niet bestaan.

AI-zoekmachines verschillen op enkele fundamentele punten van traditionele zoekmachines. Ten eerste bieden ze samenvattingen in plaats van links. Gewone zoekmachines tonen resultaten als lijsten met links en korte fragmenten, terwijl AI-zoekmachines beknopte samenvattingen genereren die direct antwoord geven op vragen, zodat gebruikers niet door meerdere websites hoeven te klikken. Ten tweede leert AI-zoeken met de tijd, terwijl traditioneel zoeken bij elke vraag opnieuw begint. AI-zoekmachines zijn ontworpen om continu te leren en zich aan te passen aan gebruikersinteracties en nieuwe data, waardoor hun prestaties verbeteren. Traditionele zoekmachines beginnen bij elke nieuwe zoekopdracht opnieuw, zonder rekening te houden met eerdere zoekopdrachten of gebruikersinteracties.

Ten derde focust AI-zoeken op semantiek, terwijl traditioneel zoeken focust op trefwoorden. Gewone zoekmachines vertrouwen vooral op trefwoordmatching om zoekopdrachten te interpreteren, terwijl AI-zoekmachines zich concentreren op semantiek—de bredere betekenis van woorden in context. Dit stelt AI-zoekmachines in staat gebruikersintentie beter te begrijpen en resultaten te leveren die dichter bij de daadwerkelijke behoefte liggen. Ten vierde accepteert AI-zoeken meerdere invoerformaten, terwijl traditioneel zoeken alleen tekst accepteert. Sommige AI-zoekmachines beschikken over multimodale mogelijkheden, wat betekent dat ze informatie kunnen verwerken uit meer dan alleen tekst, zoals afbeeldingen, video’s en audio. Dit biedt een intuïtievere en flexibelere zoekervaring dan het typen van trefwoorden.

De opkomst van AI-zoekmachines verandert hoe merken omgaan met zichtbaarheid en contentstrategie. In plaats van alleen te concurreren voor trefwoordposities moeten uitgevers en bedrijven nu rekening houden met hoe AI-systemen hun content ontleden, samenvatten en herformuleren tot eenvoudige samenvattingen. Deze verschuiving luidt een nieuw tijdperk in van “generative engine optimization” (GEO), waarbij het doel niet alleen is om te ranken, maar om opgehaald, gesynthetiseerd en geciteerd te worden door AI-systemen.

Onderzoek geeft aan dat zelfs de GEO-prestaties van marktleiders tot 20 à 50 procent achter kunnen blijven op SEO, aldus McKinsey-analyse. Deze kloof weerspiegelt de jonge aard van GEO-strategieën en de complexiteit van optimaliseren voor meerdere AI-platforms tegelijk. Voor merken zijn de gevolgen aanzienlijk: zichtbaarheid in AI-zoeken hangt af van content die vindbaar is (verschijnt in zoekresultaten), extraheerbaar (gestructureerd zodat AI-systemen het makkelijk kunnen citeren) en betrouwbaar (expertise, autoriteit en betrouwbaarheid toont). Monitoringtools zoals AmICited volgen nu merknamen op AI-platforms—waaronder Perplexity, ChatGPT, Google AI Overviews en Claude—om deze nieuwe vorm van zichtbaarheid te meten en optimalisatiemogelijkheden te identificeren.

Het landschap van AI-zoeken ontwikkelt zich snel, met grote gevolgen voor hoe informatie wordt ontdekt, verspreid en vermarkt. De wereldwijde markt voor AI-zoekmachines zal naar verwachting groeien met een CAGR van 16,8% tot 2032, gedreven door toenemende adoptie in het bedrijfsleven en consumentenbehoefte aan conversatiële, intelligente zoekervaringen. Naarmate AI-zoekmachines volwassen worden, worden verschillende trends verwacht.

Ten eerste zal consolidatie en specialisatie waarschijnlijk versnellen. Terwijl generalistische platforms zoals Google, Bing en Perplexity blijven domineren, zullen gespecialiseerde AI-zoekmachines voor verticale markten—juridisch, medisch, technisch, e-commerce—zich uitbreiden. Deze gespecialiseerde zoekmachines bieden diepere domeinexpertise en nauwkeurigere synthese voor nichevragen. Ten tweede zullen bronvermelding en naamsvermelding geavanceerder en gestandaardiseerd worden. Nu de druk vanuit regelgeving toeneemt en uitgevers duidelijkere attributie eisen, zullen AI-zoekmachines waarschijnlijk fijnmazigere citatiesystemen invoeren zodat gebruikers claims makkelijker kunnen herleiden en uitgevers zichtbaarheid kunnen meten.

Ten derde zal de definitie en meting van ‘zichtbaarheid’ fundamenteel verschuiven. In het traditionele SEO-tijdperk betekende zichtbaarheid rankingpositie en doorklikratio. In het GEO-tijdperk betekent zichtbaarheid opgehaald, gesynthetiseerd en geciteerd worden—metingen die nieuwe frameworks en tools vereisen. AmICited en vergelijkbare platforms pionieren in deze meetruimte, door merknamen op meerdere AI-platforms te volgen en inzicht te geven in hoe vaak en in welke context merken in AI-antwoorden verschijnen.

Ten vierde zal de spanning tussen AI-zoeken en traditioneel zoeken toenemen. Naarmate AI-zoekmachines meer gebruikersaandacht en verkeer trekken, zullen traditionele zoekmachines onder druk komen te staan om te innoveren of het risico lopen irrelevant te worden. De integratie van AI in het kernproduct van Google is een strategisch antwoord op deze dreiging, maar de uiteindelijke winnaar is onzeker. Uitgevers en merken moeten zowel voor traditioneel als AI-zoeken optimaliseren, wat de contentstrategie complexer en intensiever maakt.

Tot slot worden vertrouwen en nauwkeurigheid steeds belangrijker. Nu AI-zoekmachines primaire informatiebronnen worden, stijgt het belang van nauwkeurigheid en biasbeperking. Waarschijnlijk komen er regelgeving voor AI-transparantie en verantwoording, waarbij AI-zoekmachines hun trainingsdata, rankingfactoren en citatiemethoden bekend moeten maken. Voor merken en uitgevers betekent dit dat E-E-A-T-signalen—expertise, ervaring, autoriteit en betrouwbaarheid—nog crucialer worden voor zichtbaarheid in zowel traditionele als AI-zoekomgevingen.

+++ showCTA = true ctaHeading = “Monitor de zichtbaarheid van je merk in AI-zoekmachines” ctaDescription = “Inzicht in AI-zoekmachines is slechts de eerste stap. Volg waar en hoe je merk verschijnt in ChatGPT, Perplexity, Google AI Overviews en Claude met het AI-zoekmonitoringsplatform van AmICited. Meet je GEO-prestaties, ontdek citatiekansen en optimaliseer je content voor de volgende generatie zoeken.” ctaPrimaryText = “Neem contact op” ctaPrimaryURL = “/contact/” ctaSecondaryText = “Probeer het nu” ctaSecondaryURL = “https://app.amicited.com ” +++

Traditionele zoekmachines tonen resultaten als lijsten met links en fragmenten, terwijl AI-zoekmachines conversatiële samenvattingen genereren die direct antwoord geven op vragen. AI-zoekmachines gebruiken natuurlijke taalverwerking en grote taalmodellen om gebruikersintentie semantisch te begrijpen in plaats van alleen op trefwoorden te vertrouwen. Ze leren continu bij van gebruikersinteracties en kunnen meerdere invoerformaten verwerken, waaronder tekst, afbeeldingen en spraak. Daarnaast bieden AI-zoekmachines vaak realtime webtoegang via retrieval-augmented generation (RAG), waardoor ze actuele informatie kunnen leveren met bronvermeldingen.

Retrieval-augmented generation (RAG) is een techniek waarmee grote taalmodellen verse informatie uit externe bronnen kunnen ophalen en integreren voordat ze antwoorden genereren. RAG pakt de fundamentele beperkingen van LLM's aan—hallucinaties en kennisgrenzen—door antwoorden te baseren op realtime opgehaalde data. In AI-zoekmachines werkt RAG door eerst een live zoek- of ophaalstap uit te voeren, relevante documenten of fragmenten op te halen, en vervolgens een antwoord te synthetiseren op basis van die opgehaalde items. Deze aanpak zorgt ervoor dat antwoorden actueel zijn en herleidbaar naar specifieke bronnen, waardoor bronvermelding mogelijk is en de feitelijke juistheid wordt verbeterd.

Toonaangevende AI-zoekmachines zijn onder andere Perplexity (bekend om transparante bronvermeldingen), ChatGPT Search (aangedreven door GPT-4o met realtime webtoegang), Google Gemini en AI Overviews (geïntegreerd met Google's zoekinfrastructuur), Bing Copilot (gebouwd op Microsofts zoekindex) en Claude (Anthropic's model met selectieve webzoekfunctie). Perplexity geeft prioriteit aan realtime ophalen en zichtbare bronvermelding, terwijl ChatGPT zoekopdrachten opportunistisch genereert. Google's aanpak gebruikt query fan-out om meerdere intentiedimensies te dekken, en Bing CoPilot combineert traditionele SEO-signalen met generatieve synthese. Elk platform heeft onderscheidende retrieval-architecturen, bronvermeldingsgedrag en optimalisatievereisten.

AI-zoekmachines volgen een meertrapsproces: eerst analyseren ze de gebruikersvraag via natuurlijke taalverwerking om de intentie te begrijpen; vervolgens halen ze relevante documenten of passages op uit webindexen of API's via hybride retrieval (combinatie van lexicaal en semantisch zoeken); daarna rangschikken ze kandidaten op relevantie en extracteerbaarheid; en ten slotte synthetiseren ze een conversatieantwoord met een groot taalmodel, waarbij ze bronvermeldingen toevoegen aan brondocumenten. Het citatie-mechanisme verschilt per platform—sommige tonen inline bronvermeldingen, andere een bronnenlijst, en sommige verwerken bronvermeldingen in de antwoordtekst zelf. De kwaliteit en nauwkeurigheid van bronvermeldingen hangt af van hoe goed de opgehaalde passages aansluiten bij de gesynthetiseerde claims.

Generative engine optimization (GEO) is het optimaliseren van content en merkzichtbaarheid specifiek voor AI-zoekmachines, in tegenstelling tot traditionele SEO die gericht is op trefwoordposities in linkgebaseerde zoekresultaten. GEO focust op het vindbaar, extraheerbaar en citeerbaar maken van content voor AI-systemen. Belangrijke GEO-strategieën zijn onder andere het structureren van content voor duidelijkheid en directe antwoorden, gebruik van natuurlijke taal die aansluit bij gebruikersintentie, implementatie van entiteit-markup en schema, zorgen voor snelle paginalaadtijden en het opbouwen van thematische autoriteit. Uit onderzoek van McKinsey blijkt dat ongeveer 50% van de Google-zoekopdrachten al AI-samenvattingen heeft, een percentage dat naar verwachting oploopt tot meer dan 75% in 2028, waardoor GEO steeds belangrijker wordt voor merkzichtbaarheid.

AI-zoekmachines kunnen het websiteverkeer zowel vergroten als verkleinen, afhankelijk van hoe de content is geoptimaliseerd. Wanneer content wordt geciteerd in AI-gegenereerde antwoorden, krijgt het zichtbaarheid en geloofwaardigheid, maar gebruikers krijgen hun antwoord mogelijk direct zonder door te klikken naar de bron. Onderzoek wijst uit dat AI Overviews verkeer kunnen afleiden van de oorspronkelijke websites, al bieden ze ook naamsvermelding en bronlinks. Voor merken betekent deze verschuiving dat zichtbaarheid nu afhangt van opgehaald, gesynthetiseerd en geciteerd worden door AI-systemen—niet alleen van een positie in de traditionele zoekresultaten. Monitoringtools zoals AmICited volgen merknamen op AI-platforms (Perplexity, ChatGPT, Google AI Overviews, Claude) om deze nieuwe vorm van zichtbaarheid te meten en hierop te optimaliseren.

Natuurlijke taalverwerking (NLP) is fundamenteel voor hoe AI-zoekmachines gebruikersvragen begrijpen en verwerken. NLP stelt systemen in staat de structuur, semantiek en intentie achter zoekopdrachten te doorgronden, in plaats van alleen op trefwoorden te matchen. Het zorgt ervoor dat AI-zoekmachines context begrijpen, betekenis kunnen onderscheiden en synoniemen en gerelateerde concepten herkennen. NLP stuurt ook het syntheseproces aan, waarbij taalmodellen grammaticaal correcte, samenhangende antwoorden genereren die natuurlijk klinken voor gebruikers. Daarnaast helpt NLP AI-zoekmachines informatie uit webpagina's te extraheren en structureren, waarbij belangrijke entiteiten, relaties en claims worden geïdentificeerd die in de antwoorden kunnen worden verwerkt.

AI-zoekmachines verwerken realtime informatie via retrieval-augmented generation (RAG), die live zoekopdrachten of API-calls uitvoert om actuele gegevens op te halen op het moment van de vraag, in plaats van alleen te vertrouwen op trainingsdata. Platforms zoals Perplexity en Google's AI Mode zoeken actief realtime op het web, zodat antwoorden de meest recente informatie weerspiegelen. ChatGPT gebruikt Bing's zoek-API om actuele webcontent te bereiken wanneer browsen is ingeschakeld. Actualiteitssignalen worden ook verwerkt in ranking-algoritmes—pagina's met recente publicatiedata en bijgewerkte content krijgen meer gewicht bij tijdgevoelige zoekopdrachten. Sommige AI-zoekmachines vertrouwen echter nog deels op trainingsdata, die kan achterlopen op actuele gebeurtenissen, waardoor realtime retrieval een belangrijk onderscheidend vermogen is tussen platforms.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Ontdek hoe AI-zoekmachines zoals ChatGPT, Perplexity en Google AI Overviews werken. Leer over LLM's, RAG, semantisch zoeken en realtime retrieval-mechanismen.

Leer hoe je AI-zoekopdrachten onderzoekt en monitort via ChatGPT, Perplexity, Claude en Gemini. Ontdek methodes om merkvermeldingen te volgen en te optimalisere...

Ontdek wat SearchGPT is, hoe het werkt en de impact op zoeken, SEO en digitale marketing. Bekijk functies, beperkingen en de toekomst van door AI aangedreven zo...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.