Wat is Crawl Budget voor AI? Inzicht in AI Bot Resource Allocation

Leer wat crawl budget voor AI betekent, hoe het verschilt van traditionele zoek crawl budgets en waarom het belangrijk is voor de zichtbaarheid van je merk in A...

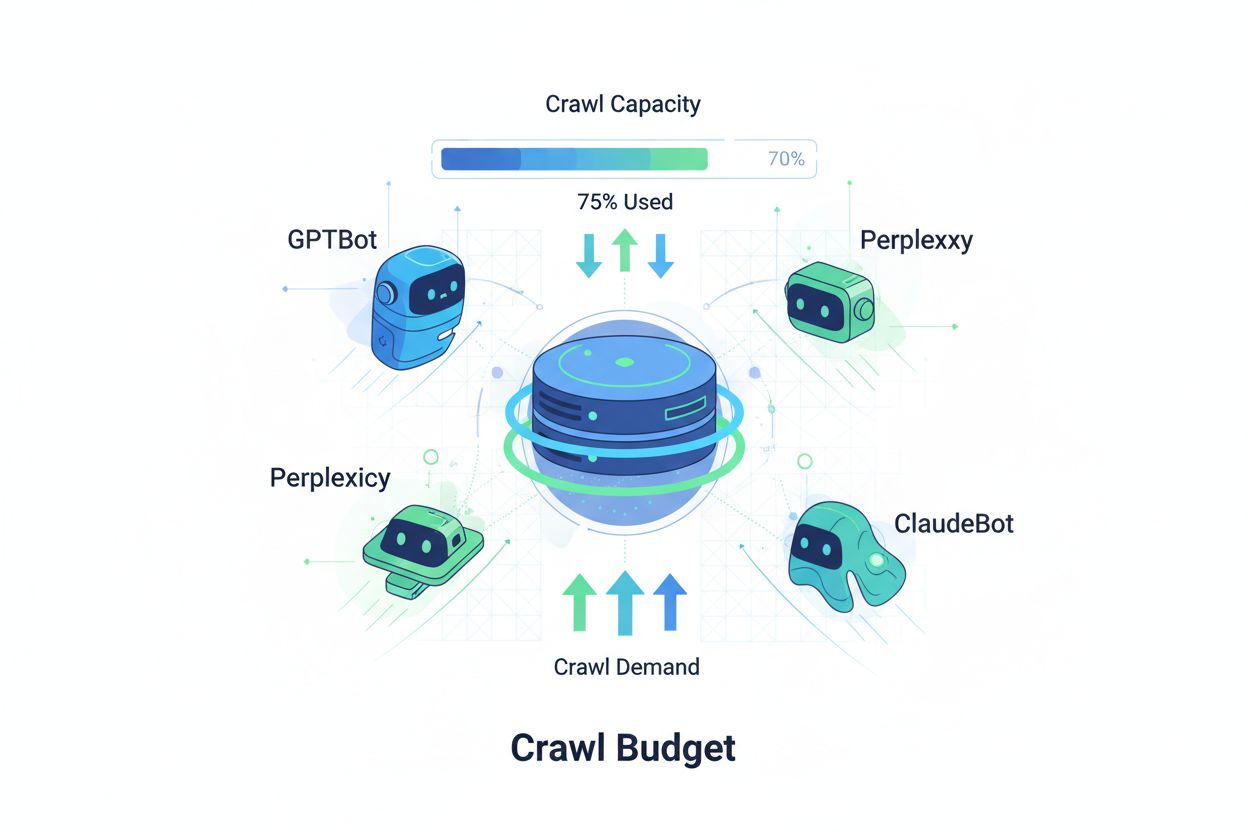

Technieken om ervoor te zorgen dat AI-crawlers efficiënt toegang krijgen tot en de belangrijkste inhoud van een website indexeren binnen hun crawl-limieten. Crawl budget optimalisatie beheert het evenwicht tussen crawlcapaciteit (serverbronnen) en crawldruk (botverzoeken) om de zichtbaarheid in AI-gegenereerde antwoorden te maximaliseren, terwijl operationele kosten en serverbelasting onder controle worden gehouden.

Technieken om ervoor te zorgen dat AI-crawlers efficiënt toegang krijgen tot en de belangrijkste inhoud van een website indexeren binnen hun crawl-limieten. Crawl budget optimalisatie beheert het evenwicht tussen crawlcapaciteit (serverbronnen) en crawldruk (botverzoeken) om de zichtbaarheid in AI-gegenereerde antwoorden te maximaliseren, terwijl operationele kosten en serverbelasting onder controle worden gehouden.

Crawl budget verwijst naar de hoeveelheid middelen—gemeten in verzoeken en bandbreedte—die zoekmachines en AI-bots toewijzen aan het crawlen van jouw website. Traditioneel gold dit concept vooral voor het crawlgedrag van Google, maar de opkomst van AI-gestuurde bots heeft de manier waarop organisaties naar crawl budgetbeheer moeten kijken fundamenteel veranderd. De crawl budget-vergelijking bestaat uit twee cruciale variabelen: crawlcapaciteit (het maximum aantal pagina’s dat een bot kan crawlen) en crawldruk (het daadwerkelijke aantal pagina’s dat de bot wil crawlen). In het AI-tijdperk is deze dynamiek exponentieel complexer geworden, aangezien bots als GPTBot (OpenAI), Perplexity Bot en ClaudeBot (Anthropic) nu concurreren om serverbronnen naast traditionele zoekmachinecrawlers. Deze AI-bots werken met andere prioriteiten en patronen dan Googlebot, verbruiken vaak aanzienlijk meer bandbreedte en hebben andere indexeringsdoelen, waardoor crawl budget optimalisatie geen optie meer is maar essentieel wordt om de siteprestaties te behouden en operationele kosten te beheersen.

AI-crawlers verschillen fundamenteel van traditionele zoekmachinebots in crawlpatronen, frequentie en verbruik van middelen. Waar Googlebot crawl budget-limieten respecteert en geavanceerde throttling-mechanismen toepast, vertonen AI-bots vaak agressiever crawlgedrag, vragen ze soms meerdere malen dezelfde content op en tonen ze minder respect voor serverbelastingsignalen. Onderzoek wijst uit dat OpenAI’s GPTBot 12-15 keer meer bandbreedte kan verbruiken dan Google’s crawler op bepaalde websites, vooral bij sites met grote contentbibliotheken of vaak bijgewerkte pagina’s. Deze agressieve aanpak vloeit voort uit AI-trainingsvereisten—deze bots moeten continu verse content opnemen om modelprestaties te verbeteren, wat een fundamenteel andere crawlfilosofie is dan zoekmachines die zich richten op indexering voor retrieval. De serverimpact is aanzienlijk: organisaties melden sterke stijgingen van bandbreedtekosten, CPU-gebruik en serverbelasting die direct aan AI-botverkeer te wijten zijn. Het cumulatieve effect van meerdere AI-bots die tegelijk crawlen kan bovendien de gebruikerservaring verslechteren, laadtijden vertragen en hostingkosten verhogen, waardoor het onderscheid tussen traditionele en AI-crawlers een kritische zakelijke overweging wordt in plaats van een technische nieuwsgierigheid.

| Kenmerk | Traditionele Crawlers (Googlebot) | AI Crawlers (GPTBot, ClaudeBot) |

|---|---|---|

| Crawlfrequentie | Adaptief, respecteert crawl budget | Agressief, continu |

| Bandbreedteverbruik | Gemiddeld, geoptimaliseerd | Hoog, veel middelen vereist |

| Respect voor Robots.txt | Strikte naleving | Variabele naleving |

| Caching-gedrag | Geavanceerde caching | Frequente herhaalde verzoeken |

| User-Agent Identificatie | Duidelijk, consistent | Soms verhuld |

| Zakelijk Doel | Zoekindexering | Modeltraining/data-acquisitie |

| Kostenimpact | Minimaal | Significant (12-15x hoger) |

Crawl budget begrijpen vereist beheersing van de twee fundamentele componenten: crawlcapaciteit en crawldruk. Crawlcapaciteit staat voor het maximum aantal URL’s dat je server aankan binnen een bepaalde periode, bepaald door verschillende onderling verbonden factoren. Deze capaciteit wordt beïnvloed door:

Crawldruk daarentegen geeft aan hoeveel pagina’s bots daadwerkelijk willen crawlen, bepaald door contentkenmerken en botprioriteiten. Factoren die crawldruk beïnvloeden zijn onder meer:

De optimalisatie-uitdaging ontstaat als crawldruk de crawlcapaciteit overschrijdt—bots moeten kiezen welke pagina’s ze crawlen en missen mogelijk belangrijke contentupdates. Als de crawlcapaciteit daarentegen veel groter is dan de vraag, verspil je serverbronnen. Het doel is crawlefficiëntie: het maximaliseren van het crawlen van belangrijke pagina’s en het minimaliseren van verspilde crawls op content met weinig waarde. Dit evenwicht wordt steeds complexer in het AI-tijdperk, waar meerdere bottypes met verschillende prioriteiten concurreren om dezelfde serverbronnen, waardoor geavanceerde strategieën nodig zijn om het crawl budget effectief over alle belanghebbenden te verdelen.

Het meten van crawl budget prestaties begint met Google Search Console, die crawlstatistieken biedt onder het gedeelte “Instellingen”, met dagelijkse crawlverzoeken, gedownloade bytes en responstijden. Om je crawlefficiëntieratio te berekenen, deel je het aantal succesvolle crawls (HTTP 200-responses) door het totale aantal crawlverzoeken; gezonde sites behalen doorgaans 85-95% efficiëntie. Een formule voor basis crawlefficiëntie is: (Succesvolle Crawls ÷ Totaal Crawlverzoeken) × 100 = Crawlefficiëntie %. Buiten de data van Google vereist praktische monitoring:

Voor AI-crawler specifieke monitoring bieden tools als AmICited.com gespecialiseerde tracking van GPTBot, ClaudeBot en Perplexity Bot, met inzicht in welke pagina’s deze bots prioriteren en hoe vaak ze terugkeren. Ook het instellen van aangepaste waarschuwingen voor ongebruikelijke crawlpieken—vooral door AI-bots—maakt een snelle respons mogelijk op onverwacht middelenverbruik. De belangrijkste metric om te volgen is crawl kosten per pagina: door het totaal aan servermiddelen dat door crawls wordt verbruikt te delen door het aantal unieke gecrawlde pagina’s, zie je of je je crawl budget efficiënt inzet of middelen verspilt aan pagina’s met lage waarde.

Het optimaliseren van het crawl budget voor AI-bots vraagt om een gelaagde aanpak die technische implementatie combineert met strategische besluitvorming. De belangrijkste optimalisatietactieken zijn:

De strategische keuze voor welke tactiek je toepast hangt af van je bedrijfsmodel en contentstrategie. E-commerce sites blokkeren mogelijk AI-crawlers op productpagina’s om trainingsdata voor concurrenten te voorkomen, terwijl contentuitgevers crawling toestaan om zichtbaarheid in AI-antwoorden te vergroten. Bij echte serverbelasting door AI-botverkeer is user-agent specifieke blokkering in robots.txt de meest directe oplossing: User-agent: GPTBot gevolgd door Disallow: / voorkomt dat de crawler van OpenAI je site volledig kan bereiken. Dit gaat echter ten koste van mogelijke zichtbaarheid in ChatGPT- en andere AI-antwoorden. Een genuanceerdere aanpak is selectief blokkeren: AI-crawlers toegang geven tot publieke content en ze blokkeren voor gevoelige delen, archieven of duplicaten die crawl budget verspillen zonder waarde voor bot of gebruiker.

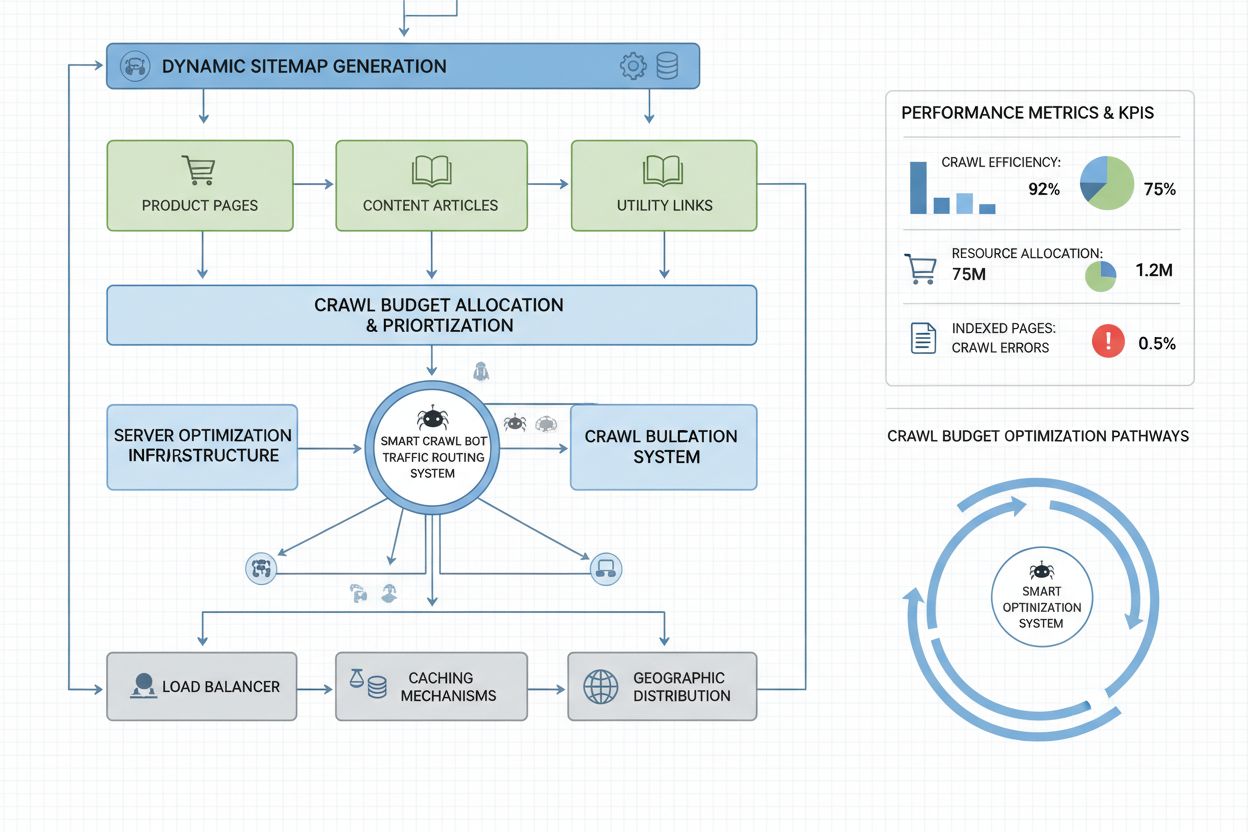

Websites op ondernemingsschaal met miljoenen pagina’s hebben geavanceerde crawl budget optimalisatie nodig die verder gaat dan eenvoudige robots.txt-configuratie. Dynamische sitemaps zijn hierbij cruciaal, waarbij sitemaps in real-time worden gegenereerd op basis van contentactualiteit, belangrijkheidsscores en crawlhistorie. In plaats van statische XML-sitemaps die alle pagina’s bevatten, geven dynamische sitemaps voorrang aan recent bijgewerkte, drukbezochte en conversiegerichte pagina’s, zodat bots hun crawl budget richten op relevante content. URL-segmentatie verdeelt je site in logische crawlzones met elk eigen optimalisatiestrategieën—nieuwssecties kunnen agressieve sitemapupdates gebruiken voor directe crawling van dagelijkse content, terwijl tijdloze content minder vaak wordt bijgewerkt.

Server-side optimalisatie omvat het toepassen van crawl-bewuste cachingstrategieën die bots gecachte antwoorden serveren en gebruikers verse content bieden, waardoor serverbelasting door herhaalde botverzoeken afneemt. Content delivery networks (CDN’s) met bot-specifieke routing isoleren botverkeer van gebruikersverkeer, zodat crawlers geen bandbreedte opsouperen die voor echte bezoekers nodig is. Rate limiting per user-agent maakt het mogelijk AI-botverzoeken te vertragen terwijl Googlebot en gebruikers normaal kunnen blijven surfen. Voor zeer grote operaties zorgt gedistribueerd crawl budget beheer over meerdere serverregio’s dat er geen single point of failure is en dat botverkeer geografisch gespreid wordt. Machine learning-gebaseerde crawlvoorspelling analyseert historische crawlpatronen om te voorspellen welke pagina’s bots als volgende zullen opvragen, zodat je deze proactief kunt optimaliseren qua performance en caching. Deze enterprise-level strategieën maken van crawl budget een beheerde resource, zodat grote organisaties miljarden pagina’s kunnen bedienen en optimale prestaties voor bots én gebruikers behouden.

De keuze om AI-crawlers te blokkeren of toe te staan is een fundamentele bedrijfsstrategie met grote gevolgen voor zichtbaarheid, concurrentiepositie en operationele kosten. AI-crawlers toestaan biedt aanzienlijke voordelen: je content komt in aanmerking voor opname in AI-gegenereerde antwoorden, wat verkeer kan opleveren uit ChatGPT, Claude, Perplexity en andere AI-applicaties; je merk krijgt zichtbaarheid via een nieuw distributiekanaal; en je profiteert van SEO-signalen door citatie door AI-systemen. Daar staan kosten tegenover: hogere serverbelasting en bandbreedteverbruik, mogelijke training van concurrent-AI-modellen met je eigen content en minder controle over hoe je informatie wordt gepresenteerd en geattribueerd in AI-antwoorden.

Het blokkeren van AI-crawlers elimineert deze kosten maar levert zichtbaarheid op en geeft mogelijk marktaandeel weg aan concurrenten die crawling toelaten. De optimale strategie hangt af van je bedrijfsmodel: contentuitgevers en nieuwsorganisaties profiteren vaak van crawling voor distributie via AI-samenvattingen; SaaS-bedrijven en e-commerce sites blokkeren misschien om concurrenten geen toegang tot hun productinformatie te geven; onderwijsinstellingen en onderzoeksorganisaties staan crawling toe voor maximale kennisverspreiding. Een hybride aanpak biedt een middenweg: crawling toestaan van publieke content en blokkeren van gevoelige delen, user-generated content of bedrijfsgevoelige informatie. Zo maximaliseer je zichtbaarheid en bescherm je waardevolle assets. Daarnaast bieden monitoringtools als AmICited.com inzicht of je content daadwerkelijk door AI-systemen wordt geciteerd—verschijn je ondanks crawling niet in AI-antwoorden, dan wordt blokkeren aantrekkelijker omdat je de crawlkosten draagt zonder zichtbaarheid te krijgen.

Effectief crawl budget beheer vereist gespecialiseerde tools die inzicht geven in botgedrag en datagedreven optimalisatie mogelijk maken. Conductor en Sitebulb bieden crawl-analyses op ondernemingsniveau, simuleren hoe zoekmachines je site crawlen en signaleren inefficiënties, verspilde crawls op foutpagina’s en kansen om crawl budget beter in te zetten. Cloudflare biedt botmanagement op netwerkniveau, met gedetailleerde controle over welke bots toegang krijgen en rate limiting specifiek voor AI-crawlers. Voor AI-crawler specifieke monitoring is AmICited.com de meest uitgebreide oplossing, met tracking van GPTBot, ClaudeBot, Perplexity Bot en andere AI-crawlers, inclusief gedetailleerde analyses van bezochte pagina’s, crawlfrequentie en of je content in AI-antwoorden verschijnt.

Serverlog-analyse blijft essentieel voor crawl budget optimalisatie—tools als Splunk, Datadog of het open source ELK Stack laten je raw access logs ontleden en verkeer per user-agent segmenteren, zodat je ziet welke bots het meeste verbruiken en welke pagina’s de meeste crawl-aandacht krijgen. Aangepaste dashboards die crawltrends door de tijd tonen, maken duidelijk of optimalisatie werkt en of er nieuwe bottypes opduiken. Google Search Console blijft onmisbaar voor Googles crawlgedrag, terwijl Bing Webmaster Tools vergelijkbare inzichten voor Microsoft biedt. De meest geavanceerde organisaties hanteren een multi-tool monitoringstrategie met Google Search Console voor traditionele crawl data, AmICited.com voor AI-crawler tracking, serverlog-analyse voor volledig botoverzicht en tools als Conductor voor crawlsimulatie en efficiëntie-analyse. Deze gelaagde aanpak geeft compleet inzicht in alle bots op je site, zodat je optimaliseert op basis van data in plaats van giswerk. Regelmatige monitoring—idealiter wekelijkse reviews van crawlmetrics—maakt snelle detectie mogelijk van problemen zoals onverwachte crawlpieken, hogere foutpercentages of opduikende agressieve bots, waardoor je snel kunt reageren voordat crawl budget problemen de prestaties of kosten beïnvloeden.

AI-bots zoals GPTBot en ClaudeBot werken met andere prioriteiten dan Googlebot. Waar Googlebot crawl budget limieten respecteert en geavanceerde throttling toepast, vertonen AI-bots vaak agressievere crawl-patronen en verbruiken ze 12-15 keer meer bandbreedte. AI-bots geven prioriteit aan continue content-inname voor modeltraining in plaats van zoekindexering, waardoor hun crawlgedrag fundamenteel verschilt en er aparte optimalisatiestrategieën nodig zijn.

Onderzoek toont aan dat OpenAI's GPTBot 12-15 keer meer bandbreedte kan verbruiken dan Google's crawler op bepaalde websites, met name bij grote contentbibliotheken. Het exacte verbruik hangt af van de grootte van je site, de frequentie van contentupdates en het aantal AI-bots dat gelijktijdig crawlt. Meerdere AI-bots tegelijk kunnen de serverbelasting en hostingkosten aanzienlijk verhogen.

Ja, je kunt specifieke AI-crawlers blokkeren via robots.txt zonder traditionele SEO te beïnvloeden. Het blokkeren van AI-crawlers betekent echter dat je zichtbaarheid in AI-gegenereerde antwoorden van ChatGPT, Claude, Perplexity en andere AI-applicaties opgeeft. De keuze hangt af van je bedrijfsmodel—contentuitgevers profiteren meestal van toelaten, terwijl e-commerce sites kunnen kiezen voor blokkeren om concurrentietraining te voorkomen.

Slecht crawl budget beheer kan ertoe leiden dat belangrijke pagina's niet gecrawld of geïndexeerd worden, tragere indexering van nieuwe content, verhoogde serverbelasting en bandbreedtekosten, een verslechterde gebruikerservaring door botverkeer dat bronnen verbruikt, en gemiste zichtbaarheid in zowel traditionele zoekopdrachten als AI-gegenereerde antwoorden. Grote sites met miljoenen pagina's zijn het meest kwetsbaar voor deze gevolgen.

Voor optimale resultaten monitor je crawl budget statistieken wekelijks, met dagelijkse controles tijdens grote contentlanceringen of bij onverwachte verkeerspieken. Gebruik Google Search Console voor traditionele crawldata, AmICited.com voor AI-crawler tracking en serverlogs voor volledig bot-inzicht. Regelmatige monitoring maakt snelle probleemdetectie mogelijk voordat de siteprestaties eronder lijden.

Robots.txt is variabel effectief bij AI-bots. Waar Googlebot robots.txt strikt respecteert, is de naleving door AI-bots inconsistent—sommigen houden zich aan de regels, anderen negeren ze. Voor betrouwbaardere controle kun je gebruikersagent-specifieke blokkering toepassen, rate limiting op serverniveau of CDN-gebaseerde botmanagementtools als Cloudflare inzetten voor meer gedetailleerde controle.

Crawl budget heeft direct invloed op AI-zichtbaarheid, omdat AI-bots geen content kunnen citeren of refereren die ze niet gecrawld hebben. Als je belangrijke pagina's door budgetbeperkingen niet gecrawld worden, verschijnen ze niet in AI-gegenereerde antwoorden. Door het crawl budget te optimaliseren zorg je ervoor dat je beste content wordt ontdekt door AI-bots, waardoor de kans op citatie in ChatGPT-, Claude- en Perplexity-antwoorden toeneemt.

Prioriteer pagina's met dynamische sitemaps die recent bijgewerkte content, veelbezochte pagina's en pagina's met conversiepotentieel benadrukken. Gebruik robots.txt om pagina's met weinig waarde, zoals archieven en duplicaten, te blokkeren. Implementeer schone URL-structuren en strategische interne links om bots naar belangrijke content te leiden. Monitor welke pagina's AI-bots daadwerkelijk crawlen met tools als AmICited.com om je strategie te verfijnen.

Volg hoe AI-bots je site crawlen en optimaliseer je zichtbaarheid in AI-gegenereerde antwoorden met het uitgebreide AI-crawler monitoringplatform van AmICited.com.

Leer wat crawl budget voor AI betekent, hoe het verschilt van traditionele zoek crawl budgets en waarom het belangrijk is voor de zichtbaarheid van je merk in A...

Crawl budget is het aantal pagina's dat zoekmachines op je website crawlen binnen een bepaalde periode. Leer hoe je het crawl budget optimaliseert voor betere i...

Crawlfrequentie is hoe vaak zoekmachines en AI-crawlers je site bezoeken. Leer wat de crawl rates beïnvloedt, waarom het belangrijk is voor SEO en AI-zichtbaarh...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.