Robots.txt voor AI: Hoe je bepaalt welke bots toegang krijgen tot je content

Leer hoe je robots.txt gebruikt om te bepalen welke AI-bots toegang krijgen tot je content. Complete gids om GPTBot, ClaudeBot en andere AI-crawlers te blokkere...

Een strategische aanpak waarmee website-eigenaren selectief bepaalde AI-crawlers kunnen toestaan en andere kunnen blokkeren op basis van zakelijke doelstellingen, contentlicentieovereenkomsten en waardebeoordeling. In plaats van generieke beleidsmaatregelen te hanteren, beoordeelt differentiële toegang elke crawler afzonderlijk om te bepalen of deze verkeer genereert, licentievoorwaarden respecteert of aansluit bij de monetisatiedoelstellingen. Uitgevers gebruiken tools zoals robots.txt, HTTP-headers en platformspecifieke controles om gedetailleerde toegangsbeleidsregels te implementeren. Deze methode balanceert innovatiekansen met contentbescherming en eerlijke compensatie.

Een strategische aanpak waarmee website-eigenaren selectief bepaalde AI-crawlers kunnen toestaan en andere kunnen blokkeren op basis van zakelijke doelstellingen, contentlicentieovereenkomsten en waardebeoordeling. In plaats van generieke beleidsmaatregelen te hanteren, beoordeelt differentiële toegang elke crawler afzonderlijk om te bepalen of deze verkeer genereert, licentievoorwaarden respecteert of aansluit bij de monetisatiedoelstellingen. Uitgevers gebruiken tools zoals robots.txt, HTTP-headers en platformspecifieke controles om gedetailleerde toegangsbeleidsregels te implementeren. Deze methode balanceert innovatiekansen met contentbescherming en eerlijke compensatie.

De explosie van AI-crawlers heeft de decennialange relatie tussen website-eigenaren en bots fundamenteel veranderd. Jarenlang werkte het internet op basis van een eenvoudige uitwisseling: zoekmachines zoals Google indexeerden content en stuurden verkeer terug naar de oorspronkelijke bron, wat een symbiotische relatie creëerde die het maken van kwalitatieve content beloonde. Tegenwoordig werkt een nieuwe generatie AI-crawlers—including GPTBot, ClaudeBot, PerplexityBot, en tientallen anderen—volgens andere regels. Deze bots scrapen content niet om het te indexeren voor vindbaarheid, maar om het direct te voeden aan AI-modellen die antwoorden genereren zonder gebruikers terug te sturen naar de originele bron. Het effect is duidelijk: volgens Cloudflare-gegevens heeft OpenAI’s GPTBot een crawl-to-referral ratio van ongeveer 1.700:1, terwijl Anthropic’s ClaudeBot een ratio van 73.000:1 bereikt, wat betekent dat voor elke bezoeker die wordt teruggestuurd naar een uitgeverssite, duizenden pagina’s worden gecrawld voor trainingsdata. Deze gebroken uitwisseling heeft uitgevers gedwongen hun crawler-toegangsbeleid te heroverwegen, weg van de binaire keuze “alles toestaan” of “alles blokkeren” naar een meer genuanceerde strategie: differentiële crawler-toegang. In plaats van generieke beleidsmaatregelen beoordelen slimme uitgevers nu elke crawler afzonderlijk en stellen kritische vragen over waarde, licenties en aansluiting bij zakelijke doelstellingen.

Het begrijpen van de verschillende typen AI-crawlers is essentieel voor het implementeren van een effectieve differentiële toegangsstrategie, omdat elk type een ander doel dient en een verschillende impact op je business heeft. AI-crawlers vallen in drie hoofdcategorieën: trainingscrawlers (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider) die content verzamelen voor modeltraining; zoekcrawlers (OAI-SearchBot, PerplexityBot, Google-Extended) die content indexeren voor AI-gestuurde zoekresultaten; en gebruikersgestuurde agents (ChatGPT-User, Claude-Web, Perplexity-User) die alleen content ophalen als gebruikers er expliciet om vragen. De waardepropositie verschilt sterk per categorie. Trainingscrawlers leveren doorgaans minimaal verkeer terug naar je site—ze onttrekken waarde zonder wederkerig voordeel—en zijn daardoor de belangrijkste kandidaten om te blokkeren. Zoekcrawlers daarentegen kunnen substantieel verwijzingsverkeer en abonnees opleveren, vergelijkbaar met traditionele zoekmachines. Gebruikersgestuurde agents nemen een tussenpositie in en activeren alleen als gebruikers actief met AI-systemen interageren. The Atlantic, een van de grootste digitale uitgevers, implementeerde een geavanceerde scorecardaanpak om crawlers te evalueren, waarbij zowel het verkeersvolume als het aantal abonnees per bot werd bijgehouden. Hun analyse liet zien dat sommige crawlers daadwerkelijk waarde leveren, terwijl andere vrijwel geen verkeer genereren maar wel veel bandbreedte verbruiken. Deze datagedreven aanpak stelt uitgevers in staat weloverwogen beslissingen te nemen in plaats van te vertrouwen op aannames.

| Type crawler | Voorbeelden | Primair doel | Typische verkeerswaarde | Aanbevolen toegang |

|---|---|---|---|---|

| Training | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Trainingsdatasets voor modellen | Zeer laag (1.700:1 tot 73.000:1 ratio) | Vaak blokkeren |

| Zoek | OAI-SearchBot, PerplexityBot, Google-Extended | AI-zoekindexering | Middel tot hoog | Vaak toestaan |

| Gebruikersgestuurd | ChatGPT-User, Claude-Web, Perplexity-User | Directe gebruikersaanvragen | Variabel | Geval per geval |

Differentiële crawler-toegang vereist een combinatie van technische tools en strategische besluitvorming, met verschillende methoden afhankelijk van je technische mogelijkheden en zakelijke behoeften. Het meest fundamentele hulpmiddel is robots.txt, een eenvoudig tekstbestand in de root van je website dat crawler-toegangsvoorkeuren communiceert via User-agent-directieven. Hoewel robots.txt vrijwillig is en slechts 40-60% van de AI-bots het respecteert, blijft het de eerste verdedigingslinie en is het kosteloos te implementeren. Voor uitgevers die sterkere handhaving zoeken, maakt Cloudflare’s managed robots.txt automatisch crawlerregels aan en bij, voegt deze toe aan je bestaande bestand en elimineert zo handmatig onderhoud. Naast robots.txt zijn er meerdere handhavingsmechanismen die extra controle bieden:

De meest effectieve aanpak combineert meerdere lagen: robots.txt voor conforme crawlers, WAF-regels voor handhaving en monitoringtools om effectiviteit te volgen en nieuwe bedreigingen te identificeren.

Differentiële crawler-toegang vereist meer dan alleen technische implementatie; het vraagt om een samenhangende bedrijfsstrategie die aansluit bij je verdienmodel en concurrentiepositie. De aanpak van The Atlantic biedt een praktisch kader: zij evalueren elke crawler op twee hoofdcriteria—verkeersvolume en abonneeverwerving—en stellen de vraag of de crawler voldoende waarde genereert om contenttoegang te rechtvaardigen. Voor een uitgever met een abonnementswaarde van €80 per jaar vertegenwoordigt een crawler die 1.000 abonnees oplevert €80.000 aan jaarlijkse inkomsten, wat het toegangsbesluit fundamenteel beïnvloedt. Maar verkeer en abonneemetingen zijn slechts een deel van de afweging. Uitgevers moeten ook rekening houden met:

De meest strategische uitgevers hanteren een gelaagd toegangsbeleid: zoekcrawlers die verkeer opleveren worden toegestaan, trainingscrawlers zonder waarde worden geblokkeerd, en met waardevolle AI-bedrijven worden licentieafspraken gemaakt. Deze aanpak maximaliseert zowel zichtbaarheid als inkomsten en beschermt intellectueel eigendom.

Hoewel differentiële crawler-toegang aanzienlijke voordelen biedt, is de praktijk complexer dan de theorie, met enkele fundamentele uitdagingen die de effectiviteit beperken en voortdurende aandacht vereisen. De belangrijkste beperking is dat robots.txt vrijwillig is—crawlers die het respecteren doen dat uit eigen beweging, niet uit verplichting. Onderzoek toont aan dat robots.txt slechts 40-60% van de AI-bots tegenhoudt, met nog eens 30-40% die wordt gestopt via user-agent-blokkering, waardoor 10-30% van de crawlers ongehinderd hun gang kan gaan. Sommige AI-bedrijven en kwaadwillenden negeren robots.txt opzettelijk, omdat toegang tot content waardevoller wordt geacht dan naleving. Bovendien ontwikkelen crawlerevasietechnieken zich voortdurend: geavanceerde bots spoofen user agents om te lijken op legitieme browsers, gebruiken verspreide IP-adressen om detectie te ontwijken en maken gebruik van headless browsers die menselijk gedrag nabootsen. Het Google-Extended-dilemma illustreert de complexiteit: als je Google-Extended blokkeert, voorkom je dat je content wordt gebruikt voor Gemini AI-training, maar Google AI Overviews (die in zoekresultaten verschijnen) volgen de standaard Googlebot-regels, waardoor je je niet kunt afmelden voor AI Overviews zonder zoekzichtbaarheid op te geven. Monitoring en handhaving vragen ook veel resources—nieuwe crawlers volgen, beleid bijwerken en effectiviteit controleren vergt voortdurende inzet. Tot slot is het juridische landschap onzeker: hoewel het auteursrecht content theoretisch beschermt, is handhaving tegen AI-bedrijven duur en onvoorspelbaar, waardoor uitgevers wel technische controle hebben maar geen juridische zekerheid.

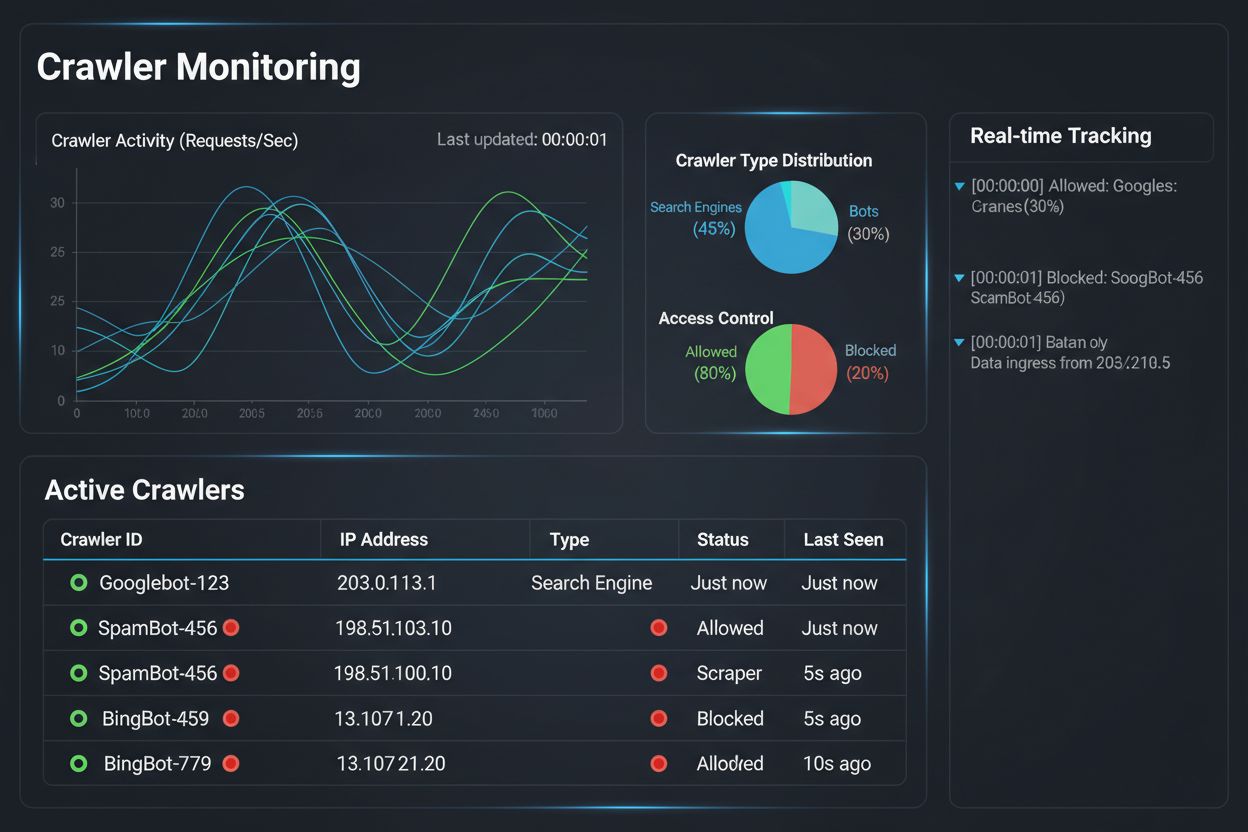

Het implementeren van een differentiële crawler-toegangsstrategie is slechts de helft van het werk; de andere helft is het begrijpen van het daadwerkelijke effect van je beleid via uitgebreide monitoring en meting. Hier wordt AmICited.com essentieel voor je crawlerbeheerstrategie. AmICited is gespecialiseerd in het monitoren van hoe AI-systemen je merk vermelden en citeren binnen GPT’s, Perplexity, Google AI Overviews en andere AI-platforms—en biedt inzicht in welke crawlers daadwerkelijk je content gebruiken en hoe deze verschijnt in AI-gegenereerde antwoorden. In plaats van te vertrouwen op serverlogs en giswerk, toont het monitoringdashboard van AmICited precies welke AI-systemen je content hebben bezocht, hoe vaak, en belangrijker nog, of je content wordt geciteerd of simpelweg wordt opgenomen in trainingsdata zonder bronvermelding. Deze informatie stuurt je beslissingen rondom differentiële toegang: als een crawler je content gebruikt maar nooit citeert in AI-antwoorden, is blokkeren een duidelijke zakelijke keuze. AmICited maakt ook concurrentiebenchmarking mogelijk, zodat je ziet hoe je contentzichtbaarheid in AI-systemen zich verhoudt tot concurrenten, en je begrijpt of je beleid te streng of te soepel is. Het platform geeft realtime meldingen wanneer nieuwe AI-systemen je content beginnen te refereren, zodat je snel je beleid kunt aanpassen. Door de monitoring van AmICited te combineren met de handhavingstools van Cloudflare, krijgen uitgevers volledig inzicht en controle: ze zien welke crawlers hun content bezoeken, meten de zakelijke impact en stellen hun beleid bij. Deze datagedreven aanpak maakt van crawlerbeheer een strategische bedrijfsfunctie in plaats van een technische formaliteit.

Het landschap van differentiële crawler-toegang ontwikkelt zich snel, met opkomende standaarden en bedrijfsmodellen die de interactie tussen uitgevers en AI-bedrijven rondom content herdefiniëren. Het IETF AI-preferentievoorstel is hierin een belangrijke stap, en creëert gestandaardiseerde manieren voor websites om hun voorkeuren voor AI-training, -inference en -zoekgebruik kenbaar te maken. In plaats van te vertrouwen op robots.txt—een 30 jaar oude standaard voor zoekmachines—biedt dit nieuwe kader expliciete, gedetailleerde controle over hoe AI-systemen content mogen gebruiken. Tegelijkertijd winnen toestemmingsgebaseerde bedrijfsmodellen terrein, met Cloudflare’s Pay Per Crawl als pionier van een model waarbij AI-bedrijven betalen voor contenttoegang en crawlers een inkomstenbron worden. Deze verschuiving van blokkeren naar licentiëren betekent een fundamentele verandering in de internet-economie: in plaats van te strijden om toegang, onderhandelen uitgevers en AI-bedrijven over eerlijke compensatie. Crawlerauthenticatie- en verificatiestandaarden maken ook voortgang, met cryptografische verificatie waarmee uitgevers crawleridentiteit kunnen bevestigen en gespoofde verzoeken voorkomen. In de toekomst zijn strengere regulatoire kaders rond AI-trainingsdata te verwachten, mogelijk met verplichte expliciete toestemming en compensatie voor contentgebruik. De convergentie van deze trends—technische standaarden, licentiemodellen, authenticatiemechanismen en regulatoire druk—suggereert dat differentiële crawler-toegang zal evolueren van een defensieve strategie naar een geavanceerde bedrijfsfunctie, waarbij uitgevers AI-crawler-toegang actief beheren, monitoren en monetariseren. Uitgevers die nu inzetten op uitgebreide monitoring en strategisch beleid, zijn het beste gepositioneerd om te profiteren van deze opkomende kansen.

Als je alle crawlers blokkeert, wordt je content volledig uit AI-systemen verwijderd, waarmee je zowel risico's als kansen elimineert. Met differentiële toegang kun je elke crawler afzonderlijk beoordelen, waarbij je diegene blokkeert die geen waarde bieden en toestaat die verkeer genereren of licentiemogelijkheden bieden. Deze genuanceerde aanpak maximaliseert zowel zichtbaarheid als inkomsten terwijl intellectueel eigendom wordt beschermd.

Je kunt crawleractiviteit monitoren via serverlogs, het Cloudflare-analyse dashboard of gespecialiseerde monitoringtools zoals AmICited.com. AmICited volgt specifiek welke AI-systemen je content bezoeken en hoe je merk verschijnt in AI-gegenereerde antwoorden, en biedt daarmee zakelijke inzichten die verder gaan dan technische logs.

Nee. Het blokkeren van AI-trainingscrawlers zoals GPTBot, ClaudeBot en CCBot heeft geen invloed op je Google- of Bing-zoekresultaten. Traditionele zoekmachines gebruiken andere crawlers (Googlebot, Bingbot) die onafhankelijk werken. Blokkeer deze alleen als je volledig uit de zoekresultaten wilt verdwijnen.

Ja, dit is voor veel uitgevers de meest strategische aanpak. Je kunt zoekgerichte crawlers zoals OAI-SearchBot en PerplexityBot toestaan (die verkeer genereren) en trainingscrawlers zoals GPTBot en ClaudeBot blokkeren (die dit doorgaans niet doen). Zo blijf je zichtbaar in AI-zoekresultaten terwijl je content wordt beschermd tegen opname in trainingsdatasets.

Hoewel grote crawlers van OpenAI, Anthropic en Google robots.txt respecteren, zijn er bots die het opzettelijk negeren. Als een crawler je robots.txt niet respecteert, heb je aanvullende handhavingsmethoden nodig, zoals WAF-regels, IP-blokkering of Cloudflare's botmanagementfuncties. Daarom zijn monitoringtools zoals AmICited essentieel—ze tonen welke crawlers je beleid daadwerkelijk naleven.

Herzie je beleid minimaal elk kwartaal, omdat AI-bedrijven regelmatig nieuwe crawlers introduceren. Anthropic heeft bijvoorbeeld hun 'anthropic-ai' en 'Claude-Web' bots samengevoegd tot 'ClaudeBot', waardoor de nieuwe bot tijdelijk onbeperkte toegang kreeg tot sites die hun regels niet hadden bijgewerkt. Regelmatige monitoring met tools zoals AmICited helpt je veranderingen voor te blijven.

Googlebot is Google's zoekcrawler die content indexeert voor zoekresultaten. Google-Extended is een controletoken dat specifiek bepaalt of je content wordt gebruikt voor Gemini AI-training. Je kunt Google-Extended blokkeren zonder invloed op zoekresultaten, maar let op: Google AI Overviews (die in zoekresultaten verschijnen) volgen de standaard Googlebot-regels, dus je kunt je niet afmelden voor AI Overviews zonder zoekzichtbaarheid te verliezen.

Ja, opkomende licentiemodellen zoals Cloudflare's Pay Per Crawl stellen uitgevers in staat AI-bedrijven te laten betalen voor contenttoegang. Hierdoor worden crawlers van een bedreiging een inkomstenbron. Dit vereist wel onderhandeling en mogelijk juridische overeenkomsten. De monitoring van AmICited helpt je te bepalen welke crawlers de meest waardevolle licentiemogelijkheden bieden.

Volg welke AI-systemen je content bezoeken en hoe je merk verschijnt in AI-gegenereerde antwoorden. Verkrijg realtime inzichten in crawlergedrag en meet de zakelijke impact van je differentiële toegangsbeleid.

Leer hoe je robots.txt gebruikt om te bepalen welke AI-bots toegang krijgen tot je content. Complete gids om GPTBot, ClaudeBot en andere AI-crawlers te blokkere...

Ontdek hoe Web Application Firewalls geavanceerde controle bieden over AI-crawlers, verder dan robots.txt. Implementeer WAF-regels om je content te beschermen t...

Leer bewezen strategieën om te verhogen hoe vaak AI-crawlers je website bezoeken, verbeter de vindbaarheid van content in ChatGPT, Perplexity en andere AI-zoekm...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.