Content SEO

Content SEO is het strategisch creëren en optimaliseren van hoogwaardige content om zoekmachineresultaten en organische zichtbaarheid te verbeteren. Leer hoe je...

JavaScript SEO is het proces van het optimaliseren van JavaScript-gerenderde websites zodat zoekmachines effectief de content kunnen crawlen, renderen en indexeren. Het omvat best practices om JavaScript-aangedreven webapplicaties vindbaar en rankbaar te maken in zoekresultaten, terwijl optimale prestaties en gebruikerservaring behouden blijven.

JavaScript SEO is het proces van het optimaliseren van JavaScript-gerenderde websites zodat zoekmachines effectief de content kunnen crawlen, renderen en indexeren. Het omvat best practices om JavaScript-aangedreven webapplicaties vindbaar en rankbaar te maken in zoekresultaten, terwijl optimale prestaties en gebruikerservaring behouden blijven.

JavaScript SEO is de gespecialiseerde praktijk van het optimaliseren van JavaScript-gerenderde websites zodat zoekmachines effectief de content kunnen crawlen, renderen en indexeren. Het omvat een uitgebreid pakket aan technische strategieën, best practices en implementatiemethoden die ontworpen zijn om JavaScript-aangedreven webapplicaties volledig vindbaar en rankbaar te maken in zoekresultaten. In tegenstelling tot traditionele HTML-websites waar content direct in de serverrespons aanwezig is, vereist JavaScript-gerenderde content extra verwerkingsstappen die sterk kunnen beïnvloeden hoe zoekmachines jouw pagina’s begrijpen en waarderen. Het vakgebied combineert technische SEO-expertise met kennis van hoe moderne webframeworks als React, Vue en Angular samenwerken met zoekmachinecrawlers. JavaScript SEO is steeds belangrijker geworden nu 98,7% van de websites op enig niveau JavaScript bevatten, waardoor het essentiële kennis is voor elke SEO-professional die met hedendaagse webtechnologieën werkt.

De opkomst van JavaScript-frameworks heeft fundamenteel veranderd hoe websites gebouwd worden en hoe zoekmachines deze moeten verwerken. In de vroege dagen van het web parseerde Googlebot simpelweg de HTML-respons van servers, waardoor SEO eenvoudig was—content in de HTML werd geïndexeerd. Maar naarmate ontwikkelaars client-side rendering gebruikten om meer interactieve en dynamische gebruikerservaringen te creëren, stonden zoekmachines voor een grote uitdaging: content was niet langer aanwezig in de initiële HTML-respons, maar werd door JavaScript in de browser gegenereerd. Deze verschuiving veroorzaakte een aanzienlijke kloof tussen wat gebruikers zagen en wat zoekmachines aanvankelijk konden bereiken. Google reageerde door headless Chromium-rendering te ontwikkelen, waardoor Googlebot JavaScript kon uitvoeren en de gerenderde DOM kon verwerken. Deze rendering is echter zeer middelenintensief—ongeveer 100 keer duurder dan alleen HTML parsen—waardoor Google niet iedere pagina direct kan renderen. Deze resourcebeperking leidde tot het concept van een renderbudget, waarbij pagina’s worden ingepland voor rendering op basis van verwachte relevantie en zoekverkeer. Inzicht in deze evolutie is cruciaal, omdat het uitlegt waarom JavaScript SEO geen optie is, maar een fundamenteel onderdeel van moderne technische SEO-strategie.

De aanpak van Google voor JavaScript-gerenderde content volgt een geavanceerd drie-fasenproces dat wezenlijk verschilt van traditioneel HTML-crawlen. In de crawl-fase vraagt Googlebot een URL op en ontvangt de initiële HTML-respons. Deze wordt direct geparseerd om links te extraheren en te controleren op indexeringsinstructies zoals robots meta-tags en noindex-declaraties. Belangrijk: als een pagina een noindex-tag in de initiële HTML bevat, zal Google deze niet renderen—een belangrijk onderscheid dat veel SEO’s over het hoofd zien. Tegelijkertijd wordt de URL in de wachtrij gezet voor de render-fase, waarin de Web Rendering Service (WRS) met headless Chromium JavaScript uitvoert, de DOM opbouwt en de volledig gerenderde HTML genereert. Deze rendering kan seconden of langer duren afhankelijk van de JavaScript-complexiteit, en pagina’s kunnen lang in de renderwachtrij blijven als Google onvoldoende resources heeft. In de indexeringsfase verwerkt Google de gerenderde HTML om content, links en metadata te extraheren voor opname in de zoekindex. Het belangrijkste inzicht: Google indexeert op basis van de gerenderde HTML, niet op basis van de initiële HTML-respons—wat betekent dat JavaScript volledig bepaalt wat wordt geïndexeerd. Dit drie-fasenproces verklaart waarom JavaScript-sites vaak trager worden geïndexeerd, waarom rendervertragingen belangrijk zijn, en waarom het vergelijken van response HTML met rendered HTML essentieel is bij het oplossen van JavaScript SEO-problemen.

| Rendermethode | Werking | SEO-voordelen | SEO-nadelen | Best geschikt voor |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | Content volledig op server gerenderd voor levering aan client | Content direct aanwezig in initiële HTML; snelle indexering; geen rendervertragingen; ondersteunt alle crawlers | Hogere serverbelasting; tragere Time to First Byte (TTFB); complexe implementatie | SEO-kritische sites, e-commerce, contentrijke sites, nieuwssites |

| Client-Side Rendering (CSR) | Server stuurt minimale HTML; JavaScript rendert content in de browser | Minder serverbelasting; betere schaalbaarheid; snellere paginawissels voor gebruikers | Vertraagde indexering; vereist rendering; onzichtbaar voor LLM-crawlers; tragere initiële laadtijd; verbruikt crawlbudget | Webapplicaties, dashboards, content achter login, sites zonder SEO-focus |

| Dynamische rendering | Server detecteert crawlers en levert voorgerenderde HTML; gebruikers krijgen CSR | Content direct beschikbaar voor crawlers; goede balans bot-gebruiker; eenvoudiger dan SSR | Complexe setup; afhankelijkheid van tools; kans op cloaking; vereist botdetectie; tijdelijke oplossing | Grote JavaScript-zware sites, SPA’s die zoekzichtbaarheid nodig hebben, overgangsoplossing |

| Static Site Generation (SSG) | Content vooraf gerenderd bij build; geleverd als statische HTML | Snelste prestaties; optimale SEO; geen rendervertraging; uitstekende Core Web Vitals | Beperkt dynamische content; rebuild nodig bij updates; niet geschikt voor realtime data | Blogs, documentatie, marketingwebsites, content die zelden verandert |

JavaScript-gerenderde websites brengen verschillende technische obstakels met zich mee die direct de SEO-prestaties en zichtbaarheid beïnvloeden. De meest fundamentele uitdaging is de rendervertraging—omdat rendering middelenintensief is, kan Google het renderen van pagina’s uren of zelfs dagen uitstellen, waardoor content niet direct na publicatie wordt geïndexeerd. Dit is vooral problematisch voor tijdgevoelige content zoals nieuwsartikelen of productlanceringen. Een ander belangrijk probleem zijn soft 404-fouten, die ontstaan wanneer single-page applications een 200 HTTP-statuscode retourneren voor niet-bestaande pagina’s, waardoor zoekmachines in de war raken over welke pagina’s geïndexeerd moeten worden. Door JavaScript veroorzaakte wijzigingen aan kritieke elementen vormen een ander groot obstakel: als JavaScript titels, canonical tags, meta robots-instructies of interne links aanpast na de initiële HTML-respons, kunnen zoekmachines verkeerde versies indexeren of belangrijke SEO-signalen missen. Het crawlbudget-probleem is vooral groot bij grote sites—JavaScript-bestanden zijn groot en middelenintensief, waardoor Google minder pagina’s kan renderen en minder diep crawlt op je site. Daarnaast voeren LLM-crawlers en AI-zoektools geen JavaScript uit, waardoor JavaScript-only content onzichtbaar is voor opkomende AI-zoekplatforms zoals Perplexity, Claude en anderen. Statistieken tonen aan dat 31,9% van de SEO’s niet weet hoe ze kunnen bepalen of een website sterk afhankelijk is van JavaScript, en 30,9% zich niet comfortabel voelt bij het onderzoeken van JavaScript-gerelateerde SEO-issues, wat de kennisachterstand in de sector benadrukt.

Het optimaliseren van JavaScript-gerenderde content vereist een veelzijdige aanpak die zowel technische implementatie als strategische besluitvorming omvat. De belangrijkste best practice is om essentiële content in de initiële HTML-respons op te nemen—titels, meta descriptions, canonical tags en kritieke body-content moeten al in de serverrespons aanwezig zijn voordat JavaScript wordt uitgevoerd. Dit zorgt ervoor dat zoekmachines direct een compleet beeld krijgen van je pagina en niet hoeven te wachten tot rendering om te begrijpen waar de pagina over gaat. Blokkeer geen JavaScript-bestanden in robots.txt, want zo kan Google pagina’s niet goed renderen; geef juist toegang tot alle JavaScript-resources die nodig zijn voor rendering. Implementeer juiste HTTP-statuscodes—gebruik 404 voor niet-bestaande pagina’s en 301 redirects voor verplaatste content, in plaats van dit met JavaScript af te handelen. Gebruik voor single-page applications de History API in plaats van URL-fragmenten om te zorgen dat elke view een unieke, crawlbare URL heeft; fragmenten zoals #/producten zijn onbetrouwbaar voor zoekmachines. Minimaliseer en stel niet-kritische JavaScript uit om de renderduur te verkorten en Core Web Vitals te verbeteren—gebruik code splitting om alleen noodzakelijke JavaScript per pagina te laden. Implementeer lazy loading voor afbeeldingen met het native loading="lazy"-attribuut in plaats van JavaScript-oplossingen, zodat zoekmachines afbeeldingen kunnen ontdekken zonder rendering. Gebruik content hashing in JavaScript-bestandsnamen (bijv. main.2a846fa617c3361f.js) zodat Google weet wanneer code gewijzigd is en opnieuw moet worden opgehaald. Test je implementatie grondig met de URL-inspectietool van Google Search Console, Screaming Frog met rendering of Sitebulb’s Response vs Render-rapport om initiële HTML met gerenderde HTML te vergelijken en verschillen te identificeren.

Het kiezen van de juiste renderaanpak is een van de meest bepalende beslissingen voor JavaScript SEO. Server-Side Rendering (SSR) is de gouden standaard voor SEO-kritische websites omdat content volledig op de server wordt gerenderd voor levering, waardoor rendervertragingen verdwijnen en alle crawlers toegang krijgen tot content. Frameworks als Next.js en Nuxt.js maken SSR-implementatie toegankelijker voor moderne ontwikkelteams. SSR vereist echter meer serverresources en kan een tragere Time to First Byte (TTFB) veroorzaken, wat de gebruikerservaring beïnvloedt. Client-Side Rendering (CSR) is geschikt voor webapplicaties waarbij SEO niet het primaire doel is, zoals dashboards, tools achter login-muren of interne applicaties. CSR verlaagt de serverbelasting en maakt zeer interactieve gebruikerservaringen mogelijk, maar veroorzaakt indexeringsvertragingen en maakt content onzichtbaar voor LLM-crawlers. Dynamische rendering vormt een pragmatische middenweg: het detecteert zoekmachinecrawlers en levert voorgerenderde HTML, terwijl gebruikers de interactieve CSR-ervaring krijgen. Tools als Prerender.io regelen dit automatisch, maar Google geeft expliciet aan dat dit een tijdelijke oplossing is en adviseert op termijn over te stappen op SSR. Static Site Generation (SSG) is optimaal voor content die zelden verandert—content wordt vooraf gerenderd bij build en geleverd als statische HTML, wat de beste prestaties en SEO oplevert. De keuze hangt af van je SEO-prioriteiten, technische resources en updatefrequentie van de content. Uit data blijkt dat 60% van de SEO’s nu JavaScript-crawlers gebruikt bij audits, wat aangeeft dat rendering steeds meer aandacht krijgt in technische SEO-analyses.

Effectieve JavaScript SEO vereist voortdurende monitoring van specifieke metrics en indicatoren die inzicht geven in hoe zoekmachines omgaan met je JavaScript-gerenderde content. De vergelijking tussen response en rendered HTML is fundamenteel—met tools als Sitebulb’s Response vs Render-rapport kun je precies zien wat JavaScript wijzigt op je pagina’s, waaronder aanpassingen aan titels, meta descriptions, canonical tags, interne links en robots-instructies. Statistieken tonen dat 18,26% van de JavaScript-crawls H1-tags alleen in de rendered HTML hebben (niet in de initiële respons), en kritisch: 4,60% van de JavaScript-audits toont noindex-tags alleen in response HTML—een rampzalig scenario waarbij Google noindex ziet en de pagina nooit rendert, waardoor indexering van gewenste content wordt voorkomen. Renderbudget-verbruik kan worden gevolgd via het Coverage Report van Google Search Console, dat toont hoeveel pagina’s in de renderwachtrij staan versus al gerenderd zijn. Core Web Vitals zijn extra belangrijk voor JavaScript-sites omdat JavaScript-uitvoering direct invloed heeft op Largest Contentful Paint (LCP), First Input Delay (FID) en Cumulative Layout Shift (CLS). Monitor indexeringslatentie—hoe snel na publicatie verschijnt je content in Google’s index—want JavaScript-sites ervaren doorgaans meer vertraging dan HTML-sites. Houd de crawlefficiëntie in de gaten door het aantal gecrawlde pagina’s te vergelijken met het totaal aantal pagina’s op je site; JavaScript-sites hebben vaak een lagere efficiëntie door resourcebeperkingen. Gebruik de URL-inspectietool van Google Search Console om te verifiëren dat kritieke content in de gerenderde HTML staat die Google verwerkt, en niet alleen in de initiële respons.

De opkomst van AI-aangedreven zoekplatforms zoals Perplexity, ChatGPT, Claude en Google AI Overviews introduceert een nieuwe dimensie aan JavaScript SEO die verder gaat dan traditionele zoekmachines. De meeste LLM-crawlers voeren geen JavaScript uit—ze gebruiken ruwe HTML en DOM-content zoals deze in de initiële serverrespons verschijnt. Dit betekent dat als jouw essentiële content, productinformatie of merkboodschap pas na JavaScript-uitvoering verschijnt, deze volledig onzichtbaar is voor AI-zoektools. Dat creëert een dubbel zichtbaarheidsprobleem: content die onzichtbaar is voor LLM-crawlers wordt niet geciteerd in AI-antwoorden, en gebruikers die via AI-platforms zoeken, vinden je content niet. Voor AmICited-gebruikers die merk- en domeinvermeldingen willen monitoren in AI-antwoorden is dit extra kritiek—als je JavaScript-gerenderde content niet toegankelijk is voor LLM-crawlers, verschijn je helemaal niet in AI-citaties. De oplossing is ervoor te zorgen dat essentiële content aanwezig is in de initiële HTML-respons, zodat deze toegankelijk is voor zowel traditionele zoekmachines als AI-crawlers. Daarom zijn Server-Side Rendering of dynamische rendering nog belangrijker in het AI-tijdperk—je wilt dat je content zichtbaar is voor zowel Googlebot als het groeiende ecosysteem van AI-zoektools die geen JavaScript uitvoeren.

Het landschap van JavaScript SEO blijft zich ontwikkelen naarmate zoekmachines en webtechnologieën vooruitgaan. Google heeft flink geïnvesteerd in verbeterde JavaScript-rendering, en is overgestapt van een tweefasig proces (crawlen en indexeren) naar een driefasig proces (crawlen, renderen en indexeren) dat moderne webapplicaties beter aankan. Toch blijft rendering resourcebeperkt, en is het onwaarschijnlijk dat Google ooit alle pagina’s direct zal renderen of het renderbudget zal afschaffen. Er is een verschuiving gaande naar hybride rendering, waarbij kritieke content server-side wordt gerenderd en interactieve elementen client-side, om SEO en gebruikerservaring te balanceren. Web Components en Shadow DOM worden steeds vaker gebruikt, waardoor SEO’s moeten begrijpen hoe deze technieken interacteren met zoekmachine-rendering. De opkomst van AI search zorgt voor extra druk om content toegankelijk te maken zonder JavaScript-uitvoering, wat waarschijnlijk de adoptie van SSR en SSG zal versnellen. Core Web Vitals blijven een ranking factor, en JavaScript’s invloed op deze metrics maakt prestatie-optimalisatie onlosmakelijk verbonden met JavaScript SEO. Branchegegevens tonen dat slechts 10,6% van de SEO’s precies begrijpt hoe Google JavaScript crawlt, rendert en indexeert, wat veel ruimte laat voor educatie en vaardigheidsontwikkeling. Naarmate JavaScript-frameworks geavanceerder worden en AI-zoekplatforms zich verspreiden, zal JavaScript SEO-expertise steeds waardevoller en noodzakelijker worden voor concurrerende organische zichtbaarheid.

main.2a846fa617c3361f.js) zodat Google weet wanneer code is gewijzigd en opnieuw moet worden opgehaaldloading="lazy") in plaats van JavaScript-oplossingen voor betere crawlercompatibiliteitJavaScript SEO is geëvolueerd van een niche technisch aandachtspunt naar een fundamenteel onderdeel van moderne zoekmachineoptimalisatie. Met 98,7% van de websites die JavaScript gebruiken en 88% van de SEO’s die regelmatig met JavaScript-afhankelijke sites werken, is de vaardigheid om JavaScript-gerenderde content te optimaliseren niet langer optioneel—het is essentieel. De complexiteit van het driefasen renderproces, de resourcebeperkingen van renderbudgetten en de opkomst van AI-zoekplatforms creëren een veelzijdige uitdaging die zowel technische kennis als strategische keuzes vereist. De cijfers zijn confronterend: 41,6% van de SEO’s heeft Google’s JavaScript-documentatie niet gelezen, 31,9% weet niet hoe ze JavaScript-afhankelijke sites herkennen, en 30,9% voelt zich niet comfortabel bij het onderzoeken van JavaScript-problemen. Toch is de impact groot—4,60% van de JavaScript-audits toont kritieke problemen zoals noindex-tags alleen in response HTML, waardoor indexering volledig wordt voorkomen. De weg vooruit vraagt om investeren in educatie, het kiezen van de juiste renderstrategie en het implementeren van best practices die zorgen dat content toegankelijk is voor zowel zoekmachines als AI-crawlers. Of het nu via Server-Side Rendering, dynamische rendering of zorgvuldige optimalisatie van Client-Side Rendering is, het doel blijft hetzelfde: maak je JavaScript-content volledig vindbaar, indexeerbaar en zichtbaar op alle zoekplatforms—van traditioneel Google Search tot opkomende AI-zoektools. Voor organisaties die AmICited gebruiken om merkzichtbaarheid in AI-antwoorden te volgen, wordt JavaScript SEO nog crucialer, omdat ongeoptimaliseerde JavaScript-content onzichtbaar is voor LLM-crawlers en geen citaties zal opleveren in AI-zoekresultaten.

Ja, Google rendert en indexeert JavaScript-content met behulp van headless Chromium. Rendering is echter zeer intensief qua middelen en wordt uitgesteld tot Google voldoende resources beschikbaar heeft. Google verwerkt pagina's in drie fasen: crawlen, renderen en indexeren. Pagina's met een noindex-tag worden niet gerenderd, en rendervertragingen kunnen het indexeren vertragen. Het belangrijkste is dat Google de gerenderde HTML—en niet de initiële HTML—gebruikt voor indexeringsbeslissingen.

Volgens gegevens uit 2024 heeft nu 98,7% van de websites een bepaalde mate van JavaScript-afhankelijkheid. Daarnaast gebruikt 62,3% van de ontwikkelaars JavaScript als primaire programmeertaal, en 88% van de SEO-specialisten heeft soms of altijd te maken met sites die afhankelijk zijn van JavaScript. Deze brede adoptie maakt JavaScript SEO-kennis essentieel voor moderne SEO-professionals.

Belangrijke uitdagingen zijn onder andere rendervertragingen die het indexeren vertragen, middelenintensieve verwerking die crawlbudget verbruikt, mogelijke soft 404-fouten in single-page applications, en door JavaScript veroorzaakte wijzigingen aan kritieke elementen zoals titels, canonicals en meta robots-tags. Bovendien voeren de meeste LLM-crawlers en AI-zoektools geen JavaScript uit, waardoor content onzichtbaar is voor AI-zoekplatformen als deze pas na rendering verschijnt.

Response HTML is de initiële HTML die door de server wordt verstuurd (wat je ziet in 'Bron weergeven'). Rendered HTML is de uiteindelijke DOM na uitvoering van JavaScript (wat je ziet in de browser Inspector). JavaScript kan de DOM aanzienlijk veranderen door content toe te voegen, meta-tags aan te passen, titels te herschrijven en links toe te voegen of te verwijderen. Zoekmachines indexeren op basis van rendered HTML, niet op basis van response HTML.

Server-Side Rendering (SSR) is optimaal voor SEO omdat de content volledig op de server wordt gerenderd voor levering. Client-Side Rendering (CSR) vereist dat zoekmachines pagina’s renderen, wat vertragingen en indexeringsproblemen kan veroorzaken. Dynamische rendering levert voorgerenderde HTML aan crawlers terwijl gebruikers CSR krijgen, maar Google raadt dit alleen als tijdelijke oplossing aan. Kies op basis van de SEO-prioriteiten van je site en technische middelen.

Gebruik de URL-inspectietool van Google Search Console: ga naar URL-inspectie, klik op 'Live URL testen', en bekijk vervolgens het tabblad 'HTML' om de gerenderde HTML te zien die Google heeft verwerkt. Alternatief kun je tools als Screaming Frog (met rendering ingeschakeld), Sitebulb’s Response vs Render-rapport of Chrome DevTools gebruiken om initiële HTML met gerenderde DOM te vergelijken en JavaScript-gerelateerde problemen te identificeren.

Een renderbudget is de hoeveelheid middelen die Google toewijst aan het renderen van pagina’s op je site. Google geeft prioriteit aan rendering voor pagina’s die naar verwachting meer zoekverkeer krijgen. JavaScript-zware sites met lagere prioriteit kunnen aanzienlijke rendervertragingen ervaren, wat het indexeren vertraagt. Het is daarom cruciaal om JavaScript te optimaliseren om de renderduur te verkorten en essentiële content in de initiële HTML-respons te plaatsen voor optimale SEO-prestaties.

De meeste LLM-crawlers en AI-zoektools (zoals Perplexity, Claude en anderen) voeren geen JavaScript uit—ze gebruiken ruwe HTML. Als jouw essentiële content pas na JavaScript-uitvoering verschijnt, is deze onzichtbaar voor zowel Google's initiële crawl als AI-zoekplatformen. Dit maakt JavaScript SEO essentieel, niet alleen voor traditionele zoekopdrachten maar ook voor zichtbaarheid en citation-mogelijkheden in opkomende AI-zoektoepassingen.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Content SEO is het strategisch creëren en optimaliseren van hoogwaardige content om zoekmachineresultaten en organische zichtbaarheid te verbeteren. Leer hoe je...

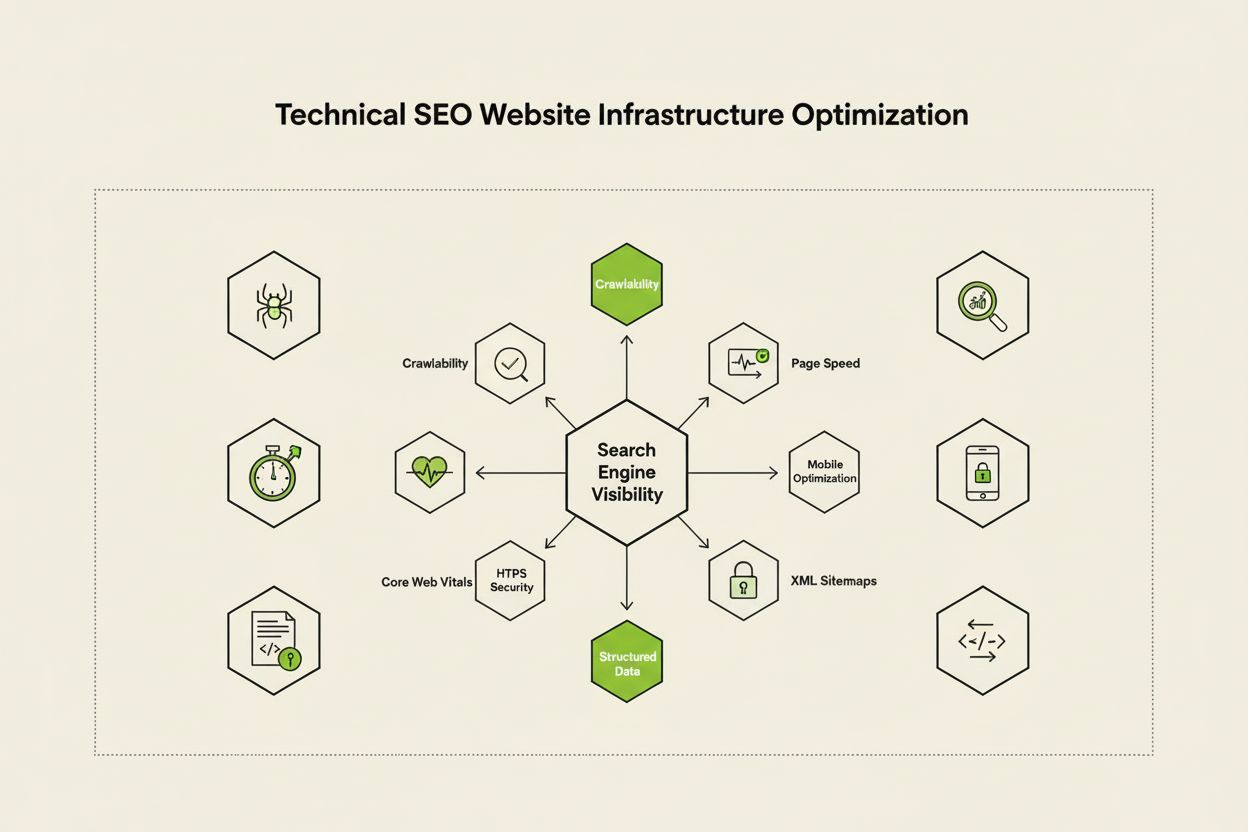

Technische SEO optimaliseert de website-infrastructuur voor crawling, indexering en ranking door zoekmachines. Leer over crawlbaarheid, Core Web Vitals, mobiele...

YouTube SEO is het proces van het optimaliseren van video's en kanalen om hoger te scoren in de zoekresultaten van YouTube. Leer rankingfactoren, optimalisaties...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.