Trainingsgegevens

Trainingsgegevens zijn de dataset die gebruikt worden om ML-modellen patronen en relaties te laten leren. Ontdek hoe de kwaliteit van trainingsgegevens de prest...

Modelparameters zijn leerbare variabelen binnen AI-modellen, zoals gewichten en bias-termen, die automatisch worden aangepast tijdens de training om het model te optimaliseren voor het maken van nauwkeurige voorspellingen en bepalen hoe het model invoerdata verwerkt om uitkomsten te genereren.

Modelparameters zijn leerbare variabelen binnen AI-modellen, zoals gewichten en bias-termen, die automatisch worden aangepast tijdens de training om het model te optimaliseren voor het maken van nauwkeurige voorspellingen en bepalen hoe het model invoerdata verwerkt om uitkomsten te genereren.

Modelparameters zijn leerbare variabelen binnen kunstmatige intelligentiemodellen die automatisch worden aangepast tijdens het trainingsproces om het vermogen van het model te optimaliseren om nauwkeurige voorspellingen te doen en te bepalen hoe het model invoerdata verwerkt om uitkomsten te genereren. Deze parameters dienen als de fundamentele “knoppen” van machine learning-systemen en bepalen het precieze gedrag en de besluitvormingspatronen van AI-modellen. In de context van deep learning en neurale netwerken bestaan parameters voornamelijk uit gewichten en biases—numerieke waarden die bepalen hoe informatie door het netwerk stroomt en hoe sterk verschillende kenmerken de voorspellingen beïnvloeden. Het doel van training is het vinden van de optimale waarden voor deze parameters die de voorspellingsfouten minimaliseren en het model in staat stellen goed te generaliseren naar nieuwe, ongeziene data. Inzicht in modelparameters is essentieel om te begrijpen hoe moderne AI-systemen zoals ChatGPT, Claude, Perplexity en Google AI Overviews functioneren en waarom ze verschillende uitkomsten genereren bij dezelfde invoer.

Het concept van leerbare parameters in machine learning stamt uit de vroege dagen van kunstmatige neurale netwerken in de jaren 1950 en 1960, toen onderzoekers voor het eerst inzagen dat netwerken interne waarden konden aanpassen om te leren van data. De praktische toepasbaarheid van parameters bleef echter beperkt tot de introductie van backpropagation in de jaren 1980, die een efficiënt algoritme bood om te berekenen hoe parameters moeten worden aangepast om fouten te verminderen. De explosieve groei van het aantal parameters versnelde enorm met de opkomst van deep learning in de jaren 2010. Vroege convolutionele neurale netwerken voor beeldherkenning bevatten miljoenen parameters, terwijl moderne grote taalmodellen (LLMs) honderden miljarden of zelfs triljarden parameters bevatten. Volgens onderzoek van Our World in Data en Epoch AI is het aantal parameters in bekende AI-systemen exponentieel gegroeid, met 175 miljard parameters in GPT-3, ongeveer 200 miljard in GPT-4o, en sommige schattingen suggereren dat GPT-4 tot 1,8 biljoen parameters bevat als rekening wordt gehouden met mixture-of-experts-architecturen. Deze schaalvergroting heeft fundamenteel veranderd wat AI-systemen kunnen bereiken, waardoor ze steeds complexere patronen in taal, beeld en redeneertaken kunnen vastleggen.

Modelparameters functioneren via een wiskundig raamwerk waarbij elke parameter een numerieke waarde vertegenwoordigt die bepaalt hoe het model invoer omzet in uitvoer. In een eenvoudig lineair regressiemodel bestaan parameters uit de helling (m) en het intercept (b) in de vergelijking y = mx + b, waarbij deze twee waarden de lijn bepalen die het beste bij de data past. In neurale netwerken wordt de situatie exponentieel complexer. Elke neuron in een laag ontvangt input van de vorige laag, vermenigvuldigt elke invoer met een corresponderende gewicht-parameter, telt deze gewogen invoeren op, voegt een bias-parameter toe en voert het resultaat door een activatiefunctie om een output te genereren. Deze output wordt vervolgens de input voor neuronen in de volgende laag, wat resulteert in een keten van parameter-gestuurde transformaties. Tijdens training gebruikt het model gradient descent en gerelateerde optimalisatie-algoritmen om te berekenen hoe elke parameter moet worden aangepast om de verliesfunctie—een wiskundige maat voor de voorspellingsfout—te verkleinen. De gradiënt van het verlies ten opzichte van elke parameter geeft de richting en grootte van de benodigde aanpassing aan. Via backpropagation stromen deze gradiënten terug door het netwerk, waardoor de optimizer alle parameters gelijktijdig en gecoördineerd kan bijwerken. Dit iteratieve proces herhaalt zich over meerdere trainingsepoches totdat de parameters convergeren naar waarden die het verlies op de trainingsdata minimaliseren en tegelijkertijd goed generaliseren naar nieuwe data.

| Aspect | Modelparameters | Hyperparameters | Features |

|---|---|---|---|

| Definitie | Leerbare variabelen die tijdens training worden aangepast | Configuratie-instellingen die vóór training worden bepaald | Kenmerken van invoerdata die het model gebruikt |

| Wanneer ingesteld | Automatisch geleerd door optimalisatie | Handmatig ingesteld door experts | Geëxtraheerd of ontwikkeld uit ruwe data |

| Voorbeelden | Gewichten, biases in neurale netwerken | Leerpercentage, batchgrootte, aantal lagen | Pixelwaarden in afbeeldingen, woordembeddings in tekst |

| Invloed op model | Bepalen hoe het model invoer koppelt aan uitvoer | Sturen het trainingsproces en de modelstructuur | Bieden de ruwe informatie waar het model van leert |

| Optimalisatiemethode | Gradient descent, Adam, AdaGrad | Grid search, random search, Bayesiaanse optimalisatie | Feature engineering, feature selectie |

| Aantal in grote modellen | Miljarden tot triljarden (bijv. 200B in GPT-4o) | Meestal 5-20 belangrijke hyperparameters | Duizenden tot miljoenen afhankelijk van data |

| Computationele kosten | Hoog tijdens training; beïnvloedt inference-snelheid | Minimale computationele kosten voor instellen | Afhankelijk van dataverzameling en preprocessing |

| Overdraagbaarheid | Kan worden overgedragen via fine-tuning en transfer learning | Moet opnieuw worden afgestemd voor nieuwe taken | Moet mogelijk herontworpen worden voor nieuwe domeinen |

Modelparameters nemen verschillende vormen aan, afhankelijk van de architectuur en het type machine learning-model. In convolutionele neurale netwerken (CNN’s) voor beeldherkenning omvatten parameters de gewichten in convolutionele filters (ook wel kernels genoemd) die ruimtelijke patronen zoals randen, texturen en vormen op verschillende schalen detecteren. Recurrente neurale netwerken (RNN’s) en long short-term memory (LSTM)-netwerken bevatten parameters die de informatiestroom door de tijd sturen, inclusief gating-parameters die bepalen welke informatie wordt onthouden of vergeten. Transformermodellen, die moderne grote taalmodellen aandrijven, bevatten parameters in meerdere componenten: attentiegewichten die bepalen op welke delen van de input wordt gefocust, gewichten in feed-forward netwerken, en normalisatieparameters per laag. In probabilistische modellen zoals Naive Bayes definiëren parameters conditionele kansverdelingen. Support vector machines gebruiken parameters die de positie en oriëntatie van beslissingsvlakken in de feature space bepalen. Mixture of Experts (MoE)-modellen, gebruikt in sommige versies van GPT-4, bevatten parameters voor meerdere gespecialiseerde subnetwerken plus routingparameters die bepalen welke experts elke invoer verwerken. Deze architecturale diversiteit betekent dat het type en aantal parameters aanzienlijk varieert tussen verschillende modellen, maar het fundamentele principe blijft gelijk: parameters zijn de geleerde waarden die het model in staat stellen zijn taak uit te voeren.

Gewichten en biases vormen de twee fundamentele typen parameters in neurale netwerken en zijn de basis van het leerproces van deze modellen. Gewichten zijn numerieke waarden die worden toegewezen aan verbindingen tussen neuronen en bepalen de sterkte en richting van de invloed die de output van het ene neuron heeft op de input van het volgende neuron. In een volledig verbonden laag met 1.000 inputneuronen en 500 outputneuronen zijn er 500.000 gewichtparameters—één per verbinding. Tijdens training worden gewichten aangepast om de invloed van specifieke kenmerken op voorspellingen te vergroten of te verkleinen. Een grote positieve gewicht betekent dat een kenmerk de volgende neuron sterk activeert, terwijl een negatief gewicht het onderdrukt. Biases zijn extra parameters, één per neuron in een laag, die een constante offset geven aan de inputsom van de neuron voordat de activatiefunctie wordt toegepast. Wiskundig gezien stelt de bias een neuron in staat om een niet-nul output te produceren, zelfs als de gewogen input nul is, wat cruciale flexibiliteit oplevert. Deze flexibiliteit stelt neurale netwerken in staat complexe beslissingsgrenzen te leren en patronen te vatten die met alleen gewichten niet mogelijk zouden zijn. In een model met 200 miljard parameters zoals GPT-4o bestaat het grootste deel uit gewichten in de aandachtmechanismen en feed-forward netwerken, met biases als een kleiner, maar nog steeds significant deel. Samen stellen gewichten en biases het model in staat de complexe patronen in taal, beeld of andere domeinen te leren die moderne AI-systemen zo krachtig maken.

Het aantal parameters in een model heeft een diepgaande invloed op het vermogen om complexe patronen te leren en op de algehele prestaties. Onderzoek toont consequent aan dat scalingswetten de relatie bepalen tussen het aantal parameters, de omvang van de trainingsdata en de modelprestaties. Modellen met meer parameters kunnen complexere functies representeren en meer genuanceerde patronen in data vatten, wat doorgaans leidt tot betere prestaties op uitdagende taken. GPT-3 met 175 miljard parameters liet opmerkelijke few-shot learning-vaardigheden zien die kleinere modellen niet konden evenaren. GPT-4o met 200 miljard parameters toont verdere verbeteringen in redeneren, codegeneratie en multimodale interpretatie. De relatie tussen parameters en prestaties is echter niet lineair en hangt sterk af van de hoeveelheid en kwaliteit van de trainingsdata. Een model met te veel parameters ten opzichte van de data zal overfitten, waarbij het specifieke voorbeelden onthoudt in plaats van generaliseerbare patronen te leren, wat resulteert in slechte prestaties op nieuwe data. Omgekeerd kan een model met te weinig parameters onderfitten, waardoor het belangrijke patronen mist en zelfs op trainingsdata suboptimale prestaties levert. Het optimale aantal parameters voor een taak hangt af van factoren zoals de complexiteit van de taak, de omvang en diversiteit van de trainingsdata en computationele beperkingen. Onderzoek van Epoch AI laat zien dat moderne AI-systemen opmerkelijke prestaties hebben bereikt door grootschalige opschaling, met sommige modellen die triljarden parameters bevatten in mixture-of-experts-architecturen, waarbij niet alle parameters actief zijn bij elke invoer.

Hoewel grote modellen met miljarden parameters indrukwekkende prestaties leveren, zijn de computationele kosten van training en inzet aanzienlijk. Dit heeft geleid tot onderzoek naar parameter-efficiënte fine-tuning methoden waarmee voorgetrainde modellen kunnen worden aangepast aan nieuwe taken zonder dat alle parameters hoeven te worden bijgewerkt. LoRA (Low-Rank Adaptation) is een prominente techniek die de meeste voorgetrainde parameters bevriest en slechts een klein aantal extra laag-rang matrices traint, waardoor het aantal te trainen parameters met orders van grootte wordt verminderd terwijl de prestaties behouden blijven. Zo kan het fine-tunen van een 7 miljard parameter model met LoRA betekenen dat slechts 1-2 miljoen extra parameters worden getraind in plaats van alle 7 miljard. Adaptermodules voegen kleine trainbare netwerken toe tussen de lagen van een bevroren voorgetraind model, wat slechts een klein percentage extra parameters toevoegt maar wel taakgerichte aanpassing mogelijk maakt. Prompt engineering en in-context learning zijn alternatieve benaderingen waarbij de parameters niet worden aangepast, maar door zorgvuldig samengestelde input worden de bestaande parameters effectiever benut. Deze parameter-efficiënte methoden hebben de toegang tot grote taalmodellen gedemocratiseerd, waardoor organisaties met beperkte middelen toch state-of-the-art modellen kunnen afstemmen op hun behoeften. De afweging tussen parameter-efficiëntie en prestaties blijft een actief onderzoeksgebied, waarbij men het verlangen naar computationele efficiëntie afweegt tegen de behoefte aan taakspecifieke nauwkeurigheid.

Inzicht in modelparameters is cruciaal voor platformen zoals AmICited die monitoren hoe merken en domeinen verschijnen in AI-gegenereerde antwoorden van systemen zoals ChatGPT, Perplexity, Claude en Google AI Overviews. Verschillende AI-modellen met verschillende parameterconfiguraties produceren verschillende uitkomsten op dezelfde vraag, wat beïnvloedt waar en hoe merken worden genoemd. De 200 miljard parameters in GPT-4o zijn anders geconfigureerd dan de parameters in Claude 3.5 Sonnet of de modellen van Perplexity, wat leidt tot variaties in antwoordgeneratie. Parameters die geleerd zijn tijdens training op verschillende datasets en met verschillende trainingsdoelen zorgen ervoor dat modellen verschillende kennis, redeneerpatronen en citeergedrag hebben. Bij het monitoren van merkvermeldingen in AI-antwoorden helpt het inzicht dat deze verschillen voortkomen uit variaties in parameters te verklaren waarom een merk prominent kan voorkomen in het antwoord van het ene AI-systeem, maar nauwelijks wordt genoemd in dat van een ander. De parameters die aandachtmechanismen aansturen, bepalen welke delen van de trainingsdata van het model het meest relevant zijn voor een vraag, wat invloed heeft op citeerpatronen. Parameters in de outputlagen bepalen hoe het model informatie structureert en presenteert. Door te volgen hoe verschillende AI-systemen met verschillende parameterconfiguraties merken noemen, biedt AmICited inzicht in hoe parameter-gedreven modelgedrag merkzichtbaarheid beïnvloedt in het AI-zoeklandschap.

De toekomst van modelparameters wordt gevormd door verschillende samenkomende trends die fundamenteel zullen veranderen hoe AI-systemen worden ontworpen en ingezet. Mixture of Experts (MoE)-architecturen vormen een belangrijke evolutie, waarbij modellen bestaan uit meerdere gespecialiseerde subnetwerken (experts) met aparte parameters, en een routeringsmechanisme bepaalt welke experts een invoer verwerken. Deze aanpak maakt het mogelijk modellen op te schalen tot triljarden parameters met behoud van computationele efficiëntie tijdens inference, omdat niet alle parameters actief zijn bij elke invoer. GPT-4 gebruikt naar verluidt een MoE-architectuur met 16 experts, elk met 110 miljard parameters, wat neerkomt op 1,8 biljoen parameters, maar slechts een fractie wordt gebruikt bij inference. Spaarzame parameters en pruning-technieken worden ontwikkeld om minder belangrijke parameters te identificeren en te verwijderen, waardoor het model kleiner wordt zonder prestatieverlies. Continual learning-benaderingen zijn gericht op het efficiënt bijwerken van parameters naarmate nieuwe data beschikbaar komt, waardoor modellen zich kunnen aanpassen zonder volledige retraining. Federated learning verdeelt parametertraining over meerdere apparaten met behoud van privacy, zodat organisaties profiteren van grootschalige training zonder gevoelige data te centraliseren. De opkomst van small language models (SLMs) met miljarden in plaats van honderden miljarden parameters wijst op een toekomst waarin parameter-efficiëntie net zo belangrijk wordt als het absolute aantal parameters. Naarmate AI-systemen steeds meer worden geïntegreerd in kritische toepassingen, zal het begrijpen en beheren van modelparameters steeds belangrijker worden voor veiligheid, eerlijkheid en afstemming op menselijke waarden. De relatie tussen het aantal parameters en het modelgedrag blijft een centraal onderwerp van AI-onderzoek, met implicaties voor alles van computationele duurzaamheid tot de uitlegbaarheid en betrouwbaarheid van AI-systemen.

Modelparameters zijn interne variabelen die tijdens de training worden geleerd via optimalisatie-algoritmen zoals gradient descent, terwijl hyperparameters externe instellingen zijn die vóór de training worden geconfigureerd. Parameters bepalen hoe het model invoer aan uitkomsten koppelt, terwijl hyperparameters het trainingsproces zelf sturen, zoals het leerpercentage en het aantal epochs. Bijvoorbeeld, gewichten en biases in neurale netwerken zijn parameters, terwijl het leerpercentage een hyperparameter is.

Moderne grote taalmodellen bevatten miljarden tot triljarden parameters. GPT-4o bevat ongeveer 200 miljard parameters, terwijl GPT-4o-mini er ongeveer 8 miljard heeft. Claude 3.5 Sonnet werkt ook met honderden miljarden parameters. Deze enorme aantallen stellen modellen in staat complexe patronen in taal te vatten en geavanceerde, contextueel relevante antwoorden te genereren over diverse onderwerpen.

Meer parameters vergroten het vermogen van een model om complexe patronen en relaties in data te leren. Met extra parameters kunnen modellen meer genuanceerde kenmerken en interacties representeren, wat leidt tot een hogere nauwkeurigheid op de trainingsdata. Er is echter een belangrijk evenwicht: te veel parameters ten opzichte van de trainingsdata kan leiden tot overfitting, waarbij het model ruis onthoudt in plaats van generaliseerbare patronen leert, wat resulteert in slechte prestaties op nieuwe, ongeziene data.

Modelparameters worden bijgewerkt via backpropagation en optimalisatie-algoritmen zoals gradient descent. Tijdens training doet het model voorspellingen, berekent het het verlies (de fout) tussen voorspellingen en werkelijke waarden, en berekent vervolgens de gradiënten die aangeven hoe elke parameter heeft bijgedragen aan die fout. De optimizer past dan de parameters aan in de richting die het verlies vermindert, en herhaalt dit proces over meerdere trainingsiteraties totdat het model convergeert naar optimale waarden.

Gewichten bepalen de sterkte van verbindingen tussen neuronen in neurale netwerken en sturen hoe sterk invoerkenmerken de uitkomsten beïnvloeden. Biases fungeren als drempel-aanpassers, waardoor neuronen kunnen activeren, zelfs als de gewogen invoer nul is. Ze bieden flexibiliteit en stellen het model in staat basispatronen te leren. Samen vormen gewichten en biases de kern van de leerbare parameters die neurale netwerken in staat stellen complexe functies te benaderen en nauwkeurige voorspellingen te doen.

Modelparameters beïnvloeden direct hoe AI-systemen zoals ChatGPT, Perplexity en Claude vragen verwerken en beantwoorden. Inzicht in het aantal en de configuratie van parameters helpt verklaren waarom verschillende AI-modellen verschillende uitkomsten geven op dezelfde prompt. Voor merkmonitoringplatformen zoals AmICited is het volgen van de invloed van parameters op modelgedrag cruciaal om te voorspellen waar merken in AI-antwoorden verschijnen en om consistentie tussen verschillende AI-systemen te begrijpen.

Ja, via transfer learning kunnen parameters van een voorgetraind model worden aangepast voor nieuwe taken. Deze aanpak, fine-tuning genoemd, houdt in dat een model met geleerde parameters wordt genomen en deze worden aangepast op nieuwe data voor specifieke toepassingen. Parameter-efficiënte fine-tuning methoden zoals LoRA (Low-Rank Adaptation) maken selectieve parameterupdates mogelijk, waardoor de computationele kosten dalen terwijl de prestaties behouden blijven. Deze techniek wordt veel gebruikt om grote taalmodellen aan te passen voor gespecialiseerde domeinen.

Modelparameters hebben direct invloed op de computationele vereisten tijdens zowel training als inferentie. Meer parameters vereisen meer geheugen, rekenkracht en tijd om te trainen en te implementeren. Een model met 175 miljard parameters (zoals GPT-3) vraagt aanzienlijk meer computationele middelen dan een model met 7 miljard parameters. Deze relatie is cruciaal voor organisaties die AI-systemen inzetten, omdat het aantal parameters de infrastructuurkosten, latency en energieverbruik in productieomgevingen beïnvloedt.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Trainingsgegevens zijn de dataset die gebruikt worden om ML-modellen patronen en relaties te laten leren. Ontdek hoe de kwaliteit van trainingsgegevens de prest...

Ontdek hoe AI-model-finetuning vooraf getrainde modellen aanpast voor specifieke industrie- en merktaken, de nauwkeurigheid verbetert en de kosten en rekenverei...

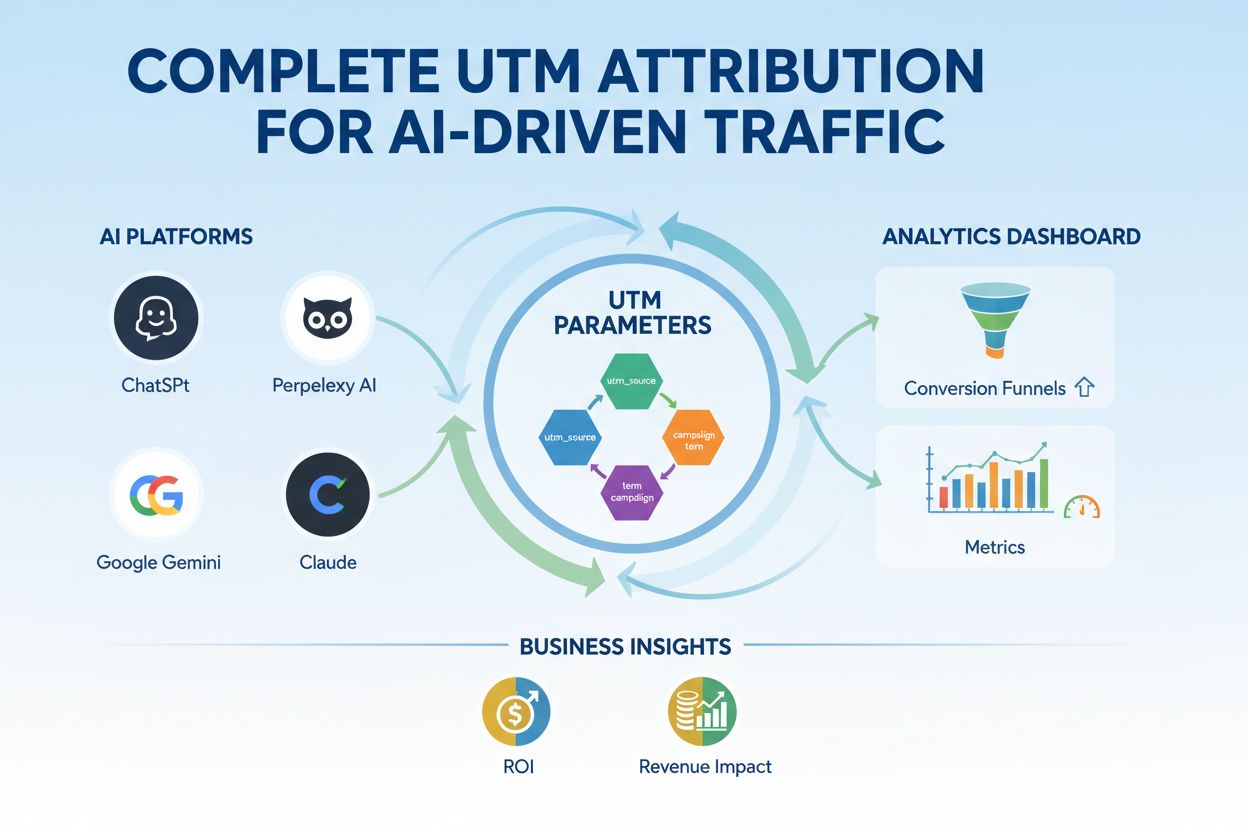

Beheers UTM-tracking voor AI-platforms zoals ChatGPT, Perplexity en Google Gemini. Leer de installatie, best practices en hoe je AI-verkeer nauwkeurig attribuee...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.