Panda Update

Lees meer over Google's Panda Update, de algoritmewijziging uit 2011 gericht op lage kwaliteitscontent. Begrijp hoe het werkt, de impact op SEO en herstelstrate...

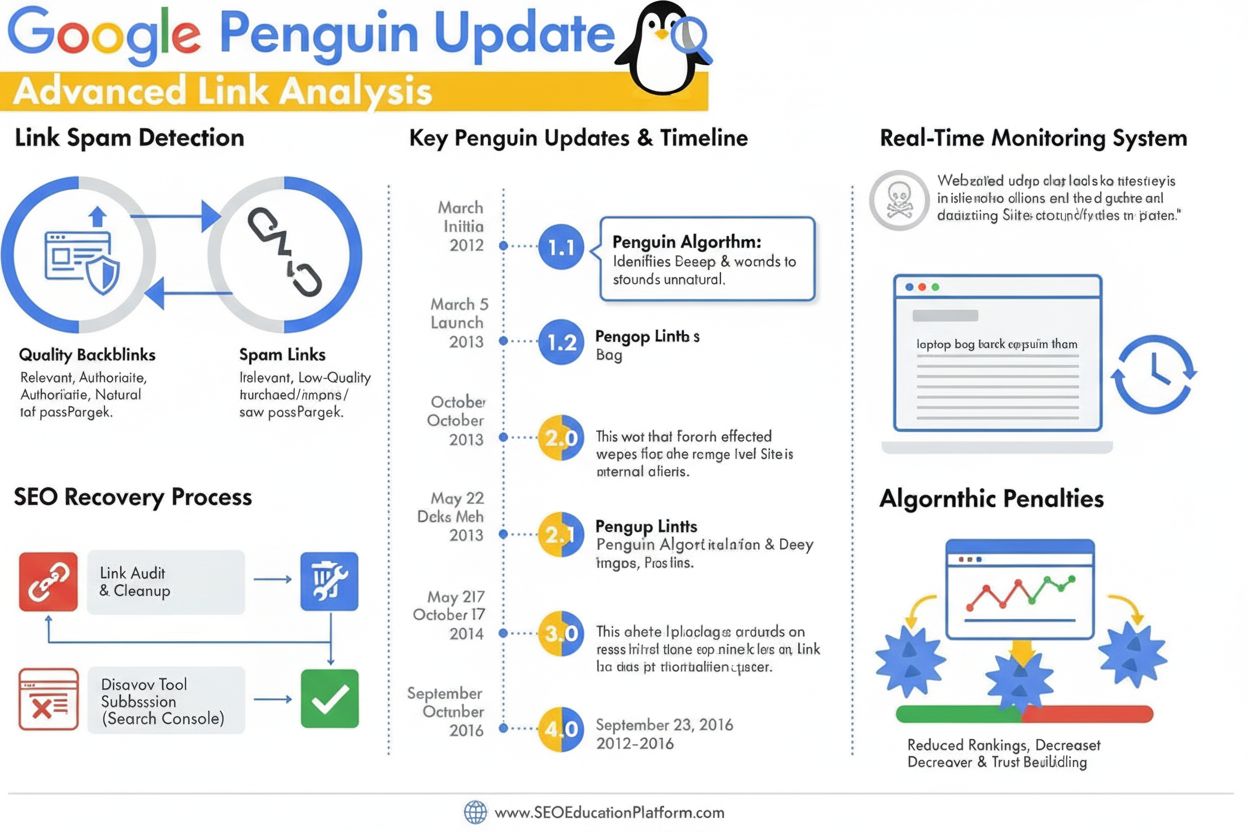

De Penguin Update is een Google-algoritme dat is ontworpen om linkspam en manipulatieve linkbuildingpraktijken tegen te gaan door lage kwaliteit, onnatuurlijke backlinks te identificeren en te devalueren. Voor het eerst gelanceerd in april 2012, evolueerde het in 2016 tot een realtime algoritmecomponent die continu de rankings monitort en aanpast op basis van backlinkkwaliteit en patronen in linknetwerken.

De Penguin Update is een Google-algoritme dat is ontworpen om linkspam en manipulatieve linkbuildingpraktijken tegen te gaan door lage kwaliteit, onnatuurlijke backlinks te identificeren en te devalueren. Voor het eerst gelanceerd in april 2012, evolueerde het in 2016 tot een realtime algoritmecomponent die continu de rankings monitort en aanpast op basis van backlinkkwaliteit en patronen in linknetwerken.

De Penguin Update is een Google-algoritme dat specifiek is ontworpen om linkspam en manipulatieve linkbuildingpraktijken tegen te gaan door websites met onnatuurlijke of lage kwaliteit backlinkprofielen te identificeren, te devalueren en te bestraffen. Voor het eerst officieel aangekondigd door Matt Cutts op 24 april 2012, vormde het Penguin-algoritme Google’s krachtige reactie op het groeiende probleem van black-hat SEO-technieken waarmee zoekresultaten kunstmatig werden opgeblazen via gekochte links, linkruil en andere misleidende methoden. Het primaire doel van het algoritme is ervoor te zorgen dat natuurlijke, gezaghebbende en relevante links worden beloond, terwijl manipulatieve en spamlinks worden gedevalueerd of volledig genegeerd. In tegenstelling tot contentgerichte updates zoals Panda, die zich richt op lage kwaliteit content, beoordeelt Penguin specifiek de kwaliteit en authenticiteit van het inkomende linkprofiel van een website, waardoor het al meer dan tien jaar een cruciaal onderdeel is van Google’s rankingsysteem.

De Penguin Update ontstond in een kritieke periode binnen zoekmachineoptimalisatie waarin het aantal links een onevenredig grote rol speelde bij het bepalen van zoekresultaten. Voor de introductie van Penguin konden webmasters hun rankings kunstmatig verhogen door grote aantallen lage kwaliteit links te verzamelen van linkfarms, private blognetwerken en andere spambronnen. Dit leidde tot een ernstig probleem voor de zoekresultaten van Google, omdat websites en content van lage kwaliteit op prominente posities verschenen zonder echte autoriteit of relevantie. Matt Cutts, destijds hoofd van Google’s webspamteam, verklaarde tijdens de SMX Advanced 2012-conferentie: “We zien het als iets dat is ontworpen om lage kwaliteit content aan te pakken. Het begon met Panda, en toen zagen we dat er nog steeds veel spam was, en Penguin is ontworpen om dat aan te pakken.” De eerste lancering van Penguin beïnvloedde meer dan 3% van alle zoekopdrachten, waarmee het een van de meest ingrijpende algoritme-updates in de geschiedenis van Google was. Deze enorme impact liet de SEO-industrie zien dat Google hard zou optreden tegen manipulatieve linkpraktijken en zijn algoritmes zou blijven doorontwikkelen om de zoekkwaliteit te waarborgen.

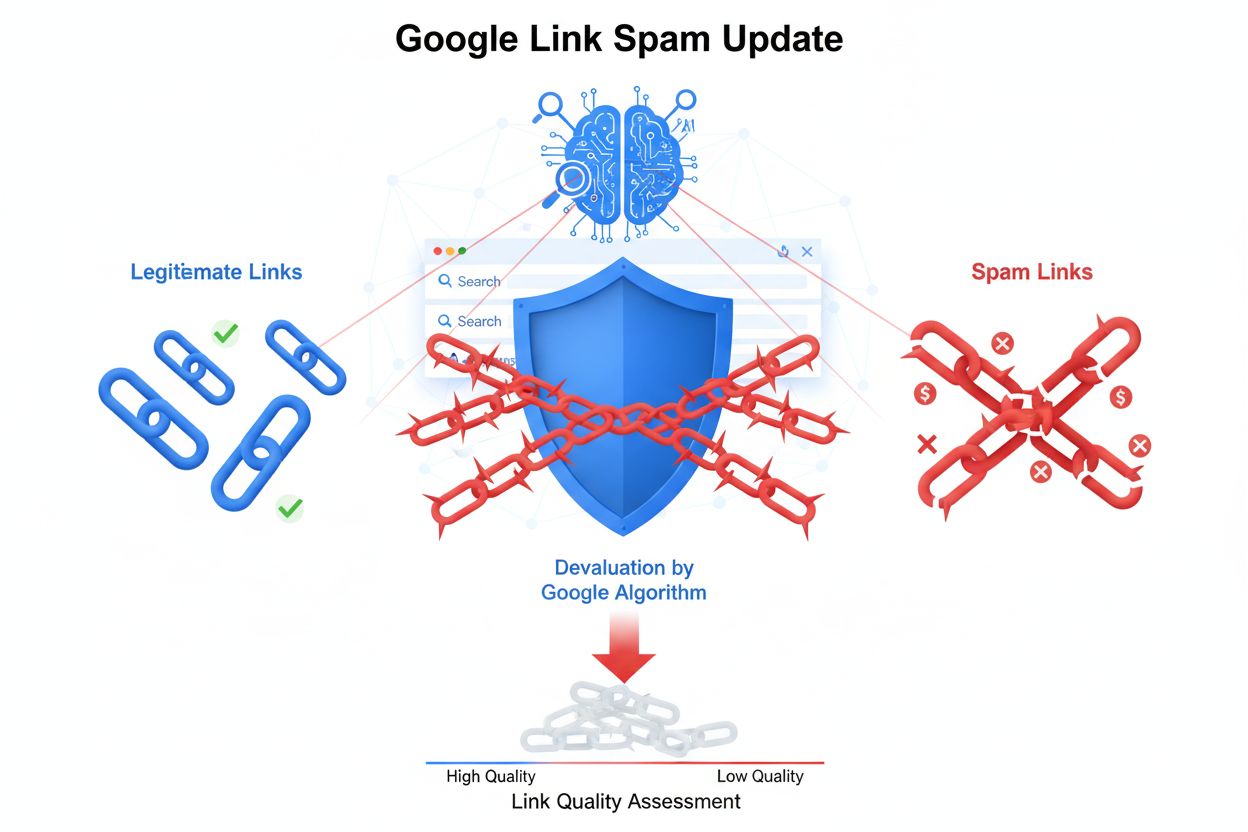

Het Penguin-algoritme werkt via geavanceerde machine learning en patroonherkenningssystemen die backlinkprofielen analyseren om onnatuurlijke linkpatronen te identificeren. Het algoritme onderzoekt meerdere factoren bij het beoordelen van linkkwaliteit, waaronder de autoriteit en relevantie van verwijzende domeinen, de gebruikte ankertekst in links, de snelheid van linkacquisitie en de contextuele relevantie tussen de verwijzende site en de doelwebsite. Penguin richt zich specifiek op linknetwerken, die een breed scala aan manipulatieve praktijken omvatten zoals gekochte links, wederzijdse linkruil, links uit private blognetwerken (PBN’s), links uit directories van lage kwaliteit en links met overdreven keyword-rijke ankertekst. Het algoritme beoordeelt ook de verhouding tussen hoogwaardige links en lage kwaliteit links in het backlinkprofiel van een website, met het besef dat zelfs legitieme websites soms enkele lage kwaliteit links ontvangen. Maar wanneer het aandeel spamlinks buitensporig hoog wordt, markeert Penguin de site voor mogelijke rankingaanpassingen. Een cruciaal aspect van het ontwerp van Penguin is dat alleen inkomende links naar een website worden beoordeeld; uitgaande links vanaf die site worden niet geanalyseerd, zodat uitsluitend de kwaliteit van backlinks naar het domein wordt geëvalueerd.

De Penguin Update onderging een aanzienlijke evolutie vanaf de eerste lancering via meerdere iteraties, met als meest ingrijpende verandering de introductie van Penguin 4.0 in september 2016. Vóór deze mijlpaal werkte Penguin op een batch-update schema, waarbij Google periodiek updates aankondigde die backlinkprofielen opnieuw evalueerden en rankings aanpasten. Penguin 1.1 (maart 2012) en Penguin 1.2 (oktober 2012) waren data-verversingen waarmee eerder bestrafte sites konden herstellen als ze hun linkprofiel hadden opgeschoond. Penguin 2.0 (mei 2013) was technisch geavanceerder, beïnvloedde ongeveer 2,3% van de Engelstalige zoekopdrachten en keek voor het eerst verder dan homepages en hoofdcategoriepagina’s, door diepere site-structuren te analyseren op linkspam. Penguin 2.1 (oktober 2013) en Penguin 3.0 (oktober 2014) zetten deze ontwikkeling voort met incrementele verbeteringen in detectie. De release van Penguin 4.0 veranderde echter fundamenteel hoe het algoritme werkt, door het te integreren in Google’s kernalgoritme als een realtime component. Dit betekende dat websites nu continu worden geëvalueerd en rankingaanpassingen direct plaatsvinden zodra het linkprofiel verandert, in plaats van te wachten op geplande updates. De omschakeling naar realtime verwerking wijzigde ook de bestrafmethode van Penguin: in plaats van directe rankingpenalty’s worden spamlinks nu simpelweg genegeerd via linkdevaluatie, waardoor ze geen site-brede dalingen meer veroorzaken.

| Beoordelingsfactor | Hoogwaardige links | Links van lage kwaliteit/spam | Penguin-detectie |

|---|---|---|---|

| Autoriteit linkbron | Gerenommeerde, vertrouwde domeinen met sterke domeinautoriteit | Nieuwe domeinen, lage DA-sites of bekende spamnetwerken | Analyseert domeingeschiedenis, vertrouwenssignalen en thematische relevantie |

| Ankertekst | Natuurlijk, gevarieerd, contextueel relevante zinnen | Exacte zoekwoorden, repetitief, over-geoptimaliseerd | Markeert onnatuurlijke ankertekstpatronen en keyword stuffing |

| Linkacquisitiesnelheid | Geleidelijke, organische opbouw in de tijd | Plotselinge pieken of onnatuurlijke patronen | Controleert snelheid en consistentie van linkaanwas |

| Contextuele relevantie | Links van inhoudelijk gerelateerde, gezaghebbende bronnen | Links van niet-gerelateerde of lage kwaliteit bronnen | Beoordeelt semantische relevantie tussen verwijzende en doelsite |

| Linkplaatsing | Redactionele links in de content, natuurlijke context | Footerlinks, zijbalklinks of plaatsingen in linkfarms | Beoordeelt linkplaatsing en contextuele integratie |

| Kwaliteit verwijzende site | Hoge kwaliteit content, legitieme bedrijfsactiviteiten | Dunne content, automatisch gegenereerde pagina’s of PBN’s | Onderzoekt algehele sitekwaliteit en contentauthenticiteit |

| Nofollow-status | Correct gebruikt waar passend | Verkeerd gebruikt of afwezig bij betaalde/promotionele links | Herkent correct gebruik van nofollow voor niet-redactionele links |

De Penguin Update transformeerde SEO-praktijken fundamenteel door linkkwaliteit tot een kritieke rankingfactor te maken en het grootschalig inzetten van black-hat linkbuildingtechnieken te ontmoedigen. Voor Penguin voerden veel SEO-bureaus en webmasters agressieve linkinkoopcampagnes, linkruil en PBN-creatie uit zonder veel gevolgen. De introductie van het algoritme veroorzaakte direct marktdisruptie, met duizenden websites die hun rankings en verkeer drastisch zagen dalen. Dit dwong de SEO-sector ethischere, white-hat strategieën te omarmen met focus op het verdienen van links via hoogwaardige content en echte relaties. De Penguin-penalty werd een waarschuwing die bedrijven beïnvloedde in hun aanpak van linkbuilding, leidend tot meer investeringen in contentmarketing, public relations en merkopbouw als belangrijkste manieren om links te verkrijgen. Uit marktonderzoek blijkt dat het begrijpen en naleven van de Penguin-vereisten essentieel werd voor duurzaam SEO-succes, met veel organisaties die backlinkaudits en linkmonitoring als standaardpraktijk invoerden. Het algoritme vergrootte tevens het belang van domeinautoriteit, thematische relevantie en linkacquisitiesnelheid als kernwaarden die SEO-professionals monitoren bij het beoordelen van linkmogelijkheden. Meer dan 78% van de bedrijven gebruikt inmiddels een vorm van AI-gedreven contentmonitoring of linkanalysetools om backlinkprofielen te volgen en te zorgen voor naleving van Google’s kwaliteitsrichtlijnen—direct gevolg van de invloed van Penguin op de industriestandaarden.

Herstel van een Penguin-downgrade vereist een systematische aanpak met backlinkaudits, linkverwijdering en strategisch gebruik van Google’s disavow-tool. De eerste stap is een volledige audit van alle inkomende links via Google Search Console en externe tools zoals Ahrefs, SEMrush of Moz, waarmee gedetailleerde backlinkprofielen en kwaliteitsbeoordelingen worden verkregen. Webmasters moeten vervolgens elke verwijzende domein afzonderlijk beoordelen om te bepalen of de link van hoge kwaliteit en natuurlijk is, of juist duidt op manipulatie. Voor links die duidelijk spam of van lage kwaliteit zijn, is het aanbevolen om de beheerder van de verwijzende site te benaderen met een verzoek tot verwijdering. Google raadt expliciet af om te betalen voor linkverwijdering, omdat dit de linkhandel in stand houdt. Voor links die niet via outreach kunnen worden verwijderd, biedt de disavow-tool in Google Search Console de mogelijkheid om een bestand in te dienen waarmee Google wordt gevraagd bepaalde links bij de beoordeling te negeren. Houd er rekening mee dat een gedisavowde link ook alle positieve waarde verliest, dus de tool moet alleen worden gebruikt voor echt schadelijke links. Na het indienen van een disavow-bestand verwerkt Google deze direct, maar het daadwerkelijke effect op de rankings hangt af van het moment waarop Google de gedisavowde links opnieuw crawlt. Omdat Penguin 4.0 realtime draait, kan herstel relatief snel plaatsvinden—soms binnen dagen of weken—zodra voldoende corrigerende maatregelen zijn genomen. Webmasters moeten er echter niet op rekenen dat rankings terugkeren naar het niveau van voor de penalty, omdat sommige van die posities mogelijk kunstmatig waren opgeblazen door de verwijderde lage kwaliteit links.

Nu AI-zoekplatforms als ChatGPT, Perplexity, Google AI Overviews en Claude steeds belangrijker worden voor merkzichtbaarheid, is kennis van Penguin’s principes relevant buiten traditionele zoekresultaten. Deze AI-systemen citeren vaak gezaghebbende bronnen en kwalitatief hoogwaardige websites bij het genereren van antwoorden, en sites met sterke backlinkprofielen en schone linkgeschiedenis worden sneller als autoriteit erkend door AI-trainingdata en retrievalsystemen. Een website die door Penguin bestraft is voor linkspam, kan niet alleen dalen in Google’s organische zoekresultaten, maar ook minder snel worden vermeld door AI-systemen die broncredibiliteit beoordelen. Omgekeerd worden websites met een schoon, kwalitatief backlinkprofiel juist vaker als autoriteit geciteerd in AI-antwoorden. Dit creëert een extra motivatie voor Penguin-naleving buiten traditionele SEO-statistieken. AmICited en vergelijkbare AI-monitoringplatforms helpen organisaties bij het volgen van domeinvermeldingen in AI-antwoorden, zodat zichtbaar wordt of hun autoriteit wordt erkend op meerdere AI-zoeksystemen. De combinatie van Penguin-naleving en AI-citatietracking vormt een nieuwe dimensie in digitale marketing, waarbij linkkwaliteit zowel traditionele zoekzichtbaarheid als zichtbaarheid in opkomende AI-zoekoplossingen bepaalt.

De Penguin Update blijft zich ontwikkelen naarmate Google zijn begrip van linkkwaliteit en manipulatieve praktijken verfijnt. De overgang naar realtime verwerking in 2016 betekende een fundamentele verandering in de werking van het algoritme, maar Google blijft de detectiemogelijkheden doorontwikkelen via machine learning en kunstmatige intelligentie. Recente ontwikkelingen in Google’s SpamBrain-systeem, aangekondigd in 2022, vormen de volgende stap in spamdetectie door geavanceerde AI in te zetten voor de identificatie van zowel sites die links kopen als sites die links verspreiden. Dit suggereert dat toekomstige iteraties van linkspamdetectie nog geavanceerder zullen worden, waardoor manipulatieve praktijken moeilijker onder de radar kunnen blijven. De trend richting white-hat SEO en earned media zal waarschijnlijk versnellen nu Google’s algoritmes steeds beter natuurlijke links van kunstmatige kunnen onderscheiden. Daarnaast, naarmate AI-zoekplatforms aan belang winnen, reikt het belang van een schoon backlinkprofiel verder dan het Google-algoritme alleen en bepaalt het mede of je als autoriteit wordt erkend in meerdere AI-systemen. Organisaties die linkkwaliteit, merkautoriteit en contentexellentie centraal stellen, zijn het beste gepositioneerd voor succes in zowel traditionele zoekresultaten als opkomende AI-zoekomgevingen. De nalatenschap van de Penguin Update is niet slechts een specifiek algoritme, maar een fundamentele verschuiving in hoe zoekmachines en AI-systemen websiteautoriteit beoordelen, waarmee linkkwaliteit een permanent en steeds belangrijker onderdeel van digitale zichtbaarheid is geworden.

Een Penguin-downgrade is algoritmisch en gebeurt automatisch wanneer Google's Penguin-algoritme patronen van linkspam detecteert, zonder menselijke tussenkomst. Een Penguin-penalty (of handmatige actie) wordt opgelegd door Google's webspamteam na menselijke beoordeling en vereist een reconsideratieverzoek om opgeheven te worden. Sinds Penguin 4.0 realtime werd in 2016, kan van algoritmische downgrades vrijwel direct worden hersteld zodra corrigerende acties zijn ondernomen, terwijl handmatige penalties expliciete goedkeuring van Google vereisen.

De Penguin Update gebruikt machine learning-algoritmes om backlinkprofielen te analyseren en patronen van manipulatieve linkbuilding te identificeren, waaronder gekochte links, linkruil, private blognetwerken (PBN's) en onnatuurlijke ankertekstpatronen. Het algoritme beoordeelt de verhouding tussen hoogwaardige, natuurlijke links en lage kwaliteit spamlinks die naar een website wijzen. Ook wordt de relevantie en autoriteit van verwijzende domeinen onderzocht om te bepalen of links kunstmatig verkregen lijken in plaats van redactioneel verdiend.

Ja, herstel is mogelijk via een meerstappenproces bestaande uit backlinkaudits, het verwijderen van spamlinks en het gebruik van Google's disavow-tool voor links die je niet direct kunt verwijderen. Omdat Penguin 4.0 realtime draait, kan herstel relatief snel plaatsvinden zodra je je linkprofiel hebt opgeschoond en Google deze pagina's opnieuw crawlt. Herstel garandeert echter geen terugkeer naar eerdere rankings, omdat een deel daarvan mogelijk kunstmatig was opgeblazen door de lage kwaliteit links die je verwijdert.

Penguin bestraft links van linkfarms, betaalde linknetwerken, private blognetwerken (PBN's), wederzijdse linkruil en sites met onnatuurlijke ankertekstpatronen. Ook worden links van lage kwaliteit directories, commentaarspam, forumspam en links verkregen via manipulatieve praktijken aangepakt. Daarnaast markeert Penguin links van gezaghebbende sites die verkocht of geplaatst lijken als advertorials zonder de juiste nofollow-tags, omdat deze in strijd zijn met Google's richtlijnen voor linknetwerken.

Sinds Penguin 4.0 werd uitgebracht in september 2016 draait het algoritme continu in realtime als onderdeel van Google's kernalgoritme. Dit betekent dat Google backlinkprofielen constant evalueert en rankings aanpast op basis van linkkwaliteit, zonder te wachten op geplande updates. Eerder werkte Penguin op een batch-update schema met aankondigingen van Google, maar realtime verwerking maakte deze aankondigingen overbodig en zorgt voor sneller herstel zodra problemen zijn opgelost.

De disavow-tool is een functie in Google Search Console waarmee webmasters Google kunnen vertellen bepaalde backlinks te negeren bij de beoordeling van hun site. Het wordt als laatste redmiddel gebruikt wanneer je webmasters niet direct kunt benaderen om spamlinks te verwijderen. Door lage kwaliteit links te disavowen voorkom je dat ze je rankings negatief beïnvloeden onder het Penguin-algoritme. Disavowed links leveren echter ook geen positieve waarde meer, dus gebruik deze tool alleen voor echt schadelijke links.

De oorspronkelijke Penguin Update, gelanceerd in april 2012, trof volgens schattingen van Google meer dan 3% van alle zoekopdrachten. Latere updates hadden wisselende impact: Penguin 2.0 trof ongeveer 2,3% van de Engelstalige zoekopdrachten, Penguin 2.1 ongeveer 1% en Penguin 3.0 minder dan 1% van de Engelstalige zoekopdrachten. Deze percentages vertegenwoordigen wereldwijd miljoenen websites, waarmee Penguin een van de meest ingrijpende algoritme-updates in de zoekgeschiedenis is.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Lees meer over Google's Panda Update, de algoritmewijziging uit 2011 gericht op lage kwaliteitscontent. Begrijp hoe het werkt, de impact op SEO en herstelstrate...

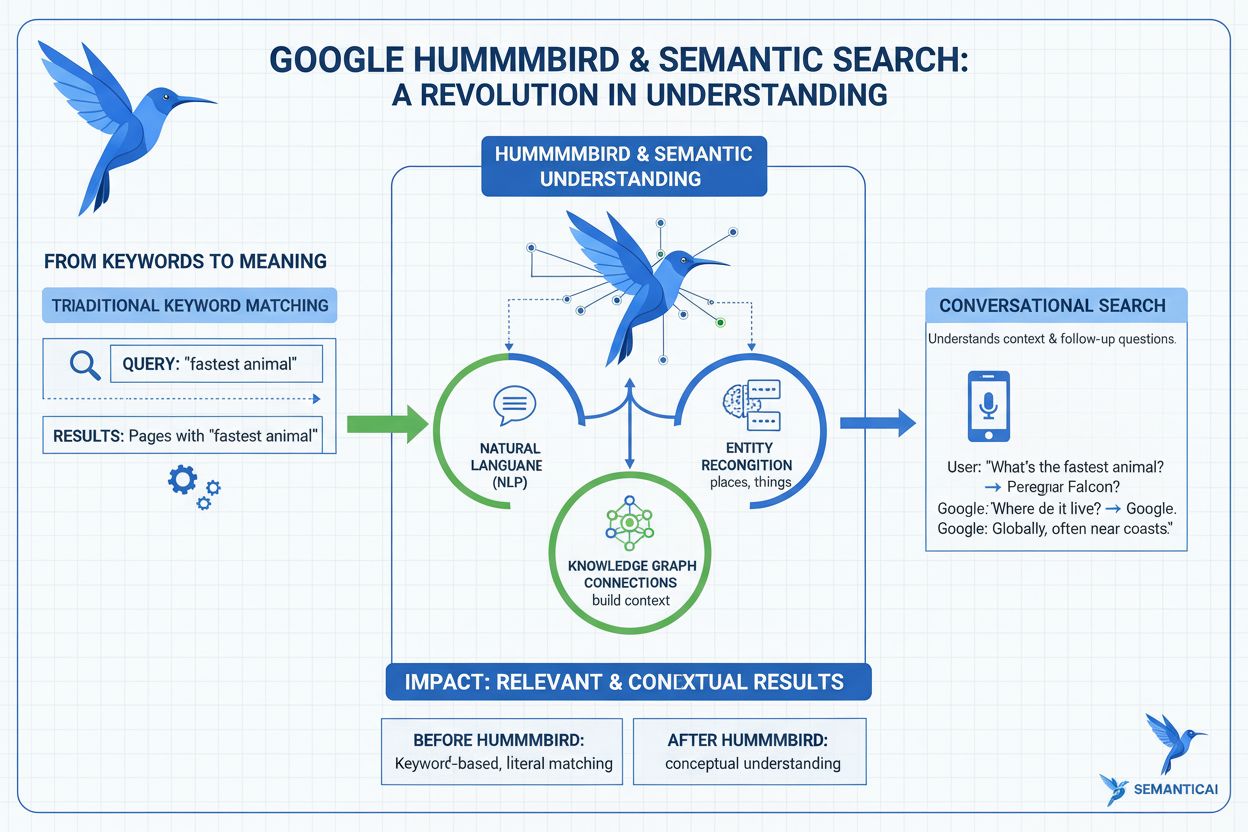

Ontdek wat de Hummingbird-update is, hoe deze de semantische zoekopdrachten in 2013 heeft gerevolutioneerd en waarom dit belangrijk is voor AI-monitoring en mer...

Lees meer over Google's Link Spam Update die manipulerende backlinks devalueert. Begrijp hoe SpamBrain linkspam detecteert, de impact op SEO en best practices v...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.