JavaScript SEO

JavaScript SEO optimaliseert JavaScript-gerenderde websites voor het crawlen en indexeren door zoekmachines. Leer best practices, render-methoden en strategieën...

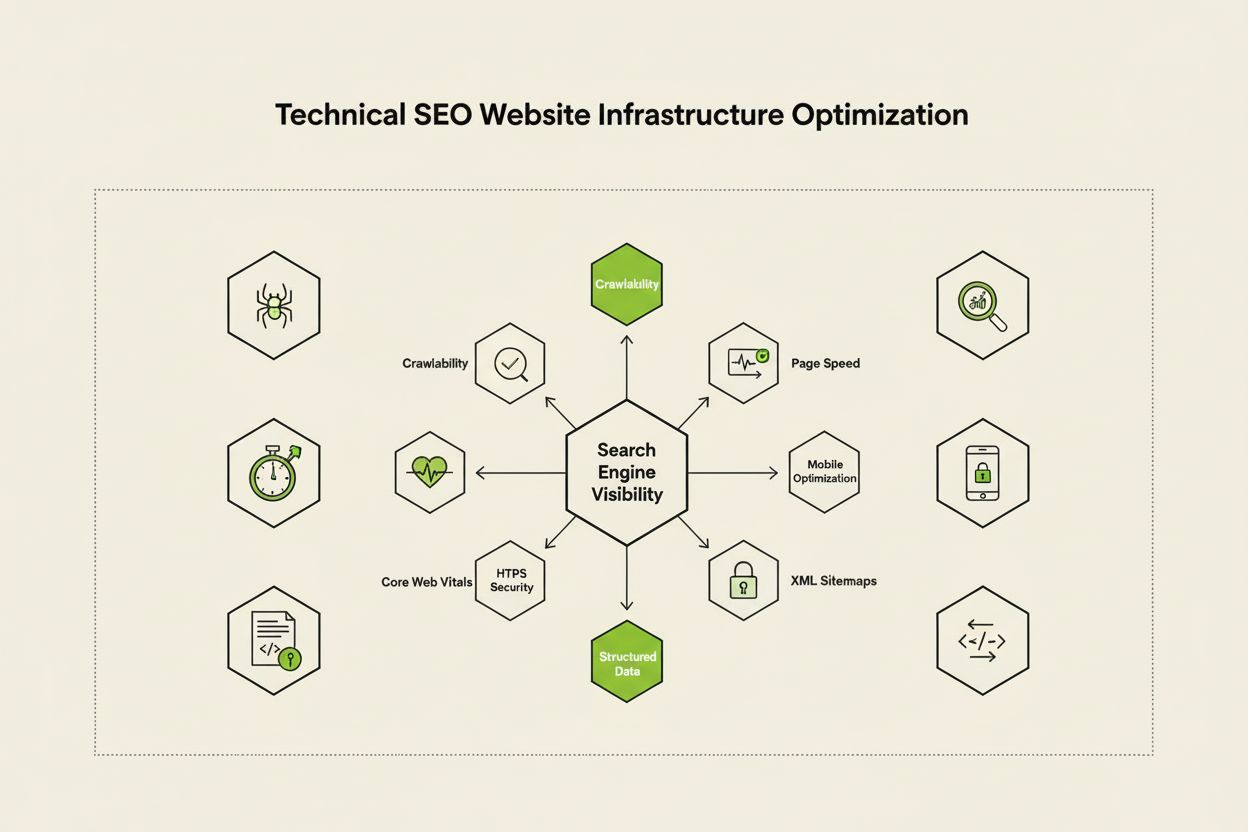

Technische SEO is het proces van het optimaliseren van de infrastructuur van een website, zodat zoekmachines de inhoud correct en efficiënt kunnen crawlen, renderen, indexeren en aanbieden. Het omvat sitesnelheid, mobielvriendelijkheid, site-architectuur, beveiliging en implementatie van gestructureerde data om ervoor te zorgen dat zoekmachines je pagina’s kunnen ontdekken en rangschikken.

Technische SEO is het proces van het optimaliseren van de infrastructuur van een website, zodat zoekmachines de inhoud correct en efficiënt kunnen crawlen, renderen, indexeren en aanbieden. Het omvat sitesnelheid, mobielvriendelijkheid, site-architectuur, beveiliging en implementatie van gestructureerde data om ervoor te zorgen dat zoekmachines je pagina's kunnen ontdekken en rangschikken.

Technische SEO is het proces waarbij de backend-infrastructuur van een website wordt geoptimaliseerd om ervoor te zorgen dat zoekmachines efficiënt content kunnen crawlen, renderen, indexeren en correct aanbieden. In tegenstelling tot on-page SEO, dat zich richt op contentkwaliteit en keywordoptimalisatie, pakt technische SEO de fundamentele elementen aan die bepalen of zoekmachines je website überhaupt kunnen bereiken en begrijpen. Dit omvat sitesnelheid, mobiele responsiviteit, site-architectuur, beveiligingsprotocollen, implementatie van gestructureerde data en crawlbaarheid. Technische SEO fungeert als het onzichtbare fundament waarop alle andere SEO-inspanningen steunen—zonder dit blijft zelfs de hoogste kwaliteit content onzichtbaar voor zoekmachines en gebruikers. Volgens brancheonderzoek gaf 91% van de marketeers aan dat SEO de websiteprestaties in 2024 heeft verbeterd, waarbij technische optimalisatie een cruciale rol speelde in het behalen van meetbare resultaten. Het belang van technische SEO is toegenomen naarmate zoekmachines geavanceerder worden en AI-gestuurde zoekplatformen opkomen, waardoor websites aan steeds strengere technische eisen moeten voldoen voor zichtbaarheid.

Technische SEO rust op vier onderling verbonden pijlers die samenwerken om de zichtbaarheid in zoekmachines te maximaliseren. Crawlbaarheid bepaalt of Googlebot en andere zoekmachinebots toegang hebben tot je websitepagina’s via links, sitemaps en interne navigatiestructuren. Indexeerbaarheid zorgt ervoor dat gecrawlde pagina’s daadwerkelijk in Google’s index worden opgeslagen en kunnen worden weergegeven in zoekresultaten. Prestaties en Core Web Vitals meten hoe snel pagina’s laden en hoe responsief ze zijn voor gebruikersinteracties—factoren die direct invloed hebben op rankings en gebruikerservaring. Mobiele optimalisatie zorgt ervoor dat je website perfect functioneert op smartphones en tablets, die nu goed zijn voor meer dan 60% van al het zoekverkeer volgens onderzoek van Sistrix. Deze vier pijlers zijn van elkaar afhankelijk; zwakte in één gebied kan de effectiviteit van de andere ondermijnen. Een snel ladende desktopsite die slecht presteert op mobiel zal bijvoorbeeld moeite hebben om te ranken in Google’s mobile-first index, ongeacht hoe goed de crawlbaarheid is geoptimaliseerd. Begrijpen hoe deze pijlers samenwerken is essentieel voor het ontwikkelen van een allesomvattende technische SEO-strategie die alle aspecten van zichtbaarheid in zoekmachines adresseert.

Hoewel vaak verward, vertegenwoordigen crawlbaarheid en indexeerbaarheid twee verschillende fasen in het zoekmachineproces. Crawlbaarheid verwijst naar het vermogen van een zoekmachine om de pagina’s van je website te ontdekken en te bereiken via interne links, externe backlinks en XML-sitemaps. Het beantwoordt de vraag: “Kan Googlebot deze pagina bereiken?” Als een pagina niet crawlbaar is—bijvoorbeeld omdat deze wordt geblokkeerd door robots.txt, verborgen is achter JavaScript of geen interne links heeft—kan deze niet worden geïndexeerd. Indexeerbaarheid bepaalt daarentegen of een gecrawlde pagina daadwerkelijk in Google’s index wordt opgeslagen en zichtbaar kan zijn in zoekresultaten. Een pagina kan perfect crawlbaar zijn, maar alsnog niet geïndexeerd worden als deze een noindex-meta tag bevat, dubbele content heeft of niet voldoet aan Google’s kwaliteitsdrempels. Volgens de uitgebreide technische SEO-gids van Search Engine Land is het begrijpen van dit onderscheid cruciaal, omdat het oplossen van crawlproblemen andere oplossingen vereist dan het oplossen van indexatieproblemen. Crawlproblemen betreffen meestal sitestructuur, robots.txt-configuratie en interne linking, terwijl indexatieproblemen vaak te maken hebben met metatags, canonical tags, contentkwaliteit en renderproblemen. Beide moeten worden aangepakt voor optimale zichtbaarheid in zoekmachines.

Core Web Vitals zijn drie specifieke metrics die Google gebruikt om de gebruikerservaring in de praktijk te meten en die direct invloed hebben op zoekresultaten. Largest Contentful Paint (LCP) meet hoe snel het grootste zichtbare element op een pagina laadt—Google adviseert een LCP van 2,5 seconden of minder. Interaction to Next Paint (INP), dat in 2024 First Input Delay verving, meet hoe responsief een pagina is op gebruikersinteracties zoals klikken en tikken—het streefdoel is onder de 200 milliseconden. Cumulative Layout Shift (CLS) meet visuele stabiliteit door onverwachte lay-outverschuivingen tijdens het laden te volgen—een score onder 0,1 wordt als goed beschouwd. Onderzoek van DebugBear wijst uit dat websites 75% van de gebruikers een “Goede” prestatie op alle drie de metrics moeten bieden om het maximale rankingvoordeel te behalen. De overgang naar INP als rankingfactor weerspiegelt Google’s inzet om de algehele paginaverantwoordelijkheid tijdens de gehele gebruikersinteractie te meten, niet alleen bij het eerste laden. Het optimaliseren van Core Web Vitals vereist een veelzijdige aanpak: LCP verbeteren door afbeeldingen te optimaliseren, CDNs te gebruiken en niet-kritische JavaScript uit te stellen; INP verbeteren door lange JavaScript-taken op te splitsen en event handlers te optimaliseren; en CLS verminderen door ruimte te reserveren voor dynamische content en lay-outverschuivende advertenties te vermijden. Deze metrics zijn onmisbaar geworden voor competitieve SEO, want pagina’s met slechte Core Web Vitals krijgen ranking-penalty’s en hogere bounce rates.

Site-architectuur verwijst naar hoe de pagina’s van je website zijn georganiseerd, gestructureerd en verbonden via interne links. Een goed ontworpen site-architectuur vervult meerdere kritieke functies: het helpt zoekmachines de hiërarchie van je content te begrijpen, verdeelt linkwaarde (rankingkracht) over je site, zorgt ervoor dat belangrijke pagina’s eenvoudig te vinden zijn en verbetert de gebruikersnavigatie. De ideale site-architectuur volgt een duidelijke hiërarchie met de homepage aan de top, categoriepagina’s op het tweede niveau en individuele contentpagina’s op diepere niveaus. Best practice schrijft voor dat alle belangrijke pagina’s binnen drie klikken vanaf de homepage bereikbaar moeten zijn, zodat Googlebot geen crawlbudget verspilt aan diep gelegen, geïsoleerde pagina’s. Interne linking fungeert als het bindweefsel van je site-architectuur en leidt zowel gebruikers als zoekmachines door je content. Strategische interne linking consolideert rankingsignalen op prioriteitspagina’s, legt thematische relaties tussen gerelateerde content en helpt zoekmachines te begrijpen welke pagina’s het belangrijkst zijn. Een hub-en-spoke-model—waarbij een uitgebreide pilaarpagina linkt naar meerdere gerelateerde subpagina’s, die op hun beurt teruglinken naar de pilaar—creëert bijvoorbeeld een krachtige structuur die thematische autoriteit aan zoekmachines signaleert. Slechte site-architectuur, gekenmerkt door verweesde pagina’s, inconsistente navigatie en diepe nesting, zorgt ervoor dat zoekmachines crawlbudget verspillen aan minder belangrijke content en maakt het moeilijk om thematische autoriteit op te bouwen. Bedrijven die hun site-architectuur herstructureren, zien vaak aanzienlijke verbeteringen in indexatiesnelheid en rankingprestaties.

Mobile-first indexing betekent dat Google primair de mobiele versie van je website gebruikt voor crawling, indexering en ranking—niet de desktopversie. Deze fundamentele verschuiving weerspiegelt het feit dat meer dan 60% van de zoekopdrachten nu afkomstig is van mobiele apparaten. Voor technische SEO betekent dit dat je mobiele ervaring vlekkeloos moet zijn: responsief design dat zich aanpast aan alle schermformaten, touchvriendelijke navigatie met voldoende ruimte tussen aanklikbare elementen, goed leesbare lettergroottes zonder te hoeven zoomen en snelle laadtijden die zijn geoptimaliseerd voor mobiele netwerken. Responsief design gebruikt flexibele layouts en afbeeldingen om zich automatisch aan te passen aan verschillende schermformaten en zo consistente functionaliteit te bieden op elk apparaat. Veelgemaakte fouten bij mobiele optimalisatie zijn onder andere opdringerige interstitials (pop-ups) die de hoofdinhoud blokkeren, tekst die te klein is om zonder zoomen te lezen, knoppen die te dicht bij elkaar staan om nauwkeurig te kunnen tikken en pagina’s die traag laden op mobiele netwerken. De Mobile-Friendly Test en Lighthouse-audits van Google kunnen deze problemen identificeren, maar testen op echte mobiele apparaten blijft essentieel. De relatie tussen mobiele optimalisatie en rankings is direct: pagina’s met een slechte mobiele ervaring worden afgestraft, terwijl mobiel geoptimaliseerde pagina’s betere zichtbaarheid krijgen. Voor e-commerce, SaaS-platforms en contentuitgevers is mobiele optimalisatie geen optie—het is essentieel voor concurrerende zoekzichtbaarheid.

XML-sitemaps dienen als routekaart voor zoekmachines, met een lijst van alle URL’s die je wilt laten indexeren, inclusief metadata zoals laatst gewijzigd-datum en prioriteit. Een goed onderhouden sitemap mag alleen canonieke, indexeerbare URL’s bevatten—geen redirects, 404-pagina’s of dubbele content. Robots.txt is een tekstbestand in de rootdirectory van je website dat crawlinstructies geeft aan zoekmachinebots, waarbij wordt aangegeven welke mappen en bestanden ze wel of niet mogen bezoeken. Robots.txt kan crawling blokkeren, maar voorkomt indexering niet als de pagina via andere wegen wordt gevonden; gebruik voor echte uitsluiting noindex-metatags. Crawlbudget verwijst naar het aantal pagina’s dat Googlebot binnen een bepaalde periode op je site zal crawlen—een beperkte resource die je strategisch moet beheren. Grote websites met miljoenen pagina’s moeten het crawlbudget optimaliseren door ervoor te zorgen dat Googlebot zich concentreert op waardevolle content in plaats van middelen te verspillen aan minder belangrijke pagina’s, duplicaten of variaties van gefacetteerde navigatie. Verspilling van crawlbudget komt vaak voor als zoekparameters eindeloze URL-variaties genereren, staging- of developmentomgevingen toegankelijk zijn voor crawlers, of dunne content te veel interne links krijgt. Volgens de officiële richtlijnen van Google is crawlbudgetbeheer vooral belangrijk voor grote sites, omdat inefficiënt crawlen de ontdekking en indexering van nieuwe of bijgewerkte content kan vertragen. Tools zoals de Crawl Stats-rapportage in Google Search Console en serverlog-analyse laten precies zien welke pagina’s Googlebot bezoekt en hoe vaak, waarmee je crawlbudget op data gebaseerde wijze kunt optimaliseren.

Gestructureerde data, geïmplementeerd via schema markup, helpt zoekmachines de betekenis en context van je content te begrijpen, verder dan alleen tekstuele analyse. Schema markup gebruikt een gestandaardiseerde woordenschat (van schema.org) om verschillende typen content te labelen—producten, artikelen, recepten, evenementen, lokale bedrijven, enzovoort. Bij correcte implementatie maakt schema markup rijke resultaten mogelijk in zoekopdrachten, waarbij Google verrijkte informatie zoals sterrenbeoordelingen, prijzen, kooktijden of evenementdata direct in de zoekresultaten toont. Deze verhoogde zichtbaarheid kan de doorklikpercentages en gebruikersbetrokkenheid aanzienlijk verbeteren. Verschillende contenttypes vereisen verschillende schema-implementaties: Artikel-schema voor blogposts en nieuws, Product-schema voor e-commercepagina’s, FAQ-schema voor veelgestelde vragen, Local Business-schema voor fysieke locaties en Event-schema voor aanstaande evenementen. Implementatie gebeurt meestal met het JSON-LD-formaat, de favoriete methode van Google. Schema markup moet echter de werkelijke inhoud van de pagina accuraat weerspiegelen—misleidende of verzonnen schema leidt tot handmatige penalty’s. Volgens onderzoek van Search Engine Land komen alleen pagina’s met geldige, relevante schema markup in aanmerking voor rijke resultaten, waardoor implementatienauwkeurigheid cruciaal is. Organisaties die uitgebreide schema markup implementeren op hun belangrijkste pagina’s zien vaak verbeterde zichtbaarheid in zowel traditionele zoekresultaten als AI-gestuurde zoekplatformen, omdat deze systemen afhankelijk zijn van gestructureerde data om content correct te begrijpen en te citeren.

HTTPS (Hypertext Transfer Protocol Secure) versleutelt gegevens die worden verzonden tussen de browser van gebruikers en je webserver, beschermt gevoelige informatie en geeft een signaal van betrouwbaarheid aan zowel gebruikers als zoekmachines. Google heeft bevestigd dat HTTPS een rankingfactor is, en sites zonder HTTPS krijgen zowel directe ranking-penalty’s als indirecte gevolgen zoals browserwaarschuwingen die gebruikers ontmoedigen. Het implementeren van HTTPS vereist het verkrijgen van een SSL/TLS-certificaat van een vertrouwde Certificate Authority en het configureren van je server om HTTPS op alle pagina’s te gebruiken. Naast basale HTTPS-implementatie bieden security headers zoals Content-Security-Policy, Strict-Transport-Security en X-Content-Type-Options extra bescherming tegen veelvoorkomende webkwetsbaarheden. Mixed content-fouten—waarbij HTTPS-pagina’s HTTP-resources laden—ondermijnen de beveiliging en kunnen waarschuwingen in de browser veroorzaken. De relatie tussen beveiliging en SEO gaat verder dan rankings: beveiligde sites bouwen gebruikersvertrouwen op, verlagen bounce rates en verhogen conversies. Voor e-commerce websites die betalingsinformatie verwerken, SaaS-platformen met gebruikersdata en elke site die persoonlijke informatie verzamelt, is beveiliging ononderhandelbaar. Regelmatige beveiligingsaudits met tools zoals het rapport Beveiligingsproblemen in Google Search Console en externe kwetsbaarheidsscanners helpen problemen te detecteren en op te lossen voordat ze rankings of gebruikersvertrouwen beïnvloeden.

| Aspect | Technische SEO | On-Page SEO | Off-Page SEO |

|---|---|---|---|

| Primaire Focus | Website-infrastructuur, snelheid, crawlbaarheid, indexeerbaarheid | Contentkwaliteit, keywords, metatags, headings | Backlinks, merkaanwezigheid, sociale signalen |

| Toegang Zoekmachine | Zorgt dat zoekmachines pagina’s kunnen crawlen en indexeren | Helpt zoekmachines de relevantie van pagina’s te begrijpen | Bouwt autoriteit en vertrouwenssignalen op |

| Belangrijke Elementen | Sitesnelheid, mobiele optimalisatie, Core Web Vitals, site-architectuur, HTTPS, gestructureerde data | Keywordplaatsing, contentdiepte, interne linking, metabeschrijvingen | Backlink-profiel, domeinautoriteit, merkaanwezigheid |

| Gebruikte Tools | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Invloed op Rankings | Fundamenteel—zonder dit kunnen pagina’s niet ranken | Direct—verbetert relevantie voor doelkeywords | Significant—bouwt autoriteit en vertrouwen op |

| Impact op Gebruikerservaring | Hoog—beïnvloedt paginasnelheid, mobiele bruikbaarheid, toegankelijkheid | Gemiddeld—beïnvloedt leesbaarheid en engagement | Laag—indirect via merkperceptie |

| Implementatietijdlijn | Doorlopend—vereist continue monitoring en optimalisatie | Doorlopend—vereist contentupdates en optimalisatie | Lange termijn—vereist voortdurende linkbuilding |

| ROI-meting | Crawlefficiëntie, indexatieratio, Core Web Vitals scores, rankings | Keywordrankings, organisch verkeer, doorklikpercentages | Backlinkgroei, domeinautoriteit, verwijzingsverkeer |

JavaScript SEO behandelt de unieke uitdagingen van JavaScript-intensieve websites, single-page applications (SPA’s) en dynamische contentrendering. Vroeger had Googlebot moeite met JavaScript omdat rendering—het uitvoeren van JavaScript-code om de uiteindelijke pagina te bouwen—complexiteit en vertraging toevoegde aan het crawlproces. Moderne Googlebot rendert nu de meeste pagina’s voordat ze worden geïndexeerd, maar dit brengt nieuwe technische SEO-overwegingen met zich mee. Server-side rendering (SSR) genereert complete HTML op de server voordat deze naar de browser wordt gestuurd, zodat zoekmachines alle content direct zien zonder op JavaScript-uitvoering te hoeven wachten. Static site generation (SSG) pre-rendert pagina’s tijdens de build, waardoor statische HTML-bestanden ontstaan die direct laden. Dynamische rendering levert voorgerenderde HTML aan zoekmachines terwijl gebruikers JavaScript ontvangen, hoewel Google heeft aangegeven dat dit een tijdelijke oplossing is. Het belangrijkste principe: alle essentiële content, metatags en gestructureerde data moeten zichtbaar zijn in de initiële HTML, en niet pas na het uitvoeren van JavaScript worden geladen. Pagina’s die cruciale content achter JavaScript verbergen, lopen risico op onvolledige of vertraagde indexatie. React-, Vue- en Angular-frameworks vereisen extra aandacht—veel organisaties die deze frameworks gebruiken, implementeren Next.js of Nuxt.js om server-side rendering en betere SEO-prestaties te waarborgen. Met Google Search Console’s URL-inspectietool en de rendering-weergave kun je testen of door JavaScript gegenereerde content correct wordt geïndexeerd.

Effectieve implementatie van technische SEO vereist een systematische aanpak die optimalisaties met hoge impact prioriteert. Begin met fundamentele elementen: zorg dat je site crawlbaar is door robots.txt en interne linking te controleren, controleer of belangrijke pagina’s indexeerbaar zijn door noindex-tags en canonical-issues te verifiëren, en stel een basislijn op voor de prestaties van Core Web Vitals. Pak daarna prestatie-optimalisatie aan: comprimeer en optimaliseer afbeeldingen, implementeer lazy loading voor content onder de vouw, stel niet-kritische JavaScript uit en gebruik Content Delivery Networks (CDN’s) voor snellere contentlevering. Optimaliseer vervolgens de sitestructuur: zorg dat belangrijke pagina’s binnen drie klikken van de homepage bereikbaar zijn, implementeer breadcrumbnavigatie met schema markup en creëer duidelijke interne linkingpatronen die gebruikers en zoekmachines leiden. Implementeer gestructureerde data voor je belangrijkste contenttypes—producten, artikelen, bedrijfsinformatie of evenementen—met JSON-LD en valideer deze met Google’s Rich Results Test. Monitor continu met Google Search Console voor indexatieproblemen, PageSpeed Insights voor Core Web Vitals en serverlogs voor crawlpatronen. Stel verantwoordelijkheid vast door belangrijke metrics te volgen zoals het aantal geïndexeerde pagina’s, Core Web Vitals scores en crawlefficiëntie in de tijd. Organisaties die technische SEO als een doorlopend proces behandelen in plaats van een eenmalige audit, presteren consequent beter dan concurrenten in zoekzichtbaarheid en gebruikerservaring.

Nu AI-zoekplatformen als Google AI Overviews, Perplexity, ChatGPT en Claude steeds prominenter worden, reikt het belang van technische SEO verder dan alleen traditionele Google-zoekopdrachten. Deze AI-systemen vertrouwen op correct geïndexeerde, goed gestructureerde content uit zoekmachine-indexen om antwoorden en citaties te genereren. Technische SEO zorgt dat je content vindbaar en correct geïnterpreteerd wordt door AI-systemen via verschillende mechanismen: correcte indexering maakt content beschikbaar voor AI-training en -opvraging, gestructureerde data helpt AI-systemen de context en betekenis van content te begrijpen en semantische rijkdom zorgt dat AI jouw content als gezaghebbend en relevant herkent. Volgens onderzoek van Conductor en Botify komen pagina’s die in AI Overviews verschijnen doorgaans van technisch gezonde, goed geïndexeerde websites met sterke semantische signalen. De relatie is tweerichtingsverkeer: waar traditionele SEO zich richt op ranking voor specifieke keywords, focust AI-zoek op het geven van volledige antwoorden die meerdere bronnen kunnen citeren. Deze verschuiving betekent dat technische SEO beide paradigma’s moet ondersteunen—pagina’s indexeren voor traditionele zoekopdrachten én ze semantisch rijk maken voor AI-systemen. Organisaties die hun zichtbaarheid op meerdere AI-platforms monitoren met tools als AmICited, kunnen vaststellen welke technische optimalisaties het beste werken voor meer citaties en zichtbaarheid in generatieve zoekresultaten.

Effectieve technische SEO vereist het volgen van specifieke metrics die de gezondheid van de website en de toegankelijkheid voor zoekmachines aangeven. Aantal geïndexeerde pagina’s toont hoeveel van je bedoelde pagina’s daadwerkelijk in Google’s index staan—deze vergelijken met het totale aantal indexeerbare pagina’s geeft je indexatie-efficiëntie. Crawlefficiëntie meet hoe effectief Googlebot zijn crawlbudget gebruikt, berekend door het aantal gecrawlde pagina’s te delen door het totale aantal pagina’s op je site. Core Web Vitals scores geven de kwaliteit van de gebruikerservaring aan op het gebied van laadsnelheid (LCP), interactiviteit (INP) en visuele stabiliteit (CLS). Mobiele bruikbaarheidsproblemen in Google Search Console tonen fouten als te kleine tikdoelen, viewportconfiguratiefouten of opdringerige interstitials. Redirect chain lengte moet minimaal zijn om linkwaarde te behouden en crawlvertraging te voorkomen. Dekening gestructureerde data toont welk percentage van je pagina’s geldige schema markup heeft. Paginasnelheidsmetrics zoals First Contentful Paint (FCP), Time to Interactive (TTI) en Total Blocking Time (TBT) bieden gedetailleerde prestatie-inzichten. Organisaties moeten basismetingen voor deze metrics vaststellen, verbeterdoelen bepalen en de voortgang maandelijks of per kwartaal volgen. Plotselinge veranderingen in deze metrics wijzen vaak op technische problemen nog vóór ze rankings beïnvloeden, waardoor tijdige correctie mogelijk is. Tools als Google Search Console, PageSpeed Insights, Lighthouse en enterpriseplatforms als Semrush bieden uitgebreide dashboards om deze metrics voor je hele website te monitoren.

Het landschap van technische SEO blijft evolueren door algoritmeveranderingen bij zoekmachines, nieuwe technologieën en veranderend gebruikersgedrag. AI-gedreven indexering en ranking zullen steeds meer bepalen welke pagina’s worden geïndexeerd en hoe ze gerangschikt worden, waardoor technische SEO moet inspelen op semantisch begrip en entiteitherkenning. Edge computing en serverless architecturen maken snellere contentlevering en real-time optimalisatie aan de netwerkedge mogelijk, wat latency vermindert en Core Web Vitals verbetert. Meer focus op E-E-A-T-signalen (Experience, Expertise, Authoritativeness, Trustworthiness) betekent dat technische SEO content-credibiliteit moet ondersteunen met juiste auteurmarkup, publicatiedata en vertrouwenssignalen. Multi-surface optimalisatie wordt standaard nu AI-zoekplatforms zich uitbreiden, waardoor websites voor zichtbaarheid moeten optimaliseren in Google, Perplexity, ChatGPT, Claude en andere opkomende platforms. Privacy-first analytics en first-party dataverzameling zullen de manier veranderen waarop organisaties technische SEO-impact meten, met een verschuiving van third-party cookies naar server-side tracking en toestemming-gebaseerde meting. Volwassenwording van JavaScript-frameworks zal SEO-mogelijkheden verder verbeteren, met frameworks als Next.js, Nuxt.js en Remix als standaard voor SEO-vriendelijke applicaties. Geautomatiseerde technische SEO op basis van AI maakt snellere detectie en oplossing van problemen mogelijk, waarbij platforms automatisch fixes voorstellen voor crawlbaarheid, indexeerbaarheid en prestatie-issues. Organisaties die deze trends voorblijven door hun technische infrastructuur voortdurend bij te werken en best practices te volgen, behouden een concurrentievoordeel in organische zoekzichtbaarheid.

Technische SEO richt zich op het optimaliseren van de backend-infrastructuur van een website—zoals sitesnelheid, crawlbaarheid, indexeerbaarheid en serverconfiguratie—om zoekmachines te helpen inhoud te ontdekken en te verwerken. On-page SEO daarentegen concentreert zich op het optimaliseren van individuele paginakenmerken zoals keywordplaatsing, metabeschrijvingen, headings en contentkwaliteit om de relevantie voor specifieke zoekopdrachten te verbeteren. Waar technische SEO zorgt dat zoekmachines je site kunnen bereiken, zorgt on-page SEO ervoor dat ze begrijpen waar je inhoud over gaat en waarom dit belangrijk is voor gebruikers.

Core Web Vitals—Largest Contentful Paint (LCP), Interaction to Next Paint (INP) en Cumulative Layout Shift (CLS)—zijn bevestigde rankingfactoren die de gebruikerservaring in de praktijk meten. Volgens onderzoek van DebugBear is het nodig dat 75% van de gebruikers op alle drie de metrics een 'Goede' ervaring heeft om het maximale rankingvoordeel te behalen. Slechte Core Web Vitals kunnen leiden tot ranking-penalty's, lagere doorklikpercentages en hogere bounce rates, wat direct invloed heeft op organische zichtbaarheid en gebruikersbetrokkenheid.

Crawlbaarheid bepaalt of zoekmachinebots toegang hebben tot en links kunnen volgen op je website. Als Googlebot je pagina's niet kan crawlen door geblokkeerde bronnen, een slechte sitestructuur of robots.txt-beperkingen, kunnen die pagina's niet worden geïndexeerd of gerangschikt. Zonder goede crawlbaarheid blijft zelfs hoogwaardige content onzichtbaar voor zoekmachines, waardoor organische zichtbaarheid onmogelijk is, ongeacht de contentkwaliteit of het backlinkprofiel.

Nu AI-gestuurde zoekplatforms zoals Google AI Overviews en Perplexity steeds belangrijker worden, blijft technische SEO fundamenteel. Deze AI-systemen vertrouwen op correct geïndexeerde, goed gestructureerde inhoud uit Google's index om antwoorden te genereren. Technische SEO zorgt ervoor dat je content vindbaar, correct gerenderd en semantisch rijk genoeg is voor AI-systemen om te citeren en te refereren. Zonder solide technische basis verschijnt je content niet in AI Overviews of andere generatieve zoekresultaten.

Voor de meeste websites wordt aanbevolen om elk kwartaal een uitgebreide technische SEO-audit te doen, met maandelijkse monitoring van kritieke issues. Grotere enterprise-sites met frequente updates zouden maandelijks moeten auditen of continue monitoring implementeren. Na grote sitewijzigingen, migraties of redesigns zijn directe audits essentieel. Regelmatige audits helpen problemen vroegtijdig te signaleren voordat ze rankings beïnvloeden en zorgen dat je site optimale crawlbaarheid, indexeerbaarheid en prestaties behoudt.

Site-architectuur bepaalt hoe zoekmachines door de hiërarchie van je website-inhoud navigeren en deze begrijpen. Een goed geoptimaliseerde architectuur zorgt ervoor dat belangrijke pagina's binnen drie klikken vanaf de homepage bereikbaar zijn, verdeelt linkwaarde effectief en helpt zoekmachines prioriteit te geven aan het crawlen van waardevolle inhoud. Slechte site-architectuur kan leiden tot verweesde pagina's, verspilling van crawlbudget en moeite met het opbouwen van thematische autoriteit, wat rankings en zichtbaarheid negatief beïnvloedt.

Paginasnelheid heeft directe invloed op zowel zoekresultaten als gebruikersgedrag. Google heeft bevestigd dat Core Web Vitals—die laadsnelheid, interactiviteit en visuele stabiliteit meten—rankingfactoren zijn. Langzaam ladende pagina's hebben hogere bounce rates, lagere betrokkenheid en minder conversies. Studies tonen aan dat pagina's die in minder dan 2,5 seconden laden aanzienlijk betere gebruikersretentie en rankingprestaties hebben dan tragere pagina's, waardoor snelheidsoptimalisatie essentieel is voor SEO-succes.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

JavaScript SEO optimaliseert JavaScript-gerenderde websites voor het crawlen en indexeren door zoekmachines. Leer best practices, render-methoden en strategieën...

Content SEO is het strategisch creëren en optimaliseren van hoogwaardige content om zoekmachineresultaten en organische zichtbaarheid te verbeteren. Leer hoe je...

YouTube SEO is het proces van het optimaliseren van video's en kanalen om hoger te scoren in de zoekresultaten van YouTube. Leer rankingfactoren, optimalisaties...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.