AI-inhoudslicentie

Ontdek alles over AI-inhoudslicentieovereenkomsten die bepalen hoe kunstmatige intelligentiesystemen auteursrechtelijk beschermde inhoud gebruiken. Verken licen...

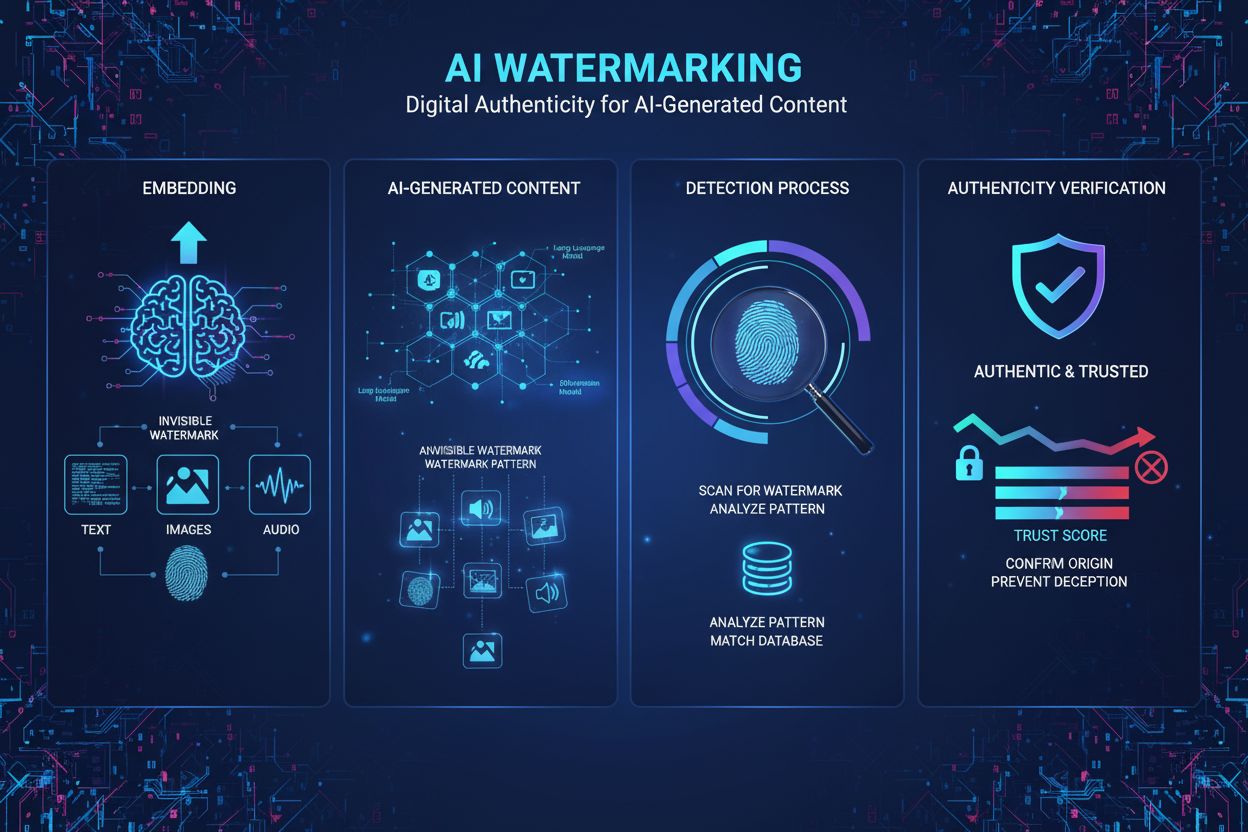

Watermarking van AI-inhoud is het proces waarbij onzichtbare of zichtbare digitale markeringen worden ingebed in door AI gegenereerde tekst, afbeeldingen, audio of video om die inhoud te identificeren en te authenticeren als machine-gegenereerd. Deze watermerken fungeren als digitale vingerafdrukken waarmee AI-materiaal kan worden opgespoord, geverifieerd en gevolgd over verschillende platforms en toepassingen.

Watermarking van AI-inhoud is het proces waarbij onzichtbare of zichtbare digitale markeringen worden ingebed in door AI gegenereerde tekst, afbeeldingen, audio of video om die inhoud te identificeren en te authenticeren als machine-gegenereerd. Deze watermerken fungeren als digitale vingerafdrukken waarmee AI-materiaal kan worden opgespoord, geverifieerd en gevolgd over verschillende platforms en toepassingen.

Watermarking van AI-inhoud verwijst naar het proces van het inbedden van digitale markeringen, patronen of handtekeningen in door AI gegenereerd materiaal om de oorsprong ervan te identificeren, authenticeren en volgen. Deze watermerken functioneren als digitale vingerafdrukken die machinegegenereerde inhoud onderscheiden van door mensen geschreven werk in tekst-, beeld-, audio- en videoformaten. Het primaire doel van watermarking van AI-inhoud is transparantie te bieden over de herkomst van inhoud, terwijl desinformatie wordt bestreden, intellectueel eigendom wordt beschermd en verantwoording wordt gegarandeerd in het snelgroeiende landschap van generatieve kunstmatige intelligentie. In tegenstelling tot traditionele watermerken die zichtbaar zijn op fysieke documenten of afbeeldingen, maken moderne AI-watermarking-technieken vaak gebruik van onzichtbare patronen die alleen door gespecialiseerde algoritmen kunnen worden gedetecteerd, waardoor de inhoudskwaliteit behouden blijft en toch robuuste authenticatie mogelijk is.

Het concept van watermarking is ontstaan in de fysieke wereld, waar onzichtbare markeringen op bankbiljetten en documenten als anti-vervalsingsmaatregel dienden. Naarmate digitale media zich verspreidden, pasten onderzoekers watermarking-technieken toe op afbeeldingen, audio en video gedurende de jaren negentig en 2000. De opkomst van geavanceerde generatieve AI-modellen zoals ChatGPT, DALL-E en Midjourney in 2022-2023 creëerde echter een dringende behoefte aan gestandaardiseerde AI-inhouds-authenticatiemethoden. De snelle vooruitgang van AI-mogelijkheden die steeds realistischere synthetische inhoud produceren, heeft overheden, technologiebedrijven en maatschappelijke organisaties ertoe aangezet watermarking als een cruciale waarborg te prioriteren. Volgens onderzoek van de Brookings Institution erkent meer dan 78% van de bedrijven het belang van AI-gebaseerde monitoringtools voor het beheren van risico’s van synthetische media. De EU AI Act, formeel aangenomen in maart 2024, werd het eerste grote regelgevingskader dat watermarking van AI-inhoud verplicht stelde en aanbieders van AI-systemen verplichtte hun output te markeren als door AI gegenereerd. Deze regelgevende impuls heeft onderzoek en ontwikkeling in watermarking-technologieën versneld, waarbij bedrijven als Google DeepMind, OpenAI en Meta aanzienlijk investeren in robuuste watermarking-oplossingen.

AI-watermarking werkt via twee primaire technische benaderingen: zichtbare watermarking en onzichtbare watermarking. Zichtbare watermerken omvatten duidelijke labels, logo’s of tekstindicatoren die aan inhoud worden toegevoegd—zoals de vijf gekleurde vierkantjes die DALL-E op gegenereerde afbeeldingen plaatst of de ChatGPT-preambule “as a language model trained by OpenAI”. Hoewel eenvoudig te implementeren, zijn zichtbare watermerken triviaal te verwijderen via eenvoudige bewerkingen. Onzichtbare watermarking daarentegen embed subtiele patronen die niet waarneembaar zijn voor mensen, maar detecteerbaar zijn door gespecialiseerde algoritmen. Voor door AI gegenereerde afbeeldingen embedden technieken zoals tree-ring watermerken ontwikkeld aan de Universiteit van Maryland patronen in het initiële willekeurige ruisbeeld vóór het diffusieproces, waardoor ze bestand zijn tegen bijsnijden, draaien en filteren. Voor door AI gegenereerde tekst vertegenwoordigt statistische watermarking de meest veelbelovende benadering, waarbij het taalmodel subtiel bepaalde tokens (“groene tokens”) verkiest en andere (“rode tokens”) vermijdt op basis van de voorgaande context. Dit creëert een statistisch ongebruikelijke ordening van woorden die detectie-algoritmen met hoge zekerheid kunnen identificeren. Audio-watermarking embedt onwaarneembare patronen in frequentiebereiken buiten het menselijk gehoor (onder 20 Hz of boven 20.000 Hz), vergelijkbaar met beeldwatermarking maar aangepast aan akoestische eigenschappen. De SynthID-technologie van Google DeepMind is een voorbeeld van moderne watermarking waarbij generatie- en detectiemodellen gezamenlijk worden getraind, zodat robuustheid tegen transformaties wordt gegarandeerd en de inhoudskwaliteit behouden blijft.

| Watermarking-methode | Inhoudstype | Robuustheid | Kwaliteitsimpact | Toegang tot model vereist | Detecteerbaarheid |

|---|---|---|---|---|---|

| Zichtbare watermarking | Afbeeldingen, Video | Zeer laag | Geen | Nee | Hoog (Menselijk) |

| Statistische watermarking | Tekst, Afbeeldingen | Hoog | Minimaal | Ja | Hoog (Algoritmisch) |

| Machine learning-gebaseerd | Afbeeldingen, Audio | Hoog | Minimaal | Ja | Hoog (Algoritmisch) |

| Tree-ring watermarking | Afbeeldingen | Zeer hoog | Geen | Ja | Hoog (Algoritmisch) |

| Content provenance (C2PA) | Alle media | Gemiddeld | Geen | Nee | Gemiddeld (Metadata) |

| Post-hoc detectie | Alle media | Laag | N.v.t. | Nee | Laag (Onbetrouwbaar) |

Statistische watermarking is de meest haalbare techniek voor het authenticeren van door AI gegenereerde tekst, omdat tekst niet de dimensionale ruimte biedt die afbeeldingen of audio hebben voor het inbedden van patronen. Tijdens het generatieproces krijgt een taalmodel instructies om bepaalde tokens te prefereren op basis van een cryptografische sleutel die alleen bekend is bij de modelontwikkelaar. De willekeur van het model wordt volgens dit schema “geladen”, waardoor het specifieke woorden of zinnen verkiest en andere vermijdt. Detectieprotocollen analyseren de gegenereerde tekst om de kans te berekenen dat de waargenomen tokenpatronen puur toevallig voorkomen; statistisch onwaarschijnlijke patronen wijzen op de aanwezigheid van een watermerk. Onderzoek van de Universiteit van Maryland en OpenAI heeft aangetoond dat deze aanpak een hoge detectienauwkeurigheid kan bereiken terwijl de tekstkwaliteit behouden blijft. Echter, statistische watermarking voor tekst kent inherente beperkingen: feitelijke antwoorden met beperkte generatie-flexibiliteit (zoals wiskundige oplossingen of historische feiten) zijn moeilijker effectief te watermerken, en grondige herschrijving of vertaling naar andere talen kan de detectiebetrouwbaarheid aanzienlijk verminderen. De SynthID Text-implementatie, nu beschikbaar in Hugging Face Transformers v4.46.0+, biedt productieklare watermarking met configureerbare parameters zoals cryptografische sleutels en n-gramlengte om robuustheid en detecteerbaarheid in balans te brengen.

Door AI gegenereerde afbeeldingen profiteren van meer geavanceerde watermarking-benaderingen dankzij de hoge dimensionale ruimte voor het inbedden van patronen. Tree-ring watermarking embedt verborgen patronen in het initiële willekeurige beeld vóór het diffusieproces, waardoor watermerken die bewerkingen zoals bijsnijden, vervagen en draaien overleven zonder afbreuk te doen aan de beeldkwaliteit. Machine learning-gebaseerde watermarking van Meta en Google gebruikt neurale netwerken om onwaarneembare watermerken te embedden en te detecteren, met meer dan 96% nauwkeurigheid op onbewerkte afbeeldingen en weerstand tegen pixel-niveau-aanvallen. Audio-watermarking past vergelijkbare principes toe en embedt onwaarneembare patronen in frequentiebereiken buiten het menselijk gehoor. AudioSeal, ontwikkeld door Meta, traint generator- en detectormodellen gezamenlijk om watermerken te creëren die robuust zijn tegen natuurlijke audiotransformaties en tegelijkertijd ononderscheidbare audiokwaliteit behouden. De technologie gebruikt perceptueel verlies om te garanderen dat watergemarkeerde audio identiek klinkt aan het origineel en maakt gebruik van localisatieloss om watermerken te detecteren, ongeacht verstoringen. Deze benaderingen laten zien dat onzichtbare watermarking zowel robuustheid als kwaliteitsbehoud kan bereiken mits goed geïmplementeerd, hoewel toegang tot het onderliggende AI-model vereist is voor het embedden van het watermerk.

De regelgevende omgeving voor watermarking van AI-inhoud is snel geëvolueerd, waarbij verschillende rechtsgebieden verplichte watermarking-eisen hebben ingevoerd of voorgesteld. De EU AI Act, formeel aangenomen in maart 2024, is het meest uitgebreide regelgevingskader en verplicht aanbieders van AI-systemen hun output te markeren als door AI gegenereerde inhoud. Deze regelgeving is van toepassing op alle generatieve AI-systemen die binnen de Europese Unie worden ingezet en legt een wettelijke verplichting op voor watermarking-compliance. De Californische AI Transparency Act (SB 942), van kracht op 1 januari 2026, verplicht gedekte AI-aanbieders om gratis, publiek toegankelijke detectietools voor AI-inhoud beschikbaar te stellen, wat in feite watermarking of vergelijkbare authenticatiemechanismen vereist. De U.S. National Defense Authorization Act (NDAA) voor het fiscale jaar 2024 bevat bepalingen voor een prijswedstrijd om watermarking-technologie te evalueren en geeft het Department of Defense de opdracht de implementatie van “open technische industriestandaarden” voor het inbedden van content provenance-informatie in metadata te bestuderen en te testen. Het Executive Order on AI van het Witte Huis geeft het Department of Commerce de opdracht standaarden te identificeren en te ontwikkelen voor het labelen van door AI gegenereerde inhoud. Deze regelgevende initiatieven weerspiegelen een groeiende consensus dat AI-watermarking essentieel is voor transparantie, verantwoording en consumentenbescherming. Uitdagingen bij de implementatie blijven echter aanzienlijk, vooral met betrekking tot open-source modellen, internationale coördinatie en de technische haalbaarheid van universele watermarking-standaarden.

Ondanks aanzienlijke technische vooruitgang kent AI-watermarking belangrijke beperkingen die de praktische effectiviteit inperken. Verwijdering van watermerken blijft mogelijk via verschillende ontwijkingstechnieken: parafraseren van tekst, bijsnijden of filteren van afbeeldingen, vertalen van inhoud naar andere talen of het toepassen van adversariële verstoringen. Onderzoek van Duke University liet proof-of-concept aanvallen zien tegen machine learning-gebaseerde watermarkdetectoren, wat aangeeft dat zelfs geavanceerde benaderingen kwetsbaar zijn voor vastberaden tegenstanders. Het niet-universaliteitsprobleem is een andere kritieke beperking—watermarkdetectoren zijn modelspecifiek, wat betekent dat gebruikers de detectieservice van elk AI-bedrijf afzonderlijk moeten raadplegen om de herkomst van inhoud te verifiëren. Zonder een gecentraliseerd register en gestandaardiseerde detectieprotocollen wordt het controleren of inhoud door AI is gegenereerd een inefficiënt, ad hoc proces. Vals-positieve percentages bij watermarkdetectie, vooral voor tekst, blijven problematisch; detectie-algoritmen kunnen door mensen geschreven inhoud ten onrechte als AI-gegenereerd markeren of watergemarkeerde inhoud niet detecteren na kleine aanpassingen. Compatibiliteit met open-source modellen levert governance-uitdagingen op, omdat watermerken kunnen worden uitgeschakeld door code uit gedownloade modellen te verwijderen. Kwaliteitsvermindering doet zich voor wanneer watermarking-algoritmen modeluitvoer kunstmatig beperken om detecteerbare patronen in te bouwen, waardoor de inhoudskwaliteit afneemt of de generatie-flexibiliteit beperkt wordt bij feitelijke of beperkte taken. De privacy-implicaties van watermarking—vooral als watermerken gebruikersidentificatie bevatten—vereisen zorgvuldig beleid. Daarnaast neemt de detectiebetrouwbaarheid aanzienlijk af bij korte inhoud; kortere teksten en sterk bewerkte inhoud leveren lagere detectiebetrouwbaarheid op, wat de bruikbaarheid van watermarking in sommige toepassingen beperkt.

De toekomst van AI-watermarking hangt af van voortdurende technische innovatie, regelgevende harmonisatie en het opzetten van vertrouwde infrastructuur voor watermarkdetectie en verificatie. Onderzoekers verkennen openbaar detecteerbare watermerken die robuust blijven ondanks openbaarmaking van detectiemethoden, wat decentrale verificatie mogelijk maakt zonder vertrouwen in derden. Standaardisatie-inspanningen via organisaties als ICANN of brancheconsortia kunnen universele watermarking-protocollen vastleggen, waardoor fragmentatie wordt verminderd en efficiënte cross-platform detectie mogelijk wordt. Integratie met content provenance-standaarden zoals C2PA kan gelaagde authenticatiebenaderingen creëren door watermerken te combineren met op metadata gebaseerde provenance-tracking. De ontwikkeling van watermerken die robuust zijn tegen vertaling en parafraseren blijft een actief onderzoeksgebied, met potentiële toepassingen in meertalige inhouds-authenticatie. Blockchain-gebaseerde verificatiesystemen kunnen onwijzigbare bewijzen van watermarkdetectie en content provenance bieden, waardoor het vertrouwen in authenticatieresultaten toeneemt. Naarmate generatieve AI-mogelijkheden zich ontwikkelen, moeten watermarking-technieken evolueren om effectief te blijven tegen steeds geavanceerdere ontwijkingspogingen. De regelgevende impuls van de EU AI Act en de Californische wetgeving zal waarschijnlijk wereldwijde adoptie van watermarking-standaarden stimuleren, wat marktprikkels creëert voor robuuste technische oplossingen. Realistische verwachtingen erkennen echter dat watermarking vooral zal worden toegepast op door populaire commerciële modellen gegenereerde inhoud en beperkt blijft in scenario’s met hoge urgentie die onmiddellijke detectie vereisen. De integratie van AI-inhoudsmonitoringsplatforms zoals AmICited met watermarking-infrastructuur stelt organisaties in staat hun merkattributie over AI-systemen te volgen, zodat hun domeinen correct worden herkend in AI-gegenereerde antwoorden. Toekomstige ontwikkelingen zullen waarschijnlijk de nadruk leggen op mens-AI-samenwerking bij inhouds-authenticatie, waarbij geautomatiseerde watermarkdetectie wordt gecombineerd met menselijke verificatie voor kritische toepassingen in de journalistiek, juridische processen en academische integriteit.

Zichtbare watermerken zijn eenvoudig waarneembaar voor mensen, zoals logo's of tekstlabels toegevoegd aan afbeeldingen of audioclips, maar ze zijn eenvoudig te verwijderen of te vervalsen. Onzichtbare watermerken embedden subtiele patronen die niet waarneembaar zijn voor het menselijk oog, maar wel detecteerbaar zijn door gespecialiseerde algoritmen, waardoor ze veel robuuster zijn tegen manipulatie en verwijderingspogingen. Onzichtbare watermerken worden over het algemeen geprefereerd voor AI-authenticatie omdat ze de kwaliteit behouden en sterkere beveiliging tegen ontwijking bieden.

Statistische watermarking voor tekst werkt door subtiel de tokenkeuze van het taalmodel tijdens generatie te beïnvloeden. De ontwikkelaar van het model 'laadt de dobbelstenen' met een cryptografisch schema, waardoor het model bepaalde 'groene tokens' verkiest en 'rode tokens' vermijdt op basis van de voorafgaande context. Detectie-algoritmen analyseren vervolgens de tekst om te bepalen of voorkeurs-tokens met statistisch ongebruikelijke frequentie voorkomen, wat duidt op de aanwezigheid van een watermerk. Deze aanpak behoudt tekstkwaliteit terwijl een detecteerbare vingerafdruk wordt ingebed.

Belangrijke uitdagingen zijn onder meer de eenvoudige verwijdering van watermerken via kleine bewerkingen of transformaties, het ontbreken van universele detectie over verschillende AI-modellen, en de moeilijkheid van watermarking van tekst in vergelijking met afbeeldingen of audio. Daarnaast vereist watermarking medewerking van modelontwikkelaars, is het niet compatibel met open-source releases en kan het de inhoudskwaliteit verminderen als het niet zorgvuldig wordt geïmplementeerd. Valse positieven en valse negatieven in detectie blijven ook belangrijke technische obstakels.

De EU AI Act, formeel aangenomen in maart 2024, vereist dat aanbieders van AI-systemen hun output markeren als door AI gegenereerde inhoud. De California AI Transparency Act (SB 942), van kracht op 1 januari 2026, verplicht gedekte AI-aanbieders om gratis, publiek toegankelijke detectietools voor inhoud beschikbaar te stellen. De U.S. National Defense Authorization Act (NDAA) voor het fiscale jaar 2024 bevat bepalingen voor de evaluatie van watermarking-technologie en de ontwikkeling van industriestandaarden voor content-provenance.

Watermarking embedt identificerende patronen direct in door AI gegenereerde inhoud zelf, waardoor een permanente digitale vingerafdruk ontstaat die blijft bestaan, zelfs als de inhoud wordt gekopieerd of aangepast. Content provenance, zoals de C2PA-standaard, slaat metadata over de oorsprong en wijzigingsgeschiedenis van de inhoud apart op in bestandsmetadata. Watermarking is robuuster tegen ontwijking maar vereist medewerking van de modelontwikkelaar, terwijl provenance eenvoudiger te implementeren is maar kan worden verwijderd door inhoud te kopiëren zonder metadata.

SynthID is een technologie van Google DeepMind die AI-inhoud markeert en identificeert door digitale watermerken direct in afbeeldingen, audio, tekst en video te embedden. Voor tekst gebruikt SynthID een logits-processor die de generatiepijplijn van het model aanpast om watermarking-informatie te coderen zonder de kwaliteit aanzienlijk te beïnvloeden. De technologie maakt gebruik van machine learning-modellen om zowel watermerken te embedden als te detecteren, waardoor deze bestand is tegen veelvoorkomende aanvallen terwijl de inhoudsgetrouwheid behouden blijft.

Ja, gemotiveerde actoren kunnen watermerken verwijderen of omzeilen via technieken zoals het parafraseren van tekst, bijsnijden of filteren van afbeeldingen, of het vertalen van inhoud naar andere talen. Het verwijderen van geavanceerde watermerken vereist echter technische expertise en kennis van het watermarking-schema. Statistische watermerken zijn robuuster dan traditionele benaderingen, maar onderzoek heeft proof-of-concept aanvallen aangetoond tegen zelfs geavanceerde watermarking-methoden, wat aangeeft dat geen enkele watermarking-techniek volledig waterdicht is.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Ontdek alles over AI-inhoudslicentieovereenkomsten die bepalen hoe kunstmatige intelligentiesystemen auteursrechtelijk beschermde inhoud gebruiken. Verken licen...

Ontdek wat detectie van AI-inhoud is, hoe detectietools werken met behulp van machine learning en NLP, en waarom ze belangrijk zijn voor merkmonitoring, onderwi...

Ontdek wat AI-inhoudsattributie is, hoe verschillende platforms bronnen citeren, waarom het belangrijk is voor merkzichtbaarheid en hoe je kunt optimaliseren vo...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.