Autoritetsbygging for AI-synlighet

Lær hvordan du bygger autoritet for AI-synlighet. Oppdag E-E-A-T-strategier, tematisk autoritet, og hvordan du blir sitert i AI Overviews og LLM-svar.

Lær hvordan du bygger tematisk autoritet for LLM-er med semantisk dybde, entitetoptimalisering og innholdsklynger. Mestre strategiene som får AI-systemer til å sitere ditt merke.

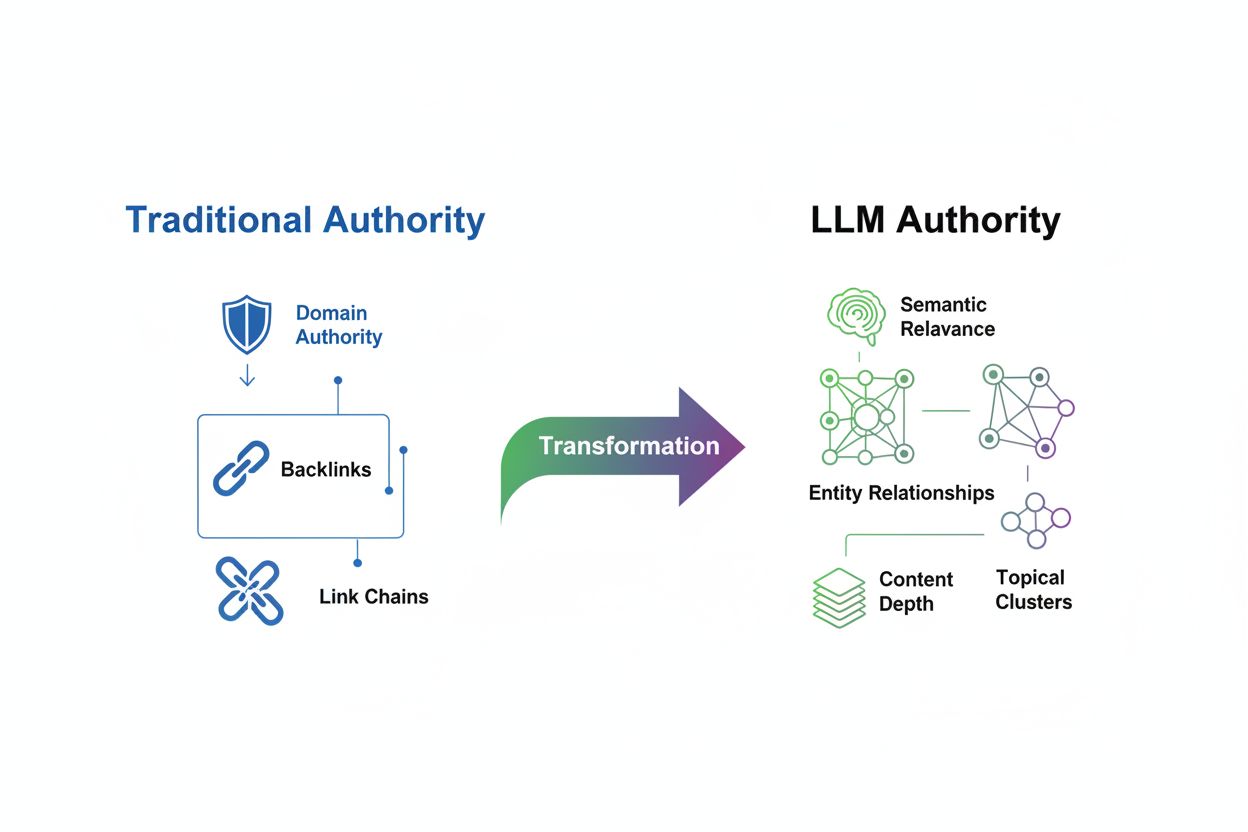

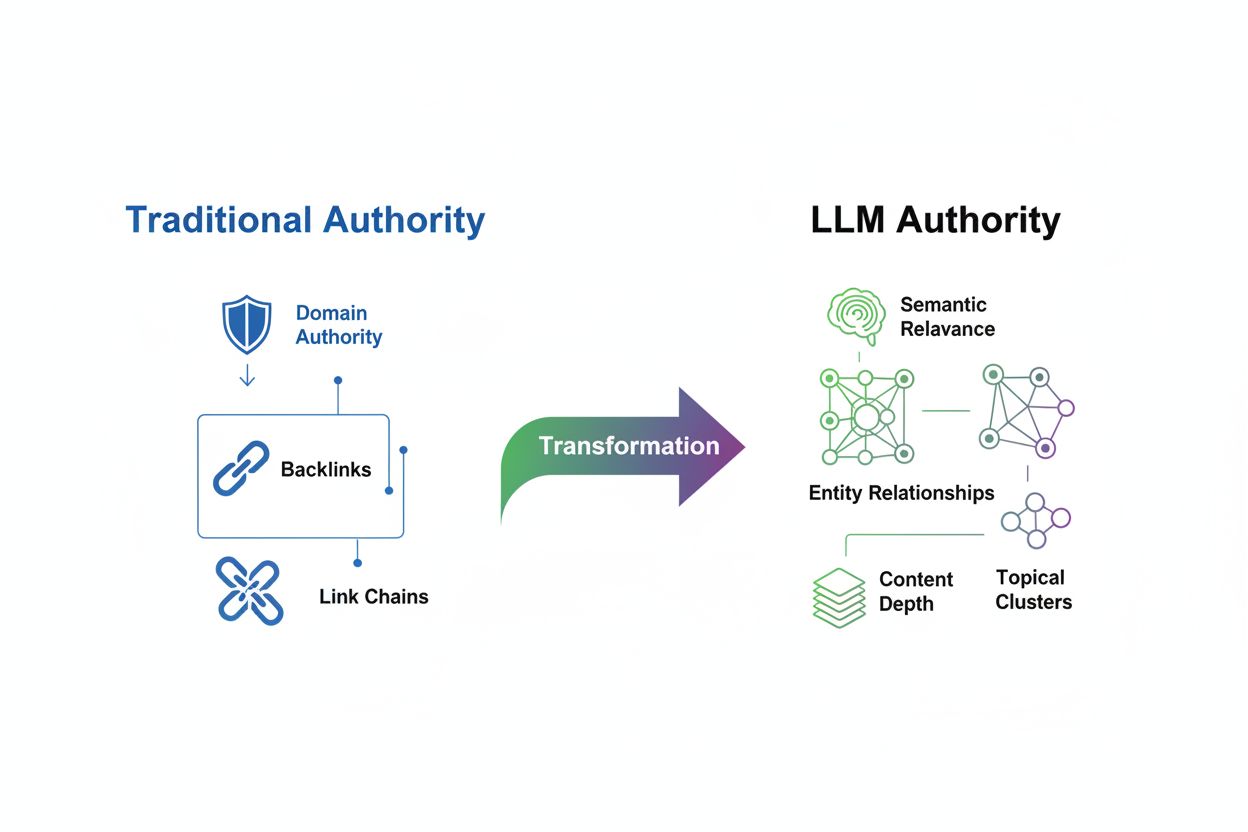

Evalueringen av tematisk autoritet har gjennomgått en grunnleggende transformasjon i epoken med store språkmodeller (LLM). Der tradisjonell SEO tidligere satte lenker og nøkkelordtetthet som de viktigste autoritetssignalene, vurderer moderne LLM-er innhold gjennom et helt annet prisme fokusert på semantisk relevans, kontekstuell dybde og entitetsforhold. Dette skiftet er mer enn en mindre algoritmeoppdatering—det er en total nytenkning av hvordan søkemotorer og AI-systemer avgjør hvilke kilder som fortjener synlighet og tillit. Den gamle modellen belønnet volum og antall lenker; det nye paradigmet belønner semantisk rikdom og helhetlig temadekning. Å forstå denne overgangen er kritisk fordi merkevarer som fortsetter å optimalisere for utdaterte autoritetssignaler, vil bli stadig mer usynlige i AI-genererte svar, selv om de har sterke tradisjonelle SEO-målinger. Fremtidens synlighet tilhører de som innser at LLM-er gjenkjenner autoritet gjennom dybde, konsistens og semantisk klarhet heller enn gjennom oppsamling av eksterne lenker.

Tematisk autoritet defineres som nivået av ekspertise, dybde og konsistens et nettsted viser innenfor et spesifikt fagområde, slik det gjenkjennes av både søkemotorer og kunstige intelligenssystemer. I motsetning til tradisjonelle autoritetsmålinger som er sterkt avhengige av ekstern validering via lenker, fokuserer LLM-basert autoritetsevaluering på hvor omfattende og sammenhengende et domene dekker sitt valgte tema. Semantisk relevans har blitt hjørnesteinen i denne nye evalueringsmetoden—LLM-er vurderer om innholdet dekker brukerintensjonen fullt ut, belyser flere vinkler av et tema og opprettholder logiske forbindelser mellom relaterte konsepter. Forskjellen er betydelig: et nettsted med 50 tynne, nøkkelordfylte artikler kan ha sterke tradisjonelle autoritetssignaler, men svak tematisk autoritet i LLM-kontekst, mens en konkurrent med 10 dyptgående, sammenkoblede artikler kan dominere AI-genererte svar.

| Authority Signal | Traditional SEO | LLM Evaluation |

|---|---|---|

| Primary Metric | Backlink quantity and domain authority | Semantic depth and topic coverage |

| Content Approach | Keyword optimization and volume | Comprehensive, interconnected content clusters |

| Entity Recognition | Minimal emphasis | Critical for understanding relationships |

| Internal Linking | Secondary consideration | Essential for demonstrating expertise |

| Measurement Focus | Domain-level metrics (DA, DR, DP) | Topic-level visibility and citation frequency |

Store språkmodeller vurderer autoritet gjennom avanserte mekanismer som skiller seg fundamentalt fra tradisjonelle søkealgoritmer. Når en LLM møter innhold, teller den ikke bare lenker eller skanner etter nøkkelordfrekvens; den bruker mønstergjenkjenning på tvers av milliarder av dokumenter for å forstå hvordan konsepter henger sammen. Modellen analyserer entitetsforhold—forbindelsene mellom personer, organisasjoner, produkter og konsepter—for å avgjøre om en kilde virkelig forstår temaet, eller bare nevner det overfladisk. Semantisk rikdom spiller en avgjørende rolle, da LLM-er vurderer forklaringsdybde, variasjon i perspektiver og logisk flyt mellom ideer. I tillegg signaliserer konsistens på tvers av flere innholdsstykker ekte ekspertise; når et domene gjentatte ganger viser kunnskap om sammenkoblede undertemaer, gjenkjenner LLM-en dette som autoritativt.

Nøkkelmekanismer LLM-er bruker for å gjenkjenne autoritet inkluderer:

I LLM-æraen har innholdsdypde blitt eksponentielt mer verdifullt enn innholdsvolum. Å publisere én omfattende, 5 000 ords guide som grundig utforsker et tema med flere vinkler, eksempler og praktiske råd, vil overgå ti 500-ords artikler som hver kun berører emnet overfladisk. Dette prinsippet utfordrer den tradisjonelle innholdsmarkedsføringsboken som belønnet produktiv publisering. LLM-er foretrekker semantisk dekning—i hvilken grad innholdet adresserer alle relevante aspekter av et tema—over nøkkelordgjentakelse. Når du lager innhold som utforsker et tema fra flere perspektiver, besvarer relaterte spørsmål og knytter til bredere konsepter, bygger du det forskere kaller temaklynger—nettverk av sammenkoblede innholdsstykker som samlet demonstrerer ekspertise. For eksempel bør et finansselskap som bygger autoritet på “pensjonsplanlegging”, lage innhold om investeringsstrategier, skatteimplikasjoner, helsekostnader, folketrygdoptimalisering og arveplanlegging—ikke bare publisere 20 varianter av “hvordan planlegge for pensjon”. Dybde-metoden signaliserer til LLM-er at organisasjonen virkelig forstår temaets økosystem, og gjør innholdet ditt langt mer sannsynlig å bli sitert i AI-genererte svar.

Å lage effektive temaklynger krever en strategisk, hierarkisk tilnærming til innholdsorganisering som signaliserer ekspertise til både brukere og LLM-er. Grunnmuren i denne strategien er pilarsiden—en omfattende, autoritativ ressurs som dekker hovedtemaet bredt og fungerer som knutepunkt for alt relatert innhold. Denne pilaren støttes av klyngesider, som går dypere inn i spesifikke undertemaer og opprettholder klare lenker tilbake til hovedpilaren gjennom strategisk internlenking.

Følg disse trinnene for å bygge en effektiv temaklynge og intern lenkestrategi:

Identifiser ditt kjerne-pilartema: Velg et bredt fagområde der organisasjonen har reell ekspertise og det finnes markedsetterspørsel. Dette bør være spesifikt nok til å demonstrere autoritet, men bredt nok til å støtte flere støtteartikler. Eksempel: “Implementering av ERP-systemer” heller enn bare “ERP”.

Kartlegg relaterte undertemaer og spørsmål: Bruk verktøy som SEMrush, AnswerThePublic og Googles “Folk spør også om” for å finne alle spørsmål, bekymringer og undertemaer målgruppen bryr seg om. Lag et visuelt kart som viser hvordan disse undertemaene henger sammen med hovedpilaren og med hverandre.

Lag din pilarside: Utvikle en omfattende guide (3 000–5 000+ ord) som belyser hovedtemaet helhetlig. Inkluder en oversikt over alle undertemaer, nøkkeldefinisjoner og lenker til klyngeinnholdet ditt. Bruk tydelige overskrifter og logisk organisering for å hjelpe både brukere og LLM-er å forstå innholdsstrukturen.

Utvikle klyngeinnhold: Skriv 8–15 støtteartikler som utforsker spesifikke undertemaer i dybden. Hver klyngeartikkel bør være 1 500–2 500 ord og fokusere på ett aspekt av pilartemaet. Sørg for at hver artikkel lenker tilbake til pilarsiden med kontekstuelle ankertekster.

Implementer strategisk internlenking: Koble klyngeartiklene til hverandre der det er relevant, og skap et nettverk av relatert innhold. Bruk beskrivende ankertekst med relevante nøkkelord og entitetsnavn. Legg til “relaterte artikler”-seksjoner og navigasjonswidgets for å oppmuntre til utforskning av innholdsnettverket ditt.

Oppretthold konsistens og oppdater regelmessig: Gå jevnlig gjennom klyngen for hull, utdatert informasjon og nye undertemaer. Legg til nye klyngeartikler etter hvert som temafeltet utvikler seg, og oppdater eksisterende innhold for å opprettholde relevans og nøyaktighet.

Entitetoptimalisering representerer et paradigmeskifte i hvordan vi strukturerer innhold og tenker SEO. I stedet for å optimalisere for nøkkelord, optimaliserer vi nå for entiteter—spesifikke personer, organisasjoner, produkter, steder og konsepter som LLM-er bruker for å forstå mening. Når du tydelig definerer og konsekvent refererer til entiteter i innholdet ditt, lærer du i praksis LLM-ens kunnskapsgraf hvordan innholdet ditt relaterer seg til det bredere informasjonssystemet. Schema markup fra Schema.org gir det tekniske grunnlaget for entitetoptimalisering, slik at du eksplisitt kan fortelle søkemotorer og LLM-er hvilke entiteter innholdet ditt diskuterer og hvordan de henger sammen.

Praktiske tips for entitetoptimalisering:

Definer nøkkelentiteter tydelig: Identifiser hovedentitetene innholdet ditt omhandler (f.eks. “Google Analytics”, “konverteringsoptimalisering”, “A/B-testing”) og nevn dem eksplisitt i overskrifter, underoverskrifter og brødtekst. Unngå vage formuleringer; vær spesifikk om hvilke produkter, personer eller konsepter du diskuterer.

Bruk strukturert data-markup: Implementer Schema.org-markup for å definere entiteter og deres relasjoner. Bruk Article-schema for blogginnlegg, Organization-schema for selskapet, Product-schema for produkter og Person-schema for forfatterinformasjon. Denne strukturerte dataen hjelper LLM-er å trekke ut og forstå sentral informasjon.

Koble entiteter til autoritative kilder: Lenke entitetene dine til autoritative eksterne referanser som Wikipedia, DBpedia og Google Knowledge Graph. Denne eksterne valideringen styrker troverdigheten til entitetsreferansene dine og hjelper LLM-er å forstå sammenhengen.

Vedlikehold konsistent entitetsbruk: Bruk samme terminologi, stavemåte og navnekonvensjoner for entiteter på tvers av alt innhold, nettsted, sosiale medier og bransjeplattformer. Konsistens signaliserer til LLM-er at du snakker om samme entitet og bygger en sammenhengende kunnskapsbase.

Googles E-E-A-T-rammeverk—Erfaring, Ekspertise, Autoritet og Tillit—har endret betydning etter hvert som LLM-er blir sentrale i søk. Selv om disse signalene fortsatt er viktige for tradisjonell rangering, tolkes de nå annerledes i AI-drevne sammenhenger. LLM-er vurderer disse signalene ikke bare gjennom lenker, men gjennom innholdsanalyse, forfatterkredentialer og konsistensmønstre.

Erfaringssignaler viser at organisasjonen eller forfatteren har direkte, praktisk erfaring med temaet. LLM-er gjenkjenner erfaring gjennom casestudier, kunderesultater, personlige historier fra kvalifiserte forfattere og detaljerte gjennomganger av prosesser. Vis heller ekspertise gjennom dokumenterte eksempler på løste problemer enn å bare påstå ekspertise. Inkluder forfatterbiografier med relevant bakgrunn, og vis tilbakemeldinger eller resultater fra faktiske kunder eller brukere.

Ekspertise formidles gjennom omfattende, nyansert innhold som demonstrerer inngående fagkunnskap. LLM-er vurderer ekspertise ved å analysere om innholdet tar opp spesialtilfeller, anerkjenner kompleksitet, siterer relevant forskning og gir innsikt som går utover overflateinformasjon. Publiser innhold som tar for seg avanserte temaer, utforsker motintuitive funn og viser forståelse for bransjedebatter og beste praksis i utvikling.

Autoritet i LLM-æraen kommer fra å bli anerkjent som en ressurs innen ditt felt. Dette bygges gjennom jevnlig publisering av kvalitetsinnhold, siteringer fra andre autoritative kilder, foredrag, publisert forskning og bransjeanerkjennelse. LLM-er sporer hvilke kilder som ofte siteres sammen og hvilke som vises i svar på autoritative spørsmål.

Tillit etableres gjennom åpenhet, nøyaktighet og ansvarlighet. Inkluder publiseringsdatoer og oppdateringstidsstempler på alt innhold, siter kilder tydelig, oppgi eventuelle interessekonflikter, og rett feil raskt. Bruk forfatterkredentialer, sertifiseringer og tilhørighet for å etablere legitimitet. LLM-er blir stadig bedre til å oppdage villedende påstander og belønner kilder som prioriterer nøyaktighet fremfor sensasjon.

Å spore tematiske autoritetsmålinger krever at man flytter fokus fra tradisjonelle SEO-målinger til nye indikatorer som gjenspeiler hvordan LLM-er oppfatter din ekspertise. Mens Domain Authority og Domain Rating fortsatt er relevante for tradisjonelt søk, viser de svak sammenheng med LLM-synlighet—forskning fra Search Atlas på 21 767 domener viser korrelasjoner fra -0,08 til -0,21, noe som indikerer at tradisjonelle autoritetssignaler har begrenset innflytelse på AI-genererte resultater.

Nøkkelmålinger og verktøy for å overvåke tematisk autoritet inkluderer:

LLM-synlighetspoeng: Følg hvor ofte og hvor fremtredende innholdet ditt vises i svar fra ChatGPT, Gemini og Perplexity. Verktøy som Search Atlas sin LLM Visibility-funksjon måler siteringsfrekvens og synlighetsprosenter på tvers av flere modeller.

Trafikk på temanivå: Overvåk organisk trafikk ikke bare for individuelle nøkkelord, men for hele temaklynger. Bruk Google Analytics til å segmentere trafikken etter tema og se om du får synlighet på flere relaterte søk.

Innholdsdekningsmålinger: Vurder om innholdet ditt dekker alle viktige undertemaer og spørsmål relatert til kjernetemaet. Verktøy som Clearscope og MarketMuse måler tematisk dekning og identifiserer innholdshull.

Intern lenkestyrke: Analyser intern lenkestruktur for å sikre at klyngesider henger logisk sammen med pilarinnhold og med hverandre. Bruk Screaming Frog for å visualisere og optimalisere internlenkingen.

Entitetskonsistens-overvåking: Følg med på om du konsekvent nevner og definerer viktige entiteter på tvers av innhold. Bruk Google Search Console for å se hvilke entiteter innholdet ditt assosieres med i søkeresultater.

Mange organisasjoner som jobber for tematisk autoritet, undergraver innsatsen sin gjennom unngåelige feil. Å forstå disse fallgruvene hjelper deg å unngå å sløse ressurser på ineffektive strategier.

Vanlige feil å unngå inkluderer:

Publisering av tynt innhold: Lage mange korte artikler (300–500 ord) som kun berører et tema uten reell dybde. LLM-er ser dette som utilstrekkelig og foretrekker færre, mer omfattende ressurser.

Dårlig intern lenkestruktur: Unnlater å koble sammen relatert innhold eller bruker generisk ankertekst som “klikk her” i stedet for beskrivende, entitetsrike ankertekster. Dette hindrer LLM-er i å forstå sammenhengene mellom innholdet ditt.

Inkonsekvent entitetsbruk: Bruke ulike begreper for samme konsept i ulike artikler (f.eks. “konverteringsoptimalisering” i én artikkel, “CRO” i en annen, “forbedre konverteringer” i en tredje). Denne fragmenteringen hindrer LLM-er i å gjenkjenne din sammenhengende ekspertise.

Ignorering av innholdshull: Publisere innhold om noen aspekter av et tema, men utelate viktige undertemaer. LLM-er ser ufullstendig temadekning og kan favorisere konkurrenter med mer helhetlige ressurser.

Forsømte innholdsoppdateringer: La eldre innhold bli utdatert mens nye artikler publiseres om samme tema. Dette skaper redundans og forvirring om hvilken ressurs som representerer dagens ekspertise.

Å bygge tematisk autoritet er en strukturert prosess som krever planlegging, gjennomføring og kontinuerlig optimalisering. Dette veikartet gir deg en tydelig vei videre.

Følg dette veikartet for å bygge LLM-anerkjent tematisk autoritet:

Gjennomfør en tematisk autoritetsrevisjon: Analyser eksisterende innhold for å finne dine sterkeste temaområder og hull. Kartlegg hvilke temaer du dekker i dag, hvilke undertemaer som mangler, og hvor innholdet er tynt eller utdatert. Bruk verktøy som SEMrush Topic Research og Ahrefs for å se hva konkurrentene dekker.

Definer dine kjerne-pilarer: Velg 3–5 sentrale temaområder der organisasjonen har genuin ekspertise og det finnes markedsetterspørsel. Disse bør være spesifikke nok til å vise autoritet, men brede nok til å støtte flere støtteartikler. Dokumenter hvorfor din organisasjon er unikt kvalifisert til å dekke disse temaene.

Lag en omfattende innholdskart: Utvikle en visuell representasjon av pilarsider og klyngeinnhold. Vis hvordan undertemaer henger sammen med hovedpilarene og med hverandre. Identifiser hvilket innhold som allerede finnes, hva som må lages, og hva som bør slås sammen eller fjernes.

Lag eller oppdater pilarsider: Opprett omfattende pilarsider (3 000–5 000+ ord) for hvert kjernetema. Sørg for at hver pilar dekker temaet bredt, inkluderer tydelige definisjoner av nøkkelentiteter og lenker til alt støtteinnhold. Optimaliser pilarsider med schema markup slik at LLM-er forstår innholdsstrukturen.

Bygg klyngeinnhold og internlenking: Lag 8–15 støtteartikler per pilar, hvor hver artikkel utforsker ett undertema i dybden. Implementer strategisk internlenking med beskrivende ankertekst. Sørg for at klyngeartikler lenker tilbake til pilaren og til relevante andre klyngeartikler.

Implementer entitetoptimalisering og schema markup: Legg til Schema.org-markup i alt innhold for å definere entiteter og deres relasjoner eksplisitt. Sørg for konsistent entitetsbruk i alt innhold. Lenke entiteter til autoritative eksterne kilder for å styrke troverdigheten.

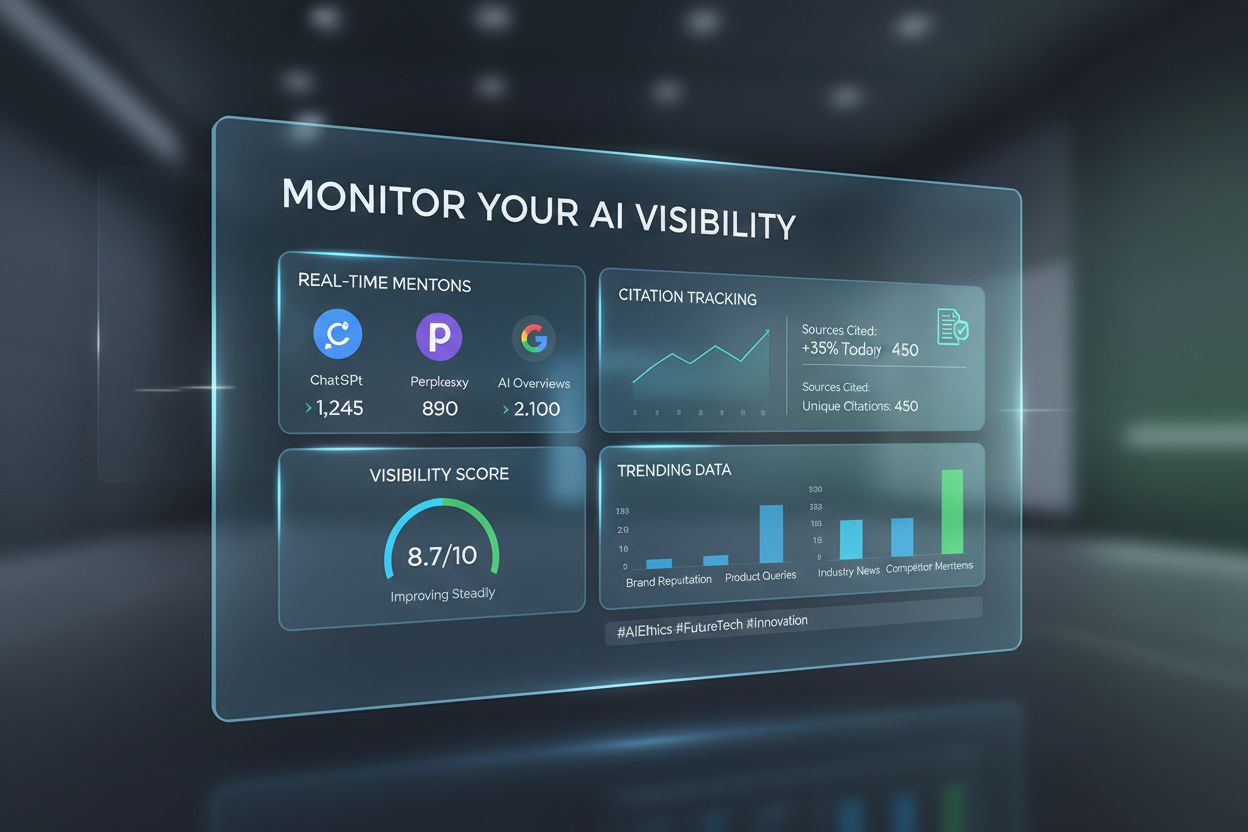

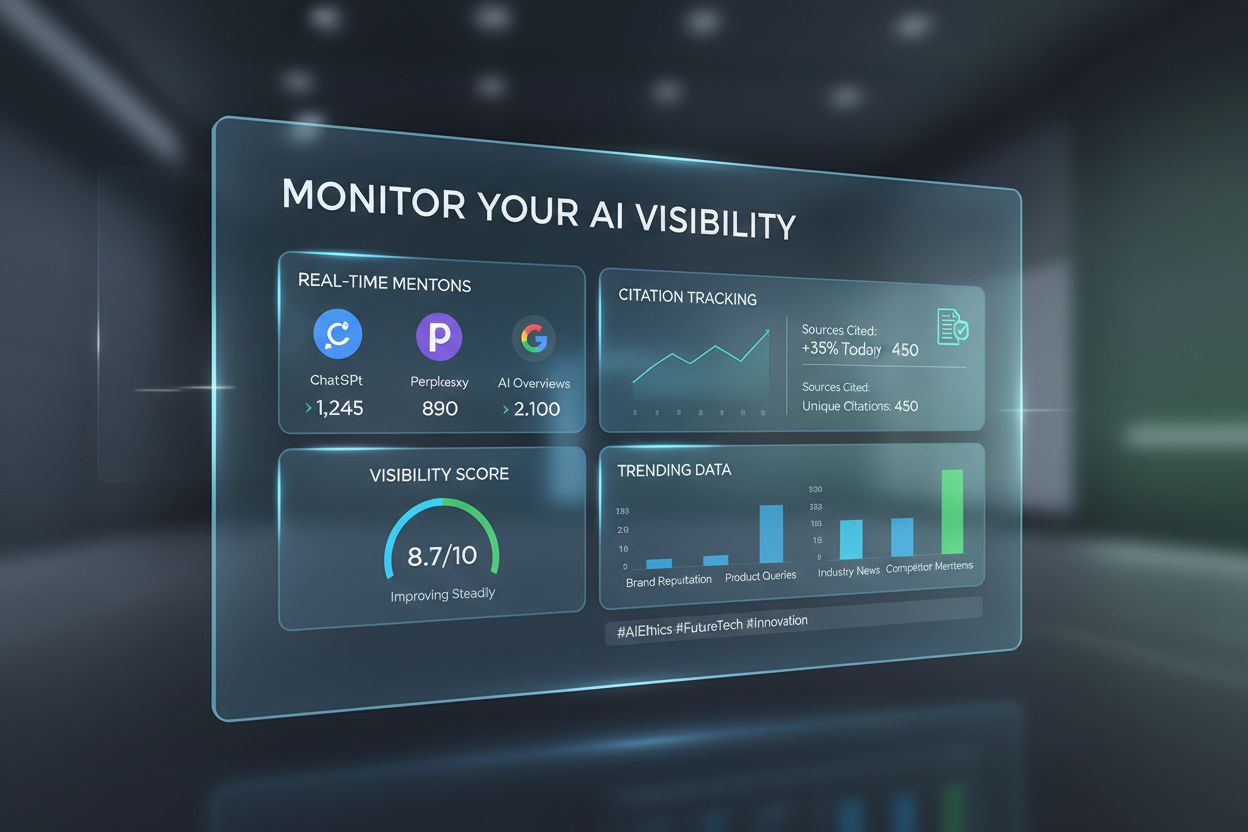

Etter hvert som din tematiske autoritet vokser, blir det avgjørende å spore hvordan dette gir synlighet i AI-systemer. AmICited er en spesialisert plattform laget for å overvåke merkevarens tilstedeværelse og siteringer på tvers av store språkmodeller, og gir deg innsikt i hvordan AI-systemer gjenkjenner og refererer til innholdet ditt. I motsetning til tradisjonelle SEO-verktøy som fokuserer på Google-rangeringer, sporer AmICited spesifikt LLM-synlighet—måling av hvor ofte og hvor fremtredende merkevaren din vises i svar fra ChatGPT, Gemini, Perplexity og andre generative AI-plattformer.

Plattformen gir flere viktige fordeler for overvåking av din autoritet i AI:

Plattformuavhengig siteringssporing: Overvåk merkevarenavn og siteringer på tvers av flere LLM-er samtidig, og forstå hvilke plattformer som gjenkjenner din autoritet sterkest og hvor du har synlighetshull.

Konkurransebenchmarking: Sammenlign LLM-synligheten din mot konkurrenter i bransjen. Se hvem som siteres oftere og analyser deres innholdsstrategier for å finne muligheter.

Sitasjonskontekst-analyse: Se ikke bare at du siteres, men hvordan du siteres. Forstå hvilke temaer som trigger siteringer, hvilken kontekst LLM-er bruker når de nevner merkevaren, og om siteringene er positive og nøyaktige.

Synlighetstrender over tid: Følg med på hvordan LLM-synligheten din endrer seg over tid etter hvert som du forbedrer tematisk autoritet. Mål effekten av nytt innhold, oppdateringer og strukturelle endringer på AI-drevet synlighet.

Innsikt i autoritetssignaler: Få anbefalinger om hvilke innholdshull du bør fylle, hvilke temaer du bør utvide og hvilke entiteter du bør optimalisere basert på LLM-sitasjonsmønstre og konkurrentanalyse.

Ved å bruke AmICited sammen med tradisjonelle SEO-verktøy får du et komplett bilde av din autoritet både i tradisjonell søk og AI-drevet oppdagelse. Dette doble perspektivet er avgjørende i 2025 og videre, ettersom LLM-drevet søk blir stadig mer sentralt for hvordan brukere finner informasjon. De merkevarene som overvåker og optimaliserer for både tradisjonell og AI-synlighet, vil beholde konkurransefortrinnet etter hvert som søk utvikler seg mot samtale- og AI-genererte svar.

Tematisk autoritet måler hvor omfattende og konsekvent du dekker et fagområde, mens nøkkelordrangering fokuserer på individuelle søkeord. LLM-er vurderer tematisk autoritet ved å analysere semantisk dybde, entitetsforhold og innholdssammenkobling. Et nettsted kan rangere for spesifikke nøkkelord uten å ha reell tematisk autoritet, men tematisk autoritet gir vanligvis synlighet på tvers av flere relaterte søk og AI-genererte svar.

Å bygge tematisk autoritet er en langsiktig strategi som vanligvis krever 3–6 måneder for å vise innledende resultater og 6–12 måneder for å etablere sterk gjenkjenning. Tidslinjen avhenger av utgangspunkt, innholdskvalitet, konkurransenivå og hvor konsekvent du gjennomfører strategien. LLM-er gjenkjenner autoritet gjennom mønstre over tid, så konsistens og dybde er viktigere enn tempo.

Ja, absolutt. I motsetning til tradisjonelle autoritetsmålinger som favoriserer etablerte domener med mange lenker, vurderer LLM-er tematisk autoritet basert på semantisk dybde og innholdskvalitet. En liten merkevare med 10 omfattende, sammenkoblede artikler om et spesifikt tema kan overgå en stor utgiver med 100 overfladiske artikler. Fokuser på dybde, konsistens og entitetoptimalisering fremfor volum.

Lenker er fortsatt relevante for tradisjonelle Google-rangeringer, men viser svak korrelasjon med LLM-synlighet. Forskning viser korrelasjoner mellom tradisjonelle autoritetsmålinger og LLM-synlighet fra -0,08 til -0,21. Selv om lenker fortsatt er viktige for SEO, prioriterer LLM-er semantisk relevans, innholdsdypde og entitetsforhold. Fokuser på å lage eksepsjonelt innhold som naturlig tiltrekker siteringer, ikke lenker for lenkens skyld.

Tegn på tematisk autoritet inkluderer: å vises i AI-genererte svar på flere relaterte spørsmål, konsekvente siteringer på tvers av ulike LLM-er, rangering for temaklynger fremfor isolerte nøkkelord, høye engasjementstall på pilar- og klyngeinnhold, og anerkjennelse som en ressurs i din bransje. Bruk verktøy som AmICited for å spore LLM-siteringer og Search Atlas for å overvåke synlighet på temanivå.

Du bør fokusere på begge deler, men med ulike prioriteringer. Tematisk autoritet blir stadig viktigere for AI-drevet oppdagelse og langsiktig synlighet, mens tradisjonell SEO forblir kritisk for Google-rangeringer. Det gode er at strategier som bygger tematisk autoritet (semantisk dybde, entitetoptimalisering, innholdsklynger) også forbedrer tradisjonell SEO. Start med tematisk autoritet som grunnmur, så følger SEO-fordelene etter.

Brukerengasjementssignaler som lesetid, scrolldybde og gjenbesøk indikerer for LLM-er at innholdet ditt gir reell verdi. Når brukere bruker tid på innholdet ditt og utforsker relaterte artikler i klyngen, signaliserer det at innholdet ditt er omfattende og autoritativt. LLM-er tolker disse engasjementsmønstrene som tegn på innholdskvalitet og relevans, så optimalisering av brukeropplevelse er essensielt for tematisk autoritet.

LLM-er analyserer hvordan du nevner og kobler sammen ulike entiteter (personer, organisasjoner, produkter, konsepter) gjennom hele innholdet. Når du konsekvent refererer til relaterte entiteter og forklarer forholdene deres, gjenkjenner LLM-er dette som bevis på omfattende forståelse. Schema markup hjelper ved å eksplisitt definere entitetsforhold. For eksempel viser det å koble 'pensjonsplanlegging' med 'folketrygd', 'investeringsstrategier' og 'skatteoptimalisering' at du forstår økosystemet rundt temaet.

Følg med på hvordan LLM-er siterer innholdet ditt og mål din tematiske autoritet på tvers av ChatGPT, Gemini og Perplexity med AmICiteds AI-overvåkingsplattform.

Lær hvordan du bygger autoritet for AI-synlighet. Oppdag E-E-A-T-strategier, tematisk autoritet, og hvordan du blir sitert i AI Overviews og LLM-svar.

Lær hva LLMO er, hvordan det fungerer, og hvorfor det er viktig for AI-synlighet. Oppdag optimaliseringsteknikker for å få merkevaren din nevnt i ChatGPT, Perpl...

Lær hvordan tematisk autoritet påvirker synlighet i AI-søk, sitater i ChatGPT og Perplexity, og hvordan du bygger ekspertise som AI-systemer gjenkjenner og site...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.