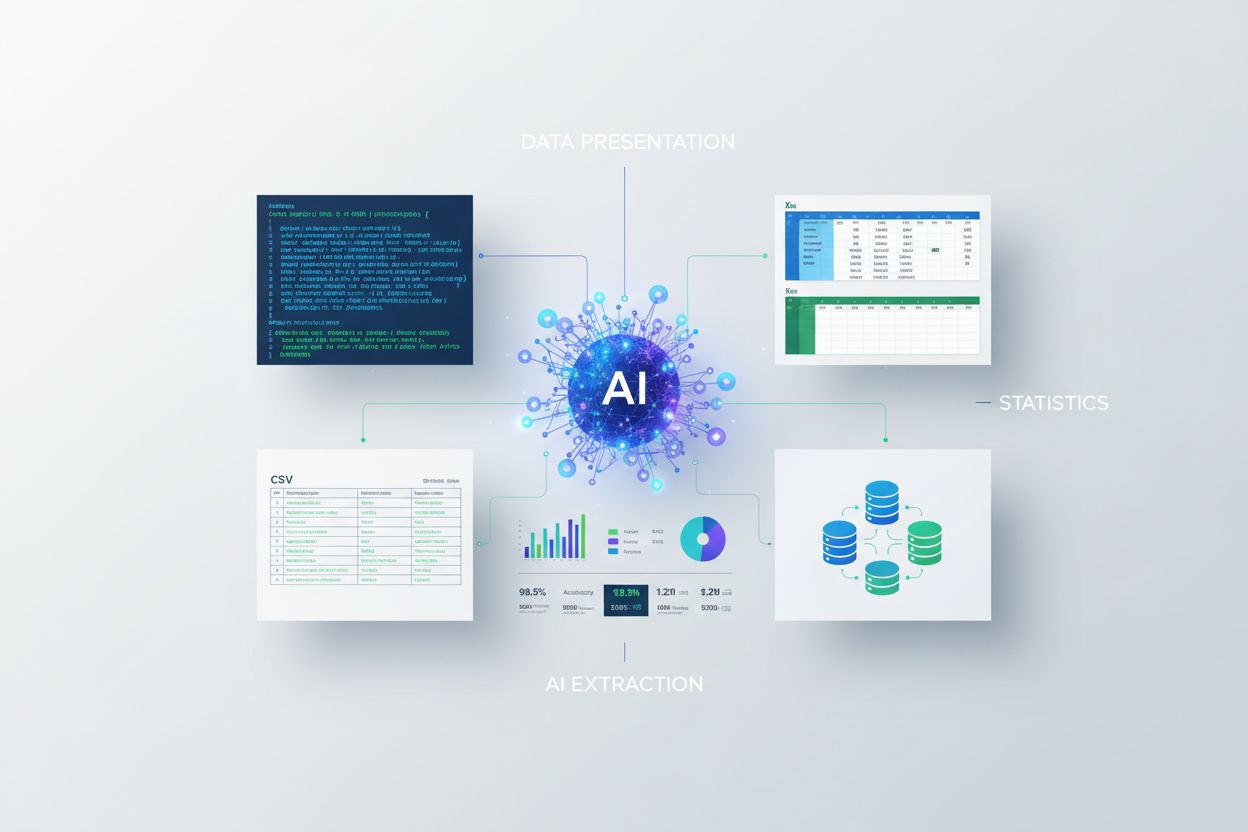

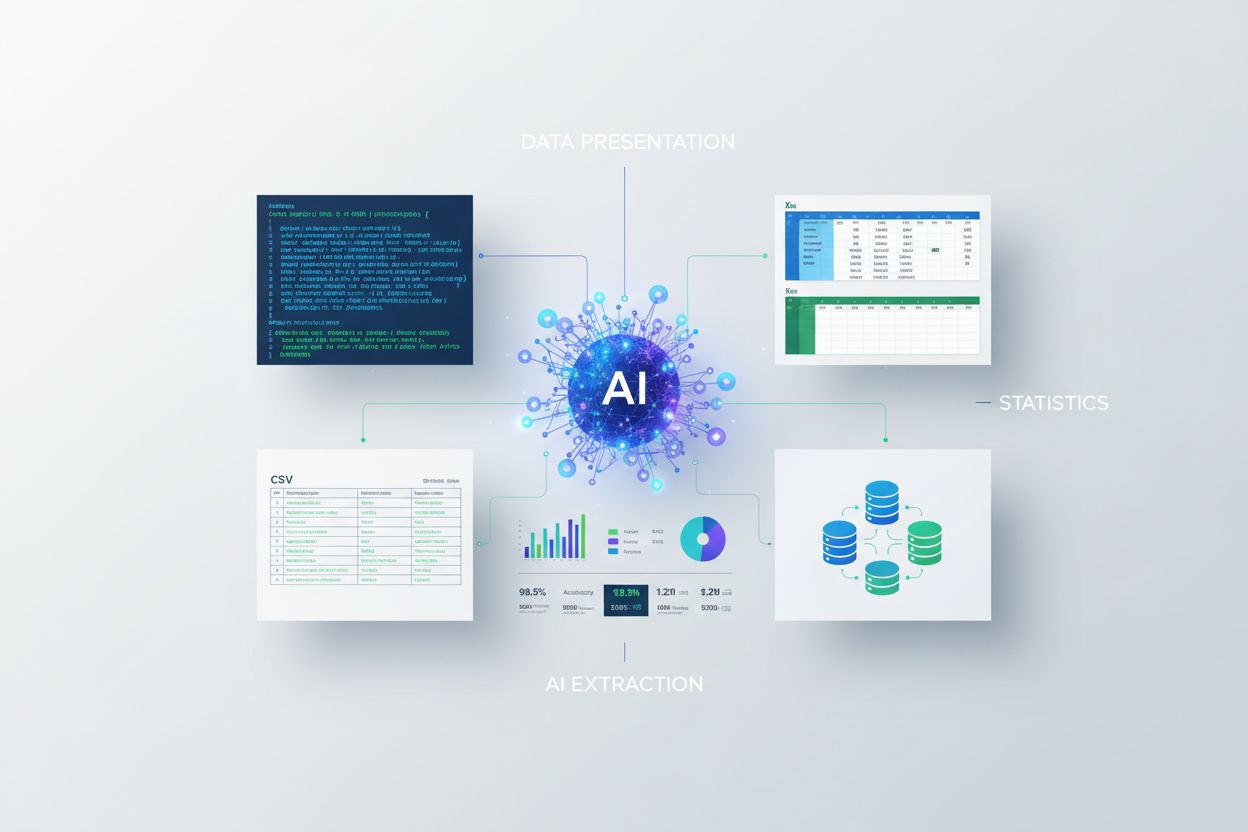

Presentasjon av statistikk for AI-uttrekk

Lær hvordan du presenterer statistikk for AI-uttrekk. Oppdag beste praksis for dataformatering, JSON vs CSV, og hvordan du sikrer at dataene dine er AI-klare fo...

Oppdag hvorfor datakvalitet betyr mer enn mengde for KI-modeller. Lær strategier for ressursallokering, kostnadsimplikasjoner og praktiske rammeverk for å optimalisere din investering i treningsdata for KI.

Den tradisjonelle oppfatningen innen maskinlæring har lenge vært at «mer data alltid er bedre». Nyere forskning utfordrer imidlertid denne antakelsen med overbevisende bevis på at datakvalitet veier tyngre enn mengde når det gjelder å avgjøre KI-modellers ytelse. En arxiv-studie fra 2024 (2411.15821) av små språkmodeller fant at treningsdatakvalitet spiller en langt viktigere rolle enn ren mengde, og viser at forholdet mellom datamengde og modellnøyaktighet er langt mer nyansert enn tidligere antatt. Kostnadsimplikasjonene er betydelige: organisasjoner som investerer tungt i datainnsamling uten å prioritere kvalitet, kaster ofte bort ressurser på lagring, prosessering og datakraft uten å se tilsvarende gevinst i modellens ytelse.

Datakvalitet er ikke et monolittisk begrep, men et multidimensjonalt rammeverk med flere kritiske aspekter. Nøyaktighet handler om hvor korrekt dataene gjenspeiler virkeligheten, og om etikettene er riktig satt. Konsistens sikrer at data følger ensartede formater og standarder i hele datasettet. Fullstendighet måler om all nødvendig informasjon er tilstede uten vesentlige hull eller manglende verdier. Relevans avgjør om dataene direkte adresserer problemet KI-modellen er laget for å løse. Pålitelighet viser hvor troverdig datakilden er og hvor stabil den er over tid. Til slutt representerer støy uønskede variasjoner eller feil som kan villede modelltreningen. Å forstå disse dimensjonene hjelper organisasjoner å prioritere datakuratering strategisk.

| Kvalitetsdimensjon | Definisjon | Innvirkning på KI |

|---|---|---|

| Nøyaktighet | Korrekthet av etiketter og datarepresentasjon | Påvirker direkte modellens pålitelighet; feiletiketter gir systematiske feil |

| Konsistens | Ensartet formatering og standardisert datastruktur | Muliggjør stabil trening; inkonsistens forvirrer læringsalgoritmer |

| Fullstendighet | Tilstedeværelse av all nødvendig informasjon uten hull | Manglende verdier reduserer effektiv treningsdata; påvirker generalisering |

| Relevans | Data adresserer direkte problemområdet | Høyt relevante data overgår store mengder generisk data |

| Pålitelighet | Troverdighet og stabilitet for datakilder | Upålitelige kilder skaper systematisk skjevhet; påvirker modellens robusthet |

| Støy | Uønskede variasjoner og målefeil | Kontrollert støy øker robusthet; overdreven støy svekker ytelse |

Jakt på datamengde uten kvalitetskontroller skaper en rekke problemer som strekker seg langt utover modellens ytelsesmålinger. Forskning av Rishabh Iyer viser at eksperimenter med etikettstøy gir dramatiske nøyaktighetsfall—feilmerkede data forringer aktivt modellens ytelse i stedet for å bare være nøytrale eksempler. Organisasjoner opplever i tillegg økende lagrings- og prosesseringskostnader for datasett som ikke gir bedre resultater, samt betydelige miljøkostnader fra unødvendig datakraft. Medisinske bilder gir et alvorlig eksempel fra virkeligheten: et datasett med tusenvis av feilmerkede røntgenbilder kan trene en modell som trygt gjør farlige diagnostiske feil, og dermed skade pasienter. Den falske økonomien i å samle billig, lavkvalitetsdata blir tydelig når man tar med kostnadene for nytrening, feilsøking og produksjonsfeil forårsaket av dårlige treningsdata.

Domene-spesifikk kvalitet overgår konsekvent generisk volum i praktiske KI-applikasjoner. Tenk på en stemningsklassifisator trent på filmanmeldelser: et nøye kuratert datasett med 10 000 filmanmeldelser vil gi vesentlig bedre resultater enn et generisk stemningsdatasett på 100 000 eksempler hentet fra finansnyheter, sosiale medier og produktanmeldelser. Relevansen til treningsdataene for det spesifikke problemområdet betyr langt mer enn ren størrelse, da modeller lærer mønstre som er spesifikke for deres treningsdistribusjon. Når data mangler relevans for målapplikasjonen, lærer modellen feilaktige sammenhenger og klarer ikke å generalisere til virkelige brukstilfeller. Organisasjoner bør prioritere å samle mindre datasett som nøye matcher deres problemområde, fremfor å akkumulere massive generiske datasett som krever omfattende filtrering og forprosessering.

Den optimale datastrategien ligger ikke i noen av ytterpunktene, men i å finne «Gullhårsonen»—det perfekte punktet hvor datamengde og -kvalitet balanseres riktig for det aktuelle problemet. For lite data, selv om det er perfekt merket, gir undertrente modeller som ikke fanger kompleksiteten i virkelige mønstre. På den andre siden gir for mye data med kvalitetsproblemer sløsing av datakraft og ustabil trening. Arxiv-studien viser denne balansen konkret: minimal duplisering ga 0,87 % økt nøyaktighet ved 25 % duplisering, mens overdreven duplisering (100 %) førte til katastrofalt 40 % nøyaktighetsfall. Den ideelle balansen avhenger av flere faktorer, inkludert algoritmetype, problemkompleksitet, tilgjengelige ressurser og naturlig variasjon i målområdet. Datadistribusjonen bør speile den virkelige verdens variasjon, ikke være kunstig jevn, slik at modellene lærer å takle variasjonen de møter i produksjon.

Ikke all ekstra data er lik—forskjellen mellom gunstig augmentering og skadelig degradering er avgjørende for effektiv datastrategi. Kontrollerte forstyrrelser og augmenteringsteknikker øker modellens robusthet ved å lære algoritmer å håndtere variasjoner som små rotasjoner, lysendringer eller små etikettvariasjoner. MNIST-datasettet med håndskrevne sifre demonstrerer dette: modeller trent med augmenterte versjoner (roterte, skalerte eller lett forvrengte sifre) generaliserer bedre til ekte håndskrift enn modeller trent kun på originalbildene. Alvorlig korrupsjon—tilfeldig støy, systematisk feiletikettering eller injisering av irrelevante data—forringer ytelsen og sløser datakraft. Den avgjørende forskjellen er hensikten: augmentering er bevisst utformet for å speile realistiske variasjoner, mens søppeldata er vilkårlig støy som forvirrer læringsalgoritmene. Organisasjoner må skille mellom disse tilnærmingene når de utvider datasettene sine.

For organisasjoner med begrensede ressurser tilbyr aktiv læring en kraftig løsning som reduserer databehovet og samtidig opprettholder eller forbedrer modellens ytelse. I stedet for å samle og merke alle tilgjengelige data passivt, identifiserer aktive læringsalgoritmer hvilke umerkede eksempler som er mest informative for modellen, og reduserer menneskelig merkingsbyrde dramatisk. Denne tilnærmingen gjør at organisasjoner kan oppnå god modellprestasjon med langt færre merkede data, ved å fokusere innsatsen på de mest innflytelsesrike eksemplene. Aktiv læring demokratiserer KI-utvikling ved å gjøre det tilgjengelig for team uten store merkingsbudsjetter, slik at de kan bygge effektive modeller gjennom strategisk datavalgt i stedet for ren mengde. Ved å lære effektivt med mindre data kan organisasjoner iterere raskere, redusere kostnader og kanalisere ressurser mot kvalitetskontroll fremfor evig datainnsamling.

Strategisk ressursallokering krever at man prioriterer kvalitet fremfor kvantitet i datastrategiske beslutninger. Organisasjoner bør investere i robuste valideringsrørledninger som fanger feil før de havner i treningsdatasett, og implementere automatiske sjekker for konsistens, fullstendighet og nøyaktighet. Dataprofilverktøy kan identifisere kvalitetsproblemer i stor skala, og avdekke mønstre av feiletikettering, manglende verdier eller irrelevante eksempler som bør utbedres før trening. Implementering av aktiv læring reduserer volumet av data som krever menneskelig gjennomgang, samtidig som de gjennomgåtte eksemplene blir maksimalt informative. Kontinuerlig overvåkning av modellens ytelse i produksjon viser om treningsdatakvalitet gir reelle feil, og muliggjør raske tilbakemeldingssløyfer for forbedring. Den optimale strategien balanserer datainnsamling med grundig kuratering, og anerkjenner at 1 000 perfekt merkede eksempler ofte overgår 100 000 støyende eksempler både i modellprestasjon og totalkostnad.

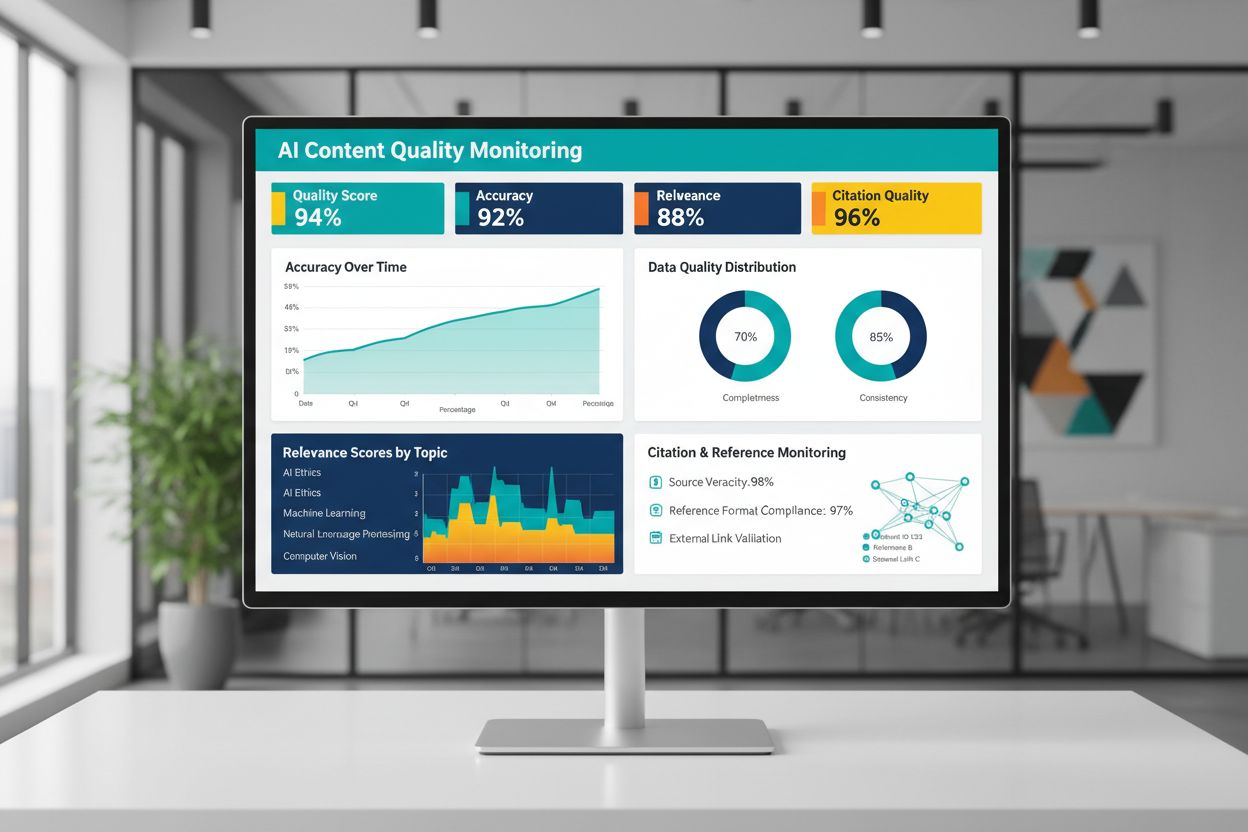

Kvaliteten på KI-generert eller KI-trent innhold avhenger i stor grad av treningsdatakvaliteten, noe som gjør kontinuerlig overvåkning av KI-utdata avgjørende for pålitelighet. Plattformene som AmICited.com dekker dette behovet ved å overvåke KI-svar og spore siteringsnøyaktighet—et direkte mål på innholdskvalitet og troverdighet. Når KI-systemer trenes på data med lav kvalitet, dårlige siteringer eller feil informasjon, arver utdataene disse feilene og kan spre feilinformasjon i stor skala. Overvåkingsverktøy bør spore ikke bare nøyaktighetsmetrikker, men også relevans, konsistens og tilstedeværelse av støttende dokumentasjon for påstander fra KI-systemer. Organisasjoner som bruker KI må ha tilbakemeldingssløyfer som oppdager når utdata avviker fra forventet kvalitet, slik at rask nytrening eller justering av underliggende data er mulig. Investering i overvåkingsinfrastruktur lønner seg ved å fange kvalitetsforringelse tidlig, før det påvirker brukere eller skader organisasjonens troverdighet.

Å omsette prinsipper for datakvalitet til handling krever en strukturert tilnærming som starter med vurdering og går videre til måling og iterasjon. Start med å vurdere din nåværende situasjon—forstå eksisterende treningsdatakvalitet gjennom revisjoner og profilering. Definer tydelige kvalitetsmetrikker tilpasset ditt brukstilfelle, enten det er nøyaktighetsgrenser, konsistensstandarder eller relevanskriterier. Innfør datastyringsrutiner som etablerer eierskap, valideringsprosedyrer og kvalitetsporter før data går inn i treningsrørledninger. Begynn med små, nøye kuraterte datasett i stedet for å prøve å prosessere massive volum umiddelbart, slik at du kan etablere kvalitetsstandarder og prosesser i overkommelig skala. Mål forbedringer grundig ved å sammenligne modellens ytelse før og etter kvalitetsforbedringer, og lag bevisbasert begrunnelse for videre investering. Skalér gradvis etter hvert som prosessene raffineres, og utvid datainnsamlingen først etter at kvalitetsforbedringer gir reelle ytelsesgevinster.

Nei. Nyere forskning viser at datakvalitet ofte betyr mer enn mengde. Dårlig kvalitet, feilmerkede eller irrelevante data kan aktivt forringe modellens ytelse, selv i stor skala. Nøkkelen er å finne riktig balanse mellom å ha nok data til effektiv trening og å opprettholde høy kvalitetsstandard.

Datakvalitet omfatter flere dimensjoner: nøyaktighet (riktige etiketter), konsistens (ensartet formatering), fullstendighet (ingen manglende verdier), relevans (samsvar med ditt problem), pålitelighet (tillitsverdige kilder) og støynivå. Definer metrikker som er spesifikke for ditt brukstilfelle og implementer valideringsporter for å oppdage kvalitetsproblemer før trening.

Den ideelle størrelsen avhenger av algoritmens kompleksitet, problemtype og tilgjengelige ressurser. I stedet for å jage maksimal størrelse, sikte mot "Gullhårsonen"—nok data til å fange virkelige mønstre uten å bli overbelastet med irrelevante eller redundante eksempler. Start smått med kuraterte data og skalér gradvis basert på ytelsesforbedringer.

Data-augmentering innebærer kontrollerte forstyrrelser (rotasjoner, små forvrengninger, lysvariasjoner) som bevarer den sanne etiketten samtidig som modellen lærer å håndtere variasjon fra den virkelige verden. Dette er forskjellig fra søppeldata—augmentering er bevisst og gjenspeiler realistiske variasjoner, noe som gjør modeller mer robuste til bruk i virkeligheten.

Aktiv læring identifiserer hvilke umerkede eksempler som ville være mest informative for modellen å lære av, og reduserer dermed betraktelig merkingsbyrden. I stedet for å merke alle tilgjengelige data, fokuserer du menneskelig innsats på de mest innflytelsesrike eksemplene og oppnår god ytelse med betydelig færre merkede data.

Prioriter kvalitet fremfor kvantitet. Invester i datavalideringsrørledninger, profilverktøy og styringsprosesser som sikrer treningsdata av høy kvalitet. Forskning viser at 1 000 perfekt merkede eksempler ofte overgår 100 000 støyende med hensyn til både modellprestasjon og totalkostnad.

Dårlig datakvalitet gir flere kostnader: nytrening av modell, feilsøking, feil under produksjonssetting, lagringsbehov og sløsing av datakraft. I kritiske områder som medisinsk bildediagnostikk kan dårlige treningsdata føre til farlige feil. Den falske økonomien ved billige, lavkvalitetsdata blir tydelig når disse skjulte kostnadene tas med i beregningen.

Implementer kontinuerlig overvåkning av KI-utdata for å spore nøyaktighet, relevans, konsistens og siteringskvalitet. Plattformer som AmICited overvåker hvordan KI-systemer refererer til informasjon og sporer siteringsnøyaktighet. Opprett tilbakemeldingssløyfer som kobler produksjonsytelse tilbake til treningsdatakvalitet for rask forbedring.

Følg med på hvordan KI-systemer refererer til merkevaren din og sørg for innholdsnøyaktighet med AmICiteds KI-overvåkingsplattform. Forstå kvaliteten på KI-genererte svar om din virksomhet.

Lær hvordan du presenterer statistikk for AI-uttrekk. Oppdag beste praksis for dataformatering, JSON vs CSV, og hvordan du sikrer at dataene dine er AI-klare fo...

Lær hvordan du tilfører variasjon til innhold for KI-systemer. Oppdag strategier for ulike datakilder, semantisk rikdom, innholdsstruktur og optimaliseringstekn...

Sammenlign optimalisering av treningsdata og strategier for sanntids-henting for KI. Lær når du bør bruke finjustering kontra RAG, kostnadsaspekter og hybride t...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.