OKR-er for AI-synlighet: Målsetting for GEO

Lær hvordan du setter effektive OKR-er for AI-synlighet og GEO-mål. Oppdag det tre-nivå målerammeverket, overvåking av merkevareomtaler og implementeringsstrate...

Lær hvordan du bygger et omfattende rammeverk for måling av AI-synlighet for å spore merkevareomtaler på tvers av ChatGPT, Google AI Overviews og Perplexity. Oppdag nøkkelindikatorer, verktøy og strategier for å måle synlighet i AI-søk.

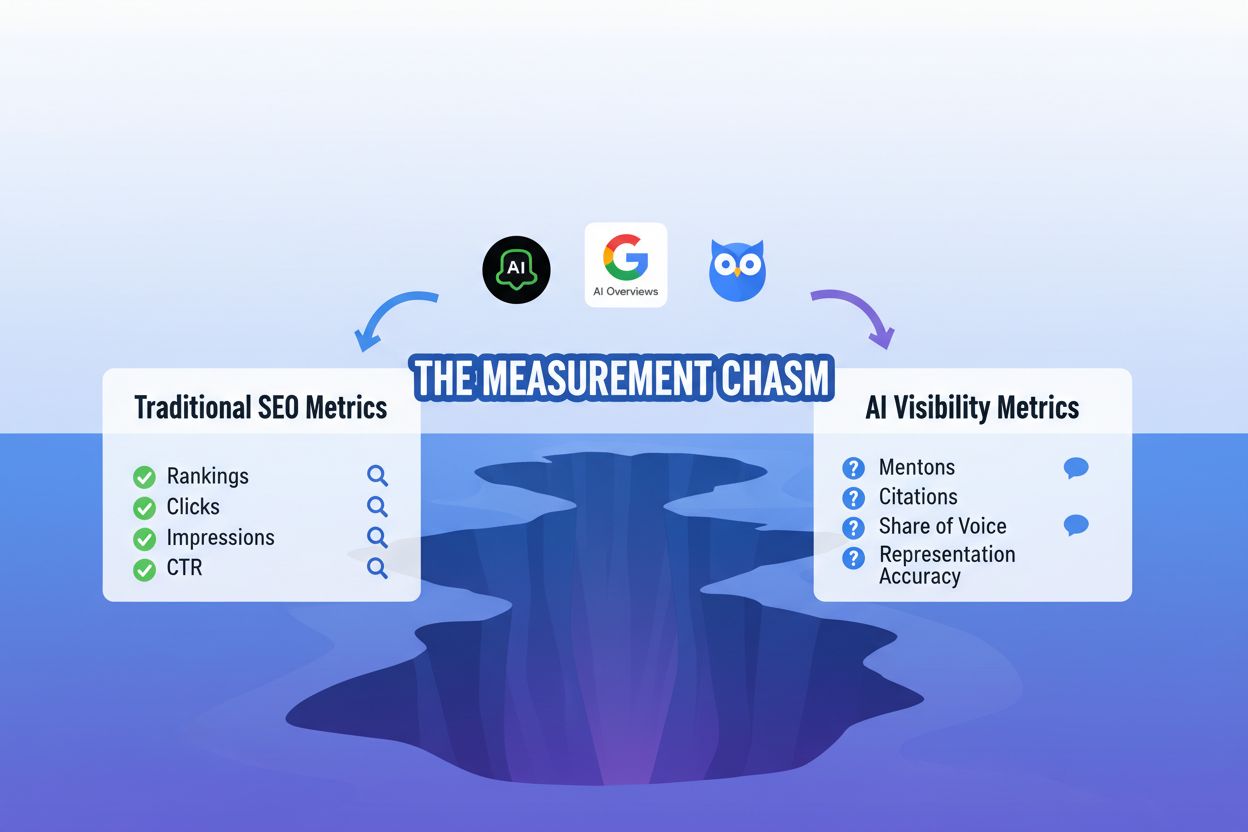

Fremveksten av generativt AI-søk har skapt det bransjeeksperter kaller “målechasmet”—et grunnleggende gap mellom tradisjonelle SEO-målinger og den nye virkeligheten med AI-drevne svar. I flere tiår har markedsførere støttet seg på SERP-sporing for å overvåke søkeordrangeringer, klikkrater og organisk synlighet. Men disse målingene blir nesten irrelevante når AI-systemer som Google AI Overviews, ChatGPT og Perplexity genererer syntetiserte svar som omgår tradisjonelle søkeresultater fullstendig. AI-synlighet opererer i et fundamentalt annerledes økosystem der innholdet ditt kan siteres, oppsummeres eller parafraseres uten noen gang å vises som en klikkbar lenke. Tradisjonelle analyserverktøy kan ikke spore disse interaksjonene fordi de skjer utenfor nettleserens standard sporingsmekanismer. Utfordringen forsterkes fordi AI-systemer opererer med begrenset åpenhet, noe som gjør det vanskelig å forstå hvordan innholdet ditt påvirker AI-genererte svar. Organisasjoner som kun fortsetter å stole på tradisjonelle SEO-målinger risikerer å bli usynlige i det AI-drevne søkelandskapet, selv når innholdet deres aktivt brukes til å generere AI-svar.

Å forstå AI-synlighet krever et helt nytt sett med målinger, spesielt utformet for hvordan generative systemer bruker og presenterer informasjon. I stedet for å spore klikk og visninger, må moderne markedsførere overvåke hvor ofte innholdet deres blir nevnt, sitert eller representert i AI-svar. Følgende rammeverk viser de viktigste målingene som bør danne grunnlaget for enhver omfattende målestrategi for AI-synlighet:

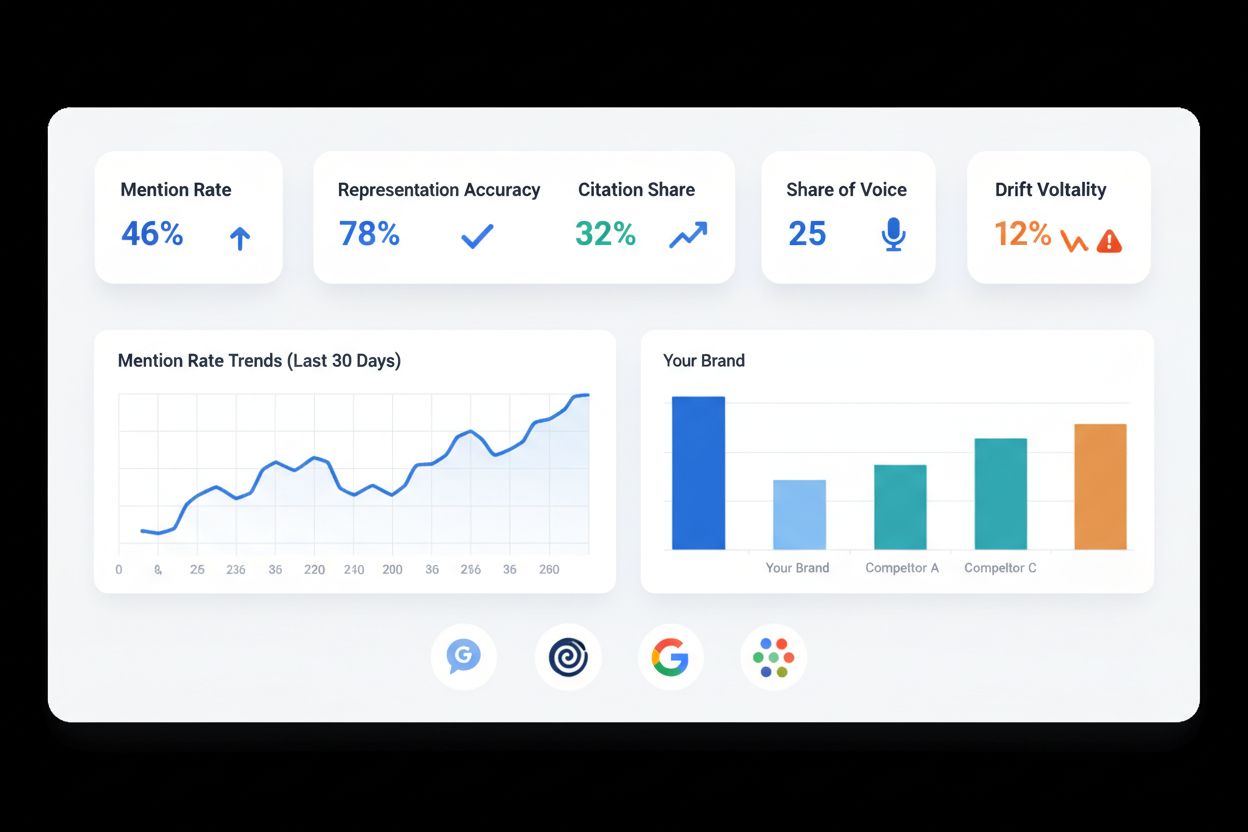

| Måling | Definisjon | Hva den måler | Hvorfor det er viktig |

|---|---|---|---|

| Omtaleprosent | Prosentandel AI-svar som refererer til merkevaren, produktet eller innholdet ditt | Rå synlighet i AI-genererte svar | Indikerer grunnleggende bevissthet og innholdsrelevans for AI-systemer |

| Representasjonsnøyaktighet | Hvor trofast AI-systemer gjengir innhold, påstander og budskap | Kvalitet og nøyaktighet på AI-siteringer | Sikrer at merkevarebudskapet ikke forvrenges eller feiltolkes |

| Sitasjonsandel | Din andel av totale siteringer innenfor et spesifikt tema eller søkekategori | Konkurranseposisjonering i AI-svar | Viser markedsandel i AI-generert innhold |

| Share of Voice (SOV) | Merkevarens synlighet sammenlignet med konkurrenter i AI-svar | Relativ konkurransestyrke | Benchmarker ytelse mot direkte konkurrenter |

| Drift og volatilitet | Svingninger i omtaleprosent og representasjon på tvers av AI-modelloppdateringer | Systemstabilitet og konsistens | Avdekker hvor følsom synligheten din er for AI-modellendringer |

Disse fem kjerneindikatorene gir til sammen et helhetlig bilde av AI-synlighet, som går utover ren tilstedeværelse for å måle kvalitet, konsistens og konkurranseposisjonering. Hver måling har sin rolle: omtaleprosent etablerer grunnleggende synlighet, representasjonsnøyaktighet beskytter merkevarens integritet, sitasjonsandel avdekker konkurransedynamikk, share of voice setter ytelsen i kontekst, og driftsovervåking sikrer langvarig stabilitet. Organisasjoner som implementerer dette rammeverket får muligheten til å spore ikke bare om de er synlige i AI-svar, men hvordan de fremstår—og om denne synligheten bidrar til forretningsresultater. Kombinasjonen av disse målingene gir grunnlaget for strategisk beslutningstaking i et AI-drevet søkemiljø.

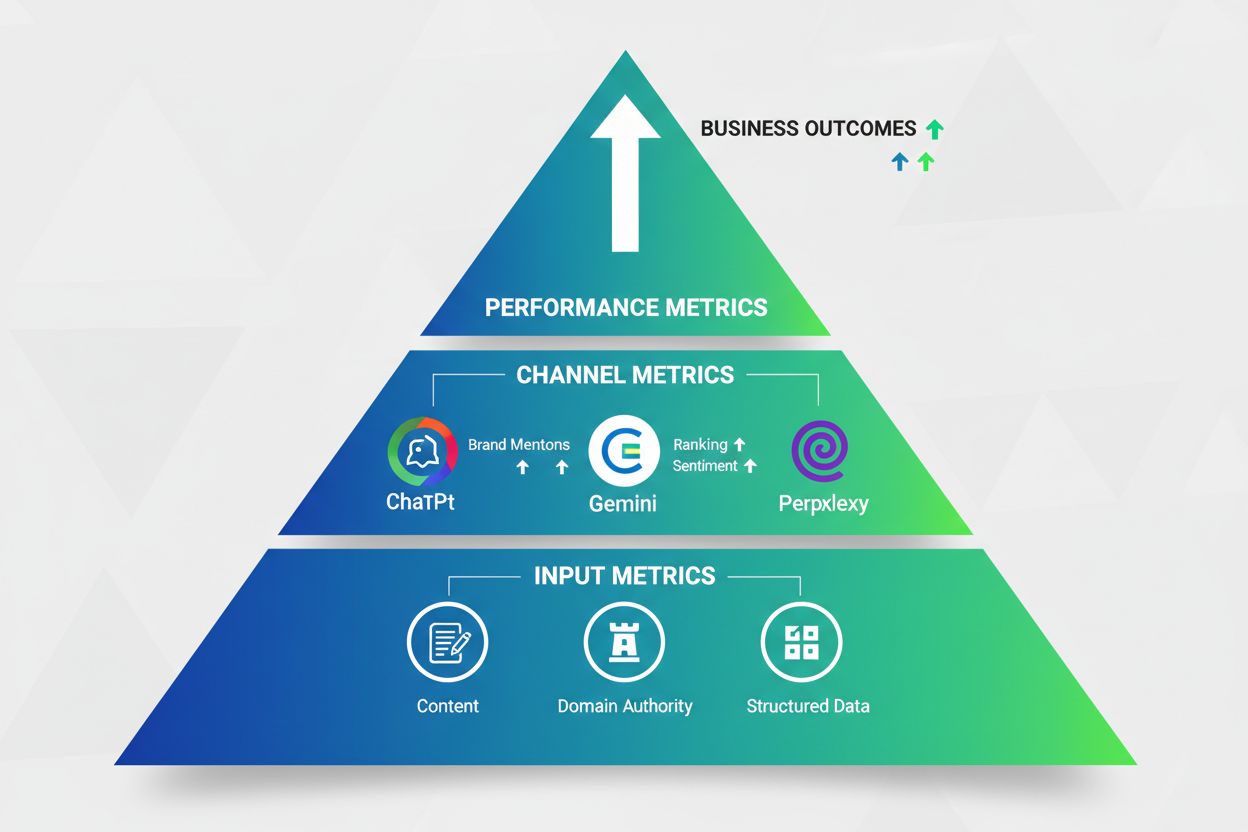

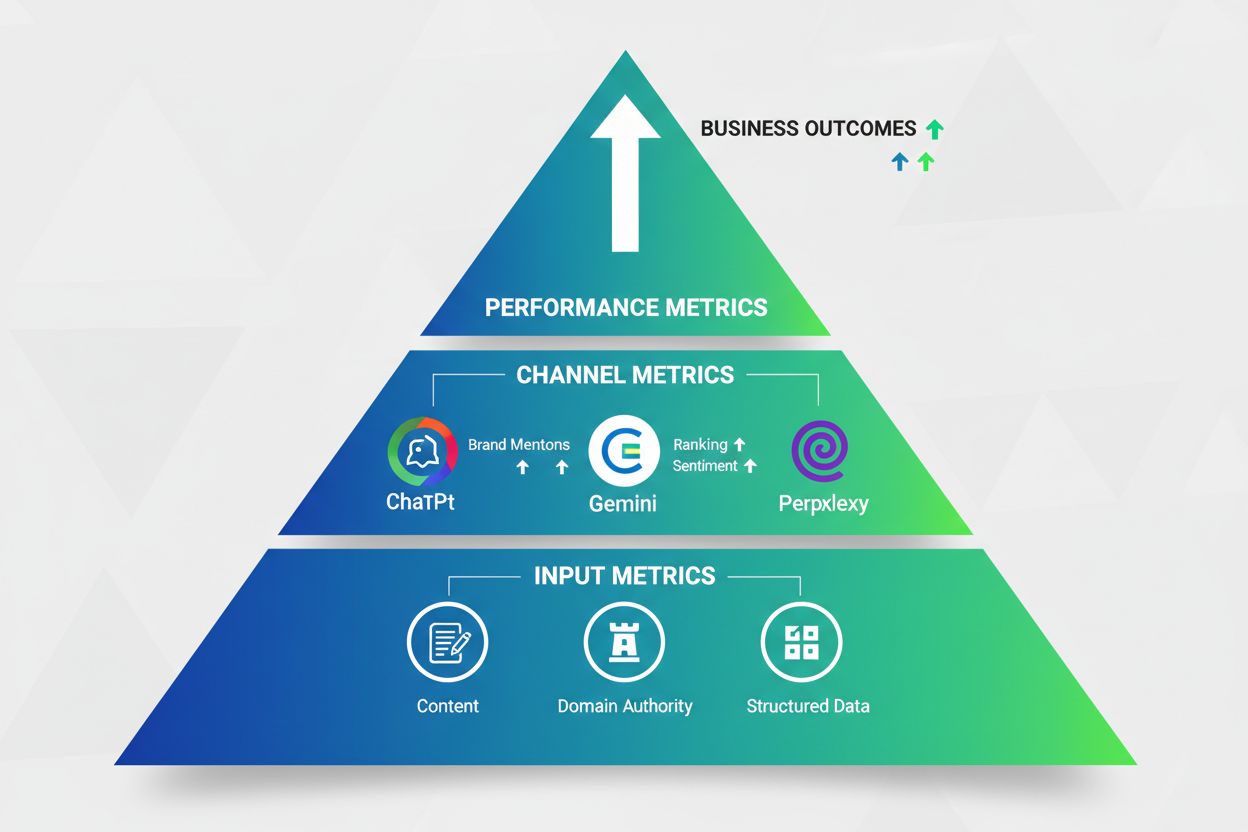

Effektiv måling av AI-synlighet krever en strukturert, hierarkisk tilnærming som fanger data på flere nivåer i kundereisen. I stedet for å behandle alle målinger likt, implementerer suksessrike organisasjoner en tredelt målerigg som flyter fra input til kanal til forretningsresultat:

Input-målinger (Nivå 1): Disse grunnleggende målingene vurderer råmaterialet som mates inn i AI-systemer. Eksempler er innholdsaktualitet, søkeordoptimalisering, bruk av strukturerte data og innholdets fylde. Input-målinger svarer på spørsmålet: “Gir vi AI-systemene det de trenger for å sitere oss?” Verktøy som Semrush og SE Ranking sporer disse overordnede faktorene.

Kanal-målinger (Nivå 2): Dette midtnivået fanger hvordan AI-systemer faktisk prosesserer og presenterer innholdet ditt. Nøkkelindikatorer er blant annet omtaleprosent, representasjonsnøyaktighet, sitasjonsandel og share of voice på tvers av ulike AI-plattformer (Google AI Overviews, ChatGPT, Perplexity, Gemini, Bing Copilot). Disse målingene krever spesialiserte overvåkingsverktøy som AmICited.com eller Profound.

Ytelsesmålinger (Nivå 3): Øverst kobles AI-synlighet til forretningsresultater som trafikk, leads, konverteringer og inntekt. Dette nivået svarer på det avgjørende spørsmålet: “Gir AI-synlighet faktisk forretningsresultater?” Ytelsesmålinger kan inkludere AI-basert trafikk, kostnad per konvertering fra AI-kanaler og inntektsattribusjon.

Denne traktbaserte tilnærmingen gjør at organisasjoner forstår ikke bare om de er synlige i AI-systemer, men hvorfor synlighet betyr noe og hvordan det henger sammen med forretningssuksess. Ved å implementere alle tre nivåer kan team avdekke flaskehalser—kanskje sterke input-målinger, men svake kanal-målinger tyder på at innholdet ikke blir korrekt indeksert av AI-systemene, mens sterke kanal-målinger med svake ytelsesmålinger viser at synlighet ikke oversettes til forretningsverdi. Den tredelte riggen gjør AI-synlighet til en konkret, målbar forretningsdisiplin.

Å etablere en robust datainnsamlingsinfrastruktur er avgjørende for pålitelig måling av AI-synlighet, og krever både teknologiske investeringer og operasjonell disiplin. Organisasjoner må implementere automatiserte overvåkingssystemer som kontinuerlig sporer omtaler, siteringer og representasjoner på tvers av flere AI-plattformer—en oppgave som manuell testing ikke kan håndtere i stor skala. Den tekniske grunnmuren inkluderer vanligvis API-integrasjoner med AI-plattformer (der det er tilgjengelig), webskrapeverktøy for å hente AI-genererte svar og datalagringsløsninger for å lagre og analysere informasjonen. AmICited.com tilbyr en integrert plattform som automatiserer mye av denne kompleksiteten, med ferdige koblinger til store AI-systemer og uten behov for egenutvikling. I tillegg bør organisasjoner etablere grunnlinjetesting, der teammedlemmer periodisk søker med målsøkeord og temaer i AI-systemene, og dokumenterer svarene for å validere automatisert sporing. Datapipelinen må inkludere kvalitetssjekk for å avdekke og rette sporingsfeil, siden selv små feil kan hope seg opp over tid. Til slutt bør det etableres tydelige retningslinjer for datastyring—hvem eier hvilke målinger, hvor ofte dataene oppdateres, og hva som regnes som tiltakskritiske endringer.

Et effektivt AI-synlighetsdashbord må betjene flere interessenter med ulike informasjonsbehov og beslutningsansvar, og krever personabaserte visninger som går langt utover generiske måletabeller. CMO-er trenger ledelsesoversikter som viser synlighetstrender, konkurranseposisjonering og forretningseffekt—ofte visualisert med trendgrafer, konkurransebenchmarks og inntektsattribusjon. SEO-ledere trenger detaljerte brudd på målinger som omtaleprosent per søkekategori, representasjonsnøyaktighet, og plattformspesifikk ytelse, ofte vist som varmekart og detaljerte tabeller. Innholdsansvarlige har behov for innholdsnivådashbord som viser hvilke saker som gir AI-siteringer, hvor ofte bestemte påstander siteres korrekt, og hvilke temaer som genererer mest AI-synlighet. Produktmarkedsføringsteam trenger konkurranseinnsikt der de sammenligner sin share of voice mot utvalgte konkurrenter og sporer hvordan produktposisjoneringen fremstår i AI-svar. Utover personaspesifikke visninger bør moderne dashbord ha sanntidsvarslinger som sier ifra når omtaleprosenten faller, representasjonsnøyaktighet svikter, eller konkurrentene vinner mye synlighet. Integrasjon med eksisterende analyseplattformer som Google Analytics og Looker sikrer at AI-synlighetsmålinger sees sammen med tradisjonelle ytelsesdata, slik at team kan koble AI-synlighet til forretningsresultater. De mest effektive dashbordene balanserer dybde og enkelhet—nok detaljer for analyser, men samtidig tilgjengelig for ikke-tekniske brukere.

Det moderne AI-landskapet består av flere konkurrerende plattformer med ulike arkitekturer, oppdateringsfrekvenser og svarmønstre, noe som krever multi-motor-sporingsstrategier som tar høyde for disse forskjellene. Google AI Overviews dominerer søkevolumet, men opererer i Googles økosystem; ChatGPT har millioner av daglige brukere, men er uavhengig; Perplexity spesialiserer seg på forskningsspørsmål; Gemini integreres med Google-økosystemet; og Bing Copilot betjener bedriftsbrukere. Hver plattform krever egen overvåking fordi de siterer kilder ulikt, oppdateres med forskjellig hyppighet og betjener ulike brukerintensjoner. Organisasjoner må også ta hensyn til geografiske og markedsmessige variasjoner, da AI-systemer ofte gir ulike svar avhengig av brukerens plassering, språk og regionalt innhold. Samsvar og merkevaresikkerhet blir viktige—det må overvåkes ikke bare om man blir sitert, men også om siteringer skjer i riktige sammenhenger og om AI-systemer feiltolker innholdet. Utfordringen forsterkes fordi AI-modelloppdateringer kan endre synligheten dramatisk over natten; en oppdatering kan endre hvordan systemene vekter kilder, siterer informasjon eller genererer svar, og krever fleksible målesystemer som kan tilpasse seg. Suksessfulle implementeringer etablerer grunnlinjer før større plattformoppdateringer, og sporer så endringer i etterkant for å forstå effekten. Verktøy som AmICited.com forenkler multi-motor-sporing ved å tilby samlet overvåking på tvers av plattformer, og eliminerer behovet for manuell sjekk av hver enkelt.

Å måle AI-synlighet er verdiløst uten en tydelig prosess for å omsette data til strategiske tiltak, og krever strukturerte optimaliseringsrutiner som knytter innsikt til innholds- og produktbeslutninger. Når omtaleprosenten viser at konkurrenter får flere siteringer på bestemte temaer, bør teamene starte innholdseksperimentering og teste ulike tilnærminger—kanskje bredere dekning, annen struktur eller sterkere påstander støttet av egen forskning. Dersom representasjonsnøyaktigheten viser at innholdet ofte feiltolkes, bør det utløse innholdsaudit og omskriving med vekt på klarhet og presisjon. Share of voice-analyse som avdekker konkurransegap, bør føre til justering av innholdsstrategien, der ressursene styres mot temaer der synlighetsgevinster er mulige. Utover innholdsoptimalisering muliggjør AI-synlighetsmålinger konkurranseinnsikt—spore hvordan konkurrenters posisjonering utvikler seg i AI-svar, identifisere fremvoksende temaer der de vinner synlighet, og forstå hvilke innholdstyper som gir flest siteringer. De mest avanserte organisasjonene kobler AI-synlighet direkte til inntekt ved å spore hvilke AI-baserte besøk som konverterer best, hvilke temaer som gir de mest verdifulle kundene, og hvilke synlighetsforbedringer som korrelerer med inntektsvekst. Dette krever integrasjon av AI-synlighetsdata med CRM- og inntektssystemer, slik at forbedringer valideres mot forretningsresultater. Organisasjoner som mestrer denne arbeidsflyten, gjør AI-synlighet til en sentral driver for markedsføringsavkastning.

Til tross for viktigheten av å måle AI-synlighet, møter organisasjoner betydelige utfordringer som kan undergrave datakvalitet og strategiske beslutninger hvis de ikke håndteres riktig. Variasjon i AI-systemene er kanskje den største utfordringen—samme søk kan gi ulike svar til ulike tider, brukere og geografier, noe som gjør det vanskelig å etablere konsistente grunnlinjer. Løsningen er å implementere statistiske utvalgsteknikker som tar høyde for naturlig variasjon, etablere konfidensintervaller rundt målingene og spore trender snarere enn absolutte tall. Begrenset plattformåpenhet innebærer at de fleste AI-selskaper ikke offentliggjør hvordan de velger kilder, vekter siteringer eller oppdaterer systemene—organisasjoner må derfor tilbakekonstruere prosessene gjennom empirisk testing. Responsattributtering fra flere kilder kompliserer målingen når AI-systemer kombinerer informasjon fra mange kilder uten å angi hvilken kilde som bidro med hva. Avanserte løsninger bruker naturlig språkbehandling og semantisk analyse for å utlede kildeattributtering selv når systemene ikke eksplisitt siterer. Personvern og brukervilkår begrenser hvor aggressivt organisasjoner kan overvåke AI-systemer—noen plattformer forbyr automatiserte forespørsler, noe som gjør at man må bruke offisielle API-er eller akseptere begrensninger på datainnsamling. Uforutsigbare modelloppdateringer gjør at synligheten kan endres raskt, og krever fleksible målesystemer som raskt kan tilpasses nye grunnlinjer. Organisasjoner som løser disse utfordringene kombinerer ofte flere innsamlingsmetoder (automatisert sporing, manuell testing, API-data), har solide kvalitetssikringsrutiner og dokumenterer endringer i metode for å sikre målekonsistens over tid.

AI-landskapet utvikler seg raskt, med nye plattformer, hyppige systemoppdateringer og best practices som fortsatt formes, og krever at organisasjoner bygger fleksible, tilpasningsdyktige målesystemer fremfor rigide rammeverk. Vellykkede implementeringer prioriterer modulær arkitektur i måleinfrastrukturen, bruker API-er og integrasjoner som kan ta inn nye AI-plattformer uten total ombygging. I stedet for å kun optimalisere for dagens plattformer som Google AI Overviews og ChatGPT, overvåker fremtidsrettede organisasjoner nye systemer og tilpasser målemetoder før de blir mainstream. Fremvoksende målinger og metoder utvikles løpende—begreper som “responskvalitet” og “brukerengasjement med AI-sitert innhold” kan bli like viktige som omtaleprosent og sitasjonsandel. Organisasjoner bør ha jevnlige gjennomganger (kvartalsvis eller halvårlig) for å revidere rammeverket, innføre nye indikatorer og fase ut utdaterte i takt med utviklingen. Langsiktige hensyn inkluderer å bygge intern kompetanse på AI-synlighet fremfor punktløsninger, utvikle ekspertise som kan tilpasse seg plattformendringer, og etablere målestyring som sikrer konsistens selv når team og verktøy endres. De som lykkes i den AI-drevne søketiden, er de som ser måling som en kontinuerlig læringsprosess—tester nye tilnærminger, validerer hypoteser med reelle data og er smidige nok til å endre strategi etter hvert som AI-landskapet forvandles.

Tradisjonell SEO-synlighet fokuserer på rangeringer, klikk og visninger fra søkeresultatsider. AI-synlighet måler hvor ofte merkevaren din nevnes, siteres eller representeres i AI-genererte svar fra systemer som ChatGPT og Google AI Overviews. Mens tradisjonell SEO sporer klikk, innebærer AI-synlighet ofte interaksjoner uten klikk der brukeren får svaret uten å besøke nettsiden din, men innholdet ditt likevel påvirker svaret.

For kritiske emner og konkurranseutsatte søk er daglig overvåking ideelt for å fange opp plutselige endringer etter AI-modelloppdateringer. For bredere sporing gir ukentlig overvåking tilstrekkelig innsikt i trender og reduserer arbeidsbelastningen. Etabler grunnlinjemålinger før store plattformoppdateringer, og spor deretter endringer etter oppdatering for å forstå effekten. De fleste organisasjoner finner at ukentlige gjennomganger kombinert med daglige varsler om store endringer gir riktig balanse.

Start med de fire viktigste plattformene: Google AI Overviews (størst rekkevidde), ChatGPT (flest daglige brukere), Perplexity (forskningsfokusert) og Gemini (bedriftsadopsjon). Bing Copilot er verdt å overvåke for bedriftsmarkedet. Prioriteringen avhenger av målgruppen din—B2B-selskaper bør fokusere på ChatGPT og Perplexity, mens forbrukermerker bør prioritere Google AI Overviews. Verktøy som AmICited.com forenkler sporing på tvers av flere motorer ved å overvåke alle plattformene samtidig.

Start med å segmentere analysene dine for å identifisere trafikk fra AI-baserte søk. Spor konverteringer fra disse segmentene separat for å forstå deres verdi. Bruk attribusjonsmodeller for å koble synlighetsforbedringer til forretningsmål som leads og inntekter. Overvåk økning i merkevaresøk etter flere AI-siteringer, da dette indikerer økt merkevarekjennskap. Den mest avanserte tilnærmingen integrerer AI-synlighetsmålinger direkte med CRM- og inntektssystemer for å skape komplette feedback-looper.

Omtaleprosenten varierer betydelig mellom bransjer og tematisk konkurranse. En omtaleprosent på 30–50 % på tvers av ditt målsøkesett anses som sterk, mens 50 %+ indikerer utmerket synlighet. Likevel er sammenligning med konkurrenter viktigere enn absolutte tall—hvis konkurrentene i snitt har 60 % omtale og du har 40 %, er det en åpenbar optimaliseringsmulighet. Bruk verktøy som AmICited.com for å spore konkurrentenes omtaleprosenter og etablere realistiske referanser for din kategori.

Etabler grunnlinjemålinger før store plattformoppdateringer, og spor så endringer etter oppdateringer for å kvantifisere effekten. Noen synlighetsnedganger er midlertidige mens modeller indekserer innholdet på nytt, mens andre indikerer strukturelle endringer i hvordan systemene vekter kilder. Implementer statistiske konfidensintervaller rundt målingene for å skille meningsfulle endringer fra normal variasjon. Dokumenter alle større plattformoppdateringer og deres effekt på synligheten for å bygge institusjonell kunnskap om hvordan endringer vanligvis påvirker merkevaren din.

Manuell testing er gratis—lag et sett med 20–50 målsøk og test dem jevnlig på AI-plattformer, og logg resultatene i et regneark. Dette gir grunnlagsdata uten kostnad. Men manuell testing skalerer ikke utover noen hundre søk. For omfattende sporing gir betalte verktøy som AmICited.com, Profound eller Semrush sitt AI Visibility Toolkit automatisering og multi-motor-overvåking. De fleste organisasjoner finner at tidsbesparelsen og bedre datakvalitet rettferdiggjør investeringen.

Innledende forbedringer i synlighet kan komme innen 2–4 uker når AI-systemer indekserer oppdatert innhold. Betydelig økning i synlig andel krever imidlertid vanligvis 6–12 uker etter hvert som du bygger innholdsautoritet og konkurrerer om siteringer. Tidslinjen avhenger av tematisk konkurranse—mindre konkurranseutsatte emner gir raskere fremgang. Etabler grunnlinjemålinger umiddelbart, og spor ukentlig for å identifisere trender. De fleste organisasjoner ser målbare forbedringer innen 30 dager og betydelige gevinster innen 90 dager med målrettet optimalisering.

AmICited sporer hvordan AI-systemer refererer til merkevaren din på tvers av ChatGPT, Google AI Overviews, Perplexity og flere. Få sanntidsinnsikt i din AI-tilstedeværelse og optimaliser innholdet ditt for generativt søk.

Lær hvordan du setter effektive OKR-er for AI-synlighet og GEO-mål. Oppdag det tre-nivå målerammeverket, overvåking av merkevareomtaler og implementeringsstrate...

Finn ut hvorfor konkurrentene dominerer AI-genererte svar, og lær dokumenterte strategier for å øke merkevarens synlighet i ChatGPT, Perplexity og Google AI Ove...

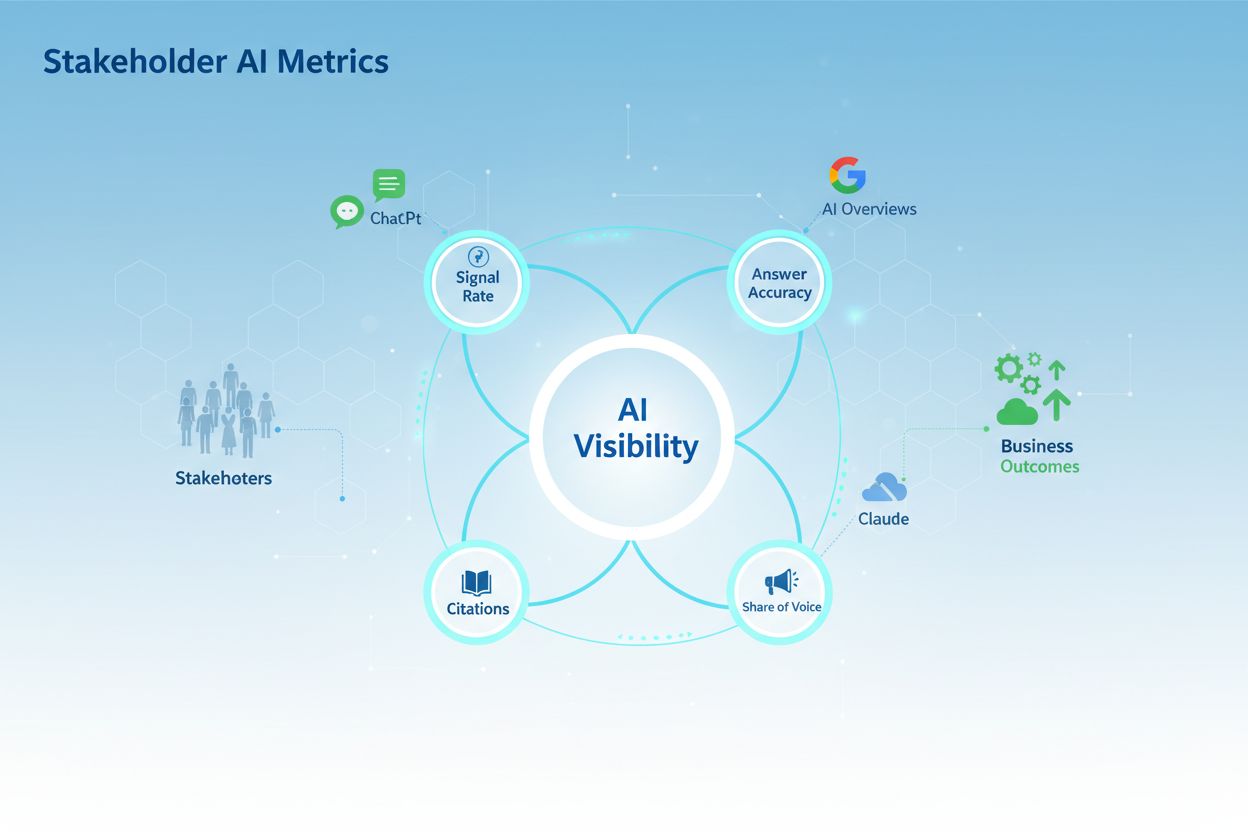

Oppdag de 4 essensielle AI-synlighetsmålingene som interessenter bryr seg om: Signal Rate, Nøyaktighet, Siteringer og Andel av Stemme. Lær hvordan du måler og r...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.